【论文笔记】图神经网络采样相关工作整理9.19

【论文笔记】图神经网络采样相关工作整理9.19

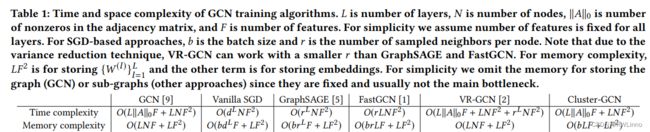

GraphSAGE NIPS2017

论文:Inductive Representation Learning on Large Graphs

目前引用数:11628

本文提出了一种称为GraphSAGE的新的图嵌入方法,该方法可以在大型图上进行高效的无监督和有监督学习。GraphSAGE通过学习如何从节点的局部邻域中聚合特征信息来生成节点的嵌入。该方法可以处理具有数百万个节点和数十亿个边的大型图,并且可以在具有少量标记节点的情况下进行半监督学习。

VR-GCN ICML2017

论文:Stochastic Training of Graph Convolutional Networks with Variance Reduction

目前引用数:487

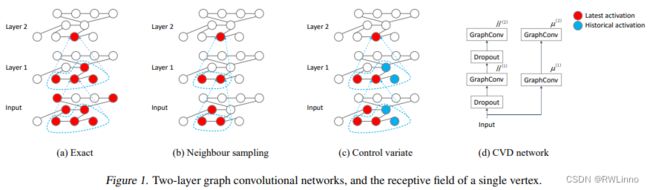

图卷积网络(GCN)是针对图结构数据的强大深度神经网络。然而GCN节点的表示使得感受野大小随着层数的增加而呈指数增长。以前缩小感受野大小的尝试并不能保证收敛,而且每个节点的感受野大小仍然数百。在本文中,我们开发了基于控制变量的算法,这种算法允许采样任意小的邻居规模。此外我们还证明了我们的算法收敛到 GCN 局部最优的新理论保证。实证结果表明,我们的算法与精确算法具有类似的收敛性。收敛性与精确算法相似

相似。运行时间在大型 Reddit 数据集上的运行时间仅为以往邻居抽样算法的七分之一。

Adaptive Sampling NIPS2018

论文名:Adaptive Sampling Towards Fast Graph Representation Learning

目前引用数:461

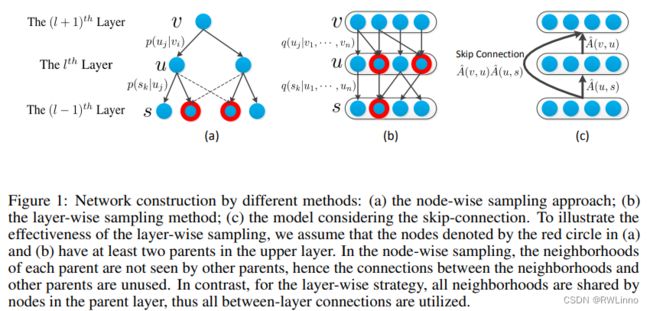

图卷积网络(GCN)已成为学习图顶点表示的重要工具。在大规模图上适应 GCNs 的主要挑战是可扩展性问题,即由于不可控的跨层邻域扩展,GCNs 在计算和内存方面都会产生高昂的成本。在本文中,我们通过开发一种自适应分层采样方法来加速 GCN 的训练。通过自上而下逐层构建网络,我们以上层为条件对下层进行采样,采样邻域由不同的父节点共享,避免了固定大小采样带来的过度扩展。更重要的是,所提出的采样器是自适应的,适用于显式方差缩小,这反过来又增强了我们方法的训练效果。此外,我们还提出了一种新颖而经济的方法,通过跳过连接来促进远节点的信息传递。在多个基准上进行的大量实验验证了我们的方法在分类准确性方面的有效性,同时还能享受更快的收敛速度。

- Adapt(自适应分层采样): 一层层构造网络

- Hop: 使用跳跃连接保持二阶邻近性

LADIES NIPS2019

论文名:Layer-Dependent Importance Sampling for Training Deep and Large GraphConvolutional Networks

目前引用数:219

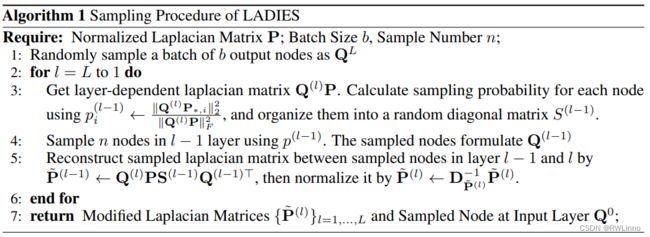

我们提出了一种新的有效采样算法,称为 "取决于层重要性采样“ (LADIES)。 基于上层的采样节点、 LADIES 会选择它们的邻域节点,构建二分图,并相应地计算重要性概率。计算相应的重要性概率。然后,它根据计算出的概率对固定数量的节点进行采样,并在每一层递归执行这样的程序,以构建整个计算过程。构建整个计算图。我们通过理论和实验证明,我们提出的采样算法在时间和性能上都优于之前的采样方法。在时间和内存成本方面都优于之前的采样方法。此外,LADIES 比原始的全批次 GCN 具有更好的泛化精度和随机性。

Cluster-GCN KDD2019

论文:Cluster-GCN: An Efficient Algorithm for Training Deep and Large Graph Convolutional Networks

目前引用数:990

本文提出的 Cluster-GCN 是一种新型 GCN 算法,它利用图聚类结构,适用于基于 SGD 的训练。Cluster-GCN 的工作原理如下:在每一步中,它采样与图聚类算法确定的密集子图相关联的节点块,并将邻域搜索限制在该子图内。

GraphSAINT ICLR2020

论文:GraphSAINT: GRAPH SAMPLING BASED INDUCTIVE LEARNING METHOD

目前引用数:749

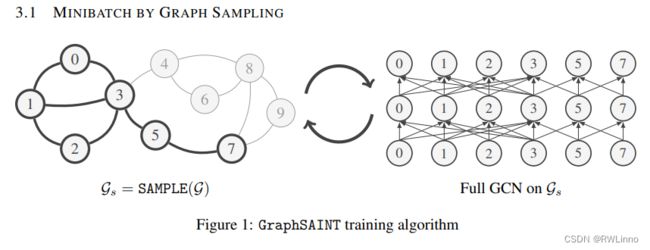

为了将 GCN 扩展到大型图,最先进的方法使用了各种层采样技术来缓解迷你批量训练过程中的 "邻居爆炸 "问题。我们提出的 GraphSAINT 是一种基于图采样的归纳学习方法,它以一种根本不同的方式提高了训练效率和准确性。通过改变视角,GraphSAINT 通过对训练图而不是 GCN 层间的节点或边进行采样来构建迷你批。每次迭代都会从正确采样的子图中构建一个完整的 GCN。这样,我们就能确保所有层中都有固定数量的连接良好的节点。我们进一步提出了消除偏差的归一化技术和减少方差的采样算法。重要的是,我们可以将采样与前向和后向传播解耦,并通过多种架构变体(如图关注、跳跃连接)扩展 GraphSAINT。在五个大型图上,GraphSAINT 在准确性和训练时间方面都表现出了卓越的性能,并在 PPI(0.995)和 Reddit(0.970)方面取得了新的一流 F1 分数。

MVS-GNN SIGKDD2020

论文:Minimal variance sampling with provable guarantees for fast training of graph neural networks

目前引用数:67

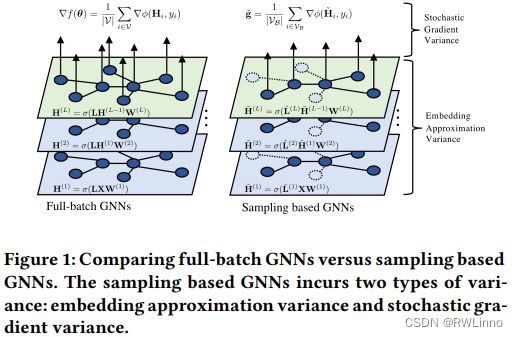

采样方法(如节点采样、层采样或子图采样)已成为加速训练大规模图神经网络(GNN)不可或缺的策略。然而,现有的采样方法大多基于图结构信息,忽略了优化的动态性,从而导致随机梯度估计的高方差。在超大图中,高方差问题会非常明显,导致收敛速度慢、泛化效果差。本文从理论上分析了采样方法的方差,并指出由于经验风险的复合结构,任何采样方法的方差都可以分解为前向阶段的嵌入近似方差和后向阶段的随机梯度方差,因此必须同时减小这两种方差才能获得更快的收敛速度。我们提出了一种解耦方差减小策略,利用**(近似)梯度信息以最小方差自适应采样节点,并明确减小嵌入近似引入的方差**。我们从理论和经验上证明,与现有方法相比,即使采用较小的迷你批次规模,所提出的方法也能获得更快的收敛速度和更好的泛化效果。

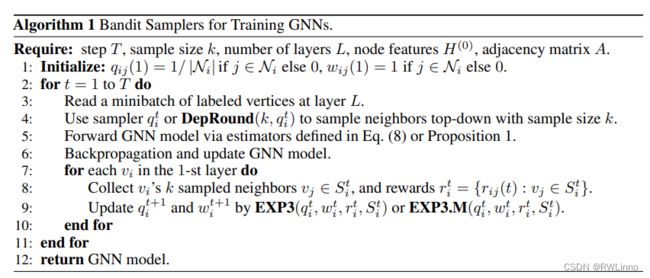

GNN-BS NIPS2020

论文:Bandit samplers for training graph neural networks

目前引用数:37

本文提出了一种新的方法来优化图神经网络的采样方差,克服了由于嵌入和学习权重的变化而带来的挑战。作者将采样方差的优化形式化为对抗赌博机问题,其中奖励与节点嵌入和学习权重相关,并且可能不断变化。因此,一个好的采样器需要同时获取更多邻居的方差信息(探索)并优化即时采样方差(利用)。作者在理论上证明了他们的算法在渐近意义下可以以3的因子逼近最优方差,并在多个数据集上展示了该方法的有效性和效率。

BNS IJCAI2021

论文:Blocking-based Neighbor Sampling for Large-scale Graph Neural Networks

目前引用数:8

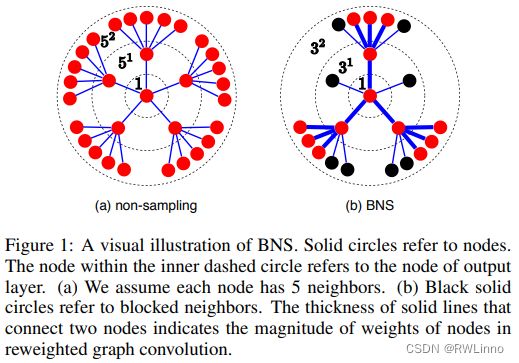

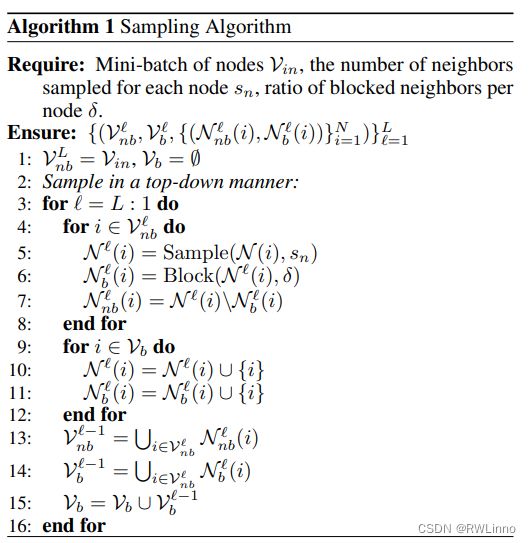

随着网络深度的增加,计算和内存复杂度呈指数级增长,这已成为图神经网络(GNN)成功应用于大规模图(如拥有数亿节点的图)的主要障碍。在本文中,我们提出了一种新颖的邻居采样策略,称为基于阻塞的邻居采样。具体来说,BNS 采用了一种随机阻断邻接节点持续扩展的策略,这可以降低 GNN计算和内存复杂度指数级增长的速度。此外,在图卷积,以调整阻塞和非阻塞邻居对中心节点的贡献。和非阻塞邻居对中心节点的贡献。我们从理论上证明,BNS为原始图卷积操作提供了无偏的估计。在三个基准数据集上的广泛实验表明,在大规模图上,BNS 比最先进的方法快 2~5 倍。此外,即使在小规模图上,BNS 也能显示出时间成本低的优势。