A Framework to Evaluate Fusion Methods for Multimodal Emotion Recognition

| 题目 | A Framework to Evaluate Fusion Methods for Multimodal Emotion Recognition |

|---|---|

| 译题 | 一种评估多模态情感识别融合方法的框架 |

| 时间 | 2022年 |

| 仅用于记录学习,不作为商用 |

一种评估多模态情感识别融合方法的框架

摘要:情绪识别的多模态方法考虑了预测情绪的几种数据来源;因此,需要一种融合方法来聚合各个结果。在文献中,有多种融合方法来执行这项任务,但它们并不适用于所有场景。特别是,有两个相关方面可能因应用而异: I I I 在许多情况下,单个模态可能具有不同水平的数据质量,甚至不存在,这需要能够区分无用数据和相关数据的融合方法;以及 I I II II 在许多应用中,存在限制复杂融合方法(例如,深度学习模型)使用的硬件限制,这可能是计算密集型的。在这种情况下,开发人员和研究人员需要衡量标准、指南和系统流程来评估和比较适合其特定应用场景的不同融合方法。作为对这一需求的回应,本文提出了一个框架,为对融合方法进行比较评估奠定了基础,以证明它们如何适应各个模态的质量差异,并评估其性能。该框架提供了对融合方法进行公平评估的同等条件。基于这个框架,我们评估了几种用于多模式情感识别的融合方法。结果表明,对于所选的体系结构和数据集,最适合的方法是:所有可用模态的自注意和加权方法,以及缺少模态时的自注意和 E m b r a c e n e t + Embracenet+ Embracenet+ 。关于时间,最佳时间对应于多层感知器(MLP)和自注意模型,因为它们的操作数量较少。因此,所提出的框架为该领域的研究人员提供了见解,以确定哪些融合方法更符合他们的要求,从而证明选择的合理性。

关键词:情感识别,融合方法,多模态

1.Introduction

人们通过言语、自发和自动的非言语表达来表达情绪,这使得其他人很容易理解这些情绪,但数字表示和识别起来很复杂 [ 1 ] , [ 2 ] , [ 3 ] ^{[1],[2],[3]} [1],[2],[3] 。因此,非语言交流(例如,身体运动、面部手势)和实际单词对于解读说话者的真实情绪是有用的,无论是对其他人还是对自动情绪识别系统都是有用的 [ 4 ] ^{[4]} [4]。目前,科学界对产生计算方法越来越感兴趣,这种方法可以考虑不同模态(包括言语和非言语)传达的不同信息,以便更准确地解读人们的情绪 [ 5 ] ^{[5]} [5] 。

在现有技术中,存在着大量多样的方法来分析单一模态并识别来自单一来源的采样数据背后的潜在情绪,例如文本 [ 6 ] , [ 7 ] , [ 8 ] ^{[6],[7],[8]} [6],[7],[8] ,语音 [ 9 ] , [ 10 ] , [ 11 ] ^{[9],[10],[11]} [9],[10],[11]、面部手势 [ 12 ] , [ 13 ] , [ 14 ] ^{[12],[13],[14]} [12],[13],[14] 。然而,仍然缺乏额外的战略来充分利用一种模式在某些情况下可以提供给另一种模态的补充信息。这就是多模态数据融合可以介入的地方。

情绪识别的多模态技术背后的复杂性是,并非所有来源或模态都携带相同质量的信息[15],[16]——即,在某些情况下,一种模态可能无法为给定样本产生预期输出(或任何输出)[17]。在这种情况下,融合过程应该以一种特定的方式聚合这些不同的数据源,以捕捉它们之间的关系[18],如果可能的话,当来自另一个样本的样本质量证明特别差时,可以找到一种方法来更多地依赖某些模态[16]。大多数多模态融合方法都得到了深度学习模型的支持,深度学习模型用于获得融合所有不同数据的新表示,对这种表示进行分类,或两者兼而有之[18]、[19]、[20]、[21]。考虑到人类在向另一个人传递信息时,自然会同时使用多个渠道进行互动,而人类大脑有能力处理所有这些信息[22],因此很容易理解为什么多模态数据融合可以自然地适用于情绪识别问题。

尽管有优势,但用于多模态融合的深度学习技术也有一些缺点,主要与过程的复杂性和来自不同来源的数据质量的可变性有关。例如,某些模态的许多最先进的模型(如视频)在分析过程中可能需要特别大量的操作[23];此外,融合模型将需要从其所有单独的单峰模型进行计算,并且还需要对融合本身进行一些额外的计算,以便进行预测(或者如果端到端训练,则进行反向传递);在这种情况下,融合模型最终可能会在有限的硬件或电池节省限制(例如,智能手机、社交机器人)中执行,计算量非常大。融合方法面临的另一个主要问题是存在并非所有来源都同样可靠的场景(例如,昏暗空间中的摄像头识别人脸,嘈杂空间中的声音传感器捕捉语音)[17]。因此,在这些情况下,任何预测都必须通过降低来源数据的重要性,甚至忽略它来进行。

在文献中,有多种融合方法来执行多模态情绪识别,但它们在所有场景中的表现并不相同,涉及到对来自不同来源的不同数据质量水平的考虑和时间复杂性。在这种情况下,开发人员和研究人员需要衡量标准、指南和系统流程来评估和比较适合其特定应用场景的不同融合方法。

作为对这一需求的回应,我们提出了一个框架,该框架为对融合方法进行比较评估奠定了基础,以证明它们如何适应各个模态的质量差异,并评估它们的性能。该框架提供了对融合方法进行公平评估的同等条件。基于这个框架,我们在多模态情感识别的背景下评估了九个融合模型。该框架提供了三个深度学习模型,用于从三种单独的模态(即面部手势、音频和文本)预测情绪;然后将结果传递给不同的融合模型。该框架提出了进行比较评估的指导方针。

基于与所提出的框架进行的比较评估,我们展示了一些融合方法如何在缺乏特定模态数据的情况下实现一定程度的弹性,其中一些方法甚至比最准确的单个模态实现了改进。在比较实验中,使用了交互式情绪动态捕捉( I E M O C A P IEMOCAP IEMOCAP)数据库 1 ^1 1。结果表明,对于这种结构/数据集的组合,当所有模态都可用时,自注意和加权方法是最好的,而当模态缺失时,自关注和拥抱+方法是最佳的。关于执行时间,最佳时间对应于多层感知器( M L P MLP MLP)和自注意方法,因为这两种方法都具有少量的操作。因此,所提出的框架为该领域的研究人员提供了见解,以确定哪些融合方法更符合他们的要求,并证明选择的合理性。总之,本文的主要贡献有三个方面:

- 一个在相同条件下比较不同融合方法的框架,以对其能力进行更公平的评估和评估,该主题的研究人员可以使用该框架来决定哪种融合方法更适合他们的项目;

- 演示不同的多模态方法如何适应不同的数据质量或存在或不存在某些模态;

- 所考虑的融合方法在执行时间方面的比较评估。

有了评估这些方面的能力,可以根据应用场景选择融合方法,从而做出更合适、更恰当的决策。

本文的结构如下。在第二节中,回顾了最近关于多模态情感识别的融合方法的一些工作。第三节描述了评估的融合方法。第四节描述了评估框架。在第五节中,对结果的评估和比较进行了介绍和讨论,并详细解释了模型的训练过程和实验过程。最后,第六节提出结论和今后的工作。

2.Related work

多模态融合的思想已被应用于许多环境中。[24]中提出的调查描述了城市数据(从气象站、出租车 G P S GPS GPS、污染水平、交通量等收集的输入)的多模态融合方法的最新状态,以对从人群流量到空气质量水平等各种事物进行预测。在[25]的另一个领域,描述了几种用于阿尔茨海默病早期检测的融合技术。作者将早期和晚期融合浅模型(如k邻居和随机森林)与深度学习模型进行了比较,深度学习模型使用了来自每种模式(即临床数据、成像和遗传)的数据的中间表示的连接。在这种情况下,最后的分类是使用一个简单的多层感知器( M L P MLP MLP )完成的。这个建议在很多上下文中都很常见。在[26]中,作者使用 M L P MLP MLP 作为融合说服力意见多媒体( P e r s u a s i v e O p i n i o n M u l t i m e d i a , P O M Persuasive Opinion Multimedia, POM PersuasiveOpinionMultimedia,POM )数据集数据的方法,以提高预测的质量。在这种情况下,预测是对样本是否有说服力的信心得分。在[27]中针对音乐类型分类问题所做的工作中,在融合步骤之前,作者应用了一些技术,如矩阵乘法和三角函数,将每个模态(即音轨、文本评论和封面图像)的结果嵌入到一个新的多模态空间中,以优化模态之间的相似性。然后将在该空间中获得的向量与原始向量连接起来,就好像所有的向量都来自不同的来源,并将得到的特征向量用作 M L P MLP MLP 的输入。在[28]和[29]中,也使用了一个 M L P MLP MLP ,将其每个模态(即文本和图像)串联起来进行文档分类[28],并在[29]中进行情感分类。后者通过情境层次对图像中的情绪进行分析,并将每个定义的情境作为模态进行处理。

更复杂的融合模型也被探索,可以应用于任何环境。 E m b r a c e n e t Embracenet Embracenet 是一种深度学习模型,它依赖多项分布从每个单个模态的结果向量中创建特征向量,文献[17]给出了该模型。这种机制不仅有助于防止过拟合,而且还允许从数据不可用的源中丢弃信息,因为它被设计为从概率为零的源中选择特征。理论上,该机制旨在提供足够的灵活性,以便在多种情况下使用,尽管它最初是在气体识别(使用气体传感器阵列数据集)[30]和人类活动识别(使用 O P P O R T U N I T Y OPPORTUNITY OPPORTUNITY 数据集)[31]的背景下进行测试的。 D e e p F u s i o n DeepFusion DeepFusion 是另一种模型,旨在减轻其中一种模式中数据缺失/质量差的问题[16]。 D e e p F u s i o n DeepFusion DeepFusion 学会计算权重,该权重代表从每个来源收到的样本的大致质量或每个来源的信息量。这样,最终的分类应该更多地依赖于它认为更有价值的数据来进行预测。 D e e p F u s i o n DeepFusion DeepFusion 还具有发现不同模态样本之间相关性的层,与前面提到的质量决定层相结合,使模型能够在活动识别问题上获得最先进的结果。

在情感识别的背景下,多模态融合方法不断得到研究。已经测试了各种模型,从单个模态结果的串联传递到MLP[32],到允许评估样本中存在的时间依赖性的更复杂的循环网络,例如[33],[34],[35]中提出的基于 L S T M LSTM LSTM 的模型或[36]中发现的 B i G R U BiGRU BiGRU 机制。注意机制也很受欢迎。[37]中提出的模型通过使用注意力机制融合音频和文本模态[5],实现了 I E M O C A P IEMOCAP IEMOCAP 数据集的最新结果。在[38]中,多模态注意( M M A MMA MMA )模块用于自适应地融合音频、肢体语言和文本的特征,也是在 I E M O C A P IEMOCAP IEMOCAP 数据集上。类似地,文献[15]中使用 R A V E N RAVEN RAVEN 模型来融合音频、文本和视频。注意力作为融合机制的一部分也在其他数据集上进行了测试,如 C M U − M O S E I CMU-MOSEI CMU−MOSEI 详见[39],或 H E U HEU HEU 第一部分和第二部分[40]。后者提出了一种多模态注意机制( c L S T M − M M A cLSTM-MMA cLSTM−MMA ),该机制在多模态注意网络( M M A N MMAN MMAN )中促进了三种模态的注意。其他复杂的方法[41],[42],[43],如 D E A P , S E E D DEAP, SEED DEAP,SEED 或 E m o F B V P EmoFBVP EmoFBVP,也能获得较高的性能。在[41]中,音频和视觉模态使用潜在空间线性映射进行融合,然后使用基于 D e m p s t e r − S h a f e r Dempster-Shafer Dempster−Shafer (DS)理论的证据融合方法将其投影到跨模态空间的特征与文本模态融合。[42]的作者提出了卷积深度信念网络( C D B N CDBN CDBN )模型,该模型学习了情绪表达的显著多模态特征,在低强度情绪表达中取得了比最先进方法更好的结果。在[43]中,使用受限玻尔兹曼机( R B M RBM RBM )模型构建了一个双峰深度自编码器( B D A E BDAE BDAE ),其提取的高级表示特征被证明是有效的情感识别。

其他类型的模型也被提出,如线性回归使用和 T e n s o r f u s i o n Tensorfusion Tensorfusion。在[44]中,作者对唤醒和效价的所有单一系统使用线性回归。线性回归也用于融合。 T e n s o r f u s i o n Tensorfusion Tensorfusion 是一种基于张量乘法的融合方法,在文献[45]中有描述,其中每个张量代表一个不同的模态。[46]中提出了一种更有效的方法,该方法依赖于低秩加权分解,设计时考虑了高维张量,并在多个数据集上进行了测试。 I E M O C A P IEMOCAP IEMOCAP 数据集获得的结果是迄今为止获得的最好的结果之一[5]。[47]中提出了一种改进的 E m b r a c e n e t Embracenet Embracenet,称为 E m b r a c e n e t + Embracenet+ Embracenet+,在使用 E M O T I C EMOTIC EMOTIC 数据集进行测试时,它被证明比 E m b r a c e n e t Embracenet Embracenet 更准确。文献[48]描述了一种结合 T r a n s f o r m e r s Transformers Transformers 和注意力的融合方法。这项工作考虑了文本、音频(语音)和视觉三种输入模态,并从独立预训练的自监督学习模型中提取特征。[49]提出了一种利用模态内注意机制和 F a c t o r i z e d B i l i n e a l P o o l i n g Factorized Bilineal Pooling FactorizedBilinealPooling ( F B P FBP FBP )进行跨模态融合的方法;它为 A F E W AFEW AFEW 数据集获得具有竞争力的结果,该数据集包含 “ i n t h e w i l d ” “in the wild” “inthewild” 样本(取自电影和电视,而不是专门为生成数据而设计的实验室会议)。

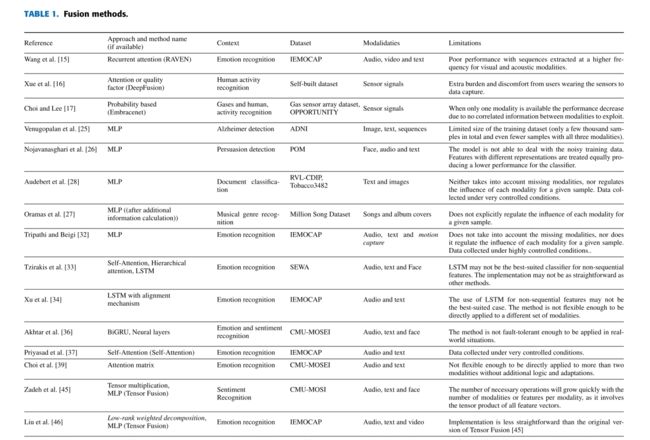

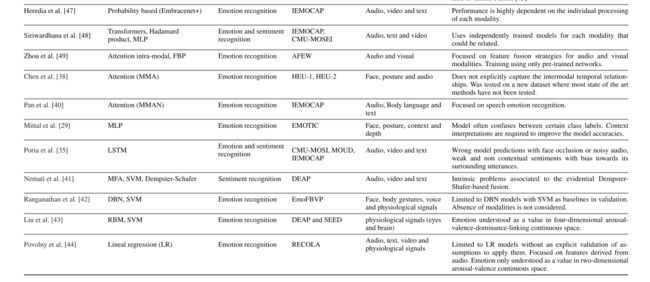

这些工作总结如表1所示。他们展示了最近对开发多模态分类方法的融合方法的兴趣和各种各样的建议。要决定哪一种方法在特定情况下最合适和最有效,重要的是要评估它们对不同质量的模式和时间消耗的适应性。特别是,在人机交互(HCI)和人机交互(HRI)的趋势话题多模态情感识别的背景下,对这些方法进行比较是有意义的。

3.FUSION METHODS TO BE EVALUATED(融合方法有待评估)

融合方法有不同的分类。最流行的分类主要考虑三种融合策略:信息/数据融合(低级融合)、特征融合(中级融合)和决策融合(高级融合)[50]。数据融合将多个原始数据来源结合在一起,产生新的原始数据,预计这些数据将比输入数据更具信息性和综合性。特征融合将所有特征连接到一个单一的表示中。然后将连接的异构特征直接输入分类器以训练模型[51]。决策融合方法使用一组分类器来提供更好和无偏的结果。分类器可以是相同或不同的类型,也可以具有相同或不同的特征集[52]。本工作研究的融合类型是基于决策融合,有时也称为后期融合。

在这项工作中,我们评估了九种融合模型,它们是各种深度学习技术的代表集。每一项的简介如下:

- 简单密集神经网络/多层感知器( D N N / M L P DNN/MLP DNN/MLP):这可能是最简单的多神经元神经网络类型,是一种非常常见的融合方法,相关工作已经证明了这一点;

- 注意机制加 M L P MLP MLP:这是基于[39]中提出的工作,并使用与[48]中类似的结构,尽管使用的是完全不同的技术。由于这项工作被称为双峰融合,因此进行了适应。即,双峰注意应用于每对模态。在这种情况下,对于每个模态,产生两个注意矩阵,然后分别乘以模态向量。结果是两个不同的向量被简化为一个原始大小的向量,并与 M L P MLP MLP 融合以进行最终分类;

- [16]中提出的 D e e p F u s i o n DeepFusion DeepFusion 模型:这是一个统一的多传感器深度学习框架,旨在学习异构感官数据的信息表示。该框架结合了不同传感器的数据质量加权信息,并结合了传感器间的相关性。该框架由两个子模块组成,即质量加权子模块和关联子模块。然后,将每个子模块的结果连接起来,一个线性层生成大小为4的向量(类别的数量)。然后将该向量应用于 s o f t m a x softmax softmax 融合以进行最终分类。在我们的工作环境中,我们额外测试每个子模块作为一个单独的融合方法,正如我们在以下两个项目中解释的那样;

- D e e p F u s i o n DeepFusion DeepFusion 模型的加权组合子模块:它使用单个神经元,每个模态具有 s i g m o i d sigmoid sigmoid 激活函数的变化,以确定模态输出质量的标量权重或因子。然后对结果因子形成的向量应用 s o f t m a x softmax softmax 函数,用测试数据集的样本对它们进行规范化。然后,将每个归一化因子乘以各自模态的输出,并将得到的向量相加。该结果被传递给一个2层门控循环单元( G R U GRU GRU ),该单元进行最终分类。该模块单独使用时,再加一个 s o f t m a x softmax softmax 层,使 G R U GRU GRU 符合[16]中提出的设计。由于这个网络的输入不是一个序列,一个更直接的非循环类型的网络可能已经足够了。

- D e e p F u s i o n DeepFusion DeepFusion 模型的跨模态子模块:它依赖于减法、连接和几个层来进行分类。首先,对于每个模态,执行一些减法(即,在模态输出向量和其他模态输出向量之间)。然后将结果向量与 R e L U ReLU ReLU 层连接并融合。该输出是一个与单个模态的输出向量(在本例中为4)大小相同的向量。然后,从这个过程中获得的向量(每个模态一个)被平均,从而得到最终的分类(当这个模块单独使用时,稍后应用一个 s o f t m a x softmax softmax 层,正如我们在上一项中解释的那样)。

- [45]中提出的张量融合模型。它是一种多模态融合方法,在多模态情感分析的背景下,使用情态嵌入的 3 − f o l d 3-fold 3−fold (三倍)笛卡尔积(Cartesian production)明确地聚合单模态、双模态和三模态相互作用。在每个向量上添加一个值为 1 1 1 的额外常数维度,以生成单峰和双峰动力学。这个过程的结果是得到三维张量。之后,这个张量被平面化并被送入 M L P MLP MLP 进行最终分类。

- [17]中提出的 E m b r a c e n e t Embracenet Embracenet 方法。它是比较容易适应其使用环境的模态之一,也是明确考虑到模态缺失问题的少数模态之一。该方法使用对接层使用 R e L U ReLU ReLU 层将每个模态生成的向量转换为特定大小的向量。然后,用这个大小创建一个新的向量,从在对接层中得到的向量的第 i i i 个元素中选择它的第 i i i 个元素。从特定模态中选择第 i i i 个元素是在训练过程中学习到的概率。

- [53]中提出的 “ E m b r a c e n e t + ” “Embracenet+” “Embracenet+” 是对 E m b r a c e n e t Embracenet Embracenet 模型的替代或改进。该模型的架构包括三个简单的 E m b r a c e n e t Embracenet Embracenet 模型,这些模型致力于改善模态的相关学习以及最终结果。使用的每个 E m b r a c e n e t Embracenet Embracenet 模型都有一个线性层和一个 d r o p o u t dropout dropout 层,这使模型更加坚固,从而提高了学习能力。由于基于 E m b r a c e n e t Embracenet Embracenet,该模型在使用的模态数量和容错或丢失数据方面是灵活的。

- 自我注意:该机制最初由[37]提出。在连接结果向量并使用带有 s o f t m a x softmax softmax 的线性层进行分类之前,将注意力单独应用于每个模态。在这种情况下,注意值由标量乘以与该模态对应的向量表示。该标量通过使用模态向量作为具有激活函数 t a n h tanh tanh 的神经元的输入来获得,然后将其结果传递给 s i g m o i d sigmoid sigmoid 函数以获得最终值。

选择这些方法是因为它们在作品中的表现,以及它们易于适应所选择的单峰方法的能力。例如,基于 L S T M LSTM LSTM 的方法被丢弃,因为所选择的单模方法的输出不是连续的,因此,这些类型的方法的优势不会得到很好的利用。此外,这些融合模型代表了不同的方法,即基于 M L P MLP MLP、注意力和概率的方法。其中一些,如 E m b r a c e n e t Embracenet Embracenet 和 S e l f − A t t e n t i o n Self-Attention Self−Attention ,已经在情绪识别领域成功测试,而其他一些,如 D e e p F u s i o n DeepFusion DeepFusion ,在其他领域获得了很好的结果,是基于在情绪识别任务中取得类似结果的前景而选择的。

5.EVALUATION FRAMEWORK(评估框架)

本节介绍了所提出的框架,对不同的融合方法进行比较,并对其进行评价。

5.1 FRAMEWORK DESCRIPTION(框架的描述)

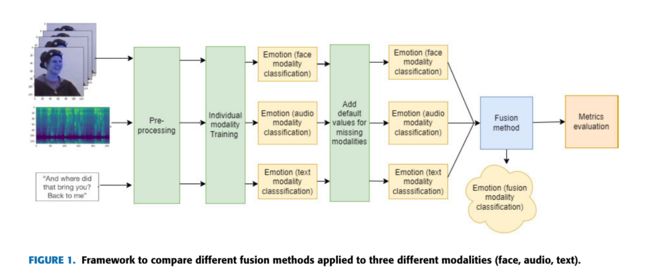

图 1 1 1 显示了使用三种模态对不同融合方法进行比较的拟议框架的示例。它由以下步骤组成:

- 数据集选择:必须根据研究上下文选择要使用的数据集;

- 预处理:这一阶段必须对数据进行准备,包括数据清洗、去噪、输入归一化、样本选择等;

- 个体模态训练:每个模态的训练过程必须执行,通常基于不同的机器学习技术。然后,以前一阶段预处理的数据作为输入,必须使用不同的技术对数据进行调整,并评估其性能;

- 融合方法的选择和测试:测试阶段包括考虑不同的融合方法进行评估。由于大多数融合方法都需要每个模态的输入,因此对于缺少某个模态信息的每个样本,都会为该模态提供默认值;

- 结果评价与比较:采用不同的定量模型评价指标,即精密度、召回率、F1评分和准确率,对每种融合方法得到的结果进行比较。

在下一节中,我们描述了如何基于所提出的框架对几种融合方法进行比较评估。

5.2 THE COMPARATIVE EVALUATION PROCESS: STEP BY STEP(比较评价过程:一步一步)

我们框架的第一步(数据集选择、预处理和个体模型训练)在之前的多模态情感识别工作中得到了考虑[47]。这项工作提出了一种架构来处理面部、音频和文本模态,并使用一种称为 E m b r a c r n e t Embracrnet Embracrnet 的融合方法进行聚合。每个模态被单独处理,其结果作为融合方法的输入。最后,融合方法产生一种公认的情绪(即快乐、中性、悲伤和愤怒)。图 2 2 2 显示了这项工作的基本结构,这是评估不同融合方法的基础。本工作中假定的每个步骤的主要考虑因素总结如下。

- 数据选择

在这项工作中,我们保留了之前工作[47]中选择的数据集: I E M O C A P IEMOCAP IEMOCAP 数据集[54]。这个数据集包含了 10 10 10 个演员在 5 5 5 个不同的会话中成对互动的录音。有些互动是照本宣科的,有些是即兴发挥的。该数据集包括这些互动的视频和音频记录及其各自的转录。获得了大约 12 12 12 小时的视听数据,包括视频、语音、面部动作捕捉和文本转录。运动捕捉( M O C A P MOCAP MOCAP )数据也包括在内,但在本文描述的实验中没有考虑它们。有 10039 10039 10039 个样本,每个样本包含来自不同模态的数据。

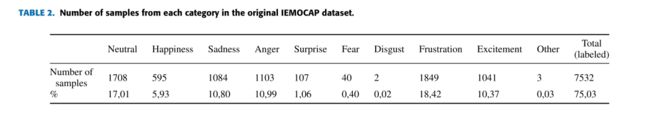

在样本注释过程中考虑的十种情绪(即中性、快乐、悲伤、愤怒、惊讶、恐惧、厌恶、沮丧、兴奋等)。然而,大多数关于这个数据集的研究只考虑了四种情绪(即快乐/兴奋、悲伤、愤怒、中性)[5]。这项工作中的所有模型都只使用具有这些标签的样本进行训练,这些标签是数据集作者最初打算使用的唯一标签。表 2 2 2 显示了 I E M O C A P IEMOCAP IEMOCAP 数据集的原始十种情绪的分布。表 3 3 3 综合了四个类别中每个类别的样本数量,这些类别至少由用于单个模式的一种模型分类。在原始数据集中, 2507 2507 2507 个样本(占总数的 24.97 24.97% 24.97 )未标记。该方案的前四次会议用于培训,而第五次会议用于测试。

-

预处理

这一阶段在之前的研究中也有涉及[47]。对于图像,分别对人脸区域进行识别和处理。音频以两种方式处理:使用 M F C C MFCC MFCC 特征提取器获得语音的图形表示,以及将语音转换为文本(语音转录)。使用 N L P NLP NLP 技术分析文本。 -

单一模态训练

为了评估融合模型,我们保留了在[47]中提出的工作中使用的相同的个人情绪识别模型,这些模型在 I E M O C A P IEMOCAP IEMOCAP 数据集中进行了训练和验证: -

面部模态:对于这种模态,使用了 P a r k h i Parkhi Parkhi 等人在[55]中提出的模型的一个变体。使用 V G G 19 VGG19 VGG19 代替 P a r h i Parhi Parhi 使用的 V G G 16 VGG16 VGG16,并将图像尺寸减小到 48 × 48 48 × 48 48×48 。后者也有助于减少最后一层的处理时间和参数数量。除了输出 512 512 512 特征向量的 V G G 19 VGG19 VGG19 外,还使用了线性层进行分类。对于该网络,为了与来自 I E M O C A P IEMOCAP IEMOCAP 的视频样本一起工作,对样本进行了如下预处理:从每个视频样本中提取包含人脸的 8 8 8 帧,并由网络单独处理。最后的结果是 8 8 8 帧中每一帧的分类向量的平均值。该模型的准确率为 0.44 0.44 0.44。但是,由于人脸信息仅适用于约 41 41% 41 的测试数据集,因此这种模态只能正确识别约 18 18% 18 的测试数据集。

-

音频模态:为了处理音频,使用了基于 C N N CNN CNN 的方法,该方法基于[56]中描述的工作,其中语音音频被表示为 M e l Mel Mel 频率倒谱系数( M F C C MFCC MFCC ),并由 C N N CNN CNN 作为图像处理。使用 A d a m O p t i m i z e r Adam Optimizer AdamOptimizer 对音频和视频模型进行训练,学习率为 0.001 0.001 0.001 ,交叉熵函数作为损失函数。人脸模型用 22 22 22 个 e p o c h epoch epoch 训练,音频模型用 60 60 60 个 e p o c h epoch epoch 训练。 e p o c h epoch epoch 数的差异是由于人脸模型的过拟合。在音频模型的情况下,还使用了调度程序,这将学习率降低到 0.000001 0.000001 0.000001 。该模型的准确率为 0.58 0.58 0.58。

-

文本模态:选择用于处理从音频转录中获得的文本的模型基于[57]中提出的 D i a l o g X L DialogXL DialogXL ,与其他文本处理模型[58]相比,该模型获得了最先进的结果。然后将 D i a l o g X L DialogXL DialogXL 的输出传递给一个神经网络,其中每一层都包含对话感知的自注意和话语重复成分。最后一层使用密集神经网络( D N N DNN DNN )进行分类。由于预先训练的 D i a l o g X L DialogXL DialogXL 版本被设计为识别六种情绪,而使用的其他模型只能识别四种情绪,因此有必要进行一些调整。情感和快乐被合并,标记为恐惧的样本从训练和随后的融合中被省略。该模型的准确率为 0.84 0.84 0.84 。但是,由于文本信息仅适用于大约 80 80% 80 的测试数据集,因此这种模式只能正确识别大约 68 68% 68 的测试数据集。

对于每个单独网络的输出,通过考虑给定的样本,音频和面部网络的输出具有相同的格式-即样本所属类别的概率分布(在这种情况下,类别是考虑的四种情绪)。同时,这个文本网络样本的输出是一个 1 1 1 和 0 0 0 的向量,表示预测类别的位置值为 1 1 1,其余位置为零。当其中一个单独的模型不能做出预测时,为了融合的目的,输出被一个零向量代替。然后,将每个个体模态的输出作为输入传递给 E m b r a c e n e t + Embracenet+ Embracenet+ 方法进行融合,该方法最终将识别的情绪作为输出返回[47]。

- 融合方法的选择和试验

选择包括在每个领域显示良好性能的最先进的融合方法;这些在前面的第三节中有描述。

所有模型都使用 A d a m O p t i m i z e r Adam Optimizer AdamOptimizer 进行训练,学习率为 0.001 0.001 0.001 , b a t c h s i z e 为 32 batch size 为32 batchsize为32。除 D e e p F u s i o n DeepFusion DeepFusion 模型外,大多数模型都选择交叉熵作为损失函数。如[16]所述,本文选取的函数是整个网络的交叉熵损失之和和两个单独分量的熵损失(加权组合和相关模块)的加权和。对于每种方法的每种配置,从头开始重复训练过程 15 15 15 次。

即使在合并了兴奋和快乐并删除了一些不太有特色的类别之后,数据仍然存在不平衡。训练是通过给每个标签分配一个权重,并应用各自损失函数的加权版本来减轻不平衡的影响,以获得更准确的结果。

对于涉及 M L P MLP MLP ( M L P MLP MLP、注意力和张量融合模型)的网络,考虑的超参数是层数和每层神经元的数量。我们测试了这些超参数的不同组合,以确定哪种组合更适合我们的问题。对于像 D e e p F u s i o n DeepFusion DeepFusion 这样的模型,层数与其原始设计中指定的层数相同[16]。此外, D e e p F u s i o n DeepFusion DeepFusion 最后阶段的一些步骤被省略了,因为它们试图降低其子模块产生的向量的维数,并使向量的大小相等;两个模块都已经产生了 1 × 4 1 × 4 1×4 的向量。 D e e p F u s i o n DeepFusion DeepFusion 中唯一变化和测试的超参数是子模块的损失函数在最终加权和中的权重(作为损失函数)。

最后,所有训练过的模型都在其中一种模式缺失的数据集版本上进行评估。这样做是为了研究每种模式对最终结果的影响程度。

对于每个模型,我们依赖于准确性和f1得分指标(所有类别得分的加权平均值)来评估方法的质量和能力。

下一节将描述框架的最后一步。

5.EVALUATION AND COMPARISON OF RESULTS(评价和比较结果)

本节描述所选择的九种融合方法的比较评价的最后一步所获得的结果。结果对应于两种情况下的测试:(1)考虑所有可用的模态,(2)考虑总是缺少一种模态。在这两种情况下,都报告了准确性和 F 1 F1 F1 性能指标。

5.1 使用所有可用的模态

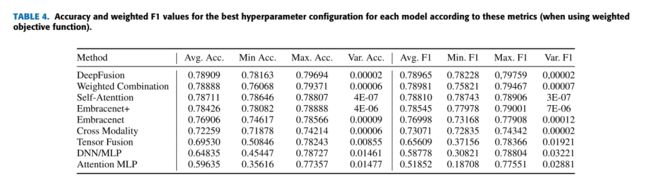

表 4 4 4 显示了使用加权样本的每种融合方法的最佳超参数配置的 a c c u r a c y accuracy accuracy 度量和 F 1 − s c o r e F1-score F1−score 。同样,表 5 5 5 显示了使用未加权样本的每种融合方法的最佳超参数配置的 a c c u r a c y accuracy accuracy 度量和 F 1 − s c o r e F1-score F1−score。

关于加权损失对训练的影响,大约有一半的方法使用该技术(加权组合、自我注意、 E m b r e n c e n e t + Embrencenet+ Embrencenet+、跨模态和 D e e p F u s i o n DeepFusion DeepFusion )在准确率或 F 1 − s c o r e F1-score F1−score 方面没有任何收益;对于未加权的目标函数,它们稍好一些。事实上,四种方法中的三种通过加权目标函数进行改进,严重依赖于 M L P s ( M L P S i m p l e , A t t e n t i o n M L P 和 T e n s o r F u s i o n ) MLPs (MLP Simple, Attention MLP和Tensor Fusion) MLPs(MLPSimple,AttentionMLP和TensorFusion) 。如第三节所述,张量融合和注意力 M L P MLP MLP 在实际将处理后的数据传递给 M L P MLP MLP 进行分类之前,使用了大量不涉及任何可学习参数的张量或矩阵乘法,这意味着对于这些方法,大部分学习都是由用于融合数据的简单 M L P MLP MLP 完成的。在 M L P MLP MLP 相关模型中,张量融合和 M L P MLP MLP 简单模型在准确率和 F 1 F1 F1 方面都是最有利的。这两种方法分别提高了 0.017 0.017 0.017 和 0.016 0.016 0.016,而 E m b a c e n e t Embacenet Embacenet 和注意力 M L P MLP MLP 分别只提高了 0.009 和 0.013 0.009和0.013 0.009和0.013 。

在对这些配置的训练模型的不同尝试中,这些方法在最佳和最差情况场景之间表现出高度的可变性和对比度。在最坏的情况下,一些模型的表现与最不准确的个体模态相似(换句话说,融合未能实现其目标)。在最好的情况下,这些模型提供的结果与 E m b r a c e n e t Embracenet Embracenet 的结果相似。如前所述,训练数据中存在明显的不平衡,并且由于这些基于 M L P MLP MLP 的模型似乎不具有机制,如加权组合或 E m b r a c e n e t Embracenet Embracenet ,故意帮助它们克服这一障碍,这可能是这些模型高度可变行为背后的原因。类权重(一种用于解释数据集中不平衡的技术)的使用减轻了这些模型结果中的可变性。最明显的是在 M L P MLP MLP 中,在最坏情况下, F 1 F1 F1 的准确率提高了 10 % 10\% 10% 和 12 % 12\% 12% 左右。在另一种情况下,[26]中的作者提到,他们的 M L P MLP MLP 分类器是根据每种模态给出的每个类的概率进行训练的(就像为这项工作测试的分类器一样),存在高度可变性的问题。

此外,平均而言, T e n s o r F u s i o n Tensor Fusion TensorFusion 和 M L P MLP MLP 分别没有达到[32]和[46]报道的结果质量。最有可能的是,这些方法并不适合用于单个模型的体系结构。这两个小组在他们的论文中使用的模型与这里使用的不同。此外,它们不会“融合”每个模态的结果;他们使用中间结果。这将输入空间改变为具有更少局部最小值的空间,其中数据集不平衡可能不代表问题。因此,它可以使训练网络达到最先进的结果变得更容易。

每种方法的代表性实例的验证集(训练完成后)的混淆矩阵如图3所示。由此,很容易确认导致 M L P MLP MLP 型模型数据不平衡的问题。 M L P ( 图 3 a ) MLP (图3a) MLP(图3a) 和 T e n s o r F u s i o n ( 图 3 d ) Tensor Fusion (图3d) TensorFusion(图3d) 从未分别分配 s a d n e s s sadness sadness 和 a n g r y angry angry 这两个类别,这两个类别在训练和验证数据集中都是最少出现的类别。更令人担忧的是注意力 M L P MLP MLP 的情况(图 3 e 3e 3e ),它从未将样本归类为属于中性(neutral)类别,尽管这在训练中是最常见的。这一点,再加上准确率和 F 1 F1 F1 的糟糕结果,使得这种方法根本不可取,至少对于这些模态和条件(即不平衡的数据集,类的数量等)的情感识别问题来说是不可取的。

至于其他方法,可以观察到一种模态,即快乐经常与中性混淆,在较小程度上,中性与快乐和悲伤混淆。关于前两种情况(快乐和中性),大多数混淆涉及这两个类别是正常的,因为它们在数据集中存在最多,因此,与其他类别相当的错误百分比转化为绝对错误数量更多。至于中性和悲伤的混淆,这可能是由于悲伤是训练集中存在率最低的类别,因此,方法可能无法调整其权重以正确区分某些边缘情况。

从表 5 5 5(未加权目标函数的结果)的值可以看出,从准确率和 F 1 F1 F1 来看, S e l f − A t t e n t i o n Self-Attention Self−Attention 是最好的方法,而从表 4 4 4 (加权目标函数的结果)来看, D e e p F u s i o n 和 w e i g h t e d C o m b i n a t i o n DeepFusion和weighted Combination DeepFusion和weightedCombination 分别在准确率和 F 1 F1 F1 上取得了最好的结果,尽管这两种方法在所有指标上的差异都很小。加权组合和 D e e p F u s i o n DeepFusion DeepFusion 的值之间的这种特别微小的差异引发了一个问题,即交叉模态对 D e e p F u s i o n DeepFusion DeepFusion 的贡献是否真的值得额外的计算,特别是在时间方面,因为它只提供了使用加权组合的微小改进,并且仅在某些指标上。这表明 D e e p F u s i o n DeepFusion DeepFusion 结果背后的关键因素是加权组合。

这些方法的成功可能是因为这些类型的方法所使用的质量因素或权重。正如第 I I I III III 节所解释的那样,自注意和加权组合背后的思想非常相似(加权组合的灵感来自于注意方法[16])。考虑到用于确定这些值的过程的简单性,很容易提供这些方法如何工作的可能解释:模态中使用的神经元以更高的精度学习由该模态预测的情绪,并输出更大的权重,这取决于分配给样本属于特定类别(情绪)的概率是否高,以及模型在识别情绪方面的精确度。尽管这些类型的方法可以归在“注意力”标签下,但在这项工作中,它们将被称为“质量因素”方法,以避免与注意力 M L P MLP MLP 混淆,后者获得了截然不同的结果。图 4 4 4显示了质量因子方法的更详细视图(特别是加权组合),其中分配给文本模态的权重对于 G R U GRU GRU 的输入向量至关重要,以便在很大程度上支持正确的情感。虽然这似乎是该机制工作原理背后的主要思想,但这个用例的一个潜在问题可能是文本模态将其结果表示为 0 0 0 和 1 1 1 的向量,而其他形式表示为更详细的概率分布,这可能会导致模型中的一些偏差。虽然加权组合方法在相当程度上提高了文本模型的准确率(考虑到完整的测试数据集时约为 10 % 10\% 10%),但如果我们观察测试数据集和获得的模型之一(具有超过平均准确率的模型),我们可以推断出这种差异来自文本模态缺失的样本。没有一种情况下,其他情态设法 “ c o r r e c t ” “correct” “correct”一个错误的预测从文本情态。这并不是说该方法不能使用较不准确的模态的结果来纠正较准确的模态,这将在下一节中展开。

5.2 只使用一些模态

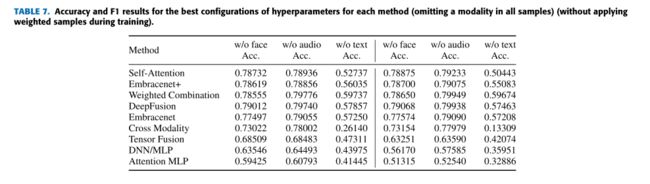

为了研究当一种模态缺失时这些模型的行为以及每种模态对最终分类器的重要性,之前训练的相同模型也在故意省略一种模态的测试数据集版本上进行了测试。表 6 6 6 显示了这些带有加权样本的测试的平均准确率和 F 1 − s c o r e F1-score F1−score,而表 7 7 7 显示了它们对应的未加权样本的平均准确率和 F 1 − s c o r e F1-score F1−score。当忽略音频或人脸模式( w / o w/o w/o 音频和 w / o w/o w/o 人脸,分别在表 6 6 6 和表 7 7 7 中)时,所有模型的性能与使用所有三种可用模态时相似;在许多情况下,省略其中一种模态可以得到更准确或更大的 F 1 F1 F1 值。这表明,这些模式对文本丢失或失败的样本的贡献大致相同,即使单个音频模型的准确率明显优于面部模型。

即使只在文本模态缺失的样本中比较这些方法的准确率,音频的准确性甚至高于人脸。对这一现象的解释是,当只考虑人脸和文本模态时,它们两者之间只覆盖了大约 88 % 88\% 88%的测试数据集,而只有音频模态具有数据集中每个样本的数据。这表明,当忽略音频时,对于每种方法,整个数据集的总体准确性可能会稍低一些。因此,当只考虑文本或人脸数据存在的样本时,文本模型的准确率为 0.75 0.75 0.75;因此,超过这个阈值的模型可以被认为是成功的,因为它们提高了可用的最佳单一模态的性能。

但是,当将这些结果与不存在文本模态时通过不同方法获得的结果进行比较时,可以注意到一个显著的差异:所有测试技术的所有指标都显着下降。最重要的是,有一种一致的比例感:在其他场景中具有优越结果的方法在这种情况下仍然具有优越结果,但有一个明显的例外,即交叉模态方法。从表 6 6 6 中可以看出,它的准确率下降了 56 % 56\% 56%,这不仅是这些实验中看到的最大的下降,而且,当将表 4 4 4 和表 5 5 5 分别与表 6 6 6 和表 7 7 7 进行比较时,我们可以注意到,当使用所有可用的模态时,交叉模态是第六好的方法(根据准确率),当缺少文本时,它是最差的方法。跨情态分析方法在进行预测时过分依赖语篇情态,无法弥补其不足。它似乎没有从其他模式中学到任何有价值的东西。就准确率和 F 1 − s c o r e F1-score F1−score 而言,其结果明显低于表现最差的个体模型和融合模型(其 F 1 F1 F1 几乎达到 0 0 0)。从表 6 6 6 中可以明显看出,当文本模态不可用时,这个问题仅限于跨模态。发生这种情况是因为文本输入的数据与其他文本相比具有不同的性质,还是因为数据集中的不平衡,或者仅仅是因为文本比其他文本更准确,这是一个有趣的问题,可以通过使用其他数据集测试此方法来回答。如果这种方法对更准确的模态产生了如此明显的偏见,那么它可能不适合野外环境,这是这种方法的最终目标,而且不同模态的数据经常丢失。

尽管有交叉模态的行为, D e e p F u s i o n DeepFusion DeepFusion 的结果并没有下降那么多,并且在使用所有模态时,与其他达到相似准确率和 F 1 F1 F1 水平的方法的比例大致相同。有两种可能的解释:跨模态对 D e e p F u s i o n DeepFusion DeepFusion 的结果没有显著的贡献(如第 5.1 5.1 5.1 节所述),或者跨模态,没有文本,是如此的有偏见,以至于 D e e p F u s i o n DeepFusion DeepFusion 可能会注意到这些偏见,并试图解释它们。如果 D e e p F u s i o n DeepFusion DeepFusion 做到了这一点,它可能能够从跨模态中获得更多有用的信息,而不是其低准确率所反映的。支持这一理论的一个事实是,当训练过程中不使用权重时,当缺少文本时,最佳跨模态配置是跨模态对损失函数有更大影响的配置,但当使用权重或省略其他模态(或不使用)时,最佳配置是加权组合具有更大影响的配置,或者两者对损失函数的贡献相等。

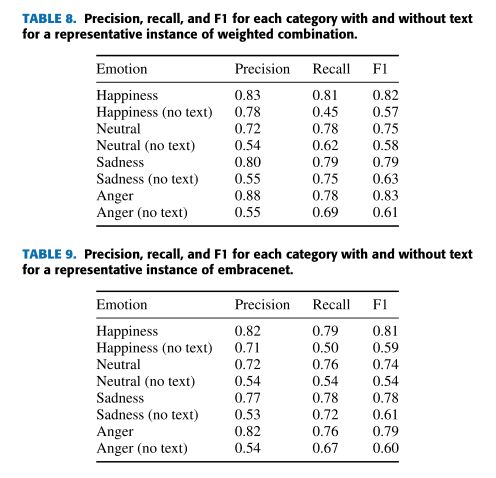

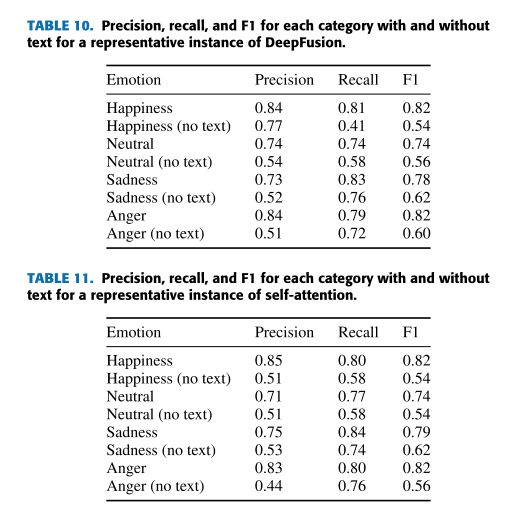

当从测试数据集中删除文本模态时,与使用的方法无关,悲伤和愤怒类别的精度( p r e c i s i o n precision precision )大幅下降,但其召回率( r e c a l l recall recall)并没有降低那么多。幸福的情况正好相反。总的来说,这可以解释为,在悲伤和愤怒类别中,假阳性的数量增加,而真实阳性的数量保持相似;在快乐类别中,真阳性的数量减少,而假阳性的数量保持相当的数量,正确的猜测仍然多于错误的猜测。似乎文本情态提供的信息是正确分类属于幸福类别的某些样本的基础,因为对该类别的预测数量显着减少,并且(大多数是错误的)转向其他类别(经常是悲伤和愤怒,这可以解释他们的精确结果)。表 8 8 8 、表 9 9 9 、表 10 10 10 和表 11 11 11 显示了使用和不使用文本模态时各种方法实例的 p r e c i s i o n 、召回率和 F 1 precision、召回率和F1 precision、召回率和F1。

在其他方面的适应性方面,加权组合和 E m b r a c e n e t Embracenet Embracenet 是最成功的。对于每一个被测试的模态组合,这些模型都成功地提高了可用的最佳模态的结果,或者至少等于它的性能:当文本模态存在时,它们在准确率和F1方面都获得了更好的结果。因此,音频是最可靠的模态, E m b r a c e n e t Embracenet Embracenet 得到了类似的结果,加权组合显著改善了它。即使最后一部分看起来不多,也可以从这些结果中推断出,在训练过程中,这些网络学习了一种“质量排名” ( q u a l i t y r a n k i n g ) (quality ranking) (qualityranking),这使它们能够确定样本中存在的哪种可用模态对最终分类更有帮助。

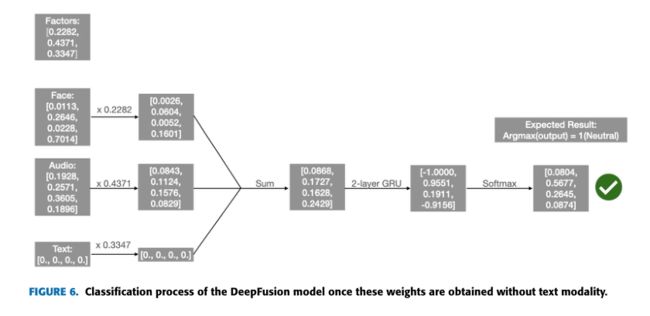

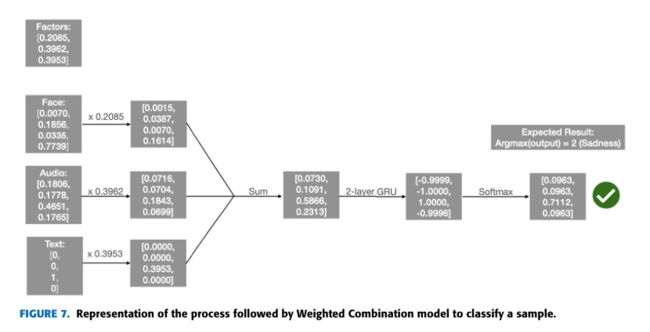

为了更好地理解这种“质量排序”机制是如何工作的,我们将更详细地分析使用加权组合对样本进行分类的过程。加权组合过程如图 5 5 5 所示(其中显示了计算质量因子的过程),图 6 6 6 (其中显示了使用质量因子对样本进行分类的过程)使用来自测试数据集的真实样本,删除了文本模态。从用于确定每个模态质量因子的神经元中的权重来看,人脸模态很难产生对 G R U GRU GRU 用于分类的最终向量有重大贡献的值,除非人脸模态预测的类别具有很大的确定性百分比。这些神经元的权重还有一个额外的目的:与其他神经元相比,它们的值似乎与模态的质量保持正比关系。这似乎可以让模型决定哪种模态对最终成为 G R U GRU GRU 输入的向量有更大的影响。例如,最不可靠的模态 f a c e face face 是其神经元中唯一具有负权重的模态,因此,它产生的质量因子将非常低。尽管在这种情况下,音频神经元的权重比文本神经元的权重大,但由于文本和音频向量格式的不同性质,文本模态仍然是最具影响力的。如图 7 7 7 所示,尽管音频的质量因子 ( 0.3962 ) (0.3962) (0.3962) 大于文本的质量因子 ( 0.3953 ) (0.3953) (0.3953),但应用质量因子后,文本模态的正确类别(悲伤,向量的第三个元素)的值为 0.3952 0.3952 0.3952 ,而音频为 0.1843 0.1843 0.1843,文本为 0.070 0.070 0.070。由于添加这些值只是为了确定 G R U GRU GRU 输入向量中类别的值,因此很明显,文本是对正确类别贡献最大的模态。

图 5 5 5 和图 6 6 6 还显示,这些质量权重并不是负责准确分类的唯一部分。在某些情况下,如上图所示, G R U GRU GRU 的输入向量似乎倾向于某种特定的情绪,但最终的输出却是另一种情绪。在回顾了这些事件对结果的影响程度之后,至少对于加权组合的研究实例,并且总是忽略文本模态,似乎有 168 168 168 个样本,其中所有可用的模态都表示一个类别,但最终的分类是另一个类别。这些变化中约有 59.5 % 59.5\% 59.5% 确实是适当的修正,这对结果产生了积极影响。在 168 168 168 个模态和最终分类器不一致的例子中,在 94 % 94\% 94% 的情况下, G R U GRU GRU 将样本归类为属于中性 ( n e u t r a l ) (neutral) (neutral) 类别,其他 6 6 6 个分布在愤怒和悲伤之间。尽管快乐是第二普遍的情绪, G R U GRU GRU 做出的这种改变从来不会产生快乐。这表明这种偏见只发生在最常见的类别上,与它们的数量不成比例。最有可能的是,当 G R U GRU GRU 的输入向量似乎不支持特定的类别时, G R U GRU GRU 已经学会了从具有更高概率的类别组中选择最常见的类别。在更平衡的数据集中,可能不会发生这种情况,或者可能对错误类别的更改数量减少,这将是理想的。

5.3 训练过程历史的可视化

本节通过每个模型的精度和损失曲线来可视化每个模型在学习过程中的行为历史。

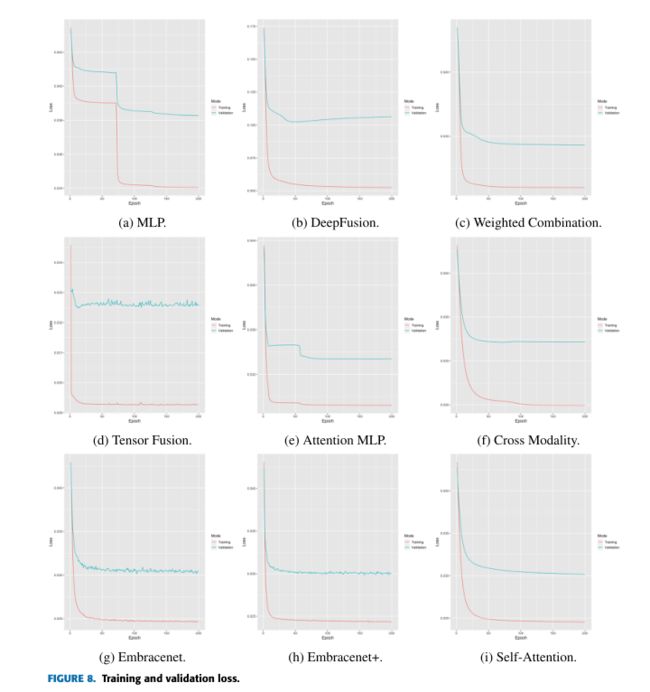

图8显示了每种融合方法的损耗曲线。像 M L P MLP MLP (图 8 a 8a 8a )和注意力 M L P MLP MLP (图 8 e 8e 8e )这样的方法可能会长时间陷入局部最小值。相比之下,其他方法,如加权组合(图 8 c 8c 8c )、自注意(图 8 i 8i 8i )和跨模态(图 8 f 8f 8f )的下降更平滑(尽管跨模态似乎有一个小的过拟合问题)。 T e n s o r F u s i o n Tensor Fusion TensorFusion(图 8 d 8d 8d )和 D e e p F u s i o n DeepFusion DeepFusion (图 8 b 8b 8b )的过拟合非常明显,可能使用更少的 e p o c h epoch epoch。最后, E m b r a c e n e t Embracenet Embracenet(图 8 g 8g 8g )和 E m b r a c e n e t + Embracenet+ Embracenet+ (图 8 h 8h 8h )显示了许多峰值,即使在几次迭代后它或多或少是稳定的。

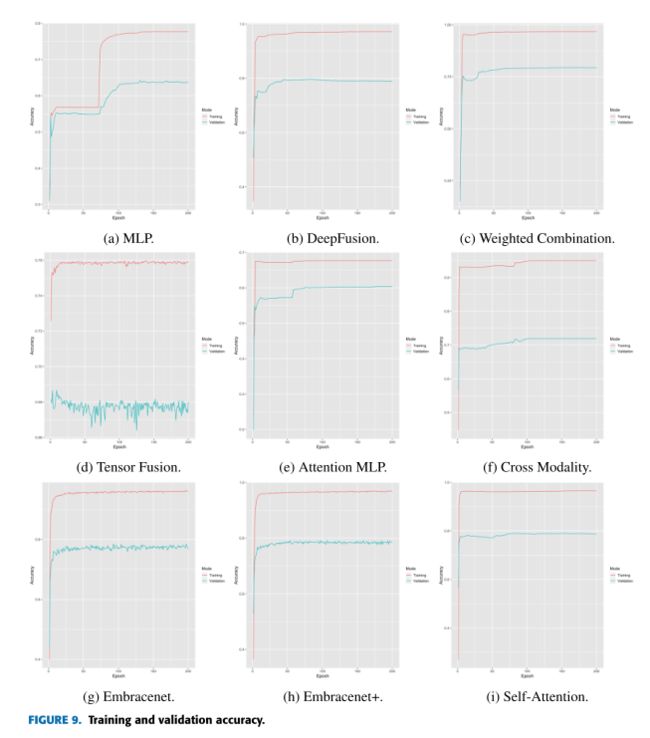

同样,图 9 9 9 显示了每种融合方法的精度曲线,它重申了图 8 8 8 中讨论的损失曲线的行为。在验证 a c c u r a c y accuracy accuracy 方面,张量融合方法(图 9 d 9d 9d )具有非常差的混沌行为,比损失函数(图 8 d 8d 8d )具有更多的峰值,这意味着该方法非常明智,损失值的微小变化会导致 a c c u r a c y accuracy accuracy 的较大变化。这与 D e e p F u s i o n DeepFusion DeepFusion (图 9 b 9b 9b )形成对比,根据损失值(图 8 b 8b 8b ),这似乎是一个明显的过拟合案例,考虑到 a c c u r a c y accuracy accuracy,这并不那么重要;这表明了一个更稳定的模型在 a c c u r a c y accuracy accuracy 方面,与张量融合相反。尽管 S e l f − A t t e n t i o n Self-Attention Self−Attention (图 9 i 9i 9i )和 W e i g h t e d C o m b i n a t i o n Weighted Combination WeightedCombination (图 9 c 9c 9c )的表现更好,但模型 A t t e n t i o n M L P Attention MLP AttentionMLP (图 9 e 9e 9e )的准确率曲线之间的差距最小。这并不像看起来那么好,因为可以看到,与 图 9 图9 图9 中的其他图相比,它是唯一一个训练 a c c u r a c y accuracy accuracy 低于 0.75 0.75 0.75 的图。还可以看到,在 E m b r a c e n e t Embracenet Embracenet (图 8 g 8g 8g 和图 8 g 8g 8g )的损耗和 a c c u r a c y accuracy accuracy 曲线中显示的峰值比 E m b r a c e n e t + Embracenet+ Embracenet+ (图 8 h 8h 8h 和图 9 h 9h 9h )的峰值更明显,其中 a c c u r a c y accuracy accuracy 的峰值比损耗的峰值小,这表明模型更稳定。这一事实,以及表 4 4 4 和表 5 5 5 所示的方差和 a c u u r a c y acuuracy acuuracy 结果证明, E m b r a c e n e t + Embracenet+ Embracenet+ 不仅实现了提高 a c c u r a c y accuracy accuracy (特别是当所有模态都存在时)和减少方差问题的目标,而且还创造了一种更稳定的方法。

5.4 平均评估时间

评估时间从被评估的融合方法接收到所有输入的时刻开始测量,直到它产生分类。通过这种方式测量时间,与单个模态相关的所有处理以及等待最慢的单模态模型完成的时间都发生在计时器开始运行之前,因此在此过程中花费的时间不会影响到时间测量。此外,由于在本研究中所有方法都共享相同的单峰架构,因此在此阶段花费的时间对于所有融合方法来说平均应该是相同的。真正的区别是在过程的融合阶段所用的时间。

与其他方法相比, M L P MLP MLP 的速度并不令人惊讶,它是一种相当直接的机制,记录这些时间的配置使用很少的神经元(两层 7 7 7 个神经元,第一个表是 4 4 4 个神经元中的一个,第一个表是 10 10 10 个神经元中的一个,第二个表是 4 4 4 个神经元中的一个)。它不执行任何类型的矩阵操作,如 T e n s o r F u s i o n Tensor Fusion TensorFusion 或 A t t e n t i o n M L P Attention MLP AttentionMLP,也不涉及在分类之前对每个模态进行额外处理,如 E m b r a c e n e t Embracenet Embracenet 或涉及计算质量因子的方法,因为它将接收到的向量连接起来,并开始直接处理它们,就像它们是一个一样。

令人惊讶的是,在质量因子方法中,自注意比加权组合要快得多,尽管它们的方法相似,甚至处理过程也相似。最合理的解释是,时间上的差异来自于每个分类器使用的最终分类器:加权组合使用由四个神经元组成的两层 G R U GRU GRU 网络,而自注意选择由四个神经元组成的单层网络。此外,加权组合还需要执行一些额外的步骤,例如 S o f t m a x Softmax Softmax 层来对得到的因子进行归一化。其他元素也可能起作用,例如一个方法将每个模态的向量连接起来,而另一个方法将它们相加。但是,加权组合分类器在概念上更复杂,使用的神经元数量是自注意分类器的两倍(尽管很少);在这种情况下,这是区分因素。

一个积极的结果是, T e n s o r F u s i o n Tensor Fusion TensorFusion 所花费的时间非常少,这与 A t t e n t i o n M L P Attention MLP AttentionMLP 不同,后者也是一种严重依赖于矩阵乘法的方法,在这一指标中表现最差。对这两种方法的性能进行更仔细的分析,很容易揭示为什么会有这种差异: T e n s o r F u s i o n Tensor Fusion TensorFusion只计算一个矩阵,然后乘以一个向量,而 A t t e n t i o n M L P Attention MLP AttentionMLP 必须计算三个矩阵,然后转置它们,并将每个矩阵乘以一个向量。注意 M L P MLP MLP 执行的这些操作非常慢,即使考虑到张量融合配置有一个包含 170 170 170 个神经元的 M L P MLP MLP 作为分类器,而注意 M L P MLP MLP 使用的四个 M L P MLP MLP 总共有大约 47 47 47 个神经元,张量融合是一个更快的方法。当然,由于执行这些乘法所需的操作数量作为这两个变量的函数而增长,因此只有在涉及的模态数量较少以及每个模态向量的维数减少的情况下,张量融合的速度才能得到强调。

显然, D e e p F u s i o n DeepFusion DeepFusion 和 E m b r a c e n e t + Embracenet+ Embracenet+ 是其他方法的组合(回想一下, E m b r a c e n e t + Embracenet+ Embracenet+ 使用了两个 E m b r a c e n e t Embracenet Embracenet )比它们各自的单独方法花费的时间更长。因此,这些低性能的模型不适合以响应时间为关键的环境。

5.5 关于结果的最后考虑

在仔细考虑了本节提供的不同结果之后,很明显,质量因子方法(深度融合,加权组合,自我关注)和 E m b r a c e n e t Embracenet Embracenet 可以被认为是成功的,因为它们改进了最佳个体模态(文本)的结果。当只使用该情态时,它们可以正确分类大多数正确分类的样本,但也可以正确分类许多文本信息不可用的样本。他们也一致地实现了这种类型的结果,这与基于 M L P MLP MLP 的模型( M L P s i m p l e , A t t e n t i o n M L P , T e n s o r F u s i o n MLP simple, Attention MLP, Tensor Fusion MLPsimple,AttentionMLP,TensorFusion )的性能形成了对比,这些模型不仅平均表现差得多,而且具有很高的可变性和稳定性问题,并且被证明对数据集中的不平衡问题非常敏感。在大多数情况下,跨模态在准确率和 F 1 F1 F1 方面都达到了可观的值,尽管略低于质量因子和 E m b r a c e n e t Embracenet Embracenet 和 E m b r a c e n e t + Embracenet+ Embracenet+ 方法,最重要的是,它对文本模态提供的信息有很大程度的依赖,这让人质疑该方法适应信息可能经常丢失的环境的能力。

E m b r a c e n e t Embracenet Embracenet 和 E m b r a c e n e t + Embracenet+ Embracenet+ 方法被提出来明确考虑处理来自不同模态的缺失信息的问题。结果表明,他们实际上达到了他们的目标(见表 6 6 6 和表 7 7 7 )。然而,质量因子方法,除了容忍缺失的模态,能够放大或减少每个模态的影响取决于每个模态的信息量。考虑到有更简单的机制可以获得比 E m b r a c e n e t s Embracenets Embracenets 更好的结果,无论是在使用每种模态时还是仅使用其中的一些模态时,以及这些方法,特别是 E m b r a c e n e t + Embracenet+ Embracenet+,在评估时间方面被证明特别慢的事实(这也使得它不适合用于处理的硬件资源非常有限的情况),似乎质量因子方法更可取。

在质量因素方法中,尽管 D e e p F u s i o n DeepFusion DeepFusion 在许多测试场景中都达到了最佳的准确率,但它使用跨模态作为其模块之一,并且考虑到该方法对单个模态的极端依赖性,直到进行进一步的实验来确定为什么会发生这种情况,至少在这种情况下,当某些模态缺失时,跨模态的低性能仍有可能影响 D e e p F u s i o n DeepFusion DeepFusion 在类似情况下使用该方法。此外,当 D e e p F u s i o n DeepFusion DeepFusion 的结果比加权组合的结果更好时,它们只是稍微好一点,这可能无法证明额外的计算是合理的( D e e p F u s i o n s DeepFusions DeepFusions 的评估时间大约是加权组合的两倍)。在加权组合和自注意之间,选择更为复杂:两者都取得了一些最好的结果,而且每一种都有其优点。自注意的方差非常低,这是稳定性的标志,它的平均评估时间证明它在处理样本时特别快,特别是与加权组合相比。但最后一种方法显示出对丢失模态的更好容忍度,因为当音频或文本丢失时(两种最准确的模态),它都具有更好的准确率和 F 1 F1 F1 值。当文本丢失时,它的结果比自注意的结果好 1 1% 1 ,这比这些方法之间通常的度量差异更大,并且表明对最准确模态的依赖程度更低。

决定哪一种方法是更好的方法是与一个人计划实施这些方法的背景和环境相关联的,因为这两种方法都被证明在使用面部、音频和文本进行情感识别的任务中是绰绰有余的。即使是在一个特定的领域,比如社交机器人,人们也应该考虑更多的细节来做出决定:加权组合可能更适合部署在有很多噪音和运动的大型活动中的机器人,比如派对或体育场活动,比如音乐会或体育运动,而自注意可能更适用于博物馆、图书馆甚至日常家庭生活,因为在这些环境中,信息可能不会经常丢失,因此,更好的响应时间可能比更好的对丢失模态的容受性更好。

由于所有模型都只在 I E M O C A P IEMOCAP IEMOCAP 数据集上进行了训练和测试,因此它们只在情感识别问题的单个变体上进行了测试(将不同的数据集视为不同的变体)。这限制了结论的范围,使得对情感识别问题的这些模型的行为进行概括变得更加困难。此外, I E M O C A P IEMOCAP IEMOCAP 数据是在受控条件下收集的,尽管该数据集历来在该研究领域非常有用[5],需要对"野外"数据集进行额外的测试,以确定当数据分布和其他因素(如缺失数据的百分比)更接近于部署多模态融合方法的应用环境(例如,与博物馆或医院的人员交互)中所期望的情况时,这种方法是否能够取得相当程度的成功。

此外,如第三节所述,选择用于融合方法的单模态架构与基于 R N N RNN RNN 的实现并不理想, R N N RNN RNN 融合了来自不同模态的数据,因为用于音频和文本的模型不会产生顺序输出。这种情况使得严重依赖循环网络的方法无法在本研究的比较中体现出来,尽管这些方法是针对该问题研究最多的方法之一[34],[35]。

6.总结

本文介绍了一种比较不同融合方法的策略。它特别允许在性能指标方面比较不同的融合方法,例如准确率、 F 1 − s c o r e F1-score F1−score、平均评估时间和训练过程中的行为。比较了九种方法( M L P s i m p l e 、 A t t e n t i o n M L P 、 D e e p F u s i o n 、 W e i g h t e d C o m b i n a t i o n 、 c r o s s − m o d a l 、 T e n s o r F u s i o n 、 E m b r a c e n e t 、 E m b r a c e n e t + 和 S e l f − A t t e n t i o n MLP simple、Attention MLP、DeepFusion、Weighted Combination、cross-modal、Tensor Fusion、Embracenet、Embracenet+和Self-Attention MLPsimple、AttentionMLP、DeepFusion、WeightedCombination、cross−modal、TensorFusion、Embracenet、Embracenet+和Self−Attention),以确定其中哪一种方法在情绪识别的背景下是最好的,以及它们的潜在用例。测试方法采用相同的实验条件,即选择相同的数据集( I E M O C A P IEMOCAP IEMOCAP )和单模态模型(人脸、音频和文本)。

为了评估模型对缺失模态的容忍度,考虑了两种情况下的实验:使用所有可用的模态和有目的地抑制其中一个模态的信息。从结果来看,使用质量因子(注意力的一种形式)的方法表现得更好,特别是加权组合和自注意,这些方法在不同场景中经常超过计算的指标。最合适的方法取决于使用它们的环境。自注意的显著稳定性和速度可能在某些情况下(如博物馆或小型聚会)更合适,但当模态缺失时(即使是最准确的模态)加权组合结果可能在其他模态缺失更频繁的情况下(如音乐会和体育赛事)更有用。此外,质量因子方法内部使用“质量排名”,这使它们能够确定哪种可用的模态信息最多,而基于 M L P MLP MLP 的方法对常见问题(如数据集不平衡或缺失模态)过于敏感。此外,结果表明,文本情态对最终分类是最重要的,因为它是唯一一个没有导致结果急剧下降的因素。

作为未来的工作,我们计划在一个更平衡的数据集上测试所研究的融合模型,以确定数据集中的不平衡对其性能的影响程度。此外,我们将在“野外”数据集上测试它们的情绪识别,因为 I E M O C A P IEMOCAP IEMOCAP 的数据是在实验室的受控条件下收集的。因此,我们将展示在非受控环境中部署这些方法的用处。