基于增强、恢复和融合的图像去雾:综述

摘要

雾霾通常对图像能见度造成严重干扰。图像的这种退化给人类观察者和计算机视觉系统都带来了麻烦。为了从退化图像中寻找高质量的图像,人们从图像增强、图像恢复、图像融合等不同角度提出了大量的图像去雾算法。特别是近年来,随着深度学习的快速发展,基于cnn的方法已经主导了图像去雾的主流,并在基准数据集上取得了重大进展。本文首先对现有的图像去雾方法进行了全面的综述,然后对有代表性的方法进行了定性和定量的比较,从经典方法到最近的先进方法。我们希望通过文献调查和基准分析可以帮助读者更好地了解现有除雾方法的优点和局限性。此外,还对单幅图像去雾的发展趋势进行了探讨,以创新进一步的工作。

1. 介绍

雾霾是一种大气现象,由灰尘、烟雾或其他气溶胶颗粒的积累引起的,它们掩盖了大气的清晰度。在雾霾环境下拍摄的图像通常会出现严重的质量退化,比如对比度低、细节丢失以及颜色褪色。对于人类观察者来说,在朦胧的环境中,远处内容物的可见性受到很大影响。同样,雾霾的存在也会在很大程度上影响现代计算机视觉系统,并导致假设在清晰条件下捕获所有视觉内容的视觉任务的性能不理想,例如图像分割[1 - 3],物体检测[4,5],人员再识别[6]。此外,在手术中,手术视野可视化中存在雾或烟会降低能见度,导致潜在的误操作,增加手术风险[3,7,8]。因此,开发应对雾霾效应的算法至关重要。

然而,在实际应用中,彻底去除真实图像中的雾霾效应具有很大的挑战。图像去雾的难点包括但不限于:(i)对多个物理变量的依赖。根据大气散射模型[9],雾霾造成的退化与多个难以准确估计的物理变量(即深度、大气光、散射系数)有很强的相关性。例如,雾霾的影响取决于场景中物体的深度,而深度估计是一项具有挑战性的任务,特别是对于单幅图像。大气光的估计常受到白色物体或彩色大气的误导。与其他简单的图像增强问题相比,图像去雾需要对场景有更深入的了解,才能准确地估计这些变量。(ii)有限的信息。在恶劣天气下,雾霾通常大面积广泛存在。因此,根据大气散射模型,距离相机较远的物体,或在密集雾霾下的物体,往往会遭受严重的退化。由于衰减效应,大部分原始信息已经丢失,被空气光所取代。这些有限的信息给忠实地恢复内容的外观带来极大的困难。(iii)病态的自然。大气散射模型定义的图像去雾问题在多变量存在的情况下存在严重不适定问题。因此,每个除雾问题都可能存在大量潜在的解决方案。如何添加适当的约束条件来处理病态,并从众多可能的解中获得最优结果是另一个棘手而又关键的问题。(iv)配对数据获取。近年来,数据驱动方法在解决低水平视觉问题方面取得了巨大进展。然而,成对雾霾数据的捕获受到天气条件的严重限制。除雾模型的训练很大程度上依赖于合成的配对数据,这限制了模型在真实场景中的表现。

到目前为止,已经提出了大量的图像去雾方法。当第一次进入这个研究领域时,人们可能会被文章淹没。因此,有必要对所提出的方法进行全面的调查和全面的评价,以帮助读者系统地了解图像去雾方法的发展及其优点和局限性。虽然已经有一些关于图像去雾的研究[10-16],但大多数都没有包含最近的基于深度学习的方法。最近进行的一些文献调查[12,17]综述了基于深度学习的图像去雾方法,但对调查方法的评价和相关比较不够全面。在本次调查中,我们从基于图像增强的方法、基于图像恢复的方法和基于融合的方法三方面对图像去雾方法进行了全面的文献综述。我们进行了大量的实验来评估它们在不同场景和指标下的表现。通过实验,我们发现,尽管许多基于深度学习的方法在合成图像上可以获得高性能,但与多年前提出的一些传统方法相比,它们在真实图像上的结果远不能令人满意。本文的主要贡献可以概括为:

- 本文综述了近200篇与图像去雾相关的论文,包括传统的和最新的基于深度学习的方法。

- 选取了19种具有代表性的图像去雾方法,进行了大量的实验。我们评估了它们在合成场景和真实场景下的去雾表现,并进一步研究了去雾结果对高水平视觉任务的影响。实验表明了现有方法的优点和局限性。

- 在调查和实验的基础上,对图像去雾的开放问题和未来发展趋势进行了探讨,希望能为进一步的研究提供创新。

本文的其余部分组织如下。第二节详细介绍了大气散射模型,帮助读者更好地理解恶劣天气造成的退化过程。第三节将现有的图像去雾方法归纳为三类,即基于图像增强的方法、基于图像恢复的方法和基于融合的方法。实验结果,广泛使用的数据集和指标,介绍在第4节。具体而言,为了衡量不同去雾方法的性能,我们对基准数据集进行了实验,并报告了定性和定量结果。此外,我们还比较了应用不同去雾方法后的目标检测精度。最后,我们总结了我们的调查,并在第5节中讨论了图像去雾的挑战和剩余的开放性问题。

2. 恶劣天气下的退化模型

恶劣天气造成的退化是由于大气中粒子的散射效应造成的。影响退化程度的决定因素可分为内部因素和外部因素。内因是指粒子的固有性质,包括主要类型、大小和密度。这些性质在不同的天气条件下变化很大,如表1所示,并导致雾霾在外观上的变化。以颜色投影color cast为例:天气好的时候,空气是清澈的,有细小的颗粒。在这种情况下,大气中的主要散射形式是瑞利散射,其强度与光波长的四分之一成反比。波长相对较短的蓝光被强烈散射。因此,天气好的时候天空看起来是蓝色的。对于雾霾天气,气溶胶广泛存在于大气中,主要引起Mie散射。Mie散射的强度与光的波长关系不大,在所以雾霾的颜色通常为白色或灰色。特定的太阳视角和粒子类型下,颜色也可以是黄色或棕色。而在有雾的日子里,大气中的水滴是无色的,所以雾的颜色取决于周围的光线。

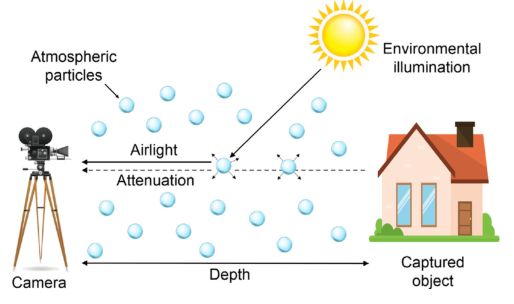

图1所示。大气散射模型的图解。

表1:不同的天气条件和相应的颗粒类型,大小和密度。(来自麦卡特尼[9])。

此外,一些外部因素也会影响雾霾效果,包括大气光和相机与被拍摄物体之间的距离。为了正式描述这些因素与雾霾效应之间的关系,McCarlney在1976年提出了基于Mie散射的大气光学模型[9]。如图1所示,本文模型由空气光散射模型和衰减模型两部分组成。具体来说,对于在恶劣天气下捕获的图像中的每个像素,两种光贡献了像素值。一是由于大气中粒子散射效应的存在,来自远处内容物的光被衰减。另一部分是物品沿视线向相机散射的光。

首先,我们讨论了衰减部分。如图2所示,我们假设从物体表面反射的一束光通过粒子介质并最终到达相机。对于特定类型的粒子,我们取厚度为![]() 的单位粒子介质,在波长

的单位粒子介质,在波长![]() 处被粒子衰减的光能量可表示为:

处被粒子衰减的光能量可表示为:

其中![]() 为衰减后的光强,

为衰减后的光强,![]() 为描述介质散射能力的散射系数。为了计算x = d处的衰减光强,我们可以将Eq.(1)从x = 0积分到x = d,得到如下表达式:

为描述介质散射能力的散射系数。为了计算x = d处的衰减光强,我们可以将Eq.(1)从x = 0积分到x = d,得到如下表达式:

其中Ed为衰减光强,E0为初始光强。

光的另一部分,增加了强度被称为空气光。空气光是指来自周围环境的衰减光,包括来自天空的直射光或漫射光和来自地面的反射光。如图3所示,单位体积内的所有粒子都可以看作一个光源。单位体积表示为:

其中dV是在一个圆锥体的立体角![]() 上的单位体积。

上的单位体积。

图2所示。衰减模型的图像。

图3所示。散射模型的图像。

与式(1)类似,空气光衰减强度的计算为:

![]()

其中k是一个常数,表示照明的性质。为了计算粒子dV在d = 0(观察者侧)处产生的衰减光照度,我们引入了点源光束的平方反比定律:

其中![]() 为点光源的强度。根据式(5),dV在d = 0时的光照度为:

为点光源的强度。根据式(5),dV在d = 0时的光照度为:

dV的辐射度计算公式为:

将Eq.(4)代入Eq.(7)可得:

![]()

然后对Eq.(8)从x = 0到x = d积分,得到从观察者侧到物体侧的总辐射度为:

![]()

通常,在室外朦胧的场景中,k替换为设d =∞为![]() 。 最后,我们得到了描述路径长度d的亮度的表达式:

。 最后,我们得到了描述路径长度d的亮度的表达式:

![]()

假设摄像机捕捉到的辐射强度与来自物体的衰减光和到达摄像机的空气光的总和成线性比例,其公式为:

![]()

式(11)中的第一项描述的是由于介质的散射,光被物体反射后的衰减,称为衰减。第二项表示介质对环境照明的散射,称为空气光。![]() 可用I(z)表示第z次观测到的雾霾强度。同理,设

可用I(z)表示第z次观测到的雾霾强度。同理,设![]() 表示物体的无霾强度,

表示物体的无霾强度,![]() 指大气光,

指大气光,![]() 表示传输,其中d(z)为第z像素的深度,我们得到以下简化公式来模拟恶劣天气下的退化:

表示传输,其中d(z)为第z像素的深度,我们得到以下简化公式来模拟恶劣天气下的退化:

![]()

式(12)是描述恶劣天气下退化最广泛采用的形式。由方程可知,模糊图像的退化程度与物体在场景中的深度密切相关。随着物体与相机/观察者距离的增加,物体反射光的衰减变得更加严重,混合空气光在最终观测强度中所占的比例会更大。结果,距离观测者的像素的潜在信息被严重遗漏或扭曲。

但是,式(12)有局限性,它不能很好地描述夜间雾霾图像、非均匀雾霾图像和水下雾霾图像的退化。对于夜间雾霾图像和水下雾霾图像,研究人员提出了更详细的模型,考虑了夜间额外的光源[18],或水下不同波长的光的散射效应[19]。

3.文献调查

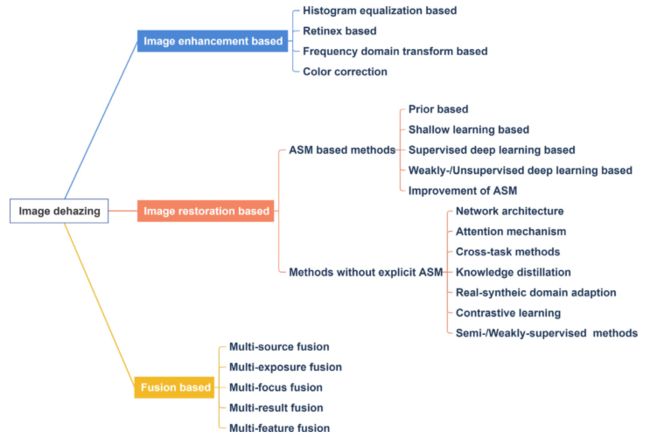

在过去的二十年里,人们提出了大量的图像去雾方法。根据如何建模去雾问题的原理,在本次调查中,我们将去雾方法分为三类:基于图像增强的方法、基于图像恢复的方法和基于融合的方法。

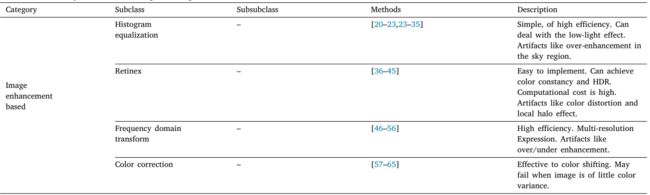

基于图像增强的方法主要是提高退化图像的视觉满意度。基于图像增强的方法不考虑图像退化的物理过程,而是旨在强调感兴趣的特征或提高图像的清晰度和可见性。例如,人们提出了许多方法来直接校正有偏差的图像统计值,包括压缩直方图分布、压强度和褪色颜色。基于图像恢复的方法将模糊图像按照物理模型从无雾图像中降级,多如式(12)。基于增强的方法与基于恢复的方法的主要区别在于,基于恢复的方法假设每个模糊图像都有一个干净的图像,其目标是忠实地恢复它。基于增强的方法旨在对模糊图像进行改进以获得更好的视觉质量。基于融合的方法不直接对模糊图像进行修改,而是将多个输入的有用信息重新组织和收集成高质量的模糊图像。具体划分如图4所示,各大类的描述如表2所示。

3.1. 基于图像增强的去雾方法

图像增强方法直接对模糊图像进行处理,以达到视觉满足。与基于图像恢复的方法不同,一般的图像增强方法很少考虑物理模型,判据通常是主观的。目前广泛采用的基于图像增强的方法包括直方图均衡化方法、基于视网膜的方法、基于频域的方法和基于颜色校正的方法。

图4所示。所调查的去雾算法的类别。

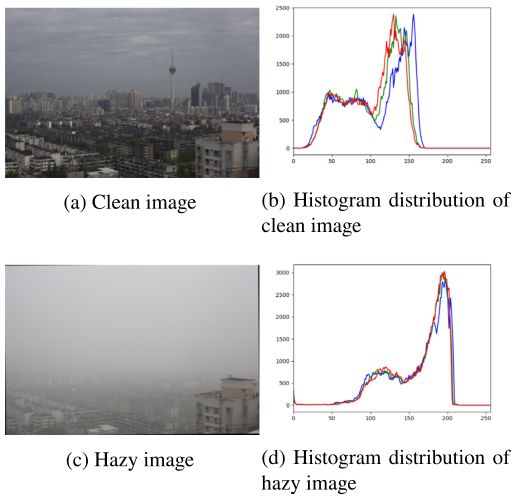

图5所示。晴天和雾霾天气下的同一场景,以及相应的直方图分布。图像选自BeDDE[164]数据集。

表2调查的图像去雾方法列表。

3.1.1. 基于直方图均衡的方法

图像直方图记录每个灰度级别的像素数。由式(12)可知,被雾霾降级后的图像中,强度有偏离原始值的趋势,并向大气光靠拢。因此,与无雾霾图像相比,雾霾图像的对比度降低,直方图分布变窄,如图5所示。直方图均衡化是一种简单而有效的图像增强算法,通常用于拉伸图像的对比度。对于图像去雾,基于直方图均衡化的方法可以进一步分为两类:通用直方图均衡化方法和基于专门直方图均衡化的图像去雾方法。

全局直方图均衡化(GHE)是一种主要和经典的算法,其目的是将缩小的直方图拉伸到更均匀的分布。这种程序可以表述为:

其中r为原始像素级别,T(r)为直方图均衡化后的像素值,ni是灰度水平i的像素数量,n是所有像素的数量。GHE是一种有效且易于实现的方法,但它直接从全局尺度调整所有像素,而不考虑局部亮度。因此,GHE不能增强局部的细节,有时会造成过亮的效果。

针对GHE的缺点,提出了一系列改进方案。Ketcham等人发明了局部直方图均衡化(local histogram equalization, LHE)[20],它对每个像素的相邻窗口进行直方图均衡化。但是窗口大小的选择不当会导致边界变化和局部区域压缩的影响。在[21]中,Dale-Jones和Tjahjadi p提出了自适应直方图均衡化(AHE),它将固定的窗口大小改变为每个像素的变量。Kim等[22]在AHE的基础上,对相邻的块进行重叠以减少块的影响,并采用时空自适应滤波来降低噪声。为了降低[22]中完全重叠的子块带来的高计算复杂度,Kim等[23]提出了一种非重叠的子块直方图均衡化。Celik和Tjahjadi[24]引入了2-D直方图,目的是最小化输入与均匀分布直方图差异的Frobenius范数之和。Wang和Ward[25]在概率分布函数(PDF)的原始计算基础上增加了加权和阈值操作,以克服伪像,并能够调整增强程度。

这些通用的基于he的方法能够提高退化图像的对比度,并可以通过去除雾霾效应来实现图像的重分级。但是,它们不是专门为处理雾霾图像而设计的,并且没有考虑到雾霾退化图像的特性。

为了更好地处理模糊图像中的缺陷,在HE的基础上,Z提出了各种具有具体设计的方法。hai和Liu[26]先剔除天空区域,然后采用修改后的部分重叠HE增强图像。Xu等人提出使用对比度限制自适应直方图均衡化(CLAHE)[28],即在AHE之前对图像直方图进行截取操作,以降低去雾图像中的噪声。为了进一步解决过增强和噪声产生的问题,一些研究将直方图均衡化和小波变换相结合。如Kim等人提出了CLAHE-DWT方法[29]对DCP脱雾结果进行后处理[69]。采用离散小波变换(DWT)将模糊图像分解为高频和低频分量,然后分别进行去噪滤波和锐化滤波。将转换回空间域的结果与CLAHE的结果进行融合,得到最终的增强图像。Jun和Rong[30]采用小波变换和调整近似系数的方法增强了CLAHE结果的边界。

此外,有些方法并没有明确地将HE作为处理步骤,而是将相对均匀的直方图分布作为优化目标。例如,一些著作提出了描述直方图均匀性的代价函数,并与其他项一起进行优化,以达到满足多个约束的最优值[31,32]。Qingsong et al[33]根据前景和背景分布对DCP结果的直方图进行划分和重建,然后应用直方图规范对重建的直方图[33]进行拟合。Chen等[34]结合HE和gamma校正作为双直方图修正,灵活调整去雾程度。最近Chi et al[35]采用1D Resnet从模糊直方图中预测增强直方图,最后通过直方图匹配和细化得到结果。

一般来说,基于直方图均衡化的算法实现简单,效率高。在大多数情况下,它们还可以处理真实朦胧场景中的弱光效果。然而,由于直方图均衡化直接操纵像素级统计,很少考虑语义信息,因此仍然存在一些像天空中过度增强这样的伪影。

3.1.2. 基于Retinex的方法

Retinex理论[165]是Land和McCann基于人类视觉系统(HVS)的特性提出的,即HVS具有在各种光照下识别物体真实颜色的能力。根据Retinex理论,观测到的图像可以表示为反射分量和照明分量的乘积,其公式为:

![]()

式中(⋅)表示逐元素的乘法,S(x, y)是捕获的图像,R(x, y)表示反射分量,I(x, y)表示照明分量。我们通常认为反射分量R(x, y)包含了图像的固有信息,而照明分量I(x, y)体现了环境照明。Retinex算法的目标是消除环境光照的影响,获得反射分量,从而达到增强图像的目的。

为了求解R(x, y),通常通过应用高斯核函数G(x, y)来估计照明分量。通过进一步对式(14)两边取对数并移动项目,我们得到:

![]()

其中*表示卷积运算。考虑到应用高斯核函数的尺度,Retinex算法可分为单尺度Retinex算法(SSR)[166]和多尺度Retinex算法(MSR)[167]。此外,Multi-scale Retinex with Color Restoration (MSRCR)[168]是一种基于MSR引入一个术语来校正偏色的算法。但是Retinex算法的一个主要缺点是没有充分考虑图像的局部特征。应用高斯核函数通常会模糊边界,导致光照估计过于平滑和不准确,并进一步导致局部细节的丢失和晕圈效应。为了解决这些缺点,Goa等[36]提出在图像的自适应尺度上采用MSRCR算法。Rong和Jun[37]采用SSR作为后处理步骤,从小波域进一步增强去雾结果。一些作品融合了Retinex算法和其他增强方法的结果,以更好地保留细节,摆脱颜色失真[38-40]。Wang等[41]提出了一种新的更符合HVS的图像质量度量方法来指导算法中参数的选择。采用非线性颜色转换[42]运算,设计了一种快速实现MSR的方法。

此外,Galdran等人证明,在雾霾图像强度为全局白平衡的假设下,Retinex对雾霾图像强度反向的结果等价于去雾结果[43]。一些方法结合Retinex算法和大气散射模型来解决去雾问题,[44,45]在YCbCr颜色空间的照明分量上应用SSR或MSRCR来估计透射图。

Retinex算法具有易于实现的优点,可以应用于低光增强、动态范围放大和单幅图像去雾等多种任务。但颜色失真、局部光晕效应以及较高的计算成本等问题仍有待进一步解决。

3.1.3. 基于频域变换的方法

图像通常由高频分量和低频分量组成。高频分量多对应于强度变化较快的区域,如图像中的边缘,而低频则相反,一般表示平坦或光滑的区域,如天空区域。在雾霾环境下,所有的成分都被均匀的大气光值衰减和增加。随后,高频分量严重消失,而低频分量大部分增加。从这个角度来看,可以通过提高高频分量和降低低频分量来增强雾霾退化图像。目前常用的方法主要有同态滤波方法[46,47]、小波变换方法[48,49]和曲波变换方法[50]。在这些方法中,小波变换更受欢迎,因为它效率高,在多分辨率下表达图像的能力更强[169]。

通过对图像进行小波变换,将图像分解为不同频率的子带。在频域上进行进一步的处理以达到不同的目的。如Liu等[48]提出分别去除低频部分的雾霾,自适应增强高频部分的纹理细节。Khan et al[51]估计了高频子带上的大气光,去除了低频子带上的密集雾霾。Anantrasirichai et al[49]采用双树复小波变换域的特征级融合来解决空间变化的失真问题。Zhang et al[52]使用快速小波变换平滑传输图,Khmag et al[53]使用第二代小波变换对估计的传输图进行细化,因为它的有效性和速度快。Busch和Debes[54]采用b样条[170]小波变换来测量雾场景中的能见度。一些工作将小波变换引入深度学习模型,Yang和Fu[55]用离散小波变换(DWT)和逆离散小波变换代替U-Net中的下采样和上采样操作来提取边缘特征。Yang et al[56]进一步提出了一种Y-net,反复使用DWT将图像分解成不同大小、尺度和频率的patch。在[56]中还提出了一种新的小波结构相似损失来计算不同斑块之间的累积SSIM损失。

3.1.4. 基于颜色校正的方法

除能见度下降外,雾霾图像的色散也是一个棘手的问题。自然界中的雾霾并不总是无色的,在特定的恶劣天气条件下,如雾霾天或沙尘暴,颗粒可能是彩色的,导致全球的颜色投射为黄色、灰色、粉红色或其他颜色。尽管Retinex算法是基于人类对颜色的感知来实现颜色恒定的,但香草Retinex算法的增强结果及其变体仍然受到局部颜色失真的影响。因此,许多作品将颜色平衡引入到他们的方法中来处理颜色转移问题。在色彩平衡算法中,灰色世界算法[171]假定自然图像上的平均颜色接近灰色(灰色世界假设,gray world Assumption, GWA),因其简单有效而被广泛采用。Huang等[57]将每个通道的强度与估计的空气光的平均强度之间的差值减去,以消除颜色失真。Dhara et al[58]将灰色世界算法专门应用于那些颜色变化的朦胧图像。Dudhane et al[59]利用估计的空气光与纯白色的比例对图像进行缩放,从而校正颜色。Ancuti和Ancuti[60]采用了shades-of-gray[61],由于其计算效率高,也是一种由灰色世界算法衍生而来的颜色平衡方法。Dudhane等[62]对CNN中提取的特征采用了基于GWA的色彩平衡进行图像杂色去雾。

此外,一些作品分析和处理了其他颜色空间上的颜色漂移问题。在[63]中,对HSV空间的饱和度分量进行了修改以稳定颜色。El Khoury等[64]通过分析IPT、LUV和LAB色彩空间上的图像,研究了不同去雾模型对图像颜色信息的影响。[65]提出了白平衡损失,该白平衡损失在LAB颜色空间中惩罚ground truth与去雾结果之间的最小偏差,以指导深度网络正确估计彩色空气光。

基于颜色校正的图像去雾方法可以有效地处理颜色漂移明显的模糊图像。然而,如果给定图像的颜色变化很小,基于颜色校正的方法可能无法修复颜色漂移。

3.2. 基于图像恢复的去雾方法

基于图像恢复的方法认为模糊图像是由无雾图像退化而来的。通常,这一类是指采用大气散射模型来描述降解过程的方法。然而,随着深度学习的推进,很多作品通过卷积神经网络端到端学习从模糊图像I(x)到干净图像J(x)的转换。这些方法没有明确考虑退化原因或物理模型,大多数方法只是简单地利用干净/清晰的图像作为模型训练的ground truth。随后,我们将其视为一种基于恢复的方法,从训练数据中隐式地构建和求解退化模型。

3.2.1. 基于ASM的恢复方法

大多数基于恢复的工作采用式(12)大气散射模型来描述降解过程。由于Eq.(12)所建模的图像去雾问题是不适定的,一些工作首先通过手工制作先验估计传输映射t(x),而另一些工作则采用学习方法从雾霾图像I(x)中预测传输映射t(x)和干净图像J(x)。

基于先验的方法:基于对雾霾图像的统计,近年来研究人员提出了各种先验来缓解单幅图像去雾的病态性[67,69,74,77,172]。

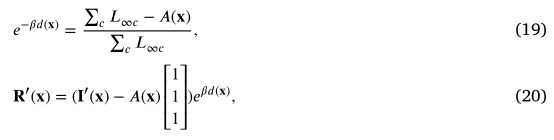

Fattal[66]基于物体表面阴影与透射图不相关的先验,提出了一种单幅图像去雾方法。具体来说,将未知的清晰图像J分解为表面反照率系数R与遮光系数L的乘积。然后R进一步分解为两个分量的和,分别平行或垂直于大气光的方向。因此,t(x)的估计表示为:

式中,![]() 为l2范数,

为l2范数,![]() 表示地表反照率与空气光相互关系的测量。〈,〉是3D内部生产,

表示地表反照率与空气光相互关系的测量。〈,〉是3D内部生产,![]() 分别是输入图像沿大气光向量A和残差向量R '的投影。然后对多反照率图像采用独立分量分析和高斯-马尔可夫随机场模型求解传输t(x)。但是对于雾霾较浓或者假设不成立的图像,性能会有明显的下降。

分别是输入图像沿大气光向量A和残差向量R '的投影。然后对多反照率图像采用独立分量分析和高斯-马尔可夫随机场模型求解传输t(x)。但是对于雾霾较浓或者假设不成立的图像,性能会有明显的下降。

在[67]中,Fattal基于对自然图像的观察提出了另一种方法,称为色线[173],该方法揭示了在自然图像中,局部patch中的像素在RGB空间中呈1D分布。

在一个小的patch中,模糊图像可以表示为:

![]()

其中t为局部补丁![]() 中的固定传输,

中的固定传输,![]() 为表面反射率。假设色线由

为表面反射率。假设色线由![]() 给出,其中

给出,其中![]() 是自由线参数,大气光(1−t)A与色线

是自由线参数,大气光(1−t)A与色线![]() 的交点沿A的距离为(1−t)。在实际计算中,交点通过以下被求解:

的交点沿A的距离为(1−t)。在实际计算中,交点通过以下被求解:

局部patch中的传输估计为t = 1−s。此外,采用基于拉普拉斯插值和Gauss–Markov随机场模型的正则化方法对粗传输进行了细化。

Tan从雾霾图像中总结了两点观测结果:(1)清晰图像的对比度通常高于雾霾图像的对比度;(2)大气光的变化在局部区域趋于平缓。基于这两个观察结果,文献[68]提出了一种最大化图像局部对比度的单幅图像去雾方法。具体来说,它首先对颜色进行类似白平衡的标准化,并将最亮的像素视为大气光。图像去雾问题在文献[68]中建模为:

![]() 表示每个颜色通道的值之和,

表示每个颜色通道的值之和, ![]() 表示由场景反射R(x)和输入图像I(x)分别进行归一化,该方法旨在寻找局部对比度最大的大气光A(x),定义为:

表示由场景反射R(x)和输入图像I(x)分别进行归一化,该方法旨在寻找局部对比度最大的大气光A(x),定义为:

∇是x轴和y轴上的一阶导数。计算在通道c上的局部窗口S中进行,通道c的大小通常设置为5 × 5。|⋅|表示绝对值。

在Markov随机场框架下对大气光进行估计,并采用图割法进行优化。该方法能够通过最大化局部对比度来恢复清晰的图像。但是,由于该方法没有考虑颜色恢复,结果可能会出现颜色失真。此外,由于操作是在局部窗口内进行的,在深度不连续的地方可能会出现晕轮效应。

在[69]中,He等人针对模糊图像提出了一种基于统计分析的简单有效先验,称为暗通道先验(Dark Channel prior, DCP)。DCP揭示,由于室外自然清晰图像色彩丰富且充满阴影,对于局部区域,除天空区域外,至少有一个通道强度非常低。所以在雾霾条件下,这些暗像素的强度主要是由大气光贡献的,可以用来估计透射图。形式上,DCP可以表示为:

![]()

其中![]() 是图像J的颜色通道。

是图像J的颜色通道。![]() 是以x为中心的局部patch。

是以x为中心的局部patch。![]() 是J的暗通道。对通道和局部patch分别进行两边的最小操作,式(12)等于:

是J的暗通道。对通道和局部patch分别进行两边的最小操作,式(12)等于:

![]() 始终为正数,将Eq.(22)代入Eq.(23),得到

始终为正数,将Eq.(22)代入Eq.(23),得到![]() 的表达式简单为:

的表达式简单为:

其中w的加入是为了给远处的物体保留更多的雾霾,以保持深度感。计算暗通道强度的patch大小设置为15 × 15。但在传播过程中仍然存在块效应block effects。在[69]中,he等人采用了软抠图算法[70]来细化传输图。但是,软抠图算法比较复杂,计算量大。在[174]中,He等人提出了一种具有非近似线性时间代价的有效的导引图像滤波方法,通常在DCP实现中采用该方法来代替软抠图。根据估计的传输图,场景亮度通过以下方法恢复:

引入透射的下界t0,使恢复后的J中至少保持少量的雾霾,以降低噪声。、

对于大气光的估计,[69]放弃了直接将全球最亮像素作为大气光。相反,搜索范围缩小到黑暗通道中最亮的前0.1%像素,以排除来自白色物体的像素。

DCP对于彩色户外图像特别有效。然而,当图像包含大面积的天空或其他白色区域时,DCP假设不成立,脱雾结果可能会失真或过度饱和。许多后续的基于dcp的工作提出了处理这一缺陷的方法。Yuan等[71]将分割结果与天空检测结果相结合,更好地识别天空区域。此外,提出了一种天空区域的自适应传输校正方法,以纠正天空区域的错误传输估计值。在[72]中,提出了一种新的特征patch map,自适应地选择DCP中的patch大小,以处理颜色失真,提高对白色场景的鲁棒性。将基于patch-map的DCP进一步嵌入到网络中,以提高雾霾去除性能。Golts等人[73]在提出的基于dcp的能量函数达到深度最优之前停止了优化。

另一种基于先验的图像去雾方法[74]是由Berman等人提出的,他们观察到无雾图像的颜色可以被几百种不同的颜色很好地近似[175],并且像素在图像中是非局部分布的。对于雾霾图像,由于集群中的像素是全局分布的,因此它们与相机的距离不同,因此从雾霾中获得的颜色也不同。因此,用于在无雾图像中聚集在一起的像素在雾霾图像的RGB空间中形成一条线,称为雾霾线。

算法首先将像素聚类为霾线,通过平移三维RGB坐标系,使大气光位于原点,再转换为球形坐标,定义![]() 为:

为:

![]()

其中r等于‖I−A‖,表示到原点的距离,![]() 和

和![]() 分别是经度和纬度。设

分别是经度和纬度。设![]() 为最大半径,粗糙的传递coarse transmission为:

为最大半径,粗糙的传递coarse transmission为:

然后,采用调节处理步骤对粗传输图进行平滑细化。与基于色线的方法相比[67],雾线是一种非局部先验,像素构成了分布在整个图像中的雾线,而色线先验只存在于局部斑块中。因此,先验不局限于像[67]这样的小patch,因此具有更强的鲁棒性和计算效率。

浅的学习:基于先验的方法建立在强有力的假设之上。一旦假设不成立,这些方法的性能将显著下降。一些研究转向将机器学习方法与ASM相结合,以建立一个更健壮的图像去雾模型。

早期的尝试利用浅学习模型,如随机森林[75],马尔可夫网络模型[76],或线性模型[77]。更具体地,在[75]中,Tang等人利用各种先验从朦胧图像中提取了一系列特征,包括多尺度暗通道、多尺度局部最大对比度、色相差异和多尺度局部最大饱和度。将这些与雾霾相关的特征输入到基于随机森林的回归模型中,以获得最终的传输估计。此外,通过对提取的特征进行观察,评价特征与模糊图像之间的相关性。然而,受限于目前的技术条件,难以获得整体的相对深度。因此,为了获得成对的训练数据,他们假设局部区域的深度是恒定的,合成的是雾霾斑块而不是整个图像。因此,在不考虑背景信息的情况下,仍然存在遮挡效应和噪声,特别是在重度雾霾情况下。

另一个代表性的工作是Zhu等人提出的颜色衰减先验(CAP)[77]。CAP假设深度与雾霾浓度正相关,这种关系用线性模型表示为:

其中x是位置,d是深度, ![]() 分别为模糊图像在HSV色彩空间中的亮度分量和饱和度分量。

分别为模糊图像在HSV色彩空间中的亮度分量和饱和度分量。![]() 是未知系数,

是未知系数,![]() 表示符合高斯分布的随机误差。根据[75]中的方法,由干净图像合成模糊图像。式(28)的最优参数是以监督的方式学习的,其值为

表示符合高斯分布的随机误差。根据[75]中的方法,由干净图像合成模糊图像。式(28)的最优参数是以监督的方式学习的,其值为![]()

![]() 输入场景的深度可由式(28)计算,然后用于恢复干净的图像。但是,由于从深度d估计透射率t时,散射系数

输入场景的深度可由式(28)计算,然后用于恢复干净的图像。但是,由于从深度d估计透射率t时,散射系数![]() 被设定为固定值

被设定为固定值![]() ,模型的灵活性受到限制。

,模型的灵活性受到限制。

用于去雾的浅学习模型通常只包含少量的可学习参数。因此,这些模型通常是轻量级和高效率的。然而,受参数数量的限制,这些模型的表示能力有限。它们的去雾能力通常弱于深度学习模型。

监督式深度学习方法:与浅层学习模型相比,深度学习模型具有更强的表示能力。早期将深度学习应用于除雾任务的工作大多基于ASM。在[78]中,Ren等人提出使用两种多尺度CNN模型从粗到细估计传播图。通过从透射图中最暗的0.1%像素中选择最高强度来估计大气光。利用估计传输图与地面真实传输图之间的MSE对模型进行优化,并基于纽约大学深度数据库[176]合成室内除雾数据集。[79]引入整体边来进一步增强[78]中的模型。[80]与[78]具有基本相同的模式,即学习从模糊图像中预测传输图,并使用先验在其网络中使用名为双边校正线性单元(brirelu)的新激活函数来估计A。在[81]中,Santra等人首先训练了CNN对雾霾和干净斑块进行分类。对于每个雾霾patch,通过不同的传输值t去雾获得一系列候选去雾patch,然后训练好的CNN通过二分搜索的方式选出最佳的去雾patch。

但是,分别用网络估计t和用先验估计A可能会导致误差的累积。在[82]中,Li等人重新表述了式(12),并提出通过估计K(x)来求解J(x), K(x)定义为:

因此,可以通过简单地估计K(x)来恢复干净的图像:

![]()

这样的设计避免了分别估计t(x)和A的累积误差。基于式(30),提出了一个端到端的轻量级AOD-Net,学习I(x)到K的映射,然后恢复场景亮度J(x)。[83,84]也采用了类似的设计,[83]采用了多尺度金字塔架构,[84]提出了特征级去雾的块。

Zhang和Patel还认为不联合估计透射图t(x)和大气光A可能会影响去雾效果,他们提出了另一种通过网络联合估计t(x)和A的范式[85]。在[85]中,他们使用密集连接的[86]编码器-解码器架构来估计t(x),并使用UNet来估计A。在[87]中,使用密集块来估计A和T。在[85,87]中还引入了GAN监督以恢复更精细的细节。在[88]中,对大气光A进行了分类估计,并通过先进的网络获取传输图t(x),其中雾霾情况从轻度到密集有序地监督不同阶段,使网络能够更好地处理各种雾霾情况。其他一些工作以迭代的方式估计组件。如Yang和Sun[89]建立了一个具有暗通道和传输先验的能量函数,设计了一个多级网络来模拟半二次分裂(half-quadratic splitting, HQS)算法迭代最小化能量的过程。Liu等人[90]将图像去雾定义为具有数据保真项和先验项的变分模型的最小化。提出了一种改进Gauss-Seidel迭代的梯度下降算法来求解变分模型,其中嵌入cnn,同时学习大气光A、透射图t(x)和清晰图像J的雾霾相关先验。另一篇论文[91]采用LSTM[177]的网络迭代更新t(x)和A的估计,可以更好地处理色散和浓雾。

一般来说,由于可学习参数的数量较多,深度学习模型的表示能力比浅层模型强得多。然而,基于普通ASM的去雾方法有时会导致局部模糊效应。此外,有些方法需要ground-truth传输t进行训练,收集时间较长。

弱/无监督深度学习方法:前面提到的基于ASM的恢复方法都是监督方法。事实上,许多弱监督和无监督方法都是基于ASM的解纠缠策略。Gandelsman等人[92]提出了使用两个DIP网络[178]进行图像分解的统一框架。它可以推广到单幅图像去雾任务,将去雾处理作为层分离问题,将模糊图像I(x)分为两层,分别为J(x)和a,混合掩模为t(x)。该网络通过包括重构损失、最小化两层梯度之间相关性的排除损失和处理非均匀大气光的正则化损失的组合来优化。另一种无监督去雾方法[94]使用三个子网络将模糊图像I(x)分解为J(x)、t(x)和A(x)。网络由损失函数联合训练为:

![]()

式中,![]() 为重构雾像与输入雾像之差的l2范数,

为重构雾像与输入雾像之差的l2范数,![]() 是解摆脱的disentangled和少量大气光之间的损失的组合,

是解摆脱的disentangled和少量大气光之间的损失的组合,![]() 是惩罚解纠缠disentangled J(x)的暗信道损失的项。另一个

是惩罚解纠缠disentangled J(x)的暗信道损失的项。另一个![]() 是正则化项,它约束A(x)和t(x)是光滑的。[95]扩展了[94]的思路,根据[77]的观察,进一步增加了一个损失项来惩罚解纠缠后的J(x)在HSV颜色空间中亮度与饱和度的差值。与[94]类似,一些采用非配对数据进行训练的弱监督方法[96,97]也将I(x)解到J(x), A和t(x)。不同之处在于使用了GAN监督来区分真正的干净图像和未配对的图像。在[97]中,这些组件是根据嵌入式DCP模块的结果估计的。有些方法采用循环一致性代替重构损失来保持内容的一致性。[98,99]通过网络估计t(x),通过先验估计A以实现去雾和再雾。但这些方法往往忽略了雾霾的物理特征,即雾霾随密度和深度的变化而变化。在[93]中,提出了一种同时考虑密度和深度信息的自增强未成对去雾框架来解决这一问题。这些弱监督或无监督方法能够解决去雾的配对训练数据难以获得的问题。然而,他们的优点也是他们的缺点。由于缺乏配对数据,其目标函数通常基于手工制作的先验[73,94,95]或GAN损失[96],不能作为配对数据提供强大的监督。当然,有监督方法与无监督或弱监督方法在性能上存在很大差距,特别是在合成朦胧图像上。

是正则化项,它约束A(x)和t(x)是光滑的。[95]扩展了[94]的思路,根据[77]的观察,进一步增加了一个损失项来惩罚解纠缠后的J(x)在HSV颜色空间中亮度与饱和度的差值。与[94]类似,一些采用非配对数据进行训练的弱监督方法[96,97]也将I(x)解到J(x), A和t(x)。不同之处在于使用了GAN监督来区分真正的干净图像和未配对的图像。在[97]中,这些组件是根据嵌入式DCP模块的结果估计的。有些方法采用循环一致性代替重构损失来保持内容的一致性。[98,99]通过网络估计t(x),通过先验估计A以实现去雾和再雾。但这些方法往往忽略了雾霾的物理特征,即雾霾随密度和深度的变化而变化。在[93]中,提出了一种同时考虑密度和深度信息的自增强未成对去雾框架来解决这一问题。这些弱监督或无监督方法能够解决去雾的配对训练数据难以获得的问题。然而,他们的优点也是他们的缺点。由于缺乏配对数据,其目标函数通常基于手工制作的先验[73,94,95]或GAN损失[96],不能作为配对数据提供强大的监督。当然,有监督方法与无监督或弱监督方法在性能上存在很大差距,特别是在合成朦胧图像上。

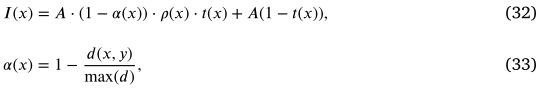

ASM的改进:除了探索不同的方法来解决ASM外,还有许多工作对大气模型进行了修改,以满足不同情况的要求。例如,Ju等人发现原始ASM在恢复结果中通常会导致暗淡的影响。为了解决这个问题,他们提出了一个增强大气散射模型(EASM),可以表述为:

其中![]() 为场景反射率,a(x)为反映ASM带来昏暗影响程度的光吸收系数,d为场景深度。与原有ASM相比,采用EASM可以增强弱光区域。然而,它可能会引入全局不光滑的照明,使结果在视觉上不真实。在[101]中,为了更好地恢复场景反射率,假设大气光是空间变化的,并以场景-聪明的的方式计算透射图以提高效率。Ju等人认为直接使大气光发生空间变异是不合理的,因为散射路径上的大部分悬浮粒子仍然暴露在大气光下。因此,直接衰减部分的大气光被细化为各个预先分割的独立场景之间不同的入射光。总的来说,改进ASM的方法有助于产生适当的照明和更少的色移。在大多数情况下,它们取得了较好的去雾效果,但在某些情况下,如黑暗地区,它们可能会放大雾霾效应。

为场景反射率,a(x)为反映ASM带来昏暗影响程度的光吸收系数,d为场景深度。与原有ASM相比,采用EASM可以增强弱光区域。然而,它可能会引入全局不光滑的照明,使结果在视觉上不真实。在[101]中,为了更好地恢复场景反射率,假设大气光是空间变化的,并以场景-聪明的的方式计算透射图以提高效率。Ju等人认为直接使大气光发生空间变异是不合理的,因为散射路径上的大部分悬浮粒子仍然暴露在大气光下。因此,直接衰减部分的大气光被细化为各个预先分割的独立场景之间不同的入射光。总的来说,改进ASM的方法有助于产生适当的照明和更少的色移。在大多数情况下,它们取得了较好的去雾效果,但在某些情况下,如黑暗地区,它们可能会放大雾霾效应。

3.2.2. 没有ASM的基于恢复的方法

许多方法没有显式地将ASM引入到它们的模型中。相比之下,这些方法直接学习从模糊图像I(x)到干净图像J(x)的映射。基于深度学习的方法以其强大的学习能力在这一领域占据主导地位。根据这些深度学习模型的特点,我们从几个方面介绍了现有的方法。

网络体系结构:由于深度网络具有很大的灵活性和潜力,许多工作都专注于修改网络架构以提高其去雾性能[103-107]。Zhang等人[103]提出了一种全端到端的去雾网络(FEEDNet),该网络通过扩张卷积来扩大接受野,通过密集的跳跃连接来融合特征。Qu等人[105]提出了增强块(enhanced block),对金字塔池化操作获得的多层特征进行处理和聚合。引入了多尺度鉴别器、感知损失[179]和特征匹配损失来增强细节。Dong等人[106]开发了一种基于SOS增强算法[180]的解码器,逐步恢复干净图像。[104]使用了由雾霾感知表示蒸馏(HARD)模块组成的多尺度架构,专注地融合全球大气亮度和局部空间结构。最近,有一些研究探索了视觉转换器(vision transformer, ViT)架构在图像恢复任务中的应用[108,181],并在去雾性能上取得了显著的提高。网络架构的设计是深度学习方法的基础之一。骨干网络体系结构的重要改进可以为许多计算机视觉任务带来广泛而显著的影响。(182 - 184)

注意力机制:注意机制使模型能够自适应地为感兴趣的特征分配更多的权重。在视觉任务中被广泛应用的注意机制形式主要有通道注意[185,186]、空间注意[187]及其混合形式[188]。在这些分类中,特征级注意多用于单幅图像去雾。特征或通道注意机制具有类似的结构,可以表述为:

式中,![]() 为第c个通道的通道注意权重,F1, F2为卷积或全连接层,

为第c个通道的通道注意权重,F1, F2为卷积或全连接层,![]() 为ReLU函数,

为ReLU函数,![]() 为Sigmoid函数,将输出映射到[0,1]范围内。在[109]中,为了提高效率,分别用深度卷积和点point-wise卷积代替F1和F2。有的模型通过串联[107]或并联[110]引入空间注意模块与通道注意模块连接,使网络集中在雾霾难以消除的区域。特征注意机制被广泛应用于去雾深度网络设计中,是提高去雾性能的有效工具[107,109-112]。

为Sigmoid函数,将输出映射到[0,1]范围内。在[109]中,为了提高效率,分别用深度卷积和点point-wise卷积代替F1和F2。有的模型通过串联[107]或并联[110]引入空间注意模块与通道注意模块连接,使网络集中在雾霾难以消除的区域。特征注意机制被广泛应用于去雾深度网络设计中,是提高去雾性能的有效工具[107,109-112]。

知识蒸馏:知识蒸馏的概念由Hinto等人提出[189]。它可以用于将知识从教师网络转移到更小的学生网络,实现模型压缩。为了实现单幅图像去雾中的知识蒸馏,除了保真度损失和感知损失外,[113]还使用了一个损失项,使学生网络模仿来自教师网络的直接特征,可以表述为:

其中![]() 为经过干净图像训练的教师网络在第m层的直接特征映射,

为经过干净图像训练的教师网络在第m层的直接特征映射,![]() 表示经过模糊图像训练的学生网络第n层的特征,g(⋅)是逐点卷积使通道数一致。[114-118]也采用了类似的设计。

表示经过模糊图像训练的学生网络第n层的特征,g(⋅)是逐点卷积使通道数一致。[114-118]也采用了类似的设计。

跨任务方法:此外,还有将单幅图像去雾与其他任务相结合的工作。Pei等[119]提出了一种联合去雾和分类的网络。[120]使用基于GAN和VAE的无监督图像到图像转换网络[190]同时进行图像去雾和合成。[127]设计了一个去雾网络和一个基于Faster r - cnn的[4]网络用于去雾和模糊物体检测。[121]引入了一种用于立体匹配和去雾的网络。[122,123]分别将视频去雾与语义分割和目标检测相结合。由于雾霾是一个退化因子,原来的高级别任务模型在雾霾场景下通常会出现性能下降。通过将这些任务与图像去雾相结合,高级任务可以提供更多的语义信息,从而更好地恢复图像,同时受益于图像去雾获得更高质量的输入。这种跨任务方法基本上可以提高图像去雾和其他子任务的性能。但是,跨任务方法还需要为其他子任务提供额外的训练数据。请注意[122,123]是基于ASM的,我们把它们放在这里是为了更清晰的显示。

对比学习:近年来,对比学习越来越受到表征学习的关注。对比学习的核心思想最早是由Hardsell等人在[191]中提出的,其目的是学习一个表示,在一些度量空间中拉正样本,推开负样本。对比学习极大地提高了现有计算机视觉任务的性能,特别是图像分类等高级视觉任务[192-194]。最近,研究人员也在探索在图像超分辨率[195]、图像脱影[196]、水下图像增强[197]、图像去烟[198]以及图像去雾[124]等低层次视觉任务中利用对比学习。

其中Gi表示固定预训练模型的第i个隐藏特征,D(x, y)是x和y之间的L1距离,wi是权重系数。实验证明,这种对比正则化可以提高几种去雾模型的视觉质量[106,107,112,113]。

真实合成域适应:

尽管基于深度学习的去雾方法已经显示出其巨大的去雾潜力,但研究人员注意到,在合成数据集上训练的去雾模型通常对真实的雾霾图像泛化能力较差。这种现象是由于合成训练数据与真实测试图像之间的差距引起的域偏移。为了提高对真实图像的泛化能力,Shao等[125]提出了一个域自适应框架,该框架由两个去雾模块和一个图像翻译模块组成。去雾模块去除合成域或真实域图像的雾霾,而翻译模块在合成域和真实域之间翻译图像以减少域差异。Yi等[126]引入了一种分两步执行域内自适应和域间自适应的去雾网络。具体而言,在域内阶段,对去雾损失较小的基特征进行整理,并使其他特征与基特征对齐,以缓解雾霾分布漂移。在域间相位方面,将真实域的特征与合成域的基特征对齐,以减小域间位移。Zhang等[127]根据雾霾密度将雾霾图像划分为不同的不同区域,并提出了一种密度切换模块,根据雾霾密度对特征进行处理。Chen等人[128]引入真实的雾霾图像,对已有的基于合成数据进行预训练的去雾模型进行微调。在[129]中,为了在合成数据集和真实数据集之间保持一致的性能,Sham等人引入了基于先验的对抗训练机制,该机制利用图像中的低频和高频成分来保留恢复图像中的颜色和结构信息。Li等[130]指出,室外数据集中用于合成雾霾的深度是不准确的,这是导致域移位的根本因素。为了解决这个问题,他们从高清3D电影中选择了高质量的真实户外场景。然后利用立体图像的深度来合成雾霾。

半/ 弱监督方法:

由于难以获得成对数据,一些方法试图以半监督或弱监督的方式训练去雾模型。半监督方法使用合成成对图像和真实的模糊图像来提高模型的泛化能力[125,128,131],而弱监督方法采用纯非成对数据(只有模糊/干净标签)来训练模型。为了实现非成对训练,一种常见的做法是应用GAN监督来训练翻译模块,将图像从源域翻译到目标域。由于没有可用的配对数据,因此需要一个保真项来保持输入和输出图像之间内容的一致性。上述一些方法采用解缠-重构策略,并引入重构损失作为保真项[96,97],而一些方法[132-134]采用周期一致损失[199],没有引入ASM。Anvari和Athitsos[132]使用全局和局部鉴别器来处理空间变化的雾霾。Engin等人[134]提出了一种循环感知损失来恢复更好的细节。Liu等[133]提出了一种感知深度损失(perceptual depth loss),惩罚输入的模糊图像深度与去雾图像深度之间的差异,并使用预先训练的网络来测量深度。半监督或弱监督方法可以在很大程度上降低获取成对数据进行训练的要求,但与全监督方法相比,通常去雾性能较低。

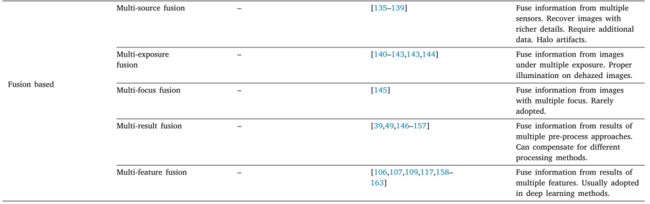

3.3. 基于融合的图像去雾

一般情况下,一张捕捉到的图像只包含现实世界场景的一部分信息。因此,来自多个来源的图像/数据通常比单一图像提供更丰富的信息。基于融合的方法旨在从多个输入源中提取和重组感兴趣或有用的信息,使之成为高质量的信息。基于融合的方法也被广泛用于去除雾霾,增强雾霾图像的对比度。根据输入源的类型,我们将基于融合的去雾方法分为多源融合、多曝光融合、多焦点融合、多结果融合和多特征融合。

3.3.1. 多源融合

多源融合主要是指用于融合的多个输入图像来自不同的传感器,如可见光图像与多光谱图像、热图像等。

根据[9],雾霾现象是波长依赖性的。波长较长的光受大气散射效应的影响较小。波长较长的光受大气散射效应的影响较小。结果表明,随着接收光波长的增加,雾霾水平从蓝色通道(450nm ~ 480 nm)开始降低,然后是绿色通道(500nm ~ 560 nm),最后是红色通道(605nm ~ 700 nm)。近红外光谱的光具有比可见光更长的波长(700nm ~ 1100nm),并且相对容易被数码相机与可见的RGB图像一起捕获。因此,许多方法都试图将可见RGB图像与近红外图像融合以消除雾霾。

Schaul等人[135]对可见光和近红外图像采用了一种带加权最小二乘优化框架的保边多分辨率分解方法[136]。然后采用像素级融合策略最大化局部对比度来实现融合结果。同样,Shibata等人[137]提出了一种融合算法来生成包含显著信息的图像。显著性也可以通过局部对比度来衡量。首先融合近红外和可见光图像的梯度信息。然后通过泊松图像编辑利用融合梯度构建亮度[138]。Kumar等人[139]根据RGB输入估计传输图,然后使用近红外图像与估计的传输图进行融合以进行细化。最后利用改进后的透射图恢复干净图像。Dümbgen等[200]计算了可见光和非红外图像之间的逐像素不一致性。在近红外图像中,由于融合阶段的反射导致图像强度较高,因此采用不一致掩模对图像细节进行衰减。

基于多源图像融合的去雾方法通常可以恢复细节更丰富的图像,但仍受限于对额外数据的要求。此外,根据融合策略的选择,这些方法可以引入局部晕伪影。

3.3.2. 多曝光融合

在摄影中,曝光是指在获取图像时到达图像传感器表面的光量。更高的快门速度和更大的光圈会导致更高的曝光,可以使捕捉到的图像更明亮。然而,对于数码相机来说,存在捕获的最高和最低强度之间的最大差异的限制,这个限制被定义为动态范围。对于包含复杂物体和照明的场景,光强的变化可能会超出动态范围,因此单次拍摄一定曝光并不能捕捉到场景中的所有内容。一个可选的解决方案是拍摄多张不同曝光设置的图像,然后将它们融合成一张图像。理想的融合结果应该具有自然的亮度,并包含捕获图像的所有显著内容。这种将不同曝光的多幅图像合并在一起的技术被称为多曝光融合(MEF)。

然而,目前应用数码相机拍摄的多曝光图像进行融合去雾的研究很少。一个原因是它需要多张图像作为输入,这限制了它更广泛的应用。另一个原因是,与多传感器融合不同,不同的曝光设置不能降低大气光的衰减和影响。事实上,在大多数实践中,多幅图像都是由单一的雾霾图像通过不同的处理步骤得到的,这些处理步骤通常包括消除雾霾的增强步骤。然后,多个结果具有不同的全局或局部亮度,这类似于捕获的多次曝光图像。因此,这种方法被归类为人工多曝光融合。

在[140]中,Galdran根据观察到Eq.(12)的解总是降低强度,提出将单幅模糊图像通过gamma校正生成一系列过曝图像,序列值![]() 满足

满足![]() > 1。融合策略简化了[141]中的方法,并考虑了对比度和饱和度。每个像素的对比度

> 1。融合策略简化了[141]中的方法,并考虑了对比度和饱和度。每个像素的对比度![]() 由其空间二阶导数测量,并由拉普拉斯滤波器实现。饱和度

由其空间二阶导数测量,并由拉普拉斯滤波器实现。饱和度![]() 由RGB通道的标准偏差测量。然后将饱和度和对比度相乘,计算融合的权重

由RGB通道的标准偏差测量。然后将饱和度和对比度相乘,计算融合的权重![]() ,可表示为:

,可表示为:

其中![]() 为第k张曝光图像在像素x处的强度,

为第k张曝光图像在像素x处的强度,![]() 为

为![]() 在颜色通道上的平均强度。后续[140,142]也采用了多张人工欠曝光图像进行融合。该方法首先降低曝光量,提高空间线性饱和度,得到一组对比度和饱和度增强的曝光不足图像。在此基础上,提出了一种具有较好边缘保持能力的基于斑块自适应结构的图像融合方法。此外,[142]证明了多次曝光融合得到的图像强度低于原始雾霾图像的强度。不同于使用不同

在颜色通道上的平均强度。后续[140,142]也采用了多张人工欠曝光图像进行融合。该方法首先降低曝光量,提高空间线性饱和度,得到一组对比度和饱和度增强的曝光不足图像。在此基础上,提出了一种具有较好边缘保持能力的基于斑块自适应结构的图像融合方法。此外,[142]证明了多次曝光融合得到的图像强度低于原始雾霾图像的强度。不同于使用不同![]() 值的gamma校正来生成多次曝光图像,Gao等人[143]在第一步估计了一个大气光范围,而不是单一的固定值。将各种预估的大气光结果转化为一系列亮度偏差的除雾结果。根据[201]提出的图像质量度量方法对结果进行排序,其中排名较低的图像使用LIME[202]进行优化。第二阶段选择使用与第一阶段相同的图像质量评估方法进行。选取高斯分布中评估得分高于

值的gamma校正来生成多次曝光图像,Gao等人[143]在第一步估计了一个大气光范围,而不是单一的固定值。将各种预估的大气光结果转化为一系列亮度偏差的除雾结果。根据[201]提出的图像质量度量方法对结果进行排序,其中排名较低的图像使用LIME[202]进行优化。第二阶段选择使用与第一阶段相同的图像质量评估方法进行。选取高斯分布中评估得分高于![]() 的图像作为融合图像。融合策略考虑了图像密集的SIFT图的局部对比度和曝光质量。Hong等[144]对具有各种恒定传输值的图像进行去雾处理,然后使用基于补丁的方法进行融合。Gao等[143]构造了一种双融合方法。首先采用DCP[69]估计粗传输图。然后采用改进的散斑减除各向异性模型(MRSAD)滤波器对雾霾图像进行降噪。采用多区域融合方法将粗传输图与滤波结果进行融合。针对DCP可能导致结果局部暗淡的问题,分别采用照度估计方法[202]和亮度约束函数[203]对直接去雾结果进行处理,然后融合在一起。

的图像作为融合图像。融合策略考虑了图像密集的SIFT图的局部对比度和曝光质量。Hong等[144]对具有各种恒定传输值的图像进行去雾处理,然后使用基于补丁的方法进行融合。Gao等[143]构造了一种双融合方法。首先采用DCP[69]估计粗传输图。然后采用改进的散斑减除各向异性模型(MRSAD)滤波器对雾霾图像进行降噪。采用多区域融合方法将粗传输图与滤波结果进行融合。针对DCP可能导致结果局部暗淡的问题,分别采用照度估计方法[202]和亮度约束函数[203]对直接去雾结果进行处理,然后融合在一起。

多曝光融合方法通过生成人工多曝光图像不需要多幅图像,在适当的光照条件下可以达到去雾效果。雾霾去除的彻底性很大程度上取决于人工多曝光输入的质量和融合策略的选择。

3.3.3. 多聚焦融合

在拍摄照片时,摄影师通常希望捕捉到所有内容都清晰呈现的图像。然而,与动态范围类似,相机也存在景深的限制。相机不能同时聚焦于场景中的所有内容。因此,在宽深度范围的拍摄图像中,通常只有部分内容是清晰的,而其余的内容由于失去焦点而模糊,特别是当内容位于不同深度时。多焦点融合技术是将聚焦在不同区域的图像融合成一幅清晰的图像来解决这一问题。

对于雾霾的去除,Gao等[145]提出了一种采用每个颜色通道的直方图分析来分割天空区域并估计空气光的方法。然后,引入自适应边界约束和快速局部拉普拉斯滤波来优化每个信道的传输。利用估计的每个通道的大气光和传输图,获得三幅候选图像。最后将其变换到YCbCr空间,其中Y通道采用多焦点融合方法在梯度域进行归一化[204],Cb和Cr通道根据其在三张候选图像中的权重进行融合。据我们所知,这是唯一一篇采用多焦点融合技术进行图像去雾的论文。此外,在多焦点融合中只采用了一个处理步骤。其输入图像不符合多焦点图像的典型特征。由此可见,多焦点融合在图像去雾方面的应用非常有限。

3.3.4. 多结果融合

上述类型的融合方法集中于处理特定类型的输入,如多曝光或多源图像。此外,也有许多方法采用不同的方法来处理单幅雾霾图像。一般来说,某种处理方法会在某些方面产生高质量的结果,而在另一些方面则存在缺陷。因此,来自多种处理方法的结果可以相互补偿。通过将这些结果融合在一起,可以获得更高质量的图像。我们把这种融合方法称为多结果融合。

在去雾的多结果融合中,一种常见的做法是融合来自多种方法的直接输出图像。例如,Ancuti等[146]对模糊图像进行了同时平衡和对比度增强处理。图像根据亮度、色度和显著性进行加权,然后在多尺度融合以避免晕晕伪影。与[147]类似,基于白平衡的最小-最大增强[205]的结果被融合在多尺度中,包括亮度、对比度、色度和显著性在内的四个权重图。Li等人[148]通过对模糊图像进行全局对比度增强和局部细节增强,在融合两幅图像时考虑了暗通道、清晰度和显著性。[39]在HSV和RGB空间上分别应用单尺度Retinex算法增强颜色和细节。结果的饱和度和亮度成分与手动设置的权重融合,而色调保持与原始图像相同。在[206]中,雾霾检测后,根据不同的透射值将图像分成几层,然后再将图像弧化。Anantrasirichai等[49]提出了一种基于双树复杂的(dual-tree complex)小波变换的区域级融合方法用于视频去雾,计算成本较低。Luo等人[149]提出了一种夜间去雾的方法,分别通过[207]恢复能见度和提高亮度,然后将结果融合以提高雾霾图像的照度。近年来有研究将CNN用于融合去雾。在[150]中,Ren等人首先分别从白平衡、对比度增强和伽马校正三种方法获取处理后的图像。然后将它们放入一个多尺度网络中,得到相应的权重图,进行进一步融合。采用MSE损失和对抗损失相结合的方法对网络进行优化。Gua等[151]从雾霾输入中导出了曝光图、显著图、伽马校正图、白平衡图和雾霾面纱图五种地图,并应用u型[182]网络进行融合。Deng等[152]引入了一种网络,首先从模糊图像中提取多尺度特征,然后将五种不同的构想formulations的恢复图像与估计的相应权重进行融合,得到去雾结果。而在[153]中,Park等人引入了融合CNN,融合合成图像训练的cGAN[208]分支的结果,以获得更精细的细节和更好的雾霾去除效果,融合未成对真实图像训练的CycleGAN分支的结果,以获得平衡的颜色和照明。除了直接融合处理后的图像外,有些方法首先从不同的方法获取传输图,然后将它们融合在一起。Guo等人[154]融合了基于asm的去雾方法的传输图,并改进了CLAHE以获得更精细的细节和平衡的颜色。Yuan等[155]首先用DCP[69]和AVC[207]计算了传播图。然后采用软分割方法,利用alpha通道对传输图进行融合。在[209]中,分别在RGB空间和YCbCr空间中应用两种网络对来自模糊图像的传输图进行了处理和估计。然后通过融合网对估计的传输图进行融合。

此外,还有一些基于补丁的去雾融合方法。Ancuti等[156]观察到基于块的方法在夜间的性能会受到所选补丁大小的很大影响,因此提出通过改变补丁大小来生成多个结果。然后,结果融合加权局部对比度,饱和度和显著性在多尺度的方式,以避免晕效应。在[157]中,基于提出的线性模型,将多尺度滤波结果有概率地融合成深度图。

3.3.5. 多特征融合

除了对图像进行融合,一些方法从模糊图像中提取多个特征,并应用进一步的处理和融合策略将其混合。大多数特征融合方法都是基于卷积神经网络,因为卷积神经网络自然地从轮廓和纹理等浅层捕获特征,到反映语义线索的深层,这为特征层的操作提供了很大的便利。

表3:图像去雾调查数据集列表。Syn表示合成的。人工雾霾是指由专业雾霾发生器产生雾霾的数据集。In和Out分别是indoor和outdoor的缩写。

Tan等人[158]提出了一种网络,该网络融合了轮廓编码的低级特征,以及通过扩张卷积提取的高级特征,然后对这些特征进行处理和解码,得到清晰的图像。Mei等[159]采用u型网络逐步融合编码器和解码器之间的特征,以更好地保留信息。Dong等[106]在反向投影算法[210]的基础上,引入了密集特征融合模块来补偿U-Net中编码器和邻接层中的信息损失。Dong等人[160]使用了一种鉴别器,将输入及其低频和高频信息融合在一起,以更好地区分真实和虚假的干净图像。

在[161]中,放置了门控融合模块,自适应地从浅到深融合特征,用于联合的joint去雨和去雾。[162]采用一系列跳跃连接的卷积块来融合模糊图像R、G、B通道的级联特征。在[109]中,设计了一个模块,从浅到深逐步融合由层提取的多尺度特征。Qin等人[107]提出了一种特征融合注意模块,其中来自不同阶段的特征被融合,然后在信道明智地和空间明智地两方面重新加权。[117]和[163]也采用了类似的设计。

图像级融合和特征级融合在应用场景上有区别。图像级融合需要多个输入图像或多个处理结果。通常要求整个算法框架以融合策略为核心。而特征级融合实现较轻,易于模块化,可用于除雾模型中提高性能,灵活有效。

5. 讨论及进一步工作

在第4节中,用合成图像去雾的全参考指标、真实图像去雾的非参考指标和去雾图像的目标检测精度来评估19种有代表性的方法。通过实验,我们可以得出以下几个结论:

- 实验表明,基于图像增强的去雾方法、基于图像恢复的去雾方法和基于图像融合的去雾方法表现出不同的特点。基于图像增强的方法可以拉伸对比度,去除雾霾,提高雾霾图像的可视性。它们对合成图像和真实图像都表现出相对稳定的性能,但其结果可能与真实的干净图像(如果存在)有偏差。对于基于恢复的方法中基于先验的方法,许多方法都可以对合成图像和真实图像去雾,但通常会给结果带来副作用。基于恢复的方法中基于学习的去雾方法,特别是监督方法,可以在与训练数据相似的合成图像上获得很高的性能,但在真实图像上表现有限。根据具体的设计,基于融合的方法可以产生在某些方面具有优势的结果。

- 引入物理模型可能有助于提高对真实图像的性能。实验表明,大多数对真实图像表现良好的方法都考虑了大气散射模型。如第1节所述,图像去雾问题是严重不适定的。引入大气散射模型相当于应用附加先验来更好地定义和约束问题,从而减小解空间中的搜索面积。因此,那些不考虑物理模型的方法更容易对训练数据进行过拟合,并且在真实样本上的泛化能力较差。

- 特征级融合可以有效地提高网络的表示能力。实验结果表明,HSTS数据集上的前2种方法均包含特征级融合和注意机制。然而,这些方法在推广到其他数据集时并没有优势。我们可以得出结论,在足够的训练数据下,特征级融合和注意机制可以提高性能,但对泛化能力的提高有限。

- 半监督有助于提高监督方法的泛化能力。除配对监督外,DADehaze[125]和PSD[128]进一步以半监督的方式将未标记的真实雾霾图像引入训练。在Test-B和Test-C上的实验表明,这些方法比单纯通过配对监督训练的去雾算法性能更好。这表明半监督可以作为成对监督的有效补充,提高其泛化能力。

此外,在调查和实验的基础上,我们指出图像去雾还存在许多有待进一步研究的问题,具体如下:

真实雾霾图像的去雾方法:在早期阶段,大多数常规方法都是为了消除真实环境中的雾霾。近年来,得益于基于监督深度学习的方法和大规模基准数据集的快速发展,人们提出了许多方法来对合成数据进行过拟合。这些方法通常在合成测试图像上具有很高的性能,但由于合成图像与真实图像之间存在固有的域差距,对真实图像的泛化能力较差。虽然已经做了一些尝试来缓解畴移问题[125,127,128],但根据实验比较,我们发现去雾结果的视觉质量远不能令人满意。此外,真实的雾霾图像去雾也可以看作是混合多因素退化的图像恢复。除了雾霾的影响,真实的雾霾图像通常受到噪声、曝光不足等因素的影响。考虑这些因素可以帮助生成具有更高视觉质量的结果。

有效的图像质量评估(IQA)措施:事实上,一些调查已经指出,不仅图像去雾迫切需要有效的IQA措施,其他低级别的任务也迫切需要IQA措施[241242]。常用的PSNR和SSIM与HVS不完全一致。VI和RI可以更忠实地评价除雾性能,但仍需要明确的参考,这在很大程度上限制了它们的应用。此外,最具挑战性和关键的一点在于开发更有效的非参考指标。近年来,人们越来越关注真实图像的去雾问题。然而,由于非参考指标与HVS严重不一致,评价很大程度上依赖于人的判断,这可能是主观的,具有极高的方差。一个有效的指标不仅有助于标准化评价,而且可以作为优化目标来辅助去雾算法的设计。

与高层任务的对接:我们实验中的Test-C验证了去雾算法能够提高目标检测的性能。然而,关于高级别任务目标是否有助于提高去雾性能的探索工作有限。Liu等人[243]已经验证了图像去噪可以从高水平视觉任务的联合训练中受益。但其对图像去雾的影响还有待进一步探索。

无监督和弱监督方法:在基于深度学习的方法中,有监督和无监督方法所占比例较小。与低光增强等恢复任务不同,雾霾的产生严重依赖于自然环境,而低光增强等恢复任务可以由人类很好地控制退化因子来构建真实的配对数据集。人工产生的雾霾与自然产生的雾霾仍然存在很大的差异。因此,建立一个高质量的成对真实数据集用于图像去雾是非常困难的。因此,迫切需要更有效的无监督和弱监督去雾方法来提高模型的泛化能力。

基于深度学习的去雾方法的实时实现:在实际的除雾应用中,常常要求除雾方法支持实时处理。然而,到目前为止,大多数图像去雾的实时实现都是基于传统的方法。具体来说,有些方法采用计算成本低的操作来减少处理时间[244 - 250],有些方法通过并行化,可以通过gpu加速来实现实时处理[251-253],还有一些方法设计基于硬件的实现来实现实时去雾[254-256]。相比之下,基于深度学习的实时去雾算法数量相对有限[82,162,257-259],特别是最近基于视觉转换器(ViT)的方法[108,181]。我们认为最先进的去雾算法的实时实现仍然是一个值得探索的趋势。

图像融合的进一步应用:在目前基于深度学习的研究中,融合方法很少被应用。然而,我们认为,要解决域漂移的问题,一个有效的解决方案是融合在合成图像和真实图像上训练的模型的结果或特征。此外,图像去雾的多曝光融合方法可以很好地处理真实图像去雾的曝光不足问题。基于多源融合的图像去雾方法在遥感图像处理中仍被广泛采用。从实验中我们可以看出,在任何情况下,没有一种去雾方法能够胜过其他方法。图像融合方法在结合多个结果、保留图像清晰部分、克服特定方法的不足等方面具有天然优势。我们认为基于融合的方法在图像去雾问题上仍有很大的应用潜