图像 跟踪 - MOTR: End-to-End Multiple-Object Tracking with Transformer (ECCV 2022)

MOTR: End-to-End Multiple-Object Tracking with Transformer - 使用Transformer进行端到端多目标跟踪(ECCV 2022)

- 摘要

- 1. 引言

- 2. 相关工作

- 3. 方法

-

- 3.1 目标检测中的查询

- 3.2 检测查询和跟踪查询

- 3.3 Tracklet-Aware标签分配

- 3.4 MOTR架构

- 3.5 查询交互模块

- 3.6 集体平均损失

- 3.7 讨论

- 4. 实验

-

- 4.1 数据集和指标

- 4.2 实施细节

- 4.3 MOT17的现状比较

- 4.4 DanceTrack的现状比较

- 4.5 多类场景的泛化

- 4.6 消融研究

- 5. 限制

- References

声明:此翻译仅为个人学习记录

文章信息

- 标题:MOTR: End-to-End Multiple-Object Tracking with Transformer (ECCV 2022)

- 作者:Fangao Zeng*, Bin Dong*, Yuang Zhang*, Tiancai Wang, Xiangyu Zhang, and Yichen Wei (*Equal contribution, **Corresponding author)

- 文章链接:https://arxiv.org/pdf/2105.03247.pdf

- 文章代码:https://github.com/megvii-research/MOTR

摘要

目标的时间建模是多目标跟踪(MOT)中的一个关键挑战。现有方法通过基于运动和基于外观的相似性启发法将检测关联起来进行跟踪。关联的后处理性质防止了视频序列中时间变化的端到端利用。

在本文中,我们提出了MOTR,它扩展了DETR[6],并引入了“跟踪查询”来对整个视频中被跟踪的实例进行建模。跟踪查询逐帧传输和更新,以随着时间的推移执行迭代预测。我们提出了tracklet-aware标签分配来训练跟踪查询和新生目标查询。我们进一步提出了时间聚合网络和集体平均损失来增强时间关系建模。DanceTrack上的实验结果表明,MOTR在HOTA指标上显著优于最先进的方法ByteTrack[42]6.5%。在MOT17上,MOTR在关联性能方面优于我们的同期作品TrackFormer[18]和TransTrack[29]。MOTR可以作为未来时间建模和基于Transformer的跟踪器研究的更强有力的基线。代码位于https://github.com/megvii-research/MOTR.

关键词:多目标跟踪,转换器(Transformer),端到端

1. 引言

多目标跟踪(MOT)预测连续图像序列中实例的轨迹[39,2]。大多数现有的方法将MOT时间关联分为外观和运动:外观方差通常通过成对的Re-ID相似性来测量[37,43],而运动则通过IoU[4]或卡尔曼滤波[3]启发式来建模。这些方法需要基于相似性的匹配来进行后处理,这成为跨帧时间信息流的瓶颈。在本文中,我们旨在介绍一种具有联合运动和外观建模特征的完全端到端的MOT框架。

最近,提出了用于端到端目标检测的DETR[6,45]。它将目标检测公式化为一个集合预测问题。如图1(a)所示,作为目标的解耦表示的目标查询被馈送到Transformer解码器中,并与图像特征交互以更新其表示。进一步采用了二部分匹配来实现目标查询和真值之间的一对一分配,消除了像NMS这样的后处理。与目标检测不同,MOT可以看作是一个序列预测问题。在端到端DETR系统中执行序列预测的方法是一个悬而未决的问题。

图1:(a)DETR通过将目标查询与图像特征交互来实现端到端检测,并在更新的查询和目标之间执行一对一分配。(b) MOTR通过更新轨迹查询来执行一组序列预测。每个轨迹查询表示一个轨迹。最好用彩色观看。

迭代预测在机器翻译中很流行[30,31]。输出上下文由隐藏状态表示,句子特征在解码器中与隐藏状态迭代交互,以预测翻译的单词。受机器翻译这些进步的启发,我们直观地将MOT视为序列集预测问题,因为MOT需要一组目标序列。每个序列对应于一个目标轨迹。从技术上讲,我们在DETR中扩展了目标查询,以跟踪用于预测目标序列的查询。轨迹查询作为目标轨迹的隐藏状态。轨迹查询的表示在Transformer解码器中更新,并用于迭代预测目标轨迹,如图1(b)所示。具体来说,跟踪查询是通过帧特征的自注意力和交叉注意力来更新的。更新后的轨迹查询被进一步用于预测边界框。一个目标的轨迹可以从不同帧中的一个轨迹查询的所有预测中获得。

为了实现上述目标,我们需要解决两个问题:1)通过一个跟踪查询来跟踪一个目标;2) 处理新生和终止目标。为了解决第一个问题,我们引入了tracklet-aware标签分配(TALA)。这意味着一个跟踪查询的预测由具有相同身份的边界框序列监督。为了解决第二个问题,我们维护了一个可变长度的跟踪查询集。新生目标的查询被合并到此集合中,而终止目标的查询则被删除。我们将这个过程称为入口和出口机制。通过这种方式,MOTR在推理过程中不需要显式的轨迹关联。此外,轨迹查询的迭代更新使得能够对外观和运动进行时间建模。

为了增强时间建模,我们进一步提出了集体平均损失(CAL)和时间聚合网络(TAN)。使用CAL,MOTR在训练期间将视频剪辑作为输入。MOTR的参数是基于为整个视频剪辑计算的总损失来更新的。TAN为跟踪查询引入了一种快捷方式,通过Transformer中的键-查询机制来聚合其先前状态的历史信息。

MOTR是一个简单的在线跟踪器。它很容易在DETR的基础上开发,只需对标签分配进行细微修改。它是一个真正的端到端MOT框架,不需要后期处理,例如在我们的同期工作TransTrack[29]和TrackFormer[18]中使用的跟踪NMS或IoU匹配。在MOT17和DanceTrack数据集上的实验结果表明,MOTR具有良好的性能。在DanceTrack[28]上,MOTR在HOTA指标上和在AssA指标上分别比最先进的ByteTrack[42]高出6.5%和8.1%。

总之,我们的贡献如下:

-

我们提出了一个完整的端到端MOT框架,名为MOTR。MOTR可以以联合的方式隐含地学习外观和位置的变化。

-

我们将MOT公式化为序列预测集的问题。我们从以前的隐藏状态生成跟踪查询,用于迭代更新和预测。

-

我们提出了tracklet-aware标签分配,用于跟踪查询和目标之间的一对一分配。引入了一种进出机制来处理新生轨迹和终止轨迹。

-

我们进一步提出了CAL和TAN来增强时间建模。

2. 相关工作

基于Transformer的体系结构。Transformer[31]首先被引入以聚合来自整个输入序列的信息,用于机器翻译。它主要涉及自注意力和交叉注意力机制。此后,它逐渐被引入许多领域,如语音处理[13,7]和计算机视觉[34,5]。最近,DETR[6]将卷积神经网络(CNN)、Transformer和二分匹配相结合来执行端到端的目标检测。为了实现快速收敛,Deformable DETR[45]在Transformer编码器和Transformer解码器中引入了deformable注意力模块。ViT[9]构建了一个用于图像分类的纯Transformer架构。此外,Swin-Transformer[16]提出了移位窗口方案,以在局部窗口内执行自注意力,从而带来更高的效率。VisTR[36]采用了直接的端到端并行序列预测框架来执行视频实例分割。

多目标跟踪。占主导地位的MOT方法主要遵循检测追踪范式[3,12,22,24,39]。这些方法通常首先使用目标检测器来定位每个帧中的目标,然后在相邻帧之间执行跟踪关联以生成跟踪结果。SORT[3]结合卡尔曼滤波器[38]和匈牙利算法[11]进行轨迹关联。DeepSORT[39]和Tracktor[2]引入了额外的余弦距离,并计算了轨迹关联的外观相似性。Track RCNN[26]、JDE[37]和FairMOT[43]在联合训练框架中进一步在目标检测器的顶部添加了Re-ID分支,结合了目标检测和Re-ID特征学习。TransMOT[8]构建了一个用于关联的时空图transformer。我们的同期工作,TransTrack[29]和TrackFormer[18]也为MOT开发了基于Transformer的框架。有关与它们的直接比较,请参阅第3.7节。

迭代序列预测。使用编码器-解码器架构通过序列到序列(seq2seq)预测序列在机器翻译[30,31]和文本识别[25]中很流行。在seq2seq框架中,编码器网络将输入编码为中间表示。然后,引入具有特定任务上下文信息的隐藏状态,并与中间表示迭代交互,以通过解码器网络生成目标序列。迭代解码过程包含多次迭代。在每次迭代中,隐藏状态对目标序列的一个元素进行解码。

3. 方法

3.1 目标检测中的查询

DETR[6]引入了一组固定长度的目标查询来检测目标。目标查询被馈送到Transformer解码器,并与从Transformer编码器提取的图像特征交互,以更新其表示。进一步采用二部分匹配来实现更新后的目标查询和真值之间的一对一分配。在这里,我们简单地将目标查询写为“检测查询”,以指定用于目标检测的查询。

3.2 检测查询和跟踪查询

在将DETR从目标检测应用于MOT时,出现了两个主要问题:1)如何通过一个跟踪查询来跟踪一个目标;2) 如何处理新生和终止的目标。在本文中,我们将检测查询扩展到跟踪查询。跟踪查询集是动态更新的,长度是可变的。如图2所示,轨迹查询集被初始化为空,DETR中的检测查询用于检测新生目标(T2处的目标3)。检测到的目标的隐藏状态产生下一帧的跟踪查询;分配给终止目标的轨迹查询被从轨迹查询集合中移除(T4处的目标2)。

3.3 Tracklet-Aware标签分配

在DETR中,一个检测(目标)查询可以被分配给图像中的任何目标,因为标签分配是通过在所有检测查询和真值之间执行二分匹配来确定的。而在MOTR中,检测查询仅用于检测新生目标,而跟踪查询则预测所有被跟踪的目标。在这里,我们介绍了tracklet-Aware标签分配(TALA)来解决这个问题。

一般来说,TALA包括两种策略。对于检测查询,我们将DETR中的分配策略修改为仅新生目标,其中在检测查询和新生目标的真值之间进行二分匹配。对于跟踪查询,我们设计了一种目标一致的分配策略。跟踪查询遵循先前帧的相同分配,因此被排除在上述二部分匹配之外。

图2:在一些典型的MOT情况下,检测(目标)查询和跟踪查询的更新过程。跟踪查询集是动态更新的,长度是可变的。跟踪查询集被初始化为空,检测查询用于检测新生目标。所有检测到的目标的隐藏状态被连接起来,以生成下一帧的跟踪查询。指定给终止目标的轨迹查询将从轨迹查询集中删除。

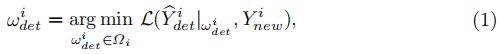

形式上,我们将跟踪查询的预测表示为 Y ^ t r \widehat{Y}_{tr} Y tr,将检测查询的预测指示为 Y ^ d e t \widehat{Y}_{det} Y det。 Y n e w Y_{new} Ynew是新生目标的真值。跟踪查询和检测查询的标签分配结果可以写成 ω t r ω_{tr} ωtr和 ω d e t ω_{det} ωdet。对于帧 i i i,从检测查询和新生目标之间的二分匹配中获得用于检测查询的标签分配,即,

其中 L \mathcal{L} L是DETR中定义的成对匹配成本,并且 Ω i Ω_i Ωi是检测查询和新生目标之间的所有二分匹配的空间。对于轨迹查询分配,我们合并了新生目标和上一帧中被跟踪目标的分配,即,对于 i > 1 i>1 i>1:

对于第一帧 ( i = 1 ) (i=1) (i=1),由于第一帧没有跟踪目标,因此跟踪查询分配 ω t r 1 ω^1_{tr} ωtr1是一个空集 ∅ ∅ ∅。对于连续帧 ( i > 1 ) (i>1) (i>1),轨迹查询分配 ω t r i ω^i_{tr} ωtri是先前轨迹查询分配 ω t r i − 1 ω^{i−1}_{tr} ωtri−1和新生目标分配 ω d e t i − 1 ω^{i−1}_{det} ωdeti−1的级联。

在实践中,由于Transformer中强大的注意力机制,TALA策略简单有效。对于每个帧,检测查询和跟踪查询被连接起来,并被馈送到Transformer解码器中以更新它们的表示。检测查询将仅检测新生目标,因为Transformer解码器中通过自注意力进行的查询交互将抑制检测跟踪目标的检测查询。这种机制类似于DETR中的重复删除,即以低分数抑制重复框。

图3:MOTR的总体架构。“Enc”代表卷积神经网络主干和提取每帧图像特征的Transformer编码器。检测查询 q d q_d qd和跟踪查询 q t r q_{tr} qtr的级联被馈送到Deformable DETR解码器(Dec)以产生隐藏状态。隐藏状态用于生成新生和被跟踪目标的预测 Y ^ \widehat{Y} Y 。查询交互模块(QIM)将隐藏状态作为输入,并为下一帧生成跟踪查询。

3.4 MOTR架构

MOTR的总体架构如图3所示。视频序列被馈送到卷积神经网络(CNN)(例如ResNet-50[10])和Deformable DETR[45]编码器中,以提取帧特征。

对于第一帧,不存在跟踪查询,并且我们仅将固定长度的可学习检测查询(图3中的 q d q_d qd)馈送到Deformable DETR[45]解码器。对于连续的帧,我们将来自前一帧的跟踪查询和可学习的检测查询的级联馈送到解码器中。这些查询与解码器中的图像特征交互,以生成用于边界框预测的隐藏状态。隐藏状态也被馈送到查询交互模块(QIM)中,以生成下一帧的轨迹查询。

在训练阶段,每个帧的标签分配如第3.3节所述。视频剪辑的所有预测都被收集到预测库 { Y ^ 1 , Y ^ 2 , … , Y ^ N } \{\widehat{Y}_1,\widehat{Y}_2,…,\widehat{Y}_N\} {Y 1,Y 2,…,Y N}中,并且我们使用第3.6节中描述的所提出的集体平均损失(CAL)进行监督。在推断时间期间,可以在线处理视频流,并生成每个帧的预测。

3.5 查询交互模块

在本节中,我们将描述查询交互模块(QIM)。QIM包括目标进出机制和时间聚合网络。

目标入口和出口。如上所述,视频序列中的一些目标可能在中间帧出现或消失。在这里,我们介绍在我们的方法中处理新生目标和终止目标的方式。对于任何帧,跟踪查询都与检测查询连接,并输入到Transformer解码器,从而产生隐藏状态(见图4的左侧)。

图4:查询交互模块(QIM)的结构。QIM的输入是由Transformer解码器产生的隐藏状态和相应的预测分数。在推理阶段,我们根据置信度分数保留新生目标和放弃退出目标。时间聚合网络(TAN)增强了长时间建模。

在训练过程中,如果匹配的目标在真值中消失,或者预测的边界框和目标之间的交并比(IoU)低于0.5的阈值,则去除终止目标的隐藏状态。这意味着,如果这些目标在当前帧消失,而其余隐藏状态保留,则相应的隐藏状态将被过滤。对于新生目标,基于等式1中定义的新生目标 ω d e t i ω^i_{det} ωdeti的分配来保持相应的隐藏状态。

为了进行推断,我们使用预测的分类分数来确定新生目标的出现和被跟踪目标的消失,如图4所示。对于目标查询,保留分类得分高于状态阈值 τ e n τ_{en} τen的预测,同时删除其他隐藏状态。对于跟踪查询,删除连续 M M M帧的分类分数低于退出阈值 τ e x τ_{ex} τex的预测,同时保留其他隐藏状态。

时间聚合网络。在这里,我们在QIM中引入了时间聚合网络(TAN),以增强时间关系建模,并为被跟踪目标提供上下文先验。

如图4所示,TAN的输入是被跟踪目标(目标“1”)的过滤隐藏状态。我们还收集来自最后一帧的跟踪查询 q t r i q^i_{tr} qtri,用于时间聚合。TAN是一个改进的Transformer解码器层。最后一帧的跟踪查询和过滤后的隐藏状态相加,成为多头自注意力(MHA)的键和查询组件。隐藏状态本身就是MHA的价值组成部分。在MHA之后,我们应用前馈网络(FFN),并将结果与新生目标(目标“3”)的隐藏状态连接起来,以生成下一帧的轨迹查询集 q t r i + 1 q^{i+1}_{tr} qtri+1。

3.6 集体平均损失

训练样本对于轨迹的时间建模很重要,因为MOTR从数据中学习时间方差,而不是像卡尔曼滤波这样手工制作的启发式算法。常见的训练策略,如在两帧内训练,无法生成长距离目标运动的训练样本。与之不同的是,MOTR采用视频剪辑作为输入。通过这种方式,可以生成长距离目标运动的训练样本用于时间学习。

我们的集体平均损失(CAL)不是逐帧计算损失,而是收集多个预测 Y ^ = { Y ^ i } i = 1 N \widehat{Y}=\{\widehat{Y}_i\}^N_{i=1} Y ={Y i}i=1N。然后通过真值 Y = { Y i } i = 1 N Y=\{Y_i\}^N_{i=1} Y={Yi}i=1N和匹配结果 ω = { ω i } i = 1 N ω=\{ω_i\}^N_{i=1} ω={ωi}i=1N来计算整个视频序列内的损失。CAL是整个视频序列的总体损失,通过目标数量进行归一化:

其中 V i = V t r i + V d e t i V_i=V^i_{tr}+V^i_{det} Vi=Vtri+Vdeti表示第 i i i帧处的真值目标的总数。 V t r i V^i_{tr} Vtri和 V d e t i V^i_{det} Vdeti分别是第 i i i帧的被跟踪目标和新生目标的数量。 L \mathcal{L} L是单个帧的损失,这类似于DETR中的检测损失。单帧损失 L \mathcal{L} L可以公式化为:

![]()

其中 L c l s \mathcal{L}_{cls} Lcls是聚焦损失[14]。 L l 1 \mathcal{L}_{l_1} Ll1表示L1损失, L g i o u \mathcal{L}_{giou} Lgiou是广义IoU损失[21]。 λ c l s λ_{cls} λcls、 λ l 1 λ_{l_1} λl1和 λ g i o u λ_{giou} λgiou是相应的权重系数。

3.7 讨论

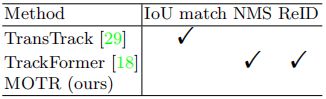

基于DETR,我们的同期工作TransTrack[29]和TrackFormer[18]也为MOT开发了基于Transformer的框架。然而,与他们相比,我们的方法显示出很大的差异:

TransTrack将完整轨迹建模为几个独立的短轨迹的组合。与检测再跟踪范式类似,TransTrack将MOT解耦为两个子任务:1)将目标对检测为两个相邻帧内的短轨迹;2) 通过IoU匹配将短轨迹与完整轨迹相关联。而对于MOTR,我们通过轨迹查询的迭代更新,以端到端的方式对完整轨迹进行建模,不需要IoU匹配。

TrackFormer与我们分享了跟踪查询的想法。然而,TrackFormer仍然在两个相邻的帧内学习。如第3.6节所述,短距离学习将导致相对较弱的时间学习。因此,TrackFormer采用启发式方法,如Track NMS和Re-ID功能,过滤掉重复的轨迹。与TrackFormer不同的是,MOTR通过CAL和TAN学习更强的时间运动,消除了这些启发式的需要。关于与TransTrack和TrackFormer的直接比较,请参见表1。

在这里,我们澄清一下,早在TrackFormer和TransTrack出现在arXiv上之前,我们就独立开始了这项工作。补充说,它们没有正式出版,我们将它们视为同期和独立的作品,而不是我们的作品所基于的先前作品。

表1:与其他基于Transformer的MOT方法的比较。

表2:用于评估的选定数据集的统计数据。

4. 实验

4.1 数据集和指标

数据集。为了进行综合评估,我们在三个数据集上进行了实验:DanceTrack[28]、MOT17[19]和BDD100k[41]。MOT17[19]包含7个训练序列和7个测试序列。DanceTrack[28]是最近的一个多目标跟踪数据集,具有均匀的外观和多样化的运动。它包含更多用于训练和评估的视频,从而为验证跟踪性能提供了更好的选择。BDD100k[41]是一个自动驾驶数据集,其MOT轨迹具有多个目标类。有关更多详细信息,请参阅数据集的统计数据,如表2所示。

评估指标。我们遵循标准评估协议来评估我们的方法。常见的指标包括用于评估多目标跟踪的高阶指标[17](HOTA、AssA、DetA)、多目标跟踪精度(MOTA)、身份切换(IDS)和身份F1分数(IDF1)。

4.2 实施细节

根据CenterTrack[44]中的设置,MOTR采用了几种数据增强方法,如随机翻转和随机裁剪。输入图像的短边的大小被调整为800,并且最大大小被限制为1536。在这个分辨率下,Tesla V100的推理速度约为7.5 FPS。我们使用随机间隔对关键帧进行采样,以解决可变帧速率的问题。此外,我们用概率 p d r o p p_{drop} pdrop擦除被跟踪的查询,为新生目标生成更多样本,并用概率 p i n s e r t p_{insert} pinsert插入假阳性的跟踪查询,以模拟终止的目标。所有实验都是在PyTorch上用8个NVIDIA Tesla V100 GPU进行的。我们还提供了一个内存优化版本,可以在NVIDIA 2080 Ti GPU上进行训练。

为了快速收敛,我们在Deformable-DETR[45]和ResNet50[10]的基础上构建了MOTR。批大小设置为1,并且每个批包含5帧的视频剪辑。我们使用AdamW优化器训练我们的模型,初始学习率为 2.0 ⋅ 1 0 − 4 2.0·10^{−4} 2.0⋅10−4。对于所有数据集,我们使用在COCO[15]数据集上预先训练的官方Deformable-DETR[45]权重初始化MOTR。在MOT17上,我们训练了200个时期的MOTR,学习率在第100个时期下降了10倍。为了进行最先进的比较,我们在联合数据集(MOT17训练集和CrowdHuman[23]验证集)上进行训练。对于CrowdHuman验证集中的~5k静态图像,我们应用[44]中的随机移位来生成具有伪轨迹的视频片段。视频剪辑的初始长度为2,我们分别在第50、90和150个时期逐渐将其增加到3、4、5。视频剪辑长度的逐渐增加提高了训练效率和稳定性。对于消融研究,我们在不使用CrowdHuman数据集的情况下在MOT17训练集上训练MOTR,并在2DMOT15训练集上进行验证。在DanceTrack上,我们在训练集上训练了20个时期,学习率在第10个时期下降。在第5、第9、第15个时期,我们逐渐将剪辑长度从2增加到3、4、5。在BDD100k上,我们在训练集上训练了20个时期,学习率在第16个时期衰减。在第6和第12个时期,我们逐渐将剪辑长度从2增加到3和4。

4.3 MOT17的现状比较

表3将我们的方法与MOT17测试集上最先进的方法进行了比较。我们主要将MOTR与我们基于Transformer的同期工作进行比较:TrackFormer[18]和TransTrack[29]。我们的方法获得了更高的IDF1分数,超过了TransTrack和TrackFormer 4.5%。MOTR在HOTA指标上的性能远高于TransTrack 3.1%。对于MOTA指标,我们的方法取得了比TrackFormer更好的性能(71.9%对65.0%)。有趣的是,我们发现TransTrack在MOTA上的性能优于我们的MOTR。我们假设TransTrack中检测和跟踪分支的解耦确实提高了目标检测性能。在MOTR中,检测和跟踪查询是通过共享的Transformer解码器学习的。检测查询在检测被跟踪目标时被抑制,限制了对新生目标的检测性能。

如果我们将其性能与其他最先进的方法(如ByteTrack[42])进行比较,就会发现在MOT17数据集上,MOTR远不如它们。通常,MOT17数据集上最先进的性能由具有良好检测性能的跟踪器主导,以应对各种外观分布。此外,不同的跟踪器倾向于采用不同的检测器来进行目标检测。我们很难公平地验证各种跟踪器的运动性能。因此,我们认为,仅凭MOT17数据集不足以充分评估MOTR的跟踪性能。我们进一步评估了DanceTrack[28]数据集上的跟踪性能,该数据集具有均匀的外观和不同的运动,如下所述。

表3:在私有检测协议下,MOTR与MOT17数据集上现有方法的性能比较。如果该数字是基于Transformer的方法中最好的,则该数字将以粗体标记。

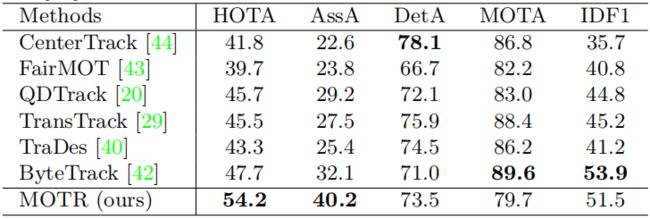

4.4 DanceTrack的现状比较

最近,引入了DanceTrack[28],一个具有均匀外观和多样化运动的数据集(见表2)。它包含更多用于评估的视频,并提供了验证跟踪性能的更好选择。我们在DanceTrack数据集上进一步进行了实验,并在表4中与最先进的方法进行了性能比较。这表明MOTR在DanceTrack数据集上取得了更好的性能。我们的方法获得了更高的HOTA分数,超过了ByteTrack 6.5%。对于AssA指标,我们的方法也比ByteTrack获得了更好的性能(40.2%对32.1%)。而对于DetA指标,MOTR不如一些最先进的方法。这意味着MOTR在时间运动学习方面表现良好,而检测性能则不那么好。HOTA的巨大改进主要来自于时间聚合网络和集体平均损耗。

4.5 多类场景的泛化

基于Re-ID的方法,如FairMOT[43],倾向于将每个被跟踪的目标(例如,人)视为一个类,并通过特征相似度来关联检测结果。然而,当被跟踪目标的数量非常大时,关联将是困难的。与之不同的是,在MOTR中,每个目标都表示为一个轨迹查询,并且轨迹查询集是动态长度的。MOTR只需修改分类分支的类数,就可以很容易地处理多类预测问题。为了验证MOTR在多类场景上的性能,我们在BDD100k数据集上进一步进行了实验(见表5)。在bdd100k验证集上的结果表明,MOTR在多类场景中表现良好,并且在较少的ID切换的情况下实现了良好的性能。

表4:在DanceTrack[28]数据集上,MOTR和现有方法之间的性能比较。现有方法的结果来自DanceTrack[28]

表5:MOTR与BDD100k[41]验证集上现有方法的性能比较。

4.6 消融研究

MOTR组件。表6a显示了集成不同组件的影响。将我们的组件集成到基线中可以逐步提高整体性能。由于大多数目标都被视为入口目标,因此仅将目标查询用作原始目标会导致大量IDs。通过引入跟踪查询,基线能够处理跟踪关联,并将IDF1从1.2提高到49.8。此外,在基线中添加TAN可使MOTA提高7.8%,IDF1提高13.6%。当在训练中使用CAL时,MOTA和IDF1分别提高了8.3%和7.1%。结果表明,TAN与CAL相结合可以增强时态运动的学习。

集体平均损失。在这里,我们探讨了视频序列长度对CAL中跟踪性能的影响。如表6b所示,当视频片段的长度从2逐渐增加到5时,MOTA和IDF1指标分别提高了8.3%和7.1%。因此,多帧CAL可以极大地提高跟踪性能。我们解释了多帧CAL可以帮助网络处理一些困难的情况,例如遮挡场景。我们观察到,被遮挡场景中的重复框、ID切换和目标丢失显著减少。为了验证这一点,我们在图5中提供了一些可视化。

表6:我方拟定MOTR的消融研究。所有实验都使用ResNet50中的单级C5特征。

擦除和插入轨迹查询。在MOT数据集中,有两种情况的训练样本很少:视频序列中的入口目标和出口目标。因此,我们采用跟踪查询擦除和插入来分别用概率 p d r o p p_{drop} pdrop和 p i n s e r t p_{insert} pinsert模拟这两种情况。表6c报告了训练期间使用不同 p d r o p p_{drop} pdrop值的表现。当 p d r o p p_{drop} pdrop设置为0.1时,MOTR可获得最佳性能。与入口目标类似,从预测为假阳性的前一帧传输的跟踪查询被插入到当前帧中,以模拟目标退出的情况。在表6d中,我们探讨了不同 p i n s e r t p_{insert} pinsert对跟踪性能的影响。当 p i n s e r t p_{insert} pinsert从0.1逐渐增加到0.7时,我们的MOTR在MOTA上获得了最高分数,当 p i n s e r t p_{insert} pinsert设置为0.3时,而IDF1分数正在下降。

目标入口和出口阈值。表6e研究了QIM中目标入口阈值 τ e n τ_{en} τen和出口阈值 τ e x τ_{ex} τex的不同组合的影响。当我们改变目标入口阈值 τ e n τ_{en} τen时,我们可以看到性能对 τ e n τ_{en} τen不那么敏感(在MOTA上在0.5%以内),并且使用0.8的入口阈值可以产生相对更好的性能。我们还通过改变目标退出阈值 τ e x τ_{ex} τex来进一步进行实验。结果表明,使用0.5的阈值会导致比0.6的阈值稍好的性能。在我们的实践中,0.6的 τ e n τ_{en} τen在MOT17测试集上表现出更好的性能。

采样间隔。在表6f中,我们评估了随机采样间隔对训练过程中跟踪性能的影响。当采样间隔从2增加到10时,IDS从209显著降低到155。在训练过程中,当帧以小间隔采样时,网络很容易陷入局部最优解。适当增加采样间隔可以模拟真实场景。当随机采样间隔大于10时,跟踪框架无法捕捉到这种长程动态,导致跟踪性能相对较差。

图5:CAL对解决(a)重复框和(b)ID切换问题的影响。顶行和底行分别是不带CAL和带CAL的跟踪结果。

5. 限制

MOTR是一款在线跟踪器,可实现端到端的多目标跟踪。由于DETR架构以及tracklet-aware标签分配,它以联合的方式隐式地学习外观和位置变化。然而,它也有几个缺点。首先,检测新生目标的性能远不能令人满意(MOTA指标的结果不够好)。如上所述,检测查询在检测被跟踪目标时被抑制,这可能违背目标查询的性质,并限制了对新生目标的检测性能。其次,MOTR中的查询传递是逐帧执行的,限制了训练过程中模型学习的效率。在我们的实践中,VisTR[36]中的并行解码无法处理MOT中的复杂场景。解决这两个问题将是基于Transformer的MOT框架的一个重要研究课题。

Acknowledgements:本研究得到了国家重点研发计划(编号:2017YFA0700800)和北京人工智能研究院(BAAI)的资助。

References

- CodaLab Competition - CVPR 2020 BDD100K Multiple Object Tracking Challenge (Jul 2022), https://competitions.codalab.org/competitions/24910, [Online; accessed 19. Jul. 2022] 12

- Bergmann, P., Meinhardt, T., Leal-Taixe, L.: Tracking without bells and whistles. In: ICCV (2019) 1, 3, 11

- Bewley, A., Ge, Z., Ott, L., Ramos, F., Upcroft, B.: Simple online and realtime tracking. In: ICIP (2016) 1, 3

- Bochinski, E., Eiselein, V., Sikora, T.: High-speed tracking-by-detection without using image information. In: AVSS (2017) 1

- Camgoz, N.C., Koller, O., Hadfield, S., Bowden, R.: Sign language transformers: Joint end-to-end sign language recognition and translation. In: CVPR (2020) 3

- Carion, N., Massa, F., Synnaeve, G., Usunier, N., Kirillov, A., Zagoruyko, S.: End-to-end object detection with transformers. In: ECCV (2020) 1, 3, 4

- Chang, X., Zhang, W., Qian, Y., Le Roux, J., Watanabe, S.: End-to-end multi-speaker speech recognition with transformer. In: ICASSP (2020) 3

- Chu, P., Wang, J., You, Q., Ling, H., Liu, Z.: Transmot: Spatial-temporal graph transformer for multiple object tracking. arXiv preprint arXiv:2104.00194 (2021) 4

- Dosovitskiy, A., Beyer, L., Kolesnikov, A., Weissenborn, D., Zhai, X., Unterthiner, T., Dehghani, M., Minderer, M., Heigold, G., Gelly, S., Uszkoreit, J., Houlsby, N.: An image is worth 16x16 words: Transformers for image recognition at scale. In: ICLR (2021) 3

- He, K., Zhang, X., Ren, S., Sun, J.: Deep residual learning for image recognition. In: CVPR (2016) 6, 10

- Kuhn, H.W.: The hungarian method for the assignment problem. Naval research logistics quarterly 2(1-2), 83–97 (1955) 3

- Leal-Taix´e, L., Canton-Ferrer, C., Schindler, K.: Learning by tracking: Siamese cnn for robust target association. In: CVPRW (2016) 3

- Li, N., Liu, S., Liu, Y., Zhao, S., Liu, M.: Neural speech synthesis with transformer network. In: AAAI (2019) 3

- Lin, T.Y., Goyal, P., Girshick, R., He, K., Doll´ar, P.: Focal loss for dense object detection. In: ICCV (2017) 8

- Lin, T.Y., Maire, M., Belongie, S., Hays, J., Perona, P., Ramanan, D., Doll´ar, P., Zitnick, C.L.: Microsoft coco: Common objects in context. In: ECCV (2014) 10

- Liu, Z., Lin, Y., Cao, Y., Hu, H., Wei, Y., Zhang, Z., Lin, S., Guo, B.: Swin transformer: Hierarchical vision transformer using shifted windows. arXiv preprint arXiv:2103.14030 (2021) 3

- Luiten, J., Osep, A., Dendorfer, P., Torr, P., Geiger, A., Leal-Taix´e, L., Leibe, B.: Hota: A higher order metric for evaluating multi-object tracking. IJCV 129(2), 548–578 (2021) 9

- Meinhardt, T., Kirillov, A., Leal-Taixe, L., Feichtenhofer, C.: Trackformer: Multi-object tracking with transformers. arXiv preprint arXiv:2101.02702 (2021) 1, 3, 4, 8, 9, 10, 11

- Milan, A., Leal-Taix´e, L., Reid, I., Roth, S., Schindler, K.: Mot16: A benchmark for multi-object tracking. arXiv preprint arXiv:1603.00831 (2016) 9

- Pang, J., Qiu, L., Li, X., Chen, H., Li, Q., Darrell, T., Yu, F.: Quasi-dense similarity learning for multiple object tracking. In: CVPR (2021) 11, 12

- Rezatofighi, H., Tsoi, N., Gwak, J., Sadeghian, A., Reid, I., Savarese, S.: Generalized intersection over union: A metric and a loss for bounding box regression. In: CVPR (2019) 8

- Schulter, S., Vernaza, P., Choi, W., Chandraker, M.: Deep network flow for multi-object tracking. In: CVPR (2017) 3

- Shao, S., Zhao, Z., Li, B., Xiao, T., Yu, G., Zhang, X., Sun, J.: Crowdhuman: A benchmark for detecting human in a crowd. arXiv preprint arXiv:1805.00123 (2018) 10

- Sharma, S., Ansari, J.A., Murthy, J.K., Krishna, K.M.: Beyond pixels: Leveraging geometry and shape cues for online multi-object tracking. In: ICRA (2018) 3

- Shi, B., Bai, X., Yao, C.: An end-to-end trainable neural network for image-based sequence recognition and its application to scene text recognition. TPAMI 39(11), 2298–2304 (2016) 4

- Shuai, B., Berneshawi, A.G., Modolo, D., Tighe, J.: Multi-object tracking with siamese track-rcnn. arXiv preprint arXiv:2004.07786 (2020) 3

- Stadler, D., Beyerer, J.: Modelling ambiguous assignments for multi-person tracking in crowds. In: Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. pp. 133–142 (2022) 11

- Sun, P., Cao, J., Jiang, Y., Yuan, Z., Bai, S., Kitani, K., Luo, P.: Dancetrack: Multi-object tracking in uniform appearance and diverse motion. arXiv preprint arXiv:2111.14690 (2021) 3, 9, 11, 12

- Sun, P., Jiang, Y., Zhang, R., Xie, E., Cao, J., Hu, X., Kong, T., Yuan, Z., Wang, C., Luo, P.: Transtrack: Multiple-object tracking with transformer. arXiv preprint arXiv: 2012.15460 (2020) 1, 3, 4, 8, 9, 10, 11, 12

- Sutskever, I., Vinyals, O., Le, Q.V.: Sequence to sequence learning with neural networks. In: NeurlPS (2014) 2, 4

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A.N., Kaiser, L., Polosukhin, I.: Attention is all you need. In: NeurlPS (2017) 2, 3, 4

- Wang, Q., Zheng, Y., Pan, P., Xu, Y.: Multiple object tracking with correlation learning. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 3876–3886 (2021) 11

- Wang, S., Sheng, H., Zhang, Y., Wu, Y., Xiong, Z.: A general recurrent tracking framework without real data. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 13219–13228 (2021) 11

- Wang, X., Girshick, R., Gupta, A., He, K.: Non-local neural networks. In: CVPR (2018) 3

- Wang, Y., Kitani, K., Weng, X.: Joint object detection and multi-object tracking with graph neural networks. In: 2021 IEEE International Conference on Robotics and Automation (ICRA). pp. 13708–13715. IEEE (2021) 11

- Wang, Y., Xu, Z., Wang, X., Shen, C., Cheng, B., Shen, H., Xia, H.: End-to-end video instance segmentation with transformers. In: CVPR (2021) 3, 14

- Wang, Z., Zheng, L., Liu, Y., Li, Y., Wang, S.: Towards real-time multi-object tracking. In: ECCV (2020) 1, 3

- Welch, G., Bishop, G., et al.: An introduction to the kalman filter (1995) 3

- Wojke, N., Bewley, A., Paulus, D.: Simple online and realtime tracking with a deep association metric. In: ICIP (2017) 1, 3

- Wu, J., Cao, J., Song, L., Wang, Y., Yang, M., Yuan, J.: Track to detect and segment: An online multi-object tracker. In: CVPR (2021) 11, 12

- Yu, F., Chen, H., Wang, X., Xian, W., Chen, Y., Liu, F., Madhavan, V., Darrell, T.: Bdd100k: A diverse driving dataset for heterogeneous multitask learning. In: IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) (June 2020) 9, 12

- Zhang, Y., Sun, P., Jiang, Y., Yu, D., Yuan, Z., Luo, P., Liu, W., Wang, X.: Bytetrack: Multi-object tracking by associating every detection box. arXiv preprint arXiv:2110.06864 (2021) 1, 3, 10, 11, 12

- Zhang, Y., Wang, C., Wang, X., Zeng, W., Liu, W.: Fairmot: On the fairness of detection and re-identification in multiple object tracking. IJCV pp. 1–19 (2021) 1, 3, 11, 12

- Zhou, X., Koltun, V., Kr¨ahenb¨uhl, P.: Tracking objects as points. In: ECCV (2020) 9, 10, 11, 12

- Zhu, X., Su, W., Lu, L., Li, B., Wang, X., Dai, J.: Deformable detr: Deformable transformers for end-to-end object detection. In: ICLR (2020) 1, 3, 6, 10