【实时图像融合:挤压分解网络:无监督:UIF】

SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion

(SDNet: 用于实时图像融合的多功能挤压分解网络)

本文提出了一种挤压分解网络 (SDNet),以实时实现多模态和数字摄影图像融合。首先,我们一般将多个融合问题转化为梯度和强度信息的提取和重构,并据此设计一种通用形式的损失函数,它由强度项和梯度项组成。对于梯度项,我们引入自适应决策块,根据像素尺度下的纹理丰富度来决定梯度分布的优化目标,从而指导融合后的图像包含更丰富的纹理细节。对于强度项,我们调整每个强度损失项的权重,以改变来自不同图像的强度信息的比例,从而可以适应多个图像融合任务。其次,我们将挤压和分解的思想引入到图像融合中。具体来说,我们不仅考虑从源图像到融合结果的压缩过程,还考虑从融合结果到源图像的分解过程。由于分解图像的质量直接取决于融合结果,因此可以迫使融合结果包含更多的场景细节。

介绍

由于硬件设备和光学成像的限制,通过单个传感器或在单个拍摄设置下获得的图像通常只能捕获场景中的部分细节。(略…)

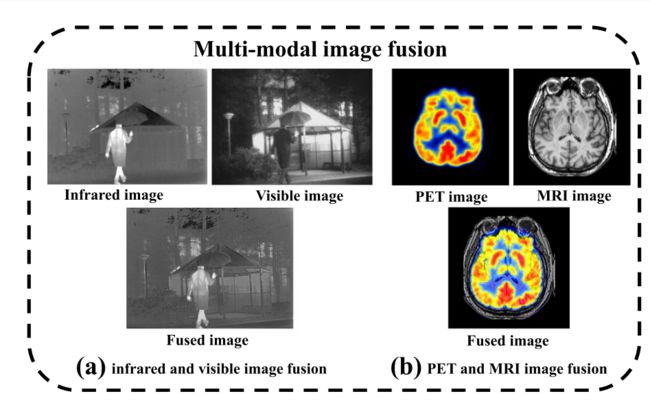

通常,根据源图像成像的差异,图像融合方案可以分为两类。

第一类是多模态图像融合。由于成像环境或设备性能等因素,有时单个传感器无法有效地描述整个场景。结合多个传感器进行观察是更好的选择。例如,正电子发射断层扫描 (positron emission tomography (PET)) 可以产生反映身体代谢状态的图像,而磁共振成像 ( magnetic resonance imaging(MRI) ) 可以提供器官和组织的优良结构纹理 。红外图像可以将目标与背景区分开,而可见光图像包含更多的纹理细节。

第二类是数码摄影影像融合。由于技术的限制,传感器通常无法在单个设置下对场景中的所有内容进行字符化。

具体地说,很难使不同深度场的所有对象都在一个图片内聚焦 。此外,图像有时会暴露于不适当的曝光,例如曝光不足和曝光过度 。在这些情况下,可以通过结合不同拍摄设置下的图像来更全面地描述场景。在图1中提供了一些示例,以更直观地说明这两种类型的图像融合场景。

尽管现有方法在大多数情况下取得了可喜的效果,但仍有几个方面需要改进。

首先,现有的传统方法通常需要手动设计活动级别度量和融合规则,由于源图像的多样性,这些规则变得复杂。这也限制了融合结果,因为不可能以一种手动设计的方式考虑所有因素。

其次,将深度学习应用于图像融合的最突出障碍是缺乏用于监督学习的地面真相融合图像。少数方法通过手动构造地面真相来解决此困难,这通常是不准确的,并且会为学习设置上限。

再次,如前所述,图像融合任务之间存在较大差异。在多模态图像融合中,源图像由不同的传感器捕获。相反,数字摄影图像融合中的源图像由同一传感器在不同的拍摄设置下拍摄。结果,现有方法无法按照相同的思想解决不同的图像融合问题。

最后,由于参数数量多或融合规则复杂度高,现有方法在运行效率上通常较弱。

因此,我们设计了一个称为SDNet的挤压分解网络,以实时实现多模态图像融合和数字摄影图像端到端融合。我们的设计主要从以下两个方面发展。

On the one hand

我们将多模态图像融合和数字摄影图像融合建模为强度和梯度信息的提取和重建。我们的观点是,图像中包含的信息可以分为梯度信息和强度信息,其中梯度信息表示纹理结构,而强度信息表示图像的整体亮度分布。基于这一思想,我们针对上述两类图像融合场景设计了一种通用形式的损失函数,该损失函数可以强制网络提取梯度和强度信息,并通过两种不同的规则进行融合。具体来说,对于梯度信息,我们认为除了噪声之外,其他具有强梯度的区域是清晰的或具有大量纹理内容。基于此观察,我们提出了一种自适应决策块,该决策块首先使用高斯低通滤波器来降低噪声的影响,然后根据梯度的水平对每个像素进行评分,从而指导融合图像的梯度分布以较大的梯度强度近似源像素。对于强度信息,由于不同的融合任务对强度信息保存的偏好不同,我们通过调整每个强度损失项的权重比例,选择更有效、更有趣的强度信息保留在融合结果中。通过使用这两种策略来提取和重建梯度和强度信息,所提出的损失函数可以很好地应用于多模态图像融合和数字摄影图像融合。

On the other hand,

基于这个动机,我们设计了一个挤压和-分解网络,包含两个部分:挤压和分解。在挤压阶段,源图像被融合成单个图像。在分解过程中阶段,融合结果被重新分解为源图像。同样,这种挤压和分解网络也是适用于多模式和数字摄影图像融合。

另一方面,我们提出了一种快速的SDNet来实现更有效的图像融合。以前的方法只考虑从源图像到融合结果的挤压过程,那么是否可以对融合结果进行分解以重新生成源图像?尽管在融合过程中不可避免地会丢弃部分信息,但要求分解结果与源图像保持一致将尽可能减少信息损失。换句话说,这种分解一致性将迫使融合的结果包含更多的场景细节,因为分解结果的质量直接取决于融合的结果。基于这种动机,我们设计了一个挤压和分解网络,该网络包含两个部分: 挤压和分解。在挤压阶段,源图像被融合为单个图像。在分解阶段,将融合的结果重新分解为源图像。同样,这种挤压分解网络也适用于多模态和数字摄影图像融合。

优点:

首先,我们的方法不需要设计活动级别度量和融合规则,可以实现端到端融合。

其次,我们的网络不需要有监督学习的基本真理,而是具有弱约束的无监督学习。

最后,我们的方法不仅适用于通过多模态成像获得的图像的融合,而且适用于通过数字摄影获得的图像的融合。值得注意的是,由于使用了1 × 1卷积内核以及对特征通道数量的控制,我们网络中的参数数量被限制在一定范围内

总之我们的方法可以高速实现融合。

贡献

1)我们提出了一种新的端到端图像融合模型,该模型可以很好地实现多模态图像融合和数字摄影图像融合。

2)我们设计了一种特定形式的损失函数,可以迫使网络生成预期的融合结果。

3)我们针对梯度损失项提出了一种自适应决策块,该决策块可以减少噪声的影响,并有效地指导融合结果包含更丰富的纹理细节。

4)我们设计了一个挤压分解网络,该网络可以同时关注融合和分解两个阶段,从而使融合结果包含更多的场景细节。

5)我们的方法可以针对多个融合任务实时执行图像融合。

(该手稿的初步版本出现在Zhang等人 (2020) 中。主要的新贡献包括以下两个方面。首先,我们设计了一个自适应决策块来约束梯度信息,而不是以前的手动比例设置策略。一方面,它减少了需要手动调整的超级参数的数量。另一方面,它使我们的方法表现更好,尤其是在多焦点图像融合中。其次,我们进一步改进了网络,不仅考虑了融合过程,还考虑了分解过程。这种分解一致性可以使融合图像包含更多的场景细节,从而具有更好的视觉效果。)

相关工作

传统方法 通常采用相关的数学变换和手工设计的融合规则来实现图像融合。Piella 概述了使用多分辨率分解的图像融合技术,该技术基于所有不同的输入图像进行多分辨率分割,并且该分割随后用于指导红外和可见光图像融合过程。

Hayat和Imran 提出了一种使用密集SIFT描述符和引导滤波器的无重影多曝光图像融合技术,该技术可以使用普通相机产生高质量的图像而不会产生伪影。

Paul等人提出了一种多焦点多曝光图像融合的通用算法,它基于使用每个像素位置处的最大梯度幅度混合输入图像的亮度分量的梯度,然后使用基于Haar小波的图像重建技术获得融合的亮度。

Fu等人将基于局部梯度约束的更精确的空间保存引入遥感图像融合,可以在保持光谱信息的同时充分利用PAN图像中包含的空间信息。结果,它们可以获得非常有希望的融合结果。

深度学习方法是可以从大量数据中学习具有良好泛化能力的融合模型。

在红外和可见光融合领域,ma等人提出了一种称为FusionGAN的端到端模型,该模型在GAN的基础上生成具有主导红外强度和附加可见梯度的融合图像。随后,他们引入了基于FusionGAN的双重鉴别器 、细节损失和目标边缘增强损失 ,以进一步增强融合结果中的纹理细节。

在多曝光图像融合领域,Prabhakar等人 提出了一种无监督深度学习框架,该框架利用无参考质量度量作为损失函数,并且可以产生令人满意的融合结果。Xu等人介绍了一种基于GAN的具有自我注意机制的端到端架构,并实现了最先进的性能。在医学图像融合中,Liu等人使用神经网络生成权重图,该权重图整合了两个源图像的像素活动水平,而融合过程通过图像金字塔以多尺度方式进行。

随着深度学习的应用,多焦点图像融合领域也取得了长足的进步。特别地ma等人提出了一种无监督网络来生成用于融合的决策图,该决策图可以指示像素是否被聚焦。

深度网络也推动了遥感影像融合的进展。Zhou等人设计了一个由编码器网络和金字塔融合网络组成的深度模型,融合了低分辨率高光谱和高分辨率多光谱图像,通过这种逐步细化提高了空间信息的保存能力。ma等人提出了一种无监督深度的全景锐化模型,以充分利用全色图像中的纹理结构。他们通过使用两个独立的鉴别器将pan-sharpening转换为多任务学习,这些鉴别器可以很好地保留光谱和空间信息。

(我们的初版PMGI (Zhang et al. 2020) 提出了一种新的基于梯度和强度信息的比例保持的图像融合网络,可以实现多种图像融合任务。但是,通过调整权重来改变梯度信息的维护比例会导致一定程度的纹理结构丢失或模糊,从而降低融合结果的质量。因此,本文对PMGI进行了改进,以实现更好的融合性能。)

方法

Overall Framework

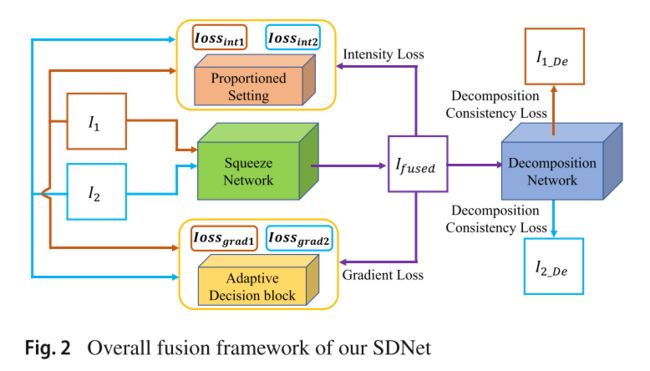

首先,我们将主要信息定义为两类: 梯度信息和强度信息。对于任何图像,它最基本的元素是像素。像素的强度可以表示整体亮度分布,可以反映图像的对比度特征。像素之间的差异构成渐变,可以表示图像中的纹理细节。因此,可以将多模态图像融合和数字摄影图像融合建模为这两种信息的提取和重建,如下图所示

梯度和强度信息的提取和重建取决于损失函数的设计。在我们的模型中,我们为不同的图像融合任务提出了一个通用的损失函数,该函数由在融合图像和两个源图像之间构造的梯度损失项和强度损失项组成。尽管使用强度损失和梯度损失 是特定的图像融合任务中的常见做法,但将它们扩展到其他图像融合任务是不平凡的。为此,我们为梯度信息和强度信息设计的重建规则有很大的不同。对于梯度信息重建,我们引入了一个作用于梯度损失项的自适应决策块。自适应决策块首先利用高斯低通滤波来降低噪声对决策过程的影响,然后基于梯度丰富度来评估相应像素的重要性,以便生成像素级决策图,该像素级决策图引导融合图像中的纹理以近似具有更丰富纹理的源像素中的纹理。结果,融合图像中包含的纹理细节与源图像的相应区域中最强的纹理细节一致。

对于强度信息重建,我们采用比例设置策略。具体地,我们调整融合图像和两个源图像之间的强度损失项的权重比,以满足不同任务对强度分布的要求。例如,在红外和可见光图像融合中,融合图像的强度分布应更偏向红外图像,以保持显着的对比度。在MRI和PET图像融合中,融合图像的强度分布应更倾向于PET图像,以保留生物组织的功能和代谢信息。

我们提出了压缩和分解的想法,以在融合结果中保留尽可能多的源图像信息。具体地,所提出的SDNet由挤压网络和分解网络两部分组成,如上图所示。挤压网络是实现图像融合的目标网络,专用于将源图像压缩为单个融合图像。相反,分解网络专门用于分解此融合结果,以获得与源图像一致的图像。总的来说,SDNet与自动编码器网络非常相似。不同之处在于,SDNet的中间结果是融合图像,而自动编码器网络的中间结果是编码向量。但相同的是,它们都要求中间结果包含更多的场景内容,这有利于重建源图像。因此,我们设计的挤压分解网络可以迫使融合结果包含更丰富的场景细节,从而具有更好的融合效果。

Loss Functions

我们的SDNet分为两部分,其中挤压网络通过强度和梯度信息的提取和重建生成单个融合图像,分解网络专门用于从融合结果中分解近似源图像的结果。

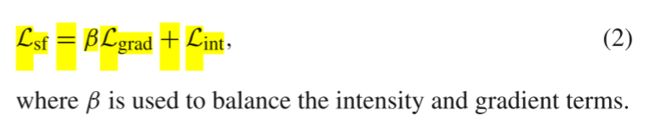

相应地,损失函数也由两部分组成: 挤压融合损失Lsf和分解一致性损失Ldc,其定义为:

Squeeze Fusion Loss

挤压融合损失Lsf决定了提取的信息类型以及重构中各类信息之间的主次关系。 由于我们的方法基于梯度和强度信息的提取和重建,因此我们的损失函数由两类损失项组成,即梯度损失Lgrad和强度损失Lint。我们将其形式化为:

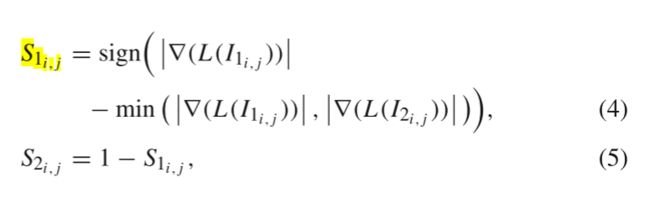

梯度损失Lgrad迫使融合图像包含丰富的纹理细节。我们在梯度损失项中引入自适应决策块,引导融合图像的纹理与源图像相应位置的最强纹理一致,定义为:

其中,i和j表示决策图或梯度图中的第i行和第j列中的像素,H和W表示图像的高度和宽度,I1和I2是源图像,Ifused是融合图像,∇ (·) 表示使用拉普拉斯算子寻找梯度图的操作。此外,S(·) 是决策块基于源图像的梯度级别生成的决策图。

自适应决策块的示意图如上图所示,为了减少噪声对梯度判断的影响,决策块首先对源图像进行高斯低通滤波。然后,我们使用拉普拉斯算子找到梯度图,并根据梯度的大小在像素尺度上生成决策图。决策图的整个生成过程可以形式化为:

其中 |·| 表示绝对值函数,∇(·) 为拉普拉斯算子,L(·) 表示高斯低通滤波函数,min(·) 表示最小函数,sign (·) 为符号函数。值得注意的是S(·) 的大小也是h × w。由于两个源图像都使用低通函数进行滤波,并且选择了具有大梯度值的像素,因此几乎不会误判正常纹理。在Goshtasby中提到了类似的选择决策思想。但是我们的自适应决策块显然更先进,原因如下:

首先,Goshtasby 使用的权重函数在补丁尺度上,而我们提出的自适应决策块在像素尺度上。从这个角度来看,我们的自适应决策块更加精致。

其次,Goshtasby 中的权重函数基于信息熵,该信息熵**对噪声不具有鲁棒性。**具体来说,当一个补丁包含更多的噪声时,它会被不合理地赋予更大的权重。相比之下,所提出的自适应决策块不仅考虑了噪声的影响,而且基于场景纹理丰富度进行决策,更加合理。

最后,权重函数在Goshtasby是直接应用于源图像,其本质上是从源图像到融合图像的线性映射。不同之处在于,我们的自适应决策块作用于梯度损失函数,以优化的方式指导融合图像在像素尺度上保留丰富的纹理,这实际上是具有更好性能的非线性映射。

强度损失Lint 引导融合图像保留像素强度所代表的有用信息,如对比度。同时,它可以使融合图像的整体场景风格更加自然,不脱离现实。强度损失可以形式化:

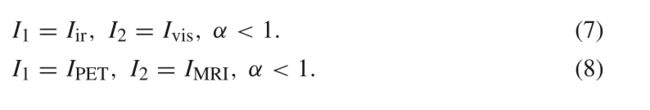

因为不同的图像融合任务对融合图像的强度分布有不同的倾向性要求。因此,我们采用比例设置策略来调整 α,以满足不同类型融合任务的强度分布要求。 α 的比例设置策略与图像融合的类型有关,对于多模态图像融合,融合结果的强度分布通常偏向于某个源图像。例如,在红外和可见光图像融合中,应从红外图像中获取主要强度信息,以保持明显的对比度。同样,对于MRI和PET图像融合,应从PET图像中获得主要强度信息,从而保留生物体的功能活动信息。因此,参数 α 应满足以下设置规则:

对于数码摄影图像融合,不同拍摄设置下拍摄的源图像的场景内容往往具有高度的互补性,融合后的图像的强度信息应统一来自所有源图像。例如,在多曝光图像融合任务中,过度曝光和曝光不足的图像都包含纹理细节,但它们的强度太强或太弱。因此,应该设置相同的权重来平衡它们,以获得合适的强度。同样,对于多焦点图像融合,源图像包含互补纹理,其强度同样重要。所以参数 α 应该满足以下设置规则:

Decomposition Consistency Loss

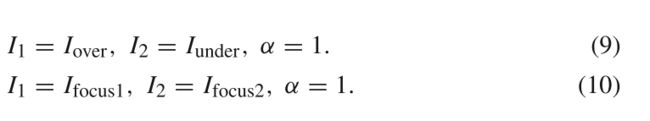

分解一致性损失Ldc要求来自融合图像的分解结果与源图像尽可能相似,其定义为:

其中I1_de和I2_de是融合图像的分解结果,I1和I2是源图像,由于分解结果和源图像的相似程度直接取决于融合图像的质量,因此分解一致性的损失会迫使融合结果包含更多的场景内容。从而达到更好的融合性能。

Network Architecture

提出的SDNet由两个子网络组成,即挤压网络和分解网络,如下图所示:

挤压网络的目的是将源图像融合为包含更丰富纹理内容的单个图像。源图像对的性质往往大不相同,其中一些是由不同的传感器捕获的,而一些是在不同的拍摄设置下使用相同的传感器拍摄的。因此,分开处理是一个更好的选择。由于 pseudo-siamese(孪生)网络非常擅长处理差异较大的数据,因此我们参考pseudo-siamese网络设计了挤压网络,以实现多种图像融合任务。同时,由于卷积过程中存在填充导致的信息丢失,我们使用DenseNet这样的密集连接来减少信息丢失,最大限度地利用信息。在每条路径中,我们使用四个卷积层进行特征提取。第一层使用5 × 5卷积内核,后三层使用3 × 3卷积内核,所有这些都具有leaky ReLU激活函数。然后,我们融合从两条路径中提取的特征,并使用串联和卷积的策略来实现这一目的。我们沿着通道连接了两个特征图。最后卷积层的核大小为1 × 1,激活函数为tanh。

分解网络专门用于分解融合图像以获得与源图像相似的结果。我们首先使用一个常见的卷积层从融合图像中提取特征。然后,我们从两个分支中实现分解以生成结果,其中每个分支包含三个卷积层。第一个公共卷积层使用大小为1 × 1的卷积核,其余卷积层均使用大小为3 × 3的卷积核。除最后一个卷积层外,所有其他卷积层均使用leaky ReLU作为激活函数,最后一个使用tanh作为激活函数。

在所有卷积层中,填充设置为相同,而stride设置为1。结果,这些卷积层都不会改变特征图的大小。