迁移学习(Transfer learning)相关名词解释

摘录总结自:请问具体什么是迁移学习? - 知乎

迁移学习

概念:从广义上讲,利用已有的知识、模型、结构来帮助我们达成在目标数据上的学习目标。因此,迁移学习可以细分为很多不同的研究子领域。

文献:Sinno Pan and Qiang Yang, A survey on transfer learning. IEEE TNN 2010

迁移学习的第一大范式:Pre-train and fine-tune(预训练-微调)

是迁移学习最重要的表现形式,指的是在源领域训练好一个网络,直接将其用于目标域的数据,并在目标域数据上进行微调。如:基于Bert的微调。利用pre-trained model,可以省去大量的训练时间。

文献:Yosinsk et al., How transerable are features in neural networks. NIPS 2014.

迁移学习的第二大范式:Domain adaptation(领域自适应、域自适应、域适应、域适配)

简称DA,是迁移学习最热门的研究方向,产出论文最多、积累最丰富。在DA问题中,我们可以访问源域和目标域,目标域通常没有标签(无监督DA)或很少的标签(半监督DA)。核心是减小两个域的分布差异,从而给目标域的数据全部打上标签。例如:如下四个域,虽然呈现的分类是相同的,但是表现形式不同。现给出Art的数据图(作为源域),要求对Realworld的图(目标域)做很好的识别,就需要使用DA。

注意:源域和目标域的类别是一样的,只是表现形式不一样。

DA的统一方法代码库DeepDA:https://github.com/jindongwang/transferlearning/tree/master/code/DeepDA

DA的延伸:Domain generation(领域泛化)

简称DG,2018年前不多,最近几年(2021年)研究方法逐渐增多。DG在DA问题上更进一步,要求在只能访问源域数据的情况下,学习一个泛化能力强的模型,使其在目标域数据上有很好的表现。DG的泛化能力比DA更强,通用性更好。目前DG领域没有DA领域那么“卷”。

DG的同义词:Out-of-distribution generation(分布外泛化)

简称OOG,与DG基本一致,也关注模型在不同分布外的泛化情况。

2021综述、DG统一方法代码库:DeepDG

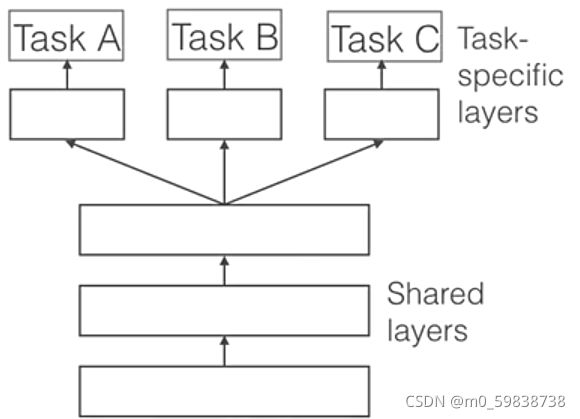

Multi-task learning(多任务学习)

多任务学习是机器学习领域非常古老的研究方向。只要我们学习过程中涉及到了多个优化目标、多个Loss,那它就是要给多任务问题。

综述文献:Zhang Y, YANG Q. A survey on multi-task learning [J]. preprint arXiv: 1707.08114, 2017.

迁移学习可以用来做多任务学习。

Meta-learning(元学习)

元学习在多任务学习的基础之上,与迁移学习殊途同归。不同点是,元学习强调一个inductive learning(强调归纳)的过程:我们需要足够多的数据,才能在这些数据上归纳出我们想要的通用知识。而迁移学习是一个transductive learning(强调迁移、传递)过程:有了一个已有函数,要在下游任务上利用此函数来达成学习目标。元学习是强调从不同的若干小任务小样本来学习一个对未知样本未知类别都有好的判别和泛化能力的模型(例如:基于爬山、骑车、骑马等一系列已有的任务,来学习新任务“滑冰”上表现好),这其实就是知识的迁移。因此迁移学习和元学习并无本质区别。

Source domain selection(源域选择)

在众多可用的源域数据中,选择那些与目标域最相似的、最适用与迁移学习的数据。

Transferability estimation(可迁移性评估)

与源域选择的目的一致,都是想使迁移学习表现更好,但作用对象不同,它表示我们要根据目标域数据和已有的众多模型,来评估哪个模型能适用于目标域模型。源域选择选的是数据,而可迁移性评估选的是模型。可迁移性评估比源域选择更新。

Instance (re)weighting(样本重要性加权)

古老的词汇。在基于样本的迁移学习中使用较多,目标是给样本进行不同层次的加权,给更适用于迁移的样本一个大权重,不适合迁移的样本小权重。

经典参考文献来自2017年。

在迁移学习相关论文中经常用的题目取名法

cross-domain ×××:其实本质就是迁移学习

distribution matching,distribution adaption:DA/DG中,把不同分布进行匹配的过程

domain shift:domain分布(feature或label)出现了漂移

Partial domain adaption(部分DA)

传统DA要求源域和目标域的类别是一样的,而partial DA放大了源域类别空间:要求源域类别中包含有目标类别级别即可(Li et al. 2020),如:源域有100个类别,目标域只有其中的20个类别。

Open set domain adaption(开放集自适应)

继承partial DA,但有所扩大:源域和目标域的类别不必完全相同,而是有一些类别是相同的、一些类别是各自特有的。算法要在公共类别上对目标域正确分类,同时识别非公共类别(Saito et al., 2018)。如:源域和目标域各有100个类别,但是只有20个是它们共同的类别,源域和目标域各有80个类别是它们各自特有的。

Universarial domain adaptation

比open set DA更宽泛,不知道源域和目标域的分类是否有相同。

Continuous domain adaption(持续DA)

将Domain adaption定义放在持续学习中:数据不是离线形式到来,而是一份一份到来。与online transfer learning一致,叫法不同,是近几年兴起的叫法(Wang et al., 2020)。核心是“温故而知新”,不能学习着新到来的数据,就把之前学习的忘记了。

参考文献:Wang H, He H, Katabi D. Continuously indexed domain adaptation[J]. arXiv preprint, 2020.

Federated domain adaptation(联邦DA)

将Domain adaption定义放在联邦学习中:源域数据无法访问,只能通过交换梯度信息或中间特征来进行模型的联合训练,在联邦基础上如何进行DA?

参考文献:Peterson D, et al., Private federated learning with domain adaptation [J]. arXiv preprint, 2019.

Source-free domain adaptation

继承DA的定义,和联邦DA一样,也是从隐私保护角度切入,但没有联邦学习的框架,无法访问源域数据,只能访问源域模型和目标域数据。

参考文献:Liang J, Hu D, Feng J. Do we really need to access the source data? source hypothesis transfer for unsupervised domain adaptation[C]. International Conference on Machine learning. PMLR. 2020.

Multi-source domain adaption(多源域自适应)

直接扩展单源的DA为多个源的结构。需要处理的问题:只有一个源域和一个目标域,那么只用处理这个源域到目标与的distribution gap,现在有多个源域,除了要处理每个源域到目标与的distribution gap,还需要处理源域和源域之间的gap,因为源域和源域是不同构的,即分布不同。

参考文献:Sun S, Shi H, Wu Y. A survey of multi-source domain adaptation[J]. Information Fusion, 2015, 24: 84-92.

Multi-target domain adaption(多目标域自适应)

将目标域扩展为多个。

参考文献:Gholami B et al., Unsupervised multi-target domain adaption: an information theoretic approach[J]. IEEE Transformations on image processing, 2020, 29: 3993-4002.

参考资料:

《迁移学习》,杨强团队

《迁移学习导论》:http://jd92.wang/tlbook

迁移学习统一代码、数据集、论文、资料库:https://transferlearning.xyz

知乎博客系列:https://zhuanlan.zhihu.com/p/130244395

善用大佬资料,事半功倍!