Linux高性能服务器编程 学习笔记 第十四章 进程池和线程池

动态创建子进程或子线程的缺点:

1.动态创建进程或线程比较耗时,这将导致较慢的客户响应。

2.动态创建的子进程或子线程通常只用来为一个客户服务(除非我们做特殊处理),这将导致系统上产生大量的进程或线程,进程或线程间的切换将消耗大量CPU时间。

3.动态创建的子进程是当前进程的完整映像,当前进程必须谨慎地管理其分配的文件描述符和堆内存等系统资源,否则子进程会复制这些资源,从而使系统的可用资源急剧下降,进而影响服务器性能。

进程池和线程池相似,我们以进程池为例进行介绍,下面对进程池的讨论也适用于线程池。

进程池是由服务器预先创建的一组子进程。线程池中的线程数量应该和CPU数量差不多,防止高负载下有CPU核心未被使用。

进程池中的所有子进程都运行着相同的代码,并具有相同的属性,如优先级、PGID等,因为进程池在服务器启动之初时就创建好了,所以每个子进程都相对干净,即它们没有打开不必要的文件描述符(从父进程继承而来),也不会错误地使用大块的堆内存(从父进程复制得到)。

当有新任务与到来时,主进程将通过某种方式选择进程池中某一子进程来为之服务,相比动态创建子进程,选择一个已经存在的子进程的代价小很多,主进程选择哪个子进程来为新任务服务主要有两种方式:

1.主进程使用某种算法主动选择子进程。最简单、最常用的算法是随机算法和Round Robin(轮流选取)算法,但更优秀、更智能的算法将使任务在各个工作进程中更均匀地分配,从而减轻服务器的整体压力。

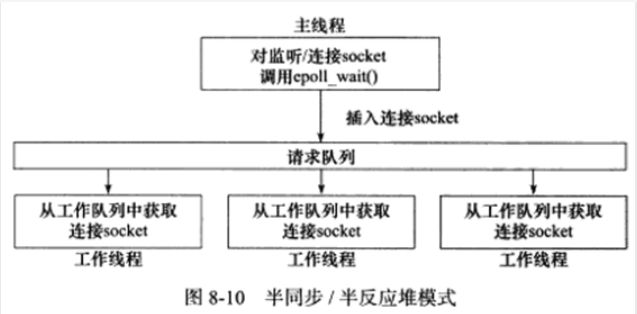

2.主进程和所有子进程通过一个共享的工作队列来同步,子进程都睡眠在该工作队列上,当有新任务到来时,主进程将任务添加到工作队列中,这将唤醒正在等待任务的子进程,但只有一个子进程能获得新任务的接管权,它可以从工作队列中取出任务并执行之,而其他子进程将继续睡眠在工作队列上。

选好子进程后,主进程还需使用某种通知机制来告诉目标子进程有新任务需要处理,并传递必要的数据,最简单的方法是,在父进程和子进程之间先创建好一条管道,然后通过该管道来实现所有的进程间通信(当然要预先定义好一套协议来规范管道的使用)。在父线程和子线程之间传递数据就要简单得多,因为我们可以把这些数据定义为全局的,那么它们本身就是被所有线程共享的。

进程池的一般模型为:

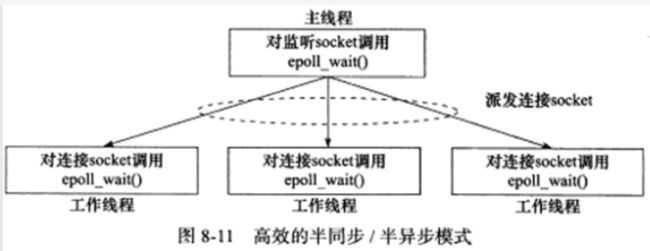

使用进程池处理多客户任务时,首先要考虑的一个问题是:监听socket和连接socket是否都由主进程来统一管理。第8章中,半同步/半反应堆模式是由主进程统一管理这两种socket的,而更高效的半同步/半异步模式和领导者/追随者模式,则是由主进程管理所有监听socket,而各个子进程分别管理属于自己的连接socket的。半同步/半异步模式中,主进程接受新的连接以得到连接socket,然后它需要将该socket传递给子进程(对于线程池而言,父线程将socket传递给子线程是简单的,因为它们可以共享该socket,而对于进程池,我们需要用UNIX域套接字来传递socket);而领导者/追随者模式的灵活性更大一点,因为子进程可以自己调用accept来接受新连接,这样父进程就无须向子进程传递socket,而只需简单地向子进程通知一声:我检测到了新连接,你来接受它。

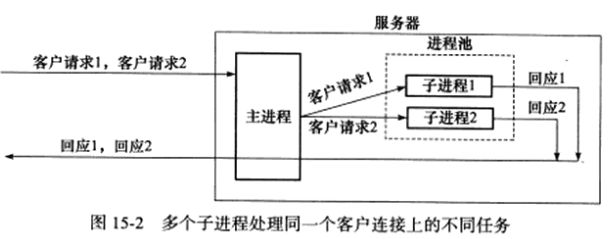

长连接只一个客户的多次请求可以复用一个TCP连接,在设计进程池时还要考虑:一个客户连接上的所有任务是否始终由一个子进程来处理,如果客户任务是无状态的,那么我们可以考虑使用不同的子进程来为该客户的不同请求服务,如下图所示:

但如果客户任务是存在上下文关系的,则最好一直用同一个子进程来为之服务,否则实现起来会比较麻烦,我们将不得不在各子进程之间传递上下文数据。

第八章中的半同步/半异步并发模式:

以下代码实现一个半同步/半异步并发模式的进程池,为了避免在父子进程间传递文件描述符,我们将接受新连接的操作放到子进程中,对于这种模式而言,一个客户连接上的所有任务始终是由一个子进程来处理的:

// filename: processpool.h

#ifndef PROCESSPOOL_H

#define PROCESSPOOL_H

#include 用以上进程池实现一个并发CGI服务器:

#include 第八章中的半同步/半反应堆并发模式:

我们接下来实现上图所示的半同步/半反应堆模式的线程池,相比以上进程池的实现,该线程池的通用性要高得多,因为它使用一个工作队列完全解除了主线程和工作线程的耦合关系:主线程往工作队列插入任务,工作线程通过竞争来取得任务并执行它。但要想将该线程池应用到实际服务器程序中,我们必须保证所有客户请求都是无状态的,因为同一个连接上的不同请求可能会由不同的线程处理。

// filename: threadpool.h

#ifndef THREADPOOL_H

#define THREADPOOL_H

#include

#include 下面使用以上线程池实现一个并发Web服务器。

首先我们需要准备线程池的模板参数类用来封装对逻辑任务的处理,这个类是http_conn,以下代码是其头文件http_conn.h:

#ifndef HTTPCONNECTION_H

#define HTTPCONNECTION_H

#include 以下是类http_conn的实现文件http_conn.cpp:

#include "http_conn.h"

// 定义HTTP响应的状态信息

const char *ok_200_title = "OK";

const char *error_400_title = "Bad Request";

const char *error_400_form = "Your request has bad syntax or is inherently impossible to satisfy.\n";

const char *error_403_title = "Forbidden";

const char *error_403_form = "You do not have permission to get file from this server.\n";

const char *error_404_title = "Not Found";

const char *error_404_form = "The requested file was not found on this server.\n";

const char *error_500_title = "Internal Error";

const char *error_500_form = "There was an unusual problem serving the requested file.\n";

const char *doc_root = "/var/www/html";

int setnonblocking(int fd) {

int old_option = fcntl(fd, F_GETFL);

int new_option = old_option | O_NONBLOCK;

fcntl(fd, F_SETFL, new_option);

return old_option;

}

void addfd(int epollfd, int fd, bool one_shot) {

epoll_event event;

event.data.fd = fd;

event.events = EPOLLIN | EPOLLET | EPOLLRDHUP;

if (one_shot) {

event.events |= EPOLLONESHOT;

}

epoll_ctl(epollfd, EPOLL_CTL_ADD, fd, &event);

setnonblocking(fd);

}

void removefd(int epollfd, int fd) {

// epoll_ctl函数的第4个参数是epoll_event类型指针,用于描述与文件描述符fd参数相关的事件以及关联的数据

// 此处执行删除操作,只需要指定要删除的文件描述符

epoll_ctl(epollfd, EPOLL_CTL_DEL, fd, 0);

close(fd);

}

void modfd(int epollfd, int fd, int ev) {

epoll_event event;

event.data.fd = fd;

event.events = ev | EPOLLET | EPOLLONESHOT | EPOLLRDHUP;

epoll_ctl(epollfd, EPOLL_CTL_MOD, fd, &event);

}

int http_conn::m_user_count = 0;

int http_conn::m_epollfd = -1;

void http_conn::close_conn(bool real_close) {

// 如果real_close为true且当前连接的socket存在(该连接的socket,即m_sockfd,不为-1)

if (read_close && (m_sockfd != -1)) {

removefd(m_epollfd, m_sockfd);

m_sockfd = -1;

// 关闭一个连接时,将客户总数减1

--m_user_count;

}

}

void http_conn::init(int sockfd, const sockaddr_in &addr) {

m_sockfd = sockfd;

m_address = addr;

// 以下两行是为了避免TIME_WAIT状态,仅用于调试,实际使用时应去掉

int reuse = 1;

setsockopt(m_sockfd, SOL_SOCKET, SO_REUSEADDR, &reuse, sizeof(reuse));

addfd(m_epollfd, sockfd, true);

++m_user_count;

init();

}

void http_conn::init() {

m_check_state = CHECK_STATE_REQUESTLINE;

m_linger = false;

m_method = GET;

m_url = 0;

m_version = 0;

m_content_length = 0;

m_host = 0;

m_start_line = 0;

m_checked_idx = 0;

m_read_idx = 0;

m_write_idx = 0;

memset(m_read_buf, '\0', READ_BUFFER_SIZE);

memset(m_write_buf, '\0', WRITE_BUFFER_SIZE);

memset(m_real_file, '\0', FILENAME_LEN);

}

// 从状态机

http_conn::LINE_STATUS http_conn::parse_line() {

char temp;

for (; m_checked_idx < m_read_idx; ++m_checked_idx) {

temp = m_read_buf[m_checked_idx];

if (temp == '\r') {

if ((m_checked_idx + 1) == m_read_idx) {

return LINE_OPEN;

} else if (m_read_buf[m_checked_idx + 1] == '\n') {

m_read_buf[m_checked_idx++] = '\0';

m_read_buf[m_checked_idx++] = '\0';

return LINE_OK;

}

return LINE_BAD;

} else if (temp == '\n') {

if ((m_checked_idx > 1) && (m_read_buf[m_checked_idx - 1] == '\r')) {

m_read_buf[m_checked_idx - 1] = '\0';

m_read_buf[m_checked_idx++] = '\0';

return LINE_OK;

}

return LINE_BAD;

}

}

return LINE_OPEN;

}

bool http_conn::read() {

if (m_read_idx >= READ_BUFFER_SIZE) {

return false;

}

int bytes_read = 0;

while (true) {

bytes_read = recv(m_sockfd, m_read_buf + m_read_idx, READ_BUFFER_SIZE - m_read_idx, 0);

if (bytes_read == -1) {

if (errno == EAGAIN || errno == EWOULDBLOCK) {

break;

}

return false;

} else if (bytes_read == 0) {

return false;

}

m_read_idx += bytes_read;

}

return true;

}

// 解析HTTP请求行,获得请求方法、目标URL、HTTP版本号

// 我们预期text的格式类似GET /path/to/resource HTTP/1.1

http_conn::HTTP_CODE http_conn::parse_request_line(char *text) {

// strpbrk函数用于在一个字符串中查找第一个包含在指定字符集合中的字符,并返回该字符在字符串中的位置

m_url = strpbrk(text, " \t");

if (!m_url) {

return BAD_REQUEST;

}

*m_url++ = '\0';

char *method = text;

if (strcasecmp(method, "GET") == 0) {

m_method = GET;

} else {

return BAD_REQUEST;

}

// strspn函数返回一个size_t类型的值,表示在第一个参数中从开头开始的连续字符数量

// 这些字符都包含在第二个参数中的字符集合中

m_url += strspn(m_url, " \t");

m_version = strpbrk(m_url, " \t");

if (!m_version) {

return BAD_REQUEST;

}

*m_version++ = '\0';

m_version += strspn(m_version, " \t");

if (strcasecmp(m_version, "HTTP/1.1") != 0) {

return BAD_REQUEST;

}

if (strncasecmp(m_url, "http://", 7) == 0) {

m_url += 7;

// strchr函数在一个字符串中查找指定字符的第一次出现的位置,并返回该位置的指针

m_url = strchr(m_url, '/');

}

if (!m_url || m_url[0] != '/') {

return BAD_REQUEST;

}

m_check_state = CHECK_STATE_HEADER;

return NO_REQUEST;

}

// 解析HTTP请求的一个头部信息

http_conn::HTTP_CODE http_conn::parse_headers(char *text) {

// 遇到空行,表示不再有头部字段

if (text[0] == '\0') {

// 如果HTTP请求有消息体,则还需读取m_content_length字节的消息体

// 状态机转移到CHECK_STATE_CONTENT状态

if (m_content_length != 0) {

m_check_state = CHECK_STATE_CONTENT;

return NO_REQUEST;

}

// 否则说明我们已经得到了一个完整HTTP请求

return GET_REQUEST;

} else if (strncasecmp(text, "Connection:", 11) == 0) {

text += 11;

text += strspn(text, " \t");

if (strcasecmp(text, "keep-alive") == 0) {

m_linger = true;

}

}

} else if (strncasecmp(text, "Content-Length:", 15) == 0) {

text += 15;

text += strspn(text, " \t");

m_content_length = atoi(text);

} else if (strncasecmp(text, "Host:", 5) == 0) {

text += 5;

text += strspn(text, " \t");

m_host = text;

} else {

printf("oop! unknown header %s\n", text);

}

return NO_REQUEST;

}

// 我们没有真正解析HTTP请求的消息体,只是判断它是否被完整读入了

http_conn::HTTP_CODE http_conn::parse_content(char *text) {

if (m_read_idx >= m_content_length + m_checked_idx) {

text[m_content_length] = '\0';

return GET_REQUEST;

}

return NO_REQUEST;

}

// 主状态机

http_conn::HTTP_CODE http_conn::process_read() {

LINE_STATUS line_status = LINE_OK;

HTTP_CODE ret = NO_REQUEST;

char *text = 0;

while (((m_check_state == CHECK_STATE_CONTENT) && (line_status == LINE_OK))

|| ((line_status = parse_line()) == LINE_OK)) {

text = get_line();

m_start_line = m_checked_idx;

printf("got 1 http line: %s\n", text);

switch (m_check_state) {

case CHECK_STATE_REQUESTLINE:

ret = parse_request_line(text);

if (ret == BAD_REQUEST) {

return BAD_REQUEST;

}

break;

case CHECK_STATE_HEADER:

ret = parse_headers(text);

if (ret == BAD_REQUEST) {

return BAD_REQUEST;

} else if (ret == GET_REQUEST) {

return do_request();

}

break;

default:

return INTERNAL_ERROR;

}

}

return NO_REQUEST;

}

// 得到一个完整、正确的HTTP请求时,该函数分析目标文件的属性

// 如果目标文件存在、对所有用户可读、不是目录,则使用mmap函数将其映射到内存地址m_file_address处

// 并告诉调用者获取文件成功

http_conn::HTTP_CODE http_coonn::do_request() {

strcpy(m_real_file, doc_root);

int len = strlen(doc_root);

strncpy(m_real_file + len, m_url, FILENAME_LEN - len - 1);

if (stat(m_real_file, &m_file_stat) < 0) {

return NO_RESOURCE;

}

if (!(m_file_stat.st_mode & S_IROTH)) {

return FORBIDDEN_REQUEST;

}

if (S_ISDIR(m_file_stat.st_mode)) {

return BAD_REQUEST;

}

int fd = open(m_real_file, O_RDONLY);

m_file_address = (char *)mmap(0, m_file_stat.st_size, PROT_READ, MAP_PRIVATE, fd, 0);

close(fd);

return FILE_REQUEST;

}

// 对内存映射区执行munmap操作

void http_conn::unmap() {

if (m_file_address) {

munmap(m_file_address, m_file_stat.st_size);

m_file_address = 0;

}

}

// 写HTTP响应

bool http_conn::write() {

int temp = 0;

int bytes_have_send = 0;

int bytes_to_send = m_write_idx;

if (bytes_to_send == 0) {

modfd(m_epollfd, m_sockfd, EPOLLIN);

init();

return true;

}

while (1) {

temp = writev(m_sockfd, m_iv, m_iv_count);

if (temp <= -1) {

// 如果TCP写缓冲区没有空间,则等待下一轮EPOLLOUT事件

// 虽然在此期间,服务器无法立即收到同一客户的下一请求,但这可保证同一连接的完整性

if (errno == EAGAIN) {

modfd(m_epollfd, m_sockfd, EPOLLOUT);

return true;

}

unmap();

return false;

}

bytes_to_send -= temp;

bytes_have_send += temp;

if (bytes_to_send <= bytes_have_send) {

// 发送HTTP响应成功

unmap();

if (m_linger) {

// 此处处理完一个请求后,直接调用init清空了读缓冲区

// 如果客户连续发送多个请求,读缓冲区中可能有多于一个请求的数据

// 会丢失请求,如果读缓冲中某个请求只读了一半,则接下来的读操作会读入另一半

// 然后由于只有一半请求而被认为是请求语法有问题

init();

modfd(m_epollfd, m_sockfd, EPOLLIN);

return true;

} else {

modfd(m_epollfd, m_sockfd, EPOLLIN);

return false;

}

}

}

}

bool http_conn::add_response(const char *format, ...) {

if (m_write_idx >= WRITE_BUFFER_SIZE) {

return false;

}

va_list arg_list;

va_start(arg_list, format);

// vsnprintf函数会根据format字符串中的格式控制码,将可变参数列表中的值格式化后写入str所指向的缓存区

// 该函数返回写入缓冲区的字节数,包含结尾的\0

// 如果缓冲区太小,则该函数返回要写入的数据的字节数(此时不包含结尾的\0)

// 因此,如果该函数返回值大于等于第二个参数的大小,说明缓冲区太小

int len = vsnprintf(m_write_buf + m_write_idx, WRITE_BUFFER_SIZE - 1 - m_write_idx, format, arg_list);

if (len >= (WRITE_BUFFER_SIZE - 1 - m_write_idx)) {

return false;

}

m_write_idx += len;

// va_start函数和va_end函数必须成对出现,va_end函数用于清理可变参数列表,用于避免潜在的内存泄漏或数据损坏

va_end(arg_list);

return true;

}

bool http_conn::add_status_line(int status, const char *title) {

return add_response("%s %d %s\r\n", "HTTP/1.1", status, title);

}

bool http::conn::add_headers(int content_len) {

add_content_length(content_len);

add_linger();

add_blank_line();

}

bool http_conn::add_content_length(int content_len) {

return add_response("Content-Length: %d\r\n", content_len);

}

bool http_conn::add_linger() {

return add_response("Connection: %s\r\n", (m_linger == true) ? "keep-alive" : "close");

}

bool http_conn::add_blank_line() {

return add_response("%s", "\r\n");

}

bool http_conn::add_content(const char *content) {

return add_response("%s", content);

}

// 根据服务器处理HTTP请求的结果,决定返回给客户端的内容

bool http_conn::process_write(HTTP_CODE ret) {

switch (ret) {

case INTERNAL_ERROR:

add_status_line(500, error_500_title);

add_headers(strlen(error_500_form));

if (!add_content(error_500_form)) {

return false;

}

break;

case BAD_REQUEST:

add_status_line(400, error_400_title);

add_headers(strlen(error_400_form));

if (!add_content(error_400_form)) {

return false;

}

break;

case NO_RESOURCE:

add_status_line(400, error_400_title);

add_headers(strlen(error_404_form));

if (!add_content(error_404_form)) {

return false;

}

break;

case FORBIDDEN_REQUEST:

add_status_line(403, error_403_title);

add_headers(strlen(error_403_form));

if (!add_content(error_403_form)) {

return false;

}

break;

case FILE_REQUEST:

add_status_line(200, ok_200_title);

if (m_file_stat.st_size != 0) {

add_headers(m_file_stat.st_size);

m_iv[0].iov_base = m_write_buf;

m_iv[0].iov_len = m_write_idx;

m_iv[1].iov_base = m_file_address;

m_iv[1].iov_len = m_file_stat.st_size;

m_iv_count = 2;

return true;

} else {

const char *ok_string = "";

add_headers(strlen(ok_string));

if (!add_content(ok_string)) {

return false;

}

}

break;

default:

return false;

}

m_iv[0].iov_base = m_write_buf;

m_iv[0].iov_len = m_write_idx;

m_iv_count = 1;

return true;

}

// 由线程池中的工作线程调用,这是处理HTTP请求的入口

void http_conn::process() {

HTTP_CODE read_ret = process_read();

if (read_ret == NO_REQUEST) {

modfd(m_epollfd, m_sockfd, EPOLLIN);

return;

}

bool write_ret = process_write(read_ret);

if (!write_ret) {

close_conn();

}

modfd(m_epollfd, m_sockfd, EPOLLOUT);

}

定义好任务类后,main函数只需负责IO读写即可:

#include