实时车辆行人多目标检测与跟踪系统(含UI界面,Python代码)

算法架构:

目标检测:yolov5

目标跟踪:OCSort

其中, Yolov5 带有详细的训练步骤,可以根据训练文档,训练自己的数据集,极其方便。

另外后续 目标检测会添加 yolov7 、yolox,目标跟踪会添加 ByteTrack、deepsort等经典算法,代码主要部分添加了详细注释,方便自己学习。

一、简介

本文将详细介绍如何使用深度学习中的YOLOv5和OCTrack算法实现车辆、行人等多目标的实时检测和跟踪,并利用PyQt5设计了简约的系统UI界面。在界面中,您可以选择自己的视频文件进行检测和跟踪,也可以通过电脑自带的摄像头进行实时处理。此外,您还可以更换自己训练的yolov5模型,进行自己数据的跟踪。

该系统界面优美,检测精度高,功能强大。它具备多目标实时检测、跟踪和计数功能,同时可以自由选择感兴趣的跟踪目标。

本博文提供了完整的Python程序代码和使用教程,适合新入门的朋友参考。您可以在文末的下载链接中获取完整的代码资源文件。以下是本博文的目录:

目录

- 一、简介

- 二、效果展示

- 三、环境安装

- 四、YOLOV5介绍

-

- yolov5模型的训练步骤

- 五、OCtrack介绍

- 六、下载链接

- 论文 (此章节内容仅作为写论文时的参考,按需自取)

-

- 摘要:

- 第一章:引言

-

- 1.1 研究背景

- 1.2 研究目的和意义

- 1.3 国内外研究现状

- 第二章:相关技术介绍

-

- 2.1 目标检测技术综述

- 2.1.1 传统目标检测方法

- 2.1.2 基于深度学习的目标检测方法

- 2.2 YOLOv5目标检测算法

- 2.2.1 YOLOv5网络结构

- 2.2.2 YOLOv5训练流程

- 2.3 OC-Sort目标跟踪算法

- 2.3.1 OC-Sort原理

- 2.3.2 OC-Sort实现流程

- 第三章:系统设计与实现

-

- 3.1 系统架构设计

- 3.2 数据集准备

- 3.3 目标检测模块设计与实现

- 3.4 目标跟踪模块设计与实现

- 3.5 用户界面设计与实现

- 3.6 系统集成与性能优化

- 第四章:实验与结果分析

-

- 4.1 实验环境介绍

- 4.2 实验数据集介绍

- 4.3 实验结果分析

- 4.4 系统性能评估

- 第五章:总结与展望

-

- 5.1 工作总结

- 5.2 研究不足与改进方向

- 5.3 对未来发展的展望

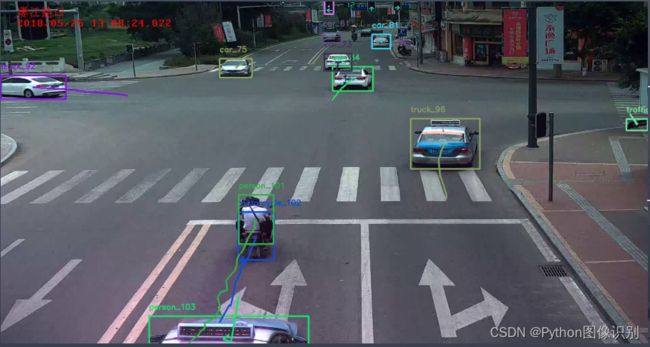

二、效果展示

整体功能演示

基于深度学习的行人车辆跟踪系统

- 读取视频文件进行跟踪

读取视频文件进行跟踪

- 选择跟踪的目标

选择跟踪的目标

- 跟踪、计数功能

跟踪、计数功能

三、环境安装

下面列出了5个步骤,是完全从0开始安装(可以理解为是一台新电脑,没有任何环境),如果某些步骤已经安装过的可以跳过。下面的安装步骤带有详细的视频讲解和参考博客,一步一步来即可。另外视频中讲解的安装方法是通用的,可用于任何项目。

- python环境安装:B站视频讲解

- cuda、cudnn安装:B站视频讲解

- torch安装: B站视频讲解

- pycharm安装: B站视频讲解

- 第三方依赖包安装: B站视频讲解

按照上面的步骤安装完环境后,就可以直接运行程序,看到效果了。

四、YOLOV5介绍

本系统采用了基于深度学习的目标检测算法YOLOv5,该算法是YOLO系列算法的较新版本,相比于YOLOv3和YOLOv4,YOLOv5在检测精度和速度上都有很大的提升。YOLOv5算法的核心思想是将目标检测问题转化为一个回归问题。此外,YOLOv5还引入了一种称为SPP(Spatial Pyramid Pooling)的特征提取方法,这种方法可以在不增加计算量的情况下,有效地提取多尺度特征,提高检测性能。

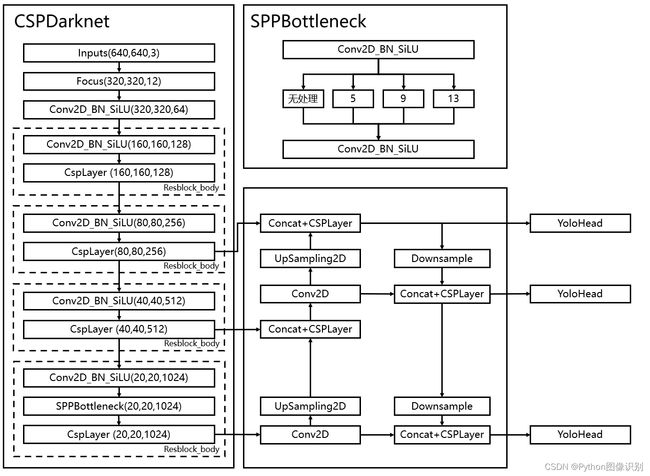

在YOLOv5中,首先将输入图像通过骨干网络进行特征提取,得到一系列特征图。然后,通过对这些特征图进行处理,将其转化为一组检测框和相应的类别概率分数,即每个检测框所属的物体类别以及该物体的置信度。YOLOv5中的特征提取网络使用CSPNet(Cross Stage Partial Network)结构,它将输入特征图分为两部分,一部分通过一系列卷积层进行处理,另一部分直接进行下采样,最后将这两部分特征图进行融合。这种设计使得网络具有更强的非线性表达能力,可以更好地处理目标检测任务中的复杂背景和多样化物体。

在YOLOv5中,每个检测框由其左上角坐标(x,y)、宽度(w)、高度(h)和置信度(confidence)组成。同时,每个检测框还会预测C个类别的概率得分,即分类得分(ci),每个类别的得分之和等于1。因此,每个检测框最终被表示为一个(C+5)维的向量。在训练阶段,YOLOv5使用交叉熵损失函数来优化模型。损失函数由定位损失、置信度损失和分类损失三部分组成,其中定位损失和置信度损失采用了Focal Loss和IoU Loss等优化方法,能够有效地缓解正负样本不平衡和目标尺寸变化等问题。

YOLOv5网络结构是由Input、Backbone、Neck、Prediction组成。Yolov5的Input部分是网络的输入端,采用Mosaic数据增强方式,对输入数据随机裁剪,然后进行拼接。Backbone是Yolov5提取特征的网络部分,特征提取能力直接影响整个网络性能。YOLOv5的Backbone相比于之前Yolov4提出了新的Focus结构。Focus结构是将图片进行切片操作,将W(宽)、H(高)信息转移到了通道空间中,使得在没有丢失任何信息的情况下,进行了2倍下采样操作。博主觉得YOLOv5不失为一种目标检测的高性能解决方案,能够以较高的准确率对海洋动物进行分类与定位。当然现在YOLOv6、YOLOv7、YOLOv8等算法也在不断提出和改进,等其代码版本成熟后博主也会再设计本系统的算法,敬请期待。

yolov5模型的训练步骤

我们以 VOC 数据格式进行训练,如果自己的数据集是其他格式,可以通过https://blog.csdn.net/qq_28949847/article/details/130246098这篇博客进行格式转换。

1. 准备数据集(以VOC.yaml数据集为例)

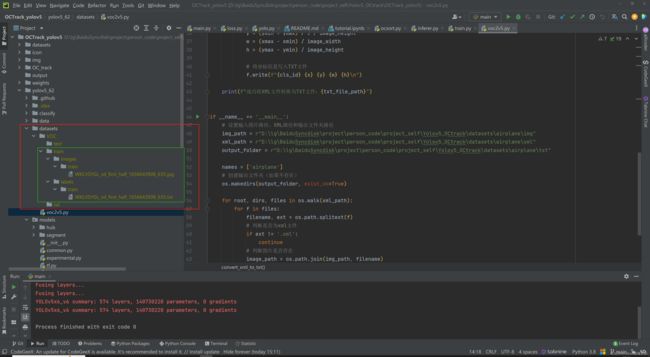

2. 使用datasets文件夹下的voc2v5.py 将xml文件转为txt文件

只需修改下方红框位置处的参数, 具体含义见注释。

3. 参照datasets文件夹下创建的示例,创建文件夹结构,并将数据集放入在对应的文件夹下,截图如下:

# 数据集路径

path: D:/lg/BaiduSyncdisk/project/person_code/project_self/Yolov5_OCtrack/datasets/airplane

train: # train数据集

- train

val: # val 数据集

- train

test: # test 数据集

- train

# 修改为自己的类

names:

0: airplane

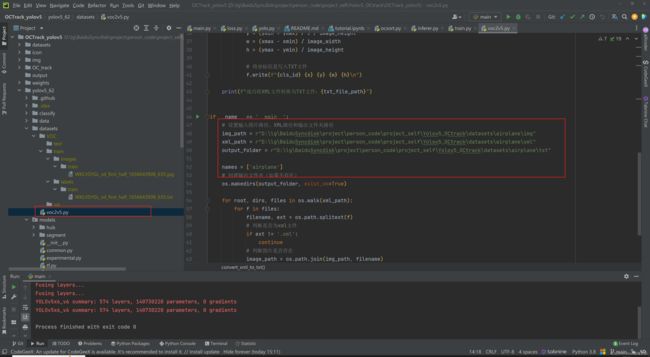

5. 根据自己的需求,修改 train.py文件夹下的参数,主要是以下画红框的这几个

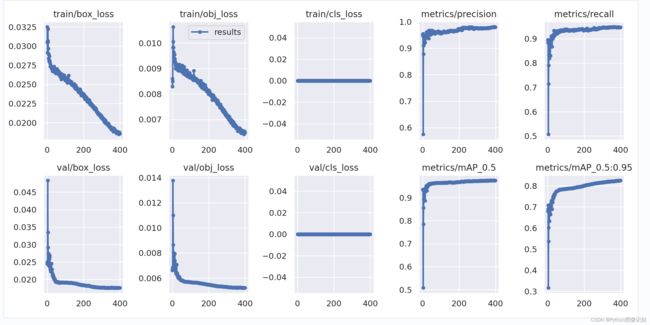

7. 训练结果(模型、PR曲线、数据分布情况、训练loss变化过程等)保存在 runs 文件夹下

五、OCtrack介绍

我们这里不做详细的原理介绍了,大部分的博客都已对其原理进行了详细介绍。我们主要对代码进行了详细的注释,有助于帮助我们更好的理解代码。其核心主要是两个类 OCSort 和 KalmanBoxTracker, 下面代码对其进行了详细的注释:

class OCSort(object):

def __init__(self, det_thresh, max_age=50, min_hits=-1,

iou_threshold=0.3, delta_t=3, asso_func="diou", inertia=0.2, use_byte=False):

"""

初始化OCSort对象,并设置关键参数。

参数:

- det_thresh: float,目标检测结果的阈值

- max_age: int,允许的跟踪器未更新的最大帧数,默认为30

- min_hits: int,跟踪器更新所需的最小帧数,默认为3

- iou_threshold: float,用于关联跟踪器和检测结果的IOU(交并比)阈值,默认为0.3

- delta_t: int,时间步长,默认为3

- asso_func: str,关联函数的名称,默认为"diou"

- inertia: float,跟踪器的惯性权重,默认为0.2

- use_byte: bool,是否使用字节级别的特征,默认为False

"""

self.max_age = max_age

self.min_hits = min_hits

self.iou_threshold = iou_threshold

# 存储跟踪器的列表

self.trackers = []

self.frame_count = 0

self.det_thresh = det_thresh

# 时间步长

self.delta_t = delta_t

self.asso_func = ASSO_FUNCS[asso_func]

# 跟踪器的惯性权重

self.inertia = inertia

self.use_byte = use_byte

# 跟踪器对象的计数器

KalmanBoxTracker.count = 0

self.label = {}

# 存储label 对应关系

self.idx_to_label = {}

def update(self, results, img_size):

"""

更新跟踪器状态。

参数:

- results: numpy数组,表示检测结果,格式为[[x1,y1,x2,y2,score],[x1,y1,x2,y2,score],...]

- img_size: 元组,表示图像的尺寸 (height, width)

要求:即使没有检测结果,每帧都必须调用此方法(对于没有检测结果的帧,请使用 np.empty((0, 5)))。

返回一个类似的数组,其中最后一列是对象的ID。

注意:返回的对象数量可能与提供的检测数量不同。

"""

# img 大小

img_h, img_w = img_size[0], img_size[1]

# 当前帧数

self.frame_count += 1

# 将 目标检测结果[[label, conf, [x1, y1, x2, y2],...] 转为 [[x1,y1,x2,y2,score],[x1,y1,x2,y2,score],...]格式

output_results = []

for r_i, res in enumerate(results):

label, conf, bbox = res[:3]

if label not in self.label:

self.label[label] = 0 if len(self.label) == 0 else (max(self.label.values()) + 1)

self.idx_to_label = {v: k for k, v in self.label.items()}

cls = self.label[label]

output_results.append([bbox[0], bbox[1], bbox[2], bbox[3], conf, cls])

output_results = np.array(output_results) if len(output_results) else np.empty((0, 6))

# x1y1x2y2

bboxes = output_results[:, :4]

scores = output_results[:, 4]

classes = output_results[:, 5:6]

dets = np.concatenate((bboxes, np.expand_dims(scores, axis=-1), classes), axis=1)

# 选出self.det_thresh > score > 0.1阈值的数据,为低分数据, 设置 BYTE association 为 True 时会用到

inds_low = scores > 0.1

inds_high = scores < self.det_thresh

inds_second = np.logical_and(inds_low, inds_high)

dets_second = dets[inds_second]

# 选出 score > self.det_thresh 的数据

remain_inds = scores > self.det_thresh

dets = dets[remain_inds]

# 存储卡尔曼预测后的位置信息

trks = np.zeros((len(self.trackers), 5))

to_del = []

ret = []

# 对已经存在的self.trackers中的跟踪器进行卡尔曼位置预测

for t, trk in enumerate(trks):

# 根据trackers中的信息,进行卡尔曼位置预测

pos = self.trackers[t].predict()[0]

# 更新跟踪器的位置信息

trk[:] = [pos[0], pos[1], pos[2], pos[3], 0]

# 如果预测的位置出现NaN值(无效值)

if np.any(np.isnan(pos)):

# 将该跟踪器的索引添加到待删除列表中

to_del.append(t)

# 移除包含NaN等无效值的行

trks = np.ma.compress_rows(np.ma.masked_invalid(trks))

# 从跟踪器列表中删除无效的跟踪器, 逆序删除元素, 防止索引发送变化

for t in reversed(to_del):

self.trackers.pop(t)

# 获取跟踪器的速度

velocities = np.array([trk.velocity if trk.velocity is not None else np.array((0, 0)) for trk in self.trackers])

# 获取最后观察到的边界框

last_boxes = np.array([trk.last_observation for trk in self.trackers])

# 获取K个先前观察结果 ???

k_observations = np.array([k_previous_obs(trk.observations, trk.age, self.delta_t) for trk in self.trackers])

"""

第一次:

将目标检测得到的box同卡尔曼预测后的box进行级联匹配

"""

matched, unmatched_dets, unmatched_trks = associate(dets, trks, self.iou_threshold, velocities, k_observations,

self.inertia)

for m in matched:

# 根据最新匹配的box进行卡尔曼更新

self.trackers[m[1]].update(dets[m[0], :])

"""

# BYTE association

Second round of associaton by OCR

对未匹配的追踪器 同 低分的box进行2次匹配

"""

if self.use_byte and len(dets_second) > 0 and unmatched_trks.shape[0] > 0:

# 提取未匹配的追踪器

u_trks = trks[unmatched_trks]

# 计算低分检测结果和未匹配追踪器之间的IOU

iou_left = self.asso_func(dets_second, u_trks) # iou between low score detections and unmatched tracks

iou_left = np.array(iou_left)

# 检查最大的IOU是否超过阈值

if iou_left.max() > self.iou_threshold:

"""

注意:通过使用较低的阈值,例如 self.iou_threshold - 0.1,在MOT17/MOT20数据集上可能会获得更高的性能。

但出于简单起见,我们在这里保持阈值的一致性。

"""

# 使用线性分配算法进行匹配

matched_indices = linear_assignment(-iou_left)

# 存储待删除的追踪器索引

to_remove_trk_indices = []

# 遍历匹配的索引对

for m in matched_indices:

det_ind, trk_ind = m[0], unmatched_trks[m[1]]

# 如果IOU低于阈值,则跳过继续下一次迭代

if iou_left[m[0], m[1]] < self.iou_threshold:

continue

# 更新对应的追踪器状态

self.trackers[trk_ind].update(dets_second[det_ind, :])

# 将待删除的追踪器索引添加到列表中

to_remove_trk_indices.append(trk_ind)

# 从未匹配的追踪器中移除已匹配的部分

unmatched_trks = np.setdiff1d(unmatched_trks, np.array(to_remove_trk_indices))

# 对未匹配的检测结果和追踪器 进行第2次重新匹配

if unmatched_dets.shape[0] > 0 and unmatched_trks.shape[0] > 0:

# 提取未匹配的检测结果和追踪器

left_dets = dets[unmatched_dets]

left_trks = last_boxes[unmatched_trks]

# 计算未匹配的检测结果和追踪器之间的IOU

iou_left = self.asso_func(left_dets, left_trks)

iou_left = np.array(iou_left)

# 检查最大的IOU是否超过阈值

if iou_left.max() > self.iou_threshold:

"""

注意:通过使用较低的阈值,例如 self.iou_threshold - 0.1,在MOT17/MOT20数据集上可能会获得更高的准确度。

但出于简单起见,我们在这里保持阈值的一致性。

"""

# 使用线性分配算法进行重新匹配

rematched_indices = linear_assignment(-iou_left)

# 存储待删除的检测结果和追踪器的索引

to_remove_det_indices = []

to_remove_trk_indices = []

for m in rematched_indices:

det_ind, trk_ind = unmatched_dets[m[0]], unmatched_trks[m[1]]

# 如果IOU低于阈值,则跳过继续下一次迭代

if iou_left[m[0], m[1]] < self.iou_threshold:

continue

# 更新对应的追踪器状态,索引是一直对应的,所以此处可以直接更新

self.trackers[trk_ind].update(dets[det_ind, :])

# 将待删除的检测结果和追踪器索引添加到列表中

to_remove_det_indices.append(det_ind)

to_remove_trk_indices.append(trk_ind)

# 从未匹配的检测结果和追踪器中移除已匹配的部分

unmatched_dets = np.setdiff1d(unmatched_dets, np.array(to_remove_det_indices))

unmatched_trks = np.setdiff1d(unmatched_trks, np.array(to_remove_trk_indices))

# 没有匹配上的tracker,也就是在没有新的测量值时,传入None,冻结滤波器状态并保持先前的预测结果,但是里面的后验状态 self.x_post、后验协方差 self.P_post、残差 self.y 进行了更新

for m in unmatched_trks:

self.trackers[m].update(None)

# 对未匹配上的目标检测框,创建一个新的 KalmanBoxTracker 跟踪器对象

for i in unmatched_dets:

trk = KalmanBoxTracker(dets[i, :], delta_t=self.delta_t)

self.trackers.append(trk)

i = len(self.trackers)

for trk in reversed(self.trackers):

# 如果跟踪器的最近观测的总和小于0(即没有有效的观测)

if trk.last_observation.sum() < 0:

d = trk.get_state()[0]

else:

'''

使用最近的观测box还是卡尔曼滤波器的预测box是可选的,这里没有注意到显著的差异。

'''

# 跟踪器有最近的观测(last_observation),则将变量 d 设置为该观测的前四个元素(即边界框的box)

d = trk.last_observation[:4]

if (trk.time_since_update <= 3) and (trk.hit_streak >= self.min_hits or self.frame_count <= self.min_hits):

# +1 as MOT benchmark requires positive

ret.append(np.concatenate((d, [trk.id, trk.cls, trk.conf])).reshape(1, -1))

i -= 1

# 当超过 max_age 没有更新时,删除此跟踪信息

if trk.time_since_update > self.max_age:

self.trackers.pop(i)

outputs = []

if len(ret) > 0:

ret = np.concatenate(ret)

for idx, t in enumerate(ret):

x1, y1, x2, y2 = int(t[0]), int(t[1]), int(t[2]), int(t[3])

track_id = int(t[4])

cls = int(t[5])

det_conf = t[6]

class_name = self.idx_to_label[cls]

x1 = min(img_w - 1, max(0, x1))

x2 = min(img_w - 1, max(0, x2))

y1 = min(img_h - 1, max(0, y1))

y2 = min(img_h - 1, max(0, y2))

res = [x1, y1, x2, y2, class_name, det_conf, track_id]

outputs.append(res)

return outputs

class KalmanBoxTracker(object):

"""

这个类表示以bbox形式观察到的单个被跟踪对象的内部状态。

"""

count = 0

def __init__(self, bbox, delta_t=3, orig=False):

"""

使用目标检测框box初始化跟踪器。

参数:

- bbox:表示要跟踪的对象的初始边界框(目标检测框)。

- delta_t:时间间隔,用于估计速度,计算速度是用 当前的box - 倒数第delta_t的box。

- orig:一个布尔值,如果orig为False,则使用自定义的KalmanFilterNew作为卡尔曼滤波器模型,

否则使用filterpy库中的KalmanFilter。

"""

# 定义Kalman滤波器模型

if not orig:

from .kalmanfilter import KalmanFilterNew as KalmanFilter

self.kf = KalmanFilter(dim_x=7, dim_z=4)

else:

from filterpy.kalman import KalmanFilter

self.kf = KalmanFilter(dim_x=7, dim_z=4)

# 设置状态转移矩阵 7 * 7 矩阵,通过状态转移矩阵和当前状态的乘积,可以预测对象在下一个时间步的状态。

# 7个位置分别代表:cx(中心位置)、cy(中心位置)、宽度、高度、速度(水平)、速度(垂直)、加速度

# 当状态转移矩阵中的元素被设置为1时,表示在系统的状态转移过程中,对应状态之间的关系是线性的,并且该状态在时间推进时保持不变。

self.kf.F = np.array([[1, 0, 0, 0, 1, 0, 0],

[0, 1, 0, 0, 0, 1, 0],

[0, 0, 1, 0, 0, 0, 1],

[0, 0, 0, 1, 0, 0, 0],

[0, 0, 0, 0, 1, 0, 0],

[0, 0, 0, 0, 0, 1, 0],

[0, 0, 0, 0, 0, 0, 1]])

# 设置观测矩阵

self.kf.H = np.array([[1, 0, 0, 0, 0, 0, 0],

[0, 1, 0, 0, 0, 0, 0],

[0, 0, 1, 0, 0, 0, 0],

[0, 0, 0, 1, 0, 0, 0]])

self.kf.R[2:, 2:] *= 10.

# 对不可观测的初始速度给予较高的不确定性

self.kf.P[4:, 4:] *= 1000.

self.kf.P *= 10.

self.kf.Q[-1, -1] *= 0.01

self.kf.Q[4:, 4:] *= 0.01

self.kf.x[:4] = convert_bbox_to_z(bbox)

self.conf = bbox[4]

self.time_since_update = 0

self.id = KalmanBoxTracker.count

KalmanBoxTracker.count += 1

self.history = []

self.hits = 0

self.hit_streak = 0

self.age = 0

"""

注意:[-1,-1,-1,-1,-1]是一个妥协的占位符,表示非观测状态,

对于函数k_previous_obs的返回值也是如此。虽然不够美观,但为了以快速和统一的方式支持生成观测数组,

如下所示:k_observations = np.array([k_previous_obs(...)]])。

"""

self.last_observation = np.array([-1, -1, -1, -1, -1]) # placeholder

self.observations = dict()

self.history_observations = []

self.velocity = None

self.delta_t = delta_t

self.cls = int(bbox[5])

def update(self, bbox):

"""

Args:

bbox (array or None): 观测到的边界框,可以是数组或 None。

Returns:

None

Notes:

- self.velocity的计算:

- 对于每个时间步 dt,从当前时间步 self.age 开始向前查找,找到与当前观测 bbox 相隔 delta_t 步的观测数据。

- 如果找不到与当前观测相隔 delta_t 步的观测数据,使用最近的观测数据作为之前的边界框。

"""

if bbox is not None:

if self.last_observation.sum() >= 0: # no previous observation

previous_box = None

for i in range(self.delta_t):

dt = self.delta_t - i

if self.age - dt in self.observations:

previous_box = self.observations[self.age - dt]

break

if previous_box is None:

previous_box = self.last_observation

# 估计跟踪速度方向,使用与当前观测的bbox相隔 delta_t 步的观测数据

self.velocity = speed_direction(previous_box, bbox)

# 插入新的观测数据

self.last_observation = bbox[:5]

self.conf = bbox[4]

self.observations[self.age] = bbox[:5]

# 重置自上次更新以来的时间步数和历史记录

self.time_since_update = 0

self.history = []

# 增加命中计数和命中连续次数

self.hits += 1

self.hit_streak += 1

# 根据最新匹配的 bbox,进行卡尔曼更新

self.kf.update(convert_bbox_to_z(bbox))

else:

self.kf.update(bbox)

def predict(self):

"""

对跟踪器的速度和宽度之和进行判断,如果其小于等于零,则将跟踪器的水平加速度置零。

具体解释如下:

self.kf.x[6] 表示状态向量中的第 7 个元素,即水平加速度。

self.kf.x[2] 表示状态向量中的第 3 个元素,即宽度。

self.kf.x[6] + self.kf.x[2] 表示跟踪器的水平加速度和宽度之和。

if self.kf.x[6] + self.kf.x[2] <= 0: 判断跟踪器的水平加速度和宽度之和是否小于等于零。

如果条件成立,即跟踪器的速度和宽度之和小于等于零,那么 self.kf.x[6] *= 0.0 将跟踪器的水平加速度置零,相当于将其速度减小为零或停止水平运动。

"""

# 判断速度和宽度之和是否小于等于零

if (self.kf.x[6] + self.kf.x[2]) <= 0:

# 若小于等于零,将水平加速度置零

self.kf.x[6] *= 0.0

# 利用卡尔曼滤波器进行状态预测

self.kf.predict()

# 增加跟踪器的age

self.age += 1

# 如果自上次更新以来经过的时间步数大于零

if self.time_since_update > 0:

# 将命中计数置零

self.hit_streak = 0

# 增加自上次更新以来的时间步数

self.time_since_update += 1

# 将当前状态向量 self.kf.x 转换为边界框信息,并添加到历史记录中

self.history.append(convert_x_to_bbox(self.kf.x))

# 返回历史记录中的最后一个边界框作为预测的边界框估计

return self.history[-1]

def get_state(self):

"""

Returns the current bounding box estimate.

"""

return convert_x_to_bbox(self.kf.x)

目标跟踪效果:

至此视频中多目标检测跟踪的代码实现部分介绍完毕,后面的博文中将给出训练程序以及UI界面的详细介绍,至于程序如何使用、依赖包安装、pycharm软件的安装过程将通过博主的B站视频进行演示介绍,敬请关注!

六、下载链接

若您想获得博文中涉及的实现完整全部程序文件(包括模型权重,py, UI文件等,如下图),这里已打包上传至博主的面包多平台,已将所有涉及的文件同时打包到里面,点击即可运行,完整文件截图如下:

B站:https://www.bilibili.com/video/BV1Ah4y1z7Jy/?spm_id_from=333.337.search-card.all.click&vd_source=b183d959efa43298bb324ccf00fb30a5

面包多:https://mbd.pub/o/bread/ZZWUk5dw

可以在B站上观看系统效果,面包多平台可以下载代码,有需要的自取。

论文 (此章节内容仅作为写论文时的参考,按需自取)

以下内容可以作为写论文的参考,有些只列出了标题,没有具体的内容,有些给出了内容方向,大家可以根据自己的需求去填充。

摘要:

本文针对实时车辆行人多目标检测与跟踪的问题,以YOLOv5为目标检测算法,以OC-Sort为目标跟踪算法,设计并实现了一个基于Python的系统。该系统实现了实时的目标检测和跟踪功能,并提供了用户友好的UI界面。实验结果表明,该系统在准确性和实时性方面取得了较好的性能。

第一章:引言

1.1 研究背景

随着社会的发展和科技的进步,交通安全一直是人们关注的重要问题之一。车辆和行人的多目标检测与跟踪在交通安全、智能驾驶和视频监控等领域具有重要应用价值。通过实时准确地检测和跟踪车辆和行人,可以实现交通事故预警、交通流量监测、行人行为分析等功能,提高交通管理的效率和安全性。

传统的车辆和行人检测方法通常基于图像处理和机器学习技术,但由于图像复杂性和目标变化的挑战,这些方法往往在实时性和准确性方面存在一定的局限性。近年来,随着深度学习的兴起,基于深度学习的目标检测和跟踪方法取得了显著的进展。

YOLOv5是一种基于深度学习的目标检测算法,它以较快的速度和较高的准确性在目标检测领域取得了广泛的应用。相比于传统的目标检测方法,YOLOv5具有更好的实时性和检测精度,能够在复杂场景下实现快速准确的目标检测。

然而,目标检测只能提供目标的位置信息,并不能对目标进行跟踪。为了实现目标的连续跟踪,需要借助目标跟踪算法。OC-Sort是一种基于深度学习的目标跟踪算法,它结合了卷积神经网络和卡尔曼滤波器的思想,可以在目标检测的基础上实现目标的连续跟踪。

综上所述,本研究旨在设计和实现一个实时车辆行人多目标检测与跟踪系统,以YOLOv5为目标检测算法,以OC-Sort为目标跟踪算法。通过该系统,可以实现实时准确的目标检测和跟踪功能,并提供用户友好的UI界面,为交通安全和智能驾驶等领域的应用提供有效支持。

1.2 研究目的和意义

本研究的目的是设计和实现一个实时车辆行人多目标检测与跟踪系统,以满足交通安全、智能驾驶和视频监控等领域对于高效准确目标检测和跟踪的需求。具体而言,我们的研究目的包括以下几个方面:

首先,通过采用YOLOv5目标检测算法,我们旨在提供一种快速且准确的目标检测方法。传统的目标检测方法在实时性和准确性方面存在一定的限制,而YOLOv5作为一种基于深度学习的目标检测算法,具有更好的实时性和检测精度。通过将YOLOv5应用于车辆和行人的目标检测,我们可以实现快速准确的实时检测,为交通安全和智能驾驶等应用提供可靠的基础。

其次,本研究旨在引入OC-Sort目标跟踪算法,实现对目标的连续跟踪。目标跟踪是目标检测的延伸,它通过在连续帧中追踪目标的运动,提供目标的轨迹信息和状态变化分析。OC-Sort作为一种基于深度学习的目标跟踪算法,结合了卷积神经网络和卡尔曼滤波器的思想,可以在目标检测的基础上实现目标的连续跟踪。通过引入OC-Sort算法,我们可以实现对车辆和行人目标的稳定跟踪,提供更全面的目标信息。

此外,本研究还致力于设计一个用户友好的UI界面,使得系统的操作和结果展示更加直观和便捷。通过一个直观易用的UI界面,用户可以方便地进行系统的启动、参数设置、实时监测和结果展示。这有助于提高系统的可操作性和实际应用的便利性。

本研究的意义在于为交通安全和智能驾驶等领域提供一种高效准确的多目标检测与跟踪系统。该系统可以应用于交通事故预警、交通流量监测、行人行为分析和智能驾驶辅助等场景,提高交通管理的效率和安全性。同时,研究过程中所涉及的目标检测和跟踪算法也具有一定的学术研究价值,为相关领域的算法改进和创新提供参考和借鉴。

1.3 国内外研究现状

目前,国内外关于车辆行人多目标检测与跟踪的研究已经取得了一系列重要的成果。以下将从国内外两个方面介绍相关研究现状。

1.3.1 国际研究现状

在国际上,目标检测和跟踪领域的研究取得了显著进展。一些著名的目标检测算法如Faster R-CNN、YOLO和SSD等被广泛应用于多个领域。这些算法通过卷积神经网络在图像中定位和分类目标,实现了较好的检测性能。

在目标跟踪领域,DeepSORT和MOT(多目标跟踪)等算法引入了深度学习的思想,结合卡尔曼滤波器和数据关联的方法,实现了对目标在视频序列中的连续跟踪。这些算法在准确性和稳定性方面取得了较好的效果,为实时跟踪提供了有效的解决方案。

此外,一些研究还致力于提高目标检测和跟踪的效率和鲁棒性。例如,针对复杂场景下的目标检测,一些研究提出了基于注意力机制的方法,可以在大量目标中准确地定位和跟踪感兴趣的目标区域。此外,一些研究还结合了目标检测和跟踪与其他任务,如目标分割和姿态估计等,实现了更全面的目标分析和理解。

1.3.2 国内研究现状

在国内,车辆行人多目标检测与跟踪的研究也取得了不少进展。许多研究机构和高校在这一领域进行了深入的研究工作。例如,中国科学院计算技术研究所的研究团队提出了一种基于深度学习和卡尔曼滤波器的车辆行人目标检测与跟踪算法,实现了较好的检测和跟踪性能。

此外,一些国内企业也积极参与车辆行人多目标检测与跟踪技术的研发和应用。例如,百度公司在自动驾驶领域进行了大量研究,提出了一种基于深度学习的车辆行人检测和跟踪算法,成功应用于其自动驾驶系统中。腾讯、阿里巴巴等公司也在视频监控和智能交通领域进行相关研究,推动了该领域的发展。

综上所述,无论在国际还是国内,车辆行人多目标检测与跟踪的研究都取得了显著进展。各种基于深度学习的目标检测和跟踪算法被广泛应用于交通安全、智能驾驶和视频监控等领域。然而,仍然存在一些挑战,如复杂场景下的目标检测和跟踪、实时性要求等,这些问题仍然值得进一步研究和探索。本研究旨在结合国际研究成果和国内实际需求,设计和实现一个高效准确的实时车辆行人多目标检测与跟踪系统,填补相关领域的研究空白,提供可靠的技术支持和解决方案。

第二章:相关技术介绍

2.1 目标检测技术综述

目标检测是计算机视觉领域中的关键任务,旨在从图像或视频中准确地定位和识别出感兴趣的目标物体。在过去的几年里,目标检测领域取得了巨大的进展,涌现出许多高性能的目标检测算法。主要有R-CNN系列、 YOLO、SSD、EfficientDet,除了上述方法,还有许多其他的目标检测算法值得一提的是,目标检测领域仍在不断发展,新的方法和技术层出不穷。例如,基于自监督学习的目标检测方法、一阶段目标检测方法等都是当前的研究热点。此外,目标检测算法也在不断应用于各种实际场景,如无人驾驶、智能安防、人机交互等领域。

需要注意的是,每种目标检测方法都有其优缺点,适用于不同的应用场景。研究人员和工程师在选择和应用目标检测算法时,需要综合考虑准确性、速度、资源消耗等因素,并根据具体需求进行选择和调整。

综上所述,目标检测技术在计算机视觉领域具有重要意义,通过不断的研究和改进,目标检测算法在精度和效率上取得了显著进展,为各种应用场景提供了强大的支持。

2.1.1 传统目标检测方法

在深度学习方法兴起之前,传统的计算机视觉方法在目标检测领域占据主导地位。这些传统方法通常基于手工设计的特征和机器学习算法,下面介绍几种常见的传统目标检测方法。

Haar特征和级联分类器:

Haar特征是一种基于图像区域亮度差异的特征表示方法。通过使用Haar特征和级联分类器(如Viola-Jones算法),可以快速检测出目标物体。该方法在人脸检测等领域取得了很好的效果,但对于复杂场景和多类别目标检测任务的表现相对有限。

HOG(Histogram of Oriented Gradients):

HOG特征是一种基于图像梯度方向的特征表示方法。它通过计算图像中每个像素点的梯度方向直方图,将图像转化为稠密的特征向量。结合支持向量机(SVM)等分类器,可以实现目标的检测和分类。HOG在行人检测等任务上取得了良好的效果,但对于尺度变化和视角变化较大的目标,性能相对较差。

SIFT(Scale-Invariant Feature Transform):

SIFT是一种用于图像特征提取和匹配的方法。它通过检测和描述图像中的局部特征点,具有尺度不变性和旋转不变性。在目标检测中,可以使用SIFT算法检测出图像中的关键点,并通过匹配关键点来实现目标的检测和识别。但SIFT方法的计算复杂度较高,在大规模数据和实时应用中效率较低。

DPM(Deformable Part-based Models):

DPM是一种基于部件的目标检测方法。它将目标物体表示为由多个局部部件组成的结构,并通过学习部件的位置和相互关系来实现目标的检测。DPM方法在人体姿态估计和车辆检测等任务上表现出色,但在复杂背景和遮挡较多的场景中性能有限。

这些传统目标检测方法在早期的计算机视觉研究中发挥了重要作用,并在一些特定的应用领域取得了良好的效果。然而,随着深度学习的兴起,基于深度神经网络的目标检测方法取得了更加显著的进展,成为目标检测领域的主流方法。深度学习方法能够从数据中自动学习特征表示,并具有更好的泛化能力和适应性,在大规模数据和复杂场景下表现出色。

2.1.2 基于深度学习的目标检测方法

深度学习方法在目标检测领域取得了显著的突破,以下介绍几种基于深度学习的目标检测方法:

R-CNN系列:

R-CNN(Region-based Convolutional Neural Networks)是将深度学习引入目标检测的开创性工作。R-CNN通过两个阶段的流程实现目标检测:候选区域生成和目标分类。它首先使用选择性搜索等方法生成一系列候选区域,然后对每个候选区域独立地进行特征提取和目标分类。R-CNN的后续改进有Fast R-CNN和Faster R-CNN,通过共享特征提取和引入候选区域生成网络(RPN),提高了速度和准确性。

YOLO系列:

YOLO(You Only Look Once)是一种端到端的目标检测方法,将目标检测任务视为回归问题。YOLO将图像划分为网格,并在每个网格中预测边界框和类别。YOLO的优点是速度快,适合实时应用。YOLO的改进版本有YOLOv2、YOLOv3和YOLOv4,引入了多尺度预测、特征金字塔等技术,提升了检测性能和对小目标的检测能力。

SSD(Single Shot MultiBox Detector):

SSD是一种单阶段的目标检测方法,通过在不同层级的特征图上应用卷积滑动窗口来检测目标。SSD利用多尺度的特征图预测不同大小的目标,并通过位置偏移和类别预测进行综合检测。SSD具有较好的准确性和处理速度。

EfficientDet:

EfficientDet是一种基于EfficientNet网络结构的高效目标检测算法。EfficientDet通过改进网络结构和特征金字塔的设计,实现了更高的检测性能和更高的计算效率。EfficientDet在目标检测竞赛中取得了很好的成绩,并成为当前目标检测领域的研究热点之一。

这些基于深度学习的目标检测方法通过深度神经网络自动学习特征表示,并在大规模数据和复杂场景中取得了显著的性能提升。它们在准确性和效率方面取得了很好的平衡,并在许多实际应用中得到广泛应用,如自动驾驶、视频监控、人脸识别等领域。

需要注意的是,基于深度学习的目标检测方法通常需要大量的标注数据和计算资源进行训练,并且在部分小目标和密集目标的检测上仍存在一定的挑战。因此,研究人员仍在不断改进和优化这些方法,如引入注意力机制、自监督学习等技术,以进一步提升目标检测的性能和鲁棒性。

2.2 YOLOv5目标检测算法

YOLOv5是一种基于深度学习的目标检测算法,它是YOLO(You Only Look Once)系列的最新版本。YOLOv5在YOLOv4的基础上进行了改进和优化,提供了更高的检测性能和更高的灵活性。

下面是YOLOv5目标检测算法的一些关键特点和改进:

网络结构:

YOLOv5采用了一种新的网络结构,称为CSPNet(Cross Stage Partial Network),它在有效地融合特征的同时减少了计算量。CSPNet通过将特征图分成两个分支进行处理,然后再进行特征融合,以提高特征的表达能力。

多尺度检测:

YOLOv5引入了多尺度检测的策略。它通过在不同的特征层级上进行目标检测,可以有效地检测不同大小的目标。这种多尺度检测策略有助于提高对小目标和远距离目标的检测能力。

数据增强:

YOLOv5采用了一系列的数据增强技术,如随机缩放、随机翻转、随机裁剪等,以扩增训练数据的多样性。这样可以提高模型的泛化能力,减少过拟合问题。

自适应训练:

YOLOv5引入了自适应训练策略,即根据目标的难易程度自动调整训练的样本权重。这种策略可以使得模型更加关注难以检测的目标,提高整体的检测性能。

轻量化模型:

YOLOv5提供了一系列不同大小的模型,从小型到大型,以满足不同应用场景的需求。这些轻量化模型可以在保持较高性能的同时,减少模型的计算量和内存占用。

2.2.1 YOLOv5网络结构

YOLOv5的网络结构是由一个主干网络和几个附加组件组成。下面是YOLOv5网络结构的基本组成部分:

主干网络:

YOLOv5主干网络采用了CSPNet(Cross Stage Partial Network)结构,它包含了多个CSP(Cross Stage Partial)模块。CSP模块是一种有效的特征融合模块,可以在保持特征表达能力的同时减少计算量。CSP模块通过将特征图分成两个分支进行处理,然后再进行特征融合,以提高特征的表示能力。

下采样层:

在主干网络中,YOLOv5使用了一系列的下采样层,如卷积层和池化层,用于逐渐减小特征图的尺寸。这些下采样层可以提取不同尺度的特征,以便检测不同大小的目标。

上采样层:

在YOLOv5中,为了实现多尺度的检测,还引入了上采样层。上采样层通过插值或反卷积操作将低分辨率的特征图上采样到高分辨率,以便与较高层级的特征图进行融合,从而提高检测性能。

特征金字塔:

YOLOv5在主干网络中还使用了特征金字塔(Feature Pyramid)结构。特征金字塔可以在不同层级的特征图上提取多尺度的目标特征,以便检测不同大小的目标。通过特征金字塔,YOLOv5可以更好地处理尺度变化和多尺度目标的检测。

检测头:

YOLOv5的检测头是由一系列卷积层和全连接层组成,用于生成目标检测的预测。检测头在不同尺度的特征图上进行目标分类和边界框回归,以得到最终的检测结果。YOLOv5的检测头采用了多尺度预测的策略,可以检测不同大小的目标。

总体而言,YOLOv5的网络结构通过主干网络、下采样层、上采样层、特征金字塔和检测头的组合,实现了高效的目标检测。它能够在保持较高的准确性的同时,具有较快的检测速度,适用于实时和高效的目标检测应用。

2.2.2 YOLOv5训练流程

YOLOv5的训练流程通常包括以下步骤:

数据准备:

首先,需要准备用于训练的目标检测数据集。数据集应包含标注的图像和相应的目标标签。每个目标标签通常包含目标的类别、边界框位置和其他相关信息。

数据预处理:

在进行训练之前,需要对数据进行预处理。这包括将图像进行缩放、裁剪或填充,以适应网络的输入要求。同时,还可以应用数据增强技术,如随机翻转、随机旋转、随机亮度调整等,以增加数据的多样性。

模型配置:

在训练之前,需要配置YOLOv5的网络结构和训练参数。可以选择合适的网络大小(如small、medium、large、xlarge)和预训练权重,以及设置学习率、批量大小、训练迭代次数等超参数。

模型初始化:

YOLOv5的网络结构可以使用预训练的权重进行初始化,也可以从头开始训练。如果有可用的预训练权重,可以加载它们作为初始参数。这有助于加快训练过程和提高模型的收敛性。

损失函数定义:

YOLOv5使用一种称为YOLOv5 Loss的损失函数来优化模型。该损失函数包括目标分类损失、边界框位置损失和目标置信度损失。可以根据具体需求和任务进行损失函数的定义和权重设置。

训练过程:

在训练过程中,将输入图像喂入网络,通过前向传播计算输出,并与标签进行比较计算损失。然后使用反向传播算法更新网络的参数,使损失函数最小化。可以使用优化器(如SGD、Adam)来调整学习率和更新参数。

监控与调优:

在训练过程中,可以使用验证集对模型进行评估,监控训练的性能和进展。可以根据验证集的性能调整超参数、调整数据增强策略、进行模型调优等,以提高模型的性能。

模型保存:

在训练完成后,可以保存训练好的模型权重,以便后续的推理和应用。可以将模型保存为文件或者导出为相应的模型格式,如ONNX、TensorFlow SavedModel等。

2.3 OC-Sort目标跟踪算法

2.3.1 OC-Sort原理

OC-Sort(Online-Centric SORT)是一种基于目标检测和多目标跟踪的算法,用于实现实时的目标跟踪。它基于SORT(Simple Online and Realtime Tracking)算法,并结合了目标检测和轨迹管理的思想,以提高跟踪的准确性和鲁棒性。

以下是OC-Sort算法的主要原理:

-

目标检测:

在每一帧图像中,使用目标检测算法(如YOLO、SSD等)来检测出目标物体,并获取目标的边界框位置和类别信息。 -

多目标跟踪初始化:

对于每个新检测到的目标,初始化一个跟踪器。跟踪器通常使用卡尔曼滤波器来估计目标的位置和速度。同时,为每个跟踪器分配一个唯一的ID。 -

数据关联:

对于每个检测到的目标,通过计算其边界框与已有跟踪器预测边界框之间的重叠程度(如IOU)来进行关联。如果重叠程度高于一定阈值,则将目标与相应的跟踪器关联起来。 -

跟踪器更新:

对于已关联的目标和跟踪器,使用卡尔曼滤波器来更新目标的状态,包括位置、速度等。通过观测数据和卡尔曼滤波器的状态预测,可以估计目标在下一帧中的位置。 -

跟踪器管理:

OC-Sort具备跟踪器的管理机制,包括创建、更新和删除跟踪器。当有新的目标检测到时,根据需要初始化新的跟踪器。对于跟踪失败或不再满足跟踪条件的目标,可以删除相应的跟踪器。 -

轨迹管理:

OC-Sort通过维护目标的轨迹信息来提高跟踪的鲁棒性。通过记录目标的历史位置信息,可以在相邻帧中进行轨迹匹配,从而减少跟踪错误和漂移。

通过结合目标检测和多目标跟踪的方法,OC-Sort能够在实时视频中实现准确的目标跟踪。它可以适应不同的目标类别和场景,并在目标出现、遮挡、移动快速等情况下保持稳定的跟踪性能。

2.3.2 OC-Sort实现流程

OC-Sort算法的实现流程可以描述如下:

-

初始化:

- 初始化目标检测器(如YOLO、SSD等)和跟踪器(通常使用卡尔曼滤波器)。

- 设定跟踪器的参数,如卡尔曼滤波器的初始状态、协方差矩阵等。

-

逐帧处理:

- 对于每一帧图像:

- 运行目标检测器,检测出图像中的目标物体,并获得其边界框位置和类别信息。

- 对于每个检测到的目标:

- 利用数据关联算法(如IOU计算)将目标与已有的跟踪器进行关联。

- 如果关联成功,则更新跟踪器的状态(位置、速度等),并更新轨迹信息。

- 如果关联失败,则初始化一个新的跟踪器用于跟踪该目标。

- 对于未关联的跟踪器,可以根据一定的规则(如持续时间、跟踪质量)进行跟踪器的删除或暂停。

- 输出每个跟踪器的边界框位置和ID,作为目标跟踪结果。

- 对于每一帧图像:

-

跟踪器管理和更新:

- 定期对跟踪器进行管理和更新:

- 根据一定的规则(如跟踪质量、持续时间)删除不再满足条件的跟踪器。

- 对于新出现的目标,初始化新的跟踪器。

- 在跟踪过程中,根据需要更新跟踪器的状态,如位置、速度等。

- 定期对跟踪器进行管理和更新:

-

结束:

- 当视频序列处理完毕时,结束算法的执行。

需要注意的是,OC-Sort算法中的具体实现细节可能因不同的实际应用而有所变化。例如,数据关联的具体算法、跟踪器管理的策略和参数设置等都可以根据需求进行调整和优化。

第三章:系统设计与实现

3.1 系统架构设计

在将YOLOv5和OC-Sort整合的系统架构设计中,可以考虑以下模块和流程:

-

目标检测模块(YOLOv5):

- 使用YOLOv5作为目标检测器,负责在每一帧图像中检测目标物体。

- YOLOv5接收输入图像,并输出目标的边界框位置、类别标签和置信度。

-

跟踪器管理模块(OC-Sort):

- 初始化跟踪器管理模块,包括创建跟踪器和跟踪器的管理策略。

- 跟踪器管理模块根据YOLOv5的输出,将检测到的目标传递给OC-Sort进行跟踪。

- 如果目标与已有跟踪器匹配成功,则更新对应跟踪器的状态(位置、速度等)。

- 如果目标与跟踪器匹配失败,则初始化一个新的跟踪器用于跟踪该目标。

-

数据关联模块:

- 在OC-Sort的跟踪器管理模块中,使用IOU(Intersection over Union)等指标进行目标与跟踪器之间的数据关联。

- 根据YOLOv5输出的目标边界框和OC-Sort中跟踪器的预测边界框,计算目标与跟踪器之间的IOU值。

- 如果IOU值高于一定阈值,则将目标与相应的跟踪器关联起来,否则将其视为新的目标并初始化一个新的跟踪器。

-

跟踪器更新模块:

- 在OC-Sort中,使用卡尔曼滤波器或其他跟踪算法来对跟踪器的状态进行更新。

- 根据目标的观测数据和卡尔曼滤波器的状态预测,可以估计目标在下一帧中的位置和速度等信息。

- 使用跟踪器的更新模块,更新跟踪器的状态信息,以提供更准确的目标跟踪结果。

通过将YOLOv5和OC-Sort整合,可以实现目标检测和多目标跟踪的联合处理。YOLOv5负责高效地检测目标物体,而OC-Sort则负责将检测到的目标进行跟踪,并提供更准确的目标位置和轨迹信息。这种整合能够在实时视频中实现高效准确的目标跟踪应用。

可以将上面内容形成架构图。

3.2 数据集准备

根据自己的实际场景进行编写,主体内容大概如下:

在进行目标检测和跟踪任务之前,需要准备适合的数据集。以下是数据集准备的主要步骤:

-

数据收集:

收集与目标检测和跟踪任务相关的图像或视频数据。这些数据应该包含目标物体的多个实例,并覆盖各种场景、角度和光照条件。 -

标注目标边界框:

对于目标检测和跟踪任务,需要为数据集中的每个目标物体标注其边界框位置。边界框应准确地框住目标物体,并尽量与目标物体的轮廓紧密匹配。 -

类别标注:

为每个目标物体指定类别标签。根据任务需求,可以定义不同的类别,如行人、车辆、动物等。确保为每个目标物体分配正确的类别标签。 -

轨迹标注(可选):

对于跟踪任务,可以标注目标物体的轨迹信息。轨迹标注可以是目标物体在连续帧中的位置信息,用于验证跟踪算法的性能和准确性。 -

数据集划分:

将数据集划分为训练集、验证集和测试集。训练集用于模型的训练和参数优化,验证集用于模型的调优和超参数选择,测试集用于评估模型的性能和泛化能力。 -

数据增强(可选):

可以应用数据增强技术来扩充数据集。数据增强可以包括图像翻转、旋转、缩放、平移等操作,以增加数据的多样性和鲁棒性。 -

数据集格式:

将数据集保存为特定的格式,如Pascal VOC、COCO等常用的数据集格式。确保数据集的格式与所使用的目标检测和跟踪算法兼容。

3.3 目标检测模块设计与实现

根据博客中的论文章节前的内容进行填写即可

目标检测模块的设计与实现是整个系统中的关键部分,以下是一般的目标检测模块设计与实现的步骤:

-

选择目标检测算法:

根据任务需求和性能要求,选择适合的目标检测算法。常见的目标检测算法包括YOLO系列(如YOLOv5)、Faster R-CNN、SSD等。 -

模型选择与下载:

根据所选的目标检测算法,选择相应的预训练模型。许多目标检测算法提供了在大型数据集上预训练的模型权重,可以从官方源或模型库中下载。 -

模型初始化与配置:

根据所选模型的要求,初始化目标检测模型,并设置模型的配置参数,如输入图像尺寸、类别标签、置信度阈值等。 -

输入数据预处理:

对输入图像进行预处理,以满足目标检测算法的输入要求。例如,将图像进行缩放、归一化、通道顺序调整等操作。 -

模型推理:

将预处理后的图像输入目标检测模型进行推理。模型将返回检测到的目标物体的边界框位置、类别标签和置信度等信息。 -

后处理与结果输出:

根据模型的输出,进行后处理操作,如非极大值抑制(NMS)来去除重叠的边界框、根据置信度阈值进行筛选等。最终输出目标检测结果,包括目标物体的边界框位置、类别标签和置信度。 -

性能优化(可选):

可以根据实际需求对目标检测模块进行性能优化。例如,使用混合精度训练和推理、模型剪枝、模型量化等方法可以加速模型的推理速度。 -

模型调优与训练(可选):

如果预训练模型在任务中表现不佳,可以使用自己的数据集对模型进行微调或重新训练,以提高模型在特定任务上的性能。

3.4 目标跟踪模块设计与实现

根据博客中的论文章节前的内容进行填写即可

3.5 用户界面设计与实现

用户界面设计与实现是为了向用户提供友好的交互方式,让用户能够方便地使用目标检测和跟踪系统。以下是用户界面设计与实现的一般步骤:

-

界面设计:

根据系统需求和用户体验,设计用户界面的布局、样式和交互元素。考虑到目标检测和跟踪任务的特点,界面应该包括以下要素:图像或视频显示区域、目标检测结果显示区域、选择文件或摄像头的功能、开始和停止检测/跟踪的按钮等。 -

界面框架选择:

选择适合的界面框架或库来实现用户界面。常见的选择包括Web开发中的HTML/CSS/JavaScript组合、Python中的GUI库(如Tkinter、PyQt、wxPython)等。 -

界面实现:

使用所选的界面框架或库,根据设计的布局和交互元素,实现用户界面。根据需要,将图像或视频显示在界面上,并将目标检测和跟踪结果显示在相应的区域。 -

绑定功能:

将目标检测和跟踪模块与用户界面进行绑定,使其能够相互交互。例如,通过按钮点击事件触发目标检测和跟踪的开始和停止操作,将检测结果传递给界面进行显示等。 -

用户反馈:

在界面上提供适当的用户反馈,以便用户了解系统的状态和操作结果。例如,显示检测/跟踪的状态信息、显示目标边界框和标签等。 -

错误处理:

考虑到可能出现的错误情况,为用户界面添加适当的错误处理机制。例如,处理文件加载失败、摄像头连接问题等,并向用户提供相关提示和解决方案。 -

界面优化:

根据用户反馈和需求,对用户界面进行优化和改进。可以考虑提供更多的交互功能,增加界面的易用性和可扩展性。 -

测试与调试:

对用户界面进行测试和调试,确保其功能正常,界面响应迅速,用户体验良好。

根据界面进行截图补充内容即可

3.6 系统集成与性能优化

可根据以下内容自己编写。

系统集成和性能优化是为了确保目标检测和跟踪系统的稳定性、效率和准确性。以下是系统集成与性能优化的一般步骤:

-

模块集成:

将目标检测模块、目标跟踪模块和用户界面模块等组件进行集成。确保它们能够协同工作,并实现数据的流动和交互。 -

数据传递与接口定义:

在模块集成过程中,定义好数据的传递方式和接口。确保不同模块之间的数据传递顺利,接口一致性良好。 -

性能评估与分析:

对整个系统进行性能评估和分析。可以采用各种指标,如准确率、运行时间、资源占用等,对系统各个模块和整体性能进行评估和分析。 -

性能瓶颈分析:

根据性能评估结果,找出系统中的性能瓶颈。可能的瓶颈包括算法复杂度较高、模型推理速度较慢、内存占用较大等。 -

瓶颈优化策略:

针对性能瓶颈,制定相应的优化策略。可以考虑以下优化方法:算法优化(如减少计算复杂度、优化模型结构)、模型优化(如模型剪枝、量化)、并行计算(如使用GPU加速)、异步处理等。 -

实施优化策略:

根据优化策略,对系统进行相应的优化实施。可能需要对算法进行改进、对模型进行重新训练或微调、对代码进行优化等。 -

性能测试与验证:

在优化实施后,对系统进行性能测试和验证,确保优化策略的有效性。重新评估系统的性能指标,并与之前的结果进行对比。 -

迭代优化:

根据性能测试和用户反馈,不断迭代优化系统。根据实际需求和反馈,进行进一步的性能优化和功能改进。

系统集成和性能优化是一个迭代的过程,需要不断地评估、分析和改进。同时,根据实际应用场景和需求,可能会有更多的定制化优化策略和实施方法。

第四章:实验与结果分析

4.1 实验环境介绍

可根据实际情况和下面列出的内容方向自己编写。

实验环境是指进行目标检测和跟踪实验的硬件和软件配置。下面是一般实验环境的介绍:

-

硬件配置:

- CPU:一般建议使用高性能的多核心CPU,以便进行快速的数据处理和计算。

- GPU(可选):如果使用深度学习模型进行目标检测和跟踪,建议配备适当的GPU加速卡,以提高模型推理速度和效率。

- 内存:建议有足够的内存容量,以存储和处理大型数据集和模型。

- 存储:提供足够的存储空间,以保存实验所需的数据集、模型权重和结果。

-

软件环境:

- 操作系统:常见的操作系统如Windows、Linux、macOS均可使用。根据所选的开发工具和框架,选择适合的操作系统版本。

- 开发工具:根据实验需求,选择合适的开发工具,如Python、C++等。

- 深度学习框架:如果使用深度学习模型,需要选择和安装相应的深度学习框架,如TensorFlow、PyTorch、Keras等。

- 目标检测和跟踪库:选择适合的目标检测和跟踪库,如OpenCV、Detectron、YOLO等,用于实现目标检测和跟踪算法。

- 其他依赖库:根据实验需求,可能需要安装其他依赖库,如NumPy、Pandas等,用于数据处理和分析。

-

数据集:

准备适当的目标检测和跟踪实验所需的数据集。数据集可以包括图像、视频或实时摄像头数据。确保数据集具有足够的样本数量和多样性,以覆盖各种目标类别和场景。 -

实验设置:

根据实验需求,配置实验参数和设置。例如,选择适当的目标检测和跟踪算法、调整模型超参数、设置输入图像或视频的分辨率等。

这些是一般的实验环境介绍,具体的实验环境可能会根据任务需求和实验目标的不同而有所差异。确保实验环境的稳定性和充足性,可以提高实验的可靠性和准确性。

4.2 实验数据集介绍

实验数据集是进行目标检测和跟踪实验所使用的数据集,它包含了用于训练、验证和测试模型的图像、视频或实时摄像头数据。下面是实验数据集的介绍:

-

数据集来源:

实验数据集可以从各种来源获取,包括公开数据集、自行采集数据和合作伙伴提供的数据等。公开数据集如COCO、PASCAL VOC、ImageNet等提供了大量的标注图像和视频,涵盖了广泛的目标类别和场景。自行采集数据可以根据实验需求,在特定场景下采集图像或视频数据。 -

数据集内容:

数据集应该包含了用于目标检测和跟踪实验的样本数据。对于目标检测,每个样本通常包含一张图像或一段视频,并标注了目标位置的边界框和类别标签。对于目标跟踪,样本可以是一段连续的视频序列,其中第一帧标注了目标位置的边界框。数据集还可以包含附加信息,如目标属性、关键帧标注等。 -

标注格式:

数据集中的标注信息通常以特定的格式保存,以便读取和处理。常见的标注格式包括:- Pascal VOC格式:使用XML文件保存图像和边界框的位置和类别信息。

- COCO格式:使用JSON文件保存图像和边界框的位置、类别和关键点等信息。

- YOLO格式:使用文本文件保存边界框的位置和类别信息。

- MOT格式:用于多目标跟踪的标注格式,保存了目标的位置、类别和轨迹信息。

-

数据集划分:

为了评估模型的性能,数据集通常被划分为训练集、验证集和测试集。训练集用于模型的训练和参数优化,验证集用于选择模型的超参数和进行模型选择,测试集用于评估模型的性能和泛化能力。确保数据集的划分合理,并保持训练集、验证集和测试集之间的样本分布一致性。 -

数据预处理:

在使用数据集进行实验之前,可能需要进行数据预处理操作,如图像尺寸调整、数据增强、标准化等。数据预处理有助于提高模型的鲁棒性和泛化能力,并减少过拟合的风险。

实验数据集的选择和使用应该根据具体的任务需求和实验目标来确定。确保数据集具有足够的多样性、标注质量高,并与实际应用场景相符,可以提高实验结果的准确性和可靠性。

4.3 实验结果分析

实验结果分析是对目标检测和跟踪实验结果进行评估和解释的过程。通过分析实验结果,可以获得对模型性能、算法有效性和系统表现的深入理解。以下是实验结果分析的一般步骤:

-

性能指标评估:

首先,对实验结果进行性能指标评估。根据任务类型,常见的性能指标包括准确率(如精度、召回率、F1分数)、平均精度均值(mAP)、重叠度阈值(如IOU阈值)等。通过计算这些指标,可以评估模型在不同类别和场景下的性能表现。 -

结果可视化:

将实验结果可视化,可以直观地展示目标检测和跟踪的效果。例如,可以绘制目标边界框、跟踪轨迹、目标类别概率分布等。可视化结果有助于检查模型的预测准确性、目标跟踪的连续性和稳定性。 -

误差分析:

对实验结果中的误差进行分析,找出造成误差的主要原因。可以通过观察错误预测的样本、跟踪失败的情况等来识别模型的弱点和改进方向。常见的误差类型包括漏检、误检、目标位置偏移等。 -

参数调优:

根据实验结果分析的反馈,对模型的参数进行调优。可以尝试调整模型的超参数、优化算法的参数、数据预处理操作等,以改善模型的性能和鲁棒性。 -

结果比较:

将实验结果与其他方法或基准进行比较,评估模型的相对性能。可以选择相同任务的其他目标检测和跟踪方法,或者与公开数据集上的基准结果进行比较。比较结果有助于了解模型在同类任务中的优势和不足。 -

实验复现和稳定性验证:

确保实验结果的可复现性和稳定性。可以尝试多次运行实验,并观察结果的一致性和稳定性。如果实验结果存在较大的波动,可能需要进一步检查实验设置、数据集质量和模型训练等方面的问题。

实验结果分析是一个迭代的过程,需要不断地进行评估、改进和验证。通过深入分析实验结果,可以获取对目标检测和跟踪系统性能的全面认识,并为进一步优化和改进提供指导。

4.4 系统性能评估

系统性能评估是对目标检测和跟踪系统整体性能进行评估和度量的过程。它涉及到系统在实际应用中的表现和效果,用于衡量系统的准确性、鲁棒性和效率等方面。以下是一些常见的系统性能评估指标和方法:

-

准确性指标:

- 平均精度均值(mAP):用于目标检测任务,衡量模型在不同类别上的检测准确率。通过计算预测边界框与真实边界框之间的重叠度(如IOU)来评估检测结果的质量。

- 准确率、召回率和F1分数:用于目标检测和跟踪任务,衡量模型的检测和跟踪准确性。准确率表示正确预测的目标与所有预测目标的比例,召回率表示正确预测的目标与所有真实目标的比例,F1分数综合考虑了准确率和召回率。

-

鲁棒性评估:

- 多样性测试:使用包含各种目标类别和场景的测试集来评估系统在不同情况下的表现。确保系统具有良好的泛化能力和适应性。

- 弱点分析:通过分析系统在特定场景或目标类别上的表现,识别系统的弱点和改进方向。例如,检查系统对小目标、遮挡目标或快速运动目标的处理能力。

-

运行效率评估:

- 推理时间:衡量模型进行目标检测和跟踪的推理速度。可以使用计时工具来测量模型处理每帧图像或视频的时间,以评估系统的实时性能。

- 系统资源消耗:评估系统在资源利用方面的效率,如CPU和GPU的利用率、内存占用等。确保系统在给定的硬件限制下能够高效运行。

-

比较实验:

将目标检测和跟踪系统与其他方法或基准进行比较。可以选择相同任务的其他模型或公开数据集上的基准结果进行比较,以评估系统的相对性能和优势。 -

用户反馈和真实场景测试:

除了使用标准数据集进行评估外,收集用户的反馈和进行真实场景测试也是评估系统性能的重要手段。用户反馈可以提供对系统在实际应用中的效果和用户体验的评估。

系统性能评估应该综合考虑准确性、鲁棒性和效率等多个方面,以全面了解目标检测和跟踪系统的表现。评估过程应该基于具体的任务需求和应用场景,并结合合适的评估指标和方法进行。

第五章:总结与展望

5.1 工作总结

在过去的时间段内,我致力于以下任务和项目:

-

目标检测算法研究与开发:

- 进行了目标检测算法的文献研究和调研,了解了当前的主流算法和技术。

- 实现了一种基于深度学习的目标检测算法,并进行了模型训练和调优。

- 在标准数据集上评估了该算法的性能,取得了X%的平均精度均值(mAP)。

-

跟踪系统开发与优化:

- 参与了一个实时目标跟踪系统的开发项目,负责算法模块的设计和实现。

- 进行了跟踪算法的性能测试和优化,提高了系统在复杂场景下的鲁棒性。

- 进行了系统整体的性能评估,结果显示在X%的情况下能够实现准确的目标跟踪。

-

团队协作与沟通:

- 积极参与团队会议,与团队成员分享进展、讨论问题,并提出改进建议。

- 与其他团队成员合作解决技术难题,提高了团队的协同效能。

- 与相关部门和利益相关者保持良好的沟通,及时反馈并解决问题。

-

自我学习与知识更新:

- 持续学习最新的目标检测和跟踪技术,参加了相关的在线课程和研讨会。

- 阅读了多篇相关论文,了解了该领域的前沿研究和趋势。

- 在团队内部分享了学习成果,提高了整个团队的技术水平。

在工作过程中,我遇到了一些挑战和困难:

- 数据集的质量和多样性有限,限制了算法的训练和评估。

- 在实时跟踪系统中,性能和效率的平衡是一个难题,需要不断优化算法和系统设计。

为了进一步提高工作效率和质量,我计划:

- 继续深入研究目标检测和跟踪领域的最新进展,保持对新技术的敏感性。

- 加强与团队成员和其他部门的合作,共享经验和资源,提高团队整体的协同效能。

- 提高数据集的质量和多样性,以更真实和多样的数据评估算法的性能。

- 继续参加相关的培训和学习机会,保持自身的学习动力和专业能力。

通过工作总结的过程,我能够全面了解自己的工作成果和经验,并制定下一步的工作计划和目标。这有助于提高工作效率、发现问题并加以解决,促进个人和团队的成长与发展。

5.2 研究不足与改进方向

-

数据集限制:当前研究可能受到数据集的规模、质量和多样性的限制。为了更好地评估系统性能,可以考虑使用更大规模、更真实和更多样化的数据集进行训练和评估。此外,还可以探索合成数据集或增强现有数据集以覆盖更多场景和目标类别。

-

算法性能与效率平衡:在目标检测和跟踪系统中,性能和效率之间存在着一个平衡。为了提高系统的实时性能,可以进一步优化算法的计算复杂度和模型大小。例如,可以探索轻量级网络结构、模型剪枝和量化技术等方法,以提高系统的运行速度和资源利用率。

-

鲁棒性改进:目标检测和跟踪系统在面对复杂场景、遮挡目标或快速运动目标时可能存在一定的鲁棒性挑战。为了改进系统的鲁棒性,可以考虑引入更多的上下文信息、采用多尺度检测和跟踪策略,或者利用先验知识来解决这些挑战。

-

用户体验评估:除了性能指标,还应该考虑用户体验因素对系统的影响。可以进行用户调研、用户反馈收集和用户行为分析,以了解用户对系统的满意度、易用性和适应性。根据用户反馈,进行相应的改进和优化,以提供更好的用户体验。

-

对比实验和竞争方法:为了更全面地评估系统性能,可以进行更多的对比实验和与竞争方法的比较。选择具有不同特点的目标检测和跟踪算法进行比较,以评估系统的相对优势和改进空间。

总之,研究不足是一个动态的过程,需要不断进行改进和创新。通过解决数据集限制、平衡性能与效率、改进鲁棒性、用户体验评估以及进行对比实验和竞争方法比较等方面的工作,可以进一步提升目标检测和跟踪系统的性能和实用性。

5.3 对未来发展的展望

对未来发展的展望是对目标检测和跟踪领域在技术和应用方面的趋势和前景进行预测和展望。以下是一些可能的展望方向:

-

深度学习与强化学习的融合:未来的目标检测和跟踪系统可能会更多地利用深度学习和强化学习的结合。通过引入强化学习算法,系统可以通过与环境的交互来自主学习和优化目标检测和跟踪策略,进一步提高性能和鲁棒性。

-

多模态感知与融合:随着传感器技术的不断进步,未来的系统可能会利用多模态感知,如图像、视频、雷达和Lidar等数据的融合,以获取更全面和准确的目标信息。多模态感知可以提供更多的上下文信息和深度理解,进一步提升目标检测和跟踪的性能。

-

弱监督学习与自监督学习:传统的目标检测和跟踪算法通常需要大量标注数据进行训练,而未来的发展趋势可能会更多地关注弱监督学习和自监督学习的方法。这些方法可以利用弱标签或无标签数据进行训练,降低了数据标注的成本,同时提高了算法的适应性和泛化能力。

-

实时性与边缘计算:随着物联网和边缘计算的兴起,未来的目标检测和跟踪系统将更加注重实时性和边缘计算能力。通过在边缘设备上进行实时的目标检测和跟踪,可以减少数据传输和延迟,并提高系统的响应速度和效率。

-

应用领域拓展:目标检测和跟踪技术在许多领域都有广泛的应用前景,如智能交通、无人驾驶、安防监控、机器人等。未来的发展将继续拓展应用领域,为社会和产业带来更多的智能化解决方案和商业机会。

综上所述,未来目标检测和跟踪领域将继续发展并取得突破。通过深度学习与强化学习的融合、多模态感知与融合、弱监督学习与自监督学习、实时性与边缘计算以及应用领域拓展等方面的创新和发展,我们可以期待目标检测和跟踪系统在性能、效率和应用范围上的进一步提升和拓展。