如何使用jupyter进行数据分析

Python是一种广泛用于数据科学和数据分析的编程语言。以下是在Python中进行数据分析的基本步骤:

-

获取数据:可以使用Python内置的csv或json库读取本地文件,或使用pandas库来读取各种数据格式的文件。

-

数据清洗:清洗数据是数据分析的重要步骤,确保数据准确且一致。在Python中,可以使用pandas库进行数据清洗。

-

数据分析:使用pandas库和numpy库中的各种函数进行数据分析。pandas库主要用于数据框的数据处理,而numpy库则主要用于数值计算。

-

可视化:使用matplotlib或seaborn库进行数据可视化。这有助于将数据分析结果清晰地展示出来,帮助用户更好地理解数据。

import pandas as pd import numpy as np import matplotlib.pyplot as plt # 读取数据 df = pd.read_csv('data.csv') # 数据清洗 df.dropna(inplace=True) # 数据分析 mean_value = np.mean(df['value']) max_value = np.max(df['value']) # 可视化 plt.plot(df['date'], df['value']) plt.xlabel('date') plt.ylabel('value') plt.title('Data Analysis'上述代码中使用了pandas和numpy库进行数据的读取、清洗、分析,并使用matplotlib库进行数据可视化。

Python中有着众多用于数据分析和应用的库,这些库包括以下几个方面:

-

NumPy库:NumPy是一个用于数值计算的Python库,提供了高效的多维数组和矩阵操作、数学函数以及随机数生成等能力。

-

Pandas库:Pandas是一个开源库,可用于数据分析、数据清理和准备以及可视化。Pandas简化了数据操作,是Python数据处理和建模的一个核心库。

-

Matplotlib库:Matplotlib是用于制作图表和其他数据可视化类型的Python 2D库。Matplotlib 作为Python 3和 Python2中用于数据分析和可视化的主要绘图库,主要是创建条形图、饼图、直方图和散点图。

-

Scikit-learn库:Scikit-learn是一个用于机器学习的Python 库。它建立在NumPy、SciPy和Matplotlib库的基础上,提供了一组丰富的机器学习工具,如分类、回归、聚类、模型选择、数据预处理、模型评估等。

-

TensorFlow库:TensorFlow 是一个开源人工智能库,用作数据流编程,它有多个编程语言接口。当前支持Python、C++、Java等多种编程语言。

-

PyTorch库:PyTorch是Facebook为试验、研究和其他更大的深度学习项目而构建的Python的基于Torch的开源机器学习库。

以上这些库是Python数据分析和应用中最常用的库,使用它们可以更加方便地进行数据处理、可视化及模型训练,并得到预期的结果。

库的下载

Python中可以使用pip这个命令行工具进行常用库的下载。具体步骤如下:

-

打开终端或命令行工具;

-

输入以下命令:

pip install 库名其中“库名”指代你要下载的库的名称,例如要下载numpy库的话,就输入:

-

pip install numpy然后按回车键执行该命令,等待下载安装完成即可。

常用的库还包括:pandas、matplotlib、scikit-learn、beautifulsoup4、requests等等,这些库的下载方法都相同,只需将“库名”替换为相应的库名即可。 -

例1

使用Python中的pandas库进行数据分析

这段代码导入了Python中的pandas库,并将其命名为pd

import pandas as pd

这段代码的主要作用是使用Pandas库中的read_csv()函数读取一个CSV文件,并将其作为一个DataFrame对象保存在变量download中。

download=pd.read_csv('user_download.csv',index_col=0,encoding='gbk')

这段代码定义了一个名为del_rep的函数,它的作用是对一个列表进行去重。

具体来说,该函数接收一个列表参数list1,并定义了一个空列表list2,用于保存去重后的数据。函数使用for循环对原始列表list1的每一个元素进行遍历,使用if语句判断该元素是否在新列表list2中出现过。如果该元素不在list2中,则将其添加到list2中。当对原始列表list1的所有元素进行遍历后,函数返回去重后的新列表list2。

最后,去重后的列表用于将用户的下载意愿从数据库中提取出来并进行处理

def del_rep(list1):#定义一个函数del_rep,接受一个列表参数list1

list2=[]#定义一个空列表list2,用于存储去重后的新列表

for i in list1:#遍历列表list1中的每一个元素

if i not in list2:#如果这个元素不在新列表list2中

list2.append(i)#将这个元素添加到新列表list2中

return list2#返回新列表list2

#这个函数的实现方法是遍历原列表,将不在新列表中的元素添加到新列表中,从而实现去重的效果

#去重,将下载意愿从数据库中提取出来这段代码将从CSV文件中读取到的数据download转换为一个列表,并且只保留了CSV文件中的是否愿意下载这一列数据。

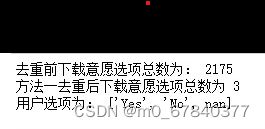

然后,代码使用len(download)函数输出下载意愿选项的总数,同时使用print()函数输出文本字符串'去重前下载意愿选项总数为:'和下载意愿选项总数。

download=list(download['是否愿意下载'])

print('去重前下载意愿选项总数为:',len(download))这段代码通过调用前面定义的自定义del_rep()函数对下载意愿选项进行去重,去重后的结果存储在变量download_rep中。接着,代码使用len(download_rep)输出去重后下载意愿选项总数,并使用print()函数输出文本字符串'用户选项为:'以及去重后的选项列表download_rep。

综合来看,这段代码的主要作用是读取CSV文件中的数据,并对其中的下载意愿选项进行去重处理,并最终输出去重后的选项列表。

download_rep=del_rep(download)#使用自定义的函数去重

print('方法一去重后下载意愿选项总数为',len(download_rep))

print('用户选项为:',download_rep)运行结果;

全部代码运行结果:

# 代码4-40

import pandas as pd

import numpy as np

from pyecharts import options as opts

from pyecharts.charts import Scatter3D

# 最大携氧能力、体重和运动后心率的三维散点图

player_data = pd.read_excel('运动员的最大携氧能力、体重和运动后心率数据.xlsx')

player_data = [player_data['体重(kg)'], player_data['运动后心率(次/分钟)'],

player_data['最大携氧能力(ml/min)']]

player_data = np.array(player_data).T.tolist()

s = (Scatter3D()

.add('', player_data, xaxis3d_opts=opts.Axis3DOpts(name='体重(kg)'),

yaxis3d_opts=opts.Axis3DOpts(name='运动后心率(次/分钟)'),

zaxis3d_opts=opts.Axis3DOpts(name='最大携氧能力(ml/min)')

)

.set_global_opts(title_opts=opts.TitleOpts(

title='最大携氧能力、体重和运动后心率3D散点图'),

visualmap_opts=opts.VisualMapOpts(range_color=[

'#1710c0', '#0b9df0', '#00fea8', '#00ff0d', '#f5f811', '#f09a09',

'#fe0300'])))

s.render_notebook()

例2

以下是一个简单的Python可视化分析代码示例,展示了如何使用Matplotlib库和Pandas库进行数据可视化:

import pandas as pd # 导入 Pandas 库,用于读取数据文件csv

import matplotlib.pyplot as plt # 导入 Matplotlib 库,用于绘图

# 读取数据文件csv

data = pd.read_csv('data.csv') # 读取名为"data.csv"的数据文件,并将其存入"data"变量中

# 绘制折线图

plt.plot(data['日期'], data['销售额'], marker='o') # 绘制折线图,x轴为日期,y轴为销售额,样式为圆点

plt.title('销售额趋势图') # 设置折线图标题

plt.xlabel('日期') # 设置x轴标签

plt.ylabel('销售额') # 设置y轴标签

plt.xticks(rotation=45, ha='right') # 设置x轴刻度标签旋转角度为45度,对齐方式为右对齐

plt.show() # 显示折线图

# 绘制柱状图

plt.bar(data['日期'], data['销售额']) # 绘制柱状图,x轴为日期,y轴为销售额

plt.title('销售额柱状图') # 设置柱状图标题

plt.xlabel('日期') # 设置x轴标签

plt.ylabel('销售额') # 设置y轴标签

plt.xticks(rotation=45, ha='right') # 设置x轴刻度标签旋转角度为45度,对齐方式为右对齐

plt.show() # 显示柱状图

# 绘制散点图

plt.scatter(data['访问量'], data['销售额']) # 绘制散点图,x轴为访问量,y轴为销售额

plt.title('销售额和访问量关系') # 设置散点图标题

plt.xlabel('访问量') # 设置x轴标签

plt.ylabel('销售额') # 设置y轴标签

plt.show() # 显示散点图该代码使用Pandas读取了一个名为"data.csv"的数据文件,并使用Matplotlib库绘制了折线图、柱状图和散点图,展示了数据的可视化分析效果。使用该代码需要安装Pandas和Matplotlib库。

例3

以下是一个使用Scikit-learn库的Python代码示例,用于训练和评估一个决策树分类器:

from sklearn import datasets # 导入 Scikit-learn 库中的数据集模块

from sklearn.tree import DecisionTreeClassifier # 导入 Scikit-learn 库中的决策树分类器模块

from sklearn.model_selection import train_test_split # 导入 Scikit-learn 库中的拆分数据集函数模块

from sklearn.metrics import accuracy_score # 导入 Scikit-learn 库中的模型评估指标模块

# 加载数据集

iris = datasets.load_iris() # 加载 Scikit-learn 库自带的鸢尾花数据集

X = iris.data # 将数据集中的特征数据存入变量X中

y = iris.target # 将数据集中的目标值存入变量y中

# 拆分数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3) # 使用拆分数据集函数将数据集拆分为训练集和测试集

# 训练决策树分类器模型

clf = DecisionTreeClassifier() # 定义一个决策树分类器

clf.fit(X_train, y_train) # 在训练集上训练决策树分类器

# 对测试集进行预测

y_pred = clf.predict(X_test) # 使用训练好的分类器对测试集进行预测

# 计算模型准确率并输出

accuracy = accuracy_score(y_test, y_pred) # 使用准确率指标计算模型准确率

print("模型准确率为:{}".format(accuracy)) # 打印输出模型准确率该示例代码导入了Scikit-learn库中的数据集、决策树分类器模型、拆分数据集函数和模型评估指标。代码加载了Scikit-learn库自带的鸢尾花数据集,使用训练集训练了一个决策树分类器,并使用测试集评估了模型的准确率。