【机器学习快速入门】3 交叉验证与网格搜索

虽然将数据划分为训练集、测试集但这种方法对数据的划分相当敏感。为了得到更客观的正确率 (不一定正确率更高),我们可以使用交叉验证 + 网格搜索方式最大程度上来获取客观的最优解。

交叉验证与网格搜索原理

虽然将数据划分为训练集、测试集虽然行的,也相对可用,但这种方法对数据的划分还是相当敏感。为了得到对泛化性能的更好估计,我们可以使用交叉验证。另外有很多模型在训练时需要设置参数。如果确定不同参数组合哪些是最优解呢?最靠谱的方式就是利用穷举搜索,在所有候选的参数选择中,通过循环便利,尝试每一种可能性,表现最好的参数就是最终的结果。其原理就是在所有参数组合过程中找最优组合。

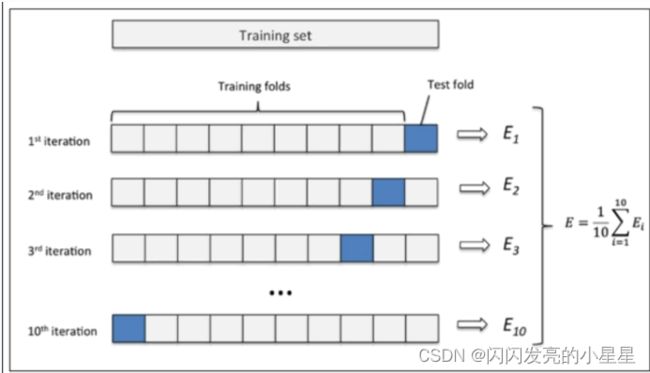

下面是10折交叉验证原理图

代码实现

- fit、predict、score:分别进行拟合、预测和得出泛化性能分数

- best_estimator_:最佳模型

- best_score_:交叉验证最优平均分数

- cv_results_:返回包含网络搜索的结果的字典

from sklearn.neighbors import KNeighborsClassifier

knn = KNeighborsClassifier()

from sklearn.model_selection import GridSearchCV

gc = GridSearchCV(estimator=knn,param_grid={'n_neighbors':[3,5],'weights':['uniform','distance']},cv=2)

# 模型训练

gc.fit(X_train,y_train)

# 交叉验证与网格搜索相关结果如下:

print("最优模型参数",gc.best_estimator_)

print('平均最优训练分数',gc.best_score_)

print('交叉验证打印结果',gc.cv_results_)

结果如下:

params : [{'n_neighbors': 3, 'weights': 'uniform'},

{'n_neighbors': 3, 'weights': 'distance'},

{'n_neighbors': 5, 'weights': 'uniform'},

{'n_neighbors': 5, 'weights': 'distance'}],

'split0_test_score': array([0.6875 , 0.6875 , 0.70486111, 0.70486111]),

'split1_test_score': array([0.72222222, 0.71527778, 0.71527778, 0.70486111]),

'mean_test_score': array([0.70486111, 0.70138889, 0.71006944, 0.70486111])

官网资料:

GridsearchCV

>>> from sklearn import svm, datasets

>>> from sklearn.model_selection import GridSearchCV

>>> iris = datasets.load_iris()

>>> parameters = {'kernel':('linear', 'rbf'), 'C':[1, 10]}

>>> svc = svm.SVC()

>>> clf = GridSearchCV(svc, parameters)

>>> clf.fit(iris.data, iris.target)

GridSearchCV(estimator=SVC(),

param_grid={'C': [1, 10], 'kernel': ('linear', 'rbf')})

>>> sorted(clf.cv_results_.keys())

['mean_fit_time', 'mean_score_time', 'mean_test_score',...

'param_C', 'param_kernel', 'params',...

'rank_test_score', 'split0_test_score',...

'split2_test_score', ...

'std_fit_time', 'std_score_time', 'std_test_score']