- Elasticstack-日志分析平台

尼古拉斯-邓

linuxkafkacentos

#ElasticStack-日志分析平台##1.Filebeat```shellvim/etc/hostsip1dijiaip2meimeiip3biaobei```###Filebeat安装```shellcurl-L-Ohttps://artifacts.elastic.co/downloads/beats/filebeat/filebeat-7.13.2-linux-x86_64.tar.g

- 部署Wordpress(LNMP)+ELK

多练项目

Linux系统架构linuxelk运维

LNMP+EFK主机软件服务版本主机名192.168.100.100Nginx-1.18、Filebeatnode100192.168.100.101PHP-5.6.27node101192.168.100.102MySQL5.7node102192.168.100.103Kafkakafka103192.168.100.104Kafkanode104192.168.100.105Kafkanod

- 如何收集k8s pod的服务日志(rancher)

一方有点方

kubernetesrancher容器

一、环境情况说明当前环境是k8s+rancher+filebeat+es+kibana本文只讲解部署filebeat收集容器日志的过程、使用daemonset的方式部署filebeat,es+kibana+k8s已提前创建好的二、部署安装1、在已创建完成的k8s环境中,用kubectl先创建一个命名空间elk-log,新增一个filebeat目录,上传一下4个代码文件filebeat.daemon

- 集群部署Elasticsearch+Logstash+Kibana+Filebeat+Kafka+Zookeeper

YH746

日志分析系统linux

目录引言一、安装Zookeeper步骤1、准备阶段(全部节点操作,以node1为例)(1)关闭防火墙和系统安全机制(全部节点操作,以node1为例)(2)同步时钟源(全部节点操作,以node1为例)(3)JDK的安装(全部节点操作,以node1为例)(4)配置hosts(全部节点操作,以node1为例)2、安装Zookeeper软件包(全部节点操作,以node1为例)3、修改配置文件(全部节点操作

- elfk+zookeeper+kafka数据流

AustinCien

zookeeperkafkaelk

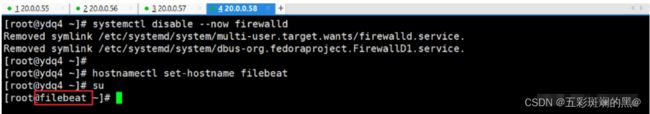

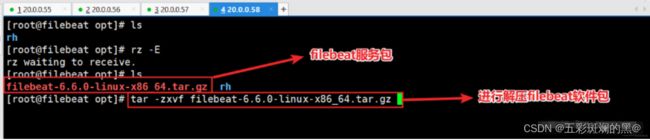

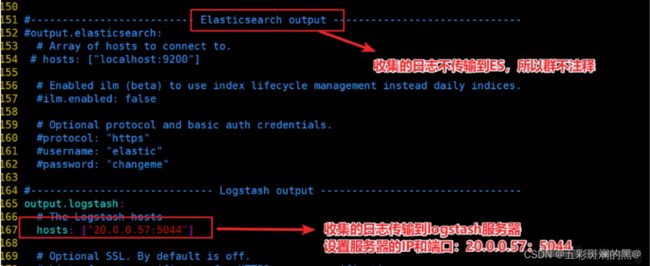

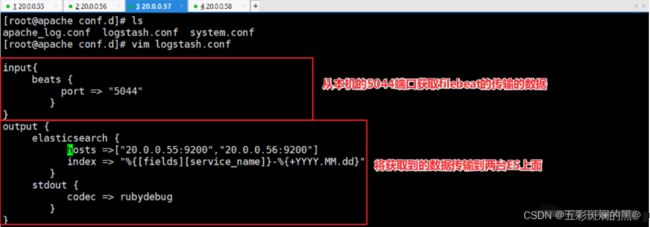

申请7台部署elfk+zookeeper+kafka数据流:filebeat(每台app)------>【logstash(2)+kafka(3)】------->logstash(1)------->【elasticsearch(3)+kibana(1)】

- deepseek部署:ELK + Filebeat + Zookeeper + Kafka

AustinCien

deepseekelkzookeeperkafka

##1.概述本文档旨在指导如何在7台机器上部署ELK(Elasticsearch,Logstash,Kibana)堆栈、Filebeat、Zookeeper和Kafka。该部署方案适用于日志收集、处理和可视化场景。##2.环境准备###2.1机器分配|机器编号|主机名|IP地址|部署组件|----------|--------------|--------------|--------------

- springboot + logback + filebeat + elk 实现分布式日志中心

imalvisc

javaspringlinux运维

前言:本文主要介绍docker搭建elk分布式日志平台,利用filebeat监听logback日志文件,传输到elk中,最终在kibana渲染展示。主要思路:filebeat监听日志文件的变化,传输到logstash,logstash通过分析提取,将日志信息推送到elasticsearch指定索引中,最终kibana从elasticsearch索引中查询并展示日志信息。一、docker搭建elk日

- EFK on Kubernetes

da pai ge

kubernetesjenkins容器

elastic公司产品链。,文档类数据库,使用Java语言,收集端logstash后来用go语言改写了(使用filebeat),查询方便(配合展示界面可以不用语句就可以查询,并且查询速度快),原理:按照类似索引的机制查询,数据全部归于索引之下ELK:logstashEFK:采集:filebeat,fluentd存储:elasticsearch展示:kibanalogstash现在少用于收集,多用于

- Golang 清晰架构RESTful API项目实战指南

郝赢泉

Golang清晰架构RESTfulAPI项目实战指南golang-clean-web-apiGolangCleanarchitectureRESTAPIexamplewithacomprehensiverealproject.Itusesdocker,dockercompose,redis,elasticsearch,kibana,filebeat,postgresql,prometheus,gr

- ELK系列(二)Kafka集群3.4.0搭建

诉光海

ELKelkjava服务器kafka

ELK系列传送门ELK系列(一)ElasticSearch8.9.2集群搭建ELK系列(二)Kafka集群3.4.0搭建ELK数据流规划ELK接入nginx-acces日志数据流规划数据流向filebeat------->kafka---->logstash---->ES-------->kibana收集mq处理日志存储、搜索展示、分析||elastalert2---钉钉告警ES集群搭建已完成可见

- 架构设计 - 常用日志收集方案选型对比与推荐

Roc.Chang

架构设计日志收集分布式日志架构方案

目录1.常用组合1.1ELKStack->ElasticStack1.2EFKStack1.3Graylog1.4PLG日志系统1.5Splunk1.6Filebeat+ELK1.7AWSCloudWatchLogs1.8阿里云日志服务1.9腾讯云CLS(日志服务)2.推荐日志收集是系统监控和调试中的关键环节。常见的日志收集方案有多个,每种方案各有优劣,选择时应根据实际业务需求进行评估。以下是几种

- Filebeat 连接Kafka 失败

ms_勇往直前

kafkafilebeat

listeners=PLAINTEXT://:9092advertised.listeners=PLAINTEXT://IP地址:9092

- 在 Ubuntu 22.04 上运行 Filebeat 7.10.2

INFINI Labs

ubuntulinux运维

环境操作系统:阿里云Ubuntu22.04.3LTS(GNU/Linux5.15.0-83-genericx86_64)软件版本:Filebeat7.10.2用户:root运行下载从这里下载filebeat7.10.2。配置简单配置一下filebeat.yml,从标准输入采集,写入到标准输出:filebeat.inputs:-type:stdinoutput.console:pretty:true

- Filebeat + es +kibana

登高·

ELKelk

背景分析--->报警Kibana展示Kibana存储ElasticSerach过滤Logstash收集Filebeat,Logstashlogstash:因为是由java写的,所以在它收集日志时非常占用业务系统的资源,从而影响线上业务,所以我们将其替换为filebeat.filebeat:为轻量的日志收集组件,会让业务系统的运行更加的稳定.由于痛点:1.出现故障,要排查的日志非常的多,没有办法很快

- EFK(elasticsearch+filebeat+kibana)日志收集系统搭建记录

listenFeng.

非常用工具

一、安装包下载(本文附带安装包均为6.7.1版)kibana-windows-64Kibana-linux-tarelasticsearelech-windows-64elasticsearch-linux-tarfilebeat-windows-64filebeat-linux-tar二、安装注:winows版本解压后可以直接使用,运行对应名称的bat文件即可(filebeat需要使用命令,如下

- elasticsearch+filebeat+kibana实现系统日志收集

耳东陈的陈陈陈

elkjavaelk

背景随着微服务盛行,造成日志分散到各个服务器各个系统中,与传统单服日志单一不同,日志的追踪,查错等就会显得很吃力,效率极其低下,所以需要一款软件能将各个系统中的日志收集并标记,然后形成统一的搜索、查看界面,并且需要高效的查询(因为随着日积月累日志将会G级别甚至T级别),所以elasticsearch+filebeat+kibana很好的解决了这个问题。原理通过filebeat扫描目标日志文件实现日

- 日志采集框架filebeat

躲在没风的地方

linux日志采集框架服务器linuxelasticsearchfilebeatlogstash

日志采集框架1filebeat和logstash比较filebeat比logstash更小巧,更简洁一些,但是功能上logstash更强大logstash(用java编写的)用于ELK中,也是用来采集传输数据的,比较浪费资源。完全可以将logstash替换为filebeat,形式EFK体系。filebeat(elastic公司)特点(1)异常中断重启后会继续上次停止的位置(通过${filebeat

- ELK日志分析系统

AWAKE-HU

服务器elk日志分布式

什么是ELK:Elasticsearch:基于lucene的开源分布式搜索服务器(类似于solr)特点:分布式,零配置,分片索引,restful风格,多数据源logStash收集日志,过滤分析,并存储Kibana用于展示日志和分析结果ELK原理多个服务器的情况下,各个服务器都会产生不同服务器下不同路径的log文件如果每一台服务器都有一个filebeat把路径下的日志传输给统一的logstash日志

- 从零开始的Docker [ 5 ] --- ELK+Filebeat + kibana 容器化、Docker compose

Nekoosu

从零开始的Dockerdockerlinuxdocker-composeelk容器化

文章目录容器技术Docker应用一、ELK容器化1.获取镜像2.启动二、Logstash容器化1.配置文件2.正常启动三、logstash配置1.Log4j2文件的方式配置2.LogingAPI的方式配置a.查看日志配置信息b.更新日志级别c.重置日志级别3.慢日志a.配置b.启用慢日志四、Filebeat容器化1.获取镜像2.设置配置文件3.运行容器a.制作日志文件b.使用自定义的配置文件运行容

- filebeat收集各种类型日志写入logstash,再从logstash中读取日志写入kafka中(有filebeat)

运维实战课程

kafka分布式

filebeat收集各种类型日志写入logstash,再从logstash中读取日志写入kafka中(有filebeat)如果对运维课程感兴趣,可以在b站上、A站或csdn上搜索我的账号:运维实战课程,可以关注我,学习更多免费的运维实战技术视频0.环境机器规划:192.168.43.163kafka1192.168.43.164kafka2192.168.43.165kafka3192.168.4

- Elastic Stack(filebeat/logstash/elasticserarch/kibana)性能分析应用

一缕晨光~

ElasticStackelasticsearchkibanaelk大数据

目录概要:1.待分析日志的格式(1条日志):2.filebeat设置获取日志的路径:3.logstash匹配日志4.调试5.Elasticsearch插件(方便对es的查询与删除)6.对已有日志进行分析7、Kibana展示概要:使用kibana展示日志分析结果的初衷是性能分析,终于分析出了第一份日志。性能压测情况下,某个日志文件的分析出的响应时间分布。上篇文章请参看:logstashconfigf

- 日志收集平台day01:项目设计

intqao

日志收集平台项目linuxkafkazookeepernginxpython

一、项目需求本项目的目的是模拟生产环境下对web服务器产生的日志进行收集并存入数据库,最终以web应用方式展示日志数据。二、技术选型环境:CentOs7web服务器:nginx/1.20.1(仅测试使用)消息队列:kafka2.12分布式应用程序协调服务软件:zookeeper3.6.3生产者:filebeat-7.17.5-1.x86_64消费者:使用python中的模块pykafka实现消费者

- 【实践】Filebeats的尝鲜

JYCJ_

Golanggolang后端

背景落盘的日志文件,查询起来比较麻烦,所以想将其存入ES中,然后通过使用Kibana来查询方案:Filebeat第三方存储:ES链路:filebeat---->[logstash]---->ES前期验证Filebeat输出ES连接问题?ES,目前使用的es版本为7.10.x,第一步:使用filebeat最新版本,连接ES容易报下面的错误:Connectionmarkedasfailedbecaus

- ELK 架构中 ES 性能优化

xianjie0318

elk架构elasticsearch

1.背景由于目前日志采集流程中,经常遇到用户磁盘IO占用超过90%以上的场景,但是观察其日志量大约在2k~5k之间,整体数据量不大,所以针对该问题进行了一系列的压测和实验验证,最后得出这篇优化建议文档2.压测前期准备2.1制造大量日志该阶段为数据源输入阶段,为了避免瓶颈在数据制造侧,所以需要保证filebeat具有足够的日志制造能力最后效果,filebeat可以达到70kQPS的数据发往logst

- 在ELFK架构中加入kafka

beretxj_

kafka分布式大数据elk

传统的ELFK架构中,filebeat到logstash这个过程中,由于logstash要进行日志的分析处理,而filebeat至进行日志的收集和发送,处理过程较为简单,所以当日志量非常巨大的时候,logstash会由于处理不及时导致日志或数据的丢失,这时候可以在filebeat和logstash之间加入kafka存储信息,在logstash处理不及时的时候,日志或数据不至于丢失。kafka的安装

- ELK日志分析系统之集成Filebeat

奔跑吧邓邓子

高效运维

目录一、Filebeat是什么?二、集成Filebeat1.安装Filebeat2.配置3.启动本博在ELK日志分析系统搭建一文中,介绍了使用Elasticsearch、Logstash、Kibana来搭建ELK。不过由于Logstash是一个功能强大的日志服务,作为日志采集器会占用较多的系统资源,如果需要添加插件,全部服务器的Logstash都要添加插件,扩展性很差。而Filebeat作为一个轻

- 部署EFK

m0_59430185

EFKEFK

文章目录前言一、拓扑图二、配置环境三、配置tomcat服务器1.安装JDK,配置JAVA环境2.安装配置Tomcat3.Tomcat配置说明4.启动Tomcat5.优化Tomcat启动速度四、配置Elasticsearch环境五、安装elasticsearch集群1.部署Elasticsearch软件3.安装elasticsearch-head插件六、部署filebeat七、node1安装Kiba

- 单机 安装 ELK 日志分析系统

TheFlsah

Linux

一、ELK介绍ELKStack是软件集合Elasticsearch、Logstash、Kibana的简称,它们都是开源软件。新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。Elasticsearch是一个基于Lucene的、支持全文索引的分布式存储和索引引擎,主要负责将日

- 搭建p2p文件服务器,p2p服务器搭建

Gary Wozniak

搭建p2p文件服务器

p2p服务器搭建内容精选换一换服务器迁移通常有三种手段:全新部署业务、主机迁移服务、镜像迁移,如表1所示。对于华为云上云服务器的跨帐号跨区域迁移,建议采用镜像迁移方式。跨帐号跨区域迁移云服务器的方案为:帐号A将区域A的云服务器做成私有镜像,将此私有镜像复制到同帐号的区域B,再共享给帐号B;帐号B接受帐号A的共享镜像后,使用该镜像创建新的云服务器。例如,帐号A在“华北-简要介绍Filebeat是一个

- 【Elasticsearch】file-beat 将文件数据导入es

日月星宿~

应用elasticsearch

1、备份filebeat.yml文件:2、新filebeat.yml文件配置示例:######################FilebeatConfigurationExample##########################==============================Filebeatinputs===============================filebeat

- 关于旗正规则引擎中的MD5加密问题

何必如此

jspMD5规则加密

一般情况下,为了防止个人隐私的泄露,我们都会对用户登录密码进行加密,使数据库相应字段保存的是加密后的字符串,而非原始密码。

在旗正规则引擎中,通过外部调用,可以实现MD5的加密,具体步骤如下:

1.在对象库中选择外部调用,选择“com.flagleader.util.MD5”,在子选项中选择“com.flagleader.util.MD5.getMD5ofStr({arg1})”;

2.在规

- 【Spark101】Scala Promise/Future在Spark中的应用

bit1129

Promise

Promise和Future是Scala用于异步调用并实现结果汇集的并发原语,Scala的Future同JUC里面的Future接口含义相同,Promise理解起来就有些绕。等有时间了再仔细的研究下Promise和Future的语义以及应用场景,具体参见Scala在线文档:http://docs.scala-lang.org/sips/completed/futures-promises.html

- spark sql 访问hive数据的配置详解

daizj

spark sqlhivethriftserver

spark sql 能够通过thriftserver 访问hive数据,默认spark编译的版本是不支持访问hive,因为hive依赖比较多,因此打的包中不包含hive和thriftserver,因此需要自己下载源码进行编译,将hive,thriftserver打包进去才能够访问,详细配置步骤如下:

1、下载源码

2、下载Maven,并配置

此配置简单,就略过

- HTTP 协议通信

周凡杨

javahttpclienthttp通信

一:简介

HTTPCLIENT,通过JAVA基于HTTP协议进行点与点间的通信!

二: 代码举例

测试类:

import java

- java unix时间戳转换

g21121

java

把java时间戳转换成unix时间戳:

Timestamp appointTime=Timestamp.valueOf(new SimpleDateFormat("yyyy-MM-dd HH:mm:ss").format(new Date()))

SimpleDateFormat df = new SimpleDateFormat("yyyy-MM-dd hh:m

- web报表工具FineReport常用函数的用法总结(报表函数)

老A不折腾

web报表finereport总结

说明:本次总结中,凡是以tableName或viewName作为参数因子的。函数在调用的时候均按照先从私有数据源中查找,然后再从公有数据源中查找的顺序。

CLASS

CLASS(object):返回object对象的所属的类。

CNMONEY

CNMONEY(number,unit)返回人民币大写。

number:需要转换的数值型的数。

unit:单位,

- java jni调用c++ 代码 报错

墙头上一根草

javaC++jni

#

# A fatal error has been detected by the Java Runtime Environment:

#

# EXCEPTION_ACCESS_VIOLATION (0xc0000005) at pc=0x00000000777c3290, pid=5632, tid=6656

#

# JRE version: Java(TM) SE Ru

- Spring中事件处理de小技巧

aijuans

springSpring 教程Spring 实例Spring 入门Spring3

Spring 中提供一些Aware相关de接口,BeanFactoryAware、 ApplicationContextAware、ResourceLoaderAware、ServletContextAware等等,其中最常用到de匙ApplicationContextAware.实现ApplicationContextAwaredeBean,在Bean被初始后,将会被注入 Applicati

- linux shell ls脚本样例

annan211

linuxlinux ls源码linux 源码

#! /bin/sh -

#查找输入文件的路径

#在查找路径下寻找一个或多个原始文件或文件模式

# 查找路径由特定的环境变量所定义

#标准输出所产生的结果 通常是查找路径下找到的每个文件的第一个实体的完整路径

# 或是filename :not found 的标准错误输出。

#如果文件没有找到 则退出码为0

#否则 即为找不到的文件个数

#语法 pathfind [--

- List,Set,Map遍历方式 (收集的资源,值得看一下)

百合不是茶

listsetMap遍历方式

List特点:元素有放入顺序,元素可重复

Map特点:元素按键值对存储,无放入顺序

Set特点:元素无放入顺序,元素不可重复(注意:元素虽然无放入顺序,但是元素在set中的位置是有该元素的HashCode决定的,其位置其实是固定的)

List接口有三个实现类:LinkedList,ArrayList,Vector

LinkedList:底层基于链表实现,链表内存是散乱的,每一个元素存储本身

- 解决SimpleDateFormat的线程不安全问题的方法

bijian1013

javathread线程安全

在Java项目中,我们通常会自己写一个DateUtil类,处理日期和字符串的转换,如下所示:

public class DateUtil01 {

private SimpleDateFormat dateformat = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

public void format(Date d

- http请求测试实例(采用fastjson解析)

bijian1013

http测试

在实际开发中,我们经常会去做http请求的开发,下面则是如何请求的单元测试小实例,仅供参考。

import java.util.HashMap;

import java.util.Map;

import org.apache.commons.httpclient.HttpClient;

import

- 【RPC框架Hessian三】Hessian 异常处理

bit1129

hessian

RPC异常处理概述

RPC异常处理指是,当客户端调用远端的服务,如果服务执行过程中发生异常,这个异常能否序列到客户端?

如果服务在执行过程中可能发生异常,那么在服务接口的声明中,就该声明该接口可能抛出的异常。

在Hessian中,服务器端发生异常,可以将异常信息从服务器端序列化到客户端,因为Exception本身是实现了Serializable的

- 【日志分析】日志分析工具

bit1129

日志分析

1. 网站日志实时分析工具 GoAccess

http://www.vpsee.com/2014/02/a-real-time-web-log-analyzer-goaccess/

2. 通过日志监控并收集 Java 应用程序性能数据(Perf4J)

http://www.ibm.com/developerworks/cn/java/j-lo-logforperf/

3.log.io

和

- nginx优化加强战斗力及遇到的坑解决

ronin47

nginx 优化

先说遇到个坑,第一个是负载问题,这个问题与架构有关,由于我设计架构多了两层,结果导致会话负载只转向一个。解决这样的问题思路有两个:一是改变负载策略,二是更改架构设计。

由于采用动静分离部署,而nginx又设计了静态,结果客户端去读nginx静态,访问量上来,页面加载很慢。解决:二者留其一。最好是保留apache服务器。

来以下优化:

- java-50-输入两棵二叉树A和B,判断树B是不是A的子结构

bylijinnan

java

思路来自:

http://zhedahht.blog.163.com/blog/static/25411174201011445550396/

import ljn.help.*;

public class HasSubtree {

/**Q50.

* 输入两棵二叉树A和B,判断树B是不是A的子结构。

例如,下图中的两棵树A和B,由于A中有一部分子树的结构和B是一

- mongoDB 备份与恢复

开窍的石头

mongDB备份与恢复

Mongodb导出与导入

1: 导入/导出可以操作的是本地的mongodb服务器,也可以是远程的.

所以,都有如下通用选项:

-h host 主机

--port port 端口

-u username 用户名

-p passwd 密码

2: mongoexport 导出json格式的文件

- [网络与通讯]椭圆轨道计算的一些问题

comsci

网络

如果按照中国古代农历的历法,现在应该是某个季节的开始,但是由于农历历法是3000年前的天文观测数据,如果按照现在的天文学记录来进行修正的话,这个季节已经过去一段时间了。。。。。

也就是说,还要再等3000年。才有机会了,太阳系的行星的椭圆轨道受到外来天体的干扰,轨道次序发生了变

- 软件专利如何申请

cuiyadll

软件专利申请

软件技术可以申请软件著作权以保护软件源代码,也可以申请发明专利以保护软件流程中的步骤执行方式。专利保护的是软件解决问题的思想,而软件著作权保护的是软件代码(即软件思想的表达形式)。例如,离线传送文件,那发明专利保护是如何实现离线传送文件。基于相同的软件思想,但实现离线传送的程序代码有千千万万种,每种代码都可以享有各自的软件著作权。申请一个软件发明专利的代理费大概需要5000-8000申请发明专利可

- Android学习笔记

darrenzhu

android

1.启动一个AVD

2.命令行运行adb shell可连接到AVD,这也就是命令行客户端

3.如何启动一个程序

am start -n package name/.activityName

am start -n com.example.helloworld/.MainActivity

启动Android设置工具的命令如下所示:

# am start -

- apache虚拟机配置,本地多域名访问本地网站

dcj3sjt126com

apache

现在假定你有两个目录,一个存在于 /htdocs/a,另一个存在于 /htdocs/b 。

现在你想要在本地测试的时候访问 www.freeman.com 对应的目录是 /xampp/htdocs/freeman ,访问 www.duchengjiu.com 对应的目录是 /htdocs/duchengjiu。

1、首先修改C盘WINDOWS\system32\drivers\etc目录下的

- yii2 restful web服务[速率限制]

dcj3sjt126com

PHPyii2

速率限制

为防止滥用,你应该考虑增加速率限制到您的API。 例如,您可以限制每个用户的API的使用是在10分钟内最多100次的API调用。 如果一个用户同一个时间段内太多的请求被接收, 将返回响应状态代码 429 (这意味着过多的请求)。

要启用速率限制, [[yii\web\User::identityClass|user identity class]] 应该实现 [[yii\filter

- Hadoop2.5.2安装——单机模式

eksliang

hadoophadoop单机部署

转载请出自出处:http://eksliang.iteye.com/blog/2185414 一、概述

Hadoop有三种模式 单机模式、伪分布模式和完全分布模式,这里先简单介绍单机模式 ,默认情况下,Hadoop被配置成一个非分布式模式,独立运行JAVA进程,适合开始做调试工作。

二、下载地址

Hadoop 网址http:

- LoadMoreListView+SwipeRefreshLayout(分页下拉)基本结构

gundumw100

android

一切为了快速迭代

import java.util.ArrayList;

import org.json.JSONObject;

import android.animation.ObjectAnimator;

import android.os.Bundle;

import android.support.v4.widget.SwipeRefreshLayo

- 三道简单的前端HTML/CSS题目

ini

htmlWeb前端css题目

使用CSS为多个网页进行相同风格的布局和外观设置时,为了方便对这些网页进行修改,最好使用( )。http://hovertree.com/shortanswer/bjae/7bd72acca3206862.htm

在HTML中加入<table style=”color:red; font-size:10pt”>,此为( )。http://hovertree.com/s

- overrided方法编译错误

kane_xie

override

问题描述:

在实现类中的某一或某几个Override方法发生编译错误如下:

Name clash: The method put(String) of type XXXServiceImpl has the same erasure as put(String) of type XXXService but does not override it

当去掉@Over

- Java中使用代理IP获取网址内容(防IP被封,做数据爬虫)

mcj8089

免费代理IP代理IP数据爬虫JAVA设置代理IP爬虫封IP

推荐两个代理IP网站:

1. 全网代理IP:http://proxy.goubanjia.com/

2. 敲代码免费IP:http://ip.qiaodm.com/

Java语言有两种方式使用代理IP访问网址并获取内容,

方式一,设置System系统属性

// 设置代理IP

System.getProper

- Nodejs Express 报错之 listen EADDRINUSE

qiaolevip

每天进步一点点学习永无止境nodejs纵观千象

当你启动 nodejs服务报错:

>node app

Express server listening on port 80

events.js:85

throw er; // Unhandled 'error' event

^

Error: listen EADDRINUSE

at exports._errnoException (

- C++中三种new的用法

_荆棘鸟_

C++new

转载自:http://news.ccidnet.com/art/32855/20100713/2114025_1.html

作者: mt

其一是new operator,也叫new表达式;其二是operator new,也叫new操作符。这两个英文名称起的也太绝了,很容易搞混,那就记中文名称吧。new表达式比较常见,也最常用,例如:

string* ps = new string("

- Ruby深入研究笔记1

wudixiaotie

Ruby

module是可以定义private方法的

module MTest

def aaa

puts "aaa"

private_method

end

private

def private_method

puts "this is private_method"

end

end