【论文笔记】RTNH+: Enhanced 4D Radar Object Detection Network using Combined CFAR-based Two-level Preproce

【论文笔记】RTNH+: Enhanced 4D Radar Object Detection Network using Combined

CFAR-based Two-level Preprocessing and Vertical Encoding

原文链接:https://arxiv.org/pdf/2310.17659.pdf

1. 引言

RTNH为第一个在大型数据集上训练的4D雷达3D目标检测模型,但其雷达预处理仅选择了固定百分比的最高测量。但雷达在距离 r r r处的测量功率与 r − 4 r^{-4} r−4成正比,这种预处理方法会导致远处物体的测量丢失,从而降低性能。

传统的CFAR改进方法如CA-CFAR和OS-CFAR或者在密集场景下会丢弃有效测量,或者需要相当大的计算量。本文提出基于组合CFAR的两阶段预处理(CCTP)算法,使用相同的测量,在两个不同的过滤级别上生成不同特性的测量值。

另一方面,RTNH将3D点云的高度压缩为单一值,得到2D BEV图像,以减小计算。有实验证明,拼接高度特征和通道特征能编码更多的高度信息,因此本文提出一种高效的垂直编码(VE)算法,通过学习垂直查询提取垂直特征。

3. 算法与贡献

RTNH有三个阶段:测量预处理、3D稀疏主干(3DSB)、颈部与头部(N&H)。本文的CCTP算法与VE算法分别增强了第一和第二阶段。

3.1 基于组合CFAR的两阶段预处理(CCTP)算法

传统的CFAR算法通过仅考虑阈值以上的测量以保证比较低的虚警率,因此,在有效测量的信噪比(SNR)较高时,就能去除大部分的噪声;但在SNR较低时,会去除多数有效测量。RTNH的固定百分比测量选取没有考虑SNR,会导致远距离物体的大量漏检。

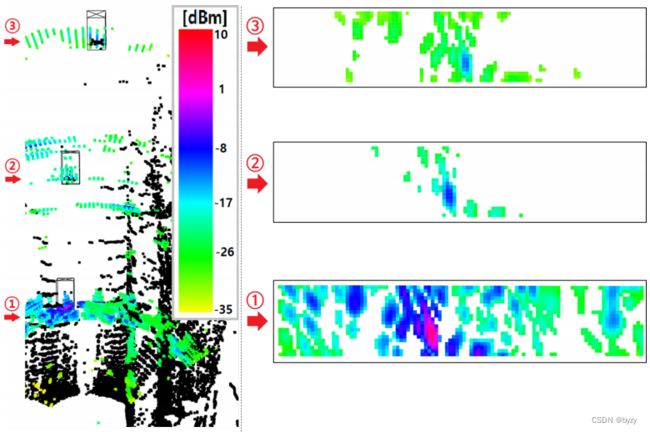

如下图所示,随着距离的增加,雷达测量的数量和功率均减小。最高功率的测量出现在物体所在位置,且水平角增减均会使强度逐渐下降。这是因为在CFAR不够低的情况下,无效成分(如噪声、干扰与杂波)难以去除。因此,使用低CFAR处理可以降低虚警率,但也会引入漏检。

本文提出的CCTP算法首先使用粗糙的、高阈值( K 1 % K_1\% K1%)的CA-CFAR以输出尽可能多的有效测量,然后使用低阈值( K 2 % K_2\% K2%)的OS-CFAR沿水平角维度处理输出以最小化无效测量(OS-CFAR对异构环境具有鲁棒性)。因此,该方法可以提取两类不同特性的测量,为目标检测网络提供更多的信息。

为加速OS-CFAR的排序操作,本文通过加权求和将垂直(俯仰角)维度压缩为单一值,得到每个水平角的1维向量。设 M 1 2 D [ i r , : , : ] M_1^{2D}[i_r,:,:] M12D[ir,:,:]为距离 i r i_r ir处的测量表达(水平角-俯仰角坐标系),由于物体的俯仰角都较小,设 W V W_V WV为垂直权重向量,加权的结果为

M 1 1 D [ i r , : ] = ∑ i e = 0 N e − 1 W V [ i e ] M 1 [ i r , : , i e ] = ∑ i e = 0 N e − 1 ( E T − i e ) M 1 [ i r , : , i e ] M_1^{1D}[i_r,:]=\sum_{i_e=0}^{N_e-1}W_V[i_e]M_1[i_r,:,i_e]=\sum_{i_e=0}^{N_e-1}(E_T-i_e)M_1[i_r,:,i_e] M11D[ir,:]=ie=0∑Ne−1WV[ie]M1[ir,:,ie]=ie=0∑Ne−1(ET−ie)M1[ir,:,ie]

其中 i e ∈ [ 0 , N e ) i_e\in[0,N_e) ie∈[0,Ne)为俯仰角索引, E T E_T ET为 M 1 M_1 M1沿俯仰角维度的大小。然后使用OS-CFAR处理 M 1 1 D [ i r , : ] M_1^{1D}[i_r,:] M11D[ir,:],选择前 K 2 % K_2\% K2%功率的测量。与RTNH在3D测量中排序相比,能大幅减小计算。在各距离平面处理后,得到距离-水平角平面内的保留测量位置集合 { [ j r , j a ] } \{[j_r,j_a]\} {[jr,ja]},对应将3D张量(距离-水平角-俯仰角坐标系)的位置保留:

M 2 3 D [ i r , i a , : ] = { M 1 3 D [ i r , i a , : ] [ i r , i a ] ∈ { [ j r , j a ] } 0 否则 M_2^{3D}[i_r,i_a,:]=\left\{\begin{matrix}M_1^{3D}[i_r,i_a,:]&[i_r,i_a]\in\{[j_r,j_a]\}\\0&否则\end{matrix}\right. M23D[ir,ia,:]={M13D[ir,ia,:]0[ir,ia]∈{[jr,ja]}否则

由于 M 2 3 D M_2^{3D} M23D是各距离分别处理的结果,保留测量沿距离轴相邻的有效值可能被移除。本文进一步恢复这些可能有效但被移除的测量,得到 M 3 3 D M_3^{3D} M33D:

M 3 3 D [ i r , i a , : ] = { M 1 3 D [ i r , i a , : ] [ i r , i a ] ∈ ⋃ [ k r , k a ] ∈ { [ j r , j a ] } ( k r − d r , k r + d r ) × ( k a − d a , k a + d a ) 0 否则 M_3^{3D}[i_r,i_a,:]=\left\{\begin{matrix}M_1^{3D}[i_r,i_a,:]&[i_r,i_a]\in \bigcup_{[k_r,k_a]\in\{[j_r,j_a]\}}(k_r-d_r,k_r+d_r)\times(k_a-d_a,k_a+d_a)\\0&否则\end{matrix}\right. M33D[ir,ia,:]={M13D[ir,ia,:]0[ir,ia]∈⋃[kr,ka]∈{[jr,ja]}(kr−dr,kr+dr)×(ka−da,ka+da)否则

其中 d r > d a ≥ 1 d_r>d_a\geq1 dr>da≥1。

两步的输出会拼接到一起输入到RTNH的第二阶段,其中第一步(下图中Step-1)的输出为主要输入,第二步(下图中Step-2&3)的输出作为可靠性指示。

3.2 使用垂直编码增强的4D雷达目标检测网络

第二阶段,CCTP的输出会被编码为稀疏特征图,并通过密集化得到密集特征图。进一步通过垂直编码(VE)算法编码为BEV特征图。VE分两步,第一步将沿垂直轴的、大小为 C n × Z f / S n C_n\times Z_f/S_n Cn×Zf/Sn的密集特征与大小为 C n × 1 C_n\times1 Cn×1的垂直查询使用多头注意力关联 Z f / S n Z_f/S_n Zf/Sn次,产生压缩高度的特征。本文的VE能高效编码垂直特征。VE的第二步将多头注意力的输出reshape为BEV特征图的大小。

第三阶段与RTNH相同,使用BEV特征图预测3D边界框。

3.3 额外贡献

由于K-Radar数据集是基于激光雷达数据进行标注的,很多物体在激光雷达视角下可见,而在雷达视角下不可见。因此,本文筛选并丢弃这样的边界框,以使任务更合理。

4. 实验

4.2 CCTP算法

本文评估了边界框内的有效测量保留率(PRVM)和边界框外的无效测量丢弃率(RRIM)。实验表明,调节超参数时,PRVM与RRIM有相反的变化趋势(一增一减)。PRVM的小幅下降仅会导致检测概率的小幅降低,但RRIM的下降会导致误检率的大幅上升,这是因为无效测量的数量比有效测量多得多。可根据其选择合适的超参数。

4.3 RTNH+与RTNH的比较

与RTNH相比,RTNH+有更低的漏检率和误检率,以及更精确的定位(因为CCTP第二步输出的有效性指示器)。

此外,VE能通过关注边界框的垂直界限来编码垂直信息,能达到更高的性能。

4.4 消融研究

修正标签的影响:使用修正后的标签训练模型,能带来更高的性能。

CCTP的影响:使用CCTP中不同步骤的结果( M k 3 D M_k^{3D} Mk3D)有相同的空间占用和不同的耗时,但完整的CCTP能带来最佳的性能。

VE的影响:与其余的高度压缩方法相比,本文的VE有最高的性能,且有更快的速度。

附录

A. RTNH+的细节

A.1 CCTP算法的图示

CCTP的第二步(图中Step-2&3)输出特征会用于建立0-1指示器,并与第一步的输出拼接。

A.2 颈部&头部的细节

颈部网络会将3D主干提取的多个BEV特征图拼接,并使用基于锚框的方法检测物体。

C. CCTP的超参数选择实验

实验表明,PRVM的小幅下降仅会导致检测性能略微下降,但RRIM的增加会导致检测性能明显下降。因此本文选择使PRVM适中,而RRIM较高的超参数。