谈谈一个IT杂家的职业生涯规划,你的护城河被AI 攻破了么

文章大纲

- 没有顶会的从业者:成为深度学习老中医

- AIGC 还未能克服的难点:忽然的惊喜 -- 大模型的智能涌现

- 未来还能做点什么,从计算机视觉的发展走向看

-

- T 字型人才与护城河

- 成为更加熟练使用人工智能的人

- 参考文献与学习路径

我的职业生涯将近十年,经历丰富。确切来说是广度足够,工作过的公司涵盖,民营小企业,外包,研究所,初创,世界五百强的外企。

而且干过的技术项目也挺广,因此自称个杂家不算过分。但杂家自然对技术变化的嗅觉更加敏锐,时常担忧某项技术的演变是否在未来保持活力。

最近在各处,比如知乎,csdn 等都看到很多,询问职业生涯规划等的帖子。我的想法和精力应该足够有代表性,至少大部分没有工作过我这么多类型的企业。我的研究生同学毕业后,4个人,3个到现在都没换过工作,只有我换过7个【算上实习就是8个】,他们都是足够专一的人,哈哈。

没有顶会的从业者:成为深度学习老中医

如果你还没有顶会文章,那你目前还不算是top level 的机器学习从业者。当然,即使有了顶级会议很多项目还是非常不好做,不一定能拿的下来。世界是变化的,数据是变化的,几百亿,万亿的参数能拟合时刻变化的现实世界吗?

Facebook公司的人工智能研究专家莱昂·博托(Léon Bottou)曾在2015年国际机器学习会议(ICML)上发表演讲——《机器学习的两大挑战》。在他看来,AI给软件工程带来了新的混乱,因为生产环境下数据必然会发生变化,会使AI模型或算法无法按预期输出稳定的结果。如果把训练好的模型作为软件模块来集成,模块的输出会受输入数据分布的变化影响,不能按模块之间的合约(Contract)“办事”,从而造成其他模块无法正常工作。

并且,AI模型什么时候、什么情况下会“违约”,无法被预先界定。传统软件工程中靠抽象封装解耦来解决大规模系统复杂度的问题,而这其中最关键的模块合约,被AI这个“捣乱”分子破坏了。模块之间的弱合约会带来“抽象泄露”(Abstraction Leak),不可依赖的子系统会让整个系统崩溃。因为数据必然会发生变化,所以模型无法按预期输出稳定结果。数据为什么会变化?发生变化之后又该怎么办呢?在真实的AI行业项目中,数据在不同客户项目和同一客户项目的不同阶段,都会呈现出不同的面貌,从而影响算法网络结构设计和模型参数设定。“做AI项目,客户第一次会提供一小撮数据样本让你理解业务数据;等你入场做POC测试时,会拿到批量的真实历史数据;等项目上生产环境后,你会碰到更实时的数据;等运行一段时间后又必然会遇到各种新的情况,例如调整客户业务的人群定位、外部行业政策有变导致业务环境也发生变化,等等。在这四个不同阶段,你所认知的客户数据特点和分布都会发生变化,而这个变化就意味着超参数要重新调整、网络结构可能要重新设计甚至对算法进行重新取舍……没办法,这就是做AI行业项目的命,很麻烦,也很折腾。”——某大厂AI算法工程师“很折腾”——更要命的是“折腾”的时间、地点、人物:是长期的折腾而不是一次性折腾;要在客户现场折腾而不是远程的云折腾;得让有AI炼金经验的算法工程师而不是普通工程师去折腾。关键是,折腾完了能不能成,怎么折腾才能成,即便是AI业界最顶尖的科学家也没法判断,因为没人知道其中的运作原理。2017年底,在AI界顶级的神经信息处理系统大会(NIPS)上,“时间检验奖”(Test of Time Award)的获得者阿里·拉希米(Ali Rahimi)在一片掌声中登台讲演,在讲完他的获奖论文之后,拉希米在大屏幕上出人意料地放出了一页:炼金术(Alchemy)。

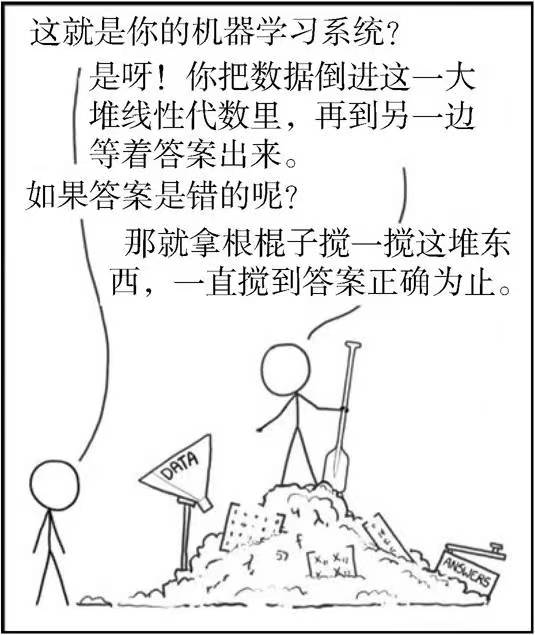

拉希米将当时快速发展的机器学习(主要指深度学习)比作炼金术,即方法虽然有不错的效果,但缺乏严谨完备可验证的理论知识,业内人士根本不理解自己做的东西是怎么运作的。例如,不小心修改一个参数就会带来模型效果天翻地覆的变化。或者,极简两层线性网络中遇到的问题,在增加网络复杂度之后就奇怪的消失了,没人能说清为啥会这样。深度学习社区对问题的解决方案,往往是在原本很神秘的技术栈上再叠加一层神秘的技巧。就像业界都知道,批量归一化可以降低内部协变量偏移(ICS),从而加快模型训练速度。但是,似乎没人知道为什么降低ICS就能加速训练,也没有证据证明批量归一化就一定能降低ICS,甚至整个业界都缺乏对ICS的严格定义!拉希米说,自己虽然不懂飞机的飞行原理,但他不怕坐飞机,因为他知道有一大批飞机专家掌握了原理。深度学习界最让人担心的是,他自己不知道原理,而且他知道其他人也不知道(参见下图)。

图 如何对付AI系统的错误图片来源:Randall Munroe,XKCD。

拉希米把这次大会变成了AI界的吐槽大会,在AI社群中引起了不少共鸣,以至于惊动了深度学习界的大佬,包括后来获得了图灵奖的杨立坤(Yann LeCun)。杨立坤对此回应道:神经网络确实没法在理论上证明自己一定收敛,但我们在实践中效果很好,千万别因为深度学习的理论跟不上实践就对AI大肆批判,这就像把孩子跟洗澡水一起倒掉,是不可取的。杨立坤的回应虽然在为AI辩护,但实际上承认了拉希米指出的问题——深度学习的理论不完备,算法模型的运行机制也不可知。因此,在AI行业项目中,不同客户环境下针对模型的调试优化能不能成功,靠的是经验加运气,调对了不知道为啥对,错了也搞不清为啥错,这样的经验自然也就不容易被传承和复制,只能依赖做过多个项目、遇到过多种情况、调试成功和失败的经验都积累了很多的AI“老中医”,这些老中医很稀缺,自然也很贵。而初级医师(有知识没经验的AI博士)要想成长起来,除了有老中医手把手指点,同样要走一遍师傅之前的路,靠项目和悟性不断积累“望闻问切”的经验。

因此,想要将AlphaGo的成功转变成其他行业的成功并不容易。想要从一个项目当前的成功迈向另一个项目的成功,也需要面对高额的成本和巨大的风险。这一轮深度学习完美叙事中“业务可复制”的理想,被现实残酷地打破了。

在AlphaGo兴起的那个年代,著名AI科学家吴恩达(Andrew Ng)曾经给出这样的期许:“如果普通人能在不到一秒的时间内完成某一项脑力工作,那么我们很可能在现在或不远的将来用AI将其自动化。”考虑到当时的实践经验,现在或许可以将其改为:如果普通人能在不到一秒的时间内完成某一项脑力工作,那么我们很可能在现在或不远的将来用AI将其自动化,至少可以找到一个符合条件的客户,把我们最贵的算法“老中医”砸进去,做一个能发公关宣传的样稿出来。

AIGC 还未能克服的难点:忽然的惊喜 – 大模型的智能涌现

涌现这个词其实不难理解,尤其是养过小孩的人。

忽然有一天,你的小孩学着妈妈的样子,会了叫你的名字,说:xxx 把水给我!

我想你一定不会生气,反而会非常惊喜。这样的场景很类似智能的涌现。

人类面对从未遇到过的问题就会涌现,但。。。

大模型许多新技能的泛化被解释为涌现,而涌现又是不可预测、不可控制的,那也就很难蓄意产出新技能的涌现了。某种程度上,大模型还是继承了深度学习炼金的特点啊。

这个涌现啊,就像凯文·凯利《失控》写过的,群集智能系统因为独立、不可控,才产生了智能的突破,所以要想有突破,就要放弃以往所习惯的中心控制,要接受不可预测、不可控制的这种失控。但是,如果社会还是不习惯这种失控,大众预期就会跟着舆论情绪走,要是因此高估了短期表现,就有可能因为暂时受挫看衰长期,这种震荡对产业发展其实是不利的。”小柯:“现在确实有一些声音,对大模型泛化的边界和程度有比较乐观的预期。前段时间,斯坦福和哈佛有人在《自然》(Nature)杂志上发了关于大模型通才式医疗AI范式的文章,他们认为不需要人工标签,就能让医疗AI从医学文本扩展到影像和视频了。但实际上,要达到这样的程度,大模型还要有技术突破,学到新的技能才行,而这都是不可预测、不可控的。”

AlphaGo年代对于业务可复制、模型可泛化的过度乐观,在大模型这波技术浪潮中会重演吗?大模型比AlphaGo更接近通用人工智能AGI吗?泛化能力:在从未碰到过的新情况下,AI能够正确理解并执行适当动作的能力。在同样的数据集训练基础上,泛化能力越强,就越能适应新的条件和场景,从而解决更多种类的问题。从技术和商业来看,泛化有两个层次:1.针对某个功能,在A数据集上进行的训练,在数据特点和分布不同的B数据集上表现也不错。这意味着,将模型和对应产品复制到新客户环境的边际成本很低,可加强业务在同一行业、同一场景下的可复制性。2.并未针对某个功能进行数据准备和训练,却学会了该功能(例如英汉翻译)。通过监督微调,甚至上下文学习就能掌握新技能。这意味着,同一个模型提供新的功能、产生新的业务价值的边际成本很低,可提高新产品新业务扩展的可行性和效率。跟AlphaGo和以往的深度学习模型相比,大模型在泛化能力上有了新的突破,因为大模型通过大量数据的预训练、更深的层次和更多的参数,学习并内置了关于世界的知识,从而在一定程度上支持了以上两个层次的泛化。用伊利亚的话说,当GPT训练自己预测下一个字的时候,其是在学习“世界的模型”,是通过学习语言文本的统计相关性来将文本中关于世界的知识压缩到模型中。基于这样的规模效应,大模型确实涌现出了许多泛化能力,体现了一定程度的通用性,但离真正的AGI(按伊利亚的标准,其泛化能力应达到人类大学本科生的水平)还有距离。

■纯文本信息还不足以建立完整的世界模型。目前的大模型在文本学习上有突破,图片学习效果还有待验证,而视频学习则可能要引入Transformer模型之外的新技术。

■大模型的泛化能力是有边界的。当前大模型从文本中学到的能力主要集中在自然语言相关的认知智能领域,而在以图像识别为代表的感知智能和以用户行为预测为代表的决策智能领域,大模型则未必适合。即便在认知智能领域,其也存在规划能力不足等一系列缺陷。

■在自然语言相关的认知智能边界内,泛化的产生是被动的。从涌现机制的角度看,只能通过事后观察来分析浅层的规律,无法做到新技能涌现的可知、可预测、可控,也就很难提升新技能涌现的效率。

在AI新技术产生突破的早期阶段,学界、产业和资本可能有意无意地对模型泛化和业务可复制、可扩展产生乐观预期。例如2023年4月斯坦福和哈佛学者在《自然》杂志发表的文章中,基于大模型提出通才式的医疗人工智能范式,认为无需特定的人工标签训练,即可从文本扩展到医学影像和视频的理解和辅助诊断。然而,文章中并未提到的是,要真正达到这样的范式转变的水平,实际上还有很长的路要走;而且,所需要的技术突破或涌现仍然是不可预测、不可控的。就像凯文·凯利在《失控》一书中讲述的群集系统智能那样,失控(不可知、不可预测、不可控)既是智能获得突破的重要原因,又是智能突破所不可避免的伴生结果。然而,这种失控并非社会所习惯的模式。如果没有合理地控制预期,大众往往在短期过度乐观,一旦受挫,便会低估长期发展趋势,造成产业的大起大落。

从产业的角度,对大模型在各行业场景下的泛化和复制能力,建议“小马过河”,谨慎乐观(参见图4.44)。单纯地期待涌现不可靠,产业界需要找到配套的方法,让大模型落地的结果更可控。[插图]◎图4.44 大模型面对落地行业的选择图片来源:作者使用AI制图软件绘制。1.选好做什么,不做什么。在一些场景中,大模型现有的一些缺陷对商用的影响没那么大,甚至可能是助益,如强调个性化和趣味性的聊天应用的character.ai的创始人说:“我并不认为幻觉是需要解决的问题,我甚至很喜欢它,这是模型有趣的特点。”在character.ai做的“角色扮演”聊天场景中,幻觉是想象力的源泉。但对另一些容错很低的行业,如医疗诊断、自动驾驶、工业自动化,幻觉却危害显著。2.通过人工或机器手段来给大模型的缺陷打补丁。在适合使用GPT大模型能力的领域,针对幻觉、规划能力不足、缺乏长期记忆等缺陷,现在都有部分解决方案。机器手段包括通过本地数据库查询的方式,在对话中带入历史记忆,增加模型的记忆能力,通过两个模型间左右互搏的方式识别幻觉。人工手段包括通过提示工程指引大模型进行复杂规划,采用人工审核的方式来发现并纠正模型幻觉。以上手段在不同行业场景、不同数据环境下的效果与成本,需要用实践验证,其综合结果会影响GPT大模型在这个行业或场景的商业价值。3.针对目标行业进行深入定制化,对快速颠覆怀有谨慎期待,对额外的成本有预期。由于大模型仍无法通吃所有行业,越来越多人意识到,在通用大模型之上,还可以针对垂直领域精细化训练和定制大模型,这类模型仅在指定行业场景下执行有限种类任务,规模可适当缩小。从轻到重,做定制化的方式有:

■基于已有闭源大模型的API接口,通过应用级的微调和打补丁做定制应用。

■选择开源的、已经完成预训练工作的基础模型,做更多定制。

■从头自己训练垂直模型:从预训练数据选择、模型结构设计切入,定制全新大模型,以解决特定行业场景的问题。如彭博推出了500亿参数的金融垂直大模型BloombergGPT,预训练使用的金融数据集和通用数据集各占一半,在金融特有任务,如在新闻情感分析领域领先于通用大模型。

越重的做法,成本越大,壁垒也越高。不同行业,怎么做最有竞争优势,没有标准答案,但可以有一个大致的决策模型:更稳的选择是先做最轻的打补丁,在掌握问题和数据、验证业务价值后,再决定是否走彻底定制路线。然而,这种做法可能错过时间窗口,导致追不上行业里更早做出垂直模型的公司,后者可能更快形成数据反馈到模型能力迭代的“数据飞轮”,与其他人拉开差距。更大胆的方式是跳进选好的方向,直接从头一边炼大模型一边找业务价值,这需要持续的资源,也是目前一批融资能力最强的创业者的共同选择。

未来还能做点什么,从计算机视觉的发展走向看

我算是搞过机器学习的两大领域,NLP 和CV , 可以说 GPT3.5 出来后, NLP 死了,CV 还能活几天估计也不远了,因为目前还有个开放域的自动驾驶没有能搞特别好的解决。我认为CV 以后的研究和应用热点 会集中在下面两个方面:

- 自动驾驶

- 深度学习大模型边缘端的部署及推理优化

OpenCV 5.0 还没问世,更新不过来了给大家发了一封邮件立面写到:

In a world where massive AI projects are closed-source, and a handful of companies are set to control the future of AI, people are rightfully asking, where is OpenCV 5? The good news is we have the answer: at the end of this campaign. OpenCV is used everywhere, but as an open source library operated by a non-profit funding has become more and more difficult to come by. If you’ve benefitted from OpenCV in your career or education, please consider supporting the library today and helping ensure the future of this iconic toolset.

这里面第一句话,我认为非常有深度:

在一个大规模人工智能项目是封闭来源的世界里,少数公司将控制人工智能的未来!

T 字型人才与护城河

从某种意义上说,目前的知识分享领域的博主都是在用 自己个人的力量在对抗人工智能。下面是我制作的两个数字人,我甚至连稿子都是AIGC 写的。

数字人-王大力精讲:《机器学习与深度学习》

数字人-王大力精讲: 视频分析 VideoAnalytics

我还在不断思考,在特定领域中,如何不被 大模型所取代。程序员这个职业还能干几年,领域常说成为T字型人才,这个深度就是护城河,目前来看大模型的深度越来越深。。。

成为更加熟练使用人工智能的人

不过也不用那么担心,不要担心人工智能会取代你。

也许取代你的,不是人工智能,而是比你更会用人工智能的人。

参考文献与学习路径

-

《大模型时代:ChatGPT开启通用人工智能浪潮》

OpenCV5 的活动:

-

https://www.indiegogo.com/projects/opencv-5-support-non-profit-open-source-cv-ai#/