程序模拟完成kafka生产者和消费者实验

kafka上的操作

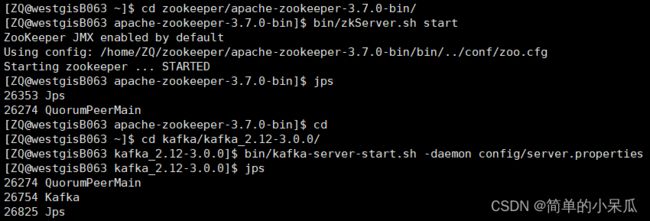

1、启动kafka

cd zookeeper/apache-zookeeper-3.7.0-bin/bin/zkServer.sh startcdcd kafka/kafka_2.12-3.0.0/bin/kafka-server-start.sh -daemon config/server.properties2、在kafka上创建一个话题test

bin/kafka-topics.sh --bootstrap-server westgisB063:9092 --create --partitions 1 --replication-factor 3 --topic test![]()

(--partition为分区数 --replication-factor为分区的副本数)

查看所有 topic

bin/kafka-topics.sh --bootstrap-server westgisB063:9092 --list查看 test 主题的详情

bin/kafka-topics.sh --bootstrap-server westgisB063:9092 --describe --topic test在IDEA中创建一个maven项目

1、在pom.xml文件中,引入kafka-clients依赖:

在pom.xml文件中增加如下内容:

org.apache.kafka

kafka-clients

3.0.0

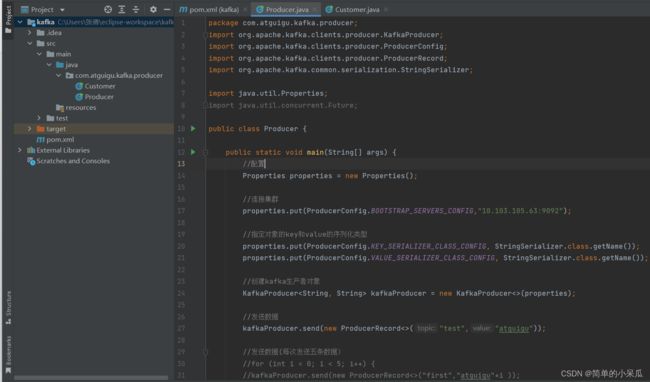

2、 创建一个KafkaProducer的生产者实例:

package com.atguigu.kafka.producer;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.common.serialization.StringSerializer;

import java.util.Properties;

import java.util.concurrent.Future;

public class Producer {

public static void main(String[] args) {

//配置

Properties properties = new Properties();

//连接集群

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG,"10.103.105.63:9092");

//指定对象的key和value的序列化类型

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

//创建kafka生产者对象

KafkaProducer kafkaProducer = new KafkaProducer<>(properties);

//发送数据

kafkaProducer.send(new ProducerRecord<>("test","atguigu"));

//发送数据(每次发送五条数据)

//for (int i = 0; i < 5; i++) {

//kafkaProducer.send(new ProducerRecord<>("first","atguigu"+i ));

//}

//关闭

kafkaProducer.close();

}

}

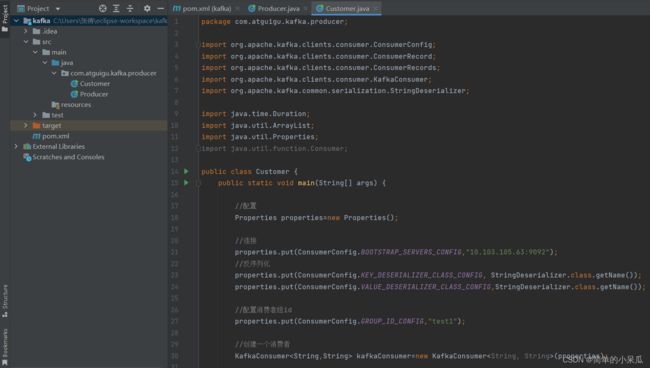

3、 创建一个KafkaConsumer的消费者实例:

package com.atguigu.kafka.producer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.serialization.StringDeserializer;

import java.time.Duration;

import java.util.ArrayList;

import java.util.Properties;

import java.util.function.Consumer;

public class Customer {

public static void main(String[] args) {

//配置

Properties properties=new Properties();

//连接

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG,"10.103.105.63:9092");

//反序列化

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG,StringDeserializer.class.getName());

//配置消费者组id

properties.put(ConsumerConfig.GROUP_ID_CONFIG,"test1");

//创建一个消费者

KafkaConsumer kafkaConsumer=new KafkaConsumer(properties);

//订阅主题test

ArrayList topics=new ArrayList<>();

topics.add("test");

kafkaConsumer.subscribe(topics);

//消费数据

while (true){

ConsumerRecords consumerRecords=kafkaConsumer.poll(Duration.ofSeconds(1));

for (ConsumerRecord consumerRecord :consumerRecords){

System.out.println(consumerRecord);

}

}

}

}

生产者和消费者之间的发送消息

IDEA上的生产者代码发送数据,xshell的消费者接收数据

1、在IDEA上运行Producer代码,并输入一些数据

2、在xshell上输入以下代码把主题中所有的数据都读取出来

bin/kafka-console-consumer.sh --bootstrap-server 10.103.105.63:9092 --topic test --from-beginning3、运行后查看结果

xshell的生产者代码发送数据,IDEA的消费者接收数据

1、在IDEA上运行Producer代码

2、在xshell上输入以下代码,并输入数据

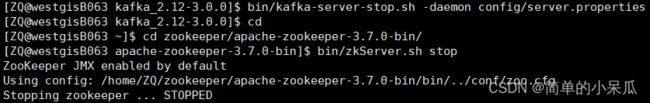

bin/kafka-console-producer.sh --bootstrap-server westgisB063:9092 --topic test关闭kafka

bin/kafka-server-stop.sh -daemon config/server.propertiescdcd zookeeper/apache-zookeeper-3.7.0-bin/bin/zkServer.sh stop