大数据实训笔记3:hdfs

HDFS(Hadoop Distributed File System)是一个文件系统,用于存储文件,通过目录树来定位文件。它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS适合一次写入,多次读出的场景,且不支持文件的修改。适合用来做数据分析,并不适合用来做网盘应用。

hdfs的命令操作

//-help: 输出这个命令参数

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -help rm

//-ls: 显示文件夹信息

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -ls /xiyou

//-lsr:显示多级文件夹信息

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -lsr /xiyou

//-mkdir:在HDFS上创建文件夹

//后面加-p代表创建多级文件夹,不带-p就是创建一个文件夹

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -mkdir -p /hadoop/input

//-moveFromLocal:从本地剪切粘贴到HDFS

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -moveFromLocal liubei.txt /hadoop/input

//-appendToFile:追加一个文件到已经存在的文件末尾

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -appendToFile zf.txt /hadoop/input/liubei.txt

//-cat:显示文件内容

[hadoop@hadoop101 hadoop-3.1.3]$ hadoop fs -cat /hadoop/input/liubei.txt

//-chgrp 、-chmod、-chown:Linux文件系统中的用法一样,修改文件所属权限

//修改liubei.txt文件所有在的组为hadoop

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -chgrp hadoop /hadoop/input/liubei.txt

//修改liubei.txt文件的权限

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -chmod 777 /hadoop/input/liubei.txt

//-copyFromLocal:从本地文件系统中拷贝文件到HDFS路径去

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -copyFromLocal zf.txt /hadoop/input

//-put:等同于copyFromLocal

[hadoop@hadoop101 hadoop-3.1.3]$ hadoop fs -put gy.txt /hadoop/input

//-copyToLocal:从HDFS拷贝到本地

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -copyToLocal /hadoop/input/liubei.txt ./

//-get:等同于-copyToLocal

[hadoop@hadoop101 hadoop-3.1.3]$ hadoop fs -get /hadoop/input/zf.txt ./

//-getmerge:合并下载多个文件

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -getmerge /hadoop/input/* ./sg.txt

//-cp :从HDFS的一个路径拷贝到HDFS的另一个路径

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -cp /hadoop/input/gy.txt /hadoop

//-mv:在HDFS目录中移动文件

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -mv /hadoop/input/zf.txt /hadoop

//-tail:显示一个文件的末尾

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -tail /hadoop/input/liubei.txt

//-rm:删除文件

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -rm /hadoop/zf.txt

//-rmdir:删除文件夹

//若文件夹非空,需要在-rmdir后加上-r

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -rmdir /hadoop/output

//-du: 统计文件夹的大小信息

//不带单位的

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -du /hadoop

//显示所有文件大小

[hadoop@hadoop101 hadoop-3.1.3]$ hdfs dfs -du -h -s /hadoop

hdfs客户端环境准备

jdk 1.8

官网下载地址

安装后,需要配置环境变量。打开我的电脑-右键-属性-高级系统设置-环境变量,在系统变量中新建一个系统变量,变量名为JAVA_HOME,变量值为JDK的安装路径。注意安装路径不要出现中文!

再打开系统变量的Path,新建一条,内容为%JAVA_HOME%\bin。

打开cmd,测试是否配置成功。

hadoop 3.1.0

安装hadoop-3.1.0后,按照上述同样的方法,配置变量HADOOP_HOME。

打开cmd,测试是否配置成功。

注意,这样就说明已经配置成功了。

maven

安装apache-maven-3.6.1后,按照上述同样的方法,配置变量MAVEN_HOME。

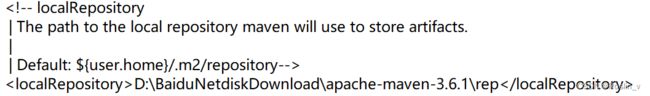

在安装路径-conf-setting.xml中,修改repository路径(默认为C盘)。

IDEA

官网下载地址

安装后,在Settings-File Encodings中,将字符集编码改为utf-8,解决中文字符乱码的问题。

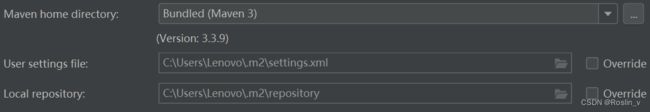

在Settings-Build, Execution, Deployment-Build Tools-Maven中,将下图中的文件位置改为自己的安装路径。

hdfs客户端操作

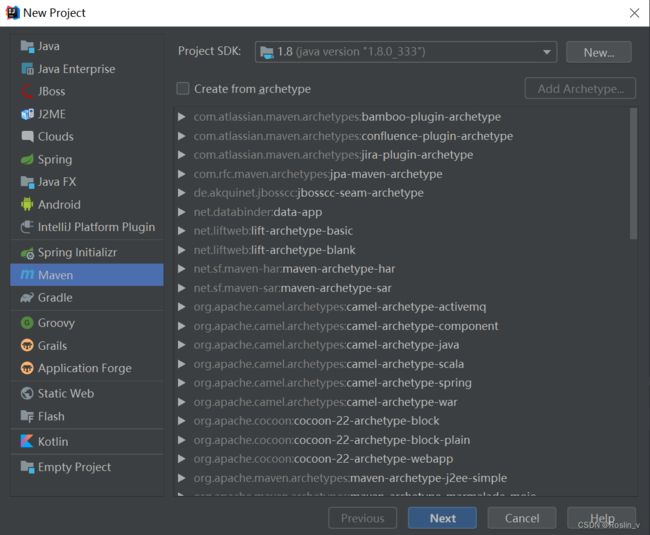

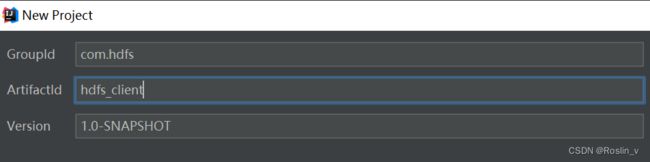

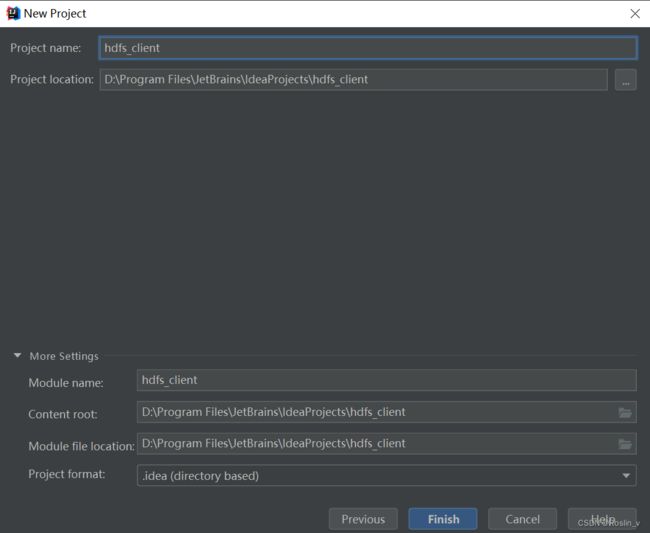

maven工程搭建

创建完成后,我们需要在pom.xml(左边栏的target文件夹下)中导入依赖。

1.8

1.8

3.1.3

org.apache.hadoop

hadoop-client

${hadoop.version}

junit

junit

RELEASE

org.slf4j

slf4j-log4j12

2.0.0-alpha2

只复制代码会报错,需要点击右边栏中Maven中的刷新按钮导入依赖。

在左边栏的src-main-resources下创建log4j.properties日志。

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n基础操作

接下来,我们介绍几个hdfs客户端基础操作。每个操作运行完后,可以在http://hadoop101:9870网站上查看运行效果。

注意,复制代码之后,还要导入包。导入过程中,记得选择与hadoop相关的包。

public class HdfsClient {

//写一个log4j日志

private Logger logger=Logger.getLogger(this.getClass());

//获取HDFS客户端对象

private FileSystem fs;

@Before

public void init() throws URISyntaxException, IOException, InterruptedException {

//创建URI对象

URI uri=new URI("hdfs://hadoop101:8020");

//创建一个配置对象

Configuration conf=new Configuration();

//获取HDFS客户端对象

fs = FileSystem.get(uri, conf, "hadoop");

}

//释放资源

@After

public void close() throws IOException {

fs.close();

}

//在HDFS上创建文件夹/sanguo

@Test

public void testCreateMkdir() throws URISyntaxException, IOException, InterruptedException {

//创建文件夹/sanguo

boolean result = fs.mkdirs(new Path("/sanguo"));

logger.info(result?"创建文件夹成功":"创建文件夹失败");

}

//上传文件到HDFS

@Test

public void testPutFile() throws URISyntaxException, IOException, InterruptedException {

//上传文件

/* @param 是否删除原有目标文件

* @param 是否覆盖已经存在的文件

* @param 原始路径

* @param 目标路径*/

fs.copyFromLocalFile(false,true,

new Path("E:/liubei.txt"),

new Path("/sanguo"));

logger.info("上传文件成功!");

}

//下载文件

@Test

public void testGetFile() throws IOException {

fs.copyToLocalFile(false, new Path("/sanguo/liubei.txt"), new Path("E:/lb.txt"),false);

logger.info("下载文件成功!");

}

//重命名

@Test

public void testRename() throws IOException {

boolean result = fs.rename(new Path("/sanguo/liubei.txt"), new Path("/sanguo/lb.txt"));

logger.info(result?"重命名成功":"重命名失败");

}

//HDFS文件详情

@Test

public void testListFile() throws IOException {

RemoteIterator listFiles = fs.listFiles(new Path("/sanguo"), true);

while (listFiles.hasNext()) {

LocatedFileStatus file = listFiles.next();

logger.info(file.getPermission());//获取文件权限

logger.info(file.getOwner());//获取文件拥有者

logger.info(file.getGroup());//获取文件所在组

logger.info(file.getLen());//获取文件大小

logger.info(file.getModificationTime());//获取文件上一次修改时间

logger.info(file.getReplication());//获取副本

logger.info(file.getBlockSize());//获取块大小

logger.info(file.getPath().getName());//获取文件名称

BlockLocation[] locations = file.getBlockLocations();

logger.info(Arrays.asList(locations));

System.out.println("---------------------");

}

}

//删除文件

@Test

public void testDelete() throws IOException {

boolean result = fs.delete(new Path("/sanguo"), true);

logger.info(result?"删除成功":"删除失败");

}

}