参赛邀请 | 第二届古汉语自动分析国际评测EvaHan(古汉语机器翻译)开始报名...

![]()

EvaHan2023

中国古代典籍是中国传统文化的重要组成部分,在古籍研究领域,古籍的翻译起着非常重要的作用。古汉语在语法、句法、词汇等方面与现代汉语有很大的差异,提高古汉语到现代汉语的机器翻译性能可以更好地推动古籍研究的发展。同时,提高古汉语到英语的机器翻译技术也可以推动中国传统文化在世界范围内的推广。

EvaHan是专注于古汉语信息处理的系列国际评测,2022年在法国马赛,与古拉丁语自动分析评测EvaLatin一起,举办了第一届古汉语分词与词性标注评测EvaHan2022,有十多支队伍参赛,并刷新了业界的最好成绩。为了推动古籍处理技术的进步,2023年在中国澳门举办第二届EvaHan评测。

EvaHan 2023是第二届古汉语信息处理国际评测,今年任务是古汉语的机器翻译,包含两个子任务:

古汉语翻译为现代汉语

古汉语翻译为英语

EvaHan 2023将于2023年9月4日在中国澳门特区召开。作为古文翻译研讨会ALT2023(http://www.ancientnlp.com/alt2023/)的子任务,在国际机器翻译顶会MT-SUMMIT2023(https://mtsummit2023.scimeeting.cn/en/web/index/)上召开。

ALT2023还将同期举行第一届楔形文字机器翻译评测,将苏美尔语和古汉语两种古老的语言自动翻译为今天的语言,是一个重要的进步。

比赛将设置一二三等奖,将给获奖队颁发证书和奖金。奖金赞助商正在洽谈。

![]()

Important Dates

Registration for the shared task: 15 Feb, 2023 ~ 25 March, 2023

Training data release: April 1, 2023

Test data release: June 1, 2023

Data submission : June 7, 2023

Tech report submission: June 15, 2023

Notification of acceptance: June 25, 2023

C

amera Ready submission: 10 July 2023

EvaHan 2023

参赛手册

![]()

数据说明

数据来源于中国的二十四史、先秦典籍和《资治通鉴》,由国家社会科学基金重大项目“中国古代典籍跨语言知识库构建及应用研究”(项目编号:21&ZD331)课题组精加工完成。

语料库中的中国古代经典文本既具有历时性,语料内容的时间跨为数千年,又具有多样性,即涵盖了中国传统的四类规范文本:经(儒家经典),史(历史著作),子(属于儒家以外的思想流派的哲学著作,但也包括农业、医学、数学、天文学、占卜、艺术评论和其他杂文)和集(文学作品集)。

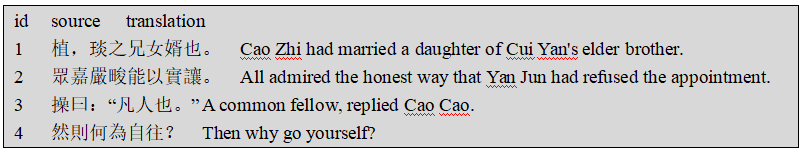

1.数据格式

发布的数据没有对任何长度的句子(包括空句子)进行标记化。所有数据都是Unicode (UTF-8)格式。平行语料库数据格式的示例如图1所示。

以古白平行语料为例,左侧为古汉语文本,右侧为以句子为单位对应的现代汉语文本(繁体)。对于古代汉英平行文本,采用相同的格式。

2.训练数据

训练数据的来源是中国二十四史古代汉语到现代汉语的平行语料库、先秦典籍古代汉语到英语的平行语料库和《资治通鉴》。训练数据的基本概况如表1所示。

总的来说,本次测评所采用的古代汉语文本跨语言平行语料具有规模大、历时性强、平衡性强的特点。

3.测试数据

测试数据将以txt格式提供,内容为古代汉语的句子。

![]()

翻译任务

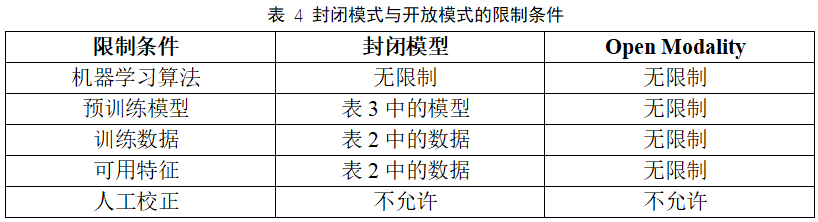

评测分为开放模式和封闭模式。

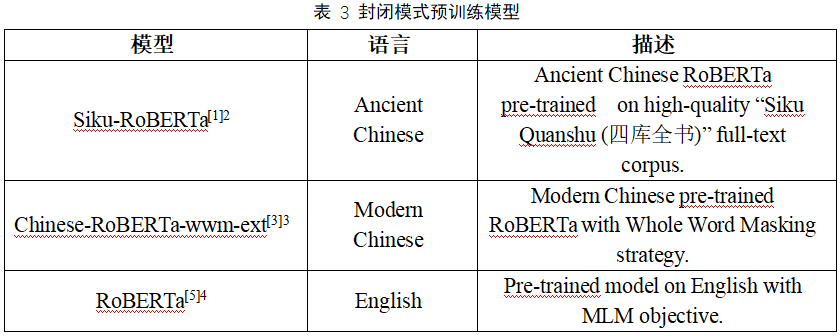

在封闭模式中,只能使用指定的数据资源,现代汉语模型采用Chinese-RoBERTa-wwm-ext[3],古代汉语模型采用Siku-RoBERTa[1],英语模型采用RoBERTa[4],参赛者需要做的就是改进模型或算法,提升机器翻译的性能。

在开放模式中,参赛队可以使用任意的数据资源,但是需要在技术报告中予以说明。

您可以同时参加多个赛道和模式。每一个参赛团队提交的结果要应该包含翻译系统的简要介绍(基本信息,例如使用的模型、技术、方法等),同时,参赛团队需要提交一份技术报告,对模型的改进以及使用的方法进行详细的介绍。

尽管本次测评的主要目标是评选出性能最为优越的机器翻译系统,我们也鼓励一些富有创造性的项目参赛,即便该项目的性能并不是最优的。您也可以通过本次测评进一步完善、提升您的系统。

![]()

评测内容

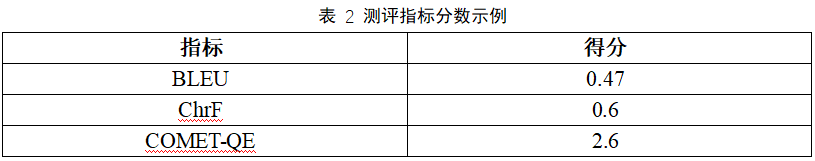

1.测评指标

我们将分别评估参与者提供的古英机器翻译模型和古白机器翻译模型的性能。本次测评采用的评测指标为BLEU[5]、ChrF[6]和COMET-QE[7-9]。

参赛队伍在参赛之初只能获取到训练数据,之后我们将发布包含古汉语文本的测试数据。测评结束后,还将发布与测试数据中古汉语对应的现代汉语和英语数据。

表2给出了评分指标的输出样例,测评过程中,将根据参赛队伍的翻译结果和相应的参考翻译自动计算测评分数。

2.封闭模式与开放模式

每个参赛队伍都可以同时参加两个赛道:封闭模式与开放模式。在封闭模式下,参赛队伍只能使用我们提供的训练数据和规定的预训练模型,如表3所示。

在开放模式中,参赛队伍使用的资源(例如:模型、数据)将不受限制。可以使用带有标注的外部数据以及一些其他辅助技术,例如汉字拼音、知识图谱、词嵌入等。请注意,参赛团队必须在最终报告中声明他们在参赛过程中使用的所有资源。

3.测评的Baseline

我们将评估谷歌翻译在测试数据上的翻译结果,作为Baseline。

![]()

参赛方式

1.注册

如果您有意向参加,请填写电子版参赛申请表:https://forms.office.com/Pages/ResponsePage.aspxid=DQSIkWdsW0yxEjajBLZtrQAAAAAAAAAAAAMAAExHmLlUMURNSUNHQTQ5SUhQMzFIR05GSEo2QUFONi4u&lang=en

您也可以在EvaHan2023官方GitHub网站查找,填写时,请确保您的信息正确且您的电子邮箱可以正常使用。收到您的注册信息后,我们会将训练数据发送到您的电子邮箱,请注意查收。

2.咨询

如果您对本次测评有任何疑问,请随时发送电子邮件到我们的官方邮箱:[email protected]。

如果您长时间没有收到回复,请检查您的邮件是否发送成功。

![]()

比赛要求

1.提交结果的格式

在您的参赛团队完成了翻译任务后,请务必按照以下说明提交翻译结果:

●文件命名:

请使用以下文件名格式命名翻译结果:

任务ID_队伍名称_结果ID_模式.tsv

例如:testa_unicatt_1_closed.tsv为一支名为unicatt的队伍在封闭模型下使用testa.txt文本(古白翻译)的第一次翻译结果。

testb_unicatt_2_open.tsv 为一支名为unicatt的队伍在开放模型下使用testb.txt文本(古英翻译)的第二次翻译结果。

●提交格式:

输出文件内容应该按照如下格式使用制表符分隔:

其中:

提交样例如下:

2.提交方式:

在提交之前,请通过我们之后提供的测评脚本进行初步测试,之后,您可以将本次得分与BLEU、ChrF和COMET-QE一起使用。

请将您的结果发送到我们的官方邮箱:[email protected],主题为“EvaHan Submission:taskID-teamName”,其中“taskID”为testa或testb。

请注意,每个参赛团队的每个翻译任务最多只能提交两次,请勿重复提交。

3.撰写技术报告

技术报告内容部分(参考文献除外)不应超过4页,格式要求参见MT Summit 2023样式指南(PDF、LaTeX、MS Word版本和Overleaf版)。由于技术报告要进行盲审,请勿在技术报告中包含作者姓名和机构,并避免过于明显的自我引用。

请于会议截至提交日期前,将技术报告提交至以下网站:https://softconf.com/mtsummit2023/research

![]()

组织方

EvaHan 2023是由南京师范大学、南京农业大学信息管理学院、南京理工大学经济管理学院的计算语言学和数字人文研究团队共同组织。

附录:古籍翻译在线资源

• 古代汉语预训练模型 SikuRoBERTa: https://huggingface.co/SIKU-BERT/sikuroberta; https://github.com/hsc748NLP/SikuBERT-for-digital-humanities-and-classical-Chinese-information-processing

• 现代汉语预训练模型 RoBERTa: https://huggingface.co/hfl/chinese-roberta-wwm-ext; https://github.com/ymcui/Chinese-BERT-wwm

• 英语预训练模型 RoBERTa: https://huggingface.co/roberta-large; https://github.com/facebookresearch/fairseq/tree/main/examples/roberta

• 多语言预训练模型 RoBERTa: https://huggingface.co/xlm-roberta-large; https://github.com/facebookresearch/fairseq/tree/main/examples/xlmr

• 古代汉语预训练模型 GPT-2: https://huggingface.co/uer/gpt2-chinese-ancient; https://github.com/Morizeyao/GPT2-Chinese

• 古代汉语预训练模型 SikuGPT: https://huggingface.co/JeffreyLau/SikuGPT2; https://github.com/SIKU-BERT/sikuGPT

• 古代汉语预训练模型GuwenBERT: https://huggingface.co/ethanyt/guwenbert-base; https://github.com/Ethan-yt/guwenbert

• 古代汉语句法语料库: http://kanji.zinbun.kyoto-u.ac.jp/~yasuoka/kyodokenkyu/2019-03-08/

• 古代汉语自动断句: https://seg.shenshen.wiki/; https://wyd.kvlab.org

• 古代汉语标注语料库: http://lingcorpus.iis.sinica.edu.tw/ancient/

• 在线汉语语料库检索系统: http://dh.ersjk.com/

• 古代汉语语料库: https://github.com/garychowcmu/daizhigev20

参考文献

[1] Wang, D., Liu, C, Zhu, Z, et al. 2022. Construction and Application of Pre-trained Models of Siku Quanshu in Orientation to Digital Humanities. Library Tribune, 42(6), 31-43. (In Chinese)

[2] Li, B., Yuan, Y., Lu, J., Feng, M., Xu, C., Qu, W., & Wang, D. (2022). The First International Ancient Chinese Word Segmentation and POS Tagging Bakeoff: Overview of the EvaHan 2022 Evaluation Campaign. In Proceedings of the Second Workshop on Language Technologies for Historical and Ancient Languages (pp. 135-140).

[3] Cui, Y., Che, W., Liu, T., et al. Revisiting pre-trained models for Chinese natural language processing[J]. arXiv preprint arXiv:2004.13922, 2020.

[4] Liu, Y., Ott, M., Goyal, N., Du, J., Joshi, M., Chen, D., ... & Stoyanov, V. (2019). Roberta: A robustly optimized bert pretraining approach. arXiv preprint arXiv:1907.11692.

[5] Papineni, K., Roukos, S., Ward, T., & Zhu, W. J. (2002). Bleu: a method for automatic evaluation of machine translation. In Proceedings of the 40th annual meeting of the Association for Computational Linguistics (pp. 311-318), Philadelphia, Pennsylvania, USA: Association for Computational Linguistics.

[6] Popović, M. (2015). chrF: character n-gram F-score for automatic MT evaluation. In Proceedings of the tenth workshop on statistical machine translation (pp. 392-395), Lisbon, Portugal: Association for Computational Linguistics.

[7] Rei, R., Stewart, C., Farinha A. C., & Lavie, A. (2020). COMET: A neural framework for MT evaluation. In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP) (pp.2685-2702), Online: Association for Computational Linguistics.

[8] Rei, R., Farinha, A. C., Zerva, C., van Stigt, D., Stewart, C., Ramos, P., ... & Lavie, A. (2021). Are references really needed? unbabel-IST 2021 submission for the metrics shared task. In Proceedings of the Sixth Conference on Machine Translation (pp. 1030-1040), Online: Association for Computational Linguistics.

[9] Kocmi, T., Bawden, R., Bojar, O.,et al. (2022). Findings of the 2022 conference on machine translation (WMT22). In Proceedings of the Seventh Conference on Machine Translation (WMT) (pp. 1-45), Abu Dhabi, United Arab Emirates: Association for Computational Linguistics.

进NLP群—>加入NLP交流群