Mistral AI发布行业领先的Mixtral 8x7B专家混合模型&完成4.15亿美元融资

一、前言

Mistral AI 是欧洲最强的 LLM 大模型公司,团队由来自 Google、Meta 和 Hugging Face 的新生代法国科学家们组成。法国是欧洲 AI 人才最集中的地方,Falcon 模型和 Hugging Face 社区都来自法国团队。他们在多模态、检索增强生成(RAG)等大模型突破方向有着丰富经验,有理由期待 Mistral AI 的下一代新模型成为 game changer 的潜力。

企业端使用 LLM 时考虑的不仅是最前沿的模型能力,也包括数据安全隐私、成本控制等多种考虑。向企业开放的开源模型更符合定制化、私有化使用的需求,而 OpenAI 等闭源模型公司并不能满足这样的需求。未来的 LLM 市场很可能是开源模型满足基本的智能需求,闭源模型满足高阶的智能需求。随着模型的升级,开源模型能满足的需求逐渐变多。

在人工智能的快速发展浪潮中,Mistral AI以其独特的视角和战略定位,正引领着行业的一场革命。Arthur Mensch在近期的访谈中揭示了Mistral AI的核心追求——通过打造小型化、高效率的模型来降低成本,并构建一个便捷、安全且经济的平台,使企业能够轻松调用这些模型。他坚信,缩小模型规模不仅能助力Agents的开发,更能大幅降低运算成本,从而孕育出众多创新应用。在Mistral AI看来,开源不是威胁,而是一个机遇——它不仅满足了企业私有化需求,还增强了模型的安全性和公众信任。作为欧洲最具实力的大型语言模型公司之一,Mistral AI正凭借其丰富的经验和开源战略,在AI世界中为自己铺设一条通往未来的道路。

二、Mistral AI,完成了4.15亿美元的融资

法国初创公司Mistral AI正式结束了备受瞩目的A轮融资。该公司筹集了3.85亿欧元,按照今天的汇率折合为4.15亿美元——据Bloomberg报道,这使得公司的估值约为20亿美元。Mistral AI今天也开放了其商业平台。

提醒一下,Mistral AI在不到六个月前筹集了1.12亿美元的种子轮融资,以建立一个与OpenAI竞争的欧洲对手。由Google的DeepMind和Meta校友共同创立,Mistral AI正在开发具有开放技术视角的基础模型。

Lightspeed Venture 的种子轮阵容十分庞大,由欧洲 LightSpeed 领头,法国的 Redpoint、Index Ventures、Xavier Niel、JCDecaux Holding、Rodolphe Saadé和Motier Ventures,德国的 La Famiglia和 Headline,意大利的 Exor Ventures,比利时的 Sofina,以及英国的 First Minute Capital 和 LocalGlobe 也都参与其中。法国投资银行 Bpifrance 和谷歌前首席执行官Eric Schmidt也是股东。接近该公司的消息人士证实,种子轮融资金额为 1.05亿欧元的融资,Mistral AI 的估值达到 2.4 亿欧元,股东占比接近 50%。

Andreessen Horowitz(a16z)领导了最近的融资轮次,Lightspeed Venture Partners再次投资这家AI公司。此外,还有一长串投资者参与了这轮投资,如Salesforce、BNP Paribas、CMA-CGM、General Catalyst、Elad Gil和Conviction。

“自从今年5月份创建Mistral AI以来,Mistral AI一直在追求一个明确的轨迹:创建一个基于开放、负责任和分散化技术方法的全球性生成人工智能的欧洲冠军,”Mistral AI的联合创始人兼CEO Arthur Mensch在一份声明中说。

三、Mistral AI在塑造欧盟AI法案讨论中发挥了重要作用

九月份,Mistral AI发布了其第一个模型,名为Mistral 7B。这个大型语言模型并不是直接与GPT-4或Claude 2竞争,因为它是在一个“小”数据集上进行训练的,大约有70亿个参数作为标记。

Mistral AI没有通过APIs开放对Mistral 7B模型的访问,而是将其作为免费下载提供给开发者,让他们可以在自己的设备和服务器上运行。

该模型是在Apache 2.0许可证下发布的,这是一个开源许可证,除了归属权之外没有对使用或复制的限制。虽然任何人都可以运行该模型,但它是在封闭的门后,使用专有的和未公开的数据集开发的。

Mistral AI在塑造欧盟的AI法案讨论中也发挥了重要的作用。这家法国AI初创公司一直在为基础模型争取完全豁免,认为规定应适用于使用案例和直接为最终用户提供产品的公司。

欧盟立法者就在几天前达成了一项政治协议。从事基础模型工作的公司将面临一些透明度要求,并必须分享技术文档和数据集摘要。

四、Mistral AI最好的模型现在只能通过API访问

Mistral AI仍计划从其基础模型中赚钱。这就是为什么Mistral AI今天在测试阶段开放其开发者平台。有了这个平台,其他公司将能够通过APIs付费使用Mistral AI的模型。

除了Mistral 7B模型(“Mistral-tiny”),开发者还将能够访问新的Mixtral 8x7B模型(“Mistral-small”)。该模型使用“路由器网络”处理输入标记,并选择最合适的参数组给出答案。

“这种技术增加了模型的参数数量,同时控制成本和延迟,因为模型每个标记只使用总参数集的一部分。具体来说,Mixtral有450亿个总参数,但每个标记只使用120亿个参数。因此,它以同样的速度和成本处理输入并生成输出,就像一个120亿的模型一样,”该公司在一篇博客文章中写道。

Mixtral 8x7B也是在Apache 2.0许可证下发布的,并作为免费下载提供。第三个模型,Mistral-medium,可以在Mistral的开发者平台上找到。据说它比Mistral AI的其他模型表现得更好,只能通过付费API平台获取——没有下载链接可用。

五、Mistral AI发布 Mixtral 8x7B 专家混合模型

随着人工智能的不断前进,Mistral AI需要超越重复使用已知架构和训练范式,采取新的技术路径。更重要的是,它需要让社区从原创模型中受益,以促进新的发明和用途。

Mistral AI团队发布了Mixtral 8x7B,这是一个高质量的专家混合模型(SMoE),具有开放的权重,遵循Apache 2.0许可证。Mixtral在大多数基准测试中的表现超过了Llama 2 70B,并且推理速度快6倍。它是具有宽松许可证的最强大的开放权重模型,也是在成本/性能权衡方面表现最佳的模型。特别是,在大多数标准基准测试中,它的表现匹配或超过了GPT3.5,并且具有 12B 密集模型的推理速度。它支持 32k 令牌的上下文长度。

Mixtral 具有与 Mistral 7B 类似的架构,不同之处在于每层由 8 个前馈块组成。对于每个令牌,在每一层,路由器网络都会选择两名专家来处理当前状态并组合他们的输出。

尽管每个令牌只看到两个专家,但所选的专家在每个时间步长都可能不同。因此,Mixtral 以 12B 模型的速度进行解码,同时有效地访问 45B 参数。

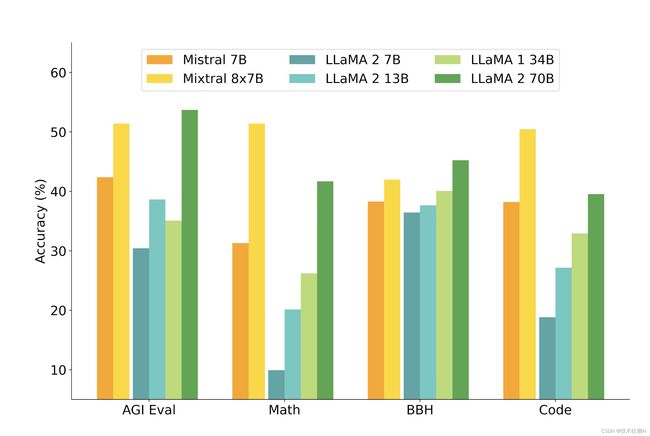

与 Mistral 7B 相比,Mixtral 在科学方面明显更强,特别是在数学和代码生成方面。

Mixtral具有以下能力:

- 它可以优雅地处理32k令牌的上下文。

- 它支持英语、法语、意大利语、德语和西班牙语。

- 在代码生成方面表现强劲。

- 它可以被微调成一个指令跟随模型,在MT-Bench上达到8.3的评分。

Mixtral 是一个专家混合模型。它是一个纯解码器模型,其中前馈块从一组 8 个不同的参数组中进行选择。在每一层,对于每个令牌,路由器网络选择其中的两个组(“专家”)来处理令牌并相加地组合它们的输出。

这种技术在控制成本和延迟的同时增加了模型的参数数量,因为模型每个令牌只使用总参数集的一小部分。具体来说,Mixtral有46.7B的总参数,但每个令牌只使用12.9B的参数。因此,它以相同的速度和成本处理输入和生成输出,就像一个12.9B模型一样。

5.1、性能

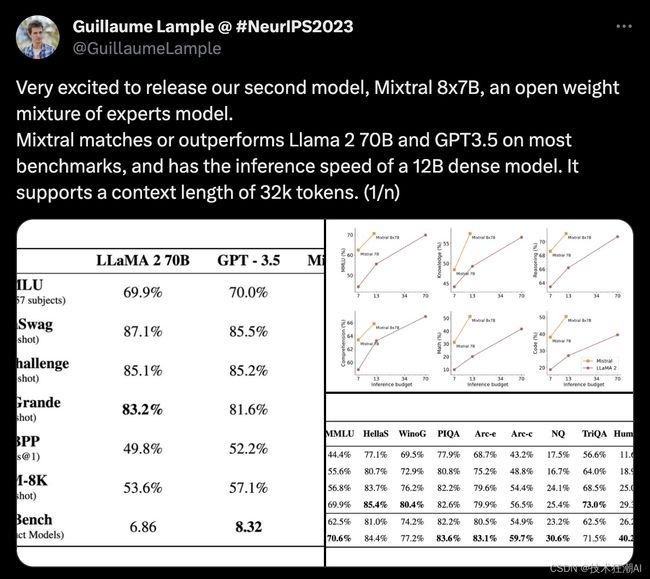

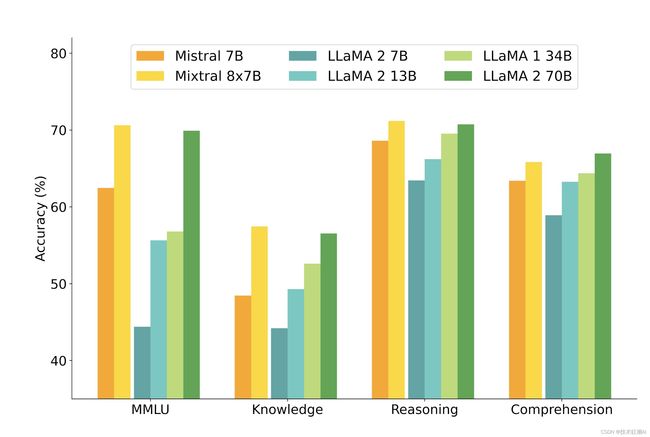

Mistral AI将Mixtral与Llama 2系列和GPT3.5基础模型进行比较。在大多数基准测试中,Mixtral的表现匹配或超过了Llama 2 70B以及GPT3.5。

在下图中,我们衡量了质量与推理预算之间的权衡。Mistral 7B和Mixtral 8x7B属于与Llama 2模型相比效率极高的模型家族。

下表详细展示了上图中的结果。

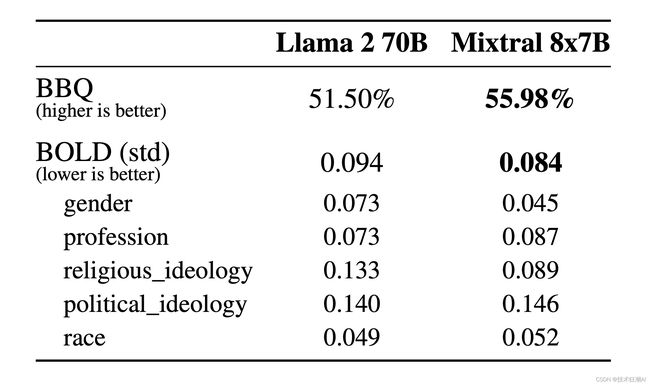

幻觉和偏见。为了识别可能需要通过微调/偏好建模来纠正的缺陷,Mistral AI测量了基础模型在TruthfulQA/BBQ/BOLD上的性能。

与Llama 2相比,Mixtral在TruthfulQA基准测试上更真实(73.9%对比50.2%),并在BBQ基准测试上呈现出更少的偏见。总体而言,在BOLD上Mixtral显示出比Llama 2更积极的情绪,每个维度内的变异性类似。

Mixtral 8x7B精通法语、德语、西班牙语、意大利语和英语。

5.2、指导模型

Mistral AI与Mixtral 8x7B一起发布了Mixtral 8x7B Instruct。通过监督式微调和直接偏好优化(DPO),该模型已被优化以精确遵循指令。在MT-Bench上,它达到了8.30的评分,使其成为最佳开源模型,并且其性能与GPT3.5相当。

注意:Mixtral可以被优雅地提示禁止某些输出,以构建需要强烈审查水平的应用程序,如此处所示。适当的偏好调整也可以达到这个目的。请记住,如果没有这样的提示,模型将只会遵循给定的任何指令。

5.3、使用开源部署栈部署Mixtral

为了使社区能够使用完全开源的栈运行Mixtral,Mistral AI已经向vLLM项目提交了更改,该项目集成了Megablocks CUDA内核以实现高效推理。

Skypilot允许在云中的任何实例上部署vLLM端点。

5.4、在Mistral AI的平台上使用Mixtral

目前Mistral AI正在使用Mixtral 8x7B来支持端点mistral-small,该端点目前处于beta测试阶段。注册即可提前访问所有生成和嵌入端点。

六、总结

Mistral AI在AI领域取得了双重突破,完成了4.15亿美元的融资,并发布了革命性的Mixtral 8x7B专家混合模型。这一模型不仅推动了技术的创新边界,还为开发者社区提供了前所未有的资源。Mixtral 8x7B以其卓越的性能和成本效益比,在AI基准测试中超越了现有模型,同时保持了对开发者友好的Apache 2.0许可证,确保了其广泛的可接入性和应用潜力。Mistral AI的这一成就标志着它在推动AI技术民主化方面迈出了坚实的一步。

七、References

[1]. Mixtral 8x7B: https://mistral.ai/news/mixtral-of-experts/

[2]. Mixtral-8x7B HF: https://huggingface.co/mistralai/Mixtral-8x7B-v0.1

[3]. Mistral vs GPT-3.5 Playground: https://sdk.vercel.ai/