某期货机构以超融合构建 CTP 主席期货交易系统云底座(附验证数据)

作者:深耕行业的 SmartX 金融团队 陈俊洁

CTP(Comprehensive Transaction Platform)是国内期货行业主流使用的期货交易系统,能够在帮助期货机构处理日常交易与结算的同时,提供实时的风险监控。作为核心交易系统,CTP 对延迟极为敏感,这就要求 IT 基础架构能够提供高性能、低延迟、高可用的支持。

近期,某期货机构使用 SmartX 超融合开展数据中心云化转型实践,以超融合架构支撑包括 CTP 主席期货交易系统在内的全部业务,并对基于超融合的 CTP 系统开展了一系列性能测试。我们将通过这篇文章,分享客户的转型经验与测试结果,为有需求的读者提供参考。

更多金融行业应用场景探索实践,欢迎阅读文末电子书《金融核心生产业务场景探索文章合集(更新版)》。

项目背景

某期货机构数据中心原使用物理机支撑 CTP 期货交易系统,在开展数据中心异地搬迁过程中,发现传统架构弊病凸显:扩展能力差、物理设备难以调整、存储存在单点故障风险、操作系统版本过低、数据安全风险较高……这些都为数据中心的整体迁移和重新构建带来不小的阻碍。

因此,对于新建机房,客户计划开展 IT 基础架构云化转型,以提升资源交付效率和整体利用率,缩短故障恢复时间,降低运维和管理成本。考虑到超融合已具备成熟的技术栈和广泛的业内应用案例,而 SmartX 超融合在产品能力和金融行业落地经验上均处于业内领先水平,客户最终决定以 SmartX 超融合作为新数据中心云底座,同时通过实际测试验证超融合对 CTP 交易系统的支持能力。

数据中心云化转型实践

项目规划

计算与存储资源转化

资源规划是整个云化转型项目的第一步,我们需要将原先的物理机资源转换为虚拟机配置:

- 原有配置梳理:梳理原有服务器硬件配置及各模块组件在服务器上的部署方式。

- 资源规划:考虑到虚拟化环境的资源征用及虚拟化带来的资源开销,计算资源按照原配置的 2 倍资源进行规划,存储资源按照 500G 和 1T 进行规划。

- 资源汇总:汇总计算资源及存储资源总量。

- 配置规划:为充分利用服务器资源,内存磁盘均按照满配的方式进行规划。考虑到后期核心业务场景的性能需求,本次规划对服务器硬盘全部采用了全闪磁盘;考虑到故障冗余、未来资源增长需求,折算所需节点数量时也有所预留。最后根据资源总量,结合以上考虑,折算所需节点数量、服务器配置和虚拟机配置。

网络配置转化

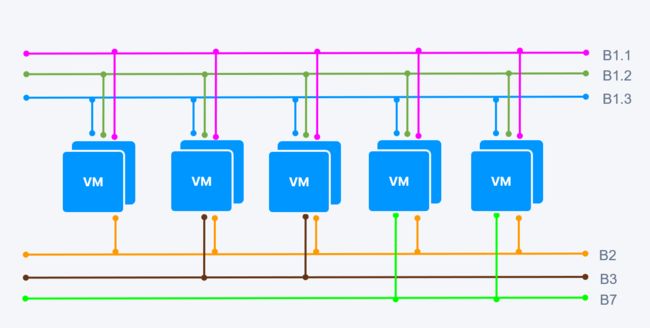

网络方面,为实现 CTP 网络系统的高性能、易扩展、易伸缩、容错以及一排座的设计目标,依据系统不同的通讯阶段对各个子网进行物理划分和隔离,总共分出 10 个网络。

注:图片仅选取部分 VM 进行展示,全部网络划分包括:B1.1 交易核心网 1、B1.2 交易核心网 2、B1.3 系统管理网、B2 仲裁网、B3 数据库网、B7 报盘核心网、B8 风控网、S1 交易前置网、S2 报盘前置网、S3 银期前置网。

整体架构

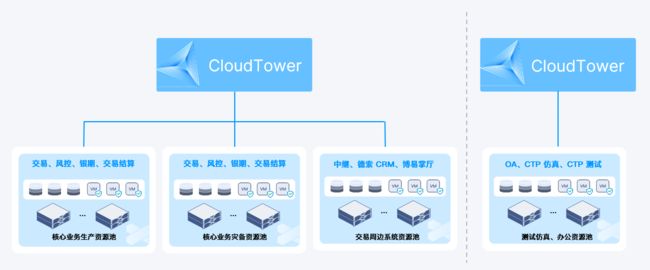

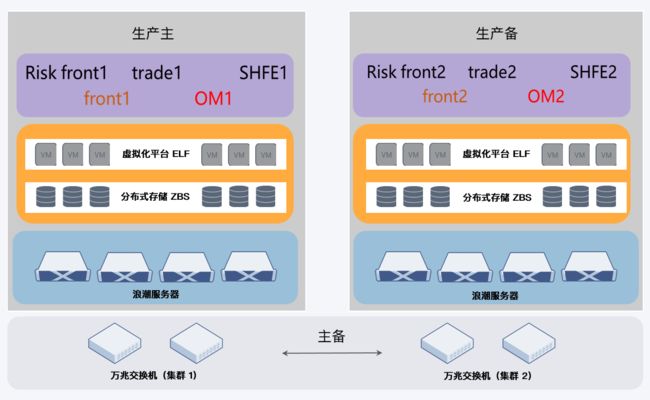

最终,客户使用 SmartX 超融合构建了 4 个集群、15 个节点,承载新建数据中心的所有业务,包括全套 CTP 主席期货交易系统、开发测试和数据库。在整套环境中运行的虚拟机数量超过 200 个,CPU 总共 480 核,内存近 30 TiB,存储空间达 623 TiB。

4 个集群包括 3 个生产集群以及 1 个办公集群,其中生产集群为 4 节点的集群,办公集群为 3 节点的集群。

- 集群 1 – 核心业务系统:CTP 席期货交易系统及组件 (交易、风控、银期、交易结算)。

- 集群 2 – 核心业务系统的灾备集群:业务同上。

- 集群 3 – CTP 外围系统:文华、博易、同花顺、中继、德索 CRM、博易掌厅。

- 集群 4 – 办公测试系统:文件服务器、OA、CTP 仿真、CTP 测试、办公应用。

可以看到,生产环境中核心交易系统配置了主集群和备集群,这是因为客户希望在应用冗余的基础上,再通过基础架构层面的冗余,进一步保证数据安全和业务的连续性,预防系统层面的风险。由于办公跟生产网络之间存在物理隔离,生产环境的三个集群由统一的 CloudTower 平台进行管理,办公集群则进行单独管理。

以上 4 个集群,SmartX 仅用时两天就完成了部署与交付,进一步体现了超融合架构的敏捷、快速交付能力。

SmartX 超融合支持 CTP 交易系统能力验证

测试场景

为了验证 SmartX 超融合对 CTP 主席期货交易系统的支持能力,客户通过以下 4 个场景进行了性能测试:

- 常规压力测试:在常规业务量情况下观察系统运行表现。

- 大压力场景测试:在大量业务压力的情况下观察 CTP 系统运行表现。

- 冗余场景测试:包含业务系统冗余、硬件冗余、网络冗余等方面的验证。

- CTP 穿透延迟场景测试:验证 CTP 系统单向报单所需时间和延迟情况。

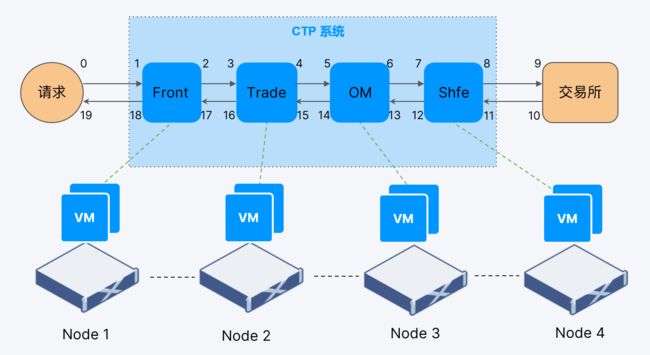

本次测试均采用上期所压力测试工具(AutoTest Platform-V1.2.3),系统流程为:压力测试工具 – Front – Trade – 报盘管理(OM)- SHFE – 交易所,再由交易所返回。

测试过程与结果

场景一:常规压力测试

测试步骤:

- 运行上期所压力测试工具(AutoTest Platform-V1.2.3)。

- 测试参数为 1 个用户、每秒 1 万笔订单(即每秒 1 万报单),持续运行 30 分钟。该参数基于客户所在地区行业情况设定。

- 记录任务执行过程中资源的消耗和使用情况。

测试结果:

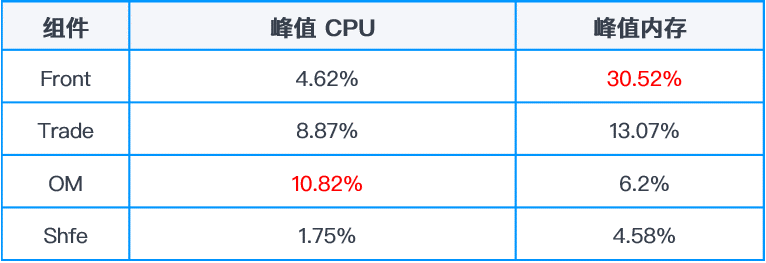

- CPU、内存、IOPS 均未到达系统上限,系统承载能力完全满足要求。

- CTP 报单流转正常。

从测试结果来看, CTP 的各个主机都未达到性能瓶颈。可以看到,内存最高的 Front 组件,其内存峰值也才不到 31%, CPU 峰值最高的是报盘管理,也不到 11%,可见总体 CPU、内存使用量还是很少的。由于常规压力测试下没有出现性能瓶颈的情况,我们就进一步增大了测试压力。

场景二:高压场景测试

测试步骤:

- 运行上期所压力测试工具(AutoTest Platform-V1.2.3)。

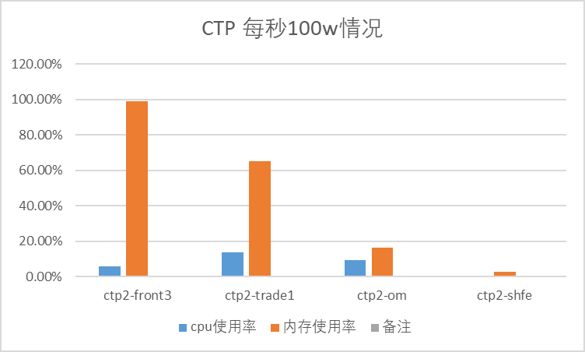

- 测试参数为 5 个用户、每秒 20 万笔订单(相当于每秒 100 万报单),持续运行 30 分钟。

测试结果:

- CTP 系统持续运行正常。

在高压力场景下,CTP 系统依旧正常运行,其中 Front 的内存使用率达到了 98%,Trade 模块的内存使用率达到了 65%,其他组件的内存使用率都比较低, 在 20% 以下。在做整个机房规划时,用户预期 CTP 业务系统每秒只需要承载 2000 笔的报单。从目前的验证情况来看,当前环境的业务能力远超预期。

场景三:冗余场景测试

如前文所述,生产环境在基础架构层面进行了冗余保护:用户使用 4 台核心交换机,其中 2 台交换机做为 1 个集群,在 2 个交换机集群之间做一个主备,每台服务器使用 4 个网口连到 4 台交换机的 4 个端口提供业务端口的冗余。在虚拟机层面,CTP 业务也分别放在 2 个集群上运行。

为了验证该冗余架构的可靠性,我们在“一个用户、每秒 5 笔报单”的条件下进行了测试,过程中依次关闭了 Front、Trade 模块、OM、数据库和报盘,测试切换情况。之后我们对 Trade 模块所在的物理服务器采取直接断电的操作,以验证单个服务器节点故障的情况下冗余架构的表现。我们也对网络的冗余进行了验证,将主集群的两台核心交换机同时断电进行验证测试。

测试发现,除了以下两种情况,其他情况下业务系统都达到了冗余:

- 众多组件中,当 Front 宕机时,需要终端用户手动切换 Front 进行重新连接。

- OM 在当前客户环境中使用了冷备,当 OM 主宕机时,需要人工切换到备机上,切换时间约 15 秒。

场景四:CTP 穿透延迟场景测试

CTP 穿透即用户请求经过图中浅蓝色框里的 CTP 组件,来到交易所,再由交易所返回到用户的一个过程。这项测试旨在了解 CTP 系统单向报单(图中 1-8)的延迟情况。其中,用户端到 Front(0-1)的网络链路延迟,以及从最后的报盘到交易所(8-9)的时间不包含在测试时间内,原因是用户端到 Front 的网络延迟主要由用户端的接入网络决定,而机房到交易所之间的延迟则主要由数据中心到交易所的专线决定,因此不在测试考察范围内。

测试发现,超融合架构下 CTP 系统单向报单延迟时间是 0.615 ms,优于原先物理环境的 0.9 ms。此前客户担心,由于虚拟化比物理机多一层软件,网络交换会有很大的消耗,导致整个报单时间的延长。这一测试结果直接让客户打消了这种疑虑。

业务切换与转型成果

经过上述测试,客户对 SmartX 超融合支撑的 CTP 交易系统性能表现非常满意,随即决定开展业务切换。测试与切换过程大致如下:

- 保证老环境正常运行的情况下,在新集群内将所有业务模块拉起,空跑运行(无实际用户交易),通过 2 周试运行验证架构稳定性。

- 将用户的部分业务切换至新系统中运行(开展交易),验证全流程的联通性,试运行 2 周。

- 经过以上验证,确保环境稳定、业务流转正常,最终完成新、老环境的正式切换。

自 7 月份业务系统切换至新数据中心至今,整套 CTP 业务系统运行状态稳定,客户体验良好。从虚拟机层面观察 CPU 和内存使用率,均维持在个位数水平。服务器主机层面 CPU 使用率维持在 15% 以下,内存平均使用率维持在 30% 以下,充分满足业务需求。

客户收益

总体来看,通过本次新数据中心 IT 基础架构云化转型,客户不仅收获了更现代化的基础设施,还通过以下方面的提升,助力业务敏捷发展:

- 效率提升:超融合架构将资源融合在一个统一的硬件平台上,方便管理,提高性能,降低成本。在金融行业,尤其是在期货市场中,利用超融合的技术优势将极大地提升业务运营效率。

- 稳定性提升:超融合技术的高可用性、容错性和自愈能力,使 CTP 期货交易系统能够在任何可能发生故障的环节都能快速自我恢复,保障交易的正常进行。

- 降低成本:通过将计算、存储和网络集成到单一的硬件平台,CTP 期货交易系统不再需要专用的硬件,并且系统管理的复杂性也大大降低,从而节省了大量的资源投入与运维成本。

- 敏捷架构:云计算和大数据时代的来临,要求企业 IT 系统能够快速跟上业务需求。超融合让系统的扩展更加灵活,客户只需购买标准硬件,就可以快速地实现 IT 系统的弹性扩展。

除了 CTP 交易系统,SmartX 还联合多家来自银行、保险、证券、基金、期货、资管等金融细分行业的头部企业,针对超融合在 TA 注册登记、估值、BI 报表、O32、柜台交易系统等多种金融核心业务系统下的表现,开展全方位评测与验证。欲了解更多金融行业应用场景探索实践,一键获取《金融核心生产业务场景探索文章合集》。