GBDT算法原理以及实例理解

转载自:

GBDT算法原理以及实例理解(含Python代码简单实现版)-CSDN博客

一、算法简介:

GBDT 的全称是 Gradient Boosting Decision Tree,梯度提升树,在传统机器学习算法中,GBDT算的上是TOP前三的算法。

想要理解GBDT的真正意义,那就必须理解GBDT中的Gradient Boosting和Decision Tree分别是什么?

1. Decision Tree:CART回归树

首先,GBDT使用的决策树是CART回归树,无论是处理回归问题还是二分类以及多分类,GBDT使用的决策树通通都是都是CART回归树。

为什么不用CART分类树呢?因为GBDT每次迭代要拟合的是梯度值,是连续值所以要用回归树。

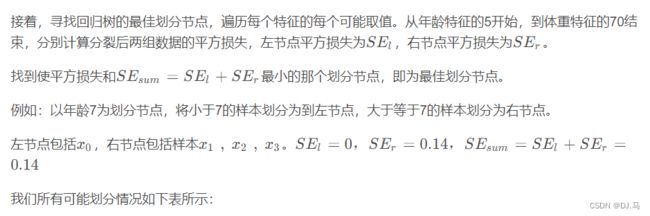

对于回归树算法来说最重要的是寻找最佳的划分点,那么回归树中的可划分点包含了所有特征的所有可取的值。

在分类树中最佳划分点的判别标准是熵或者基尼系数,都是用纯度来衡量的,但是在回归树中的样本标签是连续数值,所以再使用熵之类的指标不再合适,取而代之的是平方误差,它能很好的评判拟合程度。

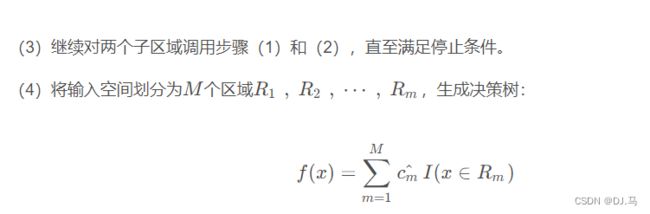

2.回归树生成算法:

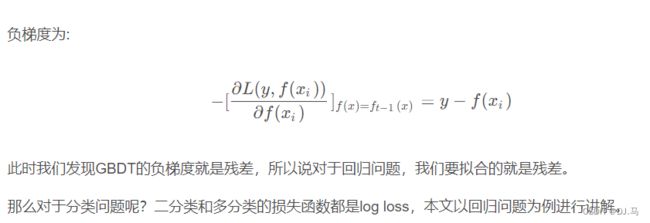

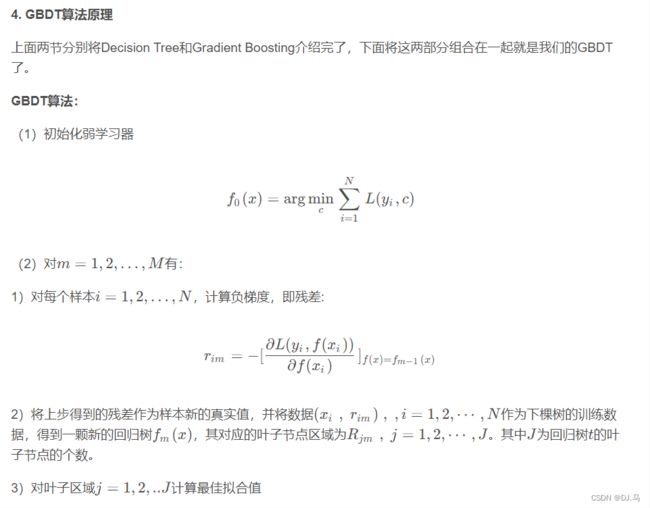

3. Gradient Boosting:拟合负梯度

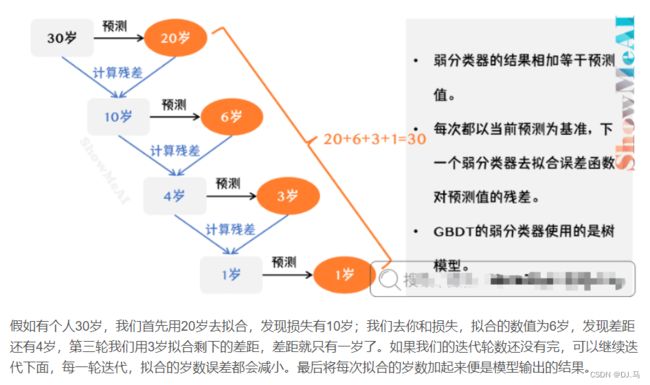

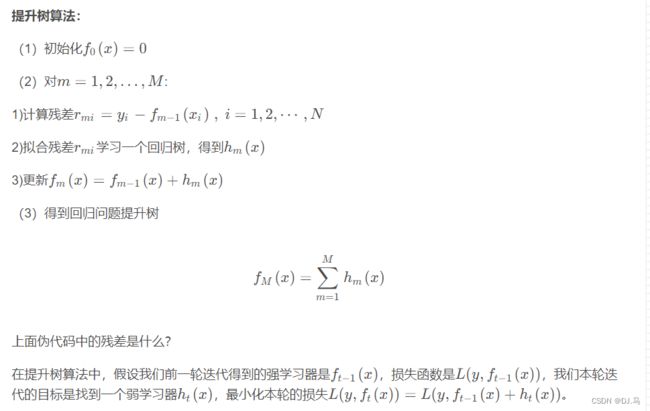

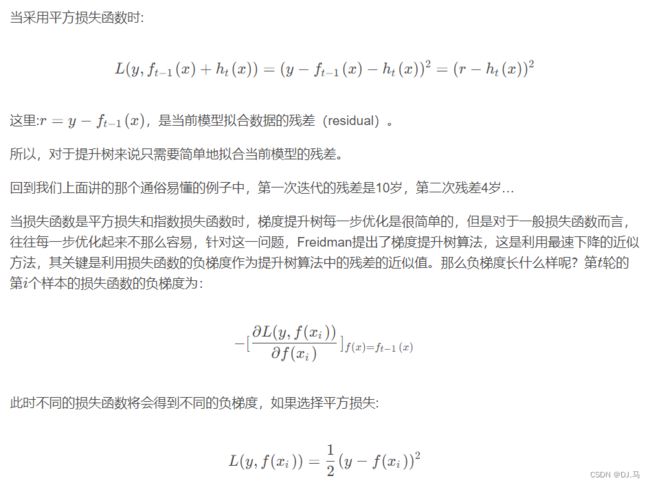

梯度提升树(Grandient Boosting)是提升树(Boosting Tree)的一种改进算法,所以在讲梯度提升树之前先来说一下提升树。

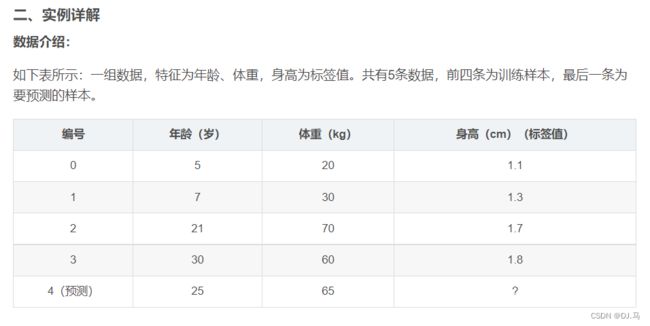

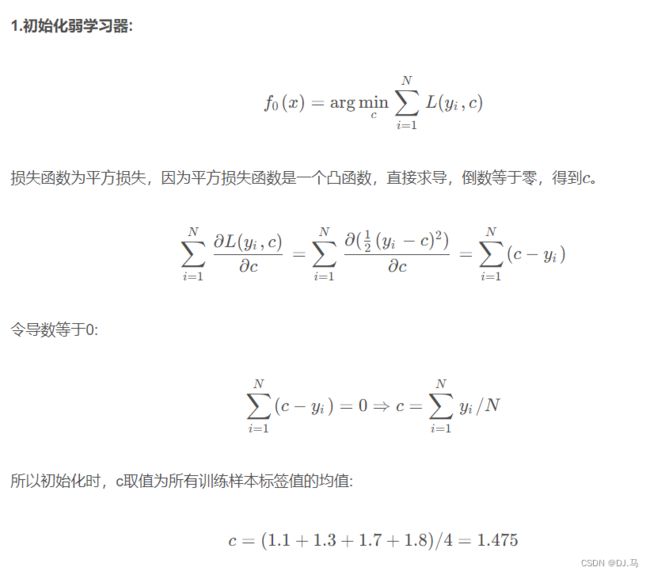

我们用上一篇文章的例子来理解:

训练阶段:

参数设置:

学习率:learning_rate=0.1

迭代次数:n_trees=5

树的深度:max_depth=3

from sklearn.tree import DecisionTreeRegressor

import numpy as np

from sklearn.ensemble import GradientBoostingRegressor

import pandas as pd

import pydotplus

from pydotplus import graph_from_dot_data

from sklearn.tree import export_graphviz

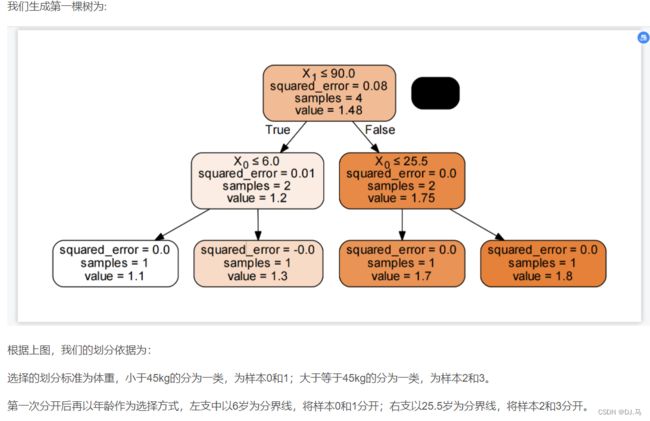

data_1=[[5,40,1.1],[7,60,1.3],[21,140,1.7],[30,120,1.8]]

data=pd.DataFrame(data_1,columns=['age','weight','标签'])

X=np.array(data.iloc[:,:-1]).reshape((-1,2))

y=np.array(data.iloc[:,-1]).reshape((-1,1))

tree_reg1 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg1.fit(X, y)

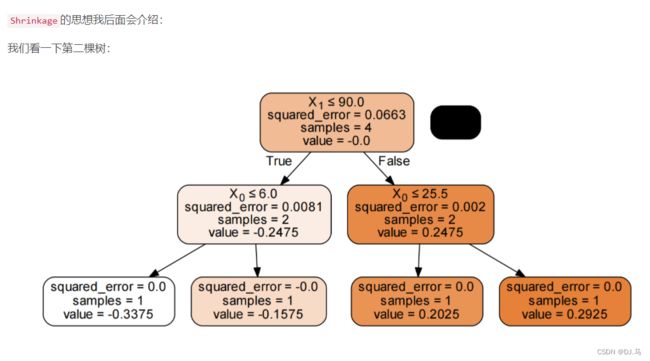

y2 = y - np.array([1.475]*4).reshape((-1,1))

tree_reg2 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg2.fit(X, y2)

y3 = y2 - 0.1*np.array(tree_reg2.predict(X)).reshape((-1,1))

tree_reg3 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg3.fit(X, y3)

y4 = y3 - 0.1*np.array(tree_reg3.predict(X)).reshape((-1,1))

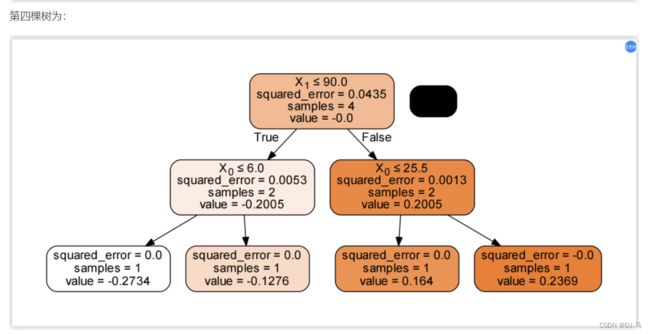

tree_reg4 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg4.fit(X, y4)

y5 = y4 - 0.1*np.array(tree_reg4.predict(X)).reshape((-1,1))

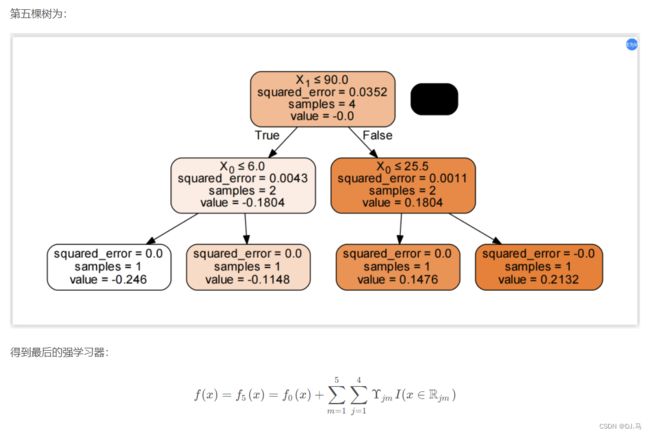

tree_reg5 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg5.fit(X, y5)

y6 = y5 - 0.1*np.array(tree_reg5.predict(X)).reshape((-1,1))

tree_reg6 = DecisionTreeRegressor(max_depth=4,random_state=10)

tree_reg6.fit(X, y6)

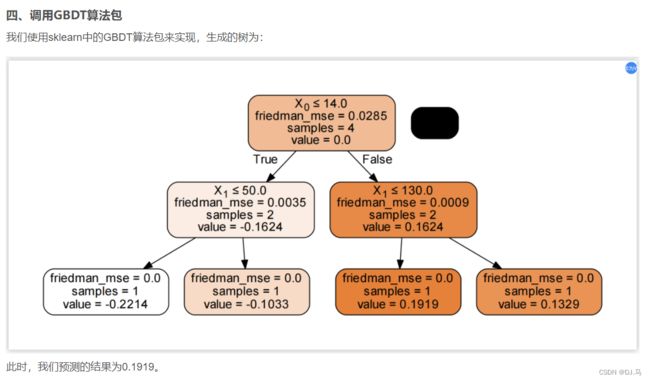

estimator=GradientBoostingRegressor(random_state=10)

estimator.fit(data.iloc[:,:-1],data.iloc[:,-1])

dot_data = export_graphviz(estimator.estimators_[5,0], out_file=None, filled=True, rounded=True, special_characters=True, precision=4)

graph = pydotplus.graph_from_dot_data(dot_data)

graph.write_pdf('estimator.pdf')