Multimodal Chain-of-Thought Reasoning in Language Models语言模型中的多模态思维链推理

Abstract

大型语言模型 (LLM) 通过利用思维链 (CoT) 提示生成中间推理链作为推断答案的基本原理,在复杂推理方面表现出了令人印象深刻的性能。然而,现有的 CoT 研究主要集中在语言情态上。我们提出了 Multimodal-CoT,它将语言(文本)和视觉(图像)模态合并到一个两阶段框架中,将基本原理生成和答案推理分开。 通过这种方式,答案推理可以更好地利用基于多模态信息生成的基本原理。 借助 Multimodal-CoT,我们的模型在 10 亿个参数下的性能比之前最先进的 LLM (GPT-3.5) 提高了 16 个百分点 (75.17%)→ 91.68%的精度)甚至超过了ScienceQA基准的人类表现。 代码已公开。1

1介绍

想象一下阅读一本没有图表的教科书。通过对视觉、语言和音频等多种数据模式进行联合建模,我们获取知识的能力得到了极大的增强。最近,大型语言模型 (LLM) (Brown 等人,2020年;托皮兰等人,2022年;雷伊等人,2021年;乔杜里等人,2022年)通过在推断答案之前生成中间推理步骤,在复杂的推理中表现出了令人印象深刻的表现。这种有趣的技术称为思想链 (CoT) 推理(Wei 等人,2022b;小岛等人,2022年;张等人,2022年)。

但是,与 CoT 推理相关的现有研究很大程度上孤立于语言模态(Wang 等人,2022b;周等人,2022年;卢等人,2022b; Fu等人,2022年),几乎没有考虑多模式方案。为了引发多模态中的 CoT 推理,我们提倡 Multimodal-CoT 范式。给定不同模态的输入,Multimodal-CoT 将多步骤问题分解为中间推理步骤(基本原理),然后推断答案。由于视觉和语言是最流行的模式,因此我们在这项工作中重点关注这两种模式。图 1 显示了一个示例。一般来说,有两种方法可以引发 Multimodal-CoT 推理:(i) 提示 LLM 和 (ii) 微调小模型。2

图1:多模式COT任务的示例。

执行Multimodal-CoT的最直接方法是将不同模态的输入转换为一种模态并提示LLM执行CoT。例如,可以通过字幕模型提取图像的字幕,然后将字幕与原始语言输入连接起来,输入到 LLM (Lu 等人,2022a)。然而,字幕过程中存在严重的信息丢失;因此,使用字幕(相对于视觉特征)可能会因不同模态的表示空间中缺乏相互协同作用而受到影响。

表格1:典型的 CoT 技术(FT:微调;KD:知识蒸馏)。第 1 部分:情境学习技巧;第 2 部分:微调技术。据我们所知,我们的工作是第一个以不同方式研究 CoT 推理的工作。此外,我们专注于 1B 模型,而不依赖于法学硕士的输出。

| 楷模 | 多式联运 | 无法学硕士 | 型号/发动机 | 训练 | 成本角色 | 成本来源 |

|---|---|---|---|---|---|---|

| 零射击 CoT (Kojima 等人, 2022年) | ✗ | ✗ | GPT-3.5 (175B) | ICL | 推理 | 模板 |

| Few-Shot-CoT (Wei 等人, 2022b) | ✗ | ✗ | 帕LM (540B) | ICL | 推理 | 手工制作 |

| self-contistency-cot ( Wang等人。2022a) | ✗ | ✗ | 法典 (175B) | ICL | 推理 | 手工制作 |

| 从最少到最多的提示 (Zhou 等人, 2022年) | ✗ | ✗ | 法典 (175B) | ICL | 推理 | 手工制作 |

| 检索 ( Zhang等人。,2022年) | ✗ | ✗ | GPT-3.5 (175B) | ICL | 推理 | 自动生成 |

| PromptPG-CoT (Lu 等人, 2022b) | ✗ | ✗ | GPT-3.5 (175B) | ICL | 推理 | 手工制作 |

| Auto-CoT (Zhang 等人, 2022年) | ✗ | ✗ | 法典 (175B) | ICL | 推理 | 自动生成 |

| 复杂性-CoT (Fu 等人, 2022年) | ✗ | ✗ | GPT-3.5 (175B) | ICL | 推理 | 手工制作 |

| Few-Shot-PoT (Chen 等人, 2022年) | ✗ | ✗ | GPT-3.5 (175B) | ICL | 推理 | 手工制作 |

| UnifiedQA (Lu 等人, 2022a) | ✗ | ✓ | T5(770M) | 金融时报 | 解释 | 爬行 |

| 微调 T5 XXL (Magister 等人, 2022年) | ✗ | ✗ | T5(11B) | 肯德基 | 推理 | LLM生成 |

| Fine-Tune-CoT (Ho 等人, 2022年) | ✗ | ✗ | GPT-3 (6.7B) | 肯德基 | 推理 | LLM生成 |

| 多式联运-CoT(我们的工作) | ✓ | ✓ | T5(770M) | 金融时报 | 推理 | 爬行 |

为了促进模态之间的交互,另一个潜在的解决方案是通过融合多模态特征来微调较小的语言模型 (LM)(Zhang 等人,2023年)。由于这种方法允许灵活地调整模型架构以合并多模态特征,因此我们在这项工作中研究微调模型,而不是提示法学硕士。关键的挑战是 1000 亿个参数下的语言模型往往会产生幻觉的基本原理,从而误导答案推断(Ho 等人,2022年;马吉斯特等人,2022年;吉等人,2022年)。

为了减轻幻觉的挑战,我们提出了 Multimodal-CoT,它将语言(文本)和视觉(图像)模态合并到一个两阶段框架中,将基本原理生成和答案推理分开。 通过这种方式,答案推理可以更好地利用基于多模态信息生成的基本原理。 我们的实验是在 ScienceQA 基准测试上进行的(Lu 等人,2022a),这是带有注释推理链的最新多模态推理基准。实验结果表明,我们的方法超越了之前最先进的 GPT-3.5 模型 +16%(75.17%→基准为91.68%)。我们的贡献总结如下:

(i) 据我们所知,这项工作是第一个以不同方式研究 CoT 推理的工作。

(ii) 我们提出了一个两阶段框架,通过微调语言模型来融合视觉和语言表示来执行 Multimodal-CoT。该模型能够生成信息丰富的基本原理,以方便推断最终答案。

(iii) 我们的方法在 ScienceQA 基准上实现了新的最先进的性能,比 GPT-3.5 的准确性高出 16%,甚至超过了人类的表现。

2背景

本节回顾了通过提示和微调语言模型来引发 CoT 推理的最新进展。

2.1使用LLM的COT推理

最近,CoT 已被广泛用于激发法学硕士的多步推理能力(Wei 等人,2022b)。具体来说,CoT 技术鼓励法学硕士生成中间推理链来解决问题。研究表明,法学硕士可以使用两种主要的技术范式进行 CoT 推理:零射击 CoT (Kojima 等人,2022年)和几个射击(Wei等人,2022b;张等人,2022年)。对于零射击 CoT,Kojima 等人。 (2022年) 通过在测试问题后添加“让我们一步一步思考”之类的提示来调用 CoT 推理,表明 LLM 是不错的零样本推理机。对于Few-Shot-CoT,使用一些逐步的推理演示作为推理的条件。每个演示都有一个问题和一个导致最终答案的推理链。演示通常是通过手工制作或自动生成获得的。因此,相应的技术被称为 Manual-CoT (Wei 等人,2022b) 和 Auto-CoT (Zhang 等人,2022年)。

通过有效的演示,Few-Shot-CoT 往往能取得比 Zero-Shot-CoT 更强的性能,并吸引了更多的研究兴趣。因此,最近的研究主要集中在如何改进Few-Shot-CoT。这些研究分为两个主要研究方向:(i)优化演示; (ii) 优化推理链。表1比较了典型的 CoT 技术。

优化演示

Few-Shot-CoT 的性能依赖于演示的质量。正如 Wei 等人报道的那样。 (2022b),使用不同注释者编写的演示会导致符号推理任务中出现巨大的准确性差异。除了手工制作演示外,最近的研究还研究了优化演示选择过程的方法。值得注意的是,Rubin 等人。 (2022年) 检索了与测试实例语义相似的演示。然而,当推理链中出现错误时,这种方法会表现出性能下降(Zhang 等人,2022年)。为了解决这一限制,Zhang 等人。 (2022年)发现关键是演示问题的多样性,并提出了 Auto-CoT:(i) 将给定数据集的问题划分为几个集群; (ii) 从每个集群中采样一个代表性问题,并使用带有简单启发式的 Zero-Shot-CoT 生成其推理链。此外,还提出了强化学习(RL)和基于复杂性的选择策略以获得有效的演示。 Fu 等人。 (2022年)选择了推理链复杂(即推理步骤较多)的例子作为演示。 Lu 等人。 (2022b)培训了一个代理商,从候选池中找到最佳的文本示例,并在与GPT-3.5互动时在给定培训示例中最大化预测奖励。

优化推理链

优化推理链的一种值得注意的方法是问题分解。 周等人。 (2022年)提出了从最小到最大的提示,将复杂问题分解为子问题,然后依次解决这些子问题。因此,先前解决的子问题的答案有助于解决给定的子问题。同样,Khot 等人。 (2022年)使用不同的分解结构并设计不同的提示来回答每个子问题。除了以自然语言文本提示推理链之外,Chen 等人。 (2022年) 提出了思维程序 (PoT),它将推理过程建模为程序,并提示法学硕士通过执行生成的程序来得出答案。另一个趋势是对测试问题的多个推理路径进行投票。 王等人。 (2022a) 引入了一种自一致性解码策略来对 LLM 的多个输出进行采样,然后获得最终答案的多数。 王等人。 (2022b) 和 Li 等人。 (2022b)在输入空间中引入随机性,以产生更多样化的投票输出。

2.2通过微调模型引发 CoT 推理

最近的一个兴趣是通过微调语言模型来引发 CoT 推理。 Lu 等人。 (2022a) 使用 CoT 注释在大规模数据集上微调编码器-解码器 T5 模型。然而,当使用 CoT 来推断答案时,即在答案之前生成推理链(推理)时,会观察到性能急剧下降。相反,CoT 仅用作答案后的解释。 Magister 等人。 (2022年) 和 Ho 等人。 (2022年) 通过根据较大的教师模型生成的思想链输出对学生模型进行微调,从而采用知识蒸馏。所提出的方法在算术、常识和符号推理任务中显示出性能提升。

将 1B 模型训练为 CoT 推理器存在一个关键挑战。正如 Wei 等人所观察到的。 (2022b),低于1000亿个参数的模型往往会产生不合逻辑的婴儿,从而导致错误的答案。换句话说,比直接生成答案,1B模型生成有效的COT可能更难。在多模式环境中,回答问题还需要了解多模式输入的情况变得更加具有挑战性。在下一部分中,我们将探讨多模式-COT的挑战,并研究如何执行有效的多步推理。

3多模式-COT的挑战

现有研究表明,CoT 推理能力可能会出现在一定规模的语言模型中,例如超过 1000 亿个参数(Wei 等人,2022a)。然而,在 1B 模型中引发这种推理能力仍然是一个尚未解决的挑战,更不用说在多模态场景中了。这项工作重点关注 1B 模型,因为它们可以使用消费级 GPU(例如 32G 内存)进行微调和部署。 在本节中,我们将研究 1B 模型在 CoT 推理中失败的原因,并研究如何设计一种有效的方法来克服这一挑战。

3.1致力于COT的角色

首先,我们对ScienceQA基准的COT推理进行微调(Lu等,)2022a)。按照 Lu等。 (2022a),我们采用unifiedqa (Khashabi等人,2020年在模型在输入中获取文本信息并生成输出序列 这包括理由和答案。作为图中所示的示例 1 ,该模型采用 问题文本(q)的代币,上下文文本(c)和多个选项(M)的串联作为输入。为了研究COT的效果,我们将性能与三种变体进行了比较:(i)直接预测答案(QCM )→A); (ii) 答案推理以基本原理为条件的推理 (QCM→RA); (iii)解释基本原理用于解释答案推理(QCM)→增强现实)。

表2:COT在一个阶段设置中的影响。

| 方法 | 格式 | 准确性 |

|---|---|---|

| 禁止 | 质量控制模块→A | 80.40 |

| 推理 | 质量控制模块→RA | 67.86 |

| 解释 | 质量控制模块→增强现实 | 69.77 |

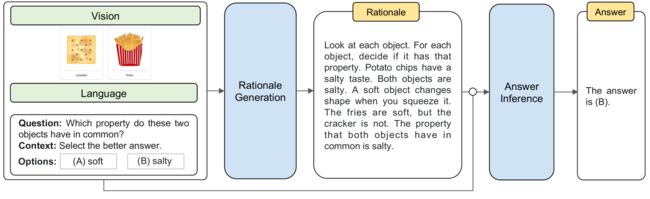

图2:用于生成基本原理和预测答案的不带视觉特征(基线)和带视觉特征(我们的)的两阶段框架示例。上半部分展示了带有黄金原理的问题细节,下半部分显示了基线的输出以及我们与视觉特征相结合的方法。我们观察到,由于幻觉原理的误导,基线未能预测正确的答案。更多示例请参见附录A.1。

令人惊讶的是,我们观察到↓12.54%的精度降低(80.40%→67.86%)如果模型在答案之前预测基本原理(QCM→RA)。结果表明,基本原理可能不一定有助于预测正确答案。 Lu 等人也观察到了类似的现象。 (2022a),其中可能的原因可能是模型在获得所需答案之前超出了最大令牌限制或提前停止生成预测。然而,我们发现生成的输出(RA)的最大长度始终小于 400 个 token,这低于语言模型的长度限制(即 UnifiedQA 中的 512))。 因此,值得更深入地研究为什么其理由会损害答案推理。

3.2幻觉的理由误导

为了深入了解基本原理如何影响答案预测,我们将 CoT 问题分为两个阶段:基本原理生成 和 回答推理。我们分别报告基本原理生成和答案推理的 RougeL 分数和准确性。表3显示了基于两阶段框架的结果。尽管两阶段基线模型的推理生成 RougeL 得分为 91.76,但答案推理准确率仅为 70.53%。与QCM相比→表中的一个变体(80.40%)2,结果表明两阶段框架中生成的基本原理并没有改善答案准确性。

表3:(i) 基本原理生成 (RougeL) 和 (ii) 答案推理 (Accuracy) 的两阶段设置。

| 方法 | (一) 质量控制模块→右 | (ii) QCMR→A |

|---|---|---|

| 两阶段框架 | 91.76 | 70.53 |

| 带字幕 | 91.85 | 71.12 |

| 带视觉功能 | 96.97 | 84.91 |

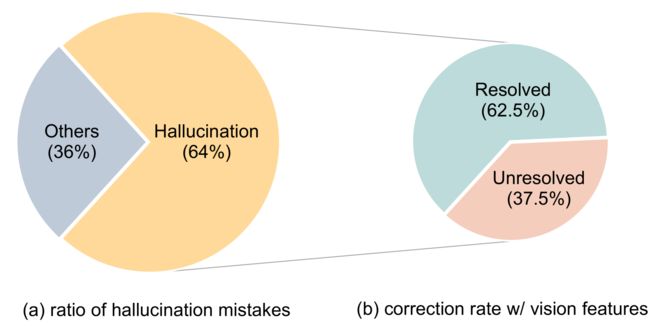

然后,我们随机采样了 50 个错误案例,发现模型倾向于生成误导答案推断的幻觉原理。如图2所示的示例,模型(左侧部分)幻想“一个物体的南极由于缺乏对视觉内容的参考,磁铁最接近另一个磁铁的南极”。 我们发现此类错误在错误案例中的比例为 64%(图3(a))。

图3:幻觉错误率 (a) 和视力特征纠正率 (b)。

图4:我们的 Multimodal-CoT 框架概述。 Multimodal-CoT 包含两个阶段:(i) 基本原理生成和 (ii) 答案推理。两个阶段共享相同的模型架构,但输入和输出不同。在第一阶段,我们向模型提供语言和视觉输入以生成基本原理。在第二阶段,我们将原始语言输入附加到第一阶段生成的基本原理。然后,我们将更新后的语言输入与原始视觉输入一起输入模型以推断答案。

3.3多模态有助于有效的理论依据

我们推测这种幻觉现象是由于缺乏执行有效的 Multimodal-CoT 所需的视觉环境造成的。要注入视觉信息,一种简单的方法是将配对图像转换为标题(Lu et al., 2022a) 然后将标题附加到两个阶段的输入中。然而,如表 3 所示,使用字幕只能带来边际性能提升 (↑0.59%)。然后,我们通过将视觉特征融入到语言模型中来探索一种先进的技术。具体来说,我们将配对图像输入 DETR 模型(Carion 等人,2020年) 提取视觉特征。然后,我们将视觉特征与编码的语言表示融合,然后再馈送到解码器(更多详细信息将在第 4 节中介绍)。有趣的是,有了视觉特征,推理生成的 RougeL 分数提升到了 96.97%(QCM→R),相应地有助于提高 84.91% 的答案准确性 (QCMR→A)。 有了这些有效的理据,幻觉现象得到缓解——第3.2节中62.5%的幻觉错误已得到纠正(图3(b)),如图2(右部分)所示。4 迄今为止的分析令人信服地表明,视觉特征确实有利于生成有效的理由并有助于准确的答案推理。作为两阶段方法(QCMR→表中的A)3比表2中的所有单阶段方法获得了更好的性能,我们在 Multimodal-CoT 框架中选择两阶段方法。

4多式联运CoT

根据第 3 节中的观察和讨论,我们提出 Multimodal-CoT 来合并语言(文本)和视觉(图像)模态分为两阶段框架。在本节中,我们将首先概述框架的流程,然后详细阐述模型架构的技术设计。

4.1框架概述

Multimodal-CoT 包含两个训练阶段:(i) 基本原理生成和 (ii) 答案推理。两个阶段共享相同的模型架构,但输入不同�和输出是。整体流程如图 4 所示。我们将以 Vision-Language 为例来展示 Multimodal-CoT 的工作原理。

在基本原理生成阶段,我们为模型提供�={�语言1,�想象}在哪里�语言1代表第一阶段的语言输入,�想象代表视觉输入,即图像。例如,� 可以实例化为多项选择推理问题的问题、上下文和选项的串联(Lu 等人,2022a)如图4。目标是学习基本原理生成模型右=�(�)在哪里右是基本原理。

在答案推理阶段,推理右附加到原始语言输入�语言1构建第二阶段的语言输入,�语言2=�语言1∘右在哪里∘表示串联。然后,我们提供更新后的输入�′={�语言2,�想象}到答案推理模型来推断出最终答案�=�(�′)。

在这两个阶段,我们独立训练具有相同架构的两个模型。他们采用带注释的元素(例如,�→右,�右→�,分别)来自监督学习的训练集。在推理过程中,给定�,使用第一阶段训练的模型生成测试集的基本原理;它们在第二阶段用于答案推理。

4.2模型架构

给定语言输入�语言ε{�语言1,�语言2}和视觉输入�想象,我们计算生成目标文本的概率是(图 4中的基本原理或答案)长度氮经过

| �(是|�语言,�想象)=∏我=1氮��(是我∣�语言,�想象,是<我), | (1) |

在哪里��(是我∣�语言,�想象,是<我) 使用基于 Transformer 的网络实现(Vaswani 等人,2017年)。网络具有三个主要过程:编码、交互和解码。具体来说,我们将语言文本输入 Transformer 编码器以获得文本表示,然后将其与视觉表示进行交互和融合,然后输入 Transformer 解码器。

编码

该模型�(�)接受语言和视觉输入并获得文本表示�语言和图像特征�想象通过以下功能:

| �语言 | = | 语言编码器(�语言), | (2) | ||

| �想象 | = | 瓦�⋅视觉提取器(�想象), | (3) |

其中语言编码器(⋅)作为 Transformer 模型实现。我们使用 Transformer 编码器中最后一层的隐藏状态作为语言表示�语言εℝ�×�在哪里�表示语言输入的长度,并且�是隐藏维度。 同时,VisionExtractor(⋅) 用于将输入图像矢量化为视觉特征。受到 Vision Transformers 最近成功的启发(Dosovitskiy 等人,2021年),我们通过现成的视觉提取模型获取块级特征,5 例如 DETR (Carion 等人,2020年)。获得块级视觉特征后,我们应用可学习的投影矩阵瓦�来转换形状视觉提取器(�想象)进入那个�语言;因此我们有�想象εℝ米×�在哪里米是补丁的数量。

算法 1 多模式-CoT

相互作用

获得语言和视觉表示后,我们使用单头注意网络将文本标记与图像补丁相关联,其中查询(), 钥匙 ()和值() 是�语言,�想象和�想象, 分别。注意力输出�想象收件人εℝ�×�定义为:

| �想象收件人 | = | 软最大(⊤��), | (4) |

在哪里��与 的维度相同�语言因为使用的是单头。

然后,我们应用门控融合机制(Zhang 等人,2020年;吴等人,2021年;李等人,2022a)融合�语言和�想象。融合输出�保险丝εℝ�×�是通过以下方式获得的:

| � | = | 乙状结肠(瓦我�语言+瓦��想象收件人), | (5) | ||

| �保险丝 | = | (1-�)⋅�语言+�⋅�想象收件人, | (6) |

在哪里瓦我和瓦�是可学习的参数。

解码

最后,融合输出�保险丝被输入 Transformer 解码器来预测目标是。 Multimodal-CoT 的完整流程如算法1所示。

表 4:主要结果 (%)。尺寸 = 主干模型尺寸。问题类别:NAT = 自然科学、SOC = 社会科学、LAN = 语言科学、TXT = 文本上下文、IMG = 图像上下文、NO = 无上下文 ,G1-6 = 1-6 年级,G7-12 = 7-12 年级。除我们之外的结果均来自Lu 等人。 (2022a)。 第 1 部分:人类表现;第 2 部分:VQA 基线;第 3 部分:UnifiedQA 基线;第 4 部分:GPT-3.5 基线;第 5 部分:我们的 Multimodal-CoT 结果。 粗体结果是最佳性能。

| 模型 | 尺寸 | 网络地址转换 | SOC | 局域网 | TXT | 免疫组化 | 不 | G1-6 | G7-12 | 平均 |

| 人类 | - | 90.23 | 84.97 | 87.48 | 89.60 | 87.50 | 88.10 | 91.59 | 82.42 | 88.40 |

| MCAN (Yu 等人, 2019年) | 95M | 56.08 | 46.23 | 58.09 | 59.43 | 51.17 | 55.40 | 51.65 | 59.72 | 54.54 |

| 自上而下(Anderson 等人, 2018年) | 70M | 59.50 | 54.33 | 61.82 | 62.90 | 54.88 | 59.79 | 57.27 | 62.16 | 59.02 |

| 禁令(Kim 等人, 2018年) | 112M | 60.88 | 46.57 | 66.64 | 62.61 | 52.60 | 65.51 | 56.83 | 63.94 | 59.37 |

| DFAF (高等人, 2019年) | 74M | 64.03 | 48.82 | 63.55 | 65.88 | 54.49 | 64.11 | 57.12 | 67.17 | 60.72 |

| ViLT (Kim 等人, 2021年) | 113M | 60.48 | 63.89 | 60.27 | 63.20 | 61.38 | 57.00 | 60.72 | 61.90 | 61.14 |

| 补丁 TRM (Lu 等人, 2021年) | 90M | 65.19 | 46.79 | 65.55 | 66.96 | 55.28 | 64.95 | 58.04 | 67.50 | 61.42 |

| VisualBERT (Li 等人, 2019年) | 111M | 59.33 | 69.18 | 61.18 | 62.71 | 62.17 | 58.54 | 62.96 | 59.92 | 61.87 |

| 统一质量保证 (Khashabi 等人, 2020年) | 223M | 68.16 | 69.18 | 74.91 | 63.78 | 61.38 | 77.84 | 72.98 | 65.00 | 70.12 |

| 统一质量保证 与 CoT (Lu 等人, 2022a) | 223M | 71.00 | 76.04 | 78.91 | 66.42 | 66.53 | 81.81 | 77.06 | 68.82 | 74.11 |

| GPT-3.5 (Chen 等人, 2020年) | 175B | 74.64 | 69.74 | 76.00 | 74.44 | 67.28 | 77.42 | 76.80 | 68.89 | 73.97 |

| GPT-3.5 w/ CoT (Lu 等人, 2022a) | 175B | 75.44 | 70.87 | 78.09 | 74.68 | 67.43 | 79.93 | 78.23 | 69.68 | 75.17 |

| 多模式CoT | 223M | 87.52 | 77.17 | 85.82 | 87.88 | 82.90 | 86.83 | 84.65 | 85.37 | 84.91 |

| 多模式CoT | 738M | 95.91 | 82.00 | 90.82 | 95.26 | 88.80 | 92.89 | 92.44 | 90.31 | 91.68 |

表 5:Multimodal-CoT 的消融结果。

| 模型 | 网络地址转换 | SOC | 局域网 | TXT | 免疫组化 | 不 | G1-6 | G7-12 | 平均 |

|---|---|---|---|---|---|---|---|---|---|

| 多式联运CoT | 87.52 | 77.17 | 85.82 | 87.88 | 82.90 | 86.83 | 84.65 | 85.37 | 84.91 |

| 没有两阶段框架 | 80.99 | 87.40 | 81.91 | 80.25 | 78.83 | 83.62 | 82.78 | 82.20 | 82.57 |

| 不带视觉功能 | 71.09 | 70.75 | 69.18 | 71.16 | 65.84 | 71.57 | 71.00 | 69.68 | 70.53 |

5实验

本节将介绍基准数据集、我们技术的实现以及比较的基线。然后,我们将报告我们的主要结果和发现。

5.1数据集

我们的方法在 ScienceQA 基准上进行评估(Lu 等人,2022a)。 ScienceQA 是第一个大规模多模式科学问题数据集,它通过详细的讲座和解释来注释答案。它包含 21,000 道多模态多项选择题,涵盖 3 个学科、26 个主题、127 个类别和 379 项技能,具有丰富的领域多样性。基准数据集分为训练、验证和测试部分,分别包含 12726、4241 和 4241 个示例。

5.2执行

以下部分介绍 Multimodal-CoT 的实验设置和基线方法。

实验设置

由于 Multimodal-CoT 任务需要生成推理链并利用视觉特征,因此我们使用 T5 编码器-解码器架构(Raffel 等人,2020年)。具体来说,我们采用 UnifiedQA (Khashabi 等人,2020年) 在两个阶段初始化我们的模型,因为它在 Lu 等人中实现了最佳微调结果。 (2022a)。为了验证我们的方法在不同 LM 中的通用性,我们还采用了 FLAN-T5 (Chung 等人,2022年) 作为第 6.3 节的主干。由于在第 3.3 节中使用图像标题不会产生显着的性能提升,因此我们没有使用标题。我们将模型微调最多 20 个 epoch,学习率为 5e-5。最大输入序列长度为 512。基础模型和大型模型的批量大小分别为 16 和 8。我们的实验在 4 个 NVIDIA Tesla V100 32G GPU 上运行。

基线模型

以下Lu 等人。 (2022a),我们的基准包括 (i) 视觉问答 (VQA) 模型(Anderson 等人,2018年;金等人,2018年;余等人,2019年;高等人,2019年;金等人,2021年;卢等人,2021年;李等人,2019年); (ii) 文本到文本的语言模型。 (卡沙比等人,2020年); (iii) GPT-3.5 模型(Chen 等人,2020年)。更多详情请参见附录B.1。

5.3主要结果

表4显示了主要结果。多模式-CoT优于 GPT-3.5 16.51% (75.17%→91.68%)并超越了人类的表现。具体来说,在 8 个问题类别中,Mutimodal-CoT达到 21.37% (67.43%→对于具有配对图像 (IMG) 的问题,性能提升 88.80%)。与利用上下文中的图像说明提供视觉语义的现有 UnifiedQA 和 GPT-3.5 方法相比,结果表明使用图像特征更有效。此外,根据表 5 中的消融研究结果,我们的两阶段框架有助于取得优异的结果。总的来说,结果验证了多模态的有效性以及通过我们的两阶段框架使用 1B 模型实现 CoT 推理的潜力。

6分析

以下分析将研究 Multimodal-CoT 的工作原理并讨论影响因素和限制。除非另有说明,我们使用基本尺寸下的模型进行分析。

pt1pt2pt3pt4pt5pt6pt7pt8pt9pt10pt40pt50pt60pt70pt80pt90ptEpochptAccuracyOne-stage BaselineOne-stage MultimodalTwo-Stage BaselineTwo-Stage Multimodal

图5:No-CoT 基线和 Multimodal-CoT 变体跨时期的准确度曲线。

6.1多模态促进融合

图5展示了基线和Multimodal-CoT在不同训练epoch下的评估精度曲线。 “单级”基于QCM→表中实现最佳性能的输入输出格式2,“两阶段”是我们的两阶段框架。我们发现,与无需 CoT 直接生成答案的单阶段基线相比,两阶段方法在开始时获得了相对较高的准确度。然而,如果没有视觉特征,随着训练的进行,由于低质量的基本原理,两阶段基线无法产生更好的结果(如第 3)。相比之下, 使用视觉特征有助于生成更有效的原理,有助于提高我们的两阶段多模态变体的答案准确性。

6.2使用不同的视觉特征

不同的视觉特征可能会影响模型的性能。我们比较了三种广泛使用的视觉特征类型,CLIP (Radford 等人,2021年),DETR (Carion 等人,2020年) 和 ResNet (He 等人,2016年)。 CLIP 和 DETR 是类似补丁的功能,其中 DETR 基于对象检测。对于ResNet特征,我们将ResNet-50的池化特征与文本序列重复相同的长度,以模仿类补丁特征,其中每个补丁与池化图像特征相同。有关视觉功能的更多详细信息,请参见附录B.2。

表 6:使用不同视觉特征的准确度(%)。

| 方法 | 一级 | 两级 |

|---|---|---|

| 带夹子 | 81.21 | 84.81 |

| 带 DETR | 82.57 | 84.91 |

| 带 ResNet | 80.97 | 84.77 |

表6显示了视觉特征的比较结果。我们观察到,使用视觉特征通常比仅使用语言基线获得更好的性能。具体来说,DETR总体上取得了相对较好的性能。因此,我们在Multimodal-CoT中默认使用DETR。

6.3跨骨干模型的总体有效性

为了测试我们的方法对其他骨干模型的好处的普遍性,我们将底层 LM 更改为不同大小或类型的其他变体。如表7所示,我们的方法对于广泛使用的骨干模型通常是有效的。

表 7:不同主干语言模型的准确率 (%)。

| 方法 | 尺寸 | 仅语言 | 多模式CoT |

|---|---|---|---|

| 统一质量保证 | 223M | 80.40 | 84.91 |

| 统一质量保证 | 738M | 83.60 | 91.68 |

| 法兰-T5 | 248M | 83.42 | 85.85 |

| 法兰-T5 | 783M | 85.19 | 93.02 |

6.4误差分析

为了更好地理解 Multimodal-CoT 的行为并促进未来的研究,我们手动调查由我们的方法生成的随机选择的示例。表8总结了Multimodal-CoT生成的分类结果。我们随机抽取了 50 个答案正确的样本和 50 个答案不正确的样本。附录C中提供了每个类别的相应示例。

表8:Multimodal-CoT 的分类分析。

| 回答 | 交易费用类别 | 百分比 (%) |

|---|---|---|

| 正确的 | 科特是正确的 | 90 |

| 科特不正确 | 10 | |

| 不正确 | 常识性错误 | 82 |

| 逻辑错误 | 12 | |

| 科特是正确的 | 6 |

我们发现正确的样本(即答案正确)包含一定量的错误思路(10%)。结果表明,CoT 可能并不总是有利于答案推理,并且该模型在某种程度上是鲁棒的——它可以通过忽略不正确的理由来预测正确的答案。对于不正确的样本(即答案不正确),CoT 中的常识性错误是最常见的错误类型 (88%)。当回答需要常识知识的问题时,模型经常犯常识性错误,例如,理解地图和计算图像中的数字(图9),并利用字母表(图10)。另一类错误是逻辑错误(12%),推理链存在矛盾(图11)。此外,有些案例的 CoT 正确(6%),但答案不正确,但可能与答案选项不一定相关(图 12)。

分析表明未来研究有前瞻性的方向。可以通过以下方式改进 Multimodal-CoT:(i)结合更多信息丰富的视觉特征并改进语言视觉交互,使其能够理解地图和计数; (ii) 注入常识性知识; (iii)应用过滤机制,例如仅使用有效的CoT来推断答案并去除不相关的CoT。

7结论

我们正式研究多模态 CoT 问题。我们提出了 Multimodal-CoT,它将语言和视觉模态合并到一个两阶段框架中,将基本原理生成和答案推理分开,因此答案推理可以更好地利用多模态信息生成的基本原理。通过 Multimodal-CoT,我们证明我们的方法在 ScienceQA 基准上的准确度比 GPT-3.5 高出 16 个百分点。我们的错误分析表明,在未来的研究中,有可能利用更有效的视觉特征、注入常识知识并应用过滤机制来改进 CoT 推理。