论文阅读:Blind Super-Resolution Kernel Estimation using an Internal-GAN

这是发表在 2019 年 NIPS 上的一篇文章,那个时候还叫 NIPS,现在已经改名为 NeurIPS 了。文章中的其中一个作者 Michal Irani 是以色 Weizmann Institute of Science (魏茨曼科学研究学院) 的一名教授,对图像纹理的内在统计规律有着很深入的研究,提出了很多基于单帧图像的 GAN 模型。这篇文章也是提出了基于单张图像的一种 Internal-GAN 模型,也算是最早开始尝试研究用深度学习进行盲超分的工作,今天看来,依然有一定的借鉴意义。文章中的一个重要假设就是 SR-kernel 是可以在不同尺度下进行递归作用的一种卷积核。

一般的超分方法都会假设一张高分辨率的图经过一个理想的下采样核(比如 Bicubic)得到一张低分辨率的图,基于这样的假设,进行超分的重建。然而,实际的下采样核往往不是理想的,也比一般的假设要复杂。基于理想下采样核训练的超分模型在遇到真实下采样核的时候,重建效果往往不好。这就延伸出了对盲超分的需求,盲超分,顾名思义,就是对下采样核未知情况下的超分重建。进一步证明,真实的 SR-核是能最大化的在 LR 图像的不同尺度上递归地作用在图像 patch 上的一个核。在这篇文章里,文章作者展示了这种跨尺度的递归属性可以通过 Deep Internal Learning 来实现。这篇文章介绍了一种 kernel-GAN,即面向特定图像的 Internal-GAN,在推理阶段,通过对待测试的 LR 图像进行训练,学习图像块之间的内在分布。这个 kernel GAN 的生成器用于生成一个 LR 图像的下采样版本,与此同时判别器无法区分原始 LR 图像的块分布与下采样图像的块分布。生成器一旦训练好,就可以作为特定图像的 SR-kernel。Kernel GAN 不需要额外的训练数据,只需要测试图像本身。

超分的基本假设是一张低分辨率的图像是由一张高分辨率的图像通过卷积和下采样之后得到的:

I L R = ( I H R ∗ k s ) ↓ s (1) I_{LR} = (I_{HR} \ast k_{s}) \downarrow_{s} \tag{1} ILR=(IHR∗ks)↓s(1)

超分的目标,就是给定低分辨率的图 I L R I_{LR} ILR,去恢复高分辨率的图 I H R I_{HR} IHR,之前的很多工作都是假设一些理想的卷积核,比如 Bicubic 等,然而实际的卷积核比这要复杂的多,实际的卷积核会受到 sensor 的影响,以及相机运动的影响,基于错误假设的 SR kernel 去训练超分模型,在实际的 LR 图像上的效果并不理想。

只给定输入的 LR 图像,文章的目的是找到图像特定的 SR 核。我们希望这个核能够最好地保持不同尺度下图像的块分布。更具体点说,我们希望能生成一个下采样的图像,这个图像的块分布与原始的 LR 图像的块分布要尽可能接近。为了匹配一个分布而不是某个单一的图像patch,文章利用了生成模型 GAN 网络,GAN 网络本身就是用来学习分布的一种模型,GAN 通常是通过大量的数据来学习图像的分布。将源分布的样本 p x p_x px 映射到目标分布 p y p_y py

G : x → y x ∼ p x G ( x ) ∼ p x G: x \rightarrow y \quad x \sim p_x \quad G(x) \sim p_x G:x→yx∼pxG(x)∼px

而文章中用到的 kernel GAN 是训练在一张图像上,学习的是这张图像内部图像块之间的独特分布。kernel GAN 包含一个下采样的生成器 G 和一个判别器 D。其中 G 和 D 都是全卷积网络,网络的输入是图像块。给定一张输入的低清图 I L R I_{LR} ILR,生成器 G 是为了生成一个下采样的图,而判别器 D 是为了对生成器生成的图与原始的低清图进行区分。

判别器 D 输出的是一张 heat map,可以称之为 D-map,D-map 上的每个像素会有一个概率,表示的是像素周围的 patch 有多大概率是来自于原始的块分布。D 的训练是交替着进行的,真实样本与虚假样本交替进行训练。D 的 loss 是 pixel-wise 的 MSE loss。label 分别是全 1 和全 0 两种形式。训练的损失函数为:

G ∗ ( I L R ) = arg min G max D { E x ∼ p a t c h e s ( I L R ) [ ∣ D ( x ) − 1 ∣ + ∣ D ( G ( x ) ) ∣ ] + R } (2) G^{*}(I_{LR}) = \argmin_{G} \max_{D} \{ \mathbb{E}_{x \sim patches(I_{LR})} [\left|D(x) - 1 \right| + \left| D(G(x))\right|] + R \} \tag{2} G∗(ILR)=GargminDmax{Ex∼patches(ILR)[∣D(x)−1∣+∣D(G(x))∣]+R}(2)

其中, R R R 表示正则项。

Discriminator

判别器的模型是一个全卷积网络,第一层是一个 7 × 7 7 \times 7 7×7 的卷积层,后面跟了 6 层 1 × 1 1 \times 1 1×1 的卷积层,输入和输出是相同 size 的。

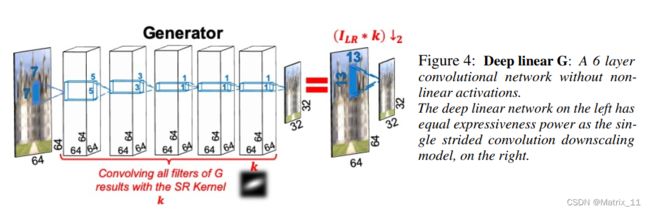

Deep Linear Generator = The downscaling SR-Kernel

对于生成器,文章中使用了一个全线性的卷积网络,也称为深度线性网络,整个网络都是卷积操作,没有非线性的激活函数。整个生成器包含 6 层卷积层,前三层分别是 7 × 7 , 5 × 5 , 3 × 3 7 \times 7, 5 \times 5, 3 \times 3 7×7,5×5,3×3 的卷积层,后面三层是 1 × 1 1 \times 1 1×1 的卷积层,前三层的卷积层可以形成一个 13 × 13 13 \times 13 13×13 的感受野,相当于一个 13 × 13 13 \times 13 13×13 的卷积核。

在训练过程中,可以对生成器直接估计出一个等效的 SR-kernel,上式中的正则项其实是对提取出的 SR-kernel 做的假设,满足如下的关系:

R = α L s u m + β L b o u n d + γ L s p a r s e + σ L c e n t e r (3) R = \alpha \mathcal{L}_{sum} + \beta \mathcal{L}_{bound} + \gamma \mathcal{L}_{sparse} + \sigma \mathcal{L}_{center} \tag{3} R=αLsum+βLbound+γLsparse+σLcenter(3)

其中, α = 0.5 , β = 0.5 , γ = 5 , σ = 1 \alpha=0.5, \beta=0.5, \gamma=5, \sigma=1 α=0.5,β=0.5,γ=5,σ=1

- $\mathcal{L}{sum} = \left | 1 - \sum{i, j} k_{i, j} \right | $

- $\mathcal{L}{bound} = \sum{i, j} \left | k_{i, j} m_{i, j} \right | $ 希望 kernel 的分布尽量靠近中心, m i j m_{ij} mij 是一个预设好的 mask,随着离中心越远,权重越高

- $\mathcal{L}{spare} = \sum{i,j} \left | k_{i,j} \right |^{1/2} $ 希望 kernel 比较稀疏,而不是比较平均的分布

- $\mathcal{L}{center} = \left | (x_0, y_0) - \frac{\sum{i,j}k_{i,j}*(i,j)}{\sum_{i,j}k_{i,j}} \right |_{2} $ 希望kernel 的中心能在中心

文章中也提到,SR-kernel 除了与图像内容本身有关,也和需要下采样的尺度有关,文章中认为不同尺度的 SR-kernel 存在一个简单的变换关系,这也是文章一直强调的,SR-kernel 是可以在不同图像的尺度下重复递归作用的一种核。文章中列举了 4x 下采样与 2x 下采样下的SR-kernel 之间的关系:

( I H R ∗ k 4 ) ↓ 4 = ( ( I H R ∗ k 2 ) ↓ 2 ) ∗ k 2 ↓ 2 (I_{HR} \ast k_{4}) \downarrow_{4} = ((I_{HR} \ast k_{2}) \downarrow_{2}) \ast k_{2} \downarrow_{2} (IHR∗k4)↓4=((IHR∗k2)↓2)∗k2↓2

简单来说,文章认为,通过 2x 下采样的 SR-kernel 的估计,再通过递归关系,可以实现更大尺度下的 SR-kernel 的估计,所以文章最终只训练了一个 2x 下采样下的 SR-kernel。文章中也给出了基于 2x 下采样学习到的 SR-kernel 通过递归的方式去预测估计 4x 下采样的 SR-kernel,如下图所示。