(2021|NIPS,基准,组合概念生成,R-Precision,CLIP-R-Precision)组合文本到图像合成的基准

Benchmark for Compositional Text-to-Image Synthesis

gz号:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料)

目录

0. 摘要

1. 简介

2. 相关工作

3. 构建文本到图像合成的组合分割

3.1 问题定义

3.2 组合拆分生成

4. 文本到图像合成的评估

5. 实验

5.1 自动评估

5.2 人工评估

5.3 定性分析

6. 讨论和更广泛的影响

S. 总结

S.1 主要贡献

S.2 新基准

S.3 评估指标

0. 摘要

文本到图像生成的快速进展经常通过 Fre´chet Inception Distance(FID)来衡量,以捕捉生成的图像的真实性,或者通过 R-Precision 来评估它们是否很好地以对给定文本描述为条件。然而,关于文本到图像合成模型如何在新颖的词组合上推广的系统性研究尚不存在。在这项工作中,我们专注于评估生成的图像在特别具有挑战性的新颖组合场景中对输入文本的保真度。我们提出了关于零样本组合拆分的文本到图像生成的第一次系统研究,针对两种情况,即未见过的物体颜色(例如 “蓝色花瓣”)和物体形状(例如 “长喙”)短语。我们在现有的 CUB 和 Oxford Flowers 数据集的基础上创建了新的基准。我们还提出了一种基于强大的视觉和语言 CLIP 模型的新度量标准,我们利用它来计算 R-Precision。这与常见的方法形成对比,常见方法在训练和评估期间使用相同的检索模型,可能导致偏差。我们尝试了几种最近的文本到图像生成方法。我们的自动和人工评估证实,当遇到以前未见的短语时,确实存在性能差距。我们表明,图像的正确性而不仅仅是感知质量受到了特别的影响。最后,我们的 CLIP-R-Precision 度量表现出比常用度量更好的与人类判断的相关性。数据集和评估代码位于:https://github.com/Seth-Park/comp-t2i-dataset。

1. 简介

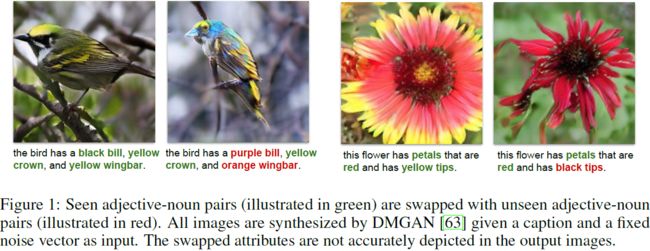

文本到图像合成旨在根据输入的文本描述生成图像,在过去几年取得了巨大的进展 [4, 37, 55]。虽然大多数文本到图像合成方法都集中在提高合成图像的感知质量上,但目前尚不清楚这些模型是否具有合成新图像的能力,或者它们是否仅仅记住了训练集。组合性是视觉智能的关键特征,在视觉感知 [28] 和图像标题 [31] 中已经有所探讨。然而,据我们所知,它从未被系统地用于文本到图像合成的研究。之前见过 “蓝色” 和 “花朵” 概念的人可以轻松想象 “一朵蓝色的花朵”,即使他们以前没有见过这种特定的组合。但是文本到图像合成模型是否能够推广到这样的新颖概念组合呢?图 1 展示了两个例子,其中模型未能正确合成新颖的组合,如 “紫色嘴巴(purple bill)” 和 “黑色尖端(black tips)”。此外,当引入新颖组合时,我们还经常观察到背景、姿势和其他属性的一些意外变化,表明所有这些特征之间存在一定的纠缠。

在这项工作中,我们提供了首次关于最先进的文本到图像生成方法对新颖概念组合的泛化的系统研究。我们观察到在常用的文本到图像合成数据集的传统测试拆分中,相对较少涉及新颖概念组合,并且没有现有的拆分专门针对这种情况。因此,我们提出了基于 Caltech-UCSD Birds(CUB)数据集 [54] 和 Oxford-102(Flowers)数据集 [32] 的新基准,人工生成的标题 [40] 进行增强,这在文本到图像合成文献中经常使用。具体而言,在两种情况下,测试集由已见的图像-标题对(其中形容词-名词对已经出现在训练集中)、未见的对(其中形容词-名词对未出现在训练集中)和交换对(通过将已见的形容词-名词对与未见的形容词-名词对交换而生成)组成。受到最近的研究启发,该研究表明某些对象属性(例如纹理)比其他属性(例如形状)“更容易” 学习 [7],我们提出了两种组合场景,一种针对物体颜色组合(例如 “蓝色花瓣”),另一种针对新颖的物体形状组合(例如 “长喙”)。我们将提出的组合基准称为 C-CUB Color/Shape 和 C-Flowers Color/Shape。

有两种类型的评估指标通常用于文本到图像合成,一些用于测量图像的保真度(感知质量),而另一些用于测量图像的正确性。Fre´chet Inception Distance(FID)[9] 通常用于评估合成图像的质量和多样性。为了评估合成图像的正确性,先前的研究使用 R-Precision,该指标衡量基于生成的图像,我们是否可以从一组干扰项中检索出原始描述。一个注意事项是,用于计算 R-Precision 的文本到图像检索模型通常与用于训练文本到图像合成网络的模型相同。因此,在训练过程中不可避免地引入了模型偏差。为了缓解这个问题,我们提出了一种新的评估指标,名为 CLIP-R-Precision,它基于大规模预训练的多模态 CLIP 模型 [38] 执行文本到图像检索。我们的人工评估表明,我们提出的指标与先前工作中使用的指标相比,更一致于人类判断。

最后,我们在我们提出的组合数据拆分和 CLIP-R-Precision 评估指标上对三种具有代表性的最新文本到图像合成方法进行基准测试,包括 DM-GAN [63]、ControlGAN [19] 和 DF-GAN [48]。我们进行自动和人工评估。我们的结果表明,新颖的组合确实导致性能下降。实际上,图像的正确性下降比图像的感知质量更为严重。我们提供了定性分析,揭示了特征纠缠可能是差劲组合泛化的一个可能原因。

总的来说,在这项工作中,我们建立了首个用于评估和分析文本到图像合成方法在概念的新颖组合中的泛化效果的基准。我们的贡献有三个方面:我们创建了新的数据拆分,其中包含未见和交换的测试样本,专门设计用于评估和分析模型在未见概念组合(如物体颜色和物体形状)中的泛化能力。我们提出了一种新的文本到图像合成评估指标,名为 CLIP-R-Precision,它与人类判断更好地相关,并克服了在常用的 R-Precision 中训练期间引入的模型偏差。我们对我们提出的数据拆分和评估指标进行了基准测试和分析,展示了在所有未见场景中性能下降。

2. 相关工作

文本到图像合成。在近年来,特别是利用生成对抗网络(GANs)[8] 的情况下,文本到图像合成取得了巨大的进展。GAN-INT-CLS [41] 和 GAWWN [42] 是基于 GAN 的文本到图像合成的首次尝试。StackGAN [60] 和其他一些方法 [61, 62, 6, 15] 通过使用堆叠的生成器结构以粗到细的方式合成图像,提高了合成图像的质量。著名的方法 AttnGAN [55] 引入了基于注意力的多阶段细化,用于细粒度的文本到图像生成;它成为许多未来工作的基础 [13]。DM-GAN [63] 引入了动态内存来逐步优化生成的图像。ControlGAN [19] 为生成器引入了单词级别的空间和通道注意力,以及单词级别的鉴别器和感知损失。DFGAN [48] 引入了一阶段文本到图像骨干网络,其中生成器使用新型融合模块,鉴别器具有目标感知性。其他方法探索引入内存机制 [63, 24]、循环一致性约束 [37, 17]、连体网络 [57, 47] 和先验知识 [36, 4] 以提高文本到图像合成性能。为了合成具有复杂场景的图像,一些工作将场景分解为多个对象,并使用对象布局或语义布局作为合成整个图像的桥梁 [11, 21, 10],或者顺序生成不同的对象 [46]。场景图到图像合成 [16] 与这一行的工作有关,因为它们都将图像视为多个对象(和对象关系)的组合。然而,与自然语言描述输入相反,图像合成的结构化信息和布局是由场景图输入直接提供的。最近的工作探索了基于 Transformer 的视觉-语言表示模型 [5]、跨模态对比学习 [59] 以及文本到图像合成的 Transformer 和离散 VAE [39]。

评估指标。大多数关于文本到图像合成的先前尝试都使用 Inception Score(IS)[45] 和 Fre´chet Inception Distance(FID)[9] 进行图像保真度的评估。对于无条件和有条件的图像合成,精度和召回率(Precision and recall) [44, 18] 是用于评估图像质量和多样性的替代评估指标。对于文本到图像合成评估,R-precision 被采用来评估生成图像与文本的对齐程度。在这项工作中,我们分析了先前评估指标的缺点,并提出了我们的新基准和评估指标,以衡量文本到图像合成模型的组合性。我们对 DM-GAN [63]、ControlGAN [19] 和 DF-GAN [48] 进行实验,这三种是上面讨论的具有代表性的方法。

视觉系统中的组合性。组合性是智能视觉系统的关键属性之一。探索视觉系统的组合性对神经网络的泛化、少样本学习以及克服数据集偏见都非常重要。一个典型的例子是:给定 “年轻老虎” 和 “旧车” 的图像,模型能否识别 “老虎”?在视觉识别中,研究人员探索了对象和属性的组合性,以便模型可以泛化到未见的视觉概念的组合 [28, 29, 53, 50, 35, 30, 23, 56, 26]。组合性也在视觉关系检测 [34, 1] 和动作识别 [27] 中得到探索。与我们的工作最相关的是图像标题和图像合成中的组合性。先前的工作探索了对未见概念的新颖图像标题生成的能力 [31]。对于图像合成,一些工作致力于对象级别的组合性,例如为面部添加一副墨镜 [51, 3, 58]。另一方面,另一些工作探索了图像合成的不同因子的解耦 [2, 25, 14, 43]。MixNMatch [22] 通过将图像合成分解为多个步骤来解耦多个因素,包括背景、姿势、形状和纹理。然而,以前的工作从未探索过文本到图像合成的组合性。在这里,我们为组合文本到图像合成建立了一个新的基准,并分析了几种现有文本到图像合成模型的组合性。

3. 构建文本到图像合成的组合分割

在本节中,我们介绍一项任务,在从输入文本合成图像时,该任务要求对形容词和目标概念进行组合理解。为了系统地分析文本到图像模型在泛化到未见概念组合时的性能,我们提出了多个基于两个常用于文本到图像合成的数据集构建的新组合拆分。

3.1 问题定义

在这里,我们定义了组合文本到图像合成任务,其目标是测量模型在泛化到包含未见概念组合的文本输入时的表现如何。假设存在一个包含 N 张图像的数据集 D,每张图像由 K 个标题描述:D =

![]()

在每个标题中,我们确定了一组概念对,具体而言,在这项工作中我们考虑形容词-名词对。尽管在训练期间每个单独的概念,即形容词或名词,都被观察到,但有些概念的组合被保留在训练集之外。例如,训练标题可能包含单个颜色(例如黑色、紫色)、单个身体部位(例如嘴巴)以及它们的一些组合(例如黑色的嘴巴),同时缺少其他一些组合(例如紫色的嘴巴)。包含保留(hold-out)组合的图像和标题将用于评估。我们设计了三种不同的测试拆分(splits)来衡量:(1)模型在训练期间观察到的形容词-名词组合上的表现有多好(测试已见),(2)模型在保留了训练的未见概念对的情况下泛化如何(测试未见),以及(3)模型在输入文本中已见概念对被交换以变成未见概念的情况下表现如何(测试交换)。第三种拆分的动机是防止影响模型泛化性能的任何其他因素,除了新颖的形容词-名词组合之外。为了实现这一点,我们通过交换形容词来形成未见组合,对已见拆分进行了最小的更改。例如,一个测试已见的标题是 “这是一只带有红色嘴巴的鸟,嘴巴弯曲而厚实”,其中“红色嘴巴” 是已见组合。而测试未见的标题是 “这是一只华丽的鸟,带有棕色冠,醒目的黄色披肩,橙色的上翅和蓝色嘴巴”。如果从未见标题中合成的图像质量不好,很难判断是因为未见组合(蓝色嘴巴)还是因为输入标题更长且更复杂。为了控制各种因素并分析新颖组合的效果,我们引入了测试交换标题,“这是一只带有蓝色嘴巴的鸟,嘴巴弯曲而厚实”,其中它采用了与已见标题相同的句子结构和词汇,只是引入了未见组合 “蓝色嘴巴”。

3.2 组合拆分生成

为了创建前述的组合拆分(compositional splits),我们首先确定数据集中存在的名词和形容词的代表性集合,并为每个单词筛选同义词以考虑它们在标题中的变化。在选择形容词时,我们首先确定出现在数据集中的 60 个最常见形容词。然后,我们过滤掉与颜色相关或形状相关的形容词。接下来,我们找到与选定形容词相关联的 100 个最常见的形容词-名词对,并提取所有的名词。我们使用 Spacy [12] 对标题进行标记、词形还原(lemmatize)和解析。

一旦确定了名词和形容词,我们选择将构成评估集的 “新颖” 形容词-名词对。具体而言,我们计算所有形容词-名词对的频率,并将它们从最频繁到最不频繁进行排序。然后,我们保留 10% 的独特形容词-名词对作为未见的,它们是从排序列表的第 25 到第 75 百分位之间随机抽样的。(从列表的顶部,即最频繁的形容词-名词对中抽样保留的对,会导致训练数据集的显著缩小,并限制评估拆分中名词的变化,因为存在某些名词在多个对之间更频繁地出现,而从长尾抽样会导致一个小的测试集。)最后,基于保留的对,将数据集拆分为 D_train、D_test-seen 和 D_test-unseen。在从 D_test-seen 生成 D_test-swapped 时,我们保留名词并仅修改形容词,使它们形成 unseen 对。鉴于保留集中可用形容词的数量有限,这种交换过程可能导致某些保留对在拆分中占主导地位。为解决这个问题,如果标题中存在其他可交换的候选词,我们识别这些主导对,并尽量避免在标题中引入它们。即便采取了这样的措施,保留对的频率仍然可能不平衡,因此在计算自动指标时,我们确保主导对不会影响评分计算。

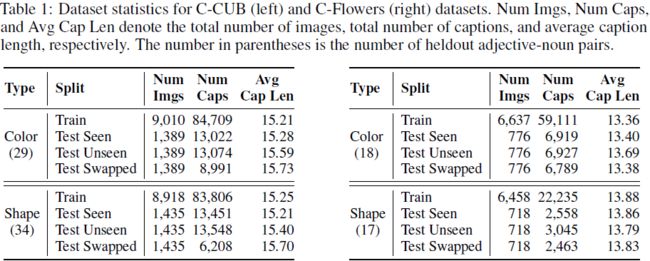

按照这个流程,我们从两个常用的文本到图像合成数据集(Caltech-UCSD Birds (CUB) [52],包含 200 种鸟类的集合,以及Oxford-102 (Flowers) [33],其中包含 102 种花卉类别)构建了四个不同的基准。这两个数据集的标题来自 [40],他们为每张图像收集了 10 个人工描述。每个数据集的许可细节请参阅相应的论文。我们将这四个不同的基准表示为 C-CUB Color、C-CUB Shape、C-Flowers Color、C-Flowers Shape,它们的统计信息可以在表 1 中找到。有关提出的基准的更多详细信息,请参阅补充材料。

4. 文本到图像合成的评估

在这里,我们回顾了常用的评估指标,讨论了它们的局限性,并提出了一种新的指标 CLIP-R-Precision,用于测量给定输入描述的生成图像正确性。

Fre´chet Inception Distance。在评估 GAN 在质量和多样性方面的性能时,特别是在无条件图像合成中,一种常见的指标是 Fre´chet Inception Distance (FID) [9]。它计算了从预训练的 Inception 网络中提取的真实图像的嵌入与合成图像的嵌入之间的 Fre´chet 距离。在条件文本到图像合成问题中,虽然此度量评估生成样本的感知质量,但它并不捕捉这些图像是否与输入文本良好匹配。相反,R-Precision 用于评估生成的图像相对于给定标题的正确性。接下来,我们将回顾 R-Precision,并讨论其局限性,随后将介绍我们提出的新指标 CLIP-R-Precision。

R-Precision。R-Precision 计算在使用生成的图像作为查询时,从 100 个文本候选中检索匹配文本的前 R 个检索准确性。通常 R = 1,意味着我们计算前 1 个检索的准确性。检索的文本-图像相似度分数是使用 Deep Attentional Multimodal Similarity Model (DAMSM) [55] 计算的,该模型包括一个图像编码器和一个文本编码器,将图像的每个子区域及其在句子中对应的单词映射到联合嵌入空间。该模型在来自训练数据的真实图像-文本对上进行了预训练,并测量了用于检索的细粒度图像-文本相似性。尽管 R-Precision 的目的是衡量生成的图像与文本输入的对齐程度,我们发现大多数文本到图像合成模型直接优化了用于计算 R-Precision 的 DAMSM 模块 [63, 19]。这导致了专门针对 DAMSM 模块进行优化的文本到图像生成系统,使 R-Precision 指标具有模型特定性。这种指标的问题在于,未经专门调整 DAMSM 模块的模型可能在该指标上表现较差,从而使该指标较不客观,必须将 DAMSM 模块纳入模型设计中,这可能并不总是理想的。

CLIP-R-Precision。为解决这个问题,我们提出了一种新的评估指标,称为 CLIP-R-Precision。我们采用最近的多模态 CLIP 模型 [38],而不是标准的 DAMSM 来计算 R-Precision 分数。CLIP 在基于 Web 的图像-标题对的大语料库上进行训练。它通过对比目标来学习将两个嵌入(视觉和文本)融合在一起。我们在分别整个 CUB 和 Oxford-102 数据集上微调预训练的 CLIP 模型。与 DAMSM 相比,CLIP 在 CUB 和 Flowers 数据集的标准测试拆分上获得了更高的图像-文本检索性能:分别为 26.20 vs. 22.1 和 20.0 vs. 18.44(使用真实图像)。总体而言,与标准的 R-Precision 相比,我们提出的 CLIP-R-Precision 是一个更强的模型无关(即在模型训练中分离的)评估指标。我们通过在第 5.2 节分析人类判断、常规 R-Precision 和 CLIP-R-Precision 之间的相关性来进一步验证这一说法。

5. 实验

在这一部分,我们研究了现有文本到图像合成模型在我们提出的组合数据拆分中对未见概念组合的泛化性能。

文本到图像合成模型。我们对三种文本到图像合成方法进行基准测试。DM-GAN(Dynamic Memory GAN)[63] 首先生成初始图像,然后使用基于动态内存的图像细化模块进行迭代细化。ControlGAN [19] 旨在通过基于单词级的空间和通道注意的生成器、单词级鉴别器和感知损失来实现用户可控的文本到图像合成。DF-GAN(Deep Fusion GAN)[48] 为生成器提出了一个深度文本图像融合块,为鉴别器提出了匹配感知梯度惩罚(MA-GP)。我们使用作者发布的代码 [64, 20, 49] 在我们的组合拆分上训练它们的模型。我们使用与它们原始论文中描述的相同的训练策略。

评估。我们采用文本到图像合成的两个常用评估指标,FID 和 R-Precision,以及我们在第 4 节中描述的新提出的 CLIP-R-Precision 指标。我们分别使用约 10,000 和 5000 个样本计算 C-CUB 和 C-Flowers 测试拆分的 FID。为了计算 R-Precision 和 CLIP-R-Precision,我们分别使用 11,000 和 7,000 张图像来自 C-CUB 和 C-Flowers 数据集。此外,我们在 Amazon Mechanical Turk 上进行了人工评估,以评估生成图像的质量和正确性(详见第 5.2 节)。

5.1 自动评估

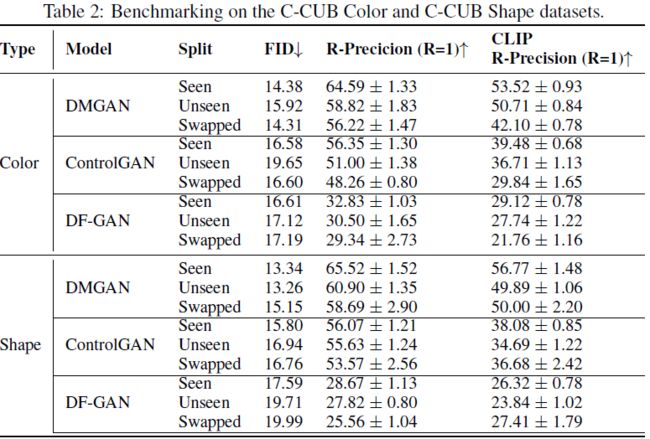

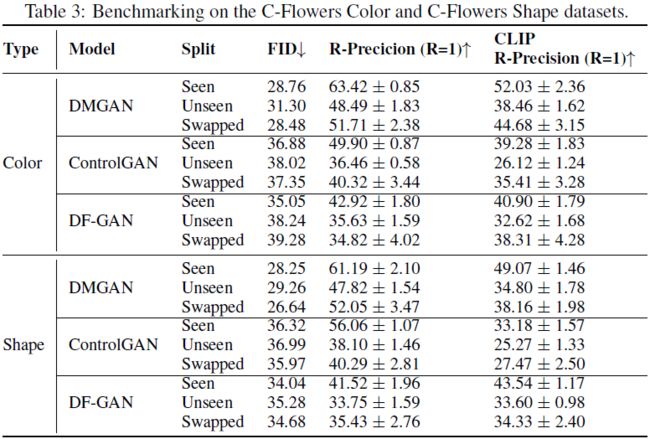

我们在提出的 C-CUB 和 C-Flowers 数据集的组合拆分上报告了自动评估分数,具体见表 2 和表 3。以下是我们的主要发现总结。

总体而言,我们观察到在大多数情况下,包括未见过和交换组合在内,图像质量(由 FID 指示)和图像正确性(由 R-Precision 和 CLIP-R-Precision 指示)都出现了退化,这验证了我们的假设,即模型不能很好地推广到概念的新组合。对于形状和颜色在两个数据集上的图像正确性(R-Precision 和 CLIP-R-Precision)而言,退化要比图像质量(FID)严重得多,对于 Test Unseen 和Test Swapped 拆分而言也是如此。换句话说,模型能够生成在感知上令人信服的图像,但它们并不与输入的标题紧密匹配。

除了一些例外情况外,模型通常在 C-CUB 的 Swapped 拆分上的表现较差,而在 C-Flowers 上的趋势相反。我们推测这样的差异可能来自于每个数据集的标题中固有的上下文信息有多少。更具体地说,即使存在未见过的组合,模型仍然可能能够根据标题中的其他描述推断出鸟或花的类别/类型,从而使模型能够生成相当正确的图像,而不一定理解新颖组合。在 C-CUB 中,上下文线索可能更强烈,使得 Swapped 拆分更加令人困惑,而在 C-Flowers 中,句子的上下文可能不太能明确指示花的类型,因此在 Swapped 拆分上表现更好。

不同方法(DMGAN、ControlGAN和DF-GAN)的趋势大致一致。对于 DMGAN 和 ControlGAN,CLIP-R-Precision 的分数明显低于 R-Precision,这是因为 DAMSM 既用于训练模型又用于评估 R-Precision。相反,DF-GAN 在训练时不使用 DAMSM 损失,因此 R-Precision 和 CLIP-R-Precision 的结果是可比较的但更低。因此,使用 DAMSM 损失进行优化通常会提高基于检索的评估指标,但会使模型偏向于 R-Precision。我们提出的 CLIP-R-Precision 是一种更客观、无偏的用于评估图像正确性的指标。

在比较 Color 和 Shape 拆分时,趋势总体上是相似的。在 C-CUB 上,DMGAN 和 ControlGAN 在形状上往往稍微做得更好,而 DF-GAN 则稍差一些。在 C-Flowers 上,结果是混合的。我们并没有看到 Color 或 Shape 一致地更具挑战性。

5.2 人工评估

接下来,我们研究自动评估指标的发现是否得到了人工评估的确认。我们关注 Seen 和 Swapped 拆分,以减少任何额外的混淆因素。所有图像都是由 DMGAN 模型生成的,这是三种方法中表现最佳的一种。我们使用 Amazon Mechanical Turk 分别评估生成图像的感知质量和正确性。

感知评估。我们从以下拆分中各采样 100 个标题-图像对:C-CUB Color Seen/Swapped,C-CUB Shape Seen/Swapped,C-Flowers Color Seen/Swapped,C-Flowers Shape Seen/Swapped。我们通过将 Seen 和 Swapped 拆分中对应于原始标题及其交换变体的图像配对来设计我们的任务(评估过程中不使用标题)。我们要求工作者回答 “哪个图像看起来更真实?” 选项有图像 1、图像2 或差不多。对于每个任务,我们要求 5 名工作者提供其判断。结果在表 4 中呈现。我们报告两个指标:“All” 独立计算所有 500 个任务;“Majority” 在 100 个图像对上计算,其中一张图像 “获胜” 如果至少有 3 名评审员同意。有趣的是,对于 Color 拆分,从 Seen 标题生成的图像得分更高,而对于 Shape 拆分则相反。我们认为 “Swapped” 生成的图像可能看起来真实,尽管不准确。

正确性评估。现在,我们的目标是回答本文的关键问题:基于含有 unseen 短语的标题生成的图像是否正确描绘了输入的描述?我们依赖于上述相同的数据。在这里,每个任务包括两个标题(Seen 和 Swapped)和一张图像。一张图像可以根据 Seen 或 Swapped 标题生成。在这里,我们问工作者:“哪个标题更匹配这个图像?” 答案选择有标题 1、标题 2 或差不多。直觉是,如果图像是正确生成的(相对于标题),那么应该能够将其与其标题匹配(而不是与干扰标题匹配)。对于每个任务,我们从 5 名工作者那里收集判断。表 5 报告了 “Seen” 和 “Swapped” 图像与其相应标题匹配的准确性。“All” 在每个拆分上计算了 500 个任务(100 x 5);对于 “Majority”,如果至少有 3 名评审员将图像与其自己的标题匹配,则图像准确性为 1,否则为 0(每个拆分 100 个任务)。在这里,我们清楚地看到 “Swapped” 图像相对于其标题的准确性较低,这明显低于 “Seen”图像的准确性。我们注意到,即使是在形状 Swapped 样本中,根据人类评审的感知质量更好,但在图像正确性方面仍明显落后于相应的形状 Seen 样本。

总的来说,正确性评估清楚地显示了质量的下降,而感知评估则没有那么明显。与前一节中的自动评估结果相比,再次看到正确性结果是一致的,而感知质量结果则较不一致。

自动分数与人工分数之间的相关性。在这里,我们评估 DAMSM 和 CLIP 嵌入(用于计算我们自动评估中的 R-Precision 和 CLIP-R-Precision)与正确性评估中的人工分数的一致性。给定一张图像和两个标题,每个标题如果被 5 名评审员中的 m 个选择,则其得分为 m/5。接下来,我们基于DAMSM 和 CLIP 嵌入计算相应的分数。最后,我们计算 Pearson 相关系数和 Spearman 相关系数,它们分别是两组数据之间线性相关性和单调相关性的度量。我们的结果在表 6 和表 7 中呈现。表 6 中的 Pearson 相关性得分较低,因为 CLIP/DAMSM 相似性得分与人工评估得分预期是单调但不一定是线性的。此外,我们还在表 8 中计算了人工评估者和模型之间的二元决策一致性。对于每对 Seen 和 Swapped 标题以及根据 Seen 或 Swapped 标题生成的图像,人工评审员和模型都会做出二元选择(即 “Seen 标题更匹配图像而不是 Swapped 标题” 或 “Swapped 标题更匹配图像而不是 Seen 标题”)。我们计算人工评审员和模型在二元决策中达成共识的百分比。我们还报告了人工评审员之间的一致性。每次,在五名评审员中留下一名评审员,计算 “留下的评审员” 和其他四名评审员的平均分数之间的 Pearson/Spearman 相关系数和二元决策一致性。五个相关性分数,每个都将一名评审员作为 “留下的评审员”,被平均以获得最终分数。基于相关性和共识分析,我们得出结论:CLIP-based 分数与人工分数的相关性比 DAMSM-based 分数更高。我们意识到这两种评估指标都远非完美,这体现在相对较低的相关性分数上。然而,我们的工作为寻找评估文本到图像合成模型正确性的改进方向提供了潜在的方向。

5.3 定性分析

在图 2 中,我们展示了由 DMGAN 合成的图像,给定包含已见形容词-名词对的文本输入与它们的交换变体(使用固定的潜在编码)。每一行对应于在 C-CUB Color/Shape 或 C-Flowers Color/Shape 数据拆分上训练的 DMGAN 模型。从 Seen 标题生成的图像在第 1、3 和 5 列;对于Swapped 标题,图像在第 2、4 和 6 列。(更多示例请参见补充材料。)

在许多情况下,从交换标题生成的图像不能准确描绘它们的标题。在某些情况下,标题中的未见交换形容词-名词对不仅在输出图像中错误地表示其自己的相应子区域,而且还降低了其他子区域的正确性。例如,在 C-CUB Color(顶行)的第一个示例中,描述中的 “蓝眼睛” 导致 “嘴” 和 “头” 的颜色也变成了 “蓝色”。这可能是由于模型学到的不同属性或身体部位之间的纠缠关系,揭示了差劲的组合泛化的原因。

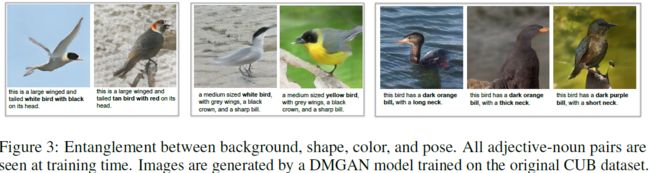

为了进一步调查这个问题,我们查看了在 CUB 数据集的原始(非组合)训练拆分上训练的DMGAN 模型。我们从多个输入描述中生成图像,其中在训练期间所有形容词-名词对都是已见的。然后,我们手动交换输入标题中的一个或两个属性,并从相同的潜在编码生成图像,如图 3 所示。请注意,交换标题中的所有形容词-名词对在训练期间也都是已见的。在这里,我们观察到背景、身体形状、颜色、姿势等之间存在纠缠关系(例如,“长颈” 通常导致 “水鸟” 的图像,“一只白鸟带有灰色翅膀” 通常出现在 “海滩” 上,而 “黄色的鸟” 则栖息在 “树枝” 上)。这揭示了即使是非组合场景也存在纠缠问题。我们假设一个有效的解纠缠方法可以帮助解决文本到图像合成模型的纠缠和组合性问题。

6. 讨论和更广泛的影响

在这项工作中,我们建立了一个基准,评估和分析文本到图像合成方法相对于概念新组合的泛化能力。我们为 CUB 和 Oxford-102 数据集(C-CUB和C-Flowers)创建了新的数据拆分,专门设计用于评估和诊断模型对新组合的泛化能力。我们还提出了一种新的评估指标,名为 CLIP-R-Precision,它提供了对图像正确性的更客观的度量。我们在提出的组合数据拆分和评估指标上评估了三种最先进的方法,DMGAN、ControlGAN 和 DF-GAN。

我们工作的一个局限性是在我们的基准研究中只包含了三种文本到图像合成方法。未来的工作应考虑更多的方法,这可能会导致更有趣的分析和发现。研究除颜色和形状之外的其他类型的组合也是值得研究的,比如对象和对象关系的新组合。

这是第一项为组合文本到图像合成建立基准的工作。我们希望这将激发未来改进文本到图像生成中的组合性的工作。在新组合上表现良好的模型也将更容易受用户控制,且更少带有偏见。这样的模型有潜力用于自动艺术设计和图像编辑。然而,图像合成技术应该谨慎使用,因为如果用于生成可能误导人们的虚假图像,可能会构成威胁。在从输入文本生成图像的同时进行对象、属性、动作和场景的新组合,可能导致虚假新闻,其中虚构的故事与看起来逼真的合成图像完美匹配。例如,有人可能宣称在地球上发现了外星生物,或者通过发布一张从未发生过的动作的恶意图像来攻击某人的声誉。在本文中,我们研究了鸟类和花卉的对象和属性的新组合,但这项研究可以扩展到其他类型的组合和其他数据集和背景。我们敦促研究人员和用户注意此类后果。最后,我们使用了大规模基于 Web 的 CLIP 模型 [38] 作为我们度量的一部分,该模型可能编码了一些不适当的偏见,这可能会传播到我们的度量中。我们提醒采用我们基于 CLIP 的度量的研究人员要确保在敏感领域中不会通过所提出的度量传播有害/冒犯性的偏见。

S. 总结

S.1 主要贡献

本研究专注于评估生成的图像在特别具有挑战性的新颖组合场景中对输入文本的保真度,提出了关于零样本组合拆分的文本到图像生成的第一次系统研究。在现有的 CUB 和 Oxford Flowers 数据集的基础上创建了新的基准。还提出了一种基于 CLIP 模型的新度量标准,CLIP-R-Precision。相比于先前工作中使用的指标,CLIP-R-Precision 与人类判断更一致。

S.2 新基准

本文提出了基于 Caltech-UCSD Birds(CUB)数据集和 Oxford-102(Flowers)数据集的新基准,使用人工生成的标题进行增强。具体而言,在两种情况下,测试集包括:

- 已见的图像-标题对(其中形容词-名词对已经出现在训练集中)

- 未见的对(其中形容词-名词对未出现在训练集中)

- 交换对(通过将已见的形容词-名词对与未见的形容词-名词对交换而生成)

S.3 评估指标

Fre´chet Inception Distance(FID)通常用于评估合成图像的质量和多样性。

Recall-Precision 评估合成图像的正确性。

- 该指标衡量基于生成的图像,是否可以从一组干扰项中检索出原始描述。

- 检索的文本-图像相似度分数是使用 Deep Attentional Multimodal Similarity Model (DAMSM) 计算的,该模型包括一个图像编码器和一个文本编码器,将图像的每个子区域及其在句子中对应的单词映射到联合嵌入空间。该模型在来自训练数据的真实图像-文本对上进行了预训练,并测量了用于检索的细粒度图像-文本相似性。

- 然而,大多数文本到图像合成模型直接优化了用于计算 R-Precision 的 DAMSM 模块。这导致了专门针对基于 DAMSM 评估度量进行优化的文本到图像生成系统,使 R-Precision 指标具有模型特定性,使得未经专门调整 DAMSM 模块的模型可能在该指标上表现较差,从而使该指标较不客观。

为了缓解这个问题,提出了 CLIP-R-Precision,它基于 CLIP 执行文本到图像检索。与 DAMSM 相比,CLIP 有更高的图像-文本检索性能。相比于先前工作中使用的指标,CLIP-R-Precision 与人类判断更一致。