vslam论文24:ESVIO: 基于事件相机的双目VIO(RAL 2023)

摘要

异步输出低延迟事件流的事件相机为具有挑战性的情况下的状态估计提供了很大的机会。尽管近年来基于事件的视觉里程测量技术得到了广泛的研究,但大多数都是基于单目的,而对立体事件视觉的研究很少。在本文中,我们介绍了ESVIO,这是第一个基于事件的立体视觉惯性里程计,它利用了事件流、标准图像和惯性测量的互补优势。我们建议的pipeline包括ESIO(纯基于事件的)和ESVIO(带有图像辅助的事件),它们实现了连续立体事件流之间的空间和时间关联。设计良好的后端紧密耦合融合了多传感器测量,得到了鲁棒状态估计。我们验证了ESIO和ESVIO在公共和自收集数据集上与其他基于图像和基于事件的基线方法相比具有优越的性能。此外,我们使用我们的pipeline在低光环境下执行机载四旋翼飞行。自动驾驶数据序列和现实世界的大规模实验也进行了验证,以证明长期有效性。我们强调,这项工作是一个实时,准确的系统,旨在在具有挑战性的环境下进行鲁棒状态估计。

关键词---视觉惯性SLAM,传感器融合,航空系统:感知和自主。

一、引言

在本文中,据我们所知,我们提出了第一个已发表的基于事件的双目视觉惯性里程计(ESVIO)。

主要研究成果如下:

(1)为了实现在剧烈性运动和弱光场景下的鲁棒状态估计,提出了基于滑动窗口图形优化的纯事件立体惯性里程计(ESIO) pipeline ,并进一步扩展了将双目事件流、双目图像帧和IMU紧密集成在一起的图像辅助(ESVIO) pipeline 。

(2)为了解决基于事件的双目特征跟踪与匹配问题,在连续双目事件流中设计了基于几何的时空数据关联。空间和时间约束保证了状态估计的准确性和可靠性。此外,设计了一种运动补偿方法,通过扭曲每个事件来强调场景的边缘。

(3)我们评估了我们的ESVIO可以在公开可用的数据集上实现最先进的性能。我们还发布了一个非常具有挑战性的基于事件的VO/VIO数据集,具有剧烈性运动和HDR场景。最后,我们使用我们的ESVIO作为估计器进行机载闭环四旋翼飞行。

二、相关工作

A.基于事件的单目视觉里程计

近年来,基于事件的单目视觉里程计在具有挑战性的场景中得到了广泛的研究。[7]是第一个使用特征轨迹来实现基于事件的VO的工作,其首先从灰度帧中检测特征,然后异步地使用事件流跟踪特征。EVO[2]提出了一种基于单目事件的并行跟踪和映射理念,该理念采用图像到模型的对齐进行跟踪,并采用基于事件的多视图立体(EMVS)[8]进行映射。[9]提出了第一个基于事件的VIO,该VIO解决了尺度的不完全估计,并基于扩展卡尔曼滤波器(EKF)提供了精确的6自由度状态估计。[10]基于事件流的时空窗口获得离散的状态数,并引入虚拟事件帧来实现非线性优化,从而细化估计姿态。Ultimate SLAM[3]利用事件相机与标准相机的互补优势,将事件流、图像帧和IMU测量与非线性优化相结合,进一步推进了上述研究。[11]采用基于三次样条的连续时间框架进行光滑轨迹估计,将事件流和IMU融合在一起。DEVO[12]提出了一种基于深度相机和事件相机混合设置的新型VO,该VO通过阈值化时间-表面图构建半密集深度图。EKLT- vio[13]将最先进的基于事件的精确特征跟踪器EKLT[14]与EKF后端集成在一起,实现了类火星数据集的基于事件的状态估计。[15]提出了一种基于图优化的实时单目事件VIO,直接利用异步原始事件进行特征检测。PL-EVIO[4]对上述方法进行了扩展,利用标准相机和事件相机的互补优势,将基于事件的点特征、基于事件的线特征、基于图像的点特征和IMU测量紧密结合在一起。

B.基于事件的双目视觉里程计

相较于单目VO需要足够的视差来恢复角点特征的深度,立体VO可以直接获得当前时间点的特征深度。解决了视差不足导致的尺度不确定性,甚至跟踪失败的问题。然而,目前关于立体事件相机的研究大多集中在深度估计和构建半密集或密集地图[16],[17]等方面,对VO/SLAM领域的研究较少。ESVO[5]提出了第一个基于事件的立体VO流水线,通过最大化立体事件流的时空一致性,实现了三维半密集映射线程和跟踪线程的并行化。[6]采用立体特征检测和几何匹配方法,采用重投影误差最小化实现姿态估计。然而,这些算法仅仅使用事件来估计状态,当系统处于静止状态时可能导致跟踪失败。此外,上述方法如果不结合IMU,可能会导致在无纹理区域下视觉轨迹的丢失。我们的工作填补了将立体事件流、立体图像帧和IMU结合在一起的空白,它可以在高分辨率事件流下实时运行,并且比以前提出的方法性能更好。

三、方法

由于图像测量的过程与事件流的过程非常相似,所以我们在本节中只介绍ESIO。我们的框架的核心在于预处理使用运动补偿的原始事件流(Section III-A)和连续双目事件流在时间和空间上的数据关联(Section III-B)。之后,我们设计了基于事件的图优化约束(Section III-C)。ESIO的流水线可以用ESVIO表示(如图2所示),无需基于图像的处理。

图2:我们的ESVIO and ESIO pipeline的结构

A.事件流运动补偿

运动补偿通过对齐对应于同一场景边缘的事件来校正弯曲的事件流。[18]只利用IMU的角速度来实现旋转补偿,而忽略了平移的影响。[19]分别通过IMU和深度相机实现旋转和平移补偿。我们设计了一种运动补偿方法来校正每个原始事件的位置,该方法使用来自IMU传感器的角速度和来自ESVIO后端的线速度来分别实现旋转和平移补偿。由于我们的运动补偿利用了后端估计的速度,它在初始化成功后工作。

图3对比了原始事件流和运动补偿事件流,其中原始事件流产生一定程度的失真,而补偿的事件流显示出清晰的场景轮廓。

图3:没有和有运动补偿的事件流。

B.基于事件的时空数据关联

运动补偿后,将双目事件流馈送生成两个(正负)活动事件曲面(SAE),该曲面存储事件像素和时间戳。对于新的到达事件流,首先通过LK光学方法对已有的事件角特征进行时间跟踪,然后在左右事件流中进行空间匹配。在当前时间戳中没有成功跟踪和匹配的事件角特征将被立即丢弃。在提取新的事件角特征时,运动补偿事件流在每个时间戳中保持最小数量(100-200)的特征。对Arc*算法[21]的公开实现进行了改进,用于基于事件的角点检测,我们利用SAE提取单个事件的事件角点。我们只选择时间戳与当前时间面间隔较短的事件,从而在密集的事件流中保留事件角特征。为了减少噪声事件的影响,我们进一步采用带极性的时间面作为掩模来过滤有效的事件角特征,并将时间面实时转换为SAE。同时,TS还通过设置最小距离d来均匀分布相邻的事件角点特征,基于事件的时空关联的几何原理如图4(a)所示。为了确保左右事件流之间的匹配特征位于极线上,我们即时匹配双目校正的时间面进行空间关联。双目事件角特征Fi 1和Fi 1在当前时间点i的左右时间面之间被正向和反向LK光流即时匹配。我们的ESVIO在每一帧执行空间和时间关联。同时,时间关联还利用正向光流和反向光流跟踪连续两个时间戳i和j的左侧事件流Fi 1和Fj 1的事件角特征。图4(b)中,红色点和蓝色点分别表示时间戳i时刻左右时间面提取的事件角特征,黄色点表示前一个时间戳j时刻左侧时间面提取的事件角特征。注意,左下角和右下角的图片形成了基于空间事件的关联,而左下角和左上角的图片形成了基于时间事件的关联。绿线将同一时间点左右时间面之间匹配的事件角特征连接起来,黄线将跟踪特征与i和j两个连续的左侧时间面连接起来。图4(c)和图1底部显示,即使由于运动模糊导致基于图像的跟踪失败,我们提出的方法也可以在连续的立体事件角特征中实现正确的时空关联,最后,通过RANSAC离群值抑制和三角剖分,恢复了事件角点特征的逆深度。如图4(a)所示,上的三维点P的匹配角特征。左右事件相机在时间戳i处的成像平面分别为L和R。P的逆深度可以通过极极几何和piL和pir之间的三角剖分来表示。同样,piL和pjL也可以用来恢复逆深度。基于这些关联的事件角点特征,可以构造相应的残差约束进行基于图的优化。

图4:双目事件角特征:(a)几何原理;(b)时间表面上事件角特征在时间和空间上的关联;(c) Eventcorner功能跟踪事件流。

C.图优化中基于事件的残差约束的构造

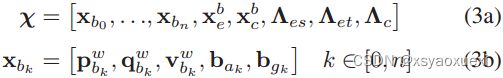

滑动窗口中的完整状态向量定义为

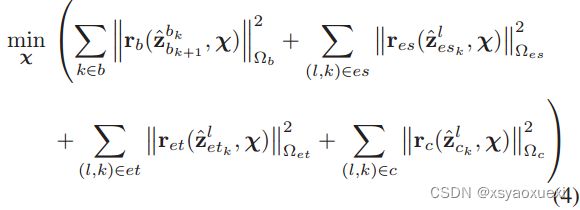

结合事件项、图像项和IMU残差项,事件视惯性里程计可表述为如下的联合非线性优化问题

对于双目事件相机,我们构建了左右事件流之间的空间关联因子![]() 和连续事件流中的时间关联因子

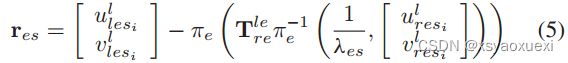

和连续事件流中的时间关联因子![]() 。考虑右侧第i个事件流中观测到的第l个特征,左侧第i个事件流中观测到的事件角特征的残差定义为:

。考虑右侧第i个事件流中观测到的第l个特征,左侧第i个事件流中观测到的事件角特征的残差定义为:

考虑左第i个事件流中首次观测到的第l个特征,则左第k个事件流中观测到的事件角特征的残差定义为:

IV. 评估

A.在具有挑战性的情况下评估我们的ESVIO

1)实验数据说明:

完整的设置包括附加的红外滤波器可以在图5中看到。

图5:我们自己设计的四旋翼平台

2)方法评估:

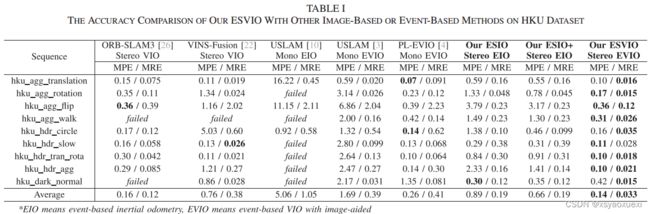

表1比较了我们的ESIO和ESVIO与其他最先进的基于事件或基于映像的系统的性能。我们的ESIO具有良好的性能,特别是对于序列hku_agg_walk和hku_dark_normal,即使在最先进的基于图像的VIO方法ORB-SLAM3失败时,我们的ESIO仍然可以产生可靠和准确的姿态估计。

B.我们的ESVIO在公共数据集上的评估

如表2所示,我们提出的ESVIO可以在大多数序列中获得相当好的结果。虽然ORB-SLAM3的MPE标准在某些序列(例如机器人正常,桌面正常,山地正常)中略好于我们的,但我们的ESVIO在大多数具有HDR或攻击性运动的恶劣情况下的序列中提供了更可靠和准确的结果。所提出的ESVIO比我们以前的PL-EVIO更精确,特别是在大规模环境中,这可能是由于更好的事件角深度估计。而传统的基于事件的方法[2],[3],[5]在这两个数据集中的大多数序列中都失败了。

表3展示了我们的模块在不同分辨率下的运行时间。我们还在随附的视频和补充材料中提供了我们的方法与其他方法的定性比较

C.室内四旋翼飞行评估

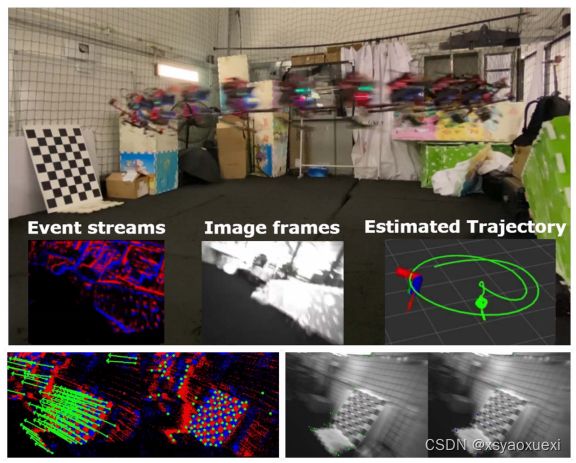

图1:我们的ESVIO为攻击性运动下的无人机提供了强大而准确的实时姿态反馈。事件提供了丰富而可靠的特征,而只有少数特征在高速运动的图像帧中被跟踪。左下:基于立体事件的特征跟踪。右下:基于立体图像的特征跟踪。

D.户外大规模评估

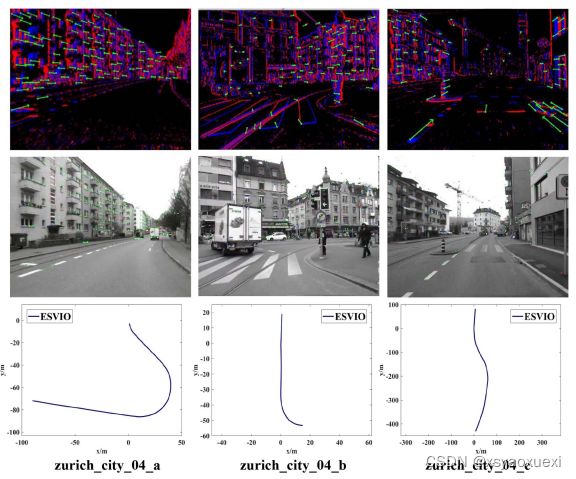

图7:ESVIO在DSEC数据集中对序列zurich_city_04 (a)至(c)的定性结果。图1:立体事件角特征跟踪性能;中:基于立体图像的特征跟踪性能;下图:由我们的ESVIO产生的估计轨迹。

图8:我们的ESVIO在大尺度环境下的估计轨迹。对实验过程中立体事件角特征和立体图像特征的检测与跟踪情况进行了可视化。

从图8可以看出,我们的ESVIO在长期运动评估中表现良好,估计的轨迹是对齐的,几乎与谷歌地图一致。

五、结论

在本文中,我们提出了一个鲁棒的、实时的基于事件的双目VIO, ESVIO,它使用基于滑动窗口的图形优化紧密融合了双目事件流、双目图像帧和IMU测量。基于几何的空间和时间连续双目事件流之间的关联被设计为确保鲁棒状态估计。此外,运动补偿方法利用IMU和ESVIO后端对弯曲的事件流进行校正,以强调场景的轮廓。广泛的评估表明,与其他最先进的算法相比,我们的ESVIO在公共数据集和我们自己收集的具有挑战性的数据集上取得了卓越的性能。此外,我们还使用所提出的ESVIO在低光场景和攻击性运动下进行各种机载闭环飞行。在我们未来的工作中,我们可能会进一步探索基于事件的四旋翼系统映射,它应该能够支持自主导航和避障。