- 理解Gunicorn:Python WSGI服务器的基石

范范0825

ipythonlinux运维

理解Gunicorn:PythonWSGI服务器的基石介绍Gunicorn,全称GreenUnicorn,是一个为PythonWSGI(WebServerGatewayInterface)应用设计的高效、轻量级HTTP服务器。作为PythonWeb应用部署的常用工具,Gunicorn以其高性能和易用性著称。本文将介绍Gunicorn的基本概念、安装和配置,帮助初学者快速上手。1.什么是Gunico

- swagger访问路径

igotyback

swagger

Swagger2.x版本访问地址:http://{ip}:{port}/{context-path}/swagger-ui.html{ip}是你的服务器IP地址。{port}是你的应用服务端口,通常为8080。{context-path}是你的应用上下文路径,如果应用部署在根路径下,则为空。Swagger3.x版本对于Swagger3.x版本(也称为OpenAPI3)访问地址:http://{ip

- 高级编程--XML+socket练习题

masa010

java开发语言

1.北京华北2114.8万人上海华东2,500万人广州华南1292.68万人成都华西1417万人(1)使用dom4j将信息存入xml中(2)读取信息,并打印控制台(3)添加一个city节点与子节点(4)使用socketTCP协议编写服务端与客户端,客户端输入城市ID,服务器响应相应城市信息(5)使用socketTCP协议编写服务端与客户端,客户端要求用户输入city对象,服务端接收并使用dom4j

- PHP环境搭建详细教程

好看资源平台

前端php

PHP是一个流行的服务器端脚本语言,广泛用于Web开发。为了使PHP能够在本地或服务器上运行,我们需要搭建一个合适的PHP环境。本教程将结合最新资料,介绍在不同操作系统上搭建PHP开发环境的多种方法,包括Windows、macOS和Linux系统的安装步骤,以及本地和Docker环境的配置。1.PHP环境搭建概述PHP环境的搭建主要分为以下几类:集成开发环境:例如XAMPP、WAMP、MAMP,这

- 使用 FinalShell 进行远程连接(ssh 远程连接 Linux 服务器)

编程经验分享

开发工具服务器sshlinux

目录前言基本使用教程新建远程连接连接主机自定义命令路由追踪前言后端开发,必然需要和服务器打交道,部署应用,排查问题,查看运行日志等等。一般服务器都是集中部署在机房中,也有一些直接是云服务器,总而言之,程序员不可能直接和服务器直接操作,一般都是通过ssh连接来登录服务器。刚接触远程连接时,使用的是XSHELL来远程连接服务器,连接上就能够操作远程服务器了,但是仅用XSHELL并没有上传下载文件的功能

- git - Webhook让部署自动化

大猪大猪

我们现在有一个需求,将项目打包上传到gitlab或者github后,程序能自动部署,不用手动地去服务器中进行项目更新并运行,如何做到?这里我们可以使用gitlab与github的挂钩,挂钩的原理就是,每当我们有请求到gitlab与github服务器时,这时他俩会根据我们配置的挂钩地扯进行访问,webhook挂钩程序会一直监听着某个端口请求,一但收到他们发过来的请求,这时就知道用户有请求提交了,这时

- Linux查看服务器日志

TPBoreas

运维linux运维

一、tail这个是我最常用的一种查看方式用法如下:tail-n10test.log查询日志尾部最后10行的日志;tail-n+10test.log查询10行之后的所有日志;tail-fn10test.log循环实时查看最后1000行记录(最常用的)一般还会配合着grep用,(实时抓包)例如:tail-fn1000test.log|grep'关键字'(动态抓包)tail-fn1000test.log

- Python多线程实现大规模数据集高效转移

sand&wich

网络python服务器

背景在处理大规模数据集时,通常需要在不同存储设备、不同服务器或文件夹之间高效地传输数据。如果采用单线程传输方式,当数据量非常大时,整个过程会非常耗时。因此,通过多线程并行处理可以大幅提升数据传输效率。本文将分享一个基于Python多线程实现的高效数据传输工具,通过遍历源文件夹中的所有文件,将它们移动到目标文件夹。工具和库这个数据集转移工具主要依赖于以下Python标准库:os:用于文件系统操作,如

- 笋丁网页自动回复机器人V3.0.0免授权版源码

希希分享

软希网58soho_cn源码资源笋丁网页自动回复机器人

笋丁网页机器人一款可设置自动回复,默认消息,调用自定义api接口的网页机器人。此程序后端语言使用Golang,内存占用最高不超过30MB,1H1G服务器流畅运行。仅支持Linux服务器部署,不支持虚拟主机,请悉知!使用自定义api功能需要有一定的建站基础。源码下载:https://download.csdn.net/download/m0_66047725/89754250更多资源下载:关注我。安

- 深入浅出 -- 系统架构之负载均衡Nginx的性能优化

xiaoli8748_软件开发

系统架构系统架构负载均衡nginx

一、Nginx性能优化到这里文章的篇幅较长了,最后再来聊一下关于Nginx的性能优化,主要就简单说说收益最高的几个优化项,在这块就不再展开叙述了,毕竟影响性能都有多方面原因导致的,比如网络、服务器硬件、操作系统、后端服务、程序自身、数据库服务等,对于性能调优比较感兴趣的可以参考之前《JVM性能调优》中的调优思想。优化一:打开长连接配置通常Nginx作为代理服务,负责分发客户端的请求,那么建议开启H

- 最简单将静态网页挂载到服务器上(不用nginx)

全能全知者

服务器nginx运维前端html笔记

最简单将静态网页挂载到服务器上(不用nginx)如果随便弄个静态网页挂在服务器都要用nignx就太麻烦了,所以直接使用Apache来搭建一些简单前端静态网页会相对方便很多检查Web服务器服务状态:sudosystemctlstatushttpd#ApacheWeb服务器如果发现没有安装web服务器:安装Apache:sudoyuminstallhttpd启动Apache:sudosystemctl

- 阿里云服务器4核8G配置购买及价格类文章汇总(10篇)

阿里云最新优惠和活动汇总

阿里云服务器4核8G配置如何购买?价格是多少?4核8G配置的阿里云服务器可以通过云服务器产品页购买也可以通过阿里云活动去下单购买,一般通过活动购买的用户比较多,但是不同实例规格的阿里云服务器价格不一样,带宽不同价格也不一样,本文为大家汇总了10篇关于阿里云服务器4核8G配置购买教程文章和价格类文章,分为购买类文章和价格类文章,以供大家参考如何购买阿里云服务器4核8G配置和最新优惠价格是多少。阿里云

- windows下python opencv ffmpeg读取摄像头实现rtsp推流 拉流

图像处理大大大大大牛啊

opencv实战代码讲解视觉图像项目windowspythonopencv

windows下pythonopencvffmpeg读取摄像头实现rtsp推流拉流整体流程1.下载所需文件1.1下载rtsp推流服务器1.2下载ffmpeg2.开启RTSP服务器3.opencv读取摄像头并调用ffmpeg进行推流4.opencv进行拉流5.opencv异步拉流整体流程1.下载所需文件1.1下载rtsp推流服务器下载RTSP服务器下载页面https://github.com/blu

- NPM私库搭建-verdaccio(Linux)

Beam007

npmlinux前端

1、安装nodelinux服务器安装nodea)、官网下载所需的node版本https://nodejs.org/dist/v14.21.0/b)、解压安装包若下载的是xxx.tar.xz文件,解压命令为tar-xvfxxx.tar.xzc)、修改环境变量修改:/etc/profile文件#SETPATHFORNODEJSexportNODE_HOME=NODEJS解压安装的路径exportPAT

- [实验室服务器使用]使用VSCode、PyCharm、MobaXterm和CMD连接远程服务器

YuanDaima2048

工具使用服务器vscodepycharmcmd代理模式机器学习实验

文章总览:YuanDaiMa2048博客文章总览实验室服务器使用:使用VSCode、PyCharm、MobaXterm和CMD连接远程服务器在进行实验室工作时,远程连接服务器是常见的需求之一。本篇文章根据个人的一些使用介绍使用不同工具连接服务器的方法,并提供优化功能,使服务器能够使用本机代理的说明。准备服务器账号信息Host(主机):10.XXX.XX.XXXPort(端口):[SSHPort]U

- L1 L2 L3 缓存

京天不下雨

windows缓存windows

L1L2L3缓存L1Cache(一级bai缓存)是CPU第一层高速缓存,分为数据缓存和指令缓存。du内置的zhiL1高速缓存的容量和结构对daoCPU的性能影响较大,不过高速缓冲存储器均由静态RAM组成,结构较复杂,在CPU管芯面积不能太大的情况下,L1级高速缓存的容量不可能做得太大。一般服务器CPU的L1缓存的容量通常在32—4096KB。L2由于L1级高速缓存容量的限制,为了再次提高CPU的运

- golang实现从服务器下载文件到本地指定目录

余生逆风飞翔

golang服务器开发语言

一、连接服务器,采用sftp连接模式packagemiddlewaresimport("fmt""time""github.com/pkg/sftp""golang.org/x/crypto/ssh")//建立服务器连接funcConnect(user,password,hoststring,portint)(*sftp.Client,error){var(auth[]ssh.AuthMethod

- 鲲鹏 ARM 架构 麒麟 Lylin v10 安装 Nginx (离线)

焚木灵

arm开发架构nginx服务器

最近做一个银行的项目,银行的服务器是鲲鹏ARM架构的服务器,并且是麒麟v10的系统,这里记录一下在无法访问外网安装Nginx的方法。其他文章:鲲鹏ARM架构麒麟Lylinv10安装Mysql8.3(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装Node和NVM(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装Pm2(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装P

- Nginx之代理模块 ngx_http_proxy_module

途径日暮不赏丶

nginxnginx

正向代理正向代理是指位于客户机(A)和站点服务器(B)之间的代理服务器(C),为了从站点服务器(B)获取资源,客户机(A)向代理服务器(C)发送请求并指定站点服务器(B),然后代理服务器(C)向站点服务器(B)转交请求并将获取的资源返回给客户机(A)。上述这样的代理模式称为正向代理,正向代理最大的特点:客户端非常明确要访问的服务器地址;服务器只清楚请求来自哪个代理服务器,而不清楚来自哪个具体的客户

- 导致格式错误的 Lambda 代理响应的原因以及如何修复它

zqhdz米时空

汇编

当人们尝试使用AWSAPIGateway和AWSLambda构建无服务器应用程序时,经常出现的一个问题是_由于配置错误而执行失败:Lambda代理响应格式错误。_没有什么比通用错误消息更糟糕的了,它们不会告诉您解决问题所需的任何内容,对吧?AWS并不是以其错误消息设计而闻名,如果甚至可以这样称呼它的话,更不用说为您提供解决问题的方法了。那么如何修复这个Lambda错误以及是什么原因造成的呢?花椒壳

- 网关gateway学习总结

猪猪365

学习总结学习总结

一微服务概述:微服务网关就是一个系统!通过暴露该微服务的网关系统,方便我们进行相关的鉴权,安全控制,日志的统一处理,易于监控的相关功能!实现微服务网关技术都有哪些呢?1nginx:nginx是一个高性能的http和反向代理web的服务器,同事也提供了IMAP/POP3/SMTP服务.他可以支撑5万并发链接,并且cpu,内存等资源消耗非常的低,运行非常的稳定!2Zuul:Zuul是Netflix公司

- Nginx之ngx_http_proxy_connect_module模块

小米bb

Nginxnginxhttp运维

近期由于项目需要使用到https正向代理,而nginx官方模块仅支持做http正向代理,一番百度学习后发现了该模块,故今日记录下此笔记供大家一起学习交流ngx_http_proxy_connect_module模块主要用于隧道SSL请求的代理服务器GitHub地址:http://www.github.com/chobits/ngx_http_proxy_connect_modulenginx配置:

- Nginx:高性能的Web服务器与反向代理

张某布响丸辣

nginx前端服务器javaSpringBoot

在当今的互联网世界中,Web服务器的选择对于网站的性能、稳定性和安全性至关重要。Nginx(发音为“engineX”)凭借其卓越的性能、丰富的功能集和灵活的配置选项,成为了众多网站和应用程序的首选Web服务器和反向代理。本文将深入探讨Nginx的特点、应用场景、基本配置以及它如何助力你的Web项目。Nginx简介Nginx是一个开源的、高性能的HTTP和反向代理服务器,也是一个IMAP/POP3/

- Android shell 常用 debug 命令

晨春计

Audiodebugandroidlinux

目录1、查看版本2、am命令3、pm命令4、dumpsys命令5、sed命令6、log定位查看APK进程号7、log定位使用场景1、查看版本1.1、Android串口终端执行getpropro.build.version.release#获取Android版本uname-a#查看linux内核版本信息uname-r#单独查看内核版本1.2、linux服务器执行lsb_release-a#查看Lin

- 解决SDK Manager 中 没有 Support Library

木鱼wzh

1、直接修改SDK-MANAGER打开sdk-manager—->Tools—->options然后点击packages—->showobsoletepackages即可在最下面的Extras目录下找到推荐两个自己使用的镜像服务器:mirrors.neusoft.edu.cn端口80mirrors.dormforce.net端口802、去官网下载SupportLibrar点击这里进入官网进入百度云

- Nginx从入门到实践(三)

听你讲故事啊

动静分离动静分离是将网站静态资源(JavaScript,CSS,img等文件)与后台应用分开部署,提高用户访问静态代码的速度,降低对后台应用访问。动静分离的一种做法是将静态资源部署在nginx上,后台项目部署到应用服务器上,根据一定规则静态资源的请求全部请求nginx服务器,达到动静分离的目标。rewrite规则Rewrite规则常见正则表达式Rewrite主要的功能就是实现URL的重写,Ngin

- Nginx的使用场景:构建高效、可扩展的Web架构

张某布响丸辣

nginx前端架构

Nginx,作为当今最流行的Web服务器和反向代理软件之一,凭借其高性能、稳定性和灵活性,在众多Web项目中扮演着核心角色。无论是个人博客、中小型网站,还是大型企业级应用,Nginx都能提供强大的支持。本文将探讨Nginx的几个主要使用场景,帮助读者理解如何在实际项目中充分利用Nginx的优势。1.静态文件服务对于包含大量静态文件(如HTML、CSS、JavaScript、图片等)的网站,Ngin

- 【nginx】ngx_http_proxy_connect_module 正向代理

等风来不如迎风去

网络服务入门与实战nginxhttp运维

50.65无法访问服务器,(403错误)50.196可以访问服务器。那么,配置65通过196访问。需要一个nginx作为代理【nginx】搭配okhttp配置反向代理发送原生的nginx是不支持okhttp的CONNECT请求的。大神竟然给出了一个java工程GINX编译ngx_http_proxy_connect_module及做正向代理是linux构建的。是windows构建的:编译Windo

- 第三十一节:Vue路由:前端路由vs后端路由的了解

曹老师

1.认识前端路由和后端路由前端路由相对于后端路由而言的,在理解前端路由之前先对于路由有一个基本的了解路由:简而言之,就是把信息从原地址传输到目的地的活动对于我们来说路由就是:根据不同的url地址展示不同的页面内容1.1后端路由以前咱们接触比较多的后端路由,当改变url地址时,浏览器会向服务器发送请求,服务器根据这个url,返回不同的资源内容后端路由的特点就是前端每次跳转到不同url地址,都会重新访

- 非关系型数据库

天秤-white

nosql

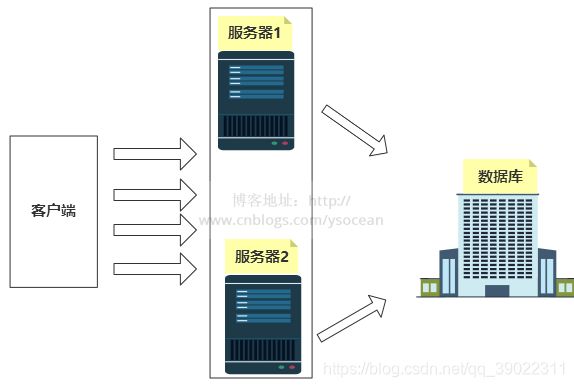

一、为什么要用Nosql1.单机MySQL的时代。一个基本的网站访问量一般不会太大,单个数据库完全足够。那时候更多使用的静态网页html,服务器根本没有太大压力。这时候网站的瓶颈是什么?-数据量如果太大,一个机器放不下。-数据量太大需要建立数据的索引(B+Tree),一个服务器内存放不下。-访问量读写混合,一个服务器承受不了。2.memcached缓存+MySQL+垂直拆分(读写分离)。网站80%

- 继之前的线程循环加到窗口中运行

3213213333332132

javathreadJFrameJPanel

之前写了有关java线程的循环执行和结束,因为想制作成exe文件,想把执行的效果加到窗口上,所以就结合了JFrame和JPanel写了这个程序,这里直接贴出代码,在窗口上运行的效果下面有附图。

package thread;

import java.awt.Graphics;

import java.text.SimpleDateFormat;

import java.util

- linux 常用命令

BlueSkator

linux命令

1.grep

相信这个命令可以说是大家最常用的命令之一了。尤其是查询生产环境的日志,这个命令绝对是必不可少的。

但之前总是习惯于使用 (grep -n 关键字 文件名 )查出关键字以及该关键字所在的行数,然后再用 (sed -n '100,200p' 文件名),去查出该关键字之后的日志内容。

但其实还有更简便的办法,就是用(grep -B n、-A n、-C n 关键

- php heredoc原文档和nowdoc语法

dcj3sjt126com

PHPheredocnowdoc

<!doctype html>

<html lang="en">

<head>

<meta charset="utf-8">

<title>Current To-Do List</title>

</head>

<body>

<?

- overflow的属性

周华华

JavaScript

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/xhtml&q

- 《我所了解的Java》——总体目录

g21121

java

准备用一年左右时间写一个系列的文章《我所了解的Java》,目录及内容会不断完善及调整。

在编写相关内容时难免出现笔误、代码无法执行、名词理解错误等,请大家及时指出,我会第一时间更正。

&n

- [简单]docx4j常用方法小结

53873039oycg

docx

本代码基于docx4j-3.2.0,在office word 2007上测试通过。代码如下:

import java.io.File;

import java.io.FileInputStream;

import ja

- Spring配置学习

云端月影

spring配置

首先来看一个标准的Spring配置文件 applicationContext.xml

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi=&q

- Java新手入门的30个基本概念三

aijuans

java新手java 入门

17.Java中的每一个类都是从Object类扩展而来的。 18.object类中的equal和toString方法。 equal用于测试一个对象是否同另一个对象相等。 toString返回一个代表该对象的字符串,几乎每一个类都会重载该方法,以便返回当前状态的正确表示.(toString 方法是一个很重要的方法) 19.通用编程:任何类类型的所有值都可以同object类性的变量来代替。

- 《2008 IBM Rational 软件开发高峰论坛会议》小记

antonyup_2006

软件测试敏捷开发项目管理IBM活动

我一直想写些总结,用于交流和备忘,然都没提笔,今以一篇参加活动的感受小记开个头,呵呵!

其实参加《2008 IBM Rational 软件开发高峰论坛会议》是9月4号,那天刚好调休.但接着项目颇为忙,所以今天在中秋佳节的假期里整理了下.

参加这次活动是一个朋友给的一个邀请书,才知道有这样的一个活动,虽然现在项目暂时没用到IBM的解决方案,但觉的参与这样一个活动可以拓宽下视野和相关知识.

- PL/SQL的过程编程,异常,声明变量,PL/SQL块

百合不是茶

PL/SQL的过程编程异常PL/SQL块声明变量

PL/SQL;

过程;

符号;

变量;

PL/SQL块;

输出;

异常;

PL/SQL 是过程语言(Procedural Language)与结构化查询语言(SQL)结合而成的编程语言PL/SQL 是对 SQL 的扩展,sql的执行时每次都要写操作

- Mockito(三)--完整功能介绍

bijian1013

持续集成mockito单元测试

mockito官网:http://code.google.com/p/mockito/,打开documentation可以看到官方最新的文档资料。

一.使用mockito验证行为

//首先要import Mockito

import static org.mockito.Mockito.*;

//mo

- 精通Oracle10编程SQL(8)使用复合数据类型

bijian1013

oracle数据库plsql

/*

*使用复合数据类型

*/

--PL/SQL记录

--定义PL/SQL记录

--自定义PL/SQL记录

DECLARE

TYPE emp_record_type IS RECORD(

name emp.ename%TYPE,

salary emp.sal%TYPE,

dno emp.deptno%TYPE

);

emp_

- 【Linux常用命令一】grep命令

bit1129

Linux常用命令

grep命令格式

grep [option] pattern [file-list]

grep命令用于在指定的文件(一个或者多个,file-list)中查找包含模式串(pattern)的行,[option]用于控制grep命令的查找方式。

pattern可以是普通字符串,也可以是正则表达式,当查找的字符串包含正则表达式字符或者特

- mybatis3入门学习笔记

白糖_

sqlibatisqqjdbc配置管理

MyBatis 的前身就是iBatis,是一个数据持久层(ORM)框架。 MyBatis 是支持普通 SQL 查询,存储过程和高级映射的优秀持久层框架。MyBatis对JDBC进行了一次很浅的封装。

以前也学过iBatis,因为MyBatis是iBatis的升级版本,最初以为改动应该不大,实际结果是MyBatis对配置文件进行了一些大的改动,使整个框架更加方便人性化。

- Linux 命令神器:lsof 入门

ronin47

lsof

lsof是系统管理/安全的尤伯工具。我大多数时候用它来从系统获得与网络连接相关的信息,但那只是这个强大而又鲜为人知的应用的第一步。将这个工具称之为lsof真实名副其实,因为它是指“列出打开文件(lists openfiles)”。而有一点要切记,在Unix中一切(包括网络套接口)都是文件。

有趣的是,lsof也是有着最多

- java实现两个大数相加,可能存在溢出。

bylijinnan

java实现

import java.math.BigInteger;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class BigIntegerAddition {

/**

* 题目:java实现两个大数相加,可能存在溢出。

* 如123456789 + 987654321

- Kettle学习资料分享,附大神用Kettle的一套流程完成对整个数据库迁移方法

Kai_Ge

Kettle

Kettle学习资料分享

Kettle 3.2 使用说明书

目录

概述..........................................................................................................................................7

1.Kettle 资源库管

- [货币与金融]钢之炼金术士

comsci

金融

自古以来,都有一些人在从事炼金术的工作.........但是很少有成功的

那么随着人类在理论物理和工程物理上面取得的一些突破性进展......

炼金术这个古老

- Toast原来也可以多样化

dai_lm

androidtoast

Style 1: 默认

Toast def = Toast.makeText(this, "default", Toast.LENGTH_SHORT);

def.show();

Style 2: 顶部显示

Toast top = Toast.makeText(this, "top", Toast.LENGTH_SHORT);

t

- java数据计算的几种解决方法3

datamachine

javahadoopibatisr-languer

4、iBatis

简单敏捷因此强大的数据计算层。和Hibernate不同,它鼓励写SQL,所以学习成本最低。同时它用最小的代价实现了计算脚本和JAVA代码的解耦,只用20%的代价就实现了hibernate 80%的功能,没实现的20%是计算脚本和数据库的解耦。

复杂计算环境是它的弱项,比如:分布式计算、复杂计算、非数据

- 向网页中插入透明Flash的方法和技巧

dcj3sjt126com

htmlWebFlash

将

Flash 作品插入网页的时候,我们有时候会需要将它设为透明,有时候我们需要在Flash的背面插入一些漂亮的图片,搭配出漂亮的效果……下面我们介绍一些将Flash插入网页中的一些透明的设置技巧。

一、Swf透明、无坐标控制 首先教大家最简单的插入Flash的代码,透明,无坐标控制: 注意wmode="transparent"是控制Flash是否透明

- ios UICollectionView的使用

dcj3sjt126com

UICollectionView的使用有两种方法,一种是继承UICollectionViewController,这个Controller会自带一个UICollectionView;另外一种是作为一个视图放在普通的UIViewController里面。

个人更喜欢第二种。下面采用第二种方式简单介绍一下UICollectionView的使用。

1.UIViewController实现委托,代码如

- Eos平台java公共逻辑

蕃薯耀

Eos平台java公共逻辑Eos平台java公共逻辑

Eos平台java公共逻辑

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年6月1日 17:20:4

- SpringMVC4零配置--Web上下文配置【MvcConfig】

hanqunfeng

springmvc4

与SpringSecurity的配置类似,spring同样为我们提供了一个实现类WebMvcConfigurationSupport和一个注解@EnableWebMvc以帮助我们减少bean的声明。

applicationContext-MvcConfig.xml

<!-- 启用注解,并定义组件查找规则 ,mvc层只负责扫描@Controller -->

<

- 解决ie和其他浏览器poi下载excel文件名乱码

jackyrong

Excel

使用poi,做传统的excel导出,然后想在浏览器中,让用户选择另存为,保存用户下载的xls文件,这个时候,可能的是在ie下出现乱码(ie,9,10,11),但在firefox,chrome下没乱码,

因此必须综合判断,编写一个工具类:

/**

*

* @Title: pro

- 挥洒泪水的青春

lampcy

编程生活程序员

2015年2月28日,我辞职了,离开了相处一年的触控,转过身--挥洒掉泪水,毅然来到了兄弟连,背负着许多的不解、质疑——”你一个零基础、脑子又不聪明的人,还敢跨行业,选择Unity3D?“,”真是不自量力••••••“,”真是初生牛犊不怕虎•••••“,••••••我只是淡淡一笑,拎着行李----坐上了通向挥洒泪水的青春之地——兄弟连!

这就是我青春的分割线,不后悔,只会去用泪水浇灌——已经来到

- 稳增长之中国股市两点意见-----严控做空,建立涨跌停版停牌重组机制

nannan408

对于股市,我们国家的监管还是有点拼的,但始终拼不过飞流直下的恐慌,为什么呢?

笔者首先支持股市的监管。对于股市越管越荡的现象,笔者认为首先是做空力量超过了股市自身的升力,并且对于跌停停牌重组的快速反应还没建立好,上市公司对于股价下跌没有很好的利好支撑。

我们来看美国和香港是怎么应对股灾的。美国是靠禁止重要股票做空,在

- 动态设置iframe高度(iframe高度自适应)

Rainbow702

JavaScriptiframecontentDocument高度自适应局部刷新

如果需要对画面中的部分区域作局部刷新,大家可能都会想到使用ajax。

但有些情况下,须使用在页面中嵌入一个iframe来作局部刷新。

对于使用iframe的情况,发现有一个问题,就是iframe中的页面的高度可能会很高,但是外面页面并不会被iframe内部页面给撑开,如下面的结构:

<div id="content">

<div id=&quo

- 用Rapael做图表

tntxia

rap

function drawReport(paper,attr,data){

var width = attr.width;

var height = attr.height;

var max = 0;

&nbs

- HTML5 bootstrap2网页兼容(支持IE10以下)

xiaoluode

html5bootstrap

<!DOCTYPE html>

<html>

<head lang="zh-CN">

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">