Sound Spaces 2.0: A Simulation Platform for Visual-Acoustic Learning(2022)

SoundSpaces2.0:一个用于视觉-声学学习的模拟平台(2022)

摘要

我们将介绍SoundSpaces 2.0,这是一个用于三维环境中基于几何体的动态音频渲染平台。

给定真实世界环境的3D网格,SoundSpace可以为从任意麦克风位置捕获的任意声音生成高度逼真的声学效果。与现有的3D视觉资产一起,它支持一系列视听研究任务,如视听导航、映射、源定位和分离以及声学匹配。

与现有资源相比,SoundSpaces 2.0具有以下优势:允许连续空间采样、新环境的通用性(泛化到新环境),以及可配置的麦克风和材料特性。

据我们所知,这是第一次基于几何的声学模拟,它提供了高保真度和真实感,同时也足够快,可用于具体化学习。我们展示了模拟器的特性,并根据真实世界的音频测量对其性能进行了基准测试。

此外,通过两项下游任务,涵盖了嵌入式导航和远场自动语音识别,突出了后者的sim2real性能。SoundSpaces 2.0是公开的,以促进对既能看到又能听到的感知系统的更广泛研究。

研究内容

我们的所见所闻支配着我们的感知体验,这两种方式之间往往有着密切的关系。

在物体级别,我们可以根据物体的外观预测其发出的声音,反之亦然(狗吠、门砰砰关、婴儿哭)。

在环境层面,我们看到的周围3D空间的材料和几何结构改变了到达我们耳朵的声音。例如,一个人在大理石地板、高天花板的博物馆里讲话,听起来与在舒适的铺着地毯的书店里讲话截然不同。

在3D空间中对视觉和声学之间的对应关系进行建模对于嵌入式AI和增强/虚拟现实(AR/VR)中的许多应用至关重要。例如,救援机器人需要定位呼救者;服务机器人需要observations和倾听,以了解咖啡机是否正常运行;AR系统需要生成与用户的声学环境一致的声音,以获得身临其境的体验。

第一人称感知体验的真实模拟是人工智能研究的宝贵资源。它们允许以可复制的方式大规模训练和评估模型。在视觉方面,近年来,快速视觉模拟器[58,68]与扫描现实世界环境[11,76,66,54]中的3D资产相结合,促进了视觉导航和相关任务的大量工作[75,12,6,30,55,33],实现了严格的基准[1],甚至成功地将“sim2real”传输到在真实世界中移动的代理[74,71,35]。

在音频方面,传统上一直在为物理模型[9]、游戏[43]和建筑设计[73]进行声学模拟,通常仅限于简单的参数化几何图形,并且与视觉环境隔离。为了将这两种模式结合起来进行联合视听模拟,最近的工作提供了初步步骤[14,21]。

SoundSpaces[14]提供了高度逼真的房间脉冲响应(RIR),通过对Replica[66]和Matterport3D[11]中的100个真实多房间环境网格的双向路径跟踪获得,而ThreeDWorld[21]使用Unity3D视频游戏平台中的物理模拟来模拟物体碰撞、撞击声音和环境混响。

这些工具支持导航[22,17,14,15,12,45]、平面图重建[53]、特征学习[23]、视听混响[16,13]和视听碰撞检测[20]方面的一系列新研究。这些早期平台虽然鼓舞人心,但也有一些局限性。

SoundSpaces的最大限制是其预先计算的离散化性质。为0.5m网格上的所有源和接收器对以及100个总环境的固定列表预先计算提供的RIR。这将防止在新位置采样数据。这反过来意味着

- 模拟器中的代理只能在空间中的离散网格点之间移动或跳跃,这将抽象出导航任务的一些困难部分;

- 模拟并没有推广到新的环境,只是提供了100个;

- 预先计算的数据本身在TBs量级上,阻碍了改变配置(例如麦克风类型或材料)的能力。

三维世界(ThreeDWorld)提供连续空间渲染,但它仅支持简单3D环境几何体的音频渲染,因此,过度简化的“鞋盒”(矩形平行六面体)模型不适用于真实扫描数据集[76,54]。

总之,当今的视听渲染平台在准确性、速度和灵活性方面都存在不足,这反过来又限制了它们能够支持的研究任务的范围,如视听体现学习[12,17]或视觉声学学习[65,44,13]。

在这项工作中,我们介绍了SoundSpaces 2.0,它为任意环境执行基于动态几何的音频渲染。

它允许对用户选择的波形的任意摄像机视图和任意麦克风位置进行高度逼真渲染,考虑了所有主要的真实世界声学因素:直接声音、早期镜面反射/漫反射、混响、双耳空间化以及材料和空气吸收的频率相关效应(如图1所示)。

Table 1: 与现有非商业数据集/模拟平台的比较。几何(Geometric)是指基于物体和空间的几何结构的声学模拟。可配置(Configurable)意味着能够改变模拟参数、材料和麦克风性能。“任意环境”(Arbitrary Env)指的是为任意新网格环境进行渲染的能力,包括在野外生成的点云。

此外,SoundSpaces 2.0将音频模拟推广到任何输入网格,使得首次可以将声音导入使用良好的环境资产,如Gibson[76]、HM3D[54]和Matterport3D[11],以及任何未来或新兴的环境资产(如Ego4D[25])。

此外,SoundSpaces 2.0允许用户配置模拟的各种属性,如源接收器位置、模拟参数、材料属性和麦克风配置。渲染平台和相关研究代码库将公开。

在本文中,我们描述了新平台及其功能,并通过各种具体示例说明了其灵活性(另请参见补充视频)。此外,我们还进行了系统的实验,以回答两个问题:1)视听模拟的准确性如何?以及2)在SoundSpaces 2.0中训练的机器学习模型能在多大程度上推广到真实世界数据?为此,我们收集了公共场景数据集副本的真实音频RIR测量值[66],并对模拟精度进行了基准测试。

我们还对两个下游任务进行了基准测试:连续视听导航和远场语音识别。

对于语音识别,我们展示了在合成数据上训练的机器学习模型在真实数据上测试时可以推广。我们提出了一种声学随机化技术,对材料声学特性的真实分布进行建模,并证明了该策略可以实现更好的sim2real泛化。

最后,除了渲染引擎本身,它很容易与Habitat集成[58],我们还发布了SoundSpaces PanoIR:一个大型图像数据集,与Soundspace 2.0中计算的RIR配对;这个准备好的数据集可以以独立的方式促进视觉声学学习的未来研究(无需与模拟器本身连接)。

提出的方法&模型架构

SoundSpaces2.0视听渲染平台

Rendering Pipeline and Simulation Enhancements 渲染管道和仿真增强功能

SoundSpaces 2.0的核心是我们为研究目的发布的音频传播引擎(RLR音频传播)。我们将该引擎集成到现有的视觉模拟器Habitat Sim[58],该模拟器提供快速视觉渲染。

此外,我们还为各种下游任务(如导航)提供高级API,并在SoundSpaces repo提供培训脚本。图1示出了传播管道。

RLR音频传播采用Habitat处理的场景网格数据,以及用户指定的源和接收器位置,并使用双向路径跟踪算法计算房间脉冲响应(RIR)[10]。

本模块模拟各种声学现象,包括反射、透射和衍射,以及空间化。模拟在M个对数间隔的频带(可配置)中运行,在该频带中,它以音频采样率计算能量-时间直方图。

该直方图使用球谐函数为每个时间样本合并空间信息,该时间样本表示到达声能的方向分布。然后将该表示空间化为双声或双耳压力脉冲响应[64],该响应可与源音频信号卷积,以在接收器位置生成声音。有关更多详细信息,请参阅补充。

与原始SoundSpaces相比,我们在几个方面改进了模拟。SoundSpaces不包括任何声学绕射模拟,因此表现出源的突然遮挡。我们使用[63]中的快速衍射方法消除了这一限制,该方法能够有效计算遮挡源的平滑衍射效应。

我们还改进了直接混响比(DRR)的精度,即定向声源发出的直接声音的声压级与混响声压级之比,方法是将偏差固定为√4π,存在于原始声空间的间接声压中。在下文中,我们将概述SoundSpaces 2.0中促进连续性、可配置性、通用性和性能的建模进展。

Figure 1:SoundSpaces 2.0在多房间多楼层HM3D[54]环境中的渲染说明。在这个场景中,一个男孩在客厅看电视,而他的妈妈在楼下的厨房叫他吃饭。我们对声音从所有来源(电视和mom)传播到him的各种频率相关声学现象进行建模,包括直接声音、反射、混响、传输、衍射和空气吸收(direct sound, reflection, reverb, transmission, diffraction and air absorption)。声音传播基于双向路径跟踪算法,该算法将场景的几何结构以及空间中物体的材质作为输入。接收到的声音通过与头部相关的传递函数(HRTF)被空间化为双耳声音。因此,SoundSpaces 2.0使用空间和声学对应来渲染视觉和音频observations。例如,电视位于更靠近右耳的位置导致右耳信号比左耳信号强。

Continuity 连续性

Configurability 可置配性

Generalizability 普遍性

场景数据集的泛化。我们的新模拟器可容纳任意三维网格作为输入。这使得它与所有可用的场景数据集(例如,Gibson[76]、HM3D[54]、Ego4D[25]、Matterport3D[11]、副本[66])以及任何未来可用的资产兼容,例如,如果用户扫描自己的实验室或家庭环境。这是相对于仅限于复制和Matterport3D的SoundSpaces的重要进步。有关生成的示例的视频,请参见补充。

对现实世界的概括。我们仿真平台的逼真度和灵活性也支持对真实世界的概括。在第5节中,我们根据真实世界的RIR对模拟器输出进行评分,并展示在SoundSpaces 2.0上训练的机器学习模型如何推广到真实数据。

Rendering Modes and Rendering Performance 渲染模式和渲染性能

我们的模拟生成基于网格和材质的高质量音频渲染,这种逼真度可用于某些研究领域。

另一方面,在具有强化学习的嵌入式导航等任务中,通常需要数百万次(甚至数十亿次[75])的训练迭代,渲染速度至关重要。因此,我们提供两种内置渲染模式:高速和高质量。

在高速模式下,我们在假设运动在空间上连续的情况下,通过利用先前计算的脉冲响应[61],减少射线数量并提高精度。我们的算法使用在先前模拟帧上计算的信息,如声音传播路径和RIR,以减少每个帧上需要的光线数量和光线反弹,以获得足够的声音质量。

在高质量模式下,我们将所有渲染参数设置为最大,并关闭时间相干特性,以确保每个脉冲响应都是准确的,不会出现时间模糊。我们的引擎是多线程的,用户可以在使用任一模式时设置线程数。关于速度和精度方面的模拟性能分析,请参见第5.1节。

数据集

Large-scale SoundSpaces-PanoIR Dataset(大规模的SoundSpaces-PanoIR数据集)

我们发布了SoundSpaces 2.0,作为一个通用平台,用户可以通过该平台动态生成observations结果(尤其与具体的人工智能模型相关),或填充自己设计的新离线数据集。

作为后者的一个例子,为了便于希望在没有代理交互层的情况下处理视觉和声学场景数据的研究人员采用,我们接下来使用SoundSpaces 2.0构建一个称为SoundSpages PanoIR的大规模数据集,将IRs与图像相耦合。对于视觉-声学学习任务,如视听去冗余[16]和基于视觉的合成声学[13,65,44],由于数据收集的高成本和复杂性,目前没有大规模精确的图像红外数据集。

我们的SoundSpaces PanoIR数据集拥有来自Matterport3D、Gibson和HM3D数据集750个环境的1M全景图像和IR对。我们以以下格式提供数据:全景图(RGB/深度)、红外、源相对于全景图中心的极坐标。

图2示出了Gibson中的一个示例。有关更多示例和统计信息,请参见补充。我们还将共享数据生成脚本。

Figure 2: Gibson[76]上渲染的SoundSpaces-PanoIR数据集示例。我们渲染全景RGB和深度图像以捕获场景几何图形。我们提供了图像、脉冲响应和点源位置相对于当前相机姿态的坐标。

评估&基线

接下来,我们使用两个机器学习基准来评估下游任务的模拟质量及其价值。图3a示出了这两个任务。

Figure 3: (a)在本例中,当一个人在客厅时,他的电话在餐厅响起,她要求机器人把电话带给她。通过双耳麦克风接收音频信号后,机器人需要弄清楚两件事:1)她在说什么(远场自动语音识别),2)如何导航到她和手机(视听导航)。请注意,远场ASR不限于机器人技术;它有各种应用,如视频字幕。(b) 比较Replica公寓[66]中7个测量位置和250Hz至4000Hz频带的真实测量和模拟。与 SoundSpaces相比, SoundSpaces 2.0的直接混响比(DRR)误差要小得多。(c) 能量衰减曲线比较。 SoundSpaces2.0的能量衰减曲线比 SoundSpaces更接近实际测量值。

Simulation Speed vs. Quality Tradeoff 模拟速度vs. 质量的权衡

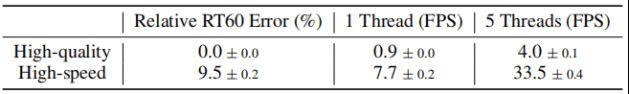

为了理解渲染质量与速度之间的权衡,我们通过在20 Matterport3D环境中沿平均长度为15米的随机轨迹渲染RIR来报告不同模式的精度和速度。我们在Xeon(R)Gold 6230 CPU上配置了2.10GHz的速度。见表2。

关于精度,我们测量了高速模式下生成的RIR与高质量模式下生成RIR的相对RT60误差。RT60是一种标准声学测量,定义为声压级降低60 dB所需的时间[29]。我们发现,与高质量模式相比,高速模式大大提高了效率,单线程提高了8倍,5线程提高了33倍,尽管RT60计算存在噪声,但仅损失了9.5%的精度。当与分布式训练相结合时,它满足了当今RL agent训练的要求。

此外,我们在高质量模式下测试了在高速模式下训练的导航模型;与表3中高速模式下的测试性能相比,性能差异小于1%。我们将高质量模式视为金标准,并将其质量与真实IRs进行比较。

表2:模拟速度vs.质量之间的权衡。我们报告了超过5次运行的平均值和标准偏差。

Table 3:连续视听导航基准。DTG代表距离目标的距离。我们通过对1个随机种子进行训练并对3个随机种子进行评估来报告平均值和标准差。

Validating Simulation Accuracy with Real IRs 用真实红外线谱验证仿真精度

我们的音频模拟有多逼真?

为了量化这一点,我们从复制数据集[66]中收集了FRL公寓的真实声学测量值,并将其与SoundSpaces 2.0输出进行比较。使用全向B&K 4295型扬声器(100Hz至8kHz频率响应)和采用指数正弦扫描法的土方工程M30话筒,在整个真实公寓的七个不同的源/接收器位置捕获IR测量。这些测量结果也将公布,以协助未来的研究。

图3b将原始SoundSpaces和提议的SoundSpaces2.0(高质量模式)的测量结果与相同源/接收器位置的相应模拟结果进行了比较。

我们报告了直接混响比(DRR)声学参数,这些参数来自图3b中的脉冲响应[29]。SoundSpaces 2.0具有更好的直接混响比匹配,与测量值相比,平均误差从11.0 dB降低到0.98 dB,同时保持12.4%的相同相对RT60误差(见补充)。

图3c强调了这一优势,绘制了从250Hz到4000Hz的模拟与实际测量的能量-时间曲线。总体而言,拟议的新功能和改进提高了声学模拟的真实感。

Benchmark 1: Continuous Audio-Visual Navigation 基准1:连续视听导航

在未映射的环境中定位声源有许多现实应用,例如救援机器人或服务机器人(例如,找到呼救者或电话铃声)。最初在[14]中引入的视听导航任务(AV Nav)正通过2021和2022年CVPR的公开竞赛获得更广泛社区的关注。8然而,由于其对SoundSpaces的依赖,AV NAW到目前为止必须假设代理沿着离散网格旅行。由于缺少碰撞和隐含的完美定位,导航任务因此更容易。

在这里,我们介绍由SoundSpaces 2.0仿真支持的连续AV导航任务。在此任务中,代理可以以1米/秒的速度每步向前移动0.15米,或者向左/向右旋转10度。如果代理在球门1米半径范围内发出停止动作,则该插曲视为成功。重要的是,代理不仅在连续空间中移动,还接收声学连续音频信号(参见第3.2节)。

我们使用高速渲染模式。我们将现有的视听导航(AV Nav)代理[14]推广为配备DD-PPO的分布式视听导航(DAV Nav)代理人[75],以加快训练过程。我们在AudioGoal导航数据集上进行训练和测试[14]。为了消除第3.1节中详述的模拟改进,对于SoundSpaces基线,我们使用增强模拟中渲染的数据在Soundspace的离散设置上训练DAV Nav;动作空间与训练期间相同。

表3显示了使用成功率、通过路径长度(SPL)归一化的成功率和到目标的距离的标准度量的结果。如果只有空间是连续的,则在SoundSpaces上训练的DAV导航代理的成功率和SPL平均为64.2%和27.5%,而在SoundSpaces2.0上训练的代理的成功度和SPL分别为64.7%和49.3%。这表明空间连续性主要损害代理的效率,而不是其成功率;尽管存在更多冲突,代理仍然可以导航到源。然而,当声音在声学上连续时,基线的性能会下降。这可能是因为代理依赖于音频中始终存在(不准确)的直接声音提示,而在连续声音渲染中,直接声音始终与环境中的混响混合,使导航更加困难。

相比之下,在SoundSpaces 2.0上训练的代理实现了更高的成功率,并且平均更接近目标位置。这表明,必须对AV Nav的空间和声学连续性进行建模,SoundSpaces 2.0实现了这一点。此外,回想一下SoundSpaces 2.0为探索AV导航打开了任何其他3D场景数据集,而以前仅适用于副本或Matterport3D。

Table 4: Far-field automatic speech recognition benchmark.表4:远场自动语音识别基准测试。

Benchmark 2: Far-Field Automatic Speech Recognition 基准测试2:远场自动语音识别

语音识别对于许多应用至关重要,包括扬声器远离麦克风的远场场景(例如,与智能家庭助理设备通话)。当在干净的语音语料库(如LibriSpeech[52])上训练语音识别模型时,它们很难推广到具有意外混响的远场情况。

由于收集真实IRs的费用很高,因此合成脉冲响应通常用于增强远场ASR的语音[36,46,69]。在这里,我们建议对通过我们生成的脉冲响应增强的远场ASR系统进行基准测试。我们采用SpeechBrain[56]提供的基于预训练变压器的ASR系统作为基础模型,SpeechBrain[56]是一个开源语音工具包。对于微调,我们使用在不同系统中生成的IRs和微调60个时期来增强LibriSpeech[52]的train-clean-100分割中的语音。为了进行测试,我们从真实的RIR数据集[67]中扩增语音,其中IRs记录在真实环境中,例如家庭、会议室和礼堂。通过这种方式,我们测试了基于合成数据训练的模型的sim2real泛化。我们将预训练模型与在热声和SoundSpaces2.0(高质量模式)生成的IRs上微调的ASR模型进行比较。表4显示了结果。

正如我们所见,预训练模型对远场语音的推广效果很差,单词错误率(WER)为29.1%,而在没有任何混响的干净测试集上,WER为2.4%。使用合成IRs进行微调可带来显著改善。将热声声学与SoundSpaces 2.0进行比较,我们生成的IRs的WER要低得多。我们的模拟生成了更真实的IRs,有助于机器学习模型更好地概括现实。

声学随机化。在现实世界中,给定物体类别的实例不需要共享相同的材质轮廓。虽然现有的模拟没有对这些细微差别进行建模,但在SoundSpaces 2.0中,我们可以以更微妙的方式操纵材质。受域随机化技术[71,72]的启发,我们将模拟参数随机化,以实现更好的sim2real泛化,并探索声学随机化是否提供类似的好处。具体来说,我们为每个物体类别定义了一组可能的声学材质。渲染时,为类别拾取随机材质以模拟类别级别变化。此外,为了模拟声学材料的差异,我们在每个系数中添加N(0,0.1)高斯噪声。总之,该策略对类别级和实例级的材料细微差别进行建模。当我们使用所提出的声学随机化技术生成相同数量的数据进行微调时,ASR模型在测试集上的功率更低,从12.48%降低到12.04%,而均匀随机化,即0和1之间的均匀采样系数,导致功率更高,为12.58%。这不仅显示了声学随机化的好处,还显示了SoundSpaces 2.0的可配置性如何促进声学sim2real的研究。

结论

我们介绍了SoundSpaces 2.0,这是一个针对3D环境的基于动态几何的音频渲染平台。

我们收集了公共3D场景中的真实测量数据,以验证模拟精度。我们对两项任务进行了基准测试,结果表明,在此模拟上训练的系统可以推广到真实世界。

值得注意的是,除了这两项任务外,我们的平台还将支持升级文献[12、17、44、31、53、65]中目前探讨的许多其他任务。

最后,我们发布了一个大型SoundSpaces全景数据集,可用于研究。我们将公开模拟和真实测量,以促进视觉声学学习的研究。