- 《基于图神经网络的安卓应用检测系统设计与实现》开题报告

大数据蟒行探索者

毕业论文/研究报告神经网络android人工智能机器学习大数据深度学习python

个人主页:@大数据蟒行探索者目录一、课题的研究目的和意义1.研究目的2.研究意义二、国内(外)研究现状及分析1.国内研究现状2.国外研究现状3.研究分析三、课题主要研究内容及可行性分析1.研究内容2.可行性分析四、研究方案和技术途径1.研究方案2.技术途径五、外部条件及解决办法1.开发环境2.解决办法六、主要参考文献一、课题的研究目的和意义1.研究目的随着智能手机的普及,安卓操作系统成为全球最为广

- 大数据和人工智能概念全面解析

就犯得上方法

一、大数据和人工智能大数据是伴随着信息数据爆炸式增长和网络计算技术迅速发展而兴起的一个新型概念。根据麦肯锡全球研究所的定义,大数据是一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。大数据能够帮助各行各业的企业从原本毫无价值的海量数据中挖掘出用户的需求,使数据能够从量变到质变,真正产生价值

- 一文搞懂大数据神器Spark,真的太牛了!

qq_23519469

大数据spark分布式

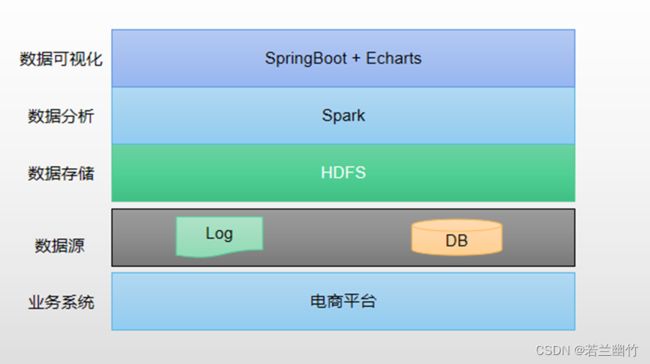

Spark是什么在如今这个大数据时代,数据量呈爆炸式增长,传统的数据处理方式已经难以满足需求。就拿电商平台来说,每天产生的交易数据、用户浏览数据、评论数据等,数量巨大且种类繁多。假如要对这些数据进行分析,比如分析用户的购买行为,找出最受欢迎的商品,预测未来的销售趋势等,用普通的单机处理方式,可能需要花费很长时间,甚至根本无法完成。这时,Spark就应运而生了。Spark是一个开源的、基于内存计算的

- 数据湖:Apache Iceberg在腾讯的探索和实践

学而知之@

数据库腾讯大数据java编程语言

摘要:今天分享的是ApacheIceberg在腾讯内部的探索和实践。本文结合腾讯大数据技术分享内容和2020全球软件开发大会分享内容进行整理,主要内容包括:1、数据湖技术概述2、ApacheIceberg的简介3、腾讯为什么选择ApacheIceberg4、腾讯看点万亿数据下的业务痛点5、ApacheIceberg在看点实践6、ApacheIceberg读写和删除ApacheIceberg新一代数

- AI 时代,学习 Java 应如何入手?

琢磨先生David

人工智能java

一、Java的现状:生态繁荣与AI融合的双重机遇在2025年的技术版图中,Java依然稳坐企业级开发的“头把交椅”。根据行业统计,Java在全球企业级应用中的市场份额仍超过65%,尤其在微服务架构、大数据平台和物联网(IoT)领域占据核心地位。随着云原生技术的普及,Java生态正经历新一轮进化:轻量化框架通过无服务器架构优化,启动速度提升300%,内存占用降低50%,使得Java在容器化部署中更具

- Apache Doris整合Iceberg + Flink CDC构建实时湖仓体的联邦查询分析架构

MfvShell

apacheflink架构Flink

随着大数据技术的迅猛发展,构建实时湖仓体并进行联邦查询分析成为了许多企业的迫切需求。在这篇文章中,我们将探讨如何利用ApacheDoris整合Iceberg和FlinkCDC来构建这样一个架构,并提供相应的源代码示例。简介实时湖仓体是一种灵活、可扩展的数据架构,结合了数据湖和数据仓库的优势。ApacheDoris是一款开源的分布式SQL引擎,专注于实时分析和查询。Iceberg是一种开放式表格格式

- Flink读取kafka数据并写入HDFS

王知无(import_bigdata)

Flink系统性学习专栏hdfskafkaflink

硬刚大数据系列文章链接:2021年从零到大数据专家的学习指南(全面升级版)2021年从零到大数据专家面试篇之Hadoop/HDFS/Yarn篇2021年从零到大数据专家面试篇之SparkSQL篇2021年从零到大数据专家面试篇之消息队列篇2021年从零到大数据专家面试篇之Spark篇2021年从零到大数据专家面试篇之Hbase篇

- Java 大视界 -- Java 大数据在智能体育赛事直播数据分析与观众互动优化中的应用(142)

青云交

大数据新视界Java大视界java大数据体育赛事直播数据分析观众互动数据采集个性化推荐

亲爱的朋友们,热烈欢迎来到青云交的博客!能与诸位在此相逢,我倍感荣幸。在这飞速更迭的时代,我们都渴望一方心灵净土,而我的博客正是这样温暖的所在。这里为你呈上趣味与实用兼具的知识,也期待你毫无保留地分享独特见解,愿我们于此携手成长,共赴新程!一、欢迎加入【福利社群】点击快速加入:青云交灵犀技韵交响盛汇福利社群点击快速加入2:2024CSDN博客之星创作交流营(NEW)二、本博客的精华专栏:大数据新视

- Apache storm

赵世炎

stormhadoop

Apachestorm是一个分布式的实时大数据处理系统。用于在容错和水平可拓展方法中处理大量数据。它是一个流数据框架,具有很高的摄取率,无状态。通过zk管理分布式环境和集群状态,并行地对实时数据执行各种操作。storm易于设置和操作,并且它保证每个消息将通过拓扑至少处理一次。基本上Hadoop和Storm框架用于分析大数据。两者互补,在某些方面有所不同。ApacheStorm执行除持久性之外的所有

- 探索电商大数据的艺术:TBBKAnalysis深度解读与应用推荐

洪显彦Lawyer

探索电商大数据的艺术:TBBKAnalysis深度解读与应用推荐TBBKAnalysis关于淘宝“爆款”数据爬取与分析。具体分析见—项目地址:https://gitcode.com/gh_mirrors/tb/TBBKAnalysis在数字化时代的数据洪流中,每一个细微的数据点都蕴含着洞察未来的机遇。今天,我们要探讨的是一个独特且极具启发性的开源项目——TBBKAnalysis。该项目源自知乎上一

- 什么是Apache Avro?

maozexijr

apache

什么是ApacheAvro?ApacheAvro是一个开源的数据序列化框架,主要用于高效的数据交换和存储。它由ApacheHadoop项目开发,广泛应用于大数据生态系统中(如Hadoop、Kafka等)。Avro提供了一种紧凑、快速的二进制数据格式,同时支持丰富的数据结构和模式演化。核心特性跨语言支持Avro支持多种编程语言(如Java、Python、C++、Go等),使得不同语言之间的数据交换变

- 计算机毕业设计之基于Hadoop的热点新闻分析系统的设计与实现

微信bishe69

课程设计pythondjangomysql

近些年来,随着科技的飞速发展,互联网的普及逐渐延伸到各行各业中,给人们生活带来了十分的便利,热点新闻分析系统利用计算机网络实现信息化管理,使整个热点新闻分析的发展和服务水平有显著提升。本文拟采用PyCharm开发工具,django框架、Python语言、Hadoop大数据处理技术进行开发,后台使用MySQL数据库进行信息管理,设计开发的热点新闻分析系统。通过调研和分析,系统拥有管理员和用户两个模块

- python爬虫项目

范哥来了

python爬虫开发语言

项目名称:国家自然科学基金大数据知识管理服务门户爬取项目爬取内容:爬取内容:资助项目爬取链接:HTTP://KD.NSFC.GOV.CN/BASEQUERY/SUPPORTQUERY为了完成“国家自然科学基金大数据知识管理服务门户”的资助项目信息爬取任务,我们需要设计一个网络爬虫。考虑到目标网站的具体情况,我们将采用Python语言结合requests库来处理HTTP请求,以及使用Beautifu

- Java 大视界 -- 基于 Java 的大数据实时流处理中的窗口操作与时间语义详解(135)

青云交

大数据新视界Java大视界java大数据大数据实时流处理窗口操作时间语义滚动窗口滑动窗口

亲爱的朋友们,热烈欢迎来到青云交的博客!能与诸位在此相逢,我倍感荣幸。在这飞速更迭的时代,我们都渴望一方心灵净土,而我的博客正是这样温暖的所在。这里为你呈上趣味与实用兼具的知识,也期待你毫无保留地分享独特见解,愿我们于此携手成长,共赴新程!一、欢迎加入【福利社群】点击快速加入:青云交灵犀技韵交响盛汇福利社群点击快速加入2:2024CSDN博客之星创作交流营(NEW)二、本博客的精华专栏:大数据新视

- Lisp语言的云存储

俞嫦曦

包罗万象golang开发语言后端

Lisp语言的云存储:构建智能化数据管理新时代引言随着信息技术的飞速发展,数据的生产和存储呈现出爆炸式增长。云存储作为一种新兴的数据管理方式,逐渐成为各行业必不可少的基础设施。尤其是在大数据、人工智能等领域,对数据的快速访问和高效存储要求尤为迫切。与此同时,Lisp语言作为一种历史悠久且具有强大表达能力的编程语言,通过其特有的特性,可以在云存储的架构设计与实现方面发挥独特的优势。本文将深入探讨Li

- 中电金信25/3/18面前笔试(需求分析岗+数据开发岗)

苍曦

需求分析前端javascript

部分相同题目在第二次数据开发岗中不做解析,本次解析来源于豆包AI,正确与否有待商榷,本文只提供一个速查与知识点的补充。一、需求分析第1题,单选题,Hadoop的核心组件包括HDFS和以下哪个?MapReduceSparkStormFlink解析:Hadoop的核心组件是HDFS(分布式文件系统)和MapReduce(分布式计算框架)。Spark、Storm、Flink虽然也是大数据处理相关技术,但

- Flink实践:通过Flink SQL进行SFTP文件的读写操作

kkk1622245

flinksql大数据

在大数据处理领域,ApacheFlink出类拔萃,它是一个高性能、易扩展、用于处理有界和无界数据流的分布式处理引擎。FlinkSQL是ApacheFlink提供的一种声明式API,允许开发者以SQL的形式,轻松实现复杂的数据流和批处理分析。本文将重点探讨如何通过FlinkSQL来实现对SFTP文件的读写操作,这是在实际应用中经常遇到的一种场景。Flink与SFTP文件的读写在很多实际应用场景中,数

- 题解 | 牛客周赛 Round 49 DEF Java题解

han_xue_feng

java

面试又黄了反正不是什么喜欢的工作[牛泪]面试又黄了反正不是什么喜欢的工作2024秋招数据开发第一波面试题露出#字节##滴滴##大数据##面经##秋招#引流字节阿里巴巴腾讯百度美团美团后端暑期实习体验——实习的一天早上:8点半出门坐地铁,9点下地铁到惠新西街南口地铁站,出地铁站坐班车(这一点还是不错的),9点30深圳阿里实习day1领工牌mac,认工位mentor,配环境看文档,七点就润了。看各个文

- Search after解决ES深度分页问题

Elastic开源社区

elasticsearch大数据searchafter深度分页ES

文章目录1、search_after的作用和意义2、search_after的工作原理3、search_after的使用方法4、注意事项5、与传统分页的对比6、总结search_after是Elasticsearch中用于实现深度分页的一种机制。相比于传统的from和size分页方式,search_after更适合处理大数据集的分页查询,因为它避免了深度分页带来的性能问题。1、search_aft

- 第七章Solr:企业级搜索应用

AGI大模型与大数据研究院

DeepSeekR1&大数据AI人工智能计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

第七章Solr:企业级搜索应用1.背景介绍1.1搜索引擎的重要性在当今信息时代,数据量呈指数级增长,海量数据中蕴含着极其宝贵的信息和知识。然而,如何快速、准确地从大数据中检索出所需的信息,一直是企业和组织面临的巨大挑战。传统的数据库查询方式已经无法满足现代搜索需求,因此高效的搜索引擎应运而生。1.2什么是SolrApacheSolr是一个高性能、可扩展、云就绪的企业级搜索平台,由Apache软件基

- 金融租赁系统的创新发展与市场竞争力提升探讨

红点租赁系统开发

其他

内容概要随着经济的快速发展,金融租赁系统逐渐成为金融市场中不可或缺的一环。它不仅提供了灵活的资金解决方案,还促进了企业的资本结构优化与资源配置效率。因此,了解该系统的市场背景与发展现状至关重要。在现今环境下,新兴技术如人工智能、大数据和区块链等正加速推动金融租赁的创新。通过这些技术,不仅可以优化业务流程,提升运营效率,还可以增强风险管理能力。例如,利用数据分析可以实时监测租赁资产的风险,从而采取相

- 分块查找算法

1haooo

算法java算法开发语言数据结构

分块的原则前一块的最大数据,小于后一窥啊中所有的数据(块内无序,块间有序)块数数量一般等于数字的个数开根号。比如:16个数字一般分为4块左右。publicclassblockSearch{publicstaticvoidmain(String[]args){int[]arr={16,5,9,12,21,18,32,23,37,26,45,34,50,48,61,52,73,66};//共18个元素

- MongoDB数据库使用及常见问题

微笑的曙光(StevenLi)

数据库数据库mongodb

MongoDB数据库之所以备受青睐,关键在于其独特的优势满足了现代应用的需求。它采用文档型存储,数据结构灵活,无需事先定义表结构,非常适合处理复杂且多变的数据。MongoDB具备高性能和可扩展性,能够轻松应对大数据量和高并发的访问,通过分片技术实现水平扩展,确保系统稳定运行。同时,它提供了强大的数据一致性和可靠性保障,支持多种复制和故障转移机制,确保数据的高可用性和持久性。此外,MongoDB拥有

- 智慧社区2.0

陈陈爱java

java

项目亮点1.技术架构层面✅多数据源整合(MySQL+Redis+HDFS+OSS)核心亮点:不仅仅是单一数据库,而是根据数据特性使用MySQL(结构化数据)+Redis(缓存)+HDFS(大数据存储)+OSS(对象存储),提高了系统的数据存储效率和查询速度。面试时可以强调:Redis作为缓存,加速社区热点数据访问,减少MySQL压力。HDFS存储海量日志和AI任务数据,支持后续分析。OSS解决图片

- Pandas与PySpark混合计算实战:突破单机极限的智能数据处理方案

Eqwaak00

Pandaspandas学习python科技开发语言

引言:大数据时代的混合计算革命当数据规模突破十亿级时,传统单机Pandas面临内存溢出、计算缓慢等瓶颈。PySpark虽能处理PB级数据,但在开发效率和局部计算灵活性上存在不足。本文将揭示如何构建Pandas+PySpark混合计算管道,在保留Pandas便捷性的同时,借助Spark分布式引擎实现百倍性能提升,并通过真实电商用户画像案例演示全流程实现。一、混合架构设计原理1.1技术栈优势分析维度P

- 智能汽车:驶向未来的革命

智能设备

一、引言汽车,作为现代文明的标志,正经历着一场前所未有的变革。人工智能、大数据、云计算等技术的飞速发展,正推动着汽车从单纯的交通工具向智能移动空间转变。智能汽车,作为这场变革的主角,正悄然改变着我们的出行方式和生活方式。二、智能汽车的定义与发展现状智能汽车,是指搭载先进传感器、控制器、执行器等装置,并融合现代通信与网络技术,实现车与X(人、车、路、云端等)智能信息交换、共享,具备复杂环境感知、智能

- 介绍 Apache Spark 的基本概念和在大数据分析中的应用

佛渡红尘

apache

ApacheSpark是一个开源的集群计算框架,最初由加州大学伯克利分校的AMPLab开发,用于大规模数据处理和分析。相比于传统的MapReduce框架,Spark具有更快的数据处理速度和更强大的计算能力。ApacheSpark的基本概念包括:弹性分布式数据集(RDD):是Spark中基本的数据抽象,是一个可并行操作的分区记录集合。RDD可以在集群中的节点间进行分布式计算。转换(Transform

- 从“笨重大象”到“敏捷火花”:Hadoop与Spark的大数据技术进化之路

Echo_Wish

大数据大数据hadoopspark

从“笨重大象”到“敏捷火花”:Hadoop与Spark的大数据技术进化之路说起大数据技术,Hadoop和Spark可以说是这个领域的两座里程碑。Hadoop曾是大数据的开山之作,而Spark则带领我们迈入了一个高效、灵活的大数据处理新时代。那么,它们的演变过程到底有何深意?背后技术上的取舍和选择,又意味着什么?一、Hadoop:分布式存储与计算的奠基者Hadoop诞生于互联网流量爆发式增长的时代,

- 最新计算机专业毕设论文选题大全基于BeautifulSoup的毕业设计详细题目100套优质毕设项目分享(源码+论文)✅

会写代码的羊

毕设选题课程设计beautifulsoup毕业设计毕业设计题目毕设题目python网络爬虫

文章目录前言最新毕设选题(建议收藏起来)基于BeautifulSoup的毕业设计选题毕设作品推荐前言2025全新毕业设计项目博主介绍:✌全网粉丝10W+,CSDN全栈领域优质创作者,博客之星、掘金/华为云/阿里云等平台优质作者。技术范围:SpringBoot、Vue、SSM、HLMT、Jsp、PHP、Nodejs、Python、爬虫、数据可视化、小程序、大数据、机器学习等设计与开发。主要内容:免费

- Flume详解——介绍、部署与使用

克里斯蒂亚诺罗纳尔多阿维罗

flume大数据分布式

1.Flume简介ApacheFlume是一个专门用于高效地收集、聚合、传输大量日志数据的分布式、可靠的系统。它特别擅长将数据从各种数据源(如日志文件、消息队列等)传输到HDFS、HBase、Kafka等大数据存储系统。特点:可扩展:支持大规模数据传输,灵活扩展容错性:支持数据恢复和失败重试,确保数据不丢失多种数据源:支持日志文件、网络数据、HTTP请求、消息队列等多种来源流式处理:数据边收集边传

- Spring的注解积累

yijiesuifeng

spring注解

用注解来向Spring容器注册Bean。

需要在applicationContext.xml中注册:

<context:component-scan base-package=”pagkage1[,pagkage2,…,pagkageN]”/>。

如:在base-package指明一个包

<context:component-sc

- 传感器

百合不是茶

android传感器

android传感器的作用主要就是来获取数据,根据得到的数据来触发某种事件

下面就以重力传感器为例;

1,在onCreate中获得传感器服务

private SensorManager sm;// 获得系统的服务

private Sensor sensor;// 创建传感器实例

@Override

protected void

- [光磁与探测]金吕玉衣的意义

comsci

这是一个古代人的秘密:现在告诉大家

信不信由你们:

穿上金律玉衣的人,如果处于灵魂出窍的状态,可以飞到宇宙中去看星星

这就是为什么古代

- 精简的反序打印某个数

沐刃青蛟

打印

以前看到一些让求反序打印某个数的程序。

比如:输入123,输出321。

记得以前是告诉你是几位数的,当时就抓耳挠腮,完全没有思路。

似乎最后是用到%和/方法解决的。

而今突然想到一个简短的方法,就可以实现任意位数的反序打印(但是如果是首位数或者尾位数为0时就没有打印出来了)

代码如下:

long num, num1=0;

- PHP:6种方法获取文件的扩展名

IT独行者

PHP扩展名

PHP:6种方法获取文件的扩展名

1、字符串查找和截取的方法

1

$extension

=

substr

(

strrchr

(

$file

,

'.'

), 1);

2、字符串查找和截取的方法二

1

$extension

=

substr

- 面试111

文强chu

面试

1事务隔离级别有那些 ,事务特性是什么(问到一次)

2 spring aop 如何管理事务的,如何实现的。动态代理如何实现,jdk怎么实现动态代理的,ioc是怎么实现的,spring是单例还是多例,有那些初始化bean的方式,各有什么区别(经常问)

3 struts默认提供了那些拦截器 (一次)

4 过滤器和拦截器的区别 (频率也挺高)

5 final,finally final

- XML的四种解析方式

小桔子

domjdomdom4jsax

在平时工作中,难免会遇到把 XML 作为数据存储格式。面对目前种类繁多的解决方案,哪个最适合我们呢?在这篇文章中,我对这四种主流方案做一个不完全评测,仅仅针对遍历 XML 这块来测试,因为遍历 XML 是工作中使用最多的(至少我认为)。 预 备 测试环境: AMD 毒龙1.4G OC 1.5G、256M DDR333、Windows2000 Server

- wordpress中常见的操作

aichenglong

中文注册wordpress移除菜单

1 wordpress中使用中文名注册解决办法

1)使用插件

2)修改wp源代码

进入到wp-include/formatting.php文件中找到

function sanitize_user( $username, $strict = false

- 小飞飞学管理-1

alafqq

管理

项目管理的下午题,其实就在提出问题(挑刺),分析问题,解决问题。

今天我随意看下10年上半年的第一题。主要就是项目经理的提拨和培养。

结合我自己经历写下心得

对于公司选拔和培养项目经理的制度有什么毛病呢?

1,公司考察,选拔项目经理,只关注技术能力,而很少或没有关注管理方面的经验,能力。

2,公司对项目经理缺乏必要的项目管理知识和技能方面的培训。

3,公司对项目经理的工作缺乏进行指

- IO输入输出部分探讨

百合不是茶

IO

//文件处理 在处理文件输入输出时要引入java.IO这个包;

/*

1,运用File类对文件目录和属性进行操作

2,理解流,理解输入输出流的概念

3,使用字节/符流对文件进行读/写操作

4,了解标准的I/O

5,了解对象序列化

*/

//1,运用File类对文件目录和属性进行操作

//在工程中线创建一个text.txt

- getElementById的用法

bijian1013

element

getElementById是通过Id来设置/返回HTML标签的属性及调用其事件与方法。用这个方法基本上可以控制页面所有标签,条件很简单,就是给每个标签分配一个ID号。

返回具有指定ID属性值的第一个对象的一个引用。

语法:

&n

- 励志经典语录

bijian1013

励志人生

经典语录1:

哈佛有一个著名的理论:人的差别在于业余时间,而一个人的命运决定于晚上8点到10点之间。每晚抽出2个小时的时间用来阅读、进修、思考或参加有意的演讲、讨论,你会发现,你的人生正在发生改变,坚持数年之后,成功会向你招手。不要每天抱着QQ/MSN/游戏/电影/肥皂剧……奋斗到12点都舍不得休息,看就看一些励志的影视或者文章,不要当作消遣;学会思考人生,学会感悟人生

- [MongoDB学习笔记三]MongoDB分片

bit1129

mongodb

MongoDB的副本集(Replica Set)一方面解决了数据的备份和数据的可靠性问题,另一方面也提升了数据的读写性能。MongoDB分片(Sharding)则解决了数据的扩容问题,MongoDB作为云计算时代的分布式数据库,大容量数据存储,高效并发的数据存取,自动容错等是MongoDB的关键指标。

本篇介绍MongoDB的切片(Sharding)

1.何时需要分片

&nbs

- 【Spark八十三】BlockManager在Spark中的使用场景

bit1129

manager

1. Broadcast变量的存储,在HttpBroadcast类中可以知道

2. RDD通过CacheManager存储RDD中的数据,CacheManager也是通过BlockManager进行存储的

3. ShuffleMapTask得到的结果数据,是通过FileShuffleBlockManager进行管理的,而FileShuffleBlockManager最终也是使用BlockMan

- yum方式部署zabbix

ronin47

yum方式部署zabbix

安装网络yum库#rpm -ivh http://repo.zabbix.com/zabbix/2.4/rhel/6/x86_64/zabbix-release-2.4-1.el6.noarch.rpm 通过yum装mysql和zabbix调用的插件还有agent代理#yum install zabbix-server-mysql zabbix-web-mysql mysql-

- Hibernate4和MySQL5.5自动创建表失败问题解决方法

byalias

J2EEHibernate4

今天初学Hibernate4,了解了使用Hibernate的过程。大体分为4个步骤:

①创建hibernate.cfg.xml文件

②创建持久化对象

③创建*.hbm.xml映射文件

④编写hibernate相应代码

在第四步中,进行了单元测试,测试预期结果是hibernate自动帮助在数据库中创建数据表,结果JUnit单元测试没有问题,在控制台打印了创建数据表的SQL语句,但在数据库中

- Netty源码学习-FrameDecoder

bylijinnan

javanetty

Netty 3.x的user guide里FrameDecoder的例子,有几个疑问:

1.文档说:FrameDecoder calls decode method with an internally maintained cumulative buffer whenever new data is received.

为什么每次有新数据到达时,都会调用decode方法?

2.Dec

- SQL行列转换方法

chicony

行列转换

create table tb(终端名称 varchar(10) , CEI分值 varchar(10) , 终端数量 int)

insert into tb values('三星' , '0-5' , 74)

insert into tb values('三星' , '10-15' , 83)

insert into tb values('苹果' , '0-5' , 93)

- 中文编码测试

ctrain

编码

循环打印转换编码

String[] codes = {

"iso-8859-1",

"utf-8",

"gbk",

"unicode"

};

for (int i = 0; i < codes.length; i++) {

for (int j

- hive 客户端查询报堆内存溢出解决方法

daizj

hive堆内存溢出

hive> select * from t_test where ds=20150323 limit 2;

OK

Exception in thread "main" java.lang.OutOfMemoryError: Java heap space

问题原因: hive堆内存默认为256M

这个问题的解决方法为:

修改/us

- 人有多大懒,才有多大闲 (评论『卓有成效的程序员』)

dcj3sjt126com

程序员

卓有成效的程序员给我的震撼很大,程序员作为特殊的群体,有的人可以这么懒, 懒到事情都交给机器去做 ,而有的人又可以那么勤奋,每天都孜孜不倦得做着重复单调的工作。

在看这本书之前,我属于勤奋的人,而看完这本书以后,我要努力变成懒惰的人。

不要在去庞大的开始菜单里面一项一项搜索自己的应用程序,也不要在自己的桌面上放置眼花缭乱的快捷图标

- Eclipse简单有用的配置

dcj3sjt126com

eclipse

1、显示行号 Window -- Prefences -- General -- Editors -- Text Editors -- show line numbers

2、代码提示字符 Window ->Perferences,并依次展开 Java -> Editor -> Content Assist,最下面一栏 auto-Activation

- 在tomcat上面安装solr4.8.0全过程

eksliang

Solrsolr4.0后的版本安装solr4.8.0安装

转载请出自出处:

http://eksliang.iteye.com/blog/2096478

首先solr是一个基于java的web的应用,所以安装solr之前必须先安装JDK和tomcat,我这里就先省略安装tomcat和jdk了

第一步:当然是下载去官网上下载最新的solr版本,下载地址

- Android APP通用型拒绝服务、漏洞分析报告

gg163

漏洞androidAPP分析

点评:记得曾经有段时间很多SRC平台被刷了大量APP本地拒绝服务漏洞,移动安全团队爱内测(ineice.com)发现了一个安卓客户端的通用型拒绝服务漏洞,来看看他们的详细分析吧。

0xr0ot和Xbalien交流所有可能导致应用拒绝服务的异常类型时,发现了一处通用的本地拒绝服务漏洞。该通用型本地拒绝服务可以造成大面积的app拒绝服务。

针对序列化对象而出现的拒绝服务主要

- HoverTree项目已经实现分层

hvt

编程.netWebC#ASP.ENT

HoverTree项目已经初步实现分层,源代码已经上传到 http://hovertree.codeplex.com请到SOURCE CODE查看。在本地用SQL Server 2008 数据库测试成功。数据库和表请参考:http://keleyi.com/a/bjae/ue6stb42.htmHoverTree是一个ASP.NET 开源项目,希望对你学习ASP.NET或者C#语言有帮助,如果你对

- Google Maps API v3: Remove Markers 移除标记

天梯梦

google maps api

Simply do the following:

I. Declare a global variable:

var markersArray = [];

II. Define a function:

function clearOverlays() {

for (var i = 0; i < markersArray.length; i++ )

- jQuery选择器总结

lq38366

jquery选择器

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40

- 基础数据结构和算法六:Quick sort

sunwinner

AlgorithmQuicksort

Quick sort is probably used more widely than any other. It is popular because it is not difficult to implement, works well for a variety of different kinds of input data, and is substantially faster t

- 如何让Flash不遮挡HTML div元素的技巧_HTML/Xhtml_网页制作

刘星宇

htmlWeb

今天在写一个flash广告代码的时候,因为flash自带的链接,容易被当成弹出广告,所以做了一个div层放到flash上面,这样链接都是a触发的不会被拦截,但发现flash一直处于div层上面,原来flash需要加个参数才可以。

让flash置于DIV层之下的方法,让flash不挡住飘浮层或下拉菜单,让Flash不档住浮动对象或层的关键参数:wmode=opaque。

方法如下:

- Mybatis实用Mapper SQL汇总示例

wdmcygah

sqlmysqlmybatis实用

Mybatis作为一个非常好用的持久层框架,相关资料真的是少得可怜,所幸的是官方文档还算详细。本博文主要列举一些个人感觉比较常用的场景及相应的Mapper SQL写法,希望能够对大家有所帮助。

不少持久层框架对动态SQL的支持不足,在SQL需要动态拼接时非常苦恼,而Mybatis很好地解决了这个问题,算是框架的一大亮点。对于常见的场景,例如:批量插入/更新/删除,模糊查询,多条件查询,联表查询,