客户数据管理的最佳实践-构建客户统一视图

文章摘自7月16日,华矩科技数据治理系列讲座,谭海华先生带来的分享:客户数据管理的最佳实践-构建客户统一视图,说明客户数据管理的流程与难点,以及数据质量与治理在构建客户统一视图的角色。

今天我想跟各位分享的主题是客户信息管理,这个也是现在很多企业关注的一个话题,从大数据的发展,包括数据变现,很多都是在数字营销、ECIF、客户信息管理这些领域,尤其关注这些问题的是保险业。在我过往的工作里面也接触到不少我们的同行也在做 ECIF,所以我想以这个话题来跟大家分享。

01 以保险业ECIF为例探讨客户数据管理的流程及主要问题

客户数据管理不是一个新的题目,在很多一些传统的企业或者说很成熟的企业里面,我相信有非常多的这方面的一些探索,包括一些实践,也获得一些成果。但为什么现在我们会把它作为一个很重要的话题来讨论呢?这个都跟大数据有关。我在前面接触到的一些朋友里面,就已经有听到的、实践过的,有些是成功的、有些是失败的。所以可以说这个问题是大数据背景下的客户信息管理的实践,我想这个问题主要是聚焦和定位在这里。

这里面当然有关客户数据管理的重要性,我这里可以举个例子,一家比较有名的保险公司里,客户数据的基础不变,通过客户数据的优化,包括质量的优化,在它的营销方面是成倍的一个增长,这是因为客户数据管理提升后推动了整个销售业绩的提升。我们在讲大数据,获得大数据的能力时会考虑几个方向:一个是获得增量,第二是提升现有存量的质量,第三个是进行一些跨界的数据共享,来快速增强数据能力。所以怎么提升我们管理的能力,实现在现有数据的规模上提升我们的销售,这个是有非常现实的意义。这个是有关客户数据的重要性。

所以我们回到客户数据管理,为什么现在大家会非常关注这个问题?这跟现在大数据背景下管理的困难度有关。这里有张PPT,讲的就是客户数据管理的冰山,这里面大家可以看到有各种的问题。举个例子,我们在讲客户数据管理的时候,有一个非常典型的场景,就是你在成千上万的客户数据里面去做电话号码的校验,你会发现你的客户数据库里面有不同的位数的电话号码,有5位、6位、7位、8位的。我们在做客户数据处理的时候,怎么认定这些数据的真伪,或者是说这些数据是否有存在的价值?这都是我们客户数据管理一个非常典型的场景。回到刚才我举的这个例子,假如说这个电话号码在你的数据库里面有6位、有7位、有8位,究竟怎么去认定或处理呢?可能有的朋友马上可能会有非常好的一个想法,说可以去找电信升级这个规则处理,比如说我去查询电话号码升级的规则,然后我来进行处理,这是一种方法。但是在一个非常长远的历史的时间段里面来讲,是很难做到的,这是一个问题。第二个就是虽然我们举的例子是不同位数的电话号码,但是还有很多不可想象的其他场景,应该怎么做呢?在我们进行客户数据处理的时候,会遇到比以前多得多的类似的问题。那怎么样才能在海量数据的背景下处理类似的问题?这些问题可能是过往我们没有遇到的,所以这是个新的问题。稍后我们会讲到该怎么做的解决办法。

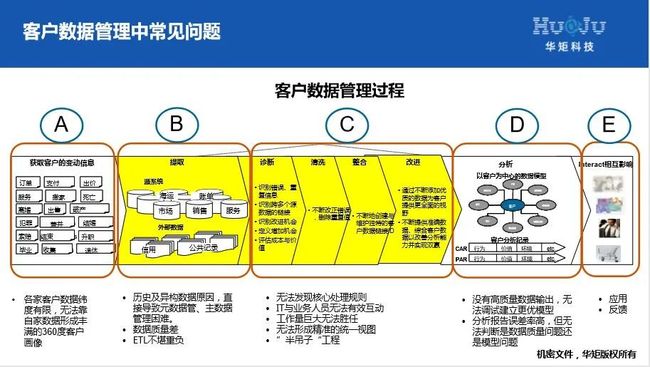

下面我跟各位分享一下,我们在做保险业ECIF的一个过程。这个是一个非常典型的ECIF的数据管理的过程,从怎么获取变动的客户信息到提取、诊断、清洗、整合、改进、分析,包括到最终用户的使用,每一个环节在海量数据的情况下可能都会遇到不同的问题。我们要去做ECIF的数据管理,可以把它分成几个步骤,从大的工作环节来讲,比如说我的PPT上面的ABCDE。

在第一类里面,我们其实要回答一个问题,就是说根据最终的应用,如客户数据的管理,它的目标在哪里?这个是首先我们要去问的,这个目标决定了我们的数据采集的方向,我们看E其实目标是落在A上,那这里面有一个很重要的就是客户的360度的画像设计的问题。假如说我们要把ECIF做好,肯定有它的目标的情况。当然在传统的做法里是尽可能罗列系统或者跨界的数据,然后来整合客户统一视图,去为我最终的使用。但在面对这种海量数据的时候,从另外一个角度考虑,需要针对未来的客户的标签画像来设计采集数据,这个就是我们讲的第一步的工作,这个工作是来决定你采集的数据源,包括数据的方向。

然后第二块的工作是从业务的抽象回到我们的系统里面,就是我们在PPT上看的B,我们是怎么进行数据源选择的,这里面当然还有包括我们整个企业的原数据是怎么做的,包括我们的主数据是怎么做的。这里面有些技术术语,就是说我们的主数据是怎么管理的,包括我们的数据仓库,为了处理数据所要进行的处理流程ETL,ETL流程以后形成了我们下一步工作的基础。我想要强调的是包括数据源、元数据的管理,它在我们后续的工作中的一个重要性。其中我刚才提到了原数据的管理,我碰到过很多个案子,因为受制于最终的报表或者说最终的分析目标的要求,在做数据采集的时候,很多时候是没有办法进行这种体系化的或者说可验证数据关联来得到我们的数据源。这个往往是在我们做很多数据的整合或者说数据的利用的时候,在源头上可能会碰到的问题,当然这个事情又跟另外一个工作相关,就是主数据的管理,这两者确保了我们的基础数据尤其是这种基础元数据的的来源的干净、清晰,包括数据的延续记录,后续我们在做分析的时候,假如发现异常,能快速进行一些判别。

第三个模块是目前我们面临的更大挑战的一个区域,包括诊断、清洗、整合、改进几个细的环节,在这几个环节里,传统的做法可能忽略一些工作,如诊断。那我们这个C的模块主要的目标是建立一个高质量的数据,同时因为应对这种海量的数据,我们希望处理的过程是能够自动化快速处理的。我想这是我们做数据处理或者做ECIF碰到的一个可以说最难的环节,因为这个工作量也是海量的,而且还不一定能够解决。所以在这里我会重点讲讲,在这个环节里有几个关键的工作可能在过往并没有得到很大的重视。首先第一个是数据剖析的问题。这个问题是建立业务规则,包括建立规则后期的数据处理里很重要的一个环节。如此前提到的客户的电话号码里面有5位、有6位、有7位、有8位该怎么样处理的问题。沿着这个例子,我们可以做一些分析,一般的情况下会怎么处理这个问题呢?我跟一些同行有交流过,一种情况就是我认为应该是8位的,所以我把其他的全部删掉,但我认为这样的处理办法并不是很好,这里面会误伤很多有用的数据,这种做法比较简单粗暴,浪费了很多数据,而且留下的8位最后还不一定知道是不是准确的,这是一种情况。第二种情况就是跟电信合作,找到电话号码的升级规则,这个办法我想能够解决一部分的问题,但是不能解决现在这种海量的数据,比如说假如说有5位、有4位怎么办?第二个方面就是说在处理的过程中,它的难点在哪里呢?它是需要我们的IT人员跟我们的业务人员进行非常高频率的交流,来诊断每一个环节。我们刚才强调了需要做数据剖析的工作,但作用在哪里呢?按照刚才这个例子,通过系统的剖析,我们能够发现一些情况,就说这6位、7位、8位的电话号码,我们发现一个规律是说在北京朝阳区20年前用户所登陆的电话号码都是6位的,我们发现有99%的案例指向了这个规律。同样我们会发现在北京海淀区在10年前登记的电话号码里面,可能有99%是指向7位的电话号码。这两个剖析出来的事实,会很快速的给到我们的IT人员或者业务人员一个指向,就是可能6位的电话号码或者7位的电话号码,在数据库里30年前登陆的这些用户里面,它是真实的,就是说可能有个别的电话号码是6位的,但是它的指向角色正好不是30年前的,可能是最近几年的,那有可能这是个笔误,是录入的时候的错误。这种规则的发现、这种数据剖析的发现,会让我们能够快速找到我们处理的这些数据的业务规则。所以这里面要强调的就是说,数据剖析在未来的整个数据管理里面会起到非常关键的作用,会解决我们很多海量数据未来处理业务规则问题,这个也是我们后续建立客户统一视图的关键过程。

后面的几个步骤,D里面我们做分析、建模,包括最后E的反馈,这个是传统的一个ECIF的处理流程,在这个流程里面我们会看到主要问题在哪里,就是说大家为什么会非常关注ECIF,是因为它的难点,因为这种难点导致了我们很多做ECIF的项目都失败了,这个是我们看到的。

所以在这张PPT里我们会看到每个模块所面临的问题、每一个工作环节所面临的问题。

在A模块,比如说在做画像的时候会存在一个非常大的困惑,就是说各家的客户数据的维度有限,无法靠自家的数据形成丰满的360度的客户画像,这个我相信是很多我们在做客户画像的时候所面临的问题,比如说在保险行业里面,可能与保险相关的一些信息我们是有的,但是保险以外的信息不一定有,这个会影响到整个画像的丰满度。画像的丰满度我刚才在前面有讲到,它会直接影响到我们对采集数据源的一些规划。

在第二个B模块包括对源数据提取的时候,我们还会碰到非常多的问题,包括历史异构数据的原因直接导致源数据的管理非常困难、数据质量很差等,还有就是海量数据的情况下,目前的ETL是没有办法去承担重任的,当然这里面有时间和工作量的要求。

在另外一个细分的工作模块C里面所面临的问题更加直接影响到我们整个ECIF的质量。第一个是无法发现核心的处理规则,这是做数据处理优化或者做ECIF的时候可能面对的一个非常大的问题。很多项目在一期做的还是非常顺利的,一期类似我这里提到的 A模块跟B模块的工作,比如怎么收集数据源,包括怎么样把数据整合放到一起。但是我们在做数据质量优化的时候,会面临一些不可逾越的困难,包括无法发现核心的处理规则、IT与业务人员无法有效的互动,这也是非常困难的地方,因为 IT人员的思维跟业务人员的角度是非常不一样的,怎么样能够通过一个有效的平台进行互动并能够快速诊断出问题也是目前大家经常碰到的困难。第三个就是工作量非常巨大,这个是不可回避的。第四个就是无法形成精准的统一视图,好的统一视图跟我的数据丰满度、包括客户的数据质量、维度都有关联。所以我们经常会发现在ECIF的项目里面,走着走着就变成半吊子的工程了,有一个好的开始但是却无法获得一个好的效果。

到最后D、E我们会看到影响是什么,没有高质量的数据输出,也无法进行更优化的模型的调试。因为整个数据跟模型是会有关联的,我们讲的垃圾数据进来,可能再好的模型出来的也是一个垃圾的结果。还有一个就是分析报告的误差率高,无法判断是数据质量的问题还是模型的问题。越往后走的话,假如说前期的工作没有做好的话,大家的信心会不断的减弱,这是我们看到的一些情况。

02 客户数据管理的最佳实践探讨

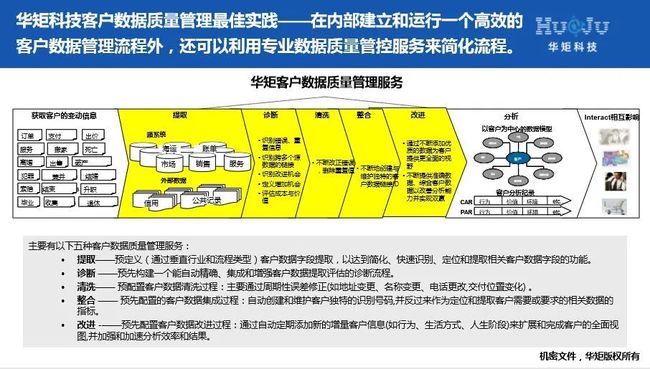

我们希望有一个更好的工具、一些更好的方法能够来解决这些问题。要是说单凭原始的这种思路去处理的话,还是非常困难的。那这里面就包括我们的整个规划,就是说怎么样去形成一套有效的处理手段,这个是我们会去考虑的。我们重点去看到我们做ECIF的几个关键的环节、现在最重要的几个优化数据质量的环节。

03 客户数据管理成功的核心环节

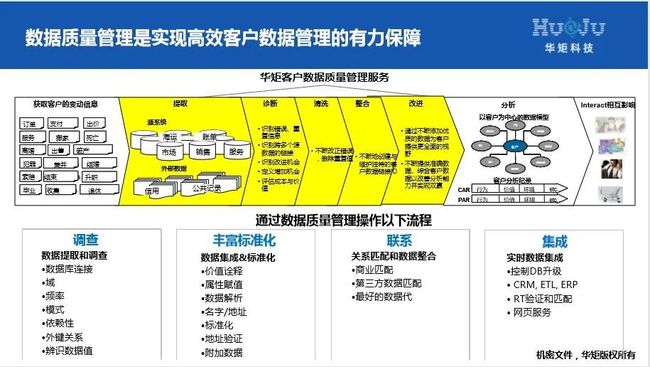

所以这里面我们会看到要去做好数据质量,包括比较核心的几个环节。

首先就是我们刚才讲的数据剖析,这个数据剖析里面有几个关键的工作,就是我们叫源数据的一些关系的分析,包括依赖性的关系分析,键值分析,基本的数据质量属性的分析,这些现在都已经具备了自动化的手段。回到那个例子,电话号码的6位、7位、8位的问题,要是我们用手工去处理的话是没办法穷尽它的各种可能性的,但是现在用一个现代化的手段的话,你可以在非常短的时间之内快速的发现所有数据的轮廓是什么、数据的整个质量的轮廓是什么,这里面就包括我刚才所提到的规则。

还有一个就更重要的,就是我们在提到数据的时候,会对数据的整个规律属性进行深度的分析,这里面会包括什么呢?一个数据我们会分成三个级别的属性,在第一级别一般是我们用数据的比如说完整的格式,长度大小,字段类型等,这些我们一般用手工的SQL语句是可以做分析的,但是第二类的这种字段的属性、数据的属性,比如像刚才提到的关联分析、键值分析等,这种就不是我们一般的这种SQL语句能够处理的,这需要一些手段和工具来处理,这是第二类的。第三类属于更加丰富的一种情况,比如我们在处理英文地址的时候,一些方法是通过发音的相似度来进行某些关键字段的匹配,来发现数据的准确性。为什么我们说在ECIF里面数据的匹配技术那么重要?因为这里面是形成统一画像,包括客户的唯一识别的核心技术。我们举个例子,英文地址或者英文的名称,我们可以用发音的相似度、打字的相似度来分析很多因为笔误所导致的某些个别误判,这是一种分析的方法。刚才还有讲到这种分类的关联性的分析方法,当然还有我们会用到比如逆向工程、反编译的这种方法,对我们的数据结构、数据字典进行分析。

刚才讲到是这种剖析,包括地址验证、电话号码验证等,除了我们刚才讲到这种剖析、验证的方法,还有第三类就是叫做业务规则的处理。还是回到电话号码的例子,除了我刚才讲的有一些关联分析、找出它的规律以外,另外一种方法是我只要知道各个地方的电话升级的规律,通过第三方的业务规则的导入,能快速的进行数据的甄别,这个也是非常关键的,就是进行业务规则的处理。怎么样跟这种相关的业务规则进行内外的互动,是在处理ECIF的时候一个很关键的手段。

这里面提到的几点都是我们在做ECIF的时候比较关键的一些技术。小结几个关键的点:

首先是整个流程设计方面,刚才提到对数据源的来源,未来的ECIF的对应的目标,数据源的采集方向的规划等。这是第一步。

第二步是怎么样通过持续的企业数据质量的提升,包括元数据的管理、主数据的管理,能够形成数据质量的基本保障,如历史数据、异构数据整合时能快速发现关联性差异性,这是第二个关注点。

第三个关注点也是最核心的一个关注点,就是在我们已经通过前面这些手段得到汇总的数据的时候,我们怎么能保证这些不同的历史数据、异构数据或者不同系统的数据在一起的时候,能够让这些数据高质量的使用。这里就回到刚才讲到的精准的用户画像问题,用户画像的精准度取决于我们的数据记录的精准匹配,包括数据甄别,这涉及如查重技术,关联字段分析之后、对这种统一记录的认定的处理技术。在这里面还要强调一点,就是我们处理的整个过程,我们需要一个更好的自动化处理手段,因为现在再去通过目测去找业务规则,或者是通过写SQL语句发现或者做一些数据处理、再跟业务人员互动的这种效率是比较低的,所以需要一个更为自动化的或者说系统的手段来处理这个事情。

04 案例研究与分析

所以总体来讲的话,有关ECIF处理刚才分析了几个方面,一是流程,一是我们实施的难点和关键点分析。下面我们分享几个案例。

第一个例子是一家全球领先的保险公司。这个案例呼叫中心是我们ECIF的直接输出应用的支持场景,那这里面怎么样提高我们的呼叫中心有效性是我们面临的对ECIF的质量非常大的挑战,当然这有一个专用的软件来处理。在这个案例里面非常明显的就是在自动化处理地址的时候,准确率可以达到97%,在不同的系统里面,它能够快速的进行地址的辨别、快速甄别出不同客人信息是否是指同一个客人,这是一个非常成功的例子。

另外一个例子是我们给一个互联网保险中介公司所做的,客户原来的数据看似很多,但是在每次整个业务报告里经常会发生一些前后矛盾的现象。从管理层团队来讲的话,会觉得这是一个很大的问题,但是也不知道这个问题在哪里,所以其实我们有一个很重要的工作,就是首先要诊断ECIF现在的问题,需要一个有效的判断。在这个有效判断的基础下做进一步的筛选、进一步的查重分析,最后能够在很短的时间之内把数据的质量给提升起来,包括我们ECIF的数据质量。

最后我想提一下的几个很关键的技术,就是在整个ECIF里面用到的几个相关联的技术。第一个就是元数据管理,我相信在这是一个基础性的工作,对我们后续的整个企业的数据质量是非常重要的。第二类我们讲到的是数据质量的技术,怎么样去运用这种有自动化的系统的数据质量工具来提升我们的数据质量。我们讲的数据质量其实涉及的面是非常广的,包括我们常见的比如说字段的缺失、错误这种情况,但还有很更重要的是它会找到相关的这种导致问题的规律跟规则,这个才是我们处理数据质量的时候尤为关注的一点,因为我们在处理数据问题的时候,其实很多情况下是找不到方向的。