视频语言规划

23年10月来自谷歌、MIT和伯克利分校的论文“video language planning”。

讨论如何利用在互联网规模数据上预训练大型生成模型,在生成的视频和语言空间中实现复杂长范围任务的视觉规划。为此,提出视频语言规划 (VLP),一种由树搜索过程组成的算法,训练 (i) 视觉-语言模型作为策略和价值函数,以及 (ii) 文本-到-视频模型作为动态模型。VLP 将长范围任务指令和当前图像观察作为输入,并输出一个长视频规划,其提供详细的多模态(视频和语言)规范,描述如何完成最终任务。VLP 随计算预算增加而扩展,其中更多的计算时间会带来更好的视频规划,并且能够合成跨不同机器人领域的长范围视频规划 - 从多目标重排列到多摄像头双臂灵巧操作。生成的视频规划可以通过目标条件策略转化为真实的机器人动作,其策略以生成视频的每个中间帧为条件。实验表明,与之前的方法相比,VLP 在模拟和真实机器人(跨 3 个不同硬件平台)上显著提高长期任务的成功率。

与物理世界的智能交互涉及规划(i)任务的高级语义抽象(即下一步做什么),以及(ii)世界的低级底层动态(即世界如何运作)。将规划问题分解为两部分,一部分由特定于任务的目标驱动,另一部分由与任务无关状态转换的建模驱动,这是一个普遍而基本的想法。这种分解推动机器人技术中的许多经典工作,从集成任务和运动规划(Cambon,2009;Wolfe,2010;Kaelbling & Lozano-Pe ́rez,2011)到推导可以在长期范围内执行复杂操作任务的控制策略,例如整理餐桌或重新排列一组物体以构建新结构。

预训练的大语言模型 (LLM) (Brown,2020;Chowdhery,2022) 能够为长期任务生成高级分步规划,而不是任务的符号(通常是语言)抽象描述(Huang,2022a;Ahn,2022),但这只是解决方案的一部分。LLM 受到文本表示的内容限制,难以进行基础推理,即对现实世界的形状、物理和约束进行推理(Tellex,2020;Huang,2023)。 LLM 可以集成到更大的视觉-语言模型 (VLM) (Driess,2023) 中,对足够的数据进行训练,这些模型可以尊重图像输入中观察的物理约束,从而生成更可行的规划,而这些规划不太可能命令机器人执行不可能的动作或操纵无法接近的目标。然而,现有的 VLM 主要在静态图像字幕和问答数据集上进行训练——因此,它们仍然难以推理动态,例如,目标如何随着时间的推移而移动或相互碰撞。

与此同时,最近在互联网上大量视频上训练的文本-到-视频模型 (Villegas,2022;Ho,2022) 已经展示了通过合成对未来的详细视频预测来学习目标动态和运动的能力 (Du,2023b)。现有的视频模型只能生成短时间范围的片段,且不会损失视觉保真度,它们是否可以应用于长期规划仍不清楚。尽管如此,它们表现出与 VLM 互补的特性,因为它们 (i) 可以以比文本更丰富的信息方式对目标的低级视觉动态进行建模,并且 (ii) 可以吸收另一种互联网数据源,例如 YouTube 视频。这自然会引出一个问题:如何构建一种规划算法,既可以利用 LLM/VLM 的长期抽象规划,又可以利用文本-到-视频模型的详细动态和运动。

提出的规划系统 VLP 以场景的视觉观察 x0 和自然语言目标 g 为依据,推断出视频规划 {xt}1:T,其中每个图像 xt 都是实现 g 的子目标。假设每个图像 xt 都是世界状态的准确表示,并使用图像目标条件策略作为控制器来推断低级控制动作 u 以达到每个图像状态。

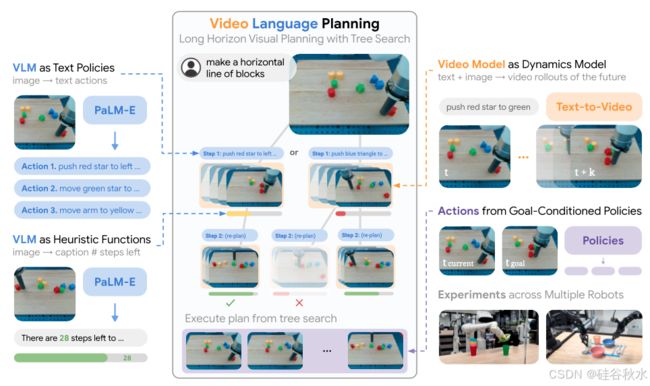

如图所示:视频语言规划(VLP)使用通过视觉-语言模型和文本-到-视频模型的前向树搜索来构建长远视频规划。从图像观察中,VLM 策略(左上)生成下一步文本动作,视频模型将其转换为可能的未来图像序列(右上)。使用 VLM 启发式函数评估未来图像状态(左下),并使用树搜索递归扩展最佳序列(中间)。可以使用目标条件策略将视频规划转换为动作执行(右下)。

1 视觉-语言和视频模型做规划子模块

首先讨论如何使用视觉语言和视频模型作为 VLP 中的子模块来合成长期规划。在高层次上,使用 VLM 的多模态处理能力来提出抽象文本动作 ai 来执行给定的目标和图像。然后,用视频模型的动态知识来准确合成执行抽象动作时可能的未来世界状态 xi1:T。最后,用 VLM 来处理可能的未来世界状态 xi1:T,并评估哪个序列 x1:T 和相关动作最有希望完成任务。

视觉-语言模型做策略。给定一个高级目标 g,VLP 会在可能的抽象动作空间中进行搜索;这些文本动作 a 由 VLM 策略 πVLM(x, g) → a 生成,该策略以目标 g 和当前状态的图像 x 为条件。按照 Driess (2023) 的方法实施此策略,并在给定自然语言目标和当前图像的token化嵌入作为上下文的情况下,向 VLM 查询要采取的自然语言动作。尝试两种不同的策略来构建此策略。首先,为 VLM 提供一组示例文本动作标签,并要求 VLM 预测可能的动作以实现目标。其次,在随机选择的短轨迹片段 x1:S 上微调 PaLM-E 模型,这些片段标有长轨迹 x1:H 内的抽象动作,其实现一个长期目标 g。

视频模型作为动态模型。为了执行高级搜索,给定当前状态的图像 x 和抽象动作的语言描述,需要预测具体的结果状态。此外,为了生成实例化此抽象动作的低级控件,需要一个可行的低级状态序列,在当前状态和结果状态之间进行“插值”。从文本-到-视频模型 fVM (x, a) 中获得上述两个内容,该模型采用图像 x 和短范围文本指令 a,并从图像观察 x0 开始输出短合成视频 x1:S。对一组短图像轨迹片段 x1:T 和相关语言标签 a 进行训练来构建该文本-到-视频模型。

视觉-语言模型做启发式函数。为了有效地修剪搜索中的分支,用 VLM 实现启发式函数 HVLM(x, g),该函数以图像观测 x 和自然语言目标描述 g 作为输入,并输出标量“启发式”,预测从当前状态 x 达到满足目标 g 的状态所需的动作数。为了构建这个启发式函数,用实现长范围目标 g 的长轨迹片段 x1:H 对 PaLM-E 模型进行微调,并训练它,根据子轨迹 xt 中的图像,预测轨迹片段结束前剩余的步数。从VLM 到完成目标,预测步数的负数用于实现 HVLM(x, g)(因此高启发式值,对应于接近目标完成)。

2 视觉-语言和视频模型做规划

直接应用 VLP策略 πVLM 来推断文本动作 a 以达到目标 g 是不够的,因为 πVLM 无法执行足够准确的长期推理来选择对长期有帮助的动作。此外,有许多可能的低级图像子序列对应于执行 a 的不同方式,但选择一个动作与达到 g 必须采取的其余动作保持一致,至关重要。

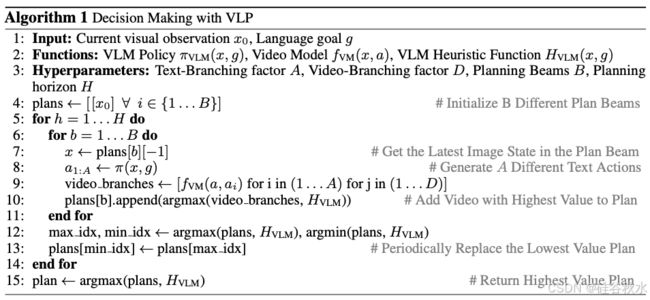

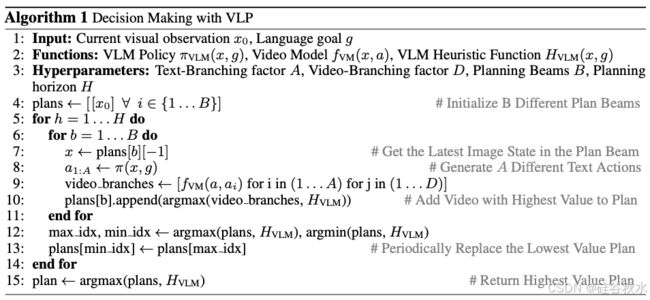

相反,该方法寻找一系列动作来达到 g,这相当于找到一个长期视频规划 x1:H去优化启发式函数 HVLM(x, g)。然后使用单独的程序来实例化控制动作 u 以制定优化的视频规划 x∗1:H。为了对长范围视频规划 x1:H 进行采样,首先从起始图像 x 到 x1:S = fVM(x, πVLM(x, g)) 合成一个短范围视频规划 x1:S ,并在最终合成的图像状态 xS 上递归应用 fVM(x, πVLM(x, g)) 自回归扩展到完整的长范围视频规划。为了跨视频规划优化HVLM(x, g),用基于并行爬山法 (Selman & Gomes, 2006) 的树搜索程序(如下算法所示)。

规划算法初始化一组 B 个并行视频规划束(beams)。在规划时域的每一步,对于每个视频束,首先使用 πVLM(x, g) 采样一组 A 个动作,并且对于每个动作,用 fVM(x, a) 合成 D 个不同的视频。然后,使用启发式函数 HVLM(x, g) 在 A × D 个生成的视频中选择启发式值最高的生成视频,并使用该生成的视频扩展相应的视频规划束。在规划生成过程中,某些视频规划束,将获得高启发式值并且更有希望进行探索。因此,每 5 步,丢弃具有最低值的束,并使用具有最高值的束复制其视频规划。最终的完整长范围视频规划,对应于规划结束时具有最高启发式值的束。

防止剥削性的模型动态。当规划程序优化 VLM 启发式函数 HVLM(x, g) 时,它可以利用动态模型 fVM(x, a) 中的不规则性来获得人为的高估计值。例如,规划程序可以利用 fVM(x, a) 中的视频,其中关键目标已传送到所需位置,或者最终图像观察遮挡了世界状态中不受欢迎的部分。为了防止过度利用 HVLM(x, g),在算法中的规划过程中,如果 fVM(x,a) 生成的视频将启发式估计 HVLM(x, g) 提高到固定阈值以上,会将其丢弃。

3 通过目标条件策略从视频中回归动作

给定一个合成视频规划 x1:H ,要执行任务,必须推断出控制动作 u 达到合成图像。先前的工作通过在每个合成帧上使用逆动力学模型从合成视频中推断动作(Du,2023b)。

在许多情况下,单一动作可能不足以直接到达下一个合成图像,例如,如果需要取下牙刷盖,即使在这种情况下,也可能很难准确预测到达下一帧的正确动作。为了减轻逆动力学模型的负担,使用短期目标条件策略 πcontrol (x, xg ),给定当前图像观察 x 和视频规划中的下一帧 xg ,输出一个低级控制动作 u ,使 xg 取得进展。对于视频规划 x1:H 中的每一帧,目标条件策略都会执行固定的预定时间步数。用成对图像和低层控制片段 xi1:T 和 ui1:T 训练 πcontrol,其中采样一个随机时间步 t、一个相应的状态 xt 和未来状态 xt+h,并训练 πcontrol(xt, xt+h) 来预测 ut。

重规划。给定一个非常长期的任务,很难使用 πcontrol 准确执行完整的视频规划 x1:H(由于累积误差),也很难在给定固定规划期限的情况下完全合成一个完全完成长期任务的规划。为了解决这个问题,用滚动时域控制策略(Kwon & Han,2005),生成具有固定时域的视频规划(可能无法完全完成任务),然后在固定数量的动作执行后,重复地重新生成/重规划具有相同时域的视频规划。