- 构建全栈式数据库与消息队列服务治理体系:监控、告警与组件搭配实践

喝醉酒的小白

DBAK8s数据库

目录标题分类✅一、分类总览表✅二、详细分类说明1.关系型数据库(RDBMS)2.NoSQL数据库3.分布式系统协调组件4.消息队列系统✅三、按用途分类(实战参考)✅四、开源vs商业(闭源)分类全面的监控指标分类与告警模板清单✅一、通用结构✅二、数据库系统级别详细监控项与告警模板1.MySQL/TiDB/OceanBase2.PostgreSQL/openGauss/GaussDB/KingBase

- 【项目实战】Redis使用场景之基于Redis实现分布式限流

本本本添哥

002-进阶开发能力003-数据库redis分布式数据库

一、技术概览1.1定义分布式限流是指在分布式系统中限制请求的速率,以保护后端服务不被过多的请求压垮。它可以帮助我们控制系统的负载,保证服务的稳定性。Redis是一个高性能的键值存储系统,常用于缓存、消息队列和实时分析等场景。由于其支持丰富的数据结构和原子操作,非常适合用来实现分布式限流。专业术语:令牌桶算法(TokenBucket):一种流量整形算法,允许突发流量但不超过平均速度。漏桶算法(Lea

- 5-RabbitMQ-高级篇

一笑39

黑马微服务系列rabbitmqjava分布式

服务异步通信-高级篇消息队列在使用过程中,面临着很多实际问题需要思考:[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-mmSGOyeb-1636540993704)(assets/image-20210718155003157.png)]1.消息可靠性消息从发送,到消费者接收,会经理多个过程:[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img

- 互联网大厂Java面试实战:严肃面试官与搞笑谢飞机的三轮提问

Fu Dun Yao

Java场景面试宝典Java面试JUCJVM多线程线程池HashMap

互联网大厂Java面试实战:严肃面试官与搞笑谢飞机的三轮提问本文通过一个面试故事,展示了互联网大厂Java求职者与严肃面试官的对话。面试官就Java核心技术、JUC、JVM、多线程、线程池、HashMap、ArrayList、Spring及相关框架、分布式技术、消息队列、中间件、数据库、Linux、Docker、设计模式及DDD等多个技术点,分三轮提问。求职者谢飞机偶尔能准确回答简单问题获得认可,

- 事件驱动架构(EDA):不止是代码,更是现代运维的灵魂

运维开发王义杰

系统运维系统架构aws架构运维

今天我们来聊一个在云原生时代越来越火热的概念——事件驱动架构(Event-DrivenArchitecture,EDA)。大家可能在浏览AWSEventBridge、ApacheKafka或RabbitMQ的文档时遇到过它。起初,可能会觉得这只是软件工程师在设计微服务时用到的一种模式。但如果我们深入思考就会发现,EDA的精髓早已渗透到现代系统运维的方方面面,甚至可以说,它是一种构建和管理高韧性、高

- 告别迷茫!GitHub上这本《系统设计101》,我愿称之为“架构圣经”

wylee

架构

各位CSDN的读者朋友们,你们是否也曾被系统设计这道“拦路虎”困扰?在软件开发的世界里,从写出能跑的代码到设计出高性能、高可用、可伸缩、易维护的复杂系统,中间隔着一道巨大的鸿沟。无论是面试中那些让人头大的“设计一个短链接系统”、“设计一个高并发的消息队列”,还是工作中面对系统扩容、性能瓶颈、稳定性挑战时的焦头烂额,无一不在提醒我们:系统设计,是程序员进阶架构师的必经之路,也是真正区分高级工程师与普

- 设备通信技术选型:MQTT和AMQP

呆呆智

网络协议javaspring开发语言mqttamqp

1.MQTT有没有消息队列和持久化?MQTT协议本身不定义消息队列,它只是:客户端发送消息到"主题"(topic)Broker(服务器)收到后转发给订阅者持久化支持有限:QoS1/2消息在服务器端可以短期持久化,防止中断丢失(比如写到磁盘或者内存)。但不是像AMQP那种强事务的长时间存储、排队消费。总结:MQTT是"消息中转",不是"消息存储和排队"。存一下下,只是为了保障重发确认流程,而不是持久

- AIRIOT物联网低代码平台如何配置MQTT驱动?

AIRIOT

网络服务器物联网

MQTT驱动配置简介MQTT全称为消息队列遥测传输(英语:MessageQueuingTelemetryTransport),是ISO标准(ISO/IECPRF20922)下基于发布(Publish)/订阅(Subscribe)范式的消息协议,工作在TCP/IP协议族上。MQTT最大优点在于,可以用极少的数据和有限的带宽,为连接远程设备提供实时可靠的消息服务。作为一种低开销、低带宽占用的即时通讯协

- 大数据面试必备:Kafka性能优化 Producer与Consumer配置指南

Kafka面试题-在Kafka中,如何通过配置优化Producer和Consumer的性能?回答重点在Kafka中,通过优化Producer和Consumer的配置,可以显著提高性能。以下是一些关键配置项和策略:1、Producer端优化:batch.size:批处理大小。增大batch.size可以使Producer每次发送更多的消息,但要注意不能无限制增大,否则会导致内存占用过多。linger

- Beam2.61.0版本消费kafka重复问题排查

隔壁寝室老吴

kafkalinq分布式

1.问题出现过程在测试环境测试flink的job的任务消费kafka的情况,通过往job任务发送一条消息,然后flinkwebui上消费出现了两条。然后通过重启JobManager和TaskManager后,任务从checkpoint恢复后就会出现重复消费。当任务不从checkpoint恢复的时候,任务不会出现重复消费的情况。由此可见是beam从checkpoint恢复的时候出现了重复消费的问题。

- opensuse安装rabbitmq

翻滚吧键盘

openSUSErabbitmqruby分布式

您好!安装RabbitMQ消息队列是一个非常棒的选择,它是许多现代应用架构中的核心组件。在openSUSETumbleweed上安装RabbitMQ主要有两种流行的方式:一种是使用系统的包管理器zypper,另一种是使用Docker容器。我将为您详细介绍这两种方法。前置知识:RabbitMQ是用Erlang语言编写的,因此安装RabbitMQ时会自动安装Erlang语言环境作为其依赖。您无需手动安

- 支持java8的kafka版本

兮动人

kafka分布式支持java8的kafka版本

文章目录1.Kafka支持Java8的版本范围2.官方建议与兼容性3.版本迁移建议4.关键时间点5.注意事项6.总结1.Kafka支持Java8的版本范围Kafka2.x和3.x版本:Kafka2.x和3.x版本(如2.8.0、3.0.0等)理论上支持Java8,但官方已逐步弃用对Java8的支持。Kafka3.0:官方在3.0版本中弃用Java8(但仍允许使用),并强烈建议升级到Java11或更

- 基于Redisson的Redis发布订阅传对象[消息队列]

1、实体类实现Serializable接口2、发布消息packagecom.ahies.stm.app.synthesizes.aifind.controller;importcom.ahies.stm.app.synthesizes.aifind.entity.AifindHistory;importcom.ahies.stm.app.util.ResponseResult;importorg.

- 华为OD机试 2025 B卷 - 模拟消息队列 (C++ & Python & JAVA & JS & GO)

无限码力

华为OD机试真题刷题笔记华为od算法华为OD2025B卷华为OD机试2025B卷华为OD机试

模拟消息队列华为OD机试真题目录:点击去查看华为od2025B卷100分题型题目描述让我们来模拟一个消息队列的运作,有一个发布者和若干消费者,发布者会在给定的时刻向消息队列发送消息,若此时消息队列有消费者订阅,这个消息会被发送到订阅的消费者中优先级最高(输入中消费者按优先级升序排列)的一个;若此时没有订阅的消费者,该消息被消息队列丢弃。消费者则会在给定的时刻订阅消息队列或取消订阅。当消息发送和订阅

- Flink SQL Connector Kafka 核心参数全解析与实战指南

Edingbrugh.南空

kafkaflink大数据flinksqlkafka

FlinkSQLConnectorKafka是连接FlinkSQL与Kafka的核心组件,通过将Kafka主题抽象为表结构,允许用户使用标准SQL语句完成数据读写操作。本文基于ApacheFlink官方文档(2.0版本),系统梳理从表定义、参数配置到实战调优的全流程指南,帮助开发者高效构建实时数据管道。一、依赖配置与环境准备1.1Maven依赖引入在FlinkSQL项目中使用Kafka连接器需添加

- 【基础篇-消息队列】——网关如何接收服务端的秒杀结果

小志的博客

消息队列消息队列

目录一、网关如何接收服务端的秒杀结果本文来源:极客时间vip课程笔记一、网关如何接收服务端的秒杀结果在《【基础篇-消息队列】——为什么需要消息队列》这节课里面,我们举了一个秒杀的例子,这个例子是用来说明消息队列是如何来实现异步处理的。课后很多同学留言提问,网关在发送消息之后,是如何来接收后端服务的秒杀结果,又如何来给APP返回响应的呢?在解答这个问题之前,我需要先说一下,实际生产环境中的秒杀系统,

- 大数据领域数据工程的消息中间件选型

大数据洞察

大数据与AI人工智能大数据ai

大数据领域数据工程的消息中间件选型关键词:消息中间件、数据工程、大数据处理、选型标准、分布式系统、实时数据流、可靠性保障摘要:在大数据领域的数据工程实践中,消息中间件是构建高可靠、高可扩展数据管道的核心组件。本文从技术架构、功能需求、应用场景等维度,系统解析消息中间件选型的关键要素。通过对比Kafka、Pulsar、RabbitMQ、RocketMQ等主流中间件的技术特性,结合数学模型分析吞吐量、

- 【基础篇-消息队列】——详解 RocketMQ 和 Kafka 的消息模型

小志的博客

消息队列消息队列

目录一、引入前提二、通过示例详解RocketMQ和Kafka的消息模型2.1、示例说明2.2、消息生产端2.3、消息消费端2.3.1、单个消费组2.3.2、多个消费组2.3.3、消费组的内部2.3.4、消费位置本文来源:极客时间vip课程笔记一、引入前提我在看《【基础篇-消息队列】——消息模型中的主题和队列有什么区别》这节课的留言时发现,不少同学对RocketMQ和kafka的消息模型理解的还不是

- Python 解析 Kafka 消息队列的高吞吐架构

```htmlPython解析Kafka消息队列的高吞吐架构Python解析Kafka消息队列的高吞吐架构Kafka是一个分布式、高吞吐量的消息队列系统,广泛应用于实时数据处理和流式计算场景。Python作为一种灵活且易于使用的编程语言,在与Kafka集成时提供了多种库支持,例如kafka-python和confluent-kafka。本文将探讨如何使用Python构建高效的Kafka消息队列应用

- C# .NET Framework 中的高效 MQTT 消息传递

csdn_aspnet

rabbitmqC#c#.netrabbitmq

介绍:在当今互联互通的世界里,设备之间高效可靠的通信至关重要。MQTT(消息队列遥测传输)就是为此而设计的轻量级消息传递协议。本文将探讨MQTT是什么、它的优势以及如何在.NET框架中设置和实现它。最后,您将对MQTT有一个清晰的了解,并通过一个实际示例来帮助您入门。1.什么是MQTT?定义和概述:MQTT代表消息队列遥测传输(MessageQueuingTelemetryTransport)。它

- No Sql之 Redis配置与优化

牛爷爷敲代码

sqlredis数据库

NoSql之Redis配置与优化Redis核心技术笔记一、基础概念定义Redis(RemoteDictionaryServer)是开源的内存键值对数据库,支持多种数据结构(字符串、哈希、列表、集合、有序集合等)。特性:高性能(单线程+多路复用)、持久化、集群、发布订阅。典型应用场景缓存:热点数据加速查询(如电商商品详情页缓存)。计数器:点赞数、访问量(原子性INCR操作)。消息队列:基于LPUSH

- SpringBoot整合kafka报could not be established. Broker may not be available.

ls65535

中间件Connectiontonode0(localhost/12couldnotbeestablished.Brokerma

SpringBoot整合kafka报couldnotbeestablished.Brokermaynotbeavailable.报错日志[AdminClientclientId=adminclient-1]Connectiontonode0(localhost/127.0.0.1:9092)couldnotbeestablished.Brokermaynotbeavailable.[AdminCl

- 大数据领域Kafka的性能优化案例分析

AGI大模型与大数据研究院

大数据kafka性能优化ai

大数据领域Kafka的性能优化案例分析关键词:Kafka、性能优化、吞吐量、延迟、分区策略、消息压缩、监控调优摘要:本文深入探讨ApacheKafka在大数据环境中的性能优化策略。我们将从Kafka的核心架构出发,分析影响性能的关键因素,并通过实际案例展示如何通过配置调优、分区策略优化、消息压缩等技术手段显著提升Kafka集群的性能。文章包含详细的性能测试数据、优化前后的对比分析,以及可落地的优化

- Kafka深入学习及运维工作笔记

喝醉酒的小白

Kafkakafka学习运维

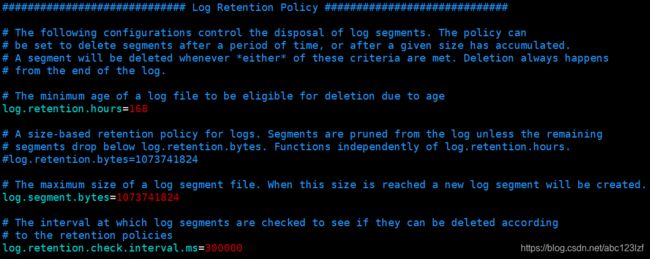

目录标题Kafka深入学习及运维工作笔记一、Kafka学习路径总览1.1学习阶段划分1.2学习资源推荐二、Kafka基础入门2.1Kafka核心概念2.1.1基础架构组件2.1.2关键术语解析2.2Kafka工作原理与核心功能2.2.1消息传递机制2.2.2核心功能特性2.3Kafka安装与基本操作2.3.1环境准备2.3.2安装与启动2.3.3基本操作命令三、Kafka进阶学习3.1Kafka架

- 基于Kafka实现企业级大数据迁移的完整指南

亲爱的非洲野猪

kafka大数据linq

在大数据时代,数据迁移已成为企业数字化转型过程中的常见需求。本文将详细介绍如何利用Kafka构建高可靠、高性能的大数据迁移管道,涵盖从设计到实施的完整流程。一、为什么选择Kafka进行数据迁移?Kafka作为分布式消息系统,具有以下独特优势:高吞吐:单集群可支持每秒百万级消息处理低延迟:端到端延迟可控制在毫秒级持久性:数据可持久化存储,防止丢失水平扩展:可轻松扩展应对数据量增长多消费者:支持多个系

- 使用 Apache Kafka 的关键要点:开发者必知指南

亲爱的非洲野猪

apachekafka分布式

ApacheKafka是一个高吞吐量、分布式、可水平扩展的消息队列系统,广泛应用于实时数据流处理、日志聚合、事件驱动架构等场景。本文将整理Kafka的核心关键点,帮助开发者高效使用Kafka。1.Kafka核心概念(1)基本组件Producer:消息生产者,向Kafka发送数据。Consumer:消息消费者,从Kafka读取数据。Broker:Kafka服务器节点,负责存储和转发消息。Topic:

- docker-compose部署rocketmq和rocketmq-dashboard以及消息队列的概念讲解

qq_53099538

dockerrocketmq容器

引言在现代软件架构,尤其是微服务架构中,组件之间的解耦和异步通信变得尤为重要。消息队列作为实现这一目标的关键技术,不仅提升了系统的可扩展性和健壮性,还简化了复杂场景下的消息传递。本文旨在深入探讨消息队列的基本概念、工作原理及其实现机制,帮助读者更好地理解和应用这一重要技术。一、基于docker-compose部署rocketmq以及rocketmq-dashboard步骤1:准备工作目录首先,你需

- RocketMQ--为什么性能不如Kafka?

IT利刃出鞘

MQrocketmqkafka分布式

原文网址:RocketMQ--为什么性能不如Kafka?-CSDN博客简介本文介绍RocketMQ为什么性能不如Kafka?阿里中间件团队对它们做过压测,同样条件下,kafka比RocketMQ快50%左右。为什么RocketMQ参考了Kafka的架构,却不能跟kafka保持一样的性能呢?读消息的方式为了防止消息队列的消息丢失,一般不会放内存里,而是放磁盘上。消息从消息队列的磁盘,发送到消费者,过

- 69、Flink 的 DataStream Connector 之 Kafka 连接器详解

猫猫爱吃小鱼粮

Flink-1.19从0到精通flinkkafka大数据

1.概述Flink提供了Kafka连接器使用精确一次(Exactly-once)的语义在Kafkatopic中读取和写入数据。目前还没有Flink1.19可用的连接器。2.KafkaSourcea)使用方法KafkaSource提供了构建类来创建KafkaSource的实例。以下代码片段展示了如何构建KafkaSource来消费“input-topic”最早位点的数据,使用消费组“my-group

- Kafka 核心术语详解

showyoui

Kafkakafka分布式

文章目录1.集群架构层Cluster(集群)Broker(代理服务器)2.存储架构层Topic(主题)Partition(分区)Message(消息)3.副本机制Leader/FollowerISR(In-SyncReplicas)副本加入ISR的条件副本被移出ISR的条件Leader选举机制ISR维护机制4.客户端Producer(生产者)Consumer(消费者)ConsumerGroup(消

- apache ftpserver-CentOS config

gengzg

apache

<server xmlns="http://mina.apache.org/ftpserver/spring/v1"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://mina.apache.o

- 优化MySQL数据库性能的八种方法

AILIKES

sqlmysql

1、选取最适用的字段属性 MySQL可以很好的支持大数据量的存取,但是一般说来,数据库中的表越小,在它上面执行的查询也就会越快。因此,在创建表的时候,为了获得更好的 性能,我们可以将表中字段的宽度设得尽可能小。例如,在定义邮政编码这个字段时,如果将其设置为CHAR(255),显然给数据库增加了不必要的空间,甚至使用VARCHAR这种类型也是多余的,因为CHAR(6)就可以很

- JeeSite 企业信息化快速开发平台

Kai_Ge

JeeSite

JeeSite 企业信息化快速开发平台

平台简介

JeeSite是基于多个优秀的开源项目,高度整合封装而成的高效,高性能,强安全性的开源Java EE快速开发平台。

JeeSite本身是以Spring Framework为核心容器,Spring MVC为模型视图控制器,MyBatis为数据访问层, Apache Shiro为权限授权层,Ehcahe对常用数据进行缓存,Activit为工作流

- 通过Spring Mail Api发送邮件

120153216

邮件main

原文地址:http://www.open-open.com/lib/view/open1346857871615.html

使用Java Mail API来发送邮件也很容易实现,但是最近公司一个同事封装的邮件API实在让我无法接受,于是便打算改用Spring Mail API来发送邮件,顺便记录下这篇文章。 【Spring Mail API】

Spring Mail API都在org.spri

- Pysvn 程序员使用指南

2002wmj

SVN

源文件:http://ju.outofmemory.cn/entry/35762

这是一篇关于pysvn模块的指南.

完整和详细的API请参考 http://pysvn.tigris.org/docs/pysvn_prog_ref.html.

pysvn是操作Subversion版本控制的Python接口模块. 这个API接口可以管理一个工作副本, 查询档案库, 和同步两个.

该

- 在SQLSERVER中查找被阻塞和正在被阻塞的SQL

357029540

SQL Server

SELECT R.session_id AS BlockedSessionID ,

S.session_id AS BlockingSessionID ,

Q1.text AS Block

- Intent 常用的用法备忘

7454103

.netandroidGoogleBlogF#

Intent

应该算是Android中特有的东西。你可以在Intent中指定程序 要执行的动作(比如:view,edit,dial),以及程序执行到该动作时所需要的资料 。都指定好后,只要调用startActivity(),Android系统 会自动寻找最符合你指定要求的应用 程序,并执行该程序。

下面列出几种Intent 的用法

显示网页:

- Spring定时器时间配置

adminjun

spring时间配置定时器

红圈中的值由6个数字组成,中间用空格分隔。第一个数字表示定时任务执行时间的秒,第二个数字表示分钟,第三个数字表示小时,后面三个数字表示日,月,年,< xmlnamespace prefix ="o" ns ="urn:schemas-microsoft-com:office:office" />

测试的时候,由于是每天定时执行,所以后面三个数

- POJ 2421 Constructing Roads 最小生成树

aijuans

最小生成树

来源:http://poj.org/problem?id=2421

题意:还是给你n个点,然后求最小生成树。特殊之处在于有一些点之间已经连上了边。

思路:对于已经有边的点,特殊标记一下,加边的时候把这些边的权值赋值为0即可。这样就可以既保证这些边一定存在,又保证了所求的结果正确。

代码:

#include <iostream>

#include <cstdio>

- 重构笔记——提取方法(Extract Method)

ayaoxinchao

java重构提炼函数局部变量提取方法

提取方法(Extract Method)是最常用的重构手法之一。当看到一个方法过长或者方法很难让人理解其意图的时候,这时候就可以用提取方法这种重构手法。

下面是我学习这个重构手法的笔记:

提取方法看起来好像仅仅是将被提取方法中的一段代码,放到目标方法中。其实,当方法足够复杂的时候,提取方法也会变得复杂。当然,如果提取方法这种重构手法无法进行时,就可能需要选择其他

- 为UILabel添加点击事件

bewithme

UILabel

默认情况下UILabel是不支持点击事件的,网上查了查居然没有一个是完整的答案,现在我提供一个完整的代码。

UILabel *l = [[UILabel alloc] initWithFrame:CGRectMake(60, 0, listV.frame.size.width - 60, listV.frame.size.height)]

- NoSQL数据库之Redis数据库管理(PHP-REDIS实例)

bijian1013

redis数据库NoSQL

一.redis.php

<?php

//实例化

$redis = new Redis();

//连接服务器

$redis->connect("localhost");

//授权

$redis->auth("lamplijie");

//相关操

- SecureCRT使用备注

bingyingao

secureCRT每页行数

SecureCRT日志和卷屏行数设置

一、使用securecrt时,设置自动日志记录功能。

1、在C:\Program Files\SecureCRT\下新建一个文件夹(也就是你的CRT可执行文件的路径),命名为Logs;

2、点击Options -> Global Options -> Default Session -> Edite Default Sett

- 【Scala九】Scala核心三:泛型

bit1129

scala

泛型类

package spark.examples.scala.generics

class GenericClass[K, V](val k: K, val v: V) {

def print() {

println(k + "," + v)

}

}

object GenericClass {

def main(args: Arr

- 素数与音乐

bookjovi

素数数学haskell

由于一直在看haskell,不可避免的接触到了很多数学知识,其中数论最多,如素数,斐波那契数列等,很多在学生时代无法理解的数学现在似乎也能领悟到那么一点。

闲暇之余,从图书馆找了<<The music of primes>>和<<世界数学通史>>读了几遍。其中素数的音乐这本书与软件界熟知的&l

- Java-Collections Framework学习与总结-IdentityHashMap

BrokenDreams

Collections

这篇总结一下java.util.IdentityHashMap。从类名上可以猜到,这个类本质应该还是一个散列表,只是前面有Identity修饰,是一种特殊的HashMap。

简单的说,IdentityHashMap和HashM

- 读《研磨设计模式》-代码笔记-享元模式-Flyweight

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java

- PS人像润饰&调色教程集锦

cherishLC

PS

1、仿制图章沿轮廓润饰——柔化图像,凸显轮廓

http://www.howzhi.com/course/retouching/

新建一个透明图层,使用仿制图章不断Alt+鼠标左键选点,设置透明度为21%,大小为修饰区域的1/3左右(比如胳膊宽度的1/3),再沿纹理方向(比如胳膊方向)进行修饰。

所有修饰完成后,对该润饰图层添加噪声,噪声大小应该和

- 更新多个字段的UPDATE语句

crabdave

update

更新多个字段的UPDATE语句

update tableA a

set (a.v1, a.v2, a.v3, a.v4) = --使用括号确定更新的字段范围

- hive实例讲解实现in和not in子句

daizj

hivenot inin

本文转自:http://www.cnblogs.com/ggjucheng/archive/2013/01/03/2842855.html

当前hive不支持 in或not in 中包含查询子句的语法,所以只能通过left join实现。

假设有一个登陆表login(当天登陆记录,只有一个uid),和一个用户注册表regusers(当天注册用户,字段只有一个uid),这两个表都包含

- 一道24点的10+种非人类解法(2,3,10,10)

dsjt

算法

这是人类算24点的方法?!!!

事件缘由:今天晚上突然看到一条24点状态,当时惊为天人,这NM叫人啊?以下是那条状态

朱明西 : 24点,算2 3 10 10,我LX炮狗等面对四张牌痛不欲生,结果跑跑同学扫了一眼说,算出来了,2的10次方减10的3次方。。我草这是人类的算24点啊。。

然后么。。。我就在深夜很得瑟的问室友求室友算

刚出完题,文哥的暴走之旅开始了

5秒后

- 关于YII的菜单插件 CMenu和面包末breadcrumbs路径管理插件的一些使用问题

dcj3sjt126com

yiiframework

在使用 YIi的路径管理工具时,发现了一个问题。 <?php

- 对象与关系之间的矛盾:“阻抗失配”效应[转]

come_for_dream

对象

概述

“阻抗失配”这一词组通常用来描述面向对象应用向传统的关系数据库(RDBMS)存放数据时所遇到的数据表述不一致问题。C++程序员已经被这个问题困扰了好多年,而现在的Java程序员和其它面向对象开发人员也对这个问题深感头痛。

“阻抗失配”产生的原因是因为对象模型与关系模型之间缺乏固有的亲合力。“阻抗失配”所带来的问题包括:类的层次关系必须绑定为关系模式(将对象

- 学习编程那点事

gcq511120594

编程互联网

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- Reverse Linked List II

hcx2013

list

Reverse a linked list from position m to n. Do it in-place and in one-pass.

For example:Given 1->2->3->4->5->NULL, m = 2 and n = 4,

return

- Spring4.1新特性——页面自动化测试框架Spring MVC Test HtmlUnit简介

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Hadoop集群工具distcp

liyonghui160com

1. 环境描述

两个集群:rock 和 stone

rock无kerberos权限认证,stone有要求认证。

1. 从rock复制到stone,采用hdfs

Hadoop distcp -i hdfs://rock-nn:8020/user/cxz/input hdfs://stone-nn:8020/user/cxz/运行在rock端,即源端问题:报版本

- 一个备份MySQL数据库的简单Shell脚本

pda158

mysql脚本

主脚本(用于备份mysql数据库): 该Shell脚本可以自动备份

数据库。只要复制粘贴本脚本到文本编辑器中,输入数据库用户名、密码以及数据库名即可。我备份数据库使用的是mysqlump 命令。后面会对每行脚本命令进行说明。

1. 分别建立目录“backup”和“oldbackup” #mkdir /backup #mkdir /oldbackup

- 300个涵盖IT各方面的免费资源(中)——设计与编码篇

shoothao

IT资源图标库图片库色彩板字体

A. 免费的设计资源

Freebbble:来自于Dribbble的免费的高质量作品。

Dribbble:Dribbble上“免费”的搜索结果——这是巨大的宝藏。

Graphic Burger:每个像素点都做得很细的绝佳的设计资源。

Pixel Buddha:免费和优质资源的专业社区。

Premium Pixels:为那些有创意的人提供免费的素材。

- thrift总结 - 跨语言服务开发

uule

thrift

官网

官网JAVA例子

thrift入门介绍

IBM-Apache Thrift - 可伸缩的跨语言服务开发框架

Thrift入门及Java实例演示

thrift的使用介绍

RPC

POM:

<dependency>

<groupId>org.apache.thrift</groupId>