HBase 数据导入

记录一下HBase 0.96.0 利用ImportTsv,completebulkload 和Import导入数据的方法。我的环境里用的是Yarn。

1、利用ImportTsv 将cvs文件导入到HBase

步骤:

a. 在hbase里面创建好table:

命令:create 'hbase-tbl-001','cf'

b. Upload simple1.cvs文件到hdfs上面,其内容为:

1,"tom"

2,"sam"

3,"jerry"

4,"marry"

5,"john"

c. 利用ImportTsv导入数据:

命令:bin/hbase org.apache.hadoop.hbase.mapreduce.ImportTsv -Dimporttsv.separator="," -Dimporttsv.columns=HBASE_ROW_KEY,cf hbase-tbl-001 /user/biadmin/simple1.cvs

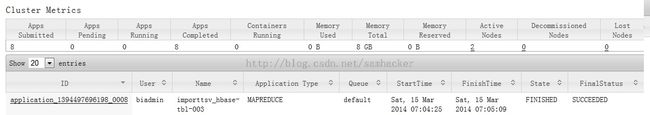

ImportTsv 任务执行结果:

在Yarn的web console上可以看到相应job的执行记录:

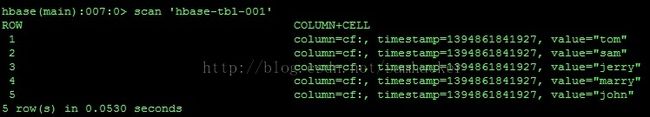

hbase的hbase-tbl-001'的值为:

2、利用completebulkload 将数据导入到HBase

a. 先通过ImportTsv生成HFile

命令:bin/hbase org.apache.hadoop.hbase.mapreduce.ImportTsv -Dimporttsv.separator="," -Dimporttsv.bulk.output=hfile_tmp3 -Dimporttsv.columns=HBASE_ROW_KEY,cf hbase-tbl-003 /user/biadmin/simple1.cvs

该命令会最终通过MapReduce job完成:

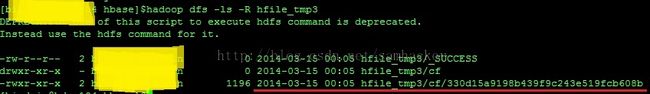

此时,可以在hdfs上面看到生成的HFile:

而且, 在hbase上也自动创建了表hbase-tbl-003,不过该表此时为空表:

b. 通过completebulkload 将数据导入表hbase-tbl-003

命令: hadoop jar lib/hbase-server-0.96.0.jar completebulkload hfile_tmp3 hbase-tbl-003

注意:执行该命令时,hadoop很可能会找不到相关的hbase依赖包,出现ClassNotFoundException的异常。一个简单的解决方法是将hbase相关的jar包都放到${HADOOP_HOME}/share/hadoop/common/lib下面,这样hadoop就能在运行前加载相关的hbase jar files。

运行该命令的本质是一个hdfs的mv操作,并不会启动MapReduce。

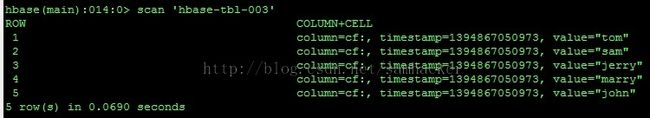

执行完后,表hbase-tbl-003里面就有了新导入的数据:

3、利用Import将数据导入到HBase

注:具体的一些实验在HBase导出CSV格式数据的方法 一文中有详细描述,这里说一下具体步骤。

a. HBase export工具导出的数据的格式是sequence file。比如,在执行完命令“bin/hbase org.apache.hadoop.hbase.mapreduce.Export test test-output-001”后,hbase会启动一个MapReduce作业,作业完成后会在hdfs上面会生成sequence file格式的数据文件

b. 对于这类Sequence file格式的数据文件,HBase是可以通过Import工具直接将它导入到HBase的表里面的。执行命令“bin/hbase org.apache.hadoop.hbase.mapreduce.Import test-01 test-output-001”,随后hbase会启动一个MapReduce 作业。然后 表test-01中会成功导入数据。