Spark导入eclipse

用了eclipse好多年,希望可以把spark带入eclipse,然后阅读源码会方便些。~~~~(>_<)~~~~ 555555555555,谁知道各种奇葩的情况发生,好无奈。最终找到一片很好的英文文章,终于解决了这个难题。

1 eclipse初探

直接以mvn项目导入eclipse(这里指的是scala IDE,当然也可以安装scala插件到eclipse中)。

然后,你懂得,项目倒是导入进来了,但是eclipse没有识别相应的package和scala文件,导致阅读的时候异常痛苦

2 阅读官方文档

https://cwiki.apache.org/confluence/display/SPARK/Contributing+to+Spark#ContributingtoSpark-IDESetup

官方文档建议sbt/eclipse之后导入eclipse,或者直接导入IntelliJ。尝试了两种方法都没成功。

当然我觉得我把IntelliJ玩坏了,完全不认scala了。。。。。

3 mvn eclipse:eclipse

当我敲下这条命令的时候,命运的齿轮开始转动,但是,,,,,,过了一会开始报错,说有几个包下不下来....................难道要我手动下载???

4 mvn update project

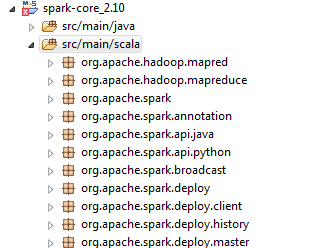

再次回到eclipse中,在项目上右键->MVN->Update Project。 耐心等待,好多包要下载,第一个实验品是Spark-Core项目,过了10分钟左右,项目更新好了,打开项目惊喜的发现.java文件都很好的识别了,但是scala文件没有识别。

解决方法是:在项目上右键->sacal -> add scala nature (当然这里可能不需要做,如果已经有了的话),

然后选中 src/main/scala 右键-> Build Path ->Use As Source Folder

参考:http://syndeticlogic.net/?p=311 Getting spark setup in eclipse

奇迹出现了,大功告成。终于可以在eclipse中阅读源码了

总结下:

sbt编译有问题,这个我觉的是windows系统的问题,因为每次执行到git clone xxx的时候,我会发现,后面跟的本地路径是/隔开的路径,部分和windows cmd的规范,导致无法成功clone下来。

mvn eclipse:eclipse失败,这个不好说,因为报错有一个是cookie denied........