Spark1.x编译与安装

1. Spark1.x编译与安装

1.1. 基础准备

见《基础准备(Hadoop/Spark/Mahout安装准备)》。

1.2. Hadoop集群准备

见《hadoop2.2.0编译与安装》

1.3. Scala安装

1) 下载

集群中每台机器安装Scala;Scala官方下载地址:

http://www.scala-lang.org/download/

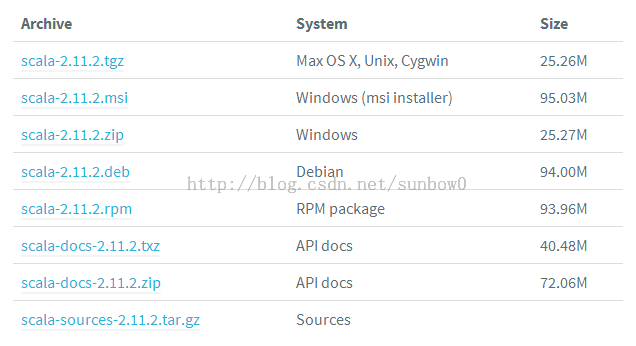

选择版本,scala-2.11.2.tgz,地址:

http://downloads.typesafe.com/scala/2.11.2/scala-2.11.2.tgz?_ga=1.203982480.1401025595.1417397566

2) 解压配置

将下载安装解压,拷贝至目录中/usr/lib/scala-2.11.2,配置环境变量:

vi /etc/profile

添加

#scala

export SCALA_HOME=/usr/lib/scala-2.11.2

export PATH=$SCALA_HOME/bin:$PATH

source /etc/profile,使生效。

测试:

scala –version

Scala code runner version 2.11.2 -- Copyright 2002-2013, LAMP/EPFL

看到提示表示安装成功。

1.4. 下载Spark1.x源码

Spark官方下载地址:

http://spark.apache.org/downloads.html

可以直接下载官方已经编译好的包,如果需要支持其它版本的Hadoop版本需要下载源码重新编译。

1.5. Spark1.x编译

方法一:Maven 编译

exportMAVEN_OPTS="-Xmx2g -XX:MaxPermSize=512M-XX:ReservedCodeCacheSize=512m"

mvn-Pyarn -Dhadoop.version=2.2.0 -Dyarn.version=2.2.0 -DskipTests clean package

方法二:ssh脚本编译

Spark源文件根目录下:make-distribution.sh ,其参数:

--hadoop VERSION : Hadoop 版本号,不加此参数时hadoop 版本为1.0.4 。

--with-yarn :是否支持Hadoop YARN ,不加参数时为不支持yarn 。

--with-hive :是否在Spark SQL 中支持hive ,不加此参数时为不支持hive 。

--skip-java-test :是否在编译的过程中略过java 测试,不加此参数时为略过。

--with-tachyon :是否支持内存文件系统Tachyon ,不加此参数时不支持tachyon 。

--tgz :在根目录下生成 spark-$VERSION-bin.tgz ,不加此参数时不生成tgz 文件,只生

成/dist 目录。

--name NAME :和— tgz 结合可以生成spark-$VERSION-bin-$NAME.tgz 的部署包,不加此

参数时NAME 为hadoop的版本号。

部署包生成方法:

1)生成支持yarn 、hadoop2.2.0 的部署包:

./make-distribution.sh--hadoop 2.2.0 --with-yarn --tgz

2)生成支持yarn 、hive 的部署包:

./make-distribution.sh--hadoop 2.2.0 --with-yarn --with-hive --tgz

1.6. Spark1.x部署安装

1) Spark安装包解压

将上面编译生成的安装包解压,拷贝至安装目录;(注意所有集群的安装目录必需一致);

2) Spark配置文件配置

vi spark-1.0.2/conf/ slaves

slave1

slave2

slave3

vi spark-1.0.2/conf/spark-env.sh

exportJAVA_HOME=/usr/local/jdk1.7.0_03

exportSPARK_MASTER_IP=192.168.180.216

exportSPARK_MASTER_PORT=7077

exportSPARK_WORKER_INSTANCES=1

exportSPARK_WORKER_CORES=2

exportSPARK_WORKER_MEMORY=6g

export SPARK_MASTER_WEBUI_PORT=8080

#exportSPARK_SSH_OPTS="-p37856 -o StrictHostKeyChecking=no -t"

如果集群SSH端口修改过,需要设置SPARK_SSH_OPTS,如果集群启动时JAVA_HOME报错,需要设置JAVA_HOME。

设置一下操作系统的环境变量,然后source一下

vi /etc/profile

#spark

export SPARK_HOME=/user/lib/spark-1.0.2

export PATH=$SPARK_HOME/bin:$PATH

source /etc/profile

3) 集群部署

Spark安装文件拷贝到各slaves中,并且各节点设置环境变量;

scp -r spark-1.0.2 hadoop: /usr/lib/

4) 集群启动

在Master主机上启动spark standalone集群

sbin/start-all.sh

启动完成后,通过浏览器访问http://master: 8080可以监控spark Standalone集群

启动完成后,通过jps查看是否有Master, Worker进程;

转载请注明出处:

http://blog.csdn.net/sunbow0/article/details/41962275