Hadoop在Linux下伪分布式的安装 wordcount实例的运行

1.安装配置java1.7(不累述)。配置完毕后,在命令行中输入java-version,如出现下列信息说明java环境安装成功。

若不会则参考http://blog.csdn.net/havedream_one/article/details/39083659

2.下载hadoop-0.20.2.tar.gz,放在用户根目录下,例如:/home/hadoop

下载地址:http://mirror.bjtu.edu.cn/apache/hadoop/common/hadoop-0.20.2/

解压:tar –zvxf hadoop-0.20.2.tar.gz

PS:关门为hadoop创建了一个hadoop用户

命令 :root@ubuntu:~# sudo addgroup hadoop

root@ubuntu:~# sudo adduser –ingroup hadoop hadoop

PS:创建了hadoop用户之后,执行sudo却出现问题,解决

修改/etc/sudoers文件

参考:http://blog.csdn.net/havedream_one/article/details/39180589

3.配置hadoop,hadoop 的主要配置都在hadoop-0.20.2/conf 下。

(1)在conf/hadoop-env.sh 中配置Java 环境以及HADOOP_HOME、PATH,例如

export JAVA_HOME=/usr/local/jdk7

export HADOOP_HOME=/home/hadoop/hadoop-0.20.2

export PATH=$PATH://home/hadoop/hadoop-0.20.2/bin

(2)配置conf/core-site.xml、conf/hdfs-site.xml、conf/mapred-site.xml

http://blog.csdn.net/havedream_one/article/details/39098605

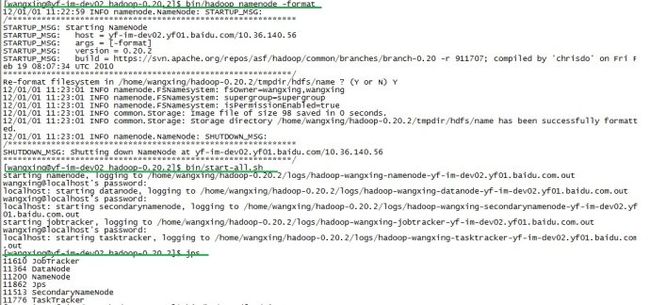

4.格式化namenode、datanode:bin/hadoop namenode -format、bin/hadoopdatanode -format

5.启动hadoop所有进程:bin/start-all.sh,我这边没有进行SSH无密码验证配置,所有namenode、datanode等的启动都需要输入用户登录linux的密码

设置无密码验证:

参考:http://blog.csdn.net/havedream_one/article/details/39098641

6.查看hadoop进程启动情况:jps。正常情况下应该有NameNode、SecondaryNameNode、DataNode、JobTracker、TaskTracker

ps:不出现namenode或datanode,请检查配置文件,伪分布模式先,最好

http://blog.csdn.net/havedream_one/article/details/39098605

7.查看集群状态:bin/hadoop dfsadmin -report

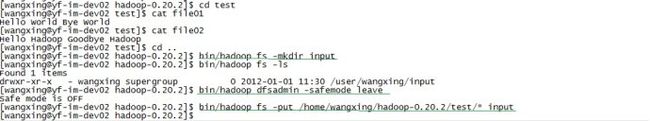

8.在 /home/hadoop/hadoop-0.20.2创建目录test,在test下创建文本file01、file02,分别输入数个单词

9.在hdfs分布式文件系统创建目录input:bin/hadoop fs -mkdir input;之后可以使用bin/hadoopfs -ls查看

ps:删除目录:bin/hadoop fs -rmr ***;删除文件:bin/hadoop fs -rm ***

10.离开hodoop的安全模式:bin/hadoop dfsadmin -safemode leave

11.将文本文件放入hdfs分布式文件系统中:bin/hadoop fs -put/home/wangxing/hadoop-0.20.2/test/* input

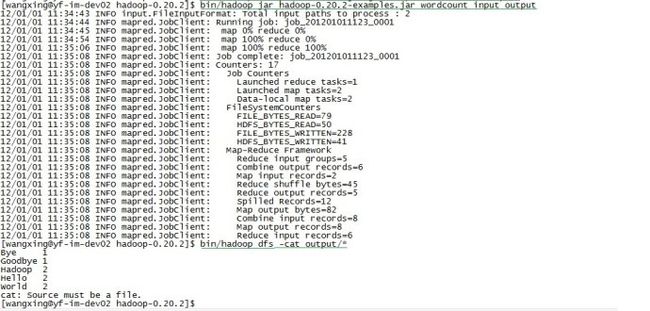

12.执行例子中的WordCount:bin/hadoop jar hadoop-0.20.2-examples.jarwordcount input output

13.查看执行结果:bin/hadoop dfs -cat output/*

14.关闭hadoop所有进程:bin/stop-all.sh