西瓜书第二章笔记

概念

错误率(error rate):分类错误的样本数占样本总数的比例

精度(accuracy):精度 = 1 - 错误率

误差(error):学习器的实际预测输出与样本的真实输出之间的差异

训练误差(training error)/经验误差(empirical error):学习器在训练集上的误差

泛化误差(generalization error):学习器在新样本上的误差

过拟合(overfitting):学习器把训练样本自身的一些特点当作了所有潜在样本都会具有的一般性质,导致泛化性能下降

欠拟合(underfitting):学习器对训练样本的一般性质尚未学好

评估方法

如果我们还有一个包含m个样例的数据集D={(x1,y1),(x2,y2),...,(xm,ym)},既要训练,又要测试,就需要通过对D进行适当的处理,从中产生出训练集S和测试集T。

1,留出法 (hold-out)

2,交叉验证法(cross validation)

3,自助法 (bootstrapping)

性能度量(performance measure):衡量模型泛化能力的评价标准。

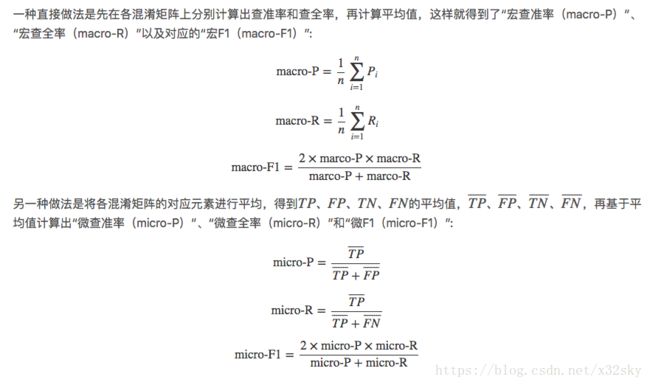

概念 查准率、查全率与F1:

查准率(precision):检索出来的条目中准确的占比

查全率(recall):所有准确的条目检索出来的占比

查准率和查全率是一对矛盾的度量.一般来说,查准率高时,查全率往往

偏低

平衡点(Break-Even Point,简称BEP):为了在PR图中识别学习器的性能谁更优异,人们设计了一些综合考虑查准率、查全率的性能度量。平衡点就是其中之一,它是查准率=查全率时的取值。平衡点的取值越大,学习器越优。

ROC 与 AUC

ROC全称是“受试者工作特征(Receiver Operating Characteristic)”曲线。根据学习器的预测结果对样例进行排序,按此顺序逐个把样本作为正例进行预测,每次计算出两个重要量的值,分别以它们的横、纵坐标作图,就得到了ROC曲线。ROC曲线的纵轴是“真正例率(True Positive Rate,简称TPR)”,横轴是“假正例率(False Positive Rate,简称FPR)”,两者分别定义为:

其中AUC(Area Under ROC Curve)为ROC曲线下所包含的面积,用于判断学习器间的性能谁更优。

偏差与方差

偏差-方差分解(bias-variance decomposition)是解释学习算法泛化性能的一种重要工具。

偏差-方差分解试图对学习算法的期望泛化错误率进行拆解。

泛化误差可分解为偏差、方差与噪声之和。

偏差度量了学习算法的期望预测与真实结果的偏离程度,即刻画了学习算法本身的拟合能力

方差度量了同样大小的训练集的变动所导致的学习性能的变化,即刻画了数据扰动所造成的影响

噪声表达了在当前任务上任何学习算法所能达到的期望泛化误差的下界,即刻画了学习问题本身的难度