FFmpeg基础知识总结

1. 概述

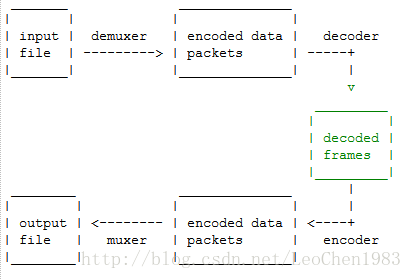

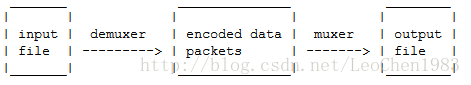

从事多媒体技术研发工程师想必提到最多的开源工程即是ffmpeg,全称是Fast Forward MPEG,有很多视频相关的互联网公司都使用该开源程序,如Google、Facebook、Youtube、腾讯、优酷土豆、爱奇艺、暴风等等。但根据使用场景的不同,术语经常有不同的含义,极易造成沟通不一致。我对ffmpeg的理解是:首先它是一个多媒体处理的工具软件(exe可执行程序),其次它还是一套完整的、可供二次开发的多媒体处理的SDK/API(头文件、lib、dll),最后它还是源代码全部开源且可容纳多个其他各种开源协议的音视频开源工程多媒体框架。本文也由浅入深分三个阶段进行介绍,首先是ffmpeg工具集的使用,其次是ffmpeg SDK的开发心得与小程序举例,最后是源码分析以及与其他开源工程的接口分析。

2. ffmpeg工具集的使用

Windows官方下载的形式为”ffmpeg-版本号-win32-bin”, Linux可通过 apt-get下载

sudo add-apt-repository ppa:mc3man/trusty-media

sudo add-apt-repository ppa:kirillshkrogalev/ffmpeg-next

sudo apt-get update

sudo apt-get dist-upgrade

sudo apt-get install ffmpeg

bin文件夹下是ffmpeg的应用程序,具体包括

ffmpeg:是一个媒体处理的万能工具,可以转换音视频协议、容器,或对音视频流进行合并、分割,既能处理文件又能处理实时流,格式工厂、SRS等都是基于该程序所做;

ffprobe:是一个用来查看多媒体文件的信息的工具,media info是基于该程序所做;

ffplay:是一个简单的播放器,使用ffmpeg 库解析和解码,通过SDL显示;

ffserver:是一个简单的流Server,仅在Linux下才能编译通过,支持RTP+RTSP/HTTP协议。

关于ffmpeg工具集的基本使用、编码参数和协议参数可参考如下四个文档:

(1). FFmpeg Documentation

(2). FFplay Documentation

(3). FFprobe Documentation

(4). FFserver Documentation

这些工具集如果使用好之后,在外围用C++/Python等做一个ffmpeg进程的warpper,就可以直接构建面向应用的程序或服务了。

ffmpeg.exe对于我来说更多的当成一个瑞士军刀来使用,它可以将任意一种音视频的封装格式、协议转化成任意另外一种封装格式与协议,并在转化过程中对音视频原始数据上做一些处理;

输入可以是文件、管道、网络流、采集的原始音视频流 -i参数

输出可以是文件、网络流 没有参数(不需要-o参数)

传输内容的类型可以是单一视频、音频、数据、字幕、attachment等也可以是多种类型即它们的混合 -map来选择 2:3代表第3路输入文件中的第4个流,-vn/-an/-sn/-dn禁止某个流

由于ffplay可以直接采集摄像头,ffmpeg也可以进行显示,故两者一同来介绍。

例:

(1). ffmpeg解码+显示

ffmpeg -re -i test.264 -pix_fmt yuv420p -f sdl 1.yuv (2). ffplay采集+显示

ffplay -f dshow -i video="Integrated Camera" 2.1 基本命令

离不开如下库(SDK开发也会用到下面的库)

libavformat 封装格式

libavcodec 编码格式

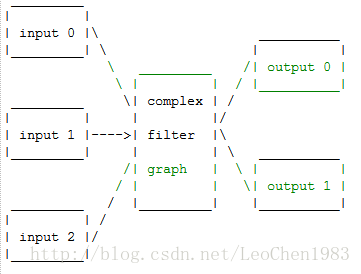

libavfilter 中间处理

例:限定比特率与帧率

ffmpeg -i input.avi -b:v 64k -bufsize 64k -r 24 output.avi简单处理: -filter -vf/-af

复杂处理:-lavfi -filter_complex

直接复制

针对流本身的参数:

例

-codec:a:1 ac3

-b:a 128k

-threads:1 4

2.2 ffmpeg流媒体相关应用

- 采集->编码->媒体流发送

ffmpeg -r 帧率 -f dshow(windows平台) -s 宽×高 -i video=”视频采集设备名称”:audio=”音频采集设备名称” -vcodec 视频编码协议名 -b 带宽 -vpre slow -acodec 音频编码协议名 -ab 音频带宽 -f 传输协议名 rtmp://server/application/stream_name

例:

ffmpeg -r 25 -f dshow -s 640×480 -i video="video source name":audio="audio source name" -vcodec libx264 -b 600k -vpre slow -acodec libfaac -ab 128k -f flv rtmp://server/application/stream_name- 文件->[转码]->媒体流发送

ffmpeg -i 文件名 -re -vcodec 编解码协议名 -f 传输协议名(如果是编解码协议即为裸流) udp[rtp]://ip:port

-re 按照原来帧率发送

-vcodec copy 不用重新编解码,编解码协议名包括 h264、mpeg2video

-f 传输协议名(如果是编解码协议即为裸流),h264、mpeg2video、rtp

例:

ffmpeg -re -i 1.h264 -vcodec copy -f h264 udp://ip:port udp传输264裸流

ffmpeg -re -i 1.h264 -vcodec mpeg2video -f mpeg2video udp://ip:port udp传输转码后的mpeg2video裸流

ffmpeg -re -i 1.h264 -vcodec copy -f rtp rtp://ip:port>test.sdp rtp传输264流

ffmpeg -re -i 1.flv -vcodec copy -acodec copy -f flv -y rtmp://ip:1935/live/livestream rtmp传输flv流 - 媒体流接收->解码->显示

ffplay -max_delay -f 编解码协议名

-max_delay 最大时延

-f 传输协议名(如果是编解码协议即为裸流),h264、mpeg2video、rtp

例:

ffplay -max_delay 100000 -f h264 udp://ip:port 播放264流

ffplay test.sdp 播放rtp流

ffplay "rtmp://ip/app/livestream live=1" 播放rtmp流- 媒体流接收->[转码]->保存文件

ffmpeg -i 流媒体url -c copy[-c:v 视频协议 -c:a 音频协议或-vcodec 视频协议 -acodec 音频协议] 1.flv[mp4]

例:

ffmpeg -i rtmp://ip/live/streamName -c copy 1.flv- 流媒体接收->[转码]->流媒体发送

ffmpeg -i 流媒体url -c copy[-c:v 视频协议 -c:a 音频协议或-vcodec 视频协议 -acodec 音频协议] 流媒体url

例:

ffmpeg -i rtmp://ip/live/originalStream -c:a copy -c:v libx264 -vpre slow -f flv rtmp://server/live/h264Stream

如果中间有空格,则加双引号 "rtmp://server/live/h264Stream live=1"

ffmpeg -i rtmp://ip/live/originalStream -c:a libfaac -ar 44100 -ab 48k -c:v libx264 -vpre slow -vpre baseline -f flv rtmp://ip/live/h264Stream- 多路

文件推流+显示

ffmpeg -re -i 1.h264 -pix_fmt yuv420p –f sdl 1.yuv -vcodec copy -f flv rtmp://localhost/Demo/livestream 由此可见ffmpeg也可以做为输出工具,1.yuv不会真的生成

流媒体推流+不同清晰度转码

ffmpeg -re -i rtmp://server/live/high_FMLE_stream -acodec copy -vcodec x264lib -s 640×360 -b 500k -vpre medium -vpre baseline rtmp://server/live/baseline_500k -acodec copy -vcodec x264lib -s 480×272 -b 300k -vpre medium -vpre baseline rtmp://server/live/baseline_300k -acodec copy -vcodec x264lib -s 320×200 -b 150k -vpre medium -vpre baseline rtmp://server/live/baseline_150k -acodec libfaac -vn -ab 48k rtmp://server/live/audio_only_AAC_48k流媒体推流+不同清晰度转码,没有用-vpre medium,使用了-x264opts

ffmpeg -re -i rtmp://server/live/high_FMLE_stream -c:a copy -c:v x264lib -s 640×360 -x264opts bitrate=500:profile=baseline:preset=slow rtmp://server/live/baseline_500k -c:a copy -c:v x264lib -s 480×272 -x264opts bitrate=300:profile=baseline:preset=slow rtmp://server/live/baseline_300k -c:a copy -c:v x264lib -s 320×200 -x264opts bitrate=150:profile=baseline:preset=slow rtmp://server/live/baseline_150k -c:a libfaac -vn -b:a 48k rtmp://server/live/audio_only_AAC_48k - 其他

用图片循环生成视频

例:

ffmpeg.exe -i INPUT.jpg -an -vcodec libx264 -coder 1 -flags +loop -cmp +chroma -subq 10 -qcomp 0.6 -qmin 10 -qmax 51 -qdiff 4 -flags2 +dct8x8 -trellis 2 -partitions +parti8x8+parti4x4 -crf 24 -threads 0 -r 25 -g 25 -y OUTPUT.mp4 3. ffmpeg工具编译

3.1 Linux环境下 ffmpeg编译

- Yasm

汇编编译器

wget http://www.tortall.NET/projects/yasm/releases/yasm-1.2.0.tar.gz

tar xzvf yasm-1.2.0.tar.gz

cd yasm-1.2.0

./configure && make && make install- x264

H.264 软件编码器

git clone git://git.videolan.org/x264

cd x264

./configure --enable-shared && make && make install- LAME

mp3编解码器

wget http://downloads.sourceforge.Net/project/lame/lame/3.99/lame-3.99.5.tar.gz

tar xzvf lame-3.99.5.tar.gz

cd lame-3.99.5

./configure --enable-nasm && make && make install- libogg

ogg编解码器

wget http://downloads.xiph.org/releases/ogg/libogg-1.3.0.tar.gz

tar xzvf libogg-1.3.0.tar.gz

cd libogg-1.3.0

./configure && make && make install- libvorbis

vorbis编解码器

wget http://downloads.xiph.org/releases/vorbis/libvorbis-1.3.3.tar.gz

tar xzvf libvorbis-1.3.3.tar.gz

cd libvorbis-1.3.3

./configure && make && make install- libvpx

vp8、vp9编解码器

wget http://storage.googleapis.com/downloads.webmproject.org/releases/webm/libvpx-1.6.1.tar.bz2

cd libvpx

./configure --enable-shared && make && make install原来用的libvpx 1.3.0有问题

ubuntu16.04:

error: conflicting types for ‘max_align_t’

max_align_t C11/C++11

typedef struct {

long long max_align_ll __attribute((aligned(alignof(long long))));

long double max_align_ld __attribute((aligned(alignof(long double))));

} max_align_t;

libvpx

union max_align

{

char c;

short s;

long l;

int i;

float f;

double d;

void * v;

void (*q)(void);

};

typedef union max_align max_align_t;

弃用libvpx1.3.0

使用libvpx1.6.1

- FAAD2

AAC编解码器

wget http://downloads.sourceforge.net/project/faac/faad2-src/faad2-2.7/faad2-2.7.tar.gz

tar zxvf faad2-2.7.tar.gz

cd faad2-2.7 && make && make install- FAAC

AAC编解码器

wget http://downloads.sourceforge.net/project/faac/faac-src/faac-1.28/faac-1.28.tar.gz

tar zxvf faac-1.28.tar.gz && make && make installmpeg4ip.h:126: error: new declaration ‘char* strcasestr(const char*, const char*)’

解决方法:

mpeg4ip.h从124行extern “C”换成extern “C++”,到126行char 前加const结束。

- Xvid

MPEG4编解码器

wget http://downloads.xvid.org/downloads/xvidcore-1.3.2.tar.gz

tar zxvf xvidcore-1.3.2.tar.gz

cd xvidcore/build/generic

./configure && make && make install- fdk-aac

AAC编解码器

git clone git://github.com/mstorsjo/fdk-aac

./configure && make && make install- opus

opus编解码器

wget http://downloads.xiph.org/releases/opus/opus-1.1.4.tar.gz

tar zxvf opus-1.1.4.tar.gz

./configure && make && make install- rtmpdump

rtmp传输协议

wget http://rtmpdump.mplayerhq.hu/download/rtmpdump-2.3.tgz

apt-get install openssl

apt-get install libssl-dev

apt-get install zlib1g-dev

tar zxvf rtmpdump-2.3.tgz

make && make install- ffmpeg

git clone git://source.ffmpeg.org/ffmpeg

cd ffmpeg

./configure \

--enable-version3 \

--enable-libvpx \

--enable-libfdk-aac \

--enable-libfaac \

--enable-libvorbis \

--disable-libopus \

--enable-libmp3lame \

--enable-libx264 \

--enable-libxvid \

--enable-librtmp \

--enable-shared \

--enable-gpl \

--enable-postproc \

--enable-nonfree \

--enable-avfilter \

--enable-pthreads

make && make install修改/etc/ld.so.conf如下:

include ld.so.conf.d/*.conf

/lib

/lib64

/usr/lib

/usr/lib64

/usr/local/lib

/usr/local/lib64

ldconfig

3.2 Windows mingw环境下 ffmpeg编译

未完待续

3.3 Windows VS2015环境下 ffmpeg编译

未完待续