边学边记(1):scrapy初窥门径爬一爬前程无忧职位

边学边记,记录遇到的坑达成的小目标。

先上一张图

Scrapy主要包括了以下组件:

- 引擎(Scrapy)

用来处理整个系统的数据流处理, 触发事务(框架核心) - 调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址 - 下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的) - 爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面 - 项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被发送到项目管道,并经过几个特定的次序处理数据。 - 下载器中间件(Downloader Middlewares)

位于Scrapy引擎和下载器之间的框架,主要是处理Scrapy引擎与下载器之间的请求及响应。 - 爬虫中间件(Spider Middlewares)

介于Scrapy引擎和爬虫之间的框架,主要工作是处理蜘蛛的响应输入和请求输出。 - 调度中间件(Scheduler Middewares)

介于Scrapy引擎和调度之间的中间件,从Scrapy引擎发送到调度的请求和响应。

Scrapy运行流程大概如下:

- 引擎从调度器中取出一个链接(URL)用于接下来的抓取

- 引擎把URL封装成一个请求(Request)传给下载器

- 下载器把资源下载下来,并封装成应答包(Response)

- 爬虫解析Response

- 解析出实体(Item),则交给实体管道进行进一步的处理

- 解析出的是链接(URL),则把URL交给调度器等待抓取

更多请移步 scrapy1.0中文教程

这些个流程原理还是需要细细品。不过话说回来python提供功能丰富性能强大的各种包,而每个包又提供了各种各样的函数,想要深入了解太难了,不如当成一部字典知道怎么去查找函数实现想要的功能,其他时候复制粘贴就可以了。菜鸟妄言,大神勿拍!

闲话少说,上菜了

step1. win系统下在cmd里打开想要创建工程的目录运行:scrapy startproject qcwy

step2. cd进入qcwy文件夹,运行:scrapy genspider Qcwyjob "51job.com" #关于genspider 点这里

step3. 此时在qcwy下面会看到如下几个文件:

关于这几个文件的介绍网上一大把就不说了。

进入spiders文件夹,Qcwyjob.py是step2后生成的文件也就是要编辑的spider文件

step4. 开始编辑文件:

1). items是最简单的一个,里面定义想要抓取的数据而且格式都是固定的,就是一填空题

import scrapy

class QcwyItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

Positionname=scrapy.Field() #职位名称

Companyname=scrapy.Field() #公司名称

Salary=scrapy.Field() #薪资福利

Workplace=scrapy.Field() #工作地点

Posttime=scrapy.Field() #发布时间

Experience=scrapy.Field() #工作经验

Xueli=scrapy.Field() #学历要求

Number=scrapy.Field() #招聘人数

#Rewards=scrapy.Field() #福利待遇import pymysql

import json

from scrapy import log

class QcwyPipeline(object):

def __init__(self):

#在初始化方法中打开文件

self.fileName = open("qcwy.json","wb")

def process_item(self, item, spider):

#把数据转换为字典再转换成json

text = json.dumps(dict(item),ensure_ascii=False)+"\n"

#写到文件中编码设置为utf-8

self.fileName.write(text.encode("utf-8"))

#返回item

return item

def close_spider(self,spider):

#关闭时关闭文件

self.fileName.close()

class MySQLPipeline(object):

def __init__(self):

# 连接数据库

self.connect = pymysql.connect(

host='localhost',

db='scrapy', #自己的数据库

user='root',

passwd='xxxxx', #数据库的密码

charset='utf8',

use_unicode=True)

# 通过cursor执行增删查改

self.cursor = self.connect.cursor()

def process_item(self, item, spider):

sql='insert into qcwy (Positionname,Companyname, Workplace, Salary ,Posttime,Experience,Xueli,Number) values (%s, %s, %s, %s, %s, %s,%s,%s)'

self.cursor.execute(sql,(item['Positionname'],

item['Companyname'],

item['Workplace'],

item['Salary'],

item['Posttime'],

item['Experience'],

item['Xueli'],

item['Number']

)

)

# 提交sql语句

self.connect.commit()

return item

我打开如下几项:

ROBOTSTXT_OBEY = False

DOWNLOAD_DELAY = 3

DEFAULT_REQUEST_HEADERS = {

'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Referer':'http://www.51job.com/',

}

ITEM_PIPELINES = {

'qcwy.pipelines.QcwyPipeline': 300,

'qcwy.pipelines.MySQLPipeline': 300, #这里是最重要的部分,一定要将自己定义的pipelines添加进来

}4).开始编辑spider,直接上代码:

import scrapy

from qcwy.items import QcwyItem

class QcwyjobSpider(scrapy.Spider):

name = 'QcwyJob'

allowed_domains = ['51job.com']

start_urls = ['http://search.51job.com/list/000000,000000,0000,00,9,99,%25E6%2595%25B0%25E6%258D%25AE%25E5%2588%2586%25E6%259E%2590,2,1.html?lang=c&stype=&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&providesalary=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare=']

def parse(self, response):

jobs=response.xpath(".//div[@class='el']")[4:] #jobs1前4项不是想要的数据,偷懒直接pass掉了

for job in jobs:

item=QcwyItem()

item['Positionname']=job.xpath(".//p/span/a/text()").extract()[0].strip()

item['Companyname']=job.xpath(".//span[@class='t2']/a/text()").extract()[0]

item['Workplace']=job.xpath(".//span[@class='t3']/text()").extract()[0]

try:

item['Salary']=job.xpath(".//span[@class='t4']/text()").extract()[0]

except:

item['Salary']='面议' #用try是部分公司薪水没写,空列表报错

item['Posttime']=job.xpath(".//span[@class='t5']/text()").extract()[0]

url=job.xpath(".//p/span/a/@href").extract()[0]

yield scrapy.Request(url,callback=self.parse_detail,dont_filter=True,meta={'key':item})

next_page=response.xpath(".//li[@class='bk'][2]/a/@href").extract()[0]

yield scrapy.Request(next_page,callback=self.parse)

#meta的用法,很实用

def parse_detail(self,response):

for info in response.xpath(".//div[@class='t1']"):

try:

item=response.meta['key']

item['Experience']=info.xpath(".//span[@class='sp4'][1]/text()").extract()[0] #工作经验

item['Xueli']=info.xpath(".//span[@class='sp4'][2]/text()").extract()[0] #学历要求

item['Number']=info.xpath(".//span[@class='sp4'][3]/text()").extract()[0] #招聘人数

#item['Rewards']=info.xpath(".//span/text()").extract()

except:

continue

yield item

关于selector,移步 selector终端

因为是菜鸟最开始是用正则表达式的,可发现需要补得知识点太多而且不好记!xpath真是超简单实用半个小时看完再多练习基本上可以做了啊!!!scrapy终端scrapy shell终端也是神器,不得不说scrapy真是方便啊

step5. 接下来就是跑spider了

在目录下scrapy crawl Qcwyjob

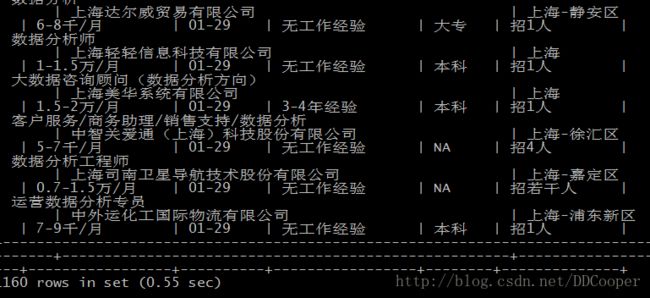

得到的就是类似下面的数据

1160条,因为我只爬取了上海前25页数据分析的职位,25页之后都是乱七八糟无关的岗位就在next_page部分做了改动只爬到25页

最后说说感受:

1.scrapy真是强大的一个框架,其实真正需要做的就是填空,将需要的东西填入对应的位置之后就差不多了。不过这只是最简单的爬虫,还没有设计到太麻烦的东西,所谓学无止境边学边摸索吧

2.抓取不到数据时要仔细看生成的档案,我是用ipython来运行的,有问题的话仔细找找它其实是会告诉你哪里出了状况(settings ,pipelines,spider这几个)然后进去研究

3.python是一部工具书,没必要知道所有的函数,但要知道怎么去查找函数