redis笔记

redis是什么

Redis is an open source (BSD licensed), in-memory data structure store, used as a database, cache and message broker. It supports data structures such as strings, hashes, lists, sets, sorted sets with range queries, bitmaps, hyperloglogs and geospatial indexes with radius queries.

开源的,BSD许可,高级的key-value存储系统,可以用来存储字符串、哈希结构、链表、集合,因此常用来提供数据结构服务。

redis和memcached相比的独特之处

- redis可以用来做存储(storge),而memcached是用来做缓存(cache),这个特点主要是因为其“持久化”的功能。

- 存储的数据结构:对于memcache来说,存储的数据只有1种类型——字符串,而redis则可以存储字符串、链表、哈希结构、集合、有序集合。

Redis对于key的操作命令

keys pattern

查询相应的key

- keys *

- keys site

- keys sit[e|y]

在redis里,允许模糊查询key

有3个通配符 *, ? ,[]

- *: 通配任意多个字符

- ?: 通配单个字符

- []: 通配括号内的某1个字符

redis 127.0.0.1:6379> flushdb

OK

redis 127.0.0.1:6379> keys *

(empty list or set)

redis 127.0.0.1:6379> mset one 1 two 2 three 3 four 4

OK

redis 127.0.0.1:6379> keys o*

1) "one"

redis 127.0.0.1:6379> key *o

(error) ERR unknown command 'key'

redis 127.0.0.1:6379> keys *o

1) "two"

redis 127.0.0.1:6379> keys ???

1) "one"

2) "two"

redis 127.0.0.1:6379> keys on?

1) "one"

redis 127.0.0.1:6379> set ons yes

OK

redis 127.0.0.1:6379> keys on[eaw]

1)"one"randomkey

返回随机key

exists key

判断key是否存在,返回值是1/0

type key

返回key存储值的类型

有String、link、set、order set、hash

ttl key

查询key的生命周期,返回的是秒数

注:对于不存在的key或已过期的key 和 不过期永久有效的key,都返回-1 Redis2.8中,对于不存在的key,返回-2

expire key 整型值

设置key的生命周期,以秒为单位

同理:

- pexpire key 毫秒数, 设置生命周期

- pttl key, 以毫秒返回生命周期

persist key

把key设置为永久有效

del key1 key2 … keyn

删除1个或者多个键,不存在的key忽略掉,返回真正删除的key的个数

rename key newKey

给key一个新的newKey名,如果newKey已经存在,则newKey的原值被覆盖

renamenx key newKey

把key改名为newKey,发生修改返回1,未发生修改返回0

注:nx——>not exists,即newKey不存在时作改名动作,存在则不改防止跟已有的冲突

move key db

将key移到某个数据库

注意: 一个redis进程,打开了不止一个数据库, 默认打开16个数据库,从0到15编号,如果想打开更多数据库,可以从配置文件修改

redis 127.0.0.1:6379[1]> select 2

OK

redis 127.0.0.1:6379[2]> keys *

(empty list or set)

redis 127.0.0.1:6379[2]> select 0

OK

redis 127.0.0.1:6379> keys *

1) "name"

2) "cc"

3) "a"

4) "b"

redis 127.0.0.1:6379> move cc 2

(integer) 1

redis 127.0.0.1:6379> select 2

OK

redis 127.0.0.1:6379[2]> keys *

1) "cc"

redis 127.0.0.1:6379[2]> get cc

"3"Redis字符串类型的操作

set key value [ ex 秒数 ] / [px 毫秒数] [ nx ] / [xx]

设置key值的同时设置有效期,同时写以后面的有效期为准

set a 1 ex 10 //10秒有效

set a 1 px 9000 //9秒有效

set a 1 ex 100 px 9000 //同时写以后面的有效期为准,这里是9000毫秒nx: 表示只有key不存在时才能执行操作

xx: 表示key必须存在时,执行操作

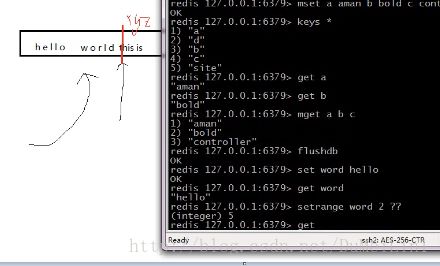

mset key1 value1 key2 value2 …

一次性设置多个key值

例: mset key1 v1 key2 v2 ….

get key

获取key的值

mget key1 key2 … keyn

获取多个key值

setrange key offset value

redis 127.0.0.1:6379> set greet hello

OK

redis 127.0.0.1:6379> setrange greet 2 x

(integer) 5

redis 127.0.0.1:6379> get greet

"hexlo"注意: 如果偏移量>字符长度, 该字符自动补0x00

redis 127.0.0.1:6379> setrange greet 6 !

(integer) 7

redis 127.0.0.1:6379> get greet

"heyyo\x00!"append key value

把value追加到key的原值上

getrange key start stop

是获取字符串中 [start, stop]范围的值

注意: 对于字符串的下标,左数从0开始,右数从-1开始

redis 127.0.0.1:6379> set title 'chinese'

OK

redis 127.0.0.1:6379> getrange title 0 3

"chin"

redis 127.0.0.1:6379> getrange title 1 -2

"hines"注意:

1: start>=length, 则返回空字符串

2: stop>=length,则截取至字符结尾

3: 如果start 所处位置在stop右边, 返回空字符串

getset key newValue

获取并返回旧值,设置新值

redis 127.0.0.1:6379> set cnt 0

OK

redis 127.0.0.1:6379> getset cnt 1

"0"

redis 127.0.0.1:6379> getset cnt 2

"1"incr key

指定的key的值加1,并返回加1后的值

注意:

1:不存在的key当成0,再incr操作

2: 范围为64有符号

常用于秒杀场景

incrby key number

增加指定值

redis 127.0.0.1:6379> incrby age 90

(integer) 92incrbyfloat key floatnumber

增加指定的小数

redis 127.0.0.1:6379> incrbyfloat age 3.5

"95.5"decr key

每次减1

redis 127.0.0.1:6379> set age 20

OK

redis 127.0.0.1:6379> decr age

(integer) 19decrby key number

redis 127.0.0.1:6379> decrby age 3

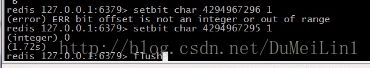

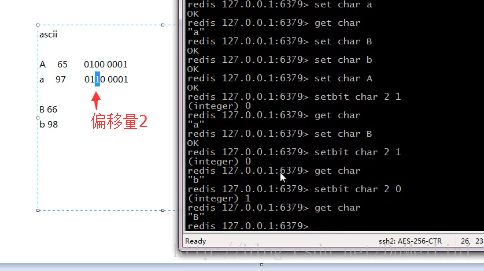

(integer) 16setbit key offset value

设置offset偏移量对应的二进制位上的值,返回的是该位上的旧值

注意:

1:如果offset过大,则会在中间填充0,

2: offset最大大到多少

3:offset最大2^32-1,可推出最大的的字符串为512M

>

常用于字符串大小写转换

getbit key offset

获取值的二进制表示,对应位上的值(从左,从0编号)

redis 127.0.0.1:6379> set char A

OK

redis 127.0.0.1:6379> getbit char 1

(integer) 1

redis 127.0.0.1:6379> getbit char 2

(integer) 0

redis 127.0.0.1:6379> getbit char 7

(integer) 1bitop operation destKey key1 [key2 … ]

对key1,key2..keyN作operation,并将结果保存到 destkey 上。

operation 可以是 AND 、 OR 、 NOT 、 XOR

对key1,key2..keyN作operation,并将结果保存到 destkey 上。

operation 可以是 AND 、 OR 、 NOT 、 XOR

redis 127.0.0.1:6379> setbit lower 7 0

(integer) 0

redis 127.0.0.1:6379> setbit lower 2 1

(integer) 0

redis 127.0.0.1:6379> get lower

" "

redis 127.0.0.1:6379> set char Q

OK

redis 127.0.0.1:6379> get char

"Q"

redis 127.0.0.1:6379> bitop or char char lower

(integer) 1

redis 127.0.0.1:6379> get char

"q"注意: 对于NOT操作, key不能多个

link 链表结构

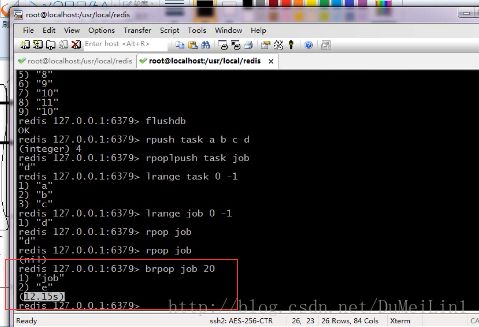

lpush key value

rpop key

返回并删除链表尾元素,lpop key弹出表头

lrange key start stop

返回链表中[start ,stop]中的元素

规律: 左数从0开始,右数从-1开始

lrem key count value

从key链表中删除 value值

注: 删除count的绝对值个value后结束

Count>0 从表头删除

Count<0 从表尾删除

ltrim key start stop

剪切key对应的链接,切[start,stop]一段,并把该段重新赋给key

lindex key index

作用: 返回index索引上的值,

lindex key 2llen key

计算链接表的元素个数

redis 127.0.0.1:6379> llen task

(integer) 3

redis 127.0.0.1:6379> linsert key after | before search value

在key链表中寻找’search’,并在search值之前|之后,.插入value

注: 一旦找到一个search后,命令就结束了,因此不会插入多个value

rpoplpush source dest

把source的尾部拿出,放在dest的头部,并返回该单元值

brpop,blpop key timeout

等待时间内弹出key的尾/头元素,如果没有,在timeout时间内就会一直等待,出现值则pop,Timeout为等待超时时间

如果timeout为0,则一直等待

Setbit 的实际应用

场景: 1亿个用户, 每个用户 登陆/做任意操作 ,记为 今天活跃,否则记为不活跃

>

每周评出: 有奖活跃用户: 连续7天活动

>

每月评,等等…

思路:

Userid dt active

1 2013-07-27 1

1 2013-07-26 1

如果是放在表中, 1:表急剧增大,2:要用group ,sum运算,计算较慢

用: 位图法 bit-map

Log0721: ‘011001……………0’

……

log0726 : ‘011001……………0’

Log0727 : ‘0110000………….1’

1: 记录用户登陆:

每天按日期生成一个位图, 用户登陆后,把user_id位上的bit值置为1

2: 把1周的位图 and 计算,

位上为1的,即是连续登陆的用户

redis 127.0.0.1:6379> setbit mon 100000000 0

(integer) 0

redis 127.0.0.1:6379> setbit mon 3 1

(integer) 0

redis 127.0.0.1:6379> setbit mon 5 1

(integer) 0

redis 127.0.0.1:6379> setbit mon 7 1

(integer) 0

redis 127.0.0.1:6379> setbit thur 100000000 0

(integer) 0

redis 127.0.0.1:6379> setbit thur 3 1

(integer) 0

redis 127.0.0.1:6379> setbit thur 5 1

(integer) 0

redis 127.0.0.1:6379> setbit thur 8 1

(integer) 0

redis 127.0.0.1:6379> setbit wen 100000000 0

(integer) 0

redis 127.0.0.1:6379> setbit wen 3 1

(integer) 0

redis 127.0.0.1:6379> setbit wen 4 1

(integer) 0

redis 127.0.0.1:6379> setbit wen 6 1

(integer) 0

redis 127.0.0.1:6379> bitop and res mon feb wen

(integer) 12500001如上例,优点:

1: 节约空间, 1亿人每天的登陆情况,用1亿bit,约1200WByte,约10M 的字符就能表示

2: 计算方便

集合 set 相关命令

集合的性质: 唯一性,无序性,确定性

注: 在string和link的命令中,可以通过range 来访问string中的某几个字符或某几个元素,但因为集合的无序性,无法通过下标或范围来访问部分元素。

因此想看元素,要么随机先一个,要么全选

sadd key value1 value2

smembers key

返回集中中所有的元素

srem key value1 value2

作用: 删除集合中集为 value1 value2的元素

返回值: 忽略不存在的元素后,真正删除掉的元素的个数

spop key

作用: 返回并删除集合中key中1个随机元素

随机——体现了无序性

场景:抽签活动,肯定不会重复

srandmember key

作用: 返回集合key中,随机的1个元素.,不从集合中删除

sismember key value

作用: 判断value是否在key集合中

是返回1,否返回0

scard key

作用: 返回集合中元素的个数

smove source dest value

作用:把source中的value删除,并添加到dest集合中

sinter key1 key2 key3

作用: 求出key1 key2 key3 三个集合中的交集,并返回

redis 127.0.0.1:6379> sadd s1 0 2 4 6

(integer) 4

redis 127.0.0.1:6379> sadd s2 1 2 3 4

(integer) 4

redis 127.0.0.1:6379> sadd s3 4 8 9 12

(integer) 4

redis 127.0.0.1:6379> sinter s1 s2 s3

1) "4"

redis 127.0.0.1:6379> sinter s3 s1 s2

1)"4"sinterstore dest key1 key2 key3

作用: 求出key1 key2 key3 三个集合中的交集,并赋给dest

suion key1 key2 key3

作用: 求出key1 key2 keyn的并集,并返回

sdiff key1 key2 key3

作用: 求出key1与key2 key3的差集

即key1-key2-key3

order set 有序集合

score代表排序因子,即排序的依据

zadd key score1 value1 score2 value2

添加元素

redis 127.0.0.1:6379> zadd stu 18 lily 19 hmm 20 lilei 21 lilei

(integer) 3zrange key start stop [withscores]

把集合排序后,返回名次[start,stop]的元素,默认是升续排列,Withscores 是把score也打印出来

zrevrange key start stop

作用:把集合降序排列,取名字[start,stop]之间的元素

zrangebyscore key min max [withscores] limit offset N

集合(升续)排序后,取score在[min,max]内的元素,并跳过 offset个, 取出N个

redis 127.0.0.1:6379> zadd stu 1 a 3 b 4 c 9 e 12 f 15 g

(integer) 6

redis 127.0.0.1:6379> zrangebyscore stu 3 12 limit 1 2 withscores //abcefg

1) "c"

2) "4"

3) "e"

4) "9"zrank key member

查询member的排名(升续 0名开始)

zrevrank key member

查询 member的排名(降续 0名开始)

zrem key value1 value2

删除集合中的元素

zremrangebyscore key min max

作用: 按照socre来删除元素,删除score在[min,max]之间的

redis 127.0.0.1:6379> zremrangebyscore stu 4 10

(integer) 2

redis 127.0.0.1:6379> zrange stu 0 -1

1) "f"zremrangebyrank key start end

作用: 按排名删除元素,删除名次在[start,end]之间的

redis 127.0.0.1:6379> zremrangebyrank stu 0 1

(integer) 2

redis 127.0.0.1:6379> zrange stu 0 -1

1) "c"

2) "e"

3) "f"

4) "g"zcard key

返回元素个数

zcount key min max

返回[min,max]区间内元素的数量

zinterstore destination numkeys key1 [key2…] [WEIGHTS weight [weight …]] [AGGREGATE SUM|MIN|MAX]

zinterstore destination numkeys key1 [key2 …]

[WEIGHTS weight [weight …]]

[AGGREGATE SUM|MIN|MAX]

求key1,key2的交集,key1,key2的权重分别是 weight1,weight2

聚合方法用: sum |min|max

聚合的结果,保存在dest集合内

注意: weights ,aggregate如何理解?

答: 如果有交集, 交集元素又有socre,score怎么处理?

Aggregate sum->score相加 , min 求最小score, max 最大score

另: 可以通过weigth设置不同key的权重, 交集时,socre * weights

比如导师一票相当于个人投票的50票

redis 127.0.0.1:6379> zadd z1 2 a 3 b 4 c

(integer) 3

redis 127.0.0.1:6379> zadd z2 2.5 a 1 b 8 d

(integer) 3

redis 127.0.0.1:6379> zinterstore tmp 2 z1 z2

(integer) 2

redis 127.0.0.1:6379> zrange tmp 0 -1

1) "b"

2) "a"

redis 127.0.0.1:6379> zrange tmp 0 -1 withscores

1) "b"

2) "4"

3) "a"

4) "4.5"

redis 127.0.0.1:6379> zinterstore tmp 2 z1 z2 aggregate sum

(integer) 2

redis 127.0.0.1:6379> zrange tmp 0 -1 withscores

1) "b"

2) "4"

3) "a"

4) "4.5"

redis 127.0.0.1:6379> zinterstore tmp 2 z1 z2 aggregate min

(integer) 2

redis 127.0.0.1:6379> zrange tmp 0 -1 withscores

1) "b"

2) "1"

3) "a"

4) "2"

redis 127.0.0.1:6379> zinterstore tmp 2 z1 z2 weights 1 2

(integer) 2

redis 127.0.0.1:6379> zrange tmp 0 -1 withscores

1) "b"

2) "5"

3) "a"

4) "7"Hash 哈希数据类型相关命令

hset key field name

作用: 把key中 filed域的值设为value

注:如果没有field域,直接添加,如果有,则覆盖原field域的值

hmset key field1 value1 [field2 value2 field3 value3 ……fieldn valuen]

作用: 设置field1->N 个域, 对应的值是value1->N

hget key field

作用: 返回key中field域的值

hmget key field1 field2 fieldN

作用: 返回key中field1 field2 fieldN域的值

hgetall key

作用:返回key中,所有域与其值

hdel key field

作用: 删除key中 field域

hlen key

作用: 返回key中元素的数量

hexists key field

作用: 判断key中有没有field域

hinrby key field value

作用: 是把key中的field域的值增长整型值value

hinrby float key field value

作用: 是把key中的field域的值增长浮点值value

hkeys key

作用: 返回key中所有的field

kvals key

作用: 返回key中所有的value

Redis 中的事务

Redis与 mysql事务的对比

| 操作 | Mysql | Redis |

|---|---|---|

| 开启 | start transaction | muitl |

| 语句 | 普通sql | 普通命令 |

| 失败 | rollback 回滚 | discard 取消 |

| 成功 | commit | ecec |

注: rollback与discard 的区别

如果已经成功执行了2条语句, 第3条语句出错.

- Rollback后,前2条的语句影响消失.

- Discard只是结束本次事务,前2条语句造成的影响仍然还在

注: 在mutil后面的语句中, 语句出错可能有2种情况

- 语法就有问题,这种,exec时,报错, 所有语句得不到执行

- 语法本身没错,但适用对象有问题. 比如 zadd 操作list对象,Exec之后,会执行正确的语句,并跳过有不适当的语句.

思考:

我正在买票Ticket -1 , money -100

而票只有1张, 如果在我multi之后,和exec之前, 票被别人买了—即ticket变成0了.

我该如何观察这种情景,并不再提交

悲观的想法:

世界充满危险,肯定有人和我抢, 给 ticket上锁, 只有我能操作. [悲观锁]

乐观的想法:

没有那么人和我抢,因此,我只需要注意,

–有没有人更改ticket的值就可以了 [乐观锁]

Redis的事务中,启用的是乐观锁,只负责监测key没有被改动.

具体的命令—- watch命令

redis 127.0.0.1:6379> watch ticket

OK

redis 127.0.0.1:6379> multi

OK

redis 127.0.0.1:6379> decr ticket

QUEUED

redis 127.0.0.1:6379> decrby money 100

QUEUED

redis 127.0.0.1:6379> exec

(nil) // 返回nil,说明监视的ticket已经改变了,事务就取消了.

redis 127.0.0.1:6379> get ticket

"0"

redis 127.0.0.1:6379> get money

"200"watch key1 key2 … keyN

作用:监听key1 key2..keyN有没有变化,如果有变, 则事务取消

unwatch

作用: 取消所有watch监听

场景:秒杀抢单类的用事务和watch

频道发布和消息订阅

使用办法:

订阅端:

- subscribe 频道名称

- psubscribe new* ——根据匹配模式监听多个频道(正则)

发布端:

- publish 频道名称 发布内容

- pubsub channels [pattern] 列出当前订阅的频道

//客户端例子:

redis 127.0.0.1:6379> subscribe news

Reading messages... (press Ctrl-C to quit)

1) "subscribe"

2) "news"

3) (integer) 1

1) "message"

2) "news"

3) "good good study"

1) "message"

2) "news"

3) "day day up"//服务端例子:

redis 127.0.0.1:6379> publish news 'good good study'

(integer) 1

redis 127.0.0.1:6379> publish news 'day day up'

(integer) 1Redis持久化

rdb快照

/**

* Rdb快照的配置选项

*/

save 900 1 // 900内,有1条写入,则产生快照

save 300 1000 // 如果300秒内有1000次写入,则产生快照

save 60 10000 // 如果60秒内有10000次写入,则产生快照

//(这3个选项都屏蔽,则rdb禁用)

stop-writes-on-bgsave-error yes // 后台备份进程出错时,主进程停不停止写入?(导出出错时不允许写入)

rdbcompression yes // 导出的rdb文件是否压缩

Rdbchecksum yes // 导入rbd(到内存中)恢复时数据时,要不要检验rdb的完整性

dbfilename dump.rdb //导出来的rdb文件名

dir ./ //rdb的放置路径aof日志

/**

* Aof 的配置

*/

appendonly no // 是否打开 aof日志功能

appendfsync always // 每1个命令,都立即同步到aof. 安全,速度慢

appendfsync everysec // 折衷方案,每秒写1次

appendfsync no // 写入工作交给操作系统,由操作系统判断缓冲区大小,统一写入到aof. 同步频率低,速度快,

no-appendfsync-on-rewrite yes: // 正在导出rdb快照的过程中,要不要停止同步aof

auto-aof-rewrite-percentage 100 //aof文件大小比起上次重写时的大小,增长率100%时,重写

auto-aof-rewrite-min-size 64mb //aof文件,至少超过64M时,重写- 注: 在dump rdb过程中,aof如果停止同步,会不会丢失?

答: 不会,所有的操作缓存在内存的队列里, dump完成后,统一操作.

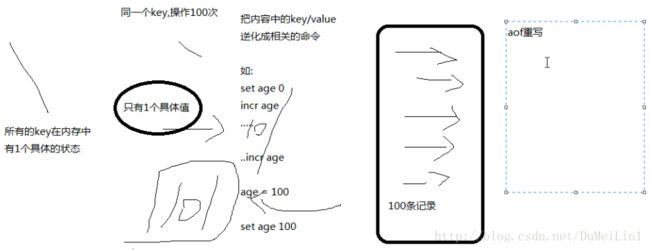

- 注: aof重写是指什么?

答: aof重写是指把内存中的数据,逆化成命令,写入到.aof日志里.

以解决 aof日志过大的问题.

- 问: 如果rdb文件,和aof文件都存在,优先用谁来恢复数据?

答: aof

- 问: 2种是否可以同时用?

答: 可以,而且推荐这么做

- 问: 恢复时rdb和aof哪个恢复的快

答: rdb快,因为其是数据的内存映射,直接载入到内存,而aof是命令,需要逐条执行

//redis 服务器端命令

redis 127.0.0.1:6380> time ,显示服务器时间 , 时间戳(秒), 微秒数

1) "1375270361"

2) "504511"

redis 127.0.0.1:6380> dbsize // 当前数据库的key的数量

(integer) 2

redis 127.0.0.1:6380> select 2

OK

redis 127.0.0.1:6380[2]> dbsize

(integer) 0

redis 127.0.0.1:6380[2]>

BGREWRITEAOF 后台进程重写AOF

BGSAVE 后台保存rdb快照

SAVE 保存rdb快照

LASTSAVE 上次保存时间

Slaveof master-Host port , 把当前实例设为master的slave

Flushall 清空所有库所有键

Flushdb 清空当前库所有键

Showdown [save/nosave]注: 如果不小心运行了flushall, 立即 shutdown nosave ,关闭服务器,然后 手工编辑aof文件, 去掉文件中的 “flushall ”相关行, 然后开启服务器,就可以导入回原来数据.

如果,flushall之后,系统恰好bgrewriteaof了,那么aof就清空了,数据丢失.

Slowlog 显示慢查询

注:多慢才叫慢?

答: 由slowlog-log-slower-than 10000 ,来指定,(单位是微秒)

服务器储存多少条慢查询的记录?

答: 由 slowlog-max-len 128 ,来做限制

Info [Replication/CPU/Memory..]

查看redis服务器的信息

Config get 配置项

Config set 配置项 值 (特殊的选项,不允许用此命令设置,如slave-of, 需要用单独的slaveof命令来设置)

主从复制

分类

主从通信原理

Redis运维时需要注意的参数

1 内存

Memory

used_memory:859192 数据结构的空间

used_memory_rss:7634944 实占空间

mem_fragmentation_ratio:8.89 前2者的比例,1.N为佳,如果此值过大,说明redis的内存的碎片化严重,可以导出再导入一次.

2 主从复制

Replication

role:slave

master_host:192.168.1.128

master_port:6379

master_link_status:up

3 持久化

Persistence

rdb_changes_since_last_save:0

rdb_last_save_time:1375224063

4 fork耗时

Status

latest_fork_usec:936 上次导出rdb快照,持久化花费微秒

注意: 如果某实例有10G内容,导出需要2分钟,

每分钟写入10000次,导致不断的rdb导出,磁盘始处于高IO状态.

5 慢日志

config get/set slowlog-log-slower-than

CONFIG get/SET slowlog-max-len slowlog get N 获取慢日志

运行时更改master-slave

修改一台slave(设为A)为new master

- 命令该服务不做其他redis服务的slave 命令: slaveof no one

- 修改其readonly为yes

其他的slave再指向new master A

- 命令该服务为new master A的slave 命令格式 slaveof IP port

监控工具 sentinel

Sentinel不断与master通信,获取master的slave信息.

监听master与slave的状态

如果某slave失效,直接通知master去除该slave.

如果master失效,,是按照slave优先级(可配置), 选取1个slave做 new master

,把其他slave–> new master

疑问: sentinel与master通信,如果某次因为master IO操作频繁,导致超时,

此时,认为master失效,很武断.

解决: sentnel允许多个实例看守1个master, 当N台(N可设置)sentinel都认为master失效,才正式失效.

Sentinel选项配置

port 26379 # 端口

sentinel monitor mymaster 127.0.0.1 6379 2 ,

给主机起的名字(不重即可),

当2个sentinel实例都认为master失效时,正式失效

sentinel down-after-milliseconds mymaster 30000 多少毫秒后连接不到master认为断开

sentinel can-failover mymaster yes #是否允许sentinel修改slave->master. 如为no,则只能监控,无权修改./

sentinel parallel-syncs mymaster 1 , 一次性修改几个slave指向新的new master.

sentinel client-reconfig-script mymaster /var/redis/reconfig.sh ,# 在重新配置new master,new slave过程,可以触发的脚本

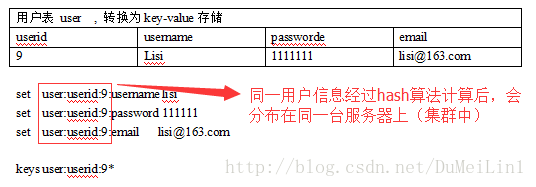

Redis key 设计技巧

1: 把表名转换为key前缀 如, tag:

2: 第2段放置用于区分区key的字段–对应mysql中的主键的列名,如userid

3: 第3段放置主键值,如2,3,4…., a , b ,c

4: 第4段,写要存储的列名