NIPS 2018 | 中科院自动化所两篇入选论文:高清真实图像生成领域及GAN研究在人脸识别领域的进展...

【论文一】自动化所在高清真实图像生成领域获得新突破

IntroVAE: Introspective Variational Autoencoders for Photographic Image Synthesis

原文地址:https://arxiv.org/abs/1807.06358自动化所智能感知与计算研究中心提出一种新的深度生成模型——自省变分自编码器(IntroVAE),用来实现高清图像等高维数据的无条件生成。该模型不仅在不引入额外的对抗判别器的情况下,克服了变分自编码器固有的合成图像趋于模糊的问题,而且在不使用常用的多阶段多判别器策略下,实现了高分辨率图像合成的稳定训练。该论文被今年人工智能顶级会议神经信息处理系统大会(NIPS2018)所收录,在生成指标上超过了英伟达在ICLR18上的工作。

生成模型包含无条件生成(unconditional generation)和条件生成(conditional generation)两种,高分辨率图像生成一般指的是从噪声中生成数据的无条件生成。Yoshua Bengio在CVPR2017论文中讲到,"生成高分辨率照片级图像已成为机器学习领域的一个长期目标。"麻省理工大学的人工智能领域知名学者Max Tegmark在IJCAI2018特邀报告中提到,"以对抗生成网络为代表的深度生成模型是人工智能研究的重要前沿方向。"高分辨率真实图像的生成由于问题困难,计算复杂度大,一直以来只有英伟达(INVIDIA)、英国牛津(Oxford)和麻省理工(MIT)等知名科研机构在研究。

论文概要

近日,自动化所智能感知与计算研究中心提出一种新的深度生成模型——自省变分自编码器(Introspective Variational Autoencoder,IntroVAE),用来实现高清图像等高维数据的无条件生成(unconditional generation)。该模型一方面在不引入额外的对抗判别器的情况下,克服了变分自编码器固有的合成图像趋于模糊的问题;另一方面在不使用常用的多阶段多判别器策略下,实现了高分辨率图像合成的稳定训练。实验结果表明,该模型不仅能够稳定生成高分辨率照片级图像(比如1024x1024的人脸图像),而且在生成模型常用的量化指标上取得了目前最好的结果。

变分自编码器 VS 对抗生成网络

深度生成模型是无监督学习最有前景的方法之一,一直是学术界研究的热点问题。目前最为流行的两种深度生成模型是变分自编码器(VAEs)和对抗生成网络(GANs)。变分自编码器是自动编码器的生成版本,通过优化一个变分下界来实现数据到先验分布的近似映射。VAEs的训练稳定,能够进行隐变量推断和对数似然估计,但是生成的样本比较模糊。对抗生成网络通过生成器和判别器之间的对抗,来学习真实数据的分布。GANs可以生成逼真的清晰图像,但是存在训练不稳定的问题,这个问题在合成高分辨率图像上尤其严重。

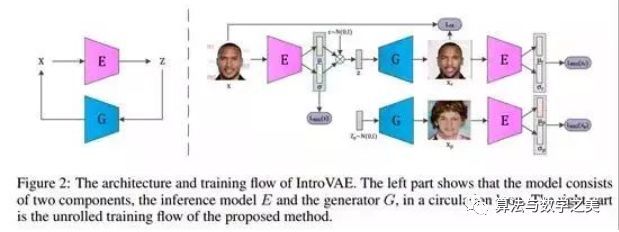

自省变分自编码器的结构和训练流程

目前主流的高分辨率图像合成方法(比如英伟达公司提出的PGGAN模型)通过将高分辨率图像分解,从低分辨率出发,分多个阶段使用多个判别器逐步合成高分辨率图像。这种训练方式增加了模型设计的复杂度,提高了模型收敛的难度。与已有的方法不同,本文采用了一种更为简单有效的方式,能够实现对高分辨率图像的一步到位直接合成。该方法将对抗学习引入VAE内部,实现了一种自省的学习,即模型自身能够判断其生成样本的质量并作出相应改变以提高性能。具体的实现方式是训练编码器使得真实图像的隐变量接近先验分布,合成图像的隐变量偏离先验分布;与之相反的是,训练生成器使得合成图像的隐变量接近先验分布。同时,与GAN不同的是,编码器和生成器除了对抗外还要协同保证对输入图像的重建误差尽量小。对于真实数据来说,该方法的训练目标跟传统VAE完全一致,这极大得稳定了模型训练;对于合成数据来说,对抗的引入提高了样本的质量。

IntroVAE的体系结构与训练流程

实验结果

实验结果显示,自省变分自编码器能够稳定合成高分辨率照片级的图像,比如1024x1024大小的人脸图像,256x256大小的卧室、教堂、狗等自然图像。该模型不仅在图像质量上,而且在量化指标上都取得了当前最好的结果。

CelebA-HQ上训练,生成的1024x1024人脸图像

LSUN BEDROOM上训练,生成的256x256卧室图像

LSUN CHURCHOUTDOOR上训练,生成256x256教堂图像

ImageNet上训练,生成的256x256狗图像

和其他方法的量化指标对比,可以看出在大部分指标上自省变分编码器都取的了最好的结果。

两种方法的定量比较

【论文二】自动化所生成对抗网络GAN研究在人脸识别领域再获新进展

Learning a High Fidelity Pose Invariant Model for High-resolution Face Frontalization

原文地址:https://arxiv.org/abs/1806.08472

自动化所智能感知与计算研究中心在生成对抗网络(GAN)基础上提出高保真度的姿态不变模型来克服人脸识别任务中最为经典的姿态不一致问题。该模型不仅在多个基准数据集的视觉效果和定量指标都优于目前已有的基于生成对抗网络的方法,而且将生成图像的分辨率在原有基础上提升了一倍。该论文已被神经信息处理系统大会(NIPS)收录。

GAN缘何入选2018年"全球十大突破性技术"?

日前,《麻省理工科技评论》正式公布了2018年“全球十大突破性技术”(10 Breakthrough Technologies 2018),涵盖:实用型金属3D打印、人造胚胎、智慧传感城市、面向每一个人的人工智能、对抗性神经网络/生成对抗网络、巴别鱼实时翻译耳塞、零碳天然气、完美的网络隐私保护、基因占卜、材料的量子飞跃。这也是这份指南第17次发布。

来自网络

回看过去几年的上榜技术,越来越多的人工智能相关技术入选榜单,其中包括:2008 年机器学习、2009 年的 Siri、2013 年的深度学习、2014 年的神经形态芯片、2016 年的语音接口与知识分享型机器人,以及 2017 年的自动驾驶卡车与强化学习。

2018年,最具突破性的人工智能技术之一就是对抗性神经网络(Dueling Neural Networks) / 生成对抗网络(GAN)——通过两个AI系统的竞争对抗,极大化加速机器学习的过程,进而赋予机器智能过去从未企及的想象力。

自动化所改良后的GAN,性能更优越

Ian Goodfellow发明出GAN后,获得Yann LeCun、黄仁勋、吴恩达等人的赞赏,吸引了诸多的机构及企业开始研究。在中国,部分学术机构致力于研究GAN理论的近一步改良及优化,其中中科院自动化所孙哲南、赫然研究团队已经取得了一系列进展,受人类视觉识别过程的启发,提出了双路径GAN(TP-GAN)用于正面人脸图像合成,已发表于2017年国际计算机视觉大会(ICCV)。随后又提出了基于姿态信息指导的共轭判别器GAN(CAPG-GAN),用于多姿态人脸图像合成,并进一步提高了跨姿态识别精度,已发表于2018年IEEE国际计算机视觉与模式识别会议(CVPR)。

近日,自动化所曹杰、胡一博、张鸿文、赫然、孙哲南在论文Learning a High Fidelity Pose Invariant Model for High-resolution Face Frontalization中提出了高保真度的姿态不变模型(High Fidelity Pose Invariant Model, HF-PIM)来克服人脸识别任务中最为经典的姿态不一致问题。

实验结果表明,该方法在多个基准数据集的视觉效果和定量指标都优于目前已有的最好方法。此外,HF-PIM所支持的生成图像分辨率也在原有方法的基础上提升了一倍。该论文已被人工智能领域顶会神经信息处理系统大会(NIPS)收录。

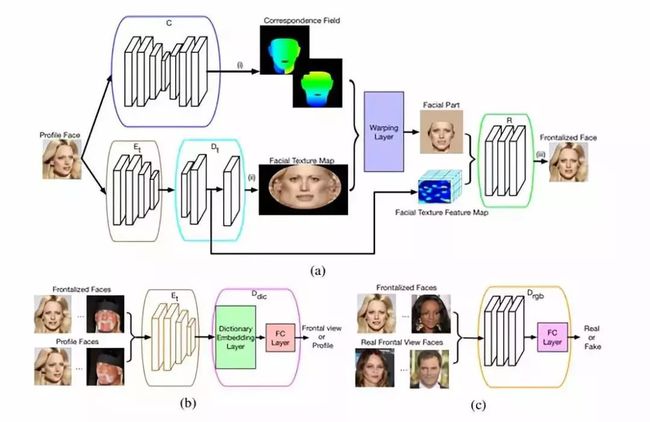

高保真度的姿态不变模型示意图

论文解析

在该论文中,作者总结了先前工作中存在的一些限制,例如,过于依赖低维信息约束,不能很好地保持原图的语义信息等。为了解决这些问题,作者对其具体做法进行如下总结:

①引入了一种能反映三维人脸模型和二维人脸图像之间点到点关联的稠密关联场,让网络能够在二维图像的指导下学习到隐含的三维人脸信息。

②设计了一种全新的纹理扭曲(warping)过程,可以有效地把人脸纹理映射到图像域,同时又可以最大程度地保持输入的语义信息。

③提出了一种对抗残差字典学习过程,从而可以在不依赖三维数据的情况下更有效地学习人脸纹理特征。

④实验表明,该方法不仅在定量和定性指标上明显地超过了已有方法,并且把生成图像的分辨率提高了一倍。

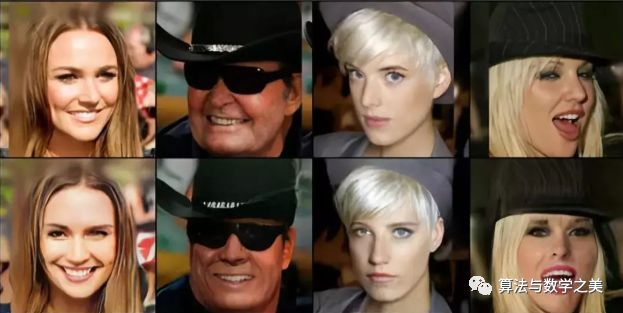

来自论文

上图是在CelebA数据库的HQ子集上的可视化结果,第一行为输入图像,第二行为通过HF-PIM模型进行人脸正面化后的结果。HF-PIM是首个支持生成256*256可视化结果的模型。

来自论文

上图在IJBA数据库上的可视化结果,第一行为输入图像,第二行为通过HF-PIM模型进行人脸正面化后的结果。

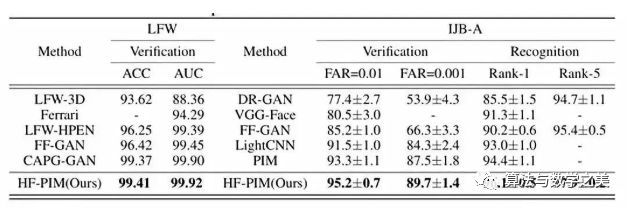

在LFW(左图)数据库和IJB-A(右图)数据库上和已有方法的对比结果。ACC: 准确率。AUC:ROC曲线下面积。FAR:错误接受率。Rank-1:第一次命中识别率。

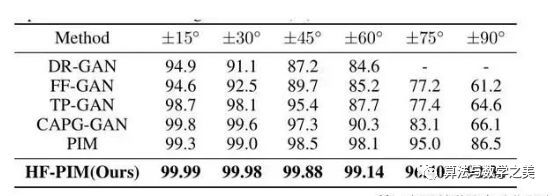

在Multi-PIE数据库上在不同的视角下对第一次命中识别率的对比。

∑编辑 | Gemini

来源 | 极市平台

更多精彩:

☞ 哈尔莫斯:怎样做数学研究

☞ 扎克伯格2017年哈佛大学毕业演讲

☞ 线性代数在组合数学中的应用

☞ 你见过真的菲利普曲线吗?

☞ 支持向量机(SVM)的故事是这样子的

☞ 深度神经网络中的数学,对你来说会不会太难?

☞ 编程需要知道多少数学知识?

☞ 陈省身——什么是几何学

☞ 模式识别研究的回顾与展望

☞ 曲面论

☞ 自然底数e的意义是什么?

☞ 如何向5岁小孩解释什么是支持向量机(SVM)?

☞ 华裔天才数学家陶哲轩自述

☞ 代数,分析,几何与拓扑,现代数学的三大方法论

算法数学之美微信公众号欢迎赐稿

稿件涉及数学、物理、算法、计算机、编程等相关领域,经采用我们将奉上稿酬。

投稿邮箱:[email protected]