论文笔记:Dual Skipping Networks 双跳网络

Changmao Cheng1∗, Yanwei Fu2∗, Yu-Gang Jiang1†,

Wei Liu3, Wenlian Lu4, Jianfeng Feng4, Xiangyang Xue1

1 School of Computer Science, Fudan University 3 Tencent AI Lab

2 School of Data Science, Fudan University 4 ISTBI, Fudan University

1. 介绍:

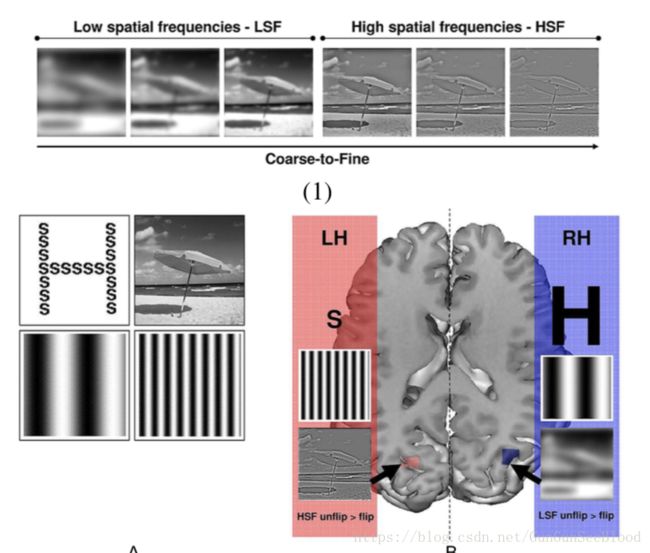

神经学公认人的视觉是从粗到细的,右脑粗左脑细。

对于快速闪过的图像,我们大概只能看到低频信息。定睛观察,才能看到高频信息。

我们很自然地会问,我们的网络是否具有用短路径预测粗略信息和用长路径预测精细视觉刺激的机制

接下来就是说生物神经是如何启发我们的。

我们提出一个附属门控网络,它学习预测在测试阶段是否跳过几个卷积层。

与DenseNets和ResNets中使用的快捷连接不同,我们学习了跳层机制来预测在测试阶段是否跳过一个特定层。跳层机制的灵感来自于一次性认知过程中,人脑中只有1%的神经元被使用[28]。

3. 模型

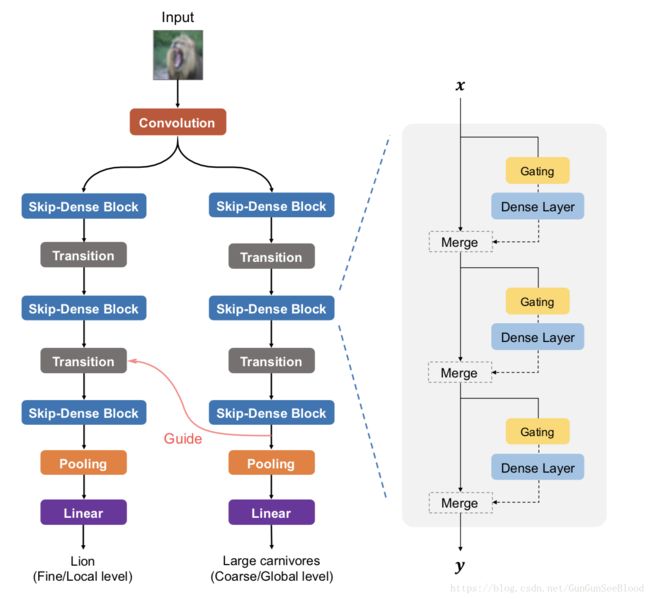

双跳网络如图所示这两个子集与相同的视觉输入共享,并且构建在几种类型的模块上,即,共享卷积层、跳过密集块、转换层、池和分类层。本节讨论了每个砌块的动力和结构。

每个skip-dense block包含很多密集链接的DenseLayer,DenseLayer被廉价的附属的Gating控制。

Transition是1x1卷机加pooling,目的是为了调整特征数量。

在一般结构中,左右子网几乎相等。

3.1. Skip-Dense Block

Dense Layer:我们在ResBlock和DenseBlock二选一种选择了Denseblock

Gating network:用来选择路径,我们的门控网络被学习来判断是否从训练数据中跳过卷积层。它也可以被认为是一种特殊类型的正则化:如果输入数据很复杂,那么选通网络应该倾向于不跳过太多层,反之亦然。这里,我们利用N×1全连接层作为N维输入特征,然后将阈值函数应用于标量输出。在实际应用中,我们对平均输入池进行了预处理。从训练集中学习全连接层的参数,并设计阈值函数来控制学习过程。

Threshold function of gating network:跳过机制的成功与否取决于阈值函数作为估计器的设计和训练策略。具体地,阈值函数的输出与卷积层输出的每个单元相乘,这影响分类的层重要性。

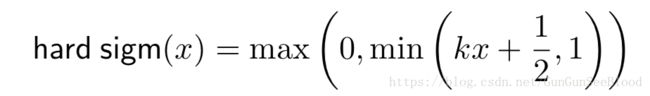

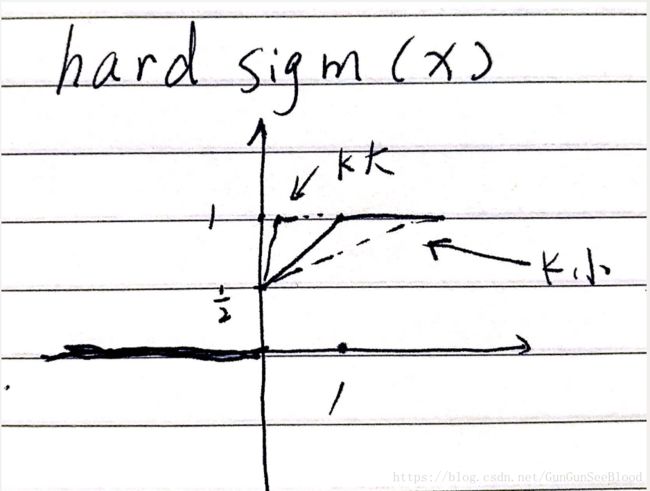

Transhold function我们选用hard sigmoid:

由于它的一阶导数在(0,1)中保持恒定,与sigmoid函数相比,它鼓励了更灵活的路径搜索。

K初始化为1,每历时增加一个固定值。K斜率越大,结果越容易成为0/1,但是大斜率会造成门控制模块训练不稳定。K和Densnet的调整是训练中最复杂的部分。

3.2. Guide:全局的半球获得的信息,能够自顶向下的对细节半球产生指导作用。这里,我们选择粗分支中最后一个跳过密集块的输出特征,以指导细分支中的最后一个过渡层。具体而言,输出特征是双线性上采样,并串联到本地子网中最后一个过渡层的输入特征中。粗略级别的反馈信息的注入对于细粒度对象分类是有益的。

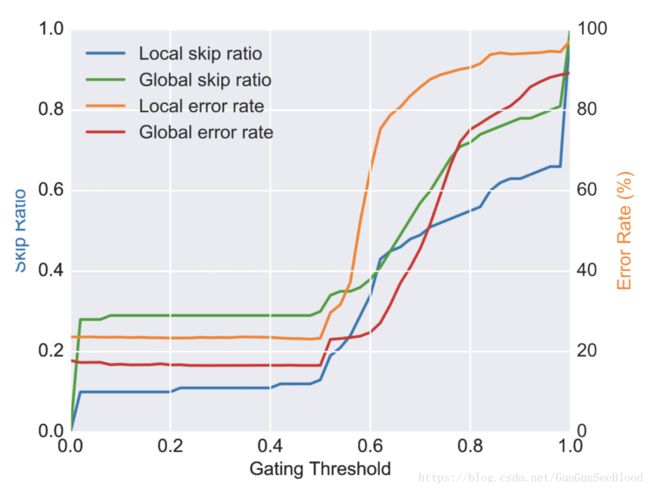

4.2 跳跃比和错误率

从结果可以看出,两个分支都能够在一定的选通阈值范围内产生可接受的精度。正如所预期的,由于识别任务的粒度级别不同,两个分支的最佳跳过率范围不同。对于全局分支,0%乘35%是最优跳跃比范围。对于局部分支,0%比20%是最优跳跃比范围,它比全局分支更严格。好处是,在每个密集层上的学习门控模块使得两个分支的性能在不同的用户定义阈值下保持一致。当门限阈值提高到0.5以上时,两个分支的跳过率迅速增加,错误率同步上升,这意味着网络变得无序和表达性弱。我们还注意到,即使没有对整个网络进行训练,两个训练分支不跳层或略有跳层的性能几乎保持不变。

结论:受近年来半脑特殊化和粗到细感知研究的启发,我们提出了一种新颖的左右不对称层可跳跃网络用于粗到细物体分类。我们利用了一种新的设计理念,使这个网络同时对粗粒度和细粒度的类进行分类。此外,我们提出了由辅助门控网络控制的密集连接的卷积层的跳层行为。在三个数据集上进行的实验验证了性能,显示了我们所提出的网络的有希望的结果。