- Caffe学习系列——工具篇:计算数据集的图像均值

Solomon1588

计算机视觉CVCaffe深度学习深度学习Caffe数据预处理特征标准化

本系列文章介绍深度学习框架Caffe及其实践,本文主要介绍Caffe的实用工具——compute_image_mean计算图像均值.1.图像预处理——零均值化数据预处理在深度学习中非常重要,数据预处理中,标准的第一步是数据归一化。特征归一化常用的方法包含如下几种:简单缩放逐样本均值消减(也称为移除直流分量)特征标准化(使数据集中所有特征都具有零均值和单位方差)特征标准化指的是(独立地)使得数据的每

- Caffe学习 (五):SSD源码解读ssd_pascal.py

QZX-light

Caffe学习系列Caffe

参考博客:https://blog.csdn.net/xunan003/article/details/79089280from__future__importprint_functionimportcaffefromcaffe.model_libsimport*fromgoogle.protobufimporttext_formatimportmathimportosimportshutilim

- caffe学习(1)------windows下基于GPU配置

lishanlu136

caffecaffe

最近准备用caffe做图片的分类,可配置caffe就让我折腾了大半个月,一直配置不成功,最后还是参考官网的tutorial才配置成功,于是决定把配置的过程写下来,如果后面有朋友配置caffe遇到什么问题,还可以参考参考。首先贴出官方的配置caffe的工程:https://github.com/BVLC/caffe/tree/windows,注意,这可是基于Windows系统的,因为我的电脑是win

- caffemodel特征可视化_Caffe学习笔记4图像特征进行可视化

weixin_39824801

caffemodel特征可视化

Caffe学习笔记4图像特征进行可视化本文为原创作品,未经本人同意,禁止转载,禁止用于商业用途!本人对博客使用拥有最终解释权欢迎关注我的博客:http://blog.csdn.net/hit2015spring和http://www.cnblogs.com/xujianqing/可以算是对它的翻译的总结吧,它可以算是学习笔记2的一个发展,2是介绍怎么提取特征,这是介绍怎么可视化特征1、准备工作首先

- Caffe学习:build/tools/convert_imageset

jiarenyf

caffecaffe

caffe/build/tools/convert_imageset用于将image图片转化为lmdb(leveldb)格式编写命令,实现图片格式转化:#!bin/sh#工具目录TOOLS_ROOT=caffe/build/tools#train_datas存放训练图片#label_train.txt保存图片标签#shuffle参数用于打乱图片读取顺序#train_db文件夹(不可手动新建)存放转

- Caffe学习之——caffe.cpp源码解析

ciky奇

caffecaffe.cpp

本文主要解析caffe源码中/tools/caffe.cpp文件,此文件是caffe程序的入口main函数,包含了命令行参数代码实现,如tain,test,time等。caffe结构请参考:https://blog.csdn.net/c20081052/article/details/80585888caffe命令行参数请参考:https://blog.csdn.net/c20081052/art

- caffe学习(1):多平台下安装配置caffe

weixin_34238642

操作系统运维git

如何在centos7.3上安装caffe深度学习工具有好多朋友在安装caffe时遇到不少问题。(看文章的朋友希望关心一下我的创业项目趣智思成)今天测试并整理一下安装过程。我是在阿里云上测试,选择centos7.3镜像。先安装epel源1yuminstallepel-release安装基本编译环境12yuminstallprotobuf-develleveldb-develsnappy-develo

- Caffe学习笔记1-安装以及代码结构

baobei0112

CNN卷积神经网络

Caffe学习笔记1-安装以及代码结构ByYuFeiGan2014-12-09更新日期:2014-12-09安装按照官网教程安装,我在OSX10.9和Ubuntu14.04上面都安装成功了。主要麻烦在于gloggflagsgtest这几个依赖项是google上面的需要。由于我用Mac没有CUDA,所以安装时需要设置CPU_ONLY:=1。如果不是干净的系统,安装还是有点麻烦的比如我在OSX10.9

- caffe学习笔记--写一个运行caffe.cpp的makefile

thystar

caffe学习

之前因为有caffe的项目要放到服务器上面,但是其实不需要在服务器上面重新安装caffe,所以写了个makefile.这里改写了个简单的,比较容易读的,只运行caffe.cpp,如果由其他的,可以按照makefile的规则添加就好。首先,还是要说一下关于caffe的依赖,参考之前的两篇博客:http://blog.csdn.net/thystar/article/details/51179064和

- caffe学习笔记10.1--Fine-tuning a Pretrained Network for Style Recognition(new)

thystar

caffe学习

在之前的文章里,写过一个关于微调的博客,但是今天上去发现这部分已经更新了http://nbviewer.jupyter.org/github/BVLC/caffe/blob/master/examples/02-fine-tuning.ipynb,因此补一篇最新的,关于微调,前面的文章由讲,参考http://blog.csdn.net/thystar/article/details/5067553

- caffe学习笔记(11):多任务学习之HDF5Data类型数据集生成

guyunee

deeplearningmatlabobjectdetection数据标签caffe深度学习

最近开始研究多任务学习(multi-tasklearning,MTL),先分享给大家:本文主要讲述数据集的建立,HDF5Data类型用于处理多标签数据,在网络中定义为:layer{name:"data"type:"HDF5Data"top:"data"top:"label"include{phase:TRAIN}hdf5_data_param{source:"list_train.txt"batc

- Caffe学习:Forward and Backward

jiarenyf

caffecaffe

原文forwardandbackwardpasses(前向迭代和反向迭代)是Net最基本的成分。下面以简单的logisticregressionclassifier(逻辑回归分类器)为例。ForwardPass(前向迭代)利用给定的输入,根据模型设定的函数,计算出输出。Thispassgoesfrombottomtotop(数据流向从bottom到top)。数据x通过一个innerproductl

- Ubuntu14.04下配置Caffe+OpenCV2.4.10+CUDA7.5+cuDNN5.1.10

cuihaolong

3DPrint系统配置

1.CUDA配置与Tensorflow,Keras等深度学习框架一样的配置方法,一次配置可以重用,其他基础软件和依赖项亦可参考:Caffe学习笔记2--Ubuntu14.0464bit安装Caffe(GPU版本)Ubuntu14.04+Caffe+Cuda7.5+Opencv3.0安装教程Caffe+Ubuntu14.0464bit+CUDA6.5配置说明Caffe搭建:Ubuntu14.04+C

- Caffe学习笔记(一): 训练和测试自己的数据集

__Sunshine__

笔记Pythoncaffe训练数据集计算机视觉

1数据准备首先在caffe根目录下建立一个文件夹myfile,用于存放数据文件和后面的caffe模型相关文件。然后在myfile文件夹下建立build_lmdb和datatest两个文件夹,其中build_lmdb文件夹用于存放生成的lmdb文件,datatest文件夹存放图片数据。在datatest下主要有2个文件夹和2个.sh文件和2个.txt文件,其中train文件夹中存放待训练的图片,va

- Caffe学习(三)Caffe模型的结构

遍地流金

Caffe学习

一总体结构在caffe中,解决一个问题首先应该定义一个slover,反应到mnist例程中也就是lenet_solver.prototxt。该slover主要包括两部分,(1)为网络模型model,(2)为该模型参数的具体optimization方法及参数。model主要由各种layer组成,主要包括数据相关的DataLayer,图像滤波变换相关的VisionLayer,非线性激活函数Activa

- caffe数据文件lmdb训练神器digits

hi我是大嘴巴

denny的学习专栏徐其华博客园首页新随笔联系管理订阅随笔-145文章-0评论-1085Caffe学习系列(21):caffe图形化操作工具digits的安装与运行经过前面一系列的学习,我们基本上学会了如何在linux下运行caffe程序,也学会了如何用python接口进行数据及参数的可视化。如果还没有学会的,请自行细细阅读:caffe学习系列:http://www.cnblogs.com/den

- Caffe学习总结(一)——初识caffe

不系之舟913

深度学习caffe深度学习机器学习框架

深度学习在当前情况下可以用一个字来形容“火”,目前项目中使用到了常用的机器学习算法,在使用过程中发现图像的特征提取成为识别的瓶颈,无意中了解到caffe,可以很好的解决特征提取的问题。于是想尝试一下caffe的威力。初识caffe,就习惯性了想了解下作者,发现设计作者是贾杨清,终于发现一个牛逼的框架是我们中国人做的啦!于是很兴奋,很想深入的进行学习,希望能在工作中使用起来。1、caffe的由来到一

- 深度学习之----caffe

Steven_ycs

本文主要讲解caffe的整个使用流程,适用于初级入门caffe,通过学习本篇博文,理清项目训练、测试流程。初级教程,高手请绕道。我们知道,在caffe编译完后,在caffe目录下会生成一个build目录,在build目录下有个tools,这个里面有个可执行文件caffe,如下图所示:有了这个可执行文件我们就可以进行模型的训练,只需要学会调用这个可执行文件就可以了,这便是最简单的caffe学习,不需

- caffe学习系列二:源码深入解析-单步跟踪调试指南

singularpt

为了更好的学习caffe,我们利用上节安装好的环境,进行单步调试,以窥caffe全貌。准备工作:要在vs2013中单步跟踪调试caffe,需要配置caffe工程,打开【属性】-【调试】-【命令行参数】中加入输入参数。如下配置:image.png先贴一张caffe的整体处理流程:image.png一、函数入口众所周知,caffe由c++写的,而c++的入口函数为main,我们在caffe.cpp文件

- Ubuntu 14.04下编译OpenPose

crazyhank

OpenPose是CMU开发的一个开源人体姿态检测模型,github地址为:https://github.com/CMU-Perceptual-Computing-Lab/openpose,下面为在ubuntu14.04版本上编译的过程下载源码由于openpose依赖于第三方的caffe学习框架,所以在gitclone一定要加上"--recursive"选项,如下所示:#gitclone--rec

- Caffe学习笔记6:过程小结

Zz鱼丸

之前写的学习笔记1用两种方法进行预测,今天发现有点不对。下面进行分析总结:先来看看Classifier的源代码#!/usr/bin/envpython"""ClassifierisanimageclassifierspecializationofNet."""importnumpyasnpimportcaffeclassClassifier(caffe.Net):"""Classifierexte

- Caffe Cifar10模型测试及可视化

不会积

本文主体来自[Caffe学习系列(17):模型各层数据和参数可视化],加了一点自己的注释(http://www.cnblogs.com/denny402/p/5105911.html)先用caffe对cifar10进行训练,将训练的结果模型进行保存,得到一个caffemodel,然后从测试图片中选出一张进行测试,并进行可视化。#加载必要的库importnumpyasnpimportmatplotl

- Caffe学习系列(3):视觉层(Vision Layers)及参数

weixin_33850890

matlab人工智能

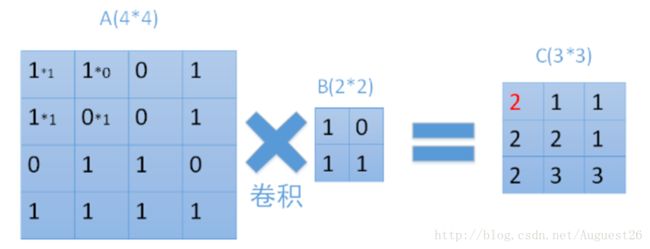

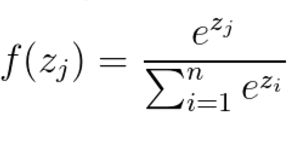

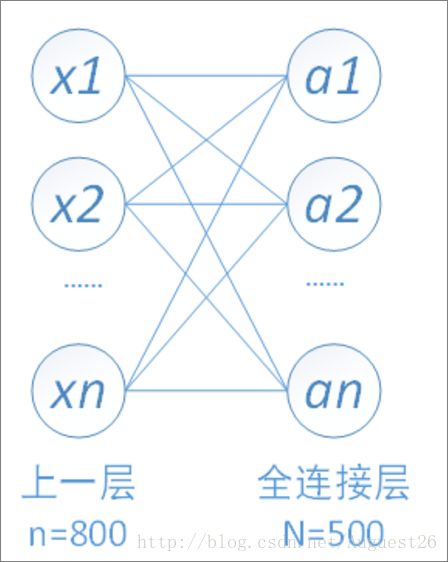

所有的层都具有的参数,如name,type,bottom,top和transform_param请参看我的前一篇文章:Caffe学习系列(2):数据层及参数本文只讲解视觉层(VisionLayers)的参数,视觉层包括Convolution,Pooling,LocalResponseNormalization(LRN),im2col等层。1、Convolution层:就是卷积层,是卷积神经网络(C

- Caffe学习之一:Caffe的配置和编译

sherry_gp

程序软件安装

最近,在学习deeplearning,使用的工具就是caffe,比较容易上手,不啰嗦了,先说环境的配置和编译。系统的平台为win10+matlab2014b+vs2013.在开始之前,要安装cuda的驱动,我使用的cuda7.5这个版本(为了和caffe里面使用的版本同步)。首先,在https://github.com/happynear/caffe-windows下载caffe和以及此页面上提供

- 【深度学习框架Caffe学习与应用】第四课 Caffe可视化工具

soldier123333

[caffe学习笔记]

1.首先准备pycaffe环境输入一下命令:2.网络可视化的工具2.1在caffe中,有一个专门用于画网络结构图的py文件:caffe/tools/draw_net.py2.2也可以通过在线可视化工具,网址如下:http://ethereon.github.io/netscope/#/editor2.caffemodel的可视化,需要先把代码看明白,这里不写了3.特征图的可视化4.loss和acc

- 【深度学习框架Caffe学习与应用】 第十一课

soldier123333

[caffe学习笔记]

1.车辆检测实践:使用Caffe训练的深度学习模型做目标检测——以车辆检测为例有关文件都放在以下文件夹中:对vehicle_detetc.cpp进行编译:编译之前,需要修改一下代码中的文件路径:我刚开始先编译之后,才修改的源文件,所以运行的时候,出现下面错误:只要修改完路径之后,重新编译就好结果如下图所示:效果不好,有误检

- 【深度学习框架Caffe学习与应用】第五课 自定义神经层和数据输入层

soldier123333

[caffe学习笔记]

一、自定义神经层1.创建新定义的头文件,目录在caffe/include/caffe/layers/my_neuron_layer.hpp我复制了conv_layer.hpp文件,然后在该文件的内容上进行更改如果只是需要CPU方法,可以注释掉forward_gpu和backward_gpu修改对照内容如下(左侧是conv_layer.hpp,右侧是my_neuron_layer.hpp):2.创建

- 【深度学习框架Caffe学习与应用】第三课 使用训练好的模型

soldier123333

[caffe学习笔记]

1.均值文件将所有训练样本的均值保存为文件。首先将计算均值文件的caffe工具compute_image_mean放到当前目录:caffe/test/mnist/下面,之后运行如下命令:这样,我们的均值文件就生成了2.改写deploy文件(以mnist为例)(略过)3.使用修改后的mnist的deploy文件,输入一张图片,输出分类结果首先我们写了一个test_mnist.cpp文件,先进行编译,

- Caffe学习笔记11:Ubuntu 16.04 中 caffe 编译出现的错误——fatal error: hdf5.h: 没有那个文件或目录

weixin_41774576

Caffe

step1:cd/usr/lib/x86_64-linux-gnusudoln-slibhdf5_serial.so.8.0.2libhdf5.sosudoln-slibhdf5_serial_hl.so.8.0.2libhdf5_hl.sostep2:changeMakefile.config//打开Makefile.config将下面的INCLUDE_DIRS:=$(PYTHON_INCLUD

- caffe学习-代码阅读DataLayer

华山汉灵

编程-深度学习框架

以下摘录自《深度学习轻松学》冯超为了能够尽可能地提高训练速度,DataLayer采用了异步准备数据的形式,数据读人的工作和模型训练的工作在各自的线程中进行,相互独立并不依赖。当模型需要数据时,只需要将数据复制到指定的内存中即可。从lmdb数据库中,Cusror逐一获取数据,然后构成batch,经过transform变换后,是实际训练用的data.最上面的虚线框是DataReader类,负责从DB中

- Algorithm

香水浓

javaAlgorithm

冒泡排序

public static void sort(Integer[] param) {

for (int i = param.length - 1; i > 0; i--) {

for (int j = 0; j < i; j++) {

int current = param[j];

int next = param[j + 1];

- mongoDB 复杂查询表达式

开窍的石头

mongodb

1:count

Pg: db.user.find().count();

统计多少条数据

2:不等于$ne

Pg: db.user.find({_id:{$ne:3}},{name:1,sex:1,_id:0});

查询id不等于3的数据。

3:大于$gt $gte(大于等于)

&n

- Jboss Java heap space异常解决方法, jboss OutOfMemoryError : PermGen space

0624chenhong

jvmjboss

转自

http://blog.csdn.net/zou274/article/details/5552630

解决办法:

window->preferences->java->installed jres->edit jre

把default vm arguments 的参数设为-Xms64m -Xmx512m

----------------

- 文件上传 下载 解析 相对路径

不懂事的小屁孩

文件上传

有点坑吧,弄这么一个简单的东西弄了一天多,身边还有大神指导着,网上各种百度着。

下面总结一下遇到的问题:

文件上传,在页面上传的时候,不要想着去操作绝对路径,浏览器会对客户端的信息进行保护,避免用户信息收到攻击。

在上传图片,或者文件时,使用form表单来操作。

前台通过form表单传输一个流到后台,而不是ajax传递参数到后台,代码如下:

<form action=&

- 怎么实现qq空间批量点赞

换个号韩国红果果

qq

纯粹为了好玩!!

逻辑很简单

1 打开浏览器console;输入以下代码。

先上添加赞的代码

var tools={};

//添加所有赞

function init(){

document.body.scrollTop=10000;

setTimeout(function(){document.body.scrollTop=0;},2000);//加

- 判断是否为中文

灵静志远

中文

方法一:

public class Zhidao {

public static void main(String args[]) {

String s = "sdf灭礌 kjl d{';\fdsjlk是";

int n=0;

for(int i=0; i<s.length(); i++) {

n = (int)s.charAt(i);

if((

- 一个电话面试后总结

a-john

面试

今天,接了一个电话面试,对于还是初学者的我来说,紧张了半天。

面试的问题分了层次,对于一类问题,由简到难。自己觉得回答不好的地方作了一下总结:

在谈到集合类的时候,举几个常用的集合类,想都没想,直接说了list,map。

然后对list和map分别举几个类型:

list方面:ArrayList,LinkedList。在谈到他们的区别时,愣住了

- MSSQL中Escape转义的使用

aijuans

MSSQL

IF OBJECT_ID('tempdb..#ABC') is not null

drop table tempdb..#ABC

create table #ABC

(

PATHNAME NVARCHAR(50)

)

insert into #ABC

SELECT N'/ABCDEFGHI'

UNION ALL SELECT N'/ABCDGAFGASASSDFA'

UNION ALL

- 一个简单的存储过程

asialee

mysql存储过程构造数据批量插入

今天要批量的生成一批测试数据,其中中间有部分数据是变化的,本来想写个程序来生成的,后来想到存储过程就可以搞定,所以随手写了一个,记录在此:

DELIMITER $$

DROP PROCEDURE IF EXISTS inse

- annot convert from HomeFragment_1 to Fragment

百合不是茶

android导包错误

创建了几个类继承Fragment, 需要将创建的类存储在ArrayList<Fragment>中; 出现不能将new 出来的对象放到队列中,原因很简单;

创建类时引入包是:import android.app.Fragment;

创建队列和对象时使用的包是:import android.support.v4.ap

- Weblogic10两种修改端口的方法

bijian1013

weblogic端口号配置管理config.xml

一.进入控制台进行修改 1.进入控制台: http://127.0.0.1:7001/console 2.展开左边树菜单 域结构->环境->服务器-->点击AdminServer(管理) &

- mysql 操作指令

征客丶

mysql

一、连接mysql

进入 mysql 的安装目录;

$ bin/mysql -p [host IP 如果是登录本地的mysql 可以不写 -p 直接 -u] -u [userName] -p

输入密码,回车,接连;

二、权限操作[如果你很了解mysql数据库后,你可以直接去修改系统表,然后用 mysql> flush privileges; 指令让权限生效]

1、赋权

mys

- 【Hive一】Hive入门

bit1129

hive

Hive安装与配置

Hive的运行需要依赖于Hadoop,因此需要首先安装Hadoop2.5.2,并且Hive的启动前需要首先启动Hadoop。

Hive安装和配置的步骤

1. 从如下地址下载Hive0.14.0

http://mirror.bit.edu.cn/apache/hive/

2.解压hive,在系统变

- ajax 三种提交请求的方法

BlueSkator

Ajaxjqery

1、ajax 提交请求

$.ajax({

type:"post",

url : "${ctx}/front/Hotel/getAllHotelByAjax.do",

dataType : "json",

success : function(result) {

try {

for(v

- mongodb开发环境下的搭建入门

braveCS

运维

linux下安装mongodb

1)官网下载mongodb-linux-x86_64-rhel62-3.0.4.gz

2)linux 解压

gzip -d mongodb-linux-x86_64-rhel62-3.0.4.gz;

mv mongodb-linux-x86_64-rhel62-3.0.4 mongodb-linux-x86_64-rhel62-

- 编程之美-最短摘要的生成

bylijinnan

java数据结构算法编程之美

import java.util.HashMap;

import java.util.Map;

import java.util.Map.Entry;

public class ShortestAbstract {

/**

* 编程之美 最短摘要的生成

* 扫描过程始终保持一个[pBegin,pEnd]的range,初始化确保[pBegin,pEnd]的ran

- json数据解析及typeof

chengxuyuancsdn

jstypeofjson解析

// json格式

var people='{"authors": [{"firstName": "AAA","lastName": "BBB"},'

+' {"firstName": "CCC&

- 流程系统设计的层次和目标

comsci

设计模式数据结构sql框架脚本

流程系统设计的层次和目标

- RMAN List和report 命令

daizj

oraclelistreportrman

LIST 命令

使用RMAN LIST 命令显示有关资料档案库中记录的备份集、代理副本和映像副本的

信息。使用此命令可列出:

• RMAN 资料档案库中状态不是AVAILABLE 的备份和副本

• 可用的且可以用于还原操作的数据文件备份和副本

• 备份集和副本,其中包含指定数据文件列表或指定表空间的备份

• 包含指定名称或范围的所有归档日志备份的备份集和副本

• 由标记、完成时间、可

- 二叉树:红黑树

dieslrae

二叉树

红黑树是一种自平衡的二叉树,它的查找,插入,删除操作时间复杂度皆为O(logN),不会出现普通二叉搜索树在最差情况时时间复杂度会变为O(N)的问题.

红黑树必须遵循红黑规则,规则如下

1、每个节点不是红就是黑。 2、根总是黑的 &

- C语言homework3,7个小题目的代码

dcj3sjt126com

c

1、打印100以内的所有奇数。

# include <stdio.h>

int main(void)

{

int i;

for (i=1; i<=100; i++)

{

if (i%2 != 0)

printf("%d ", i);

}

return 0;

}

2、从键盘上输入10个整数,

- 自定义按钮, 图片在上, 文字在下, 居中显示

dcj3sjt126com

自定义

#import <UIKit/UIKit.h>

@interface MyButton : UIButton

-(void)setFrame:(CGRect)frame ImageName:(NSString*)imageName Target:(id)target Action:(SEL)action Title:(NSString*)title Font:(CGFloa

- MySQL查询语句练习题,测试足够用了

flyvszhb

sqlmysql

http://blog.sina.com.cn/s/blog_767d65530101861c.html

1.创建student和score表

CREATE TABLE student (

id INT(10) NOT NULL UNIQUE PRIMARY KEY ,

name VARCHAR

- 转:MyBatis Generator 详解

happyqing

mybatis

MyBatis Generator 详解

http://blog.csdn.net/isea533/article/details/42102297

MyBatis Generator详解

http://git.oschina.net/free/Mybatis_Utils/blob/master/MybatisGeneator/MybatisGeneator.

- 让程序员少走弯路的14个忠告

jingjing0907

工作计划学习

无论是谁,在刚进入某个领域之时,有再大的雄心壮志也敌不过眼前的迷茫:不知道应该怎么做,不知道应该做什么。下面是一名软件开发人员所学到的经验,希望能对大家有所帮助

1.不要害怕在工作中学习。

只要有电脑,就可以通过电子阅读器阅读报纸和大多数书籍。如果你只是做好自己的本职工作以及分配的任务,那是学不到很多东西的。如果你盲目地要求更多的工作,也是不可能提升自己的。放

- nginx和NetScaler区别

流浪鱼

nginx

NetScaler是一个完整的包含操作系统和应用交付功能的产品,Nginx并不包含操作系统,在处理连接方面,需要依赖于操作系统,所以在并发连接数方面和防DoS攻击方面,Nginx不具备优势。

2.易用性方面差别也比较大。Nginx对管理员的水平要求比较高,参数比较多,不确定性给运营带来隐患。在NetScaler常见的配置如健康检查,HA等,在Nginx上的配置的实现相对复杂。

3.策略灵活度方

- 第11章 动画效果(下)

onestopweb

动画

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- FAQ - SAP BW BO roadmap

blueoxygen

BOBW

http://www.sdn.sap.com/irj/boc/business-objects-for-sap-faq

Besides, I care that how to integrate tightly.

By the way, for BW consultants, please just focus on Query Designer which i

- 关于java堆内存溢出的几种情况

tomcat_oracle

javajvmjdkthread

【情况一】:

java.lang.OutOfMemoryError: Java heap space:这种是java堆内存不够,一个原因是真不够,另一个原因是程序中有死循环; 如果是java堆内存不够的话,可以通过调整JVM下面的配置来解决: <jvm-arg>-Xms3062m</jvm-arg> <jvm-arg>-Xmx

- Manifest.permission_group权限组

阿尔萨斯

Permission

结构

继承关系

public static final class Manifest.permission_group extends Object

java.lang.Object

android. Manifest.permission_group 常量

ACCOUNTS 直接通过统计管理器访问管理的统计

COST_MONEY可以用来让用户花钱但不需要通过与他们直接牵涉的权限

D