- Flink系列-2、Flink架构体系

技术武器库

大数据专栏flink架构jvm

版权声明:本文为博主原创文章,遵循CC4.0BY-SA版权协议,转载请附上原文出处链接和本声明。大数据系列文章目录官方网址:https://flink.apache.org/学习资料:https://flink-learning.org.cn/目录Flink中的重要角⾊Flink数据流编程模型Libraries支持Flink集群搭建Local本地模式(开发测试)Standalone-伪分布环境(开

- Flink 的核心特点和概念

Ray.1998

大数据大数据数据分析数据仓库flink

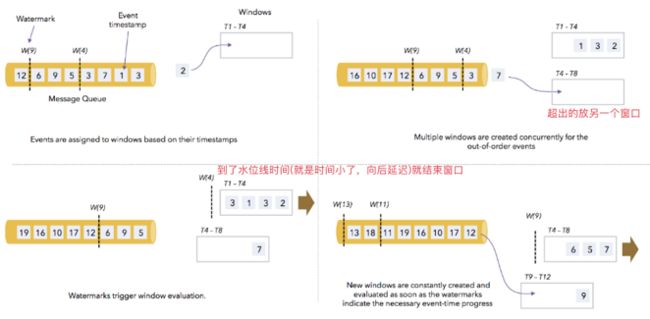

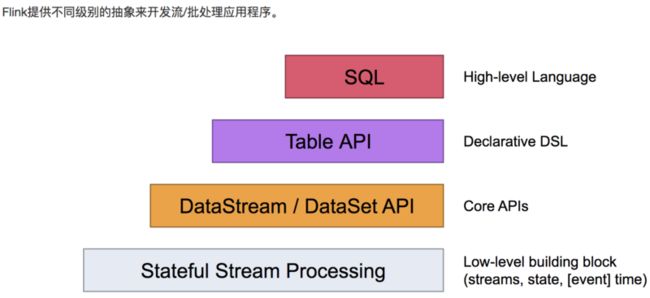

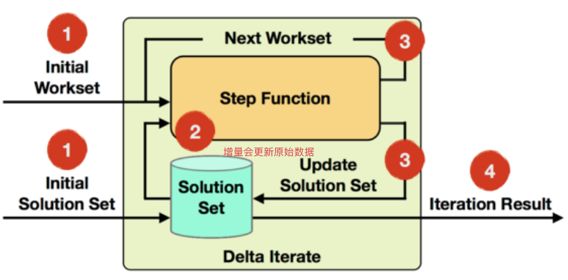

Flink是一个流式处理框架,专注于高吞吐量、低延迟的数据流处理。它能处理无限流(即实时数据流)和有限流(批处理),具有很强的灵活性和可扩展性,广泛应用于实时数据分析、监控系统、数据处理平台等场景。下面是一些关于Flink的核心特点和概念:1.流处理和批处理流处理(StreamProcessing):Flink的核心就是流处理,它能够实时处理不断到达的数据流。Flink会将数据划分成时间窗口来处理

- Flink的流处理和批处理

Ray.1998

大数据flink大数据数据挖掘数据分析

1.流处理(StreamProcessing)流处理是Flink的核心功能之一,主要用于处理无限流数据,也就是不断到达的数据。它能够实时处理数据流,并对每个数据元素执行操作。流处理中的数据没有预定的边界,它的特征是持续到达,因此,流处理必须实时处理每个事件,而不能等到所有数据都到齐后再进行处理。核心特点:实时性:流处理的最大优势是实时性。Flink允许对实时数据流进行分析,计算和处理,几乎是对数据

- HUDI-0.11.0 BUCKET index on Flink 特性试用

_Magic

BigDataflinkhudi

1.背景在0.10.1版本下,使用默认的index(FLINK_STATE),在upsert模式下,几十亿级别的数据更新会消耗大量内存,并且检查点(checkpoint)时间过长。因此,切换到0.11.0的BUCKET索引。当前环境:Flink1.13.2+Hudi0.11.0(master2022.04.11)+COW+HDFS。关键配置项:index.type=BUCKEThoodie.buc

- Kafka 迁移 AutoMQ 时 Flink 位点管理的挑战与解决方案

AutoMQ

云计算云原生Kafka消息计算大数据AWSAutoMQ阿里云腾讯云GCP

编辑导读:AutoMQ是一款与ApacheKafka100%完全兼容的新一代Kafka,可以做到至多10倍的成本降低和极速的弹性。凭借其与Kafka的完全兼容性可以与用户已有的Flink等大数据基础设施进行轻松整合。Flink是重要的流处理引擎,与Kafka有着密切的关系。本文重点介绍了当用户需要将生产Kafka集群迁移到AutoMQ时,如何处理好Flink的位点来确保整体迁移的平滑过渡。引言在云

- 20250120 Flink 的 缓冲区超时(Buffer Timeout)

靈臺清明

flink

Flink的缓冲区超时(BufferTimeout)机制确实类似于一辆车等待乘客的过程,如果车每次只载一个乘客就发车,会导致效率低下,资源浪费。同样,在Flink的数据流处理中,缓冲区超时的设置对吞吐量和延迟的权衡至关重要。以下是更详细的原因解析和背后的机制:1.什么是缓冲区超时(BufferTimeout)?在Flink中,算子之间的数据通过网络传输。为了提高传输效率,Flink会在发送数据之前

- Java 驱动大数据流处理:Storm 与 Flink 入门 (大数据)

用心去追梦

大数据javastorm

Java是一种广泛使用的编程语言,特别适用于企业级应用开发。随着数据量的不断增长,处理大数据流成为了现代软件开发中的一个重要领域。ApacheStorm和ApacheFlink是两个用于处理大规模数据流的开源框架,它们都支持用Java编写的应用程序。下面将简要介绍这两个框架,并提供一些入门指导。ApacheStormApacheStorm是一个免费、开源的分布式实时计算系统。Storm让用户能够轻

- SeaTunnel 与 DataX 、Sqoop、Flume、Flink CDC 对比

不二人生

#数据集成工具SeaTunnel

文章目录SeaTunnel与DataX、Sqoop、Flume、FlinkCDC对比同类产品横向对比2.1、高可用、健壮的容错机制2.2、部署难度和运行模式2.3、支持的数据源丰富度2.4、内存资源占用2.5、数据库连接占用2.6、自动建表2.7、整库同步2.8、断点续传2.9、多引擎支持2.10、数据转换算子2.11、性能2.12、离线同步2.13、增量同步&实时同步2.14、CDC同步2.15

- 20250120 深入了解 Apache Flink 的 Checkpointing

靈臺清明

Flinkapacheflink大数据

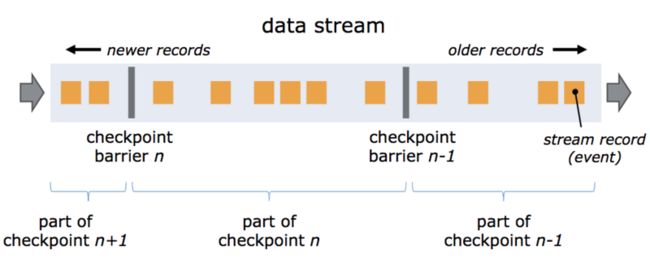

ApacheFlink是一种用于实时流处理和批处理的分布式计算框架。在实时流处理任务中,保证数据的一致性和任务的容错性是至关重要的,而Flink的Checkpointing机制正是实现这一目标的核心技术。本文将详细介绍Flink的Checkpointing,包括其概念、原理、配置和实际应用。什么是Checkpointing?Checkpointing是Flink提供的一种用于容错的机制。它会在流处

- Flink Standalone 方案中解决挂机问题

星尘幻宇科技

flink大数据

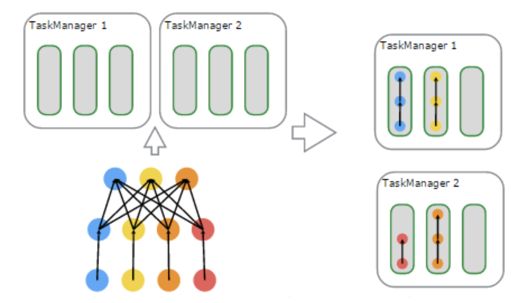

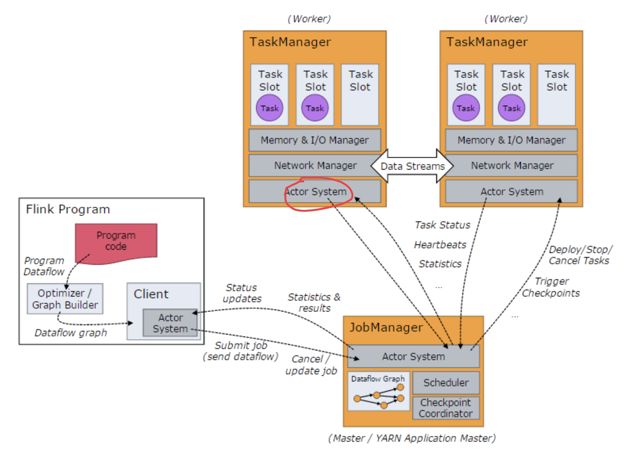

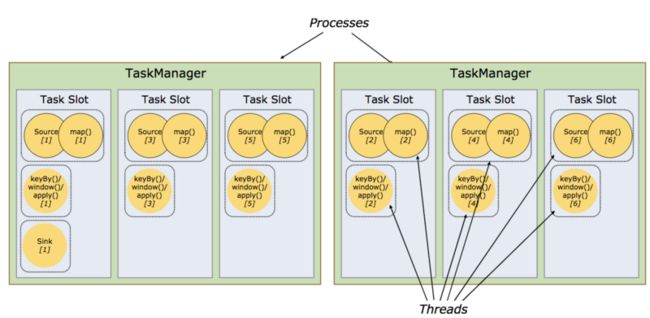

Standalone中可以配置HighAvailability(HA)部署和配置首先了解Flink实际运行时包括两类进程:JobManager(又称为JobMaster):协调Task的分布式执行,包括调度Task、协调创Checkpoint以及当Jobfailover时协调各个Task从Checkpoint恢复等。TaskManager(又称为Worker):执行Dataflow中的Tasks,

- 大数据学习(37)- Flink运行时架构

viperrrrrrr

学习flink大数据

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1)作业管理器(JobManager)JobManager是一个Flink集群中任务管理和调度的核心,是控制应用执行的主进程。也就是说,每个应用都应该被唯一的JobManager所控制执行。JobManger又包含3个不同的组件。(1)JobMasterJobM

- Flink CDC MySQL同步MySQL错误记录

lingllllove

flinkmysql大数据

FlinkCDC简介FlinkCDC(ChangeDataCapture)是一种高效的数据同步工具,利用Flink强大的实时流处理能力,从MySQL等数据库捕获数据变更,并将这些变更实时同步到目标数据库。本文将详细介绍FlinkCDCMySQL同步到MySQL时常见的错误记录及其解决方法。常见错误及解决方法1.连接错误错误信息:FailedtoconnecttoMySQLserver.可能原因:

- FFA 2024 「流批一体」专场:探索在不同场景的流批一体

Apache Flink

FlinkForwardAsia2024即将盛大开幕!作为ApacheFlink社区备受期待的年度盛会之一,本届大会将于11月29至30日在上海隆重举行。FlinkForwardAsia(简称FFA)是由Apache官方授权的社区技术大会,旨在汇聚领先的行业实践与技术动态。在众多合作伙伴和技术开发者的支持下,FFA已成功举办六届。适逢ApacheFlink诞生10周年,今年的FFA将与广大开发者分

- Scaleph:基于Kubernetes的开放式数据平台

尤淞渊

Scaleph:基于Kubernetes的开放式数据平台scalephOpendataplatformbasedonFlinkandKubernetes,supportsweb-uiclick-and-dropdataintegrationwithSeaTunnelbackendedbyFlinkengine,flinkonlinesqldevelopmentbackendedbyFlinkSql

- 深入Flink : 源码解读数据倾斜代码落地

java

大家好,我是大圣,很高兴又和大家见面。上篇文章,我们详细说了通过使得Flink每个并行子任务上面都有对应的key来解决数据倾斜。但是我们只说了这个方案的思想和设计理解,还没有把这种方案真正应用到我们的Flink任务当中。这篇文章我们就重点把这种方案实践到我们写的Flink任务当中。什么是数据倾斜解决方案回顾代码如下:publicclassRebalanceKeyCreator{privateint

- Flink(十):DataStream API (七) 状态

Leven199527

Flinkflink大数据

1.状态的定义在ApacheFlink中,状态(State)是指在数据流处理过程中需要持久化和追踪的中间数据,它允许Flink在处理事件时保持上下文信息,从而支持复杂的流式计算任务,如聚合、窗口计算、联接等。状态是Flink处理有状态操作(如窗口、时间戳操作、聚合等)的核心组成部分。2.状态的类型Flink提供了强大的状态管理机制,允许应用程序在分布式环境中处理状态,保证高可用性和容错性。Flin

- Apache Flink

morcake

flink大数据

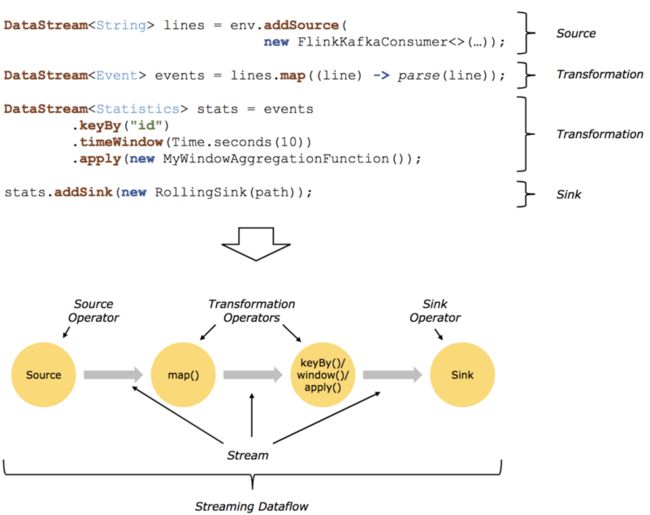

"ApacheFlinkistheopensourcestreamprocessingframeworkfordistributed,high-performance,ready-to-use,andaccuratestreamprocessingapplications."ApacheFlinkisaframeworkanddistributedprocessingengineforstatef

- 一文帮你搞懂flink中窗口的分类(一)

知否&知否

flink中窗口及其函数分类flink大数据

Window可以分成两类:CountWindow:按照指定的数据条数生成一个Window,与时间无关。滚动计数窗口,每隔N条数据,统计前N条数据滑动计数窗口,每隔N条数据,统计前M条数据TimeWindow:按照时间生成Window。(重点)滚动时间窗口,每隔N时间,统计前N时间范围内的数据,窗口长度N,滑动距离N滑动时间窗口,每隔N时间,统计前M时间范围内的数据,窗口长度M,滑动距离N还有一种特

- Java 大视界 -- Java 驱动大数据流处理:Storm 与 Flink 入门(六)

青云交

大数据新视界Java大视界FlinkStorm大数据流处理实时数据处理架构实时监控数据分析java

亲爱的朋友们,热烈欢迎你们来到青云交的博客!能与你们在此邂逅,我满心欢喜,深感无比荣幸。在这个瞬息万变的时代,我们每个人都在苦苦追寻一处能让心灵安然栖息的港湾。而我的博客,正是这样一个温暖美好的所在。在这里,你们不仅能够收获既富有趣味又极为实用的内容知识,还可以毫无拘束地畅所欲言,尽情分享自己独特的见解。我真诚地期待着你们的到来,愿我们能在这片小小的天地里共同成长,共同进步。本博客的精华专栏:大数

- 【大数据】Flink CDC 实时同步mysql数据

小码农叔叔

springboot入门到精通大数据FlinkCDCFlinkCDC同步数据FlinkCDC数据同步

目录一、前言二、FlinkCDC介绍2.1什么是FlinkCDC2.2FlinkCDC特点2.3FlinkCDC核心工作原理2.4FlinkCDC使用场景三、常用的数据同步方案对比3.1数据同步概述3.1.1数据同步来源3.2常用的数据同步方案汇总3.3为什么推荐FlinkCDC3.4FlinkCDC适用范围3.5FlinkCDC不同版本对比3.5.1FlinkCDC1.x3.5.2FlinkCD

- Flink 使用 Kafka 作为数据源时遇到了偏移量提交失败的问题

java我跟你拼了

异常笔记flinkkafka大数据

具体的错误日志21:43:57.069[KafkaFetcherforSource:CustomSource->Map->Filter(1/1)#2]ERRORorg.apache.kafka.clients.consumer.internals.ConsumerCoordinator-[ConsumerclientId=consumer-my-group-6,groupId=my-group]O

- 2、Flink 在 DataStream 和 Table 之间进行转换

猫猫爱吃小鱼粮

FlinkSQLflink大数据

1.概述TableAPI和DataStreamAPI都可以处理有界流和无界流。DataStreamAPI提供了流处理的基础(时间、状态和数据流管理);TableAPI抽象了许多内部内容,并提供了一个结构化和声明性的API;在处理历史数据时,需要管理有边界的流;无边界流出现在实时处理场景中,这些场景可能需要先使用历史数据进行初始化。为了高效执行,这两个API都以优化的批处理执行模式处理有界流。由于批

- Flink 常见面试题

知否&知否

flink大数据kafka

1、Flink的四大特征(基石)checkpoint:基于Chandy-Lamport算法,实现了分布式一致性快照,提供了一致性的语义。State:丰富的StateAPI。ValueState,ListState,MapState,BroadcastState.Time:实现了Watemark机制,乱序数据处理,迟到数据容忍。Window:开箱即用的滚动、滑动、会话窗口。以及灵活的自定义窗口。2、

- 大数据-257 离线数仓 - 数据质量监控 监控方法 Griffin架构

武子康

大数据离线数仓大数据数据仓库java后端hadoophive

点一下关注吧!!!非常感谢!!持续更新!!!Java篇开始了!目前开始更新MyBatis,一起深入浅出!目前已经更新到了:Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume(已更完)Sqoop(已更完)Zookeeper(已更完)HBase(已更完)Redis(已更完)Kafka(已更完)Spark(已更完)Flink(已更完)ClickHouse(已

- Apache Flink 2.0-preview released

flink大数据

ApacheFlink社区正在积极准备Flink2.0,这是自Flink1.0发布8年以来的首次大版本发布。作为一个重要的里程碑,Flink2.0将引入许多激动人心的功能和改进,以及一些不兼容的破坏性变更。为了促进用户和上下游项目(例如,连接器)尽早适配这些变更,提前尝试这些令人兴奋的新功能同时收集反馈,我们现在提供了Flink2.0的预览版本。注意:Flink2.0预览版不是稳定版本,请不要应用

- 2024年最新Python:Page Object设计模式_python page object,BTAJ大厂最新面试题汇集

m0_60707708

程序员python设计模式开发语言

最后硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是

- 2024年总结:大转向

年度总结

本文于2025年1月2号首发于公众号“狗哥琐话”。2024年是个打工人苦命年,我看到几乎每个人都比以往辛苦。这让我想起了六字真言,钱难赚屎难吃。职业转向今年我在职业上尝试做了一个转向,具体的结果可能需要比较长的时间来检验我选择是否正确,所以转向的细节我就不全部展开了,可以确定是我依然会专注在Infra和BigData,比如今年我发布了SparkSQL和FlinkSQL的IDEA提效插件。那么我为什

- Flink 批作业如何在 Master 节点出错重启后恢复执行进度?

flink大数据

摘要:本文撰写自阿里云研发工程师李俊睿(昕程),主要介绍Flink1.20版本中引入了批作业在JMfailover后的进度恢复功能。主要分为以下四个内容:背景解决思路使用效果如何启用一、背景在Flink1.20版本之前,如果Flink的JobMaster(JM)发生故障导致被终止,将会发生如下两种情况:如果作业未启用高可用性(HA),作业将失败。如果作业启用了HA,JM会被自动重新拉起(JMfai

- 读Flink源码谈设计:Metric

javaflink

版本日期备注1.02021.10.8文章首发1.12022.3.9fixtypo1.22022.7.3fixtypo0.前言前阵子笔者涉及了些许监控相关的开发工作,在开发过程中也碰到过些许问题,便翻读了Flink相关部分的代码,在读代码的过程中发现了一些好的设计,因此也是写成文章整理上来。本文的源码基于Flink1.13.2。1.扩展插件化在官网中,Flink社区自己提供了一些已接入的Report

- Flink CDC 在阿里云实时计算Flink版的云上实践

flink大数据实时计算

摘要:本文整理自阿里云高级开发工程师,ApacheFlinkCommitter阮航老师在FlinkForwardAsia2024生产实践(三)专场中的分享,主要分为以下四个方面:一、FlinkCDC&实时计算Flink二、CDCYAML核心功能三、CDCYAML典型应用场景四、Demo&未来规划一、FlinkCDC&实时计算Flink1.1FlinkCDC简介FlinkCDC在经过多个版本的发布后

- JAVA基础

灵静志远

位运算加载Date字符串池覆盖

一、类的初始化顺序

1 (静态变量,静态代码块)-->(变量,初始化块)--> 构造器

同一括号里的,根据它们在程序中的顺序来决定。上面所述是同一类中。如果是继承的情况,那就在父类到子类交替初始化。

二、String

1 String a = "abc";

JAVA虚拟机首先在字符串池中查找是否已经存在了值为"abc"的对象,根

- keepalived实现redis主从高可用

bylijinnan

redis

方案说明

两台机器(称为A和B),以统一的VIP对外提供服务

1.正常情况下,A和B都启动,B会把A的数据同步过来(B is slave of A)

2.当A挂了后,VIP漂移到B;B的keepalived 通知redis 执行:slaveof no one,由B提供服务

3.当A起来后,VIP不切换,仍在B上面;而A的keepalived 通知redis 执行slaveof B,开始

- java文件操作大全

0624chenhong

java

最近在博客园看到一篇比较全面的文件操作文章,转过来留着。

http://www.cnblogs.com/zhuocheng/archive/2011/12/12/2285290.html

转自http://blog.sina.com.cn/s/blog_4a9f789a0100ik3p.html

一.获得控制台用户输入的信息

&nbs

- android学习任务

不懂事的小屁孩

工作

任务

完成情况 搞清楚带箭头的pupupwindows和不带的使用 已完成 熟练使用pupupwindows和alertdialog,并搞清楚两者的区别 已完成 熟练使用android的线程handler,并敲示例代码 进行中 了解游戏2048的流程,并完成其代码工作 进行中-差几个actionbar 研究一下android的动画效果,写一个实例 已完成 复习fragem

- zoom.js

换个号韩国红果果

oom

它的基于bootstrap 的

https://raw.github.com/twbs/bootstrap/master/js/transition.js transition.js模块引用顺序

<link rel="stylesheet" href="style/zoom.css">

<script src=&q

- 详解Oracle云操作系统Solaris 11.2

蓝儿唯美

Solaris

当Oracle发布Solaris 11时,它将自己的操作系统称为第一个面向云的操作系统。Oracle在发布Solaris 11.2时继续它以云为中心的基调。但是,这些说法没有告诉我们为什么Solaris是配得上云的。幸好,我们不需要等太久。Solaris11.2有4个重要的技术可以在一个有效的云实现中发挥重要作用:OpenStack、内核域、统一存档(UA)和弹性虚拟交换(EVS)。

- spring学习——springmvc(一)

a-john

springMVC

Spring MVC基于模型-视图-控制器(Model-View-Controller,MVC)实现,能够帮助我们构建像Spring框架那样灵活和松耦合的Web应用程序。

1,跟踪Spring MVC的请求

请求的第一站是Spring的DispatcherServlet。与大多数基于Java的Web框架一样,Spring MVC所有的请求都会通过一个前端控制器Servlet。前

- hdu4342 History repeat itself-------多校联合五

aijuans

数论

水题就不多说什么了。

#include<iostream>#include<cstdlib>#include<stdio.h>#define ll __int64using namespace std;int main(){ int t; ll n; scanf("%d",&t); while(t--)

- EJB和javabean的区别

asia007

beanejb

EJB不是一般的JavaBean,EJB是企业级JavaBean,EJB一共分为3种,实体Bean,消息Bean,会话Bean,书写EJB是需要遵循一定的规范的,具体规范你可以参考相关的资料.另外,要运行EJB,你需要相应的EJB容器,比如Weblogic,Jboss等,而JavaBean不需要,只需要安装Tomcat就可以了

1.EJB用于服务端应用开发, 而JavaBeans

- Struts的action和Result总结

百合不是茶

strutsAction配置Result配置

一:Action的配置详解:

下面是一个Struts中一个空的Struts.xml的配置文件

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE struts PUBLIC

&quo

- 如何带好自已的团队

bijian1013

项目管理团队管理团队

在网上看到博客"

怎么才能让团队成员好好干活"的评论,觉得写的比较好。 原文如下: 我做团队管理有几年了吧,我和你分享一下我认为带好团队的几点:

1.诚信

对团队内成员,无论是技术研究、交流、问题探讨,要尽可能的保持一种诚信的态度,用心去做好,你的团队会感觉得到。 2.努力提

- Java代码混淆工具

sunjing

ProGuard

Open Source Obfuscators

ProGuard

http://java-source.net/open-source/obfuscators/proguardProGuard is a free Java class file shrinker and obfuscator. It can detect and remove unused classes, fields, m

- 【Redis三】基于Redis sentinel的自动failover主从复制

bit1129

redis

在第二篇中使用2.8.17搭建了主从复制,但是它存在Master单点问题,为了解决这个问题,Redis从2.6开始引入sentinel,用于监控和管理Redis的主从复制环境,进行自动failover,即Master挂了后,sentinel自动从从服务器选出一个Master使主从复制集群仍然可以工作,如果Master醒来再次加入集群,只能以从服务器的形式工作。

什么是Sentine

- 使用代理实现Hibernate Dao层自动事务

白糖_

DAOspringAOP框架Hibernate

都说spring利用AOP实现自动事务处理机制非常好,但在只有hibernate这个框架情况下,我们开启session、管理事务就往往很麻烦。

public void save(Object obj){

Session session = this.getSession();

Transaction tran = session.beginTransaction();

try

- maven3实战读书笔记

braveCS

maven3

Maven简介

是什么?

Is a software project management and comprehension tool.项目管理工具

是基于POM概念(工程对象模型)

[设计重复、编码重复、文档重复、构建重复,maven最大化消除了构建的重复]

[与XP:简单、交流与反馈;测试驱动开发、十分钟构建、持续集成、富有信息的工作区]

功能:

- 编程之美-子数组的最大乘积

bylijinnan

编程之美

public class MaxProduct {

/**

* 编程之美 子数组的最大乘积

* 题目: 给定一个长度为N的整数数组,只允许使用乘法,不能用除法,计算任意N-1个数的组合中乘积中最大的一组,并写出算法的时间复杂度。

* 以下程序对应书上两种方法,求得“乘积中最大的一组”的乘积——都是有溢出的可能的。

* 但按题目的意思,是要求得这个子数组,而不

- 读书笔记-2

chengxuyuancsdn

读书笔记

1、反射

2、oracle年-月-日 时-分-秒

3、oracle创建有参、无参函数

4、oracle行转列

5、Struts2拦截器

6、Filter过滤器(web.xml)

1、反射

(1)检查类的结构

在java.lang.reflect包里有3个类Field,Method,Constructor分别用于描述类的域、方法和构造器。

2、oracle年月日时分秒

s

- [求学与房地产]慎重选择IT培训学校

comsci

it

关于培训学校的教学和教师的问题,我们就不讨论了,我主要关心的是这个问题

培训学校的教学楼和宿舍的环境和稳定性问题

我们大家都知道,房子是一个比较昂贵的东西,特别是那种能够当教室的房子...

&nb

- RMAN配置中通道(CHANNEL)相关参数 PARALLELISM 、FILESPERSET的关系

daizj

oraclermanfilespersetPARALLELISM

RMAN配置中通道(CHANNEL)相关参数 PARALLELISM 、FILESPERSET的关系 转

PARALLELISM ---

我们还可以通过parallelism参数来指定同时"自动"创建多少个通道:

RMAN > configure device type disk parallelism 3 ;

表示启动三个通道,可以加快备份恢复的速度。

- 简单排序:冒泡排序

dieslrae

冒泡排序

public void bubbleSort(int[] array){

for(int i=1;i<array.length;i++){

for(int k=0;k<array.length-i;k++){

if(array[k] > array[k+1]){

- 初二上学期难记单词三

dcj3sjt126com

sciet

concert 音乐会

tonight 今晚

famous 有名的;著名的

song 歌曲

thousand 千

accident 事故;灾难

careless 粗心的,大意的

break 折断;断裂;破碎

heart 心(脏)

happen 偶尔发生,碰巧

tourist 旅游者;观光者

science (自然)科学

marry 结婚

subject 题目;

- I.安装Memcahce 1. 安装依赖包libevent Memcache需要安装libevent,所以安装前可能需要执行 Shell代码 收藏代码

dcj3sjt126com

redis

wget http://download.redis.io/redis-stable.tar.gz

tar xvzf redis-stable.tar.gz

cd redis-stable

make

前面3步应该没有问题,主要的问题是执行make的时候,出现了异常。

异常一:

make[2]: cc: Command not found

异常原因:没有安装g

- 并发容器

shuizhaosi888

并发容器

通过并发容器来改善同步容器的性能,同步容器将所有对容器状态的访问都串行化,来实现线程安全,这种方式严重降低并发性,当多个线程访问时,吞吐量严重降低。

并发容器ConcurrentHashMap

替代同步基于散列的Map,通过Lock控制。

&nb

- Spring Security(12)——Remember-Me功能

234390216

Spring SecurityRemember Me记住我

Remember-Me功能

目录

1.1 概述

1.2 基于简单加密token的方法

1.3 基于持久化token的方法

1.4 Remember-Me相关接口和实现

- 位运算

焦志广

位运算

一、位运算符C语言提供了六种位运算符:

& 按位与

| 按位或

^ 按位异或

~ 取反

<< 左移

>> 右移

1. 按位与运算 按位与运算符"&"是双目运算符。其功能是参与运算的两数各对应的二进位相与。只有对应的两个二进位均为1时,结果位才为1 ,否则为0。参与运算的数以补码方式出现。

例如:9&am

- nodejs 数据库连接 mongodb mysql

liguangsong

mongodbmysqlnode数据库连接

1.mysql 连接

package.json中dependencies加入

"mysql":"~2.7.0"

执行 npm install

在config 下创建文件 database.js

- java动态编译

olive6615

javaHotSpotjvm动态编译

在HotSpot虚拟机中,有两个技术是至关重要的,即动态编译(Dynamic compilation)和Profiling。

HotSpot是如何动态编译Javad的bytecode呢?Java bytecode是以解释方式被load到虚拟机的。HotSpot里有一个运行监视器,即Profile Monitor,专门监视

- Storm0.9.5的集群部署配置优化

roadrunners

优化storm.yaml

nimbus结点配置(storm.yaml)信息:

# Licensed to the Apache Software Foundation (ASF) under one

# or more contributor license agreements. See the NOTICE file

# distributed with this work for additional inf

- 101个MySQL 的调节和优化的提示

tomcat_oracle

mysql

1. 拥有足够的物理内存来把整个InnoDB文件加载到内存中——在内存中访问文件时的速度要比在硬盘中访问时快的多。 2. 不惜一切代价避免使用Swap交换分区 – 交换时是从硬盘读取的,它的速度很慢。 3. 使用电池供电的RAM(注:RAM即随机存储器)。 4. 使用高级的RAID(注:Redundant Arrays of Inexpensive Disks,即磁盘阵列

- zoj 3829 Known Notation(贪心)

阿尔萨斯

ZOJ

题目链接:zoj 3829 Known Notation

题目大意:给定一个不完整的后缀表达式,要求有2种不同操作,用尽量少的操作使得表达式完整。

解题思路:贪心,数字的个数要要保证比∗的个数多1,不够的话优先补在开头是最优的。然后遍历一遍字符串,碰到数字+1,碰到∗-1,保证数字的个数大于等1,如果不够减的话,可以和最后面的一个数字交换位置(用栈维护十分方便),因为添加和交换代价都是1