由C#编写的多线程异步抓取网页的网络爬虫控制台程序

一、本程序的主要功能

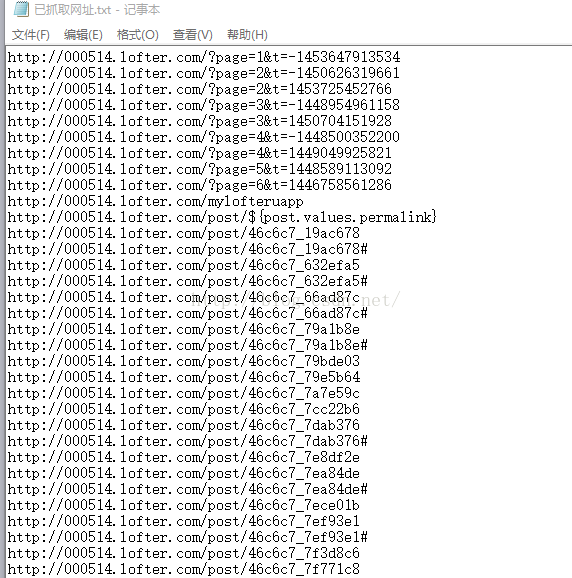

对网络链接进行抓取,把链接地址保存成文件,如下图:

二、实现本程序的主要类

1、WebPage类

WebPage类编写者另有其人,类Link的定义在他博文的留言区,这是他的博文地址 http://blog.csdn.net/yysyangyangyangshan/article/details/6661886

WebPage类很强大,主要可以抓取一个网址里面的文本和链接。不过因为未经作者同意,不能转载,所以这里不贴出他的代码了。

需要注意的是,WebPage类里面的几个私有成员没有初始化,程序在链接数目比较大时会报错,所以需要小改动,把相关成员变量赋初始值,就可以了。另外这个类不能处理https开头的链接,注意有个“s”,只能处理http开头的链接,具体原因还在调查中。

2、Link类

WebPage类的成员变量需要定义的类,只有两个属性,并不复杂,具体去看他的博文留言区。

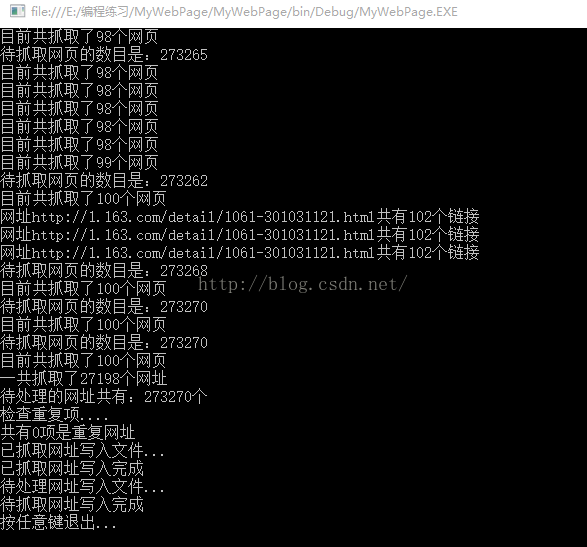

3、主程序Program类

这个类是我写的,主要是多线程处理WebPage类抓下来的网址链接,具体可以看下面源代码,注释的也比较详细,这里就不多说了,程序的运行截图如下:

///

/// 主程序编写作者:大黑

/// (WebPage类编写者另有其人,类Link的定义在他博文的留言区,这是他的博文地址http://blog.csdn.net/yysyangyangyangshan/article/details/6661886)

/// 描述:由C#编写的多线程异步抓取网页的网络爬虫控制台程序

/// 功能:目前只能提取网络链接,所用的两个记录文件并不需要很大。网页文本、图片、视频和html代码暂时不能抓取,请见谅。

/// 但需要注意,网页的数目是非常庞大的,如下代码理论上大概可以把整个互联网网页链接都抓下来。

/// 但事实上,由于处理器功能和网络条件(主要是网速)限制,一般的家用电脑最多能胜任12个线程左右的抓取任务,抓取速度有限。可以抓取,但需要时间和耐心。

/// 当然,这个程序把所有链接抓下来是可能的,因为链接占系统空间并不多,而且有记录文件的帮助,已抓取网页的数量可以堆积下去,

/// 甚至可以把所有的互联网网络链接都存取下来,当然,最好是分批次。建议设置maxNum为500-1000左右,慢慢累积下去。

/// 另外因为是控制台程序,有时候显示字符过多会系统会暂停显示,这时候只要点击控制台按下回车键就可以了。程序假死的时候,可以按回车键(Enter)试试。

/// 使用本程序,请确保已创建相应的记录文件,出于简化代码的考虑,本程序做的并不健壮,请见谅。

/// 默认的文件创建在E盘根目录“已抓取网址.txt”和“待抓取网址.txt”这两个文本文件中,使用者需要自行创建这两个文件,注意后缀名不要搞错。

/// 这两个文件里面的链接基本都是有效链接,可以单独处理使用。

/// 本爬虫程序的速度如下:

/// 10线程最快大概500个链接每分钟

/// 6-8线程最快大概400-500个链接每分钟

/// 2-4线程最快大概200-400个链接每分钟

/// 单线程最快大概70-100个链接每分钟

/// 之所以用多线程异步抓取完全是出于效率考虑,本程序多线程同步并不能带来速度的提升,只要抓取的网页不要太多重复和冗余就可以,异步并不意味着错误。

///

class Program

{

//默认的种子网址,可以改动。尽量保持不同的网址,可以提高效率。

//另外注意改的时候“,”符号要注意,别改错了,要英文逗号。

//默认是3线程3个种子网址,最多12线程12个网址,如果要12个以上,可以自己在后面添加。线程设定为12个以上时,必须添加网址,不然会出错

//每个网址对应一个线程,即6线程对应6网址,12线程对应12网址,改默认值的时候要注意parts和数组linkArray的对应关系。

//实测当CPU是i5处理器时,最多运行8-10线程,会伴有严重的卡顿。线程数越高,对CPU要求越高。一般CPU 2-4线程就可以。

static string[] linkArray = { "http://www.163.com/", "http://www.sohu.com/", "http://www.ifeng.com/",

"http://www.sina.com.cn/","http://wan.360.cn/?src=hao-mz-top01","http://www.pconline.com.cn/?ad=6347&360hot_site",

"http://ai.taobao.com/?pid=mm_26632323_6762370_25910879","http://www.apple.com/cn/","http://www.zol.com.cn/",

"http://www.yesky.com/","http://www.asus.com.cn/","http://edu.360.cn/yingyu/",

};

//设定存放已抓取网址列表的文件路径

static string urlCapturedDir = @"E:\已抓取网址.txt";

//设定存放未抓取网址列表的文件路径

static string myLinkDir = @"E:\待抓取网址.txt";

//同时抓取网址的线程数

private static int parts=3;

//目前抓取的网页数量

private static int count=0;

//设定的最多抓取网页的数量

private static int maxNum=500;

//待抓取的网址链表

private static List<string> myLink=new List<string>();

//已抓取的网址链表

private static List<string> urlCaptured=new List<string>();

//用于临时存放待抓取的某一个网址

private static string strLink = "";

public Program(string link)

{

myLink.Add(link);

}

public void doWork()

{

Console.WriteLine("working...");

while ((myLink.Count != 0) && (count < maxNum))

{

strLink = myLink[0];

if (!urlCaptured.Contains(strLink))

{

//加入已抓取队列

urlCaptured.Add(strLink);

//当前抓取的网页数量

count++;

//通过WebPage类抓取

WebPage tempWeb = new WebPage(strLink);

Console.WriteLine("网址" + strLink + "共有" + tempWeb.Links.Count + "个链接");

foreach (Link li in tempWeb.Links)

{

//确保不重复抓取

if (!myLink.Contains(li.NavigateUrl))

myLink.Add(li.NavigateUrl);

}

Console.WriteLine("待抓取网页的数目是:" + myLink.Count);

//确保不重复抓取,此句多线程运行会报错

while(myLink.Remove(strLink));

}

else

{

//删除重复网址

while (myLink.Remove(strLink)) ;

}

Console.WriteLine("目前共抓取了" + count + "个网页");

}

}

static void printLinks(List<string> links)

{

foreach(string s in links)

{

Console.WriteLine(s);

}

}

static void Main(string[] args)

{

//读取已处理网址列表(urlCaptured)

string[] lines = System.IO.File.ReadAllLines(urlCapturedDir);

int urlCapturedIndex = 0;

foreach (string line in lines)

{

//if (!urlCaptured.Contains(line))

{

urlCaptured.Add(line);

urlCapturedIndex++;

if(urlCapturedIndex%2000==0)

{

Console.WriteLine("已导入" + urlCapturedIndex + "项已抓取网址");

}

}

}

// 显示已抓取网址列表

Console.WriteLine("已读取已处理网址列表,共"+urlCaptured.Count+"条信息:");

//未抓取网址初始化

string[] lines2 = System.IO.File.ReadAllLines(myLinkDir);

int myLinkIndex = 0;

foreach (string line in lines2)

{

//Contains方法太耗时

//if (!myLink.Contains(line))

{

myLink.Add(line);

myLinkIndex++;

if(myLinkIndex%2000==0)

{

Console.WriteLine("已导入" + myLinkIndex + "项待抓取网址");

}

}

}

// 显示未抓取网址列表

Console.WriteLine("已读取未抓取网址列表,共" + myLink.Count + "条信息:");

System.Threading.Thread[] threads = new System.Threading.Thread[parts];

for (int i = 0; i < parts; i++)

{

string str_l = linkArray[i];

Program p = new Program(str_l);

System.Threading.Thread t = new System.Threading.Thread(new System.Threading.ThreadStart(p.doWork));

threads[i] = t;

threads[i].Name = "Thread" + i.ToString();

}

for (int i = 0; i < parts; i++)

{

threads[i].Start();

}

//为了确保 Main 函数不会尝试在辅助线程有机会执行结束之前将它终止

//Main 函数将一直循环,直到辅助线程对象的 IsAlive 属性设置为 false

//必须用while,表示线程都已经执行完了

for (int i = 0; i < parts; i++)

{

while (threads[i].IsAlive)

{

;

}

}

Console.WriteLine("一共抓取了" + urlCaptured.Count + "个网址");

Console.WriteLine("待处理的网址共有:" + myLink.Count + "个");

Console.WriteLine("检查重复项....");

List<string> temp_l = new List<string>();

foreach (string str in urlCaptured)

{

if (!temp_l.Contains(str))

{

temp_l.Add(str);

}

else

{

Console.WriteLine("网址" + str + "重复");

}

}

Console.WriteLine("共有" + (urlCaptured.Count - temp_l.Count) + "项是重复网址");

urlCaptured = temp_l;

Console.WriteLine("已抓取网址写入文件...");

//对已抓取的网址进行排序

urlCaptured.Sort();

using (System.IO.StreamWriter file =

new System.IO.StreamWriter(urlCapturedDir))

{

foreach(string s in urlCaptured)

{

file.WriteLine(s);

}

}

Console.WriteLine("已抓取网址写入完成");

Console.WriteLine("待处理网址写入文件...");

myLink.Sort();

using (System.IO.StreamWriter file =

new System.IO.StreamWriter(myLinkDir))

{

foreach (string s in myLink)

{

file.WriteLine(s);

}

}

Console.WriteLine("待抓取网址写入完成");

//下面的句子表示保持显示当前控制台命令行,不然控制台会一闪而过

Console.WriteLine("按任意键退出...");

Console.ReadKey();

}

}

}