从2019 Google I/O大会看深度学习的发展与应用

周末看了一下5月7号举行的2019 Google I/O大会。整场大会基本围绕Google Search,Google Lens,Google Go,Duplex,Google Assistant,Federated Learning,Android Q,Nest Hub Max,Pixel手机,Google AI这些产品或技术进行。贯穿整个大会的有两条主线,一个是机器学习(或者说深度学习)的发展和应用,一个是用户隐私的保护。自从Google从Mobile First转到AI First后,发表了大量的学术论文,发布了TensorFlow这一目前使用最多的深度学习框架,也几乎在每一个产品中应用了最新的深度学习成果,让Google成为了名副其实的全球AI第一大厂。这些年出现了一个有趣的现象,自从2012年深度学习兴起后,以Google为代表的科技公司发表了数量众多的学术论文,在各大学术会议上显得特别耀眼,这在之前并不常见。百度或许是国内互联网公司中最先意识到深度学习潜力的公司,早早的在2013年年初就成立了深度学习研究院。错过了移动互联网的李彦宏急切的想要找到下一个风口,后面百度甚至还喊出了All in AI的口号,但天不遂人愿,AI目前所提供的能力并没有那么好商业化,跟移动互联网的浪潮相比,简直是小巫见大巫。马化腾是一个比较谨慎的人,到了大概2016年形势比较明朗了,才在公司大力的倡导深度学习的学习和应用,但我们的口号是AI in All,即将AI应用到所有产品中。我便在这一次浪潮中入了机器学习的坑。后来在一次内部交流会上,我们的一个VP直言不讳的告诉我们,百度All in AI的策略在他们看来就是一个笑话。百度也逐步意识到了这一点,后面李彦宏公开说他从来没有说过要All in AI,他确实没说过,是陆奇说的。现在百度的市值只有阿里、腾讯的十分之一,李彦宏确实是一个不太懂产品和商业又独裁的技术男。

回到正题。

大会一开场,劈柴哥便宣布了Google新的使命。过去Google的使命是organize the world’s information and make it universally accessible and useful,但是we are moving from a company that helps you find answers to a company that helps you get things done。

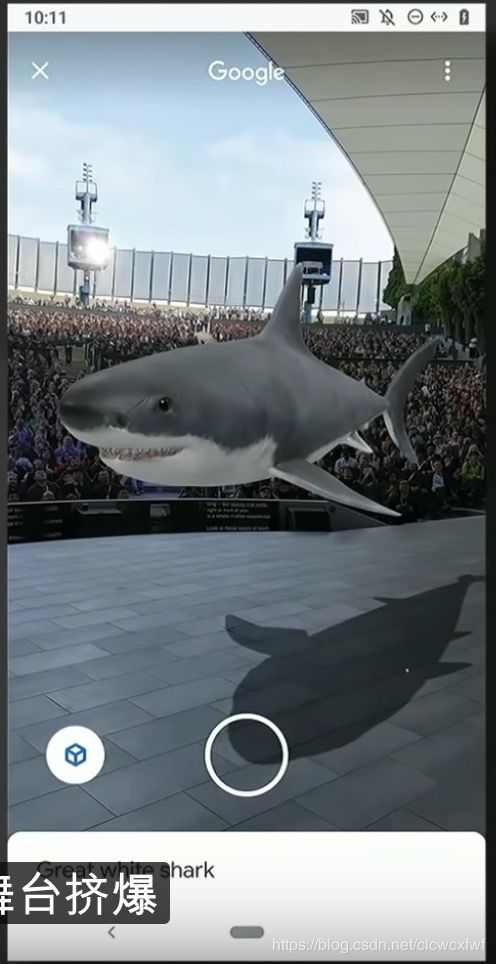

作为Google最重要的产品,第一个出场的便是Google Search。新的feature包括Full Coverage和AR等。Full Coverage我没太搞懂,大概是用机器学习的方法将信息组织得更好。AR也没啥新意,在搜索结果里直接以3D的形式展示物体。我们在2016年便做过AR红包。

展示这个鲨鱼的时候又让我想起了Magic Leap这个赫赫有名的骗子公司,竟然连Google和阿里的钱都能骗到。

接下来展示了Google Lens这个应用,也没什么新意,大概是用这个app打开摄像头去识别一朵花,去做OCR文字识别计算小费等。其实国内的公司也很厉害了,一两年前就有一些教育类的app可以直接打开摄像头扫描小学生的数学作业,显示哪些加减乘除运算是错的。

接着是Google Go这个应用。因为我没有听说过这个app,所以赶紧google了一下:

大致是一个为低端手机和低速网络打造的一个搜索产品,给经济没那么发达的地区的人用。这个产品新feature的介绍也没啥新奇的,大致是拍一张ATM机上的提示的照片,再进行OCR文字识别,同时可以做翻译以及文字转语音。

这里面用到了OCR、机器翻译、文字转语音等技术。技术虽然都是现成的了,但Google厉害的地方在于这些深度神经网络模型完全运行在一台35美元(200~300RMB)的手机上,不需要后端服务器的参与,所有这些模型只有100KB。

Google在去年的I/O大会上展示了Duplex技术,让智能助手帮你打电话给真人预约一次剪头发,可以说是相当惊艳了。今年Google将Duplex技术从语音扩展到了web领域,叫Duplex on the web。它可以帮你用某个app预订出租车或者电影票,免去你各种选择和填资料的麻烦。

接下来是Google Assistant。现在做到了可以不用唤醒词,不用每次发指令前都说句hi, google。现场展示了通过语音打开手机上的各个app,且速度非常快,以及一个完全通过语音帮你写邮件的demo:

这里面可以识别很多关键词,并做响应的动作,比如直接说send it,邮件就发送了。

看演示,语音识别的速度确实非常快,这都得益于Google大力发展的On-device Machine Learning技术。劈柴哥说他们将100G的模型压缩到了0.5G,直接在手机上运行。厉害了。

Facebook最近在隐私保护上栽了大跟斗,也让Google加强了这方面的动作。Google介绍了一些关于隐私保护的新feature,接着介绍了一个很强大的技术,叫Federated Learning联合学习:

大致是在云端有一个Global的model,将这个global model拆成一个个小的子model下发给手机,手机就自己训练这个模型,再将训练好的模型发送到云端,去更新那个Global Model,这样就完全不用将用户的原始信息上传到云端了。如果真要做到在机器学习时代完全的保护用户隐私,就只有直接在手机端训练模型这一条路了。

Gboard输入法便用到了Federated Learning。这个想法确实很好,很多新出现的词是没有办法从我自己的手机上学习到的,必须得成千上万的其他人去更新全局模型才能实现。这样虽然我从来没有输入过YOLO这个专有名词,也能被联想出来。这里我来吐槽一下YOLO这篇论文吧,这个词的全称是You Only Look Once,是一篇非常有名的object detection论文的标题。一般论文的标题都比较学术和具体,就好比“一种xxx新方法”之类的,但这篇论文的标题就比较有新意,搞学术的人也越来越会玩了。

接下来介绍的是Android Q。新的功能包括支持折叠屏、5G、夜间模式、各种AI功能、用户隐私保护等。

Google Hub被改名为了Nest Hub。Google将所有的智能家居产品全部统一到了Nest这个品牌下。着重介绍的是Nest Hub Max这个产品:

这里基本是集成了最新的语音识别和图像识别等技术,包括手势识别、人脸识别,但它的人脸数据是没有上传到云端的,完全在本地设备上。嗯,保护用户隐私最重要!

接下来是Pixel手机。之前Pixel确实卖得比较贵,今年Google降低了Pixel手机的价格,400美金,还是觉得贵。

这里重点介绍了手机的摄像头功能,通过AI从软件方面增强图像的效果,而不是用更贵的摄像头。比如在光线不足时,通过算法也能拍出清晰的照片:

还顺便黑了一下iPhone。

介绍时说到Pixel的电池用到了adaptive battery技术,机器学习根据你使用手机的方式进行电池的优化,使得使用时间更长,但没有具体说,比较好奇是怎么做的。

最后压轴的是Google AI。jeff介绍了他们提出的Bidirectional Encoder Representations from Transformers BERT技术,据说在自然语言理解上非常有效,没有仔细了解过,不过看名字:Bidirectional,双向的上下文理解,确实应该比LSTM之类的要强一些。接着一个中国的小姐姐介绍了深度学习支持的计算机视觉在视网膜病变和癌症早期检测方面的应用,准确率比训练有素的放射科医生更高,这点我一点也不怀疑。

纵观整场大会,就两个关键词:AI和隐私保护。

更多信息请关注我的公众号: LongchensViewOfTheWorld