逻辑斯谛回归与最大熵模型logistic regression/maximum entropy model

本文是《统计学习方法》李航著学习笔记。

为了叙述方便,将logistic regression mode简称LR,maximum entropy mode简称ME。LR和ME都是判别模型,即将预测实例点分配到“条件概率分布”最大的类中。下述讨论会着重于LR模型和ME模型的学习过程。

逻辑斯谛函数:

l ( x ) = 1 1 + e − ( x − μ ) / γ , μ 为 位 置 参 数 , γ > 0 为 形 状 参 数 l(x)=\frac{1}{1+e^{-(x-\mu)/\gamma}},\mu为位置参数,\gamma>0为形状参数 l(x)=1+e−(x−μ)/γ1,μ为位置参数,γ>0为形状参数

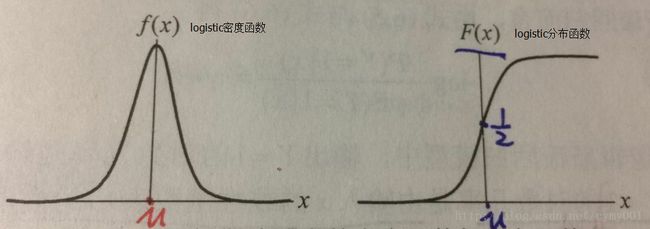

逻辑斯谛分布:

X X X是连续型随机变量,如 X ∼ F ( x ) X\sim F(x) X∼F(x),其中 F ( x ) F(x) F(x)是形如上述 l ( x ) l(x) l(x)的逻辑斯谛函数,则称 X X X服从逻辑斯谛分布,此时,随机变量 X X X:

分 布 函 数 : F ( x ) = P ( X ≤ x ) = 1 1 + e − ( x − μ ) / γ 分布函数:F(x)=P(X\leq x)=\frac{1}{1+e^{-(x-\mu)/\gamma}} 分布函数:F(x)=P(X≤x)=1+e−(x−μ)/γ1

密 度 函 数 : f ( x ) = F ′ ( x ) = e − ( x − μ ) / γ γ ( 1 + e − ( x − μ ) / γ ) 2 密度函数:f(x)=F^{'}(x)=\frac{e^{-(x-\mu)/\gamma}}{\gamma(1+e^{-(x-\mu)/\gamma})^2} 密度函数:f(x)=F′(x)=γ(1+e−(x−μ)/γ)2e−(x−μ)/γ

将上述分布函数变形,并记 1 γ = w ^ , − μ γ = b \frac{1}{\gamma}=\hat{w},-\frac{\mu}{\gamma}=b γ1=w^,−γμ=b,则得类似于二类分类问题的logistic模型函数:

F ( x ) = P ( X ≤ x ) = e 1 γ x − μ γ 1 + e 1 γ x − μ γ = e x p ( w ^ ⋅ x + b ) 1 + e x p ( w ^ ⋅ x + b ) F(x)=P(X\leq x)=\frac{e^{\frac{1}{\gamma}x-\frac{\mu}{\gamma}}}{1+e^{\frac{1}{\gamma}x-\frac{\mu}{\gamma}}}=\frac{exp(\hat{w}\cdot x+b)}{1+exp(\hat{w}\cdot x+b)} F(x)=P(X≤x)=1+eγ1x−γμeγ1x−γμ=1+exp(w^⋅x+b)exp(w^⋅x+b)

极大似然估计:

参考http://blog.csdn.net/cymy001/article/details/78016109

LR模型:

二项LR模型的条件概率分布:

P ( Y = 1 ∣ x ) = e x p ( w ^ ⋅ x + b ) 1 + e x p ( w ^ ⋅ x + b ) P ( Y = 0 ∣ x ) = 1 1 + e x p ( w ^ ⋅ x + b ) P(Y=1|x)=\frac{exp(\hat{w}\cdot x+b)}{1+exp(\hat{w}\cdot x+b)}\\ P(Y=0|x)=\frac{1}{1+exp(\hat{w}\cdot x+b)} P(Y=1∣x)=1+exp(w^⋅x+b)exp(w^⋅x+b)P(Y=0∣x)=1+exp(w^⋅x+b)1

上述 x = ( x ( 1 ) , x ( 2 ) , ⋯ , x ( n ) ) T ∈ R n x=(x^{(1)},x^{(2)},\cdots,x^{(n)})^{T}\in R^{n} x=(x(1),x(2),⋯,x(n))T∈Rn为训练数据的输入, Y ∈ { 0 , 1 } Y\in \{0,1\} Y∈{0,1}为训练数据的输出, w ^ ∈ R n , b ∈ R \hat{w}\in R^{n},b\in R w^∈Rn,b∈R是需要用训练数据集学习的模型参数。

记 w = ( w ^ T , b ) T , x = ( x ( 1 ) , x ( 2 ) , ⋯ , x ( n ) , 1 ) w=(\hat{w}^{T},b)^{T},x=(x^{(1)},x^{(2)},\cdots,x^{(n)},1) w=(w^T,b)T,x=(x(1),x(2),⋯,x(n),1),二项LR模型的条件概率分布进一步化简:

P ( Y = 1 ∣ x ) = e x p ( w ⋅ x ) 1 + e x p ( w ⋅ x ) P ( Y = 0 ∣ x ) = 1 1 + e x p ( w ⋅ x ) P(Y=1|x)=\frac{exp(w\cdot x)}{1+exp(w\cdot x)}\\ P(Y=0|x)=\frac{1}{1+exp(w\cdot x)} P(Y=1∣x)=1+exp(w⋅x)exp(w⋅x)P(Y=0∣x)=1+exp(w⋅x)1

则对于给定的训练数据集 T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , ⋯ , ( x N , y N ) } T=\{(x_{1},y_{1}),(x_{2},y_{2}),\cdots,(x_{N},y_{N})\} T={(x1,y1),(x2,y2),⋯,(xN,yN)},其中 x i ∈ R n , y i ∈ { 0 , 1 } x_{i}\in R^{n},y_{i}\in\{0,1\} xi∈Rn,yi∈{0,1},每个样本点 ( x i , y i ) (x_{i},y_{i}) (xi,yi)的概率分布为

P ( Y = 1 ∣ x i ) y i P ( Y = 0 ∣ x i ) 1 − y i P(Y=1|x_{i})^{y_{i}}P(Y=0|x_{i})^{1-y_{i}} P(Y=1∣xi)yiP(Y=0∣xi)1−yi

训练数据集 T T T中的样本点联合概率分布为

∏ i = 1 N P ( Y = 1 ∣ x i ) y i P ( Y = 0 ∣ x i ) 1 − y i \prod_{i=1}^{N}P(Y=1|x_{i})^{y_{i}}P(Y=0|x_{i})^{1-y_{i}} i=1∏NP(Y=1∣xi)yiP(Y=0∣xi)1−yi

上式也就是LR模型参数的似然函数,取对数得对数似然函数

L ( w ) = ∑ i = 1 N [ y i log P ( Y = 1 ∣ x i ) + ( 1 − y i ) log P ( Y = 0 ∣ x i ) ] = ∑ i = 1 N [ y i ( w ⋅ x i ) − log ( 1 + e x p ( w ⋅ x i ) ) ] L(w)=\sum_{i=1}^{N}\big[y_{i}\log P(Y=1|x_{i})+(1-y_{i})\log P(Y=0|x_{i})\big]\\ =\sum_{i=1}^{N}\big[y_{i}(w\cdot x_{i})-\log(1+exp(w\cdot x_{i}))\big] L(w)=i=1∑N[yilogP(Y=1∣xi)+(1−yi)logP(Y=0∣xi)]=i=1∑N[yi(w⋅xi)−log(1+exp(w⋅xi))]

采用极大似然估计求LR模型参数 w w w,就是对 L ( w ) L(w) L(w)求极大值,即无约束最优化问题。可以通过梯度下降法、牛顿法等求 w ∗ = a r g m a x w L ( w ) w^{*}=\mathop{argmax}_{w}L(w) w∗=argmaxwL(w),将 w ∗ w^{*} w∗带回 P ( Y = 1 ∣ x ) , P ( Y = 0 ∣ x ) P(Y=1|x),P(Y=0|x) P(Y=1∣x),P(Y=0∣x)即是训练数据集 T T T学习到的LR模型。

事件的几率:

事 件 的 几 率 = 事 件 发 生 的 概 率 事 件 不 发 生 的 概 率 = 事 件 发 生 的 概 率 1 − 事 件 发 生 的 概 率 事件的几率=\frac{事件发生的概率}{事件不发生的概率}=\frac{事件发生的概率}{1-事件发生的概率} 事件的几率=事件不发生的概率事件发生的概率=1−事件发生的概率事件发生的概率

事 件 的 对 数 几 率 = log ( 事 件 的 几 率 ) 事件的对数几率=\log(事件的几率) 事件的对数几率=log(事件的几率)

对于二项LR模型,“输出 Y = 1 Y=1 Y=1”这一事件发生的对数几率

log ( P ( Y = 1 ∣ x ) 1 − P ( Y = 1 ∣ x ) ) = w ⋅ x \log\Big(\frac{P(Y=1|x)}{1-P(Y=1|x)}\Big)=w\cdot x log(1−P(Y=1∣x)P(Y=1∣x))=w⋅x

是关于输入 x x x的线性函数,这也是LR回归模型的名字由来。

多项LR模型:

输出随机变量 Y Y Y的取值范围是 { 1 , 2 , ⋯ , K } \{1,2,\cdots,K\} {1,2,⋯,K},对应的LR模型是

P ( Y = k ∣ x ) = e x p ( w k ⋅ x ) 1 + ∑ k = 1 K − 1 e x p ( w k ⋅ x ) , k = 1 , 2 , ⋯ , K − 1 P(Y=k|x)=\frac{exp(w_{k}\cdot x)}{1+\sum\limits_{k=1}^{K-1}exp(w_{k}\cdot x)},k=1,2,\cdots,K-1 P(Y=k∣x)=1+k=1∑K−1exp(wk⋅x)exp(wk⋅x),k=1,2,⋯,K−1

P ( Y = K ∣ x ) = 1 1 + ∑ k = 1 K − 1 e x p ( w k ⋅ x ) P(Y=K|x)=\frac{1}{1+\sum\limits_{k=1}^{K-1}exp(w_{k}\cdot x)} P(Y=K∣x)=1+k=1∑K−1exp(wk⋅x)1

其中 x , w k ∈ R n + 1 x,w_{k}\in R^{n+1} x,wk∈Rn+1。

—————————————————————————

最大熵原理:

学习概率模型时,在所有可能的概率分布模型中,熵最大的模型是最好的。在满足约束条件的模型集合中,选择熵最大的模型。熵的最大化表示等可能性。

模型获取训练数据集信息:

1.)给定训练数据集 T T T,联合分布 P ( X , Y ) P(X,Y) P(X,Y)的经验分布 P ~ ( X , Y ) \widetilde{P}(X,Y) P (X,Y),边缘分布 P ( X ) P(X) P(X)的经验分布 P ~ ( X ) \widetilde{P}(X) P (X)依次为:

P ~ ( X = x , Y = y ) = ν ( X = x , Y = y ) ∣ T ∣ , P ~ ( X = x ) = ν ( X = x ) ∣ T ∣ \widetilde{P}(X=x,Y=y)=\frac{\nu(X=x,Y=y)}{|T|},\widetilde{P}(X=x)=\frac{\nu(X=x)}{|T|} P (X=x,Y=y)=∣T∣ν(X=x,Y=y),P (X=x)=∣T∣ν(X=x)

其中 ν ( X = x , Y = y ) \nu(X=x,Y=y) ν(X=x,Y=y)表示训练数据集中样本 ( x , y ) (x,y) (x,y)出现的频数, ν ( X = x ) \nu(X=x) ν(X=x)表示训练数据集中样本输入 x x x出现的频次, ∣ T ∣ |T| ∣T∣表示训练数据集样本容量。

2.)定义特征函数 f ( x , y ) f(x,y) f(x,y)满足:

f ( x , y ) = { 1 , x 与 y 满 足 某 一 事 实 0 , 否 则 f(x,y)=\begin{cases} 1, &x与y满足某一事实\cr 0, &否则\end{cases} f(x,y)={1,0,x与y满足某一事实否则

soso,若“特征函数 f ( x , y ) f(x,y) f(x,y)关于经验分布 P ~ ( X , Y ) \widetilde{P}(X,Y) P (X,Y)的期望”:

E P ~ ( f ) = ∑ x , y P ~ ( x , y ) f ( x , y ) E_{\widetilde{P}}(f)=\sum_{x,y}\widetilde{P}(x,y)f(x,y) EP (f)=x,y∑P (x,y)f(x,y)

与“特征函数 f ( x , y ) f(x,y) f(x,y)关于学习到的条件概率分布模型 P ( Y ∣ X ) P(Y|X) P(Y∣X)和经验分布 P ~ ( X ) \widetilde{P}(X) P (X)的期望”:

E P ( f ) = ∑ x , y P ~ ( x ) P ( y ∣ x ) f ( x , y ) E_{P}(f)=\sum_{x,y}\widetilde{P}(x)P(y|x)f(x,y) EP(f)=x,y∑P (x)P(y∣x)f(x,y)

相等,则表示“模型能够获取训练数据集的信息”,即 E P ~ ( f ) = E P ( f ) E_{\widetilde{P}}(f)=E_{P}(f) EP (f)=EP(f)。

ME模型:

ME模型就是“满足 E P ~ ( f ) = E P ( f ) E_{\widetilde{P}}(f)=E_{P}(f) EP (f)=EP(f)条件,并且使条件熵

H ( P ) = − ∑ x , y P ~ ( x ) P ( y ∣ x ) log P ( y ∣ x ) H(P)=-\sum\limits_{x,y}\widetilde{P}(x)P(y|x)\log P(y|x) H(P)=−x,y∑P (x)P(y∣x)logP(y∣x)

最大的条件概率分布 P ( Y ∣ X ) P(Y|X) P(Y∣X)模型”。 ⇔ \Leftrightarrow ⇔如下优化问题:

KaTeX parse error: No such environment: align* at position 7: \begin{̲a̲l̲i̲g̲n̲*̲}̲ &\max_{P\in C}…

将上述优化问题转化成极小化 min P ∈ C − H ( P ) \min\limits_{P\in C} -H(P) P∈Cmin−H(P),再有Lagrange乘子法,可得Lagrange函数 L ( P , w ) L(P,w) L(P,w):

L ( P , w ) = − H ( P ) + w 0 ( 1 − ∑ y P ( y ∣ x ) ) + ∑ i = 1 n ( E P ~ ( f ) − E P ( f i ) ) L(P,w)=-H(P)+w_{0}\big(1-\sum_{y}P(y|x)\big)+\sum_{i=1}^{n}\big(E_{\widetilde{P}}(f_{})-E_{P}(f_{i})\big) L(P,w)=−H(P)+w0(1−y∑P(y∣x))+i=1∑n(EP (f)−EP(fi))

则上述优化问题可 ⇔ \Leftrightarrow ⇔转化为无约束优化问题:

min P ∈ C max w L ( P , w ) \min_{P\in C}\max_{w}L(P,w) P∈CminwmaxL(P,w)

由于 L ( P , w ) L(P,w) L(P,w)是 P P P的凸函数,进一步,优化问题可以转化成对偶问题:

max w min P ∈ C L ( P , w ) \max_{w}\min_{P\in C}L(P,w) wmaxP∈CminL(P,w)

a.)先求 min P ∈ C L ( P , w ) \min\limits_{P\in C}L(P,w) P∈CminL(P,w)得关于 w w w的条件概率分布 P w ( y ∣ x ) P_{w}(y|x) Pw(y∣x):

{ ∂ L ( P , w ) ∂ P ( y ∣ x ) = 0 P ~ ( x ) = 0 ∑ y P ( y ∣ x ) = 1 ⇒ { P w ( y ∣ x ) = 1 Z w ( x ) e x p ( ∑ i = 1 n w i f i ( x , y ) ) Z w ( x ) = ∑ y e x p ( ∑ i = 1 n w i f i ( x , y ) ) \begin{cases} \frac{\partial L(P,w)}{\partial P(y|x)}=0 \cr \widetilde{P}(x)=0 \cr \sum\limits_{y}P(y|x)=1\end{cases} \Rightarrow \begin{cases} P_{w}(y|x)=\frac{1}{Z_{w}(x)}exp(\sum\limits_{i=1}^{n}w_{i}f_{i}(x,y)) \cr Z_{w}(x)=\sum\limits_{y}exp(\sum\limits_{i=1}^{n}w_{i}f_{i}(x,y))\end{cases} ⎩⎪⎪⎨⎪⎪⎧∂P(y∣x)∂L(P,w)=0P (x)=0y∑P(y∣x)=1⇒⎩⎪⎪⎨⎪⎪⎧Pw(y∣x)=Zw(x)1exp(i=1∑nwifi(x,y))Zw(x)=y∑exp(i=1∑nwifi(x,y))

上式 P w ( y ∣ x ) P_{w}(y|x) Pw(y∣x)即为最大熵模型,记

Φ ( w ) = min P ∈ C L ( P , w ) = L ( P w , w ) = ∑ x , y P ~ ( x , y ) ∑ i = 1 n w i f i ( x , y ) − ∑ x P ~ ( x ) log Z w ( x ) \Phi(w)=\min_{P\in C}L(P,w)=L(P_{w},w) =\sum\limits_{x,y}\widetilde{P}(x,y)\sum_{i=1}^{n}w_{i}f_{i}(x,y)-\sum\limits_{x}\widetilde{P}(x)\log Z_{w}(x) Φ(w)=P∈CminL(P,w)=L(Pw,w)=x,y∑P (x,y)i=1∑nwifi(x,y)−x∑P (x)logZw(x)

称 Φ ( w ) \Phi(w) Φ(w)为“对偶函数”,此时优化目标可转化为

max w Φ ( w ) \max_{w}\Phi(w) wmaxΦ(w)

b.)到此为止,就可以采用改进的迭代尺度法或者拟牛顿法求解“ Φ ( w ) \Phi(w) Φ(w)关于 w w w的极大值问题”了。

改进的迭代尺度法:

假设最大熵模型的当前参数向量 w = ( w 1 , w 2 , ⋯ , w n ) T w=(w_{1},w_{2},\cdots,w_{n})^{T} w=(w1,w2,⋯,wn)T,希望找到一个新的参数向量 w + δ = ( w 1 + δ 1 , w 2 + δ 2 , ⋯ , w n + δ n ) w+\delta=(w_{1}+\delta_{1},w_{2}+\delta_{2},\cdots,w_{n}+\delta_{n}) w+δ=(w1+δ1,w2+δ2,⋯,wn+δn),使模型的对偶函数值 Φ ( w + δ ) > Φ ( w ) \Phi(w+\delta)>\Phi(w) Φ(w+δ)>Φ(w)。

Φ ( w + δ ) − Φ ( w ) = ∑ x , y P ~ ( x , y ) ∑ i = 1 n δ i f i ( x , y ) − ∑ x P ~ ( x ) log Z w + δ ( x ) Z w ( x ) ≥ ∑ x , y P ~ ( x , y ) ∑ i = 1 n δ i f i ( x , y ) + 1 − ∑ x P ~ ( x ) ∑ y P w ( y ∣ x ) e x p ( ∑ i = 1 n δ i f i ( x , y ) ) ≜ A ( δ ∣ w ) \Phi(w+\delta)-\Phi(w)=\sum_{x,y}\widetilde{P}(x,y)\sum_{i=1}^{n}\delta_{i}f_{i}(x,y)-\sum_{x}\widetilde{P}(x)\log\frac{Z_{w+\delta}(x)}{Z_{w}(x)}\\ \geq\sum_{x,y}\widetilde{P}(x,y)\sum_{i=1}^{n}\delta_{i}f_{i}(x,y)+1-\sum_{x}\widetilde{P}(x)\sum_{y}P_{w}(y|x)exp(\sum_{i=1}^{n}\delta_{i}f_{i}(x,y))\triangleq A(\delta|w) Φ(w+δ)−Φ(w)=x,y∑P (x,y)i=1∑nδifi(x,y)−x∑P (x)logZw(x)Zw+δ(x)≥x,y∑P (x,y)i=1∑nδifi(x,y)+1−x∑P (x)y∑Pw(y∣x)exp(i=1∑nδifi(x,y))≜A(δ∣w)

由于指数项 e x p ( ∑ i = 1 n δ i f i ( x , y ) ) exp(\sum_{i=1}^{n}\delta_{i}f_{i}(x,y)) exp(∑i=1nδifi(x,y))关于 δ i \delta_{i} δi求导时无法分离 δ j , j ≠ i \delta_{j},j\neq i δj,j̸=i,所以利用Jensen不等式进一步降低下限,记 f ♯ ( x , y ) = ∑ i f i ( x , y ) f^{\sharp}(x,y)=\sum_{i}f_{i}(x,y) f♯(x,y)=∑ifi(x,y)为所有特征在 ( x , y ) (x,y) (x,y)出现的次数,于是有:

A ( δ ∣ w ) = ∑ x , y P ~ ( x , y ) ∑ i = 1 n δ i f i ( x , y ) + 1 − ∑ x P ~ ( x ) ∑ y P w ( y ∣ x ) e x p ( f ♯ ( x , y ) ∑ i = 1 n δ i f i ( x , y ) f ♯ ( x , y ) ) ≥ ∑ x , y P ~ ( x , y ) ∑ i = 1 n δ i f i ( x , y ) + 1 − ∑ x P ~ ( x ) ∑ y P w ( y ∣ x ) ∑ i = 1 n f i ( x , y ) f ♯ ( x , y ) e x p ( δ i f ♯ ( x , y ) ) ≜ B ( δ ∣ w ) A(\delta|w)=\sum_{x,y}\widetilde{P}(x,y)\sum_{i=1}^{n}\delta_{i}f_{i}(x,y)+1-\sum_{x}\widetilde{P}(x)\sum_{y}P_{w}(y|x)exp\Big(f^{\sharp}(x,y)\sum_{i=1}^{n}\frac{\delta_{i}f_{i}(x,y)}{f^{\sharp}(x,y)}\Big)\\ \geq \sum_{x,y}\widetilde{P}(x,y)\sum_{i=1}^{n}\delta_{i}f_{i}(x,y)+1-\sum_{x}\widetilde{P}(x)\sum_{y}P_{w}(y|x)\sum_{i=1}^{n}\frac{f_{i}(x,y)}{f^{\sharp}(x,y)}exp\Big(\delta_{i}f^{\sharp}(x,y)\Big)\triangleq B(\delta|w) A(δ∣w)=x,y∑P (x,y)i=1∑nδifi(x,y)+1−x∑P (x)y∑Pw(y∣x)exp(f♯(x,y)i=1∑nf♯(x,y)δifi(x,y))≥x,y∑P (x,y)i=1∑nδifi(x,y)+1−x∑P (x)y∑Pw(y∣x)i=1∑nf♯(x,y)fi(x,y)exp(δif♯(x,y))≜B(δ∣w)

由上式可见 B ( δ ∣ w ) B(\delta|w) B(δ∣w)关于 δ i \delta_{i} δi求导可分离其余 δ j , j ≠ i \delta_{j},j\neq i δj,j̸=i,则由 ∂ B ( δ ∣ w ) ∂ δ i = 0 \frac{\partial B(\delta|w)}{\partial \delta_{i}}=0 ∂δi∂B(δ∣w)=0得:

∑ x , y P ~ ( x , y ) f i ( x , y ) = ∑ x , y P ~ ( x ) P w ( y ∣ x ) f i ( x , y ) e x p ( δ i f ♯ ( x , y ) ) \sum_{x,y}\widetilde{P}(x,y)f_{i}(x,y)=\sum_{x,y}\widetilde{P}(x)P_{w}(y|x)f_{i}(x,y)exp(\delta_{i}f^{\sharp}(x,y)) x,y∑P (x,y)fi(x,y)=x,y∑P (x)Pw(y∣x)fi(x,y)exp(δif♯(x,y))

由此式求解 δ i \delta_{i} δi即可,这是一个一元函数求零点问题,当解析解不易求解时,可通过牛顿法、二分法等求解。

拟牛顿法BFGS算法:

min w ∈ R n − Φ ( w ) = max w ∈ R n Φ ( w ) \min\limits_{w\in R^{n}}-\Phi(w)=\max\limits_{w\in R^{n}}\Phi(w) w∈Rnmin−Φ(w)=w∈RnmaxΦ(w)

不同于改进的迭代尺度法,拟牛顿法直接处理的是多元函数的优化问题,记 g ( w ) = − ∇ Φ ( w ) g(w)=-\nabla\Phi(w) g(w)=−∇Φ(w),则由拟牛顿条件 B k p k = − g k B_{k}p_{k}=-g_{k} Bkpk=−gk更新参数 w k w_{k} wk每一步的迭代方向;由一维精确或不精确线性搜索方法进行步长搜索更新 f ( w ( k ) + λ k p k ) = min λ ≥ 0 f ( w ( k ) + λ k p k ) f(w^{(k)}+\lambda_{k}p_{k})=\min\limits_{\lambda\geq0}f(w^{(k)}+\lambda_{k}p_{k}) f(w(k)+λkpk)=λ≥0minf(w(k)+λkpk);由BFGS公式对类Hessian矩阵进行更新。

ME模型生成算法的问题转化:

(1.)学习概率模型时,在满足已有事实条件下,不确定部分按照“等可能”处理,转化成“最大熵原理”。

(2.)“最大熵模型”也就是“在满足约束的条件下,使条件熵最大的条件概率分布模型”,这是一个含等式约束的优化问题,通过Lagrange乘子法求解,进而转化成“对偶问题”,可以先求出“含参数的最大熵条件概率分布模型”。

(3.)对“含参数的最大熵条件概率分布模型”确定的“对偶函数”关于参数求极大值。A.)一种方法,可以通过“改进的迭代尺度法”求迭代参数序列,使“对偶函数”递增。以降低“对偶函数”增加幅度为代价,将“多变量参数优化”通过Jensen不等式转化成“单变量参数优化”问题。B.)另一种方法,可以直接利用拟牛顿法的BFGS等算法对“对偶函数”关于参数求极值。

最后,由于“最大熵模型 P ( y ∣ x ) P(y|x) P(y∣x)关于训练数据集 T T T的联合概率分布的对数似然函数” ⇔ \Leftrightarrow ⇔ “对偶函数”,所以“对偶函数的极大化” ⇔ \Leftrightarrow ⇔“最大熵模型的极大似然估计”: