DeepLab-V1: SEMANTIC IMAGE SEGMENTATION WITH DEEP CON-VOLUTIONAL NETS AND FULLY CONNECTED CEFs

Abstract

通过结合DCNNs(深度卷积网络)和概率图模型解决语义分割问题. DCNN最后一层不足够充分的定位, 无法进行精确的目标分割, 这源于非常固定的属性使得DCNNs对于高层任务性能好. 通过合并DCNN最后一层的相应和一个全连接的CRF克服这个深度网络本地化差的属性.

最好的结果是怎么获取的:

1. careful network re-purposing

2. wavelet community 的 hole算法

1 Introduction

相比于传统的视觉算法(SIFT或HOG),DCNN以其end-to-end(端到端)方式获得了很好的效果。这样的成功部分可以归功于DCNN对图像转换的平移不变性,根本是源于重复的池化和下采样组合层。平移不变性增强了对数据分层抽象的能力,但同时可能会阻碍低级视觉任务,例如姿态估计、语义分割等,在这些任务中我们倾向于精确的定位而不是抽象的空间关系。

DCNN在图像标记任务中存在两个技术障碍:

信号下采样;

空间不敏感。

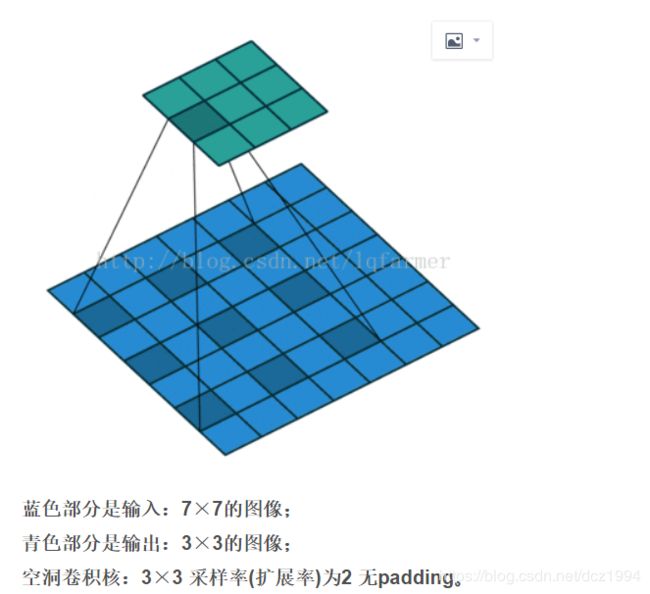

第一个问题涉及到:在DCNN中重复最大池化和下采样带来的分辨率下降问题,分辨率的下降会丢失细节。DeepLab是采用的atrous(带孔)算法扩展感受野,获取更多的上下文信息。

第二个问题涉及到:分类器获取以对象中心的决策是需要空间变换的不变性,这天然的限制了DCNN的定位精度,DeepLab采用完全连接的条件随机场(DenseCRF)提高模型捕获细节的能力。

主要贡献:

(i)速度:带atrous算法的DCNN可以保持8FPS的速度,全连接CRF平均推断需要0.5s;

(ii)准确性:在PASCAL语义分割挑战中获得了第二的成绩

(iii)简单性:我们的系统由两个相当完善的模块,DCNN和CRFs组成。

2 Related Work

DeepLab系统应用在语义分割任务上,目的是做逐像素分类的,这与使用两阶段的DCNN方法形成鲜明对比(指R-CNN等系列的目标检测工作),R-CNN系列的做法是原先图片上获取候选区域,再送到DCNN中获取分割建议,重新排列取结果。虽然这种方法明确地尝试处理前段分割算法的本质,但在仍没有明确的利用DCNN的预测图。

我们的系统与其他先进模型的主要区别在于DenseCRFs和DCNN的结合。是将每个像素视为CRF节点,利用远程依赖关系,并使用CRF推理直接优化DCNN的损失函数。Koltun(2011)的工作表明完全连接的CRF在语义分割下非常有效。

也有其他组采取非常相似的方向,将DCNN和密集的CRF结合起来,我们已经更新提出了DeepLab系统(指的是DeepLabV2)。

3 CNN for dense image labeling

3.1 通过hole算法进行有效的滑动窗口提取特征

这里先描述一下DCNN如何设计,调整VGG16模型,转为一个可以有效提取特征的语义分割系统。具体来说,先将VGG16的FC层转为卷积层,模型变为全卷积的方式,在图像的原始分辨率上产生非常稀疏的计算检测分数(步幅32,步幅=输入尺寸/输出特征尺寸步幅),为了以更密集(步幅8)的计算得分,我们在最后的两个最大池化层不下采样(padding到原大小),再通过2或4的采样率的空洞卷积对特征图做采样扩大感受野,缩小步幅。

这种带孔的采样又称atrous算法,可以稀疏的采样底层特征映射,该方法具有通常性,并且可以使用任何采样率计算密集的特征映射。在VGG16中使用不同采样率的空洞卷积,可以让模型再密集的计算时,明确控制网络的感受野。保证DCNN的预测图可靠的预测图像中物体的位置。

训练时将预训练的VGG16的权重做fine-tune,损失函数取是输出的特征图与ground truth下采样8倍做交叉熵和;测试时取输出图双线性上采样8倍得到结果.

3.2 控制接受域的大小并且加速CNN的密度计算

重新利用我们的网络进行密集分数计算的另一个关键要素是明确地控制网络的接受域大小。多少的当前基于DCNN的图片识别方法依赖于Imagenet 大尺度分类任务上的预训练. 这些网络通常有一个大的接受域: VGG-16的224X224(0填充)和404X404像素. 在所有的卷积之后的FC层, 第一个FC层有7X7的空间大小的4096滤波器, 这个成为我们密度映射计算的瓶颈.

我们通过空间下采样(通过简单抽取)解决了这个实际问题-第一个FC层到4×4(或3×3)空间大小。降低网络的接受域大小到128X128(0填充)和308X308(在卷积模型中), 并且减少了第一层FC的计算时间2-3倍. 也通过减少FC层通道数量(4096->1024)成功的实验.

4. 详细的边界恢复:FC-CRFs和多尺度预测

4.1 深度卷积网络和定位挑战

但DCNN的预测物体的位置是粗略的,没有确切的轮廓。在卷积网络中,因为有多个最大池化层和下采样的重复组合层使得模型的具有平移不变性,我们在其输出的high-level的基础上做定位是比较难的。这需要做分类精度和定位精度之间是有一个自然的折中。

解决这个问题的工作,主要分为两个方向:

第一种是利用卷积网络中多个层次的信息;比如FCN

第二种是采样超像素表示,实质上是将定位任务交给低级的分割方法。比如:zoom-out

DeepLab是结合了DCNNs的识别能力和全连接的CRF的细化度定位精度,寻求一个结合的方法,结果证明能够产生准确的语义分割结果。

4.2 精准定位的全连接CRF

传统的CRF有用于平滑噪声分割图 (Rother et al., 2004; Kohli et al., 2009). 通常,这些模型包含耦合相邻节点的energy terms,有利于相同标签分配到空间上近端像素。这些short-range CRF的主要功能是清除基于本地手动提取特征的弱分类器的虚假预测.

与这些较弱的分类器相比,现代DCNN架构(例如我们在此工作中使用的架构)产生得分图和语义标签预测,这些预测在质量上是不同的。在这种情况下,使用short-rangeCRF可能是有害的,因为我们的目标应该是恢复详细的局部结构而不是进一步平滑它。将对比度敏感势能与局部范围CRF结合使用可以潜在地改善定位,但仍然缺少细的结构,并且通常需要解决昂贵的离散优化问题。

为了克服short-CRFs的限制, 整合了我们的系统到FC-CRF模型, 模型的energy function:

4.3 多尺度预测

在输入图像和前四个最大池化层的输出上附加了两层的MLP(第一层是128个3×3卷积,第二层是128个1×1卷积),最终输出的特征映射送到模型的最后一层辅助预测,合起来模型最后的softmax层输入增加5×128=640个通道,实验表示多尺度有助于提升预测结果,但是效果不如CRF明显。

5 Experimental evaluation

dataset: PASCAL VOC 2012, 20个前景1个背景. Training, validation, testing image: 1464, 1449, 1456. 数据集通过提供的额外注释进行扩展. 结果Training image: 10582.通过21个类的平均像素 IoU 测量性能.

Training

DeepLab由DCNN和CRF组成,训练策略是分段训练,即DCNN的输出是CRF的一元势函数,在训练CRF时是固定的。在对DCNN做了fine-tune后,对CRF做交叉验证

DCNN训练使用VGG-16网络(已经在imagenet上预训练), 在交叉熵loss函数上通过SGD微调网络. mini-batch=20. learning rate = 0.001. 每2000次迭代学习率乘以0.1. mementum = 0.9. weight decay = 0.0005.

在DCNN微调之后, 交叉验证FC-CRF模型的参数. 默认值 w2 = 3 and σγ = 3, 在验证集的一个子集中(100个图片)通过交叉验证搜索 w1 , σα , and σβ 的最好的值. 使用从粗到细的体制. 参数的初始搜索范围. w 1 ∈ [5,10], σα ∈ [50 : 10 : 100] and σβ ∈ [3 : 1 : 10]. 然后我们围绕第一轮的最佳值细化搜索步骤的大小. 我们将所有已报道的实验的平均场迭代数固定为10.

Evaluation on Validation set

使用完全连接的CRF显着地改善了结果,使模型能够准确地捕捉复杂的对象边界。

Multi-Scale features

我们还利用了中间层的特性. 如表1所示, 增加多尺度特征提高了性能1.5%. DeepLab+MSc+CRF 改善了4%. 利用多尺度特性可以稍微细化对象边界.

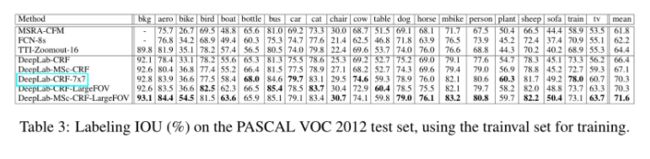

Field of View

使用的"Atrous算法"允许我们通过调整输入步长来任意控制模型的filed-of-view(Fov, 视场)。我们在第一个FC层进行了几个内核大小和输入步长的实验. DeepLab-CRF-7X7是直接修改VGG-16网络, 内核大小是7, 输入步长=4. 这个模型1.44images/second, 通过修改kernel大小4X4, 变为2.9images/second. 最后,我们使用内核大小3×3和输入步长=12,并将最后两层的滤波器尺寸从4096进一步更改为1024(DeepLab-CRF-LargeFOV, large是指输入步长很大)。

Mean Pixel IOU along Object Boundaries

使用val set中注释的'void'标签,该标签通常出现在对象边界周围. 我们计算位于'void'标签的窄带(称为trimap)内的那些像素的平均IOU. 如图5所示,利用来自中间层的多尺度特征并通过完全连接的CRF细化分割结果显着改善了对象边界周围的结果。

Comparison with State-of-art

Reproducibility(复现)

https://bitbucket.org/Depplab/Depplab-public

Test set results

最好的模型 DeepLab-MSc-CRF-LargeFOV.

6 DISCUSSION

我们通过融合DCNN和FC-CRF的思想, 生成了一个全新的能够产生异议精准预测和细节分割图的方法,而且计算有效率.实验结果表明,该方法大大提高了Pascal voc 2012语义图像分割任务的研究水平.

在我们的模型中,有许多方面我们打算改进,比如充分整合它的两个主要组成部分(cnn和crf),并以端到端的方式对整个系统进行训练,我们还计划对更多的数据集进行实验,并将我们的方法应用于其他数据源,如深度地图或视频. 另外,我们还以包围框或图像级标签的形式,对带有弱监督注解的模型进行了训练.

在更高的层次上,我们的工作在于卷积神经网络和概率图形模型的交集。我们计划进一步研究这两类强大方法之间的相互作用,并探讨它们在解决具有挑战性的计算机视觉任务方面的协同潜力。