谷歌发布TensorFlow Lite:移动端+快速+跨平台部署深度学习

大数据文摘作品

作者:龙牧雪 魏子敏

相隔近半年,谷歌TensorFlow Lite终于正式发布。

11月15日凌晨,谷歌正式发布了TensorFlow Lite开发者预览版(developer preview)。

Google I/O 2017终于来了:GoogleLens,谷歌云TPU横空出世,Youtube直播打赏受争议

TensorFlow Lite旨在为智能手机和嵌入式设备创建更轻量级的机器学习解决方案。

正如它的名字"Lite"一样,“轻量级”是谷歌最希望向我们传递的信息。谷歌在其开发者博客中指出,TensorFlow Lite的主要亮点是:

-

跨平台:可以在许多不同平台上运行,安卓和iOS应用开发者都可以使用

-

快速:针对移动设备进行了优化,包括快速初始化,显著提高的模型加载时间,并支持硬件加速

速度!速度!速度!这里的重点不是训练模型,而是让不太稳健的设备也能低延时地运行机器学习模型。这意味着TensorFlow Lite将专注于将模型的现有功能应用于所提供的新数据,而不是从现有数据中学习新的功能——大多数移动设备根本没有足够的处理能力。

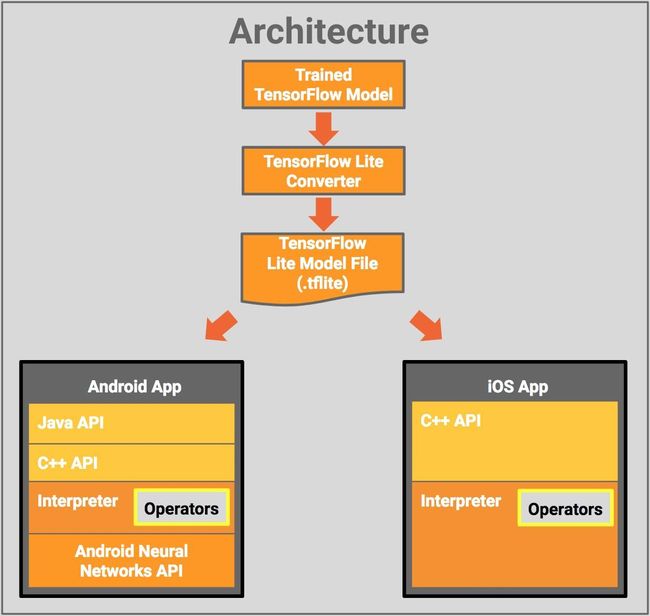

TensorFlow Lite框架如下图所示:

其组件包括:

-

TensorFlow 模型(TensorFlow Model):保存在磁盘中的训练模型。

-

TensorFlow Lite 转化器(TensorFlow Lite Converter):将模型转换成 TensorFlow Lite 文件格式的项目。

-

TensorFlow Lite 模型文件(TensorFlow Lite Model File):基于 FlatBuffers,适配最大速度和最小规模的模型。

此前,通过TensorFlow Mobile API,TensorFlow已经支持手机上的模型嵌入式部署。TensorFlow Lite应该被视为TensorFlow Mobile的升级版。

本次发布的是开发者预览版,并非完整版本,依然有待完善。谷歌团队表示,基于用户的需求,他们将推出更多模型和功能。随着TensorFlow Lite逐渐成熟,它将成为在手机和嵌入式设备上部署模型的标配。

伴随着TensorFlow Lite的发布,也有少量预训练AI模型面世,比如MobileNet、用于计算机视觉物体识别的Inception v3、用于自然语言处理的Smart Reply(Gmail和谷歌的聊天软件Allo中已经用到Smart Reply来为用户提供回复内容的建议)。TensorFlow Lite上也可以部署用自己的数据集定制化训练的模型。

TensorFlow Lite使用的是Android Neural Networks API,可以在没有硬件加速时调用CPU处理,确保模型在不同设备上的运行。

自今年5月谷歌宣布该项目以来,多家竞争对手相继推出了适配移动端的AI架构,包括苹果CoreML、Clarifai这样的框架,和华为Mate10里用到的麒麟970处理器等。

“通过这一开发者版本,我们希望在一个略受限的平台上,优先确保几个最重要常见模型的运转效率。”TensorFlow开发团队如此解释,“我们会根据用户需要调整未来的功能扩展优先级。我们的目标是简化开发,并且确保其在移动端的性能。”

谷歌终于发布的TensorFlow Lite尽管是一个轻量级版本,依然是在智能手机和嵌入式设备上部署深度学习的一大动作。

One more thing

今日早晨,谷歌翻译广告出现在微信

信息来源:venturebeat, techcrunch, googleblog

精品课程

数据科学实训营第4期

优秀助教推荐|姜姜

作为一枚对数据分析的理解仅限于Excel的小白,曾经一直认为通过写代码来分析数据是件无比高大上的事。可是,在文摘的数据科学实训营居然就实现了!

手把手的教学方式,助教和同学们热烈的交流讨论,让我慢慢地觉得一行行代码如此亲切。而当把自己头脑中的构思通过代码实现,看到结果的那一刻,真是无比激动!

经过Kaggle、天池的案例的历练,对这些数据比赛也开始兴趣盎然,有没有小伙伴有兴趣一起去玩一玩的?

作为第4期的北美地区助教,寄语各位学员:前方高能,请准备好足够的时间,如果你能按时提交作业,结业时一定脱胎换骨。

往期精彩文章

点击图片阅读

Yann LeCun说是时候放弃概率论了,因果关系才是理解世界的基石