作者:DataPipeline CEO 陈诚

上周我们探讨了数据的「资产负债表」与「现状」,期间抛给大家一个问题:如果我们制作一个企业的“数据资产负债表”,到底会有多少数据是企业真正的资产?

数据出现问题并不仅仅是数据部门的原因,更多是组织架构及配合的问题。相较于追责某些工具,反而应该思考该用何种理念和方法来面对背后的“元问题”。基于此,我们提出应从DataOps入手。

一、DataOps理念

Gartner对于DataOps的定义

Data ops is the hub for collecting and distributing data, with a mandate to provide controlled access to systems of record for customer and marketing performance data, while protecting privacy, usage restrictions and data integrity.

该定义没错,不过我们解读DataOps理念的宗旨在于以最快的速度用数据满足业务发展需要,并保障其质量。 在业务发展日新月异,且数据、系统和团队又重度分裂的情形下,我们应当用文化、流程和工具实现数据驱动业务的最佳实践。 为能深入理解DataOps的理念,我们不妨先进行回顾:

过去很多企业投入资源践行了DAMA(数据管理协会)的数据治理模式,也收到了很多效果,但在新时代的发展需求下,不同的经济周期里,我们逐渐看到了DAMA数据治理框架的一些局限性和需要调整的地方。 DAMA提出的数据治理框架,非常详细地阐述了在建设和使用数据过程中常见的问题,诸如组织、流程、角色和一些实践原理。但最缺失的一点是,在竞争如此激烈的商业环境中,这样大而全的模式很难严格按照配方从一而终地实践下来,周期太长,见效太慢。

为此,DataOps借用了DAMA数据治理的基础框架,且揉和了DevOps理念中敏捷快速、持续集成的关键点,强调通过调整文化、流程和使用的工具,在安全合规的前提下,快速提升业务价值。同时将持续迭代数据架构,不断强化组织的数据思维作为核心理念。

接下来我们需要从企业所遭遇的数据困境和数据部门的困境两个层面进行分析:

企业的数据需求往往从以高层希望关注的业务指标(KPI)为起点,逐渐发展延伸为中层管理者被动或主动需要关注的指标(KPI),这些指标非常重要,因此很多人说:“凡是高管能看到的KPI指标都会提升。”这句话没错,但是只使用这些描述性的指标就像开车时只能看后视镜,如果以一个相对狭窄而固定的角度去看在企业发展历程中发生的事,所能得到的结论也是有限的。

在经济上行期,数据的价值很难被重视,因为有很多方式可以增加收入。而在桥水基金创始人Ray Dalio所描述的下行经济周期中,大众预期普遍悲观,增长乏力,需要从粗放转化到精细经营,而精细化的基础就是数据。因此企业高管无不在思考,如何能使用数据让企业尽快向前看,驱动新的增长点,产生更多新的业务价值。但高管们深知,这时只能去激活一线业务用户使用数据的思维和潜力。而要做到这点,面临两个挑战:

1)让数据使用安全合规,建立严格的权限管控;

2)快速匹配业务部门相应的数据能力和资源。

这两个重要问题,目前都没有成熟有效的方法去实践解决。很多高管希望通过数据建立与外部的连接,变革商业模式,增加收入。不可否认,愿景是美好的,但当内部数据出现流转使用效率低下、质量问题层出不穷等困境时,也只能望洋兴叹。 导致这种局面的本质原因,在于数据部门经常处于一种永远竭尽全力满足各种需求,却始终得不到认可的状态中。为何如此?

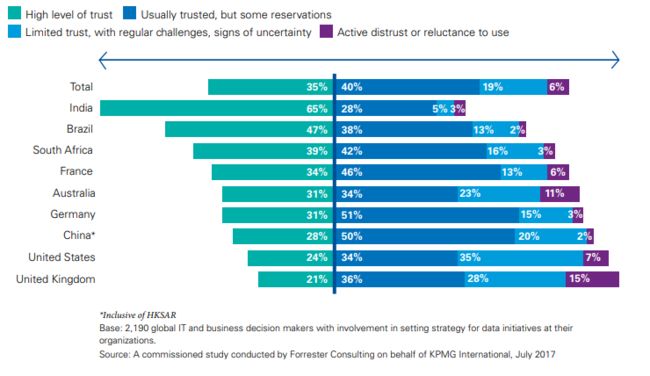

通常数据部门面临人手不足的问题,因为整个企业,从前台业务、市场,甚至到中后台的财务、供应链、人力资源,都在向一个部门提需求,由一个部门承接。其数据的多样性,业务的变化性,数据量的日益增长给系统稳定性带来了不小挑战。导致数据部门每天对外要理解业务数据需求的内涵,竭力排期满足,对内要运维所使用的陈旧工具和系统,保证其正常运行,每天不堪重负,没有时间和人力去思考如何自动化、智能化地提高效率。这时,一旦出现数据质量、元数据等问题,就会被挑战得体无完肤,甚至会升级到能力和信任的高度。

有些企业在业务线中放置业务分析师,希望借助一些自助分析工具和框架,来分流和缓解数据部门的压力,这是积极有效的尝试。但会造成中心化的数据架构部分负载增加,运维难度和成本进一步上升。有时经常因无法说明这些新的开销对于业务增长的意义,以及责权界限不清,收不到预期的效果。 长此以往,这种落后于时代的组织形式和技术视野会导致企业和数据部门无法真正做到快速响应业务需求。 因此,在这样的大环境下,我们看到一个机会,一种变革,它包括了:

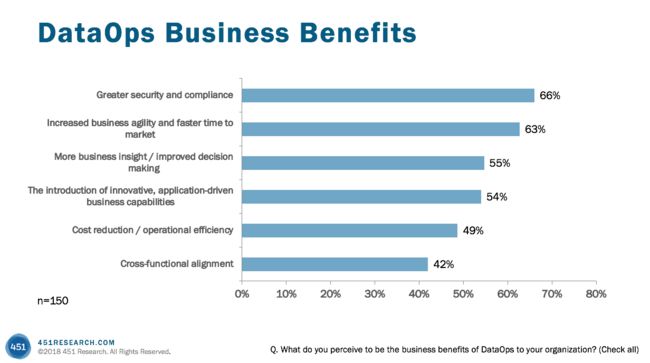

1)使用数据时,责权清晰的组织架构和规则流程,即DataOps理念,使数据思维在组织内深入人心;

2)将自动化、智能化的现代基础设施与数据管理体系组合起来赋能企业中的每一个人。用自上而下的信任和管控激发自下而上的自主和创新,从而打破数据组因长期过载而制约企业发展的局面,逐渐从只看后视镜的困境中走向前后兼顾的未来转型。

二、DataOps设计原则

因此,我们需要在此提出DataOps的五大设计原则:

1)安全合规

2)快速敏捷

3)开放协同

4)自助服务

5)自动智能

安全合规

首先,我们需要根据企业的业务属性,确定极为清晰且安全合规的数据隐私和权限管控标准。数据协同使用可以让授权的业务用户和第三方安全合规地使用企业数据,无需担心数据的隐私和泄漏,这是一切后续的基础。否则,就无法真正做到将数据赋能给一线的业务用户。

快速敏捷

其次,在合规的基础上,将一切围绕数据产生的价值提升到最大,这样才能不错失创收的机会。

开放协同

将自上而下的描述性指标,转为将数据开放给业务用户,进行自下而上地探索和使用。因为业务用户最了解创新所需要的数据应该如何应用,因此应该最大限度地发挥他们的主观能动性,带来业务创新。

业务用户使用数据去探索,是阶段性的。从只会用excel到看报表再到写SQL直至会用python做数据探索,不同的发展阶段,数据探索的能力也截然不同。而DataOps倡导的是每个人都应当学习去使用数据,数据不是某个人,某个小组的精英才能掌握的能力,它是一种文化。

自助服务

通过自助式服务,将数据部门从日常数据使用的生命周期管理中解放出来,以提高数据的时效性。并且要计算使用数据资源的成本,让数据资产负债的概念深入人心,而不是将数据资源当成免费的午餐,吃完还要“评头论足”。

自动智能

让数据部门全身心地投入到对于自动化、智能化数据科技的实践中,以最快地速度满足数据多样性,动态性,质量监控,系统稳定性的底层技术需求(后续会详细描述)。

继上周交代了数据管理目前的现状以及DataOps出现的背景之后,本篇主要介绍了DataOps理念及设计原则。接下来我们会探讨由这些原则衍生出的具体组织架构、技术考量和实施步骤。

对上述问题感兴趣的伙伴,请持续关注DataPipeline