SUMMARY

• LASSO在系数绝对值之和小于某个常数的情况下,使残差平方和最小。往往使一些系数精确的等于0,所以给出了具有解释力的模型;

• LASSO具有一些子集选择和岭回归的优点。像子集选择一样,它可以得到具有解释力的模型;想岭回归一样,它具有稳定性。

INTRODUCTION

• 普通最小二乘(OLS)估计通过最小化残差平方和获得。OLS估计的局限性是:

(1)预测精度:OLS估计具有低偏差(拟合训练集的误差低)和高方差(模型的泛化能力弱),通过收缩(shrinking)方法或令某些系数为0可使预测能力提高,即牺牲一些偏差来降低方差;

(2)解释能力:当解释变量非常多时,往往选出其中一小部分对响应值进行最有效的解释。

• 岭回归(Ridge Regression):

![]()

避免 ![]() 不可逆的情况,并且相对于OLS,w向原点压缩,但不会出现某一系数为0的稀疏解的情况。

不可逆的情况,并且相对于OLS,w向原点压缩,但不会出现某一系数为0的稀疏解的情况。

• OLS估计的两种改进:

(1)子集选择

Cons:通过筛选变量增加了模型的解释能力;

Pron:模型不稳健。因为选择变量是一个离散的过程,变量要么保留要么舍弃,数据的微小变动会导致模型很大的不同,降低预测的准确性。

(2)岭回归

Cons:是一个连续的、收缩系数的过程,因此较为稳定;

Pron:不能精确地把系数收缩到0,所以不容易给出解释力强的模型。

• LASSO( Least Absolute Shrinkage and Selection Operator )可以把系数精确收缩到0,所以保留了子集选择和岭回归的优点。

2 THE LASSO

2.1 Definition

• 一个类似的模型:non-negative garotte

garotte的预测误差比子集选择低,效果和岭回归差不多。缺点是garotte直接使用了OLS估计,如果OLS估计量本身表现差,那么garotte也表现差。

• LASSO避免了对OLS估计量的直接使用

参数 t 控制了对回归系数的压缩量。

2.2 Orthonormal Design Case

• LASSO的解为:

![]()

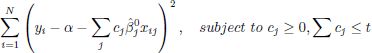

• 子集选择回归、岭回归、LASSO、garottte 的解函数:

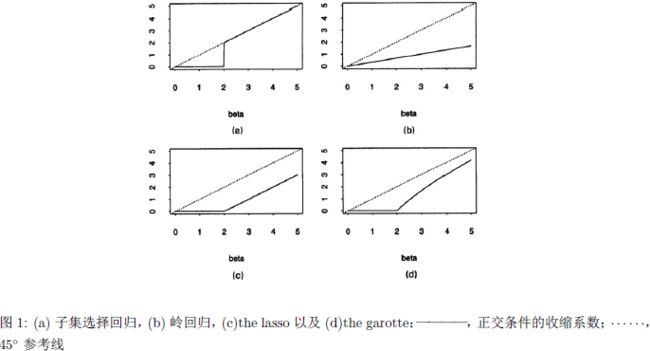

2.3 Geometry of Lasso

2.4 More on Two-predictor Case

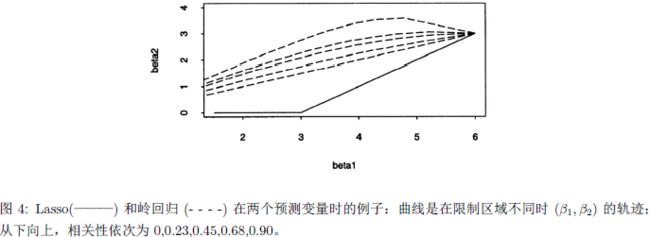

• 岭回归收缩与变量的相关性有很大关系。当相关系数为0时,岭回归按比例对系数收缩,而当相关系数较大时,收缩量关于限制的强弱不单调,当限制变弱时收缩量反而变大。

2.5 Standard Errors

• 使用bootstrap估计参数标准差。首先将惩罚项改写为![]() ,然后借助岭回归来估计系数的协方差矩阵:

,然后借助岭回归来估计系数的协方差矩阵:![]() 。利用这个近似可以使用一个岭回归的迭代算法来计算lasso估计,效率很低,但对选择t很有用。

。利用这个近似可以使用一个岭回归的迭代算法来计算lasso估计,效率很低,但对选择t很有用。

3 EXAMPLE-PROSTATE CANCER DATA

当s趋于0时,每个系数都趋向于0.在这个例子中,曲线是单调的,但在通常情况下可能不是单调的,岭回归和子集选择也有这种非单调性。

4 PREDICTION ERROR AND ESTIMATION OF t

5 LASSO AS BAYES ESTIMATE

6 ALGORITHMS FOR FINDING LASSO SOLUTIONS

7 SIMULATIONS

8 APPLICATION TO GENERALIZED REGRESSION MODELS

11 DISCUSSION

• 对于少数变量有较大的解释力——子集选择最优,LASSO效果不很好,岭回归很差;

对于中等解释力的变量不多不少——LASSO最好,岭回归次之,子集选择再次之;

对于很多变量有较小的解释力——岭回归平均表现最好,LASSO次之,子集选择再次之。

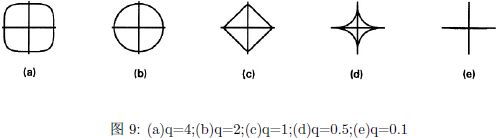

• Frank和Friedman通过在残差平方和上加入惩罚项![]() 推广了岭回归和子集选择,称为bridge。子集选择相当于q→0。q‹1就不是凸优化了。

推广了岭回归和子集选择,称为bridge。子集选择相当于q→0。q‹1就不是凸优化了。

• LASSO优点:

(1)连续选择变量

(2)压缩系数+特征选择

(3)具有可解释性