DeepNude已迅速下线,来看看它涉及的图像修复技术

导读:本文会探讨一些image/text/random-to-image的神经网络模型,仅供学习交流之用,也欢迎分享你的技术解决方案。

作者:yuanxiaosc

来源:Github、大数据文摘

原文:

https://github.com/yuanxiaosc/DeepNude-an-Image-to-Image-technology

上周,又一AI偏门应用DeepNude爆出,一键直接“脱掉”女性的衣服,火爆全球。

应用也很容易上手,只需要给它一张照片,即可借助神经网络技术,自动“脱掉”衣服。原理虽然理解门槛高,但是应用起来却毫不费力,因为对于使用者来说,无需任何技术知识,一键即可获取。

据发布者表示,研发团队是个很小的团队,相关技术显然也还很不成熟,多数照片(尤其是低分辨率照片)经过DeepNude处理后,得出的图像会有人工痕迹;而输入卡通人物照片,得出的图像是完全扭曲的,大多数图像和低分辨率图像会产生一些视觉伪像。

这一应用瞬间引发了社区的各类声讨,表示是对AI利用的反例。

连吴恩达也出面发声,声讨这一项目。

该应用在一片讨伐声中很快下线,但是,余震犹存。

尤其是对这一应用背后技术的探讨还一直在持续。

本周,一个名为“研究DeepNude使用的图像生成和图像修复相关的技术和论文“的GitHub升至一周热榜,获得了不少星标。

项目创始人显然对于这一项目背后的技术很有研究,提出了其生成需要的一系列技术框架,以及哪些技术可能有更好的实现效果。在此我们进行转载,希望各位极客在满足技术好奇心的同时,也可以正确使用自己手中的技术力量。

以下为原文内容:

接下来我会开源一些image/text/random-to-image的神经网络模型,仅供学习交流之用,也欢迎分享你的技术解决方案。

01 Image-to-Image Demo图像到图像demo

DeepNude软件主要使用Image Inpainting for Irregular Holes Using Partial Convolutions 中提出的Image-to-Image技术,该技术有很多其它的应用,比如把黑白的简笔画转换成色彩丰富的彩图,你可以点击下方的链接在浏览器中尝试Image-to-Image技术。

https://affinelayer.com/pixsrv/

在左侧框中按照自己想象画一个简笔画的猫,再点击pix2pix按钮,就能输出一个模型生成的猫。

02 Deep Computer Vision in DeepNude

1. Image Inpainting图像修复

论文:

NVIDIA 2018 paper Image Inpainting for Irregular Holes Using Partial Convolutions and Partial Convolution based Padding.

代码:Paper code partialconv

▲效果

在Image_Inpainting(NVIDIA_2018).mp4视频中左侧的操作界面,只需用工具将图像中不需要的内容简单涂抹掉,哪怕形状很不规则,NVIDIA的模型能够将图像“复原”,用非常逼真的画面填补被涂抹的空白。可谓是一键P图,而且“毫无ps痕迹”。

该研究来自Nvidia的Guilin Liu等人的团队,他们发布了一种可以编辑图像或重建已损坏图像的深度学习方法,即使图像穿了个洞或丢失了像素。这是目前2018 state-of-the-art的方法。

2. Pix2Pix(need for paired train data)

DeepNude mainly uses this Pix2Pix technology.

论文 :

Berkeley 2017 paper Image-to-Image Translation with Conditional Adversarial Networks.

主页 :

homepage Image-to-Image Translation with Conditional Adversarial Nets

代码:code pix2pix

Run in Google Colab:pix2pix.ipynb

Image-to-Image Translation with Conditional Adversarial Networks是伯克利大学研究提出的使用条件对抗网络作为图像到图像转换问题的通用解决方案。

3. CycleGAN(without the need for paired train data)

论文:

Berkeley 2017 paper Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

代码:code CycleGAN

Run in Google Colab:cyclegan.ipynb

▲效果

CycleGAN使用循环一致性损失函数来实现训练,而无需配对数据。换句话说,它可以从一个域转换到另一个域,而无需在源域和目标域之间进行一对一映射。这开启了执行许多有趣任务的可能性,例如照片增强,图像着色,样式传输等。您只需要源和目标数据集。

03 未来

可能不需要Image-to-Image。我们可以使用GAN直接从随机值生成图像或从文本生成图像。

1. Obj-GAN

微软人工智能研究院(Microsoft Research AI)开发的新AI技术Obj-GAN可以理解自然语言描述、绘制草图、合成图像,然后根据草图框架和文字提供的个别单词细化细节。换句话说,这个网络可以根据描述日常场景的文字描述生成同样场景的图像。

▲效果

▲模型

2. StoryGAN

进阶版神笔:只需一句话、一个故事,即可生成画面。

微软新研究提出新型GAN——ObjGAN,可根据文字描述生成复杂场景。他们还提出另一个可以画故事的GAN——StoryGAN,输入一个故事的文本,即可输出「连环画」。

当前最优的文本到图像生成模型可以基于单句描述生成逼真的鸟类图像。然而,文本到图像生成器远远不止仅对一个句子生成单个图像。给定一个多句段落,生成一系列图像,每个图像对应一个句子,完整地可视化整个故事。

▲效果

现在用得最多的Image-to-Image技术应该就是美颜APP了,所以我们为什么不开发一个更加智能的美颜相机呢?

![]()

有话要说

Q: 关于这些P图神技,你怎么看?

欢迎留言与大家分享

猜你想看

发际线预警!10本程序员必读烧脑经典,你敢挑战一本吗?

手把手教你实现共享单车数据分析及需求预测

2019上半年这10本新书,技术大牛们都在追着看

高能干货:OpenCV看这篇就够了,9段代码详解图像变换基本操作

更多精彩

在公众号对话框输入以下关键词

查看更多优质内容!

PPT | 报告 | 读书 | 书单 | 干货

大数据 | 揭秘 | Python | 可视化

AI | 人工智能 | 5G | 区块链

机器学习 | 深度学习 | 神经网络

1024 | 段子 | 数学 | 高考

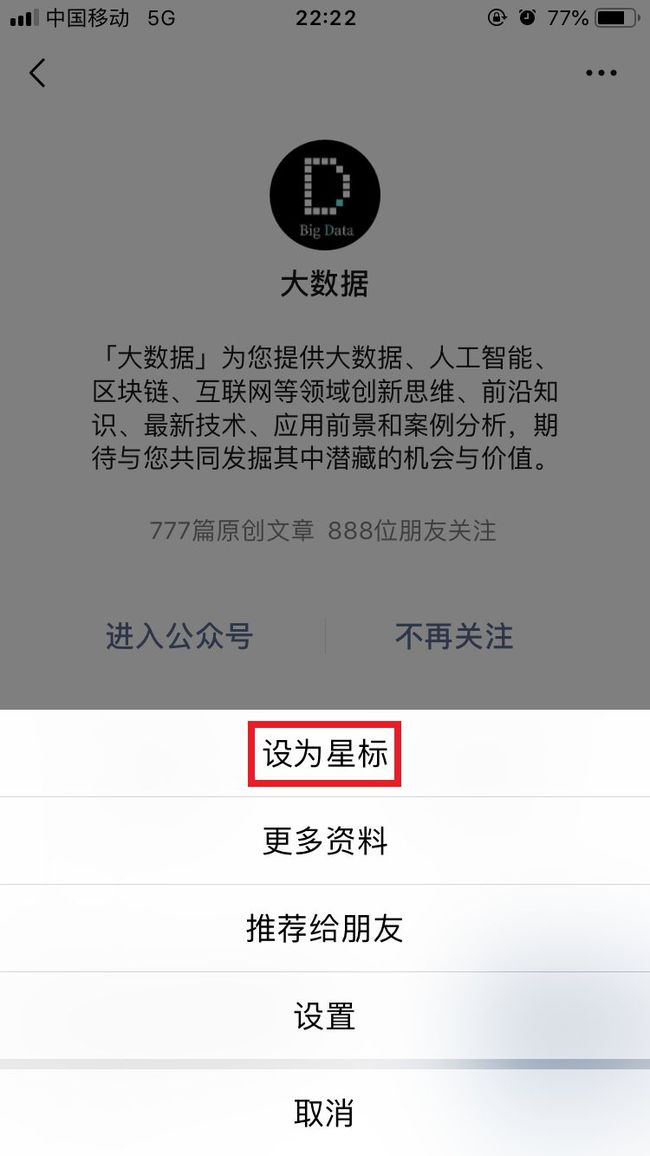

据统计,99%的大咖都完成了这个神操作

觉得不错,请把这篇文章分享给你的朋友

转载 / 投稿请联系:[email protected]

更多精彩,请在后台点击“历史文章”查看