大数据开发从小白到大神(二)——安装配置Hadoop框架

在上一篇文章中我们完成了5台虚拟机的搭建工作,并且完成了对5台虚拟机都进行了静态ip的设置,这只是大数据平台搭建的基础部分,今天我们就来开始真正的接触大数据——Hadoop。

在这个系列中我只想写干货,真正与开发有关的东西,所以关于Hadoop是个什东西,为什么要用Hadoop,网上的资料一大推,大家可以自行百度。

在安装Hadoop之前还是有一些预备工作要做,笔者一般喜欢在命令行操作Linux系统,所有这里简单介绍一下Linux中命令行和图形界面的切换。ctrl + alt + F1(~F6)是切换到命令行,ctrl + alt + F7是切换到图形界面。大家可以自己试试。

另外还有一个东西需要安装一下,就是ssh,今后我们需要在一台主机上可以操作其他主机,在Hadoop中,一台主机就是一个节点,因此我们需要ssh,它可以帮助我们安全的操作网络中的其他节点。

- 安装ssh

$>sudo apt-get install ssh //安装ssh

$>ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa //生成密钥对,一个公钥一个私钥

$>ls -al .ssh //查看密钥对,这时应该有一个公钥,一个私钥

id_rsa是私钥,id_rsa.pub就是公钥。其他的先不用管

$>cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys //将公钥放在授权keys中,这样就是用ssh登录了

$>ssh localhost

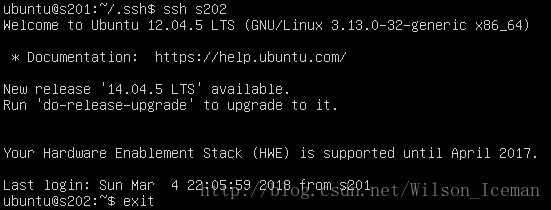

当第一次登录时,会弹出yes/no的提示,直接输入yes就好,然后exit,再次登录时应该就会出现上面的页面

此时我们可以开发第二台虚拟机,我们第二台虚拟机的主机名是s202,关于修改主机名,大家可以自己百度。在第二台

虚拟机

上

操作

$>sudo apt-get install ssh

//安装ssh

$>ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

//生成密钥对,一个公钥一个私钥

这个时候,我们需要把s201的公钥放在s202的授权keys中,这样就可以用s201来登录s202了。这里我们使用nc来传递

在s202中操作。

$>nc -l 8888 > id_rsa.pub.s201 //使用nc来传递文件,新建一个id_rsa.pub.s201来存放传递过来的数据

在s201中操作

$>nc s202 8888 < ~/.ssh/id_rsa.pub //将s201的公钥传递到s202指定的文件夹中

在s202中操作

$>cat id_rsa.pub.s201 >> authorized_keys //将s201的公钥放在指定的授权文件中

在s201中操作

$>ssh s202

这样我们就可以在s201中登录s202

- 安装jdk

我们可以从oracle官网下载jdk的Linux的tar包

jdk-8u161-linux-x64.tar.gz,把它放在sharefolders中然后在虚拟机中安装

$>cd /mnt/hgfs/sharefolder/ //进入设置的共享文件夹

$>cp jdk-8u161-linux-x64.tar.gz ~/Downloads //拷贝文件到自己的目录里

$>cd ~/Downloads //进入自己的目录

$>tar -xzvf jdk-8u161-linux-x64.tar.gz //解压

我们在根目录中新建一个soft文件夹,用来存放我们安装的软件

$>cd / //进入根目录

$>sudo mkdir soft //新建一个文件夹soft

这里要修改soft文件夹的owner和所在组

$>sudo chown ubuntu:ubuntu /soft //修改soft文件夹的owner和group

$>mv ~/Downloads/jdk1.8.0_161 /soft //把解压后的文件移动到/soft文件中

这里新建一个link文件来指向jdk1.8.0_161

$>ln -s jdk1.8.0_161 jdk //新建一个link文件,方便配置环境变量

接下来我们需要配置jdk的环境变量,

$>sudo nano /etc/environment

//修改环境变量

按照上图来配置环境变量,注意在后面追加路径是用":"来分割,与windows中不同

$>source environment

//是环境变量立即生效

$>java -version

//查看jdk是否安装成功,环境变量是否配置成功

出现上图表示你的jdk的环境变量配置完成

- 安装Hadoop

在官网下载Hadoop,我使用的是Hadoop 2.7.2

http://archive.apache.org/dist/hadoop/common/hadoop-2.7.2/

$>和安装jdk是一样的,使用sharefolder来传递到虚拟机中,然后把tar包cp到~/Downloads目录中

$>cd /mnt/hgfs/sharefolder

$>cp hadoop-2.7.2.tar.gz ~/Downloads

$>cd ~/Downloads

$>tar -xzvf hadoop-2.7.2.tar.gz

$>sudo mv hadoop-2.7.2 /soft

$>ln -s

hadoop-2.7.2 hadoop

同样需要配置环境变量,修改/etc/environment文件如下

$>source environment

$>sudo reboot

$>hadoop version //查看hadoop是否安装成功,hadoop环境变量是否配置成功

- 配置Hadoop的环境

安装好之后,我们来配置Hadoop的运行环境。Hadoop一共有三种运行模式:local,伪分布和完全分布。local模式是直接使用Linux的文件格式,主要用于在调试。用的比较多的就是伪分布模式和完全分布模式,这两中模式其实没有什么分别,区别就是伪分布模式是把所有的节点分布在一台设备上,而完全分布式模式是每一个节点是在不同的机器上,也就是说区别就是在节点的数量。

Hadoop默认是local模式的,今天我们先介绍伪分布模式。

配置伪分布模式要修改4个文件

$>cd /sotf/hadoop/etc/hadoop

这四个文件分别是

cors-site.xml,该文件需要配置成

hdfs-site.xml,该文件需要配置成

mapred-site.xml,该文件需要配置成

yarn-site.xml,该文件需要配置成

配置完成后,我们来格式化Hadoop的文件系统

$>Hadoop namenode -format //格式化Hadoop的文件系统

$>start-all.sh //启动所有进程

$>jps //查看当前开启的进程

注意上面有5个进程,这5个进程必须全部开启,否则hadoop启动失败,需要再次格式化文件系统,再启动进程。

启动进程后我们就可以新建自己的目录结构

$>hadoop fs -mkdir -p /user/ubuntu/data //在hadoop中新建自己的目录结构